Gdy Pozycje SEO Nie Równa się Widoczności w AI: Rozbieżność

Dowiedz się, dlaczego wysokie pozycje w Google nie gwarantują widoczności w AI. Poznaj różnicę między SEO a cytowaniami AI i jak zoptymalizować się pod oba kana...

Stopień, w jakim platformy AI ujawniają, w jaki sposób wybierają i klasyfikują źródła podczas generowania odpowiedzi. Przejrzystość rankingu AI odnosi się do widoczności algorytmów i kryteriów, które decydują o tym, jakie źródła pojawiają się w odpowiedziach generowanych przez AI, odróżniając ją od tradycyjnego rankingu wyszukiwarek. Ta przejrzystość jest kluczowa dla twórców treści, wydawców i użytkowników, którzy muszą rozumieć, jak informacje są wybierane i priorytetyzowane. Bez przejrzystości użytkownicy nie mogą zweryfikować wiarygodności źródeł ani zrozumieć potencjalnych uprzedzeń w treściach generowanych przez AI.

Stopień, w jakim platformy AI ujawniają, w jaki sposób wybierają i klasyfikują źródła podczas generowania odpowiedzi. Przejrzystość rankingu AI odnosi się do widoczności algorytmów i kryteriów, które decydują o tym, jakie źródła pojawiają się w odpowiedziach generowanych przez AI, odróżniając ją od tradycyjnego rankingu wyszukiwarek. Ta przejrzystość jest kluczowa dla twórców treści, wydawców i użytkowników, którzy muszą rozumieć, jak informacje są wybierane i priorytetyzowane. Bez przejrzystości użytkownicy nie mogą zweryfikować wiarygodności źródeł ani zrozumieć potencjalnych uprzedzeń w treściach generowanych przez AI.

Przejrzystość rankingu AI oznacza ujawnianie, w jaki sposób systemy sztucznej inteligencji wybierają, priorytetyzują i prezentują źródła podczas generowania odpowiedzi na zapytania użytkowników. W przeciwieństwie do tradycyjnych wyszukiwarek, które wyświetlają uporządkowane listy linków, nowoczesne platformy AI, takie jak Perplexity, ChatGPT i Google AI Overviews, integrują wybór źródeł bezpośrednio w proces generowania odpowiedzi, przez co kryteria rankingu stają się dla użytkowników w dużej mierze niewidoczne. Ta nieprzejrzystość tworzy istotną lukę między tym, co widzi użytkownik (syntetyzowana odpowiedź), a tym, jak ta odpowiedź powstała (jakie źródła zostały wybrane, jak je zważono i zacytowano). Dla twórców treści i wydawców taki brak przejrzystości oznacza, że ich widoczność zależy od algorytmów, których nie mogą zrozumieć ani na nie wpłynąć tradycyjnymi metodami optymalizacji. Różnica względem przejrzystości tradycyjnych wyszukiwarek jest znacząca: podczas gdy Google publikuje ogólne czynniki rankingowe i wytyczne jakości, platformy AI często traktują mechanizmy wyboru źródeł jako zastrzeżone tajemnice handlowe. Kluczowymi interesariuszami są tu twórcy treści szukający widoczności, wydawcy dbający o atrybucję ruchu, menedżerowie marek monitorujący reputację, badacze weryfikujący źródła informacji oraz użytkownicy, którzy chcą rozumieć wiarygodność odpowiedzi generowanych przez AI. Zrozumienie przejrzystości rankingu AI stało się niezbędne dla każdego, kto tworzy, dystrybuuje lub polega na treściach cyfrowych w coraz bardziej zdominowanym przez AI krajobrazie informacyjnym.

Platformy AI stosują systemy Retrieval-Augmented Generation (RAG), które łączą modele językowe z wyszukiwaniem informacji w czasie rzeczywistym, by opierać odpowiedzi na rzeczywistych źródłach, zamiast polegać wyłącznie na danych treningowych. Proces RAG składa się z trzech głównych etapów: wyszukiwania (odnajdywanie odpowiednich dokumentów), rankingu (porządkowanie źródeł według trafności) i generowania (synteza informacji z zachowaniem cytowań). Różne platformy wdrażają odmienne podejścia rankingowe—Perplexity stawia na autorytet i aktualność źródła, Google AI Overviews kładzie nacisk na trafność tematyczną i sygnały E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność), a ChatGPT Search równoważy jakość źródeł z kompleksowością odpowiedzi. Na wybór źródeł wpływają zazwyczaj: autorytet domeny (uznana reputacja i profil linków zwrotnych), aktualność treści (świeżość informacji), trafność tematyczna (zgodność semantyczna z zapytaniem), sygnały zaangażowania (metryki interakcji użytkowników) i częstotliwość cytowań (jak często źródła są referowane przez inne autorytatywne strony). Systemy AI różnie ważą te sygnały w zależności od intencji zapytania—zapytania faktograficzne mogą priorytetyzować autorytet i aktualność, a opinie—różnorodność perspektyw i zaangażowanie. Algorytmy rankingu pozostają w dużej mierze nieujawnione, choć dokumentacja platform daje ograniczony wgląd w mechanizmy ważenia czynników.

| Platforma | Przejrzystość cytowań | Kryteria wyboru źródeł | Ujawnienie algorytmu rankingu | Kontrola użytkownika |

|---|---|---|---|---|

| Perplexity | Wysoka – cytowania w tekście z linkami | Autorytet, aktualność, trafność, ekspertyza tematyczna | Umiarkowana – częściowa dokumentacja | Średnia – opcje filtrowania źródeł |

| Google AI Overviews | Średnia – lista cytowanych źródeł | E-E-A-T, trafność tematyczna, świeżość, zaangażowanie | Niska – minimalne ujawnienie | Niska – ograniczona personalizacja |

| ChatGPT Search | Średnia – źródła podane oddzielnie | Jakość, trafność, kompleksowość, autorytet | Niska – algorytm zastrzeżony | Niska – brak personalizacji rankingu |

| Brave Leo | Średnia – atrybucja źródeł | Źródła dbające o prywatność, trafność, autorytet | Niska – nacisk na prywatność | Średnia – opcje wyboru źródeł |

| Consensus | Bardzo wysoka – akademickie metryki | Liczba cytowań, status recenzji, aktualność, trafność tematyczna | Wysoka – akademicka przejrzystość | Wysoka – filtrowanie według typu badania i jakości |

Branża AI nie posiada standaryzowanych praktyk ujawniania, jak działają systemy rankingowe, przez co każde rozwiązanie samo określa poziom przejrzystości. ChatGPT Search od OpenAI oferuje minimalne wyjaśnienia wyboru źródeł, systemy AI Meta udostępniają ograniczoną dokumentację, a Google AI Overviews ujawnia więcej niż konkurencja, lecz wciąż nie podaje kluczowych szczegółów algorytmicznych. Platformy wzbraniają się przed pełnym ujawnieniem, powołując się na przewagę konkurencyjną, ochronę własności intelektualnej oraz trudność wyjaśnienia systemów uczenia maszynowego szerokiej publiczności—jednak ta nieprzejrzystość uniemożliwia zewnętrzny audyt i rozliczalność. Pojawia się problem „prania źródeł” – gdy systemy AI cytują źródła, które same agregują lub przepisują oryginalne treści, co zaciemnia prawdziwe pochodzenie informacji i może wzmagać dezinformację przez kolejne warstwy syntezy. Rośnie presja regulacyjna: unijna ustawa o AI wymaga od systemów wysokiego ryzyka prowadzenia dokumentacji danych treningowych i procesów decyzyjnych, a NTIA AI Accountability Policy wzywa firmy do ujawniania możliwości, ograniczeń i właściwych zastosowań systemów AI. Przykłady niedostatecznego ujawniania to: początkowe problemy Perplexity z prawidłową atrybucją (później poprawione), niejasne wyjaśnienia Google dotyczące wyboru źródeł w AI Overviews oraz ograniczona transparentność ChatGPT co do tego, dlaczego pewne źródła pojawiają się w odpowiedziach, a inne nie. Brak standaryzowanych metryk mierzenia przejrzystości utrudnia użytkownikom i regulatorom obiektywne porównywanie platform.

Nieprzejrzystość systemów rankingowych AI powoduje istotne wyzwania w zakresie widoczności dla twórców treści, ponieważ tradycyjne strategie SEO nie przekładają się bezpośrednio na optymalizację pod platformy AI. Wydawcy nie mogą łatwo zrozumieć, dlaczego ich treści pojawiają się w jednych odpowiedziach AI, a w innych nie, co uniemożliwia opracowanie skutecznych strategii zwiększania widoczności w generowanych odpowiedziach. Pojawia się stronniczość cytowań, gdy systemy AI faworyzują określone źródła—duże portale, instytucje naukowe czy popularne strony—kosztem mniejszych wydawców, niezależnych twórców i ekspertów niszowych, którzy mogą dostarczać równie wartościowych informacji. Mniejsi wydawcy są szczególnie poszkodowani, ponieważ systemy rankingowe AI często mocno premiują autorytet domeny, a nowe lub wyspecjalizowane witryny nie mają rozbudowanego profilu linków ani rozpoznawalnej marki. Badania Search Engine Land pokazują, że AI Overviews zmniejszyły wskaźnik kliknięć w tradycyjne wyniki wyszukiwania o 18–64% w zależności od typu zapytania, a ruch koncentruje się na kilku źródłach cytowanych przez AI. Coraz ważniejsze staje się rozróżnienie między SEO (Search Engine Optimization) a GEO (Generative Engine Optimization)—SEO skupia się na klasycznym rankingu wyszukiwarki, a GEO wymaga zrozumienia i optymalizacji pod kryteria wyboru AI, które pozostają w dużej mierze niejawne. Twórcy treści potrzebują narzędzi takich jak AmICited.com, by monitorować, gdzie ich treści pojawiają się w odpowiedziach AI, śledzić częstotliwość cytowań i rozumieć swoją widoczność na różnych platformach AI.

Branża AI wypracowała kilka ram dokumentowania i ujawniania zachowania systemów, choć wdrożenie jest nierówne w zależności od platformy. Model Cards to standaryzowana dokumentacja wydajności modeli uczenia maszynowego, przeznaczenia, ograniczeń i analizy uprzedzeń—podobnie jak etykiety żywieniowe dla AI. Datasheets for Datasets opisują skład, metody zbierania i potencjalne uprzedzenia w danych treningowych, podkreślając, że systemy AI są tak dobre, jak ich dane wejściowe. System Cards mają szerszy zakres: dokumentują zachowanie całego systemu, interakcje komponentów, potencjalne tryby awarii i efektywność w różnych grupach użytkowników. NTIA AI Accountability Policy zaleca firmom prowadzenie szczegółowej dokumentacji rozwoju, testowania i wdrożenia systemów AI, zwłaszcza w zastosowaniach wysokiego ryzyka wpływających na dobro publiczne. Unijna ustawa o AI nakłada obowiązek, by systemy wysokiego ryzyka prowadziły dokumentację techniczną, rejestry danych i logi wydajności, a także raporty transparentności i informowanie użytkowników. Do najlepszych praktyk branżowych coraz częściej należą:

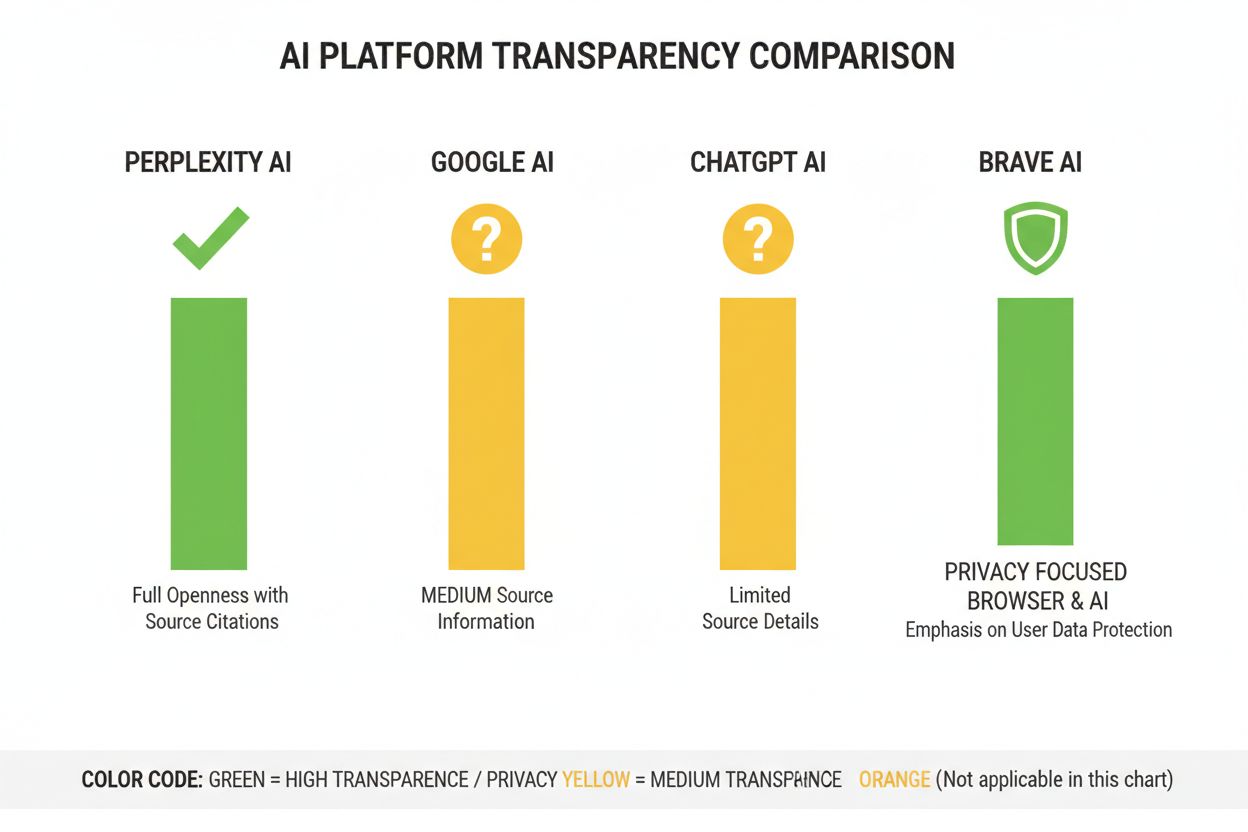

Perplexity pozycjonuje się jako najbardziej transparentna pod względem cytowań platforma AI, wyświetlając linki do źródeł w tekście odpowiedzi i pozwalając użytkownikom sprawdzić, które źródła przyczyniły się do powstania danej informacji. Platforma dość jasno dokumentuje swoje podejście do rankingu, kładąc nacisk na autorytet, ekspertyzę tematyczną i aktualność treści, choć dokładne wagi tych czynników pozostają tajemnicą handlową. Google AI Overviews oferuje umiarkowaną przejrzystość, prezentując cytowane źródła na końcu odpowiedzi, lecz słabo wyjaśnia, dlaczego wybrano jedne źródła, a nie inne, i jak algorytm waży poszczególne sygnały. Dokumentacja Google podkreśla zasady E-E-A-T, ale nie ujawnia w pełni, jak są mierzone lub ważone w procesie rankingu AI. ChatGPT Search od OpenAI to rozwiązanie pośrednie: wyświetla źródła oddzielnie od tekstu odpowiedzi i umożliwia przejście do oryginału, lecz niemal nie wyjaśnia kryteriów wyboru źródeł ani metodologii rankingu. Brave Leo stawia na transparentność zorientowaną na prywatność, deklarując korzystanie ze źródeł dbających o prywatność i brak śledzenia zapytań użytkowników, kosztem mniej szczegółowych wyjaśnień mechanizmów rankingu. Consensus wyróżnia się, skupiając wyłącznie na badaniach naukowych i zapewniając wysoką przejrzystość przez metryki cytowań, status recenzji i wskaźniki jakości badań—czyni to tę platformę najbardziej transparentną algorytmicznie dla zapytań naukowych. Zakres kontroli użytkownika znacząco się różni: Perplexity umożliwia filtrowanie źródeł, Consensus pozwala na filtrowanie według typu i jakości badań, podczas gdy Google i ChatGPT niemal nie pozwalają na personalizację rankingu. Zróżnicowanie podejść do przejrzystości odzwierciedla różne modele biznesowe i grupy docelowe: platformy naukowe stawiają na ujawnianie, a konsumenckie równoważą przejrzystość z ochroną własnych interesów.

Zaufanie i wiarygodność opierają się na tym, że użytkownik rozumie, jak informacje do niego trafiają—jeśli systemy AI ukrywają źródła lub logikę rankingu, użytkownik nie może samodzielnie zweryfikować twierdzeń ani ocenić rzetelności źródeł. Przejrzystość umożliwia weryfikację i fact-checking, pozwalając badaczom, dziennikarzom i świadomym użytkownikom śledzić twierdzenia do oryginalnych źródeł i oceniać ich dokładność oraz kontekst. Zapobieganie dezinformacji i uprzedzeniom to ogromna korzyść: gdy algorytmy rankingu są jawne, badacze mogą wykryć systemowe stronniczości (np. faworyzowanie określonych perspektyw politycznych lub interesów komercyjnych), a platformy mogą być pociągane do odpowiedzialności za wzmacnianie fałszywych informacji. Odpowiedzialność algorytmiczna to podstawowe prawo użytkownika w społeczeństwach demokratycznych—każdy powinien rozumieć, jak systemy kształtujące środowisko informacyjne podejmują decyzje, zwłaszcza gdy wpływają na opinię publiczną, decyzje zakupowe czy dostęp do wiedzy. Dla badań naukowych i pracy akademickiej przejrzystość jest kluczowa, bo naukowcy muszą znać źródła, by właściwie interpretować syntezy AI i nie opierać się nieświadomie na stronniczych lub niekompletnych zbiorach. Konsekwencje biznesowe dla twórców treści są ogromne: bez znajomości czynników rankingu wydawcy nie mogą skutecznie planować strategii, mniejsi twórcy nie mają szans na uczciwą rywalizację z dużymi podmiotami, a cały ekosystem staje się mniej merytokratyczny. Przejrzystość chroni też przed manipulacją—gdy kryteria rankingu są ukryte, nieuczciwi aktorzy mogą wykorzystywać nieznane luki do promowania wprowadzających w błąd treści, podczas gdy jawne systemy można audytować i ulepszać.

Trendy regulacyjne zmierzają ku obowiązkowej przejrzystości: implementacja unijnej ustawy o AI w latach 2025–2026 wymusi szczegółową dokumentację i ujawnianie dla systemów wysokiego ryzyka, a podobne przepisy pojawiają się w Wielkiej Brytanii, Kalifornii i innych jurysdykcjach. Branża dąży do standaryzacji praktyk przejrzystości, a organizacje takie jak Partnership on AI i instytucje naukowe opracowują wspólne ramy dokumentowania i ujawniania działania systemów AI. Rosnące oczekiwania użytkowników co do przejrzystości są coraz bardziej widoczne—badania pokazują, że ponad 70% użytkowników chce wiedzieć, jak systemy AI wybierają źródła i klasyfikują informacje. Innowacje techniczne w objaśnialnej AI (XAI) umożliwiają coraz bardziej szczegółowe wyjaśnienia decyzji rankingowych bez konieczności pełnego ujawniania algorytmów, np. poprzez techniki takie jak LIME (Local Interpretable Model-agnostic Explanations) czy SHAP (SHapley Additive exPlanations). Narzędzia do monitoringu, takie jak AmICited.com, zyskają na znaczeniu wraz z wdrażaniem mechanizmów przejrzystości przez platformy, pomagając twórcom i wydawcom śledzić swoją widoczność w różnych systemach AI i rozumieć wpływ zmian rankingu na zasięg. Konwergencja wymagań regulacyjnych, oczekiwań użytkowników oraz możliwości technicznych sprawia, że lata 2025–2026 będą przełomowe dla przejrzystości rankingu AI—platformy prawdopodobnie wdrożą bardziej ustandaryzowane praktyki ujawniania, lepszą kontrolę użytkownika nad wyborem źródeł i klarowniejsze wyjaśnienia logiki rankingu. Przyszły krajobraz będzie najpewniej opierał się na warstwowej przejrzystości—platformy naukowe i badawcze będą liderami w ujawnianiu, platformy konsumenckie zaoferują umiarkowaną przejrzystość z opcjami personalizacji, a zgodność z regulacjami stanie się standardem branżowym.

Przejrzystość rankingu AI odnosi się do tego, jak otwarcie platformy AI ujawniają swoje algorytmy wyboru i klasyfikacji źródeł w generowanych odpowiedziach. Ma to znaczenie, ponieważ użytkownicy muszą rozumieć wiarygodność źródeł, twórcy treści powinni optymalizować widoczność w AI, a badacze weryfikować źródła informacji. Bez przejrzystości systemy AI mogą wzmacniać dezinformację i tworzyć nieuczciwą przewagę dla dużych wydawców kosztem mniejszych.

Platformy AI wykorzystują systemy Retrieval-Augmented Generation (RAG), które łączą modele językowe z wyszukiwaniem informacji w czasie rzeczywistym. Źródła klasyfikują na podstawie takich czynników jak autorytet domeny, aktualność treści, trafność tematyczna, sygnały zaangażowania i częstotliwość cytowań. Jednak dokładne wagi tych czynników pozostają w większości zastrzeżone i nieujawniane przez większość platform.

Tradycyjne SEO koncentruje się na pozycjonowaniu w listach linków wyszukiwarki, gdzie Google publikuje ogólne czynniki rankingowe. Przejrzystość rankingu AI dotyczy tego, jak platformy AI wybierają źródła do syntezowanych odpowiedzi, co opiera się na innych kryteriach i jest w dużej mierze nieujawniane. Podczas gdy strategie SEO są dobrze udokumentowane, czynniki rankingu AI pozostają w większości niejawne.

Możesz przejść do oryginalnych źródeł, by zweryfikować twierdzenia w pełnym kontekście, sprawdzić, czy pochodzą z autorytatywnych domen, szukać informacji o recenzji naukowej (szczególnie w treściach akademickich) oraz porównywać informacje między różnymi źródłami. Narzędzia takie jak AmICited pomagają śledzić, które źródła pojawiają się w odpowiedziach AI i jak często Twoje treści są cytowane.

Consensus wyróżnia się przejrzystością, koncentrując się wyłącznie na recenzowanych badaniach naukowych z jasnymi metrykami cytowań. Perplexity zapewnia cytowania w tekście i umiarkowaną dokumentację czynników rankingowych. Google AI Overviews oferuje średnią przejrzystość, podczas gdy ChatGPT Search i Brave Leo ujawniają niewiele informacji o algorytmach rankingu.

Model cards to standaryzowana dokumentacja wydajności systemów AI, przeznaczenia, ograniczeń i analizy uprzedzeń. Datasheets dokumentują skład danych treningowych, metody zbierania i potencjalne uprzedzenia. System cards opisują zachowanie całego systemu. Te narzędzia pomagają zwiększyć przejrzystość i porównywalność systemów AI, podobnie jak etykiety żywieniowe dla żywności.

Unijna ustawa o AI wymaga, by systemy AI wysokiego ryzyka prowadziły szczegółową dokumentację techniczną, rejestry danych treningowych i dzienniki wydajności. Nakłada obowiązek raportów transparentności oraz informowania użytkowników o użyciu systemu AI. Te wymagania skłaniają platformy AI do większej przejrzystości mechanizmów rankingu i kryteriów wyboru źródeł.

AmICited.com to platforma monitorująca cytowania przez AI, która śledzi, jak systemy AI, takie jak Perplexity, Google AI Overviews i ChatGPT cytują Twoją markę i treści. Zapewnia wgląd w to, które źródła pojawiają się w odpowiedziach AI, jak często Twoje treści są cytowane i jak Twoja przejrzystość rankingu wypada na tle różnych platform AI.

Śledź, jak platformy AI, takie jak Perplexity, Google AI Overviews i ChatGPT cytują Twoje treści. Zrozum przejrzystość swojego rankingu i zoptymalizuj widoczność w wyszukiwarkach AI dzięki AmICited.

Dowiedz się, dlaczego wysokie pozycje w Google nie gwarantują widoczności w AI. Poznaj różnicę między SEO a cytowaniami AI i jak zoptymalizować się pod oba kana...

Dowiedz się, dlaczego świeżość treści jest kluczowa dla widoczności w AI search. Odkryj, jak ChatGPT, Perplexity i inne silniki AI priorytetyzują świeże treści ...

Dowiedz się, jak odzyskać widoczność w AI dzięki praktycznym strategiom dla ChatGPT, Perplexity i innych wyszukiwarek AI. Popraw obecność swojej marki w odpowie...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.