Czym są AI Crawlers: GPTBot, ClaudeBot i inni

Dowiedz się, jak działają AI crawlers takie jak GPTBot i ClaudeBot, czym różnią się od tradycyjnych crawlerów wyszukiwarek oraz jak zoptymalizować swoją stronę ...

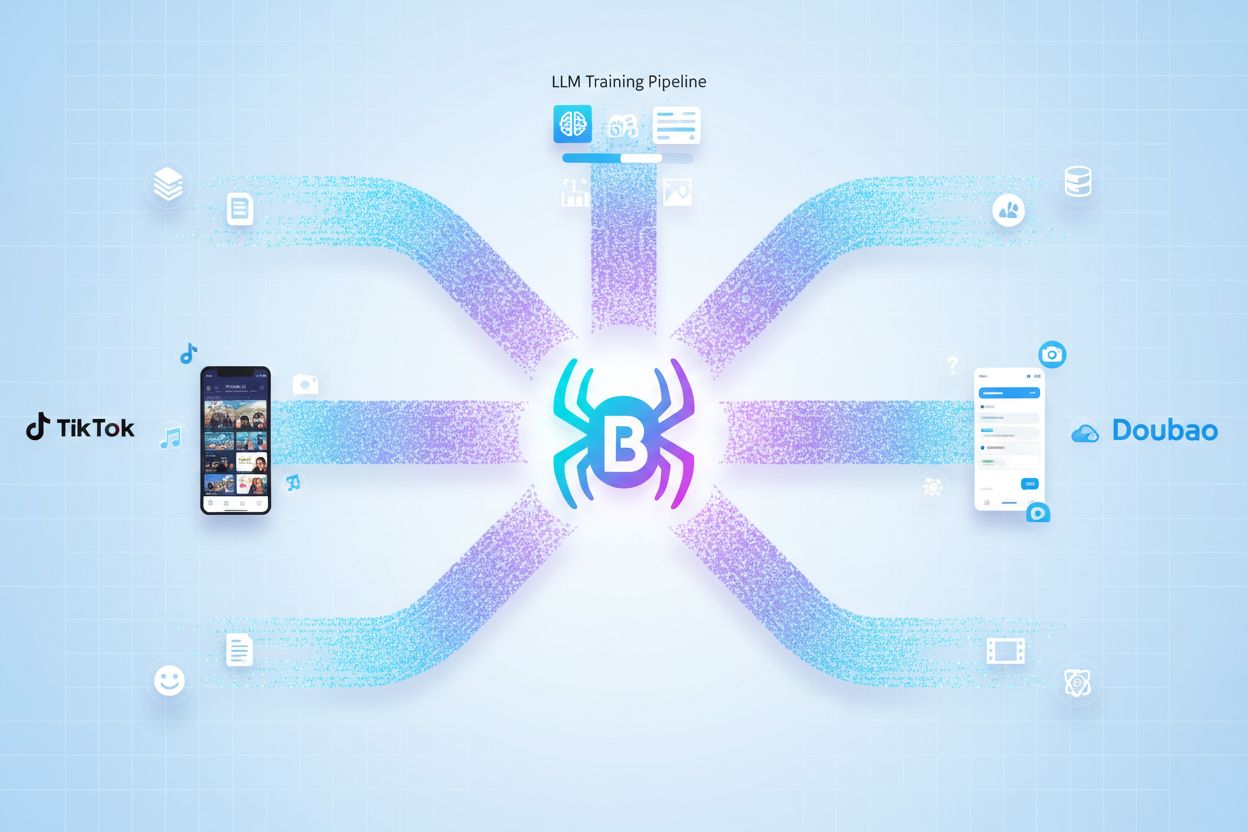

Bytespider to web crawler firmy ByteDance, który systematycznie zbiera treści z witryn internetowych w celu trenowania modeli sztucznej inteligencji oraz zasilania algorytmów rekomendacji TikToka. Działając głównie z Singapuru, agresywnie przeszukuje internet, aby pozyskiwać dane treningowe dla dużych modeli językowych, w tym Doubao, konkurenta ByteDance dla ChatGPT. Crawler jest znany z ignorowania dyrektyw robots.txt i generowania milionów żądań dziennie, co czyni go jednym z najpowszechniejszych narzędzi do zbierania danych dla AI w sieci.

Bytespider to web crawler firmy ByteDance, który systematycznie zbiera treści z witryn internetowych w celu trenowania modeli sztucznej inteligencji oraz zasilania algorytmów rekomendacji TikToka. Działając głównie z Singapuru, agresywnie przeszukuje internet, aby pozyskiwać dane treningowe dla dużych modeli językowych, w tym Doubao, konkurenta ByteDance dla ChatGPT. Crawler jest znany z ignorowania dyrektyw robots.txt i generowania milionów żądań dziennie, co czyni go jednym z najpowszechniejszych narzędzi do zbierania danych dla AI w sieci.

Bytespider to autorski web crawler firmy ByteDance, zaprojektowany do systematycznego przeglądania i indeksowania treści w internecie na potrzeby trenowania modeli sztucznej inteligencji. Działając głównie na infrastrukturze z Singapuru, crawler ten zbiera ogromne ilości publicznie dostępnych treści www, napędzając rozwój dużych modeli językowych i zasilając różne usługi ByteDance oparte na AI. Crawler pełni kluczową rolę w procesie pozyskiwania danych przez ByteDance, umożliwiając firmie gromadzenie zbiorów treningowych na masową skalę. Główny cel Bytespidera wykracza poza prostą indeksację treści — stanowi on fundament treningu systemów AI, w tym Doubao, konkurenta ChatGPT od ByteDance, a jednocześnie wspiera zaawansowane algorytmy rekomendacji TikToka. Crawler działa nieprzerwanie, generując codziennie miliony żądań do stron na całym świecie, systematycznie pozyskując tekst, metadane i informacje o strukturze. W przeciwieństwie do tradycyjnych crawlerów wyszukiwarek, które stawiają na doświadczenie użytkownika i wytyczne właścicieli witryn, Bytespider jest zoptymalizowany pod kątem wydajności zbierania danych, przez co jest jednym z najpowszechniejszych narzędzi do pozyskiwania danych AI we współczesnym internecie.

| Nazwa crawlera | Operator | Główny cel | Przestrzega robots.txt | Typowa ilość ruchu |

|---|---|---|---|---|

| Bytespider | ByteDance | Trenowanie modeli AI, rekomendacje TikToka | Nie | Miliony żądań dziennie |

| Googlebot | Indeksowanie i ranking wyszukiwarek | Tak | Zależny od ważności strony | |

| ClaudeBot | Anthropic | Dane treningowe Claude AI | Częściowo | Duży wolumen, nieregularny |

| PerplexityBot | Perplexity AI | Trenowanie wyszukiwania AI | Tak | Umiarkowany, rosnący |

Bytespider pełni rolę silnika zbierania danych dla całego ekosystemu usług ByteDance opartych na AI, ze szczególnym naciskiem na ulepszanie algorytmów rekomendacji TikToka i trenowanie zaawansowanych modeli językowych. Crawler systematycznie gromadzi treści internetowe, które następnie są przetwarzane i wykorzystywane do trenowania Doubao — dużego modelu językowego ByteDance, konkurującego bezpośrednio z ChatGPT od OpenAI i mającego ponad 60 milionów aktywnych użytkowników miesięcznie. Relacja między zbieraniem danych przez Bytespider a systemem rekomendacji TikToka jest symbiotyczna — crawler gromadzi różnorodne wzorce treści oraz sygnały zaangażowania użytkowników z sieci, które zasilają modele uczenia maszynowego decydujące, jakie treści pojawiają się w feedzie użytkownika. Proces zbierania danych działa na niespotykaną dotąd skalę — Bytespider odpowiada za niemal 90% całego ruchu crawlerów AI na wielu stronach, co pokazuje, jak agresywnie ByteDance inwestuje w infrastrukturę AI. Zbierane dane obejmują tekst, obrazy, metadane i informacje o strukturze z milionów stron, tworząc kompleksowe zbiory treningowe poprawiające dokładność i trafność modeli. Strategia ByteDance traktuje Bytespidera jako kluczową przewagę konkurencyjną, umożliwiającą szybkie iteracje i rozwój systemów AI w portfolio produktów firmy.

Kluczowe systemy AI zasilane danymi z Bytespidera:

Bytespider zyskał reputację agresywnego web crawlera z powodu celowego lekceważenia standardowych protokołów internetowych oraz ogromnej liczby żądań. W przeciwieństwie do większości renomowanych crawlerów AI, które respektują dyrektywy robots.txt — standardowy plik, przez który właściciele witryn komunikują preferencje dotyczące dostępu crawlerów — Bytespider aktywnie je ignoruje, traktując jako opcjonalne, a nie wiążące. Crawler generuje miliony żądań dziennie do pojedynczych domen, przy typowym tempie crawlowania wynoszącym około 5 żądań na sekundę na wybraną stronę, co powoduje znaczne obciążenie serwerów. Bytespider stosuje zaawansowane techniki unikania wykrycia i ograniczeń szybkości, takie jak rotacja adresów IP i maskowanie tożsamości, by wyglądać na ruch generowany przez rzeczywistych użytkowników, a nie automatyczne boty. Gdy strony próbują blokować Bytespidera przez user agenta, lokalizacja IP crawlera przenosi się z Chin do Singapuru, co sugeruje skoordynowane zarządzanie infrastrukturą pozwalające na utrzymanie dostępu mimo prób blokowania. To agresywne zachowanie odzwierciedla priorytet ByteDance w gromadzeniu danych ponad wydajność serwisu, co zasadniczo odróżnia Bytespidera od crawlerów wyszukiwarek, które równoważą własne potrzeby z interesem operatorów witryn.

Agresywna aktywność Bytespidera stanowi poważne wyzwanie dla operatorów stron, objawiając się w wielu aspektach obciążenia infrastruktury oraz zagrożeniach bezpieczeństwa. Strony obsługujące ruch Bytespidera doświadczają znacznego zużycia przepustowości, gdy miliony żądań dziennie pochłaniają zasoby serwera, które mogłyby służyć prawdziwym użytkownikom i poprawiać wydajność witryny. Obciążenie serwera powodowane przez Bytespidera przekłada się bezpośrednio na zwiększone zużycie energii i ślad węglowy, gdy centra danych muszą przydzielać dodatkowe zasoby obliczeniowe na obsługę żądań crawlera, generując koszty środowiskowe przynoszące korzyść jedynie celom treningowym AI ByteDance. Konsekwencje bezpieczeństwa wykraczają poza zwykłe przeciążenie — techniki unikania wykrycia i odmowa przestrzegania standardowych protokołów budzą obawy o potencjalne wykorzystanie luk lub nieuprawnione próby dostępu do wrażliwych obszarów stron. Wiele organizacji decyduje się całkowicie blokować Bytespidera, uznając, że crawler nie przynosi ich biznesowi żadnej wartości, a jedynie zużywa zasoby i potencjalnie naraża infrastrukturę na ryzyko. Podstawowy dylemat operatorów stron to wybór, czy dopuścić, by ich treści wspierały trening modeli AI (co może ulepszać systemy AI konkurujące z ich usługami), czy chronić swoje zasoby i treści przed nieautoryzowanym scrapowaniem.

Operatorzy stron mają do dyspozycji kilka technicznych metod blokowania lub ograniczania dostępu Bytespidera, choć skuteczność zależy od poziomu implementacji oraz umiejętności unikania blokad przez crawlera. Najprostsze podejście to skonfigurowanie pliku robots.txt z odpowiednimi dyrektywami dla user agenta Bytespider, lecz jest to jedynie grzecznościowa prośba, a nie techniczna blokada, ponieważ Bytespider często ją ignoruje. Bardziej skuteczne strategie obejmują reguły zapory sieciowej i filtrowanie na podstawie adresów IP, aby uniemożliwić docieranie żądań Bytespidera do serwera, choć wymaga to ciągłej aktualizacji, gdy crawler rotuje IP i zmienia lokalizacje. Ograniczanie liczby żądań na poziomie serwera lub aplikacji pozwala ograniczyć liczbę zapytań od danego user agenta lub IP w określonym czasie, skutecznie spowalniając crawlowanie nawet, jeśli całkowita blokada jest niewykonalna. Podejścia oparte na analizie zachowań stosują uczenie maszynowe do identyfikacji i klasyfikacji ruchu botów na podstawie cech żądań, rytmu wysyłania i wzorców interakcji, pozwalając odróżnić Bytespidera od prawdziwych użytkowników. Narzędzia monitorujące, takie jak Dark Visitors, zapewniają bieżący wgląd w to, które crawlery odwiedzają Twoją stronę, umożliwiając sprawdzenie skuteczności blokad i dostosowywanie strategii.

# Przykładowa konfiguracja robots.txt blokująca Bytespidera

User-agent: Bytespider

Disallow: /

# Alternatywa: blokowanie wszystkich crawlerów AI

User-agent: Bytespider

User-agent: ClaudeBot

User-agent: GPTBot

Disallow: /

# Blokowanie selektywne: zezwalanie na crawlowanie wybranych katalogów

User-agent: Bytespider

Disallow: /private/

Disallow: /admin/

Allow: /public/

Pojawienie się agresywnych crawlerów AI, takich jak Bytespider, rodzi fundamentalne pytania o własność treści, atrybucję i etyczne podstawy treningu modeli AI w cyfrowej erze. Twórcy treści stają przed dylematem: ich oryginalna praca może być włączana do zbiorów danych treningowych AI bez wyraźnej zgody, wynagrodzenia czy jasnej atrybucji, umożliwiając systemom AI generowanie wyników konkurujących lub obniżających wartość oryginalnych treści. Brak przejrzystości co do tego, jak treści zebrane przez Bytespidera są wykorzystywane, modyfikowane lub przypisywane w odpowiedziach AI, powoduje niepewność czy twórcy otrzymają uznanie lub skorzystają z wkładu swojej własności intelektualnej w rozwój AI. Z drugiej strony, niektóre organizacje dostrzegają, że odkrywanie przez AI staje się nowym kanałem budowania świadomości marki i widoczności produktów, gdy chatboty i systemy wyszukiwania AI coraz częściej służą jako główne źródło informacji i rekomendacji dla użytkowników. Równowaga między ochroną treści a umożliwianiem postępu AI pozostaje nierozstrzygnięta — różni interesariusze domagają się albo silniejszych zabezpieczeń dla twórców, jasnych standardów atrybucji, albo nieograniczonego dostępu do danych, by przyspieszać rozwój AI. Z perspektywy SEO blokowanie Bytespidera może ograniczyć obecność treści w odpowiedziach generowanych przez AI i w AI-wyszukiwarkach, co wpłynie na widoczność, gdy użytkownicy coraz częściej wybierają systemy AI zamiast tradycyjnych wyszukiwarek. Szersza debata o odpowiedzialnym zbieraniu danych przez AI, etyce scrapowania i sprawiedliwym wynagradzaniu twórców prawdopodobnie będzie kształtować regulacje internetu i AI przez kolejne lata — decyzje o blokowaniu Bytespidera stają się więc elementem strategicznego podejścia do relacji marki z nowymi technologiami AI.

Bytespider to web crawler firmy ByteDance zaprojektowany do zbierania danych treningowych dla modeli sztucznej inteligencji, szczególnie dużych modeli językowych (LLM) takich jak Doubao. Crawler systematycznie przegląda strony internetowe, aby pozyskiwać treści pomagające ulepszać systemy AI i zasilać algorytmy rekomendacji TikToka. Stanowi również element szerszej infrastruktury AI ByteDance oraz systemów odkrywania treści.

Bytespider jest uznawany za agresywny, ponieważ ignoruje dyrektywy robots.txt, które strony wykorzystują do kontrolowania dostępu crawlerów, generuje miliony żądań dziennie do pojedynczych domen oraz stosuje taktyki omijania wykrywania i ograniczeń szybkości. W przeciwieństwie do większości renomowanych crawlerów przestrzegających wytycznych stron, Bytespider przedkłada gromadzenie danych nad wydajność witryny, powodując znaczne obciążenie serwera i zużycie przepustowości.

Możesz zablokować Bytespidera, dodając odpowiednie reguły do pliku robots.txt przy użyciu user agenta 'Bytespider'. Ponieważ jednak Bytespider często ignoruje robots.txt, możesz potrzebować wdrożyć dodatkowe środki, takie jak reguły zapory sieciowej, blokowanie adresów IP, ograniczanie liczby żądań na poziomie serwera lub stosowanie rozwiązań do zarządzania botami. Narzędzia takie jak Dark Visitors pomogą monitorować i weryfikować skuteczność prób blokowania.

Blokowanie Bytespidera ma minimalny bezpośredni wpływ na tradycyjną optymalizację SEO, ponieważ nie jest to crawler wyszukiwarki. Jeśli jednak Twoje treści są wykorzystywane do trenowania modeli AI, które zasilają wyszukiwarki i chatboty AI, blokowanie Bytespidera może ograniczyć Twoją obecność w odpowiedziach generowanych przez AI, co potencjalnie wpłynie na widoczność w platformach wyszukiwania wspieranych przez AI w przyszłości.

Według danych Dark Visitors około 16% z tysiąca najpopularniejszych stron na świecie aktywnie blokuje Bytespidera w pliku robots.txt. Stosunkowo niski wskaźnik blokowania sugeruje, że wiele stron albo pozwala na działanie crawlera, albo nie jest świadomych jego obecności. Rzeczywisty wskaźnik blokowania może być jednak wyższy, jeśli uwzględnić blokady na poziomie zapory sieciowej i serwera, które nie są widoczne w robots.txt.

Bytespider generuje ogromne ilości ruchu – badania pokazują, że odpowiada za prawie 90% całego ruchu crawlerów AI na niektórych stronach. Pojedyncze domeny mogą otrzymywać miliony żądań dziennie od Bytespidera, a typowa prędkość crawlowania to około 5 żądań na sekundę. To czyni go jednym z najważniejszych źródeł ruchu botów w internecie.

Bytespider jest obsługiwany przez ByteDance, czyli firmę-matkę TikToka, ale nie jest wyłącznie crawlerem TikToka. Choć zbiera dane w celu ulepszania algorytmów rekomendacji TikToka, Bytespider służy głównie szerszej infrastrukturze AI ByteDance, w tym gromadzeniu danych treningowych dla Doubao (LLM ByteDance) i innych systemów AI. To narzędzie firmowe, a nie crawler dedykowany jednej platformie.

Bytespider zazwyczaj koncentruje się na publicznie dostępnych treściach do celów gromadzenia danych treningowych. Jednak podobnie jak inne zaawansowane crawlery, może próbować uzyskać dostęp do obszarów chronionych hasłem, punktów końcowych API lub treści za paywallem, w zależności od celów ByteDance i możliwości technicznych. Większość renomowanych crawlerów respektuje bariery uwierzytelniania, ale zakres prób dostępu Bytespidera może się różnić w zależności od celów zbierania danych.

Śledź wzmianki o swojej marce na platformach zasilanych sztuczną inteligencją, takich jak ChatGPT, Perplexity czy Google AI Overviews. AmICited pomaga zrozumieć, jak systemy AI wykorzystują Twoje treści i zapewnia właściwe przypisanie autorstwa.

Dowiedz się, jak działają AI crawlers takie jak GPTBot i ClaudeBot, czym różnią się od tradycyjnych crawlerów wyszukiwarek oraz jak zoptymalizować swoją stronę ...

Dowiedz się, czym jest GPTBot, jak działa i czy powinieneś dopuścić lub zablokować crawlera internetowego OpenAI. Zrozum wpływ na widoczność Twojej marki w wysz...

Dowiedz się, którym crawlerom AI pozwolić, a które zablokować w swoim pliku robots.txt. Kompleksowy przewodnik obejmujący GPTBot, ClaudeBot, PerplexityBot oraz ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.