Wielomodalne wyszukiwanie AI: Optymalizacja pod kątem zapytań obrazowych i głosowych

Opanuj optymalizację wielomodalnego wyszukiwania AI. Dowiedz się, jak optymalizować obrazy i zapytania głosowe pod wyniki wyszukiwania wspierane przez AI, ze st...

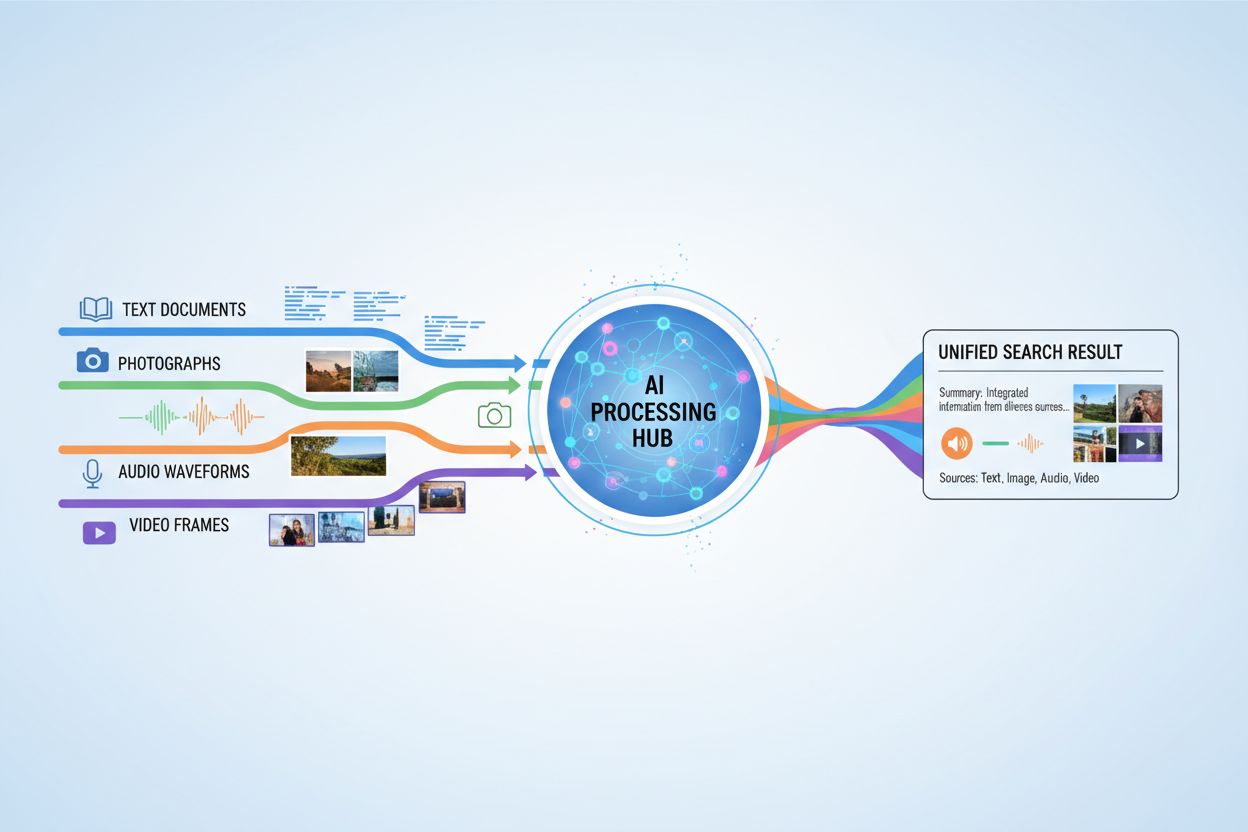

Systemy AI, które jednocześnie przetwarzają i odpowiadają na zapytania obejmujące tekst, obrazy, dźwięk i wideo, umożliwiając pełniejsze zrozumienie i kontekstowe odpowiedzi na podstawie wielu typów danych.

Systemy AI, które jednocześnie przetwarzają i odpowiadają na zapytania obejmujące tekst, obrazy, dźwięk i wideo, umożliwiając pełniejsze zrozumienie i kontekstowe odpowiedzi na podstawie wielu typów danych.

Wielomodalne wyszukiwanie AI odnosi się do systemów sztucznej inteligencji, które jednocześnie przetwarzają i integrują informacje z różnych typów danych, czyli modalności—takich jak tekst, obrazy, dźwięk i wideo—aby dostarczyć pełniejsze i bardziej kontekstowe wyniki. W przeciwieństwie do AI unimodalnego, polegającego na jednym typie wejścia (np. wyszukiwarki tylko tekstowe), systemy wielomodalne wykorzystują komplementarne zalety różnych formatów danych, osiągając głębsze zrozumienie i dokładniejsze rezultaty. Takie podejście odzwierciedla ludzką percepcję, gdzie naturalnie łączymy informacje wizualne, dźwiękowe i tekstowe, aby zrozumieć otoczenie. Przetwarzając różnorodne typy wejścia wspólnie, systemy wielomodalnego wyszukiwania AI są w stanie wychwycić niuanse i powiązania niedostępne dla podejść jednokanałowych.

Wielomodalne wyszukiwanie AI opiera się na zaawansowanych technikach fuzji, które łączą informacje z różnych modalności na różnych etapach przetwarzania. System najpierw niezależnie wyodrębnia cechy z każdej modalności, a następnie strategicznie łączy te reprezentacje, tworząc spójne zrozumienie. Moment i metoda fuzji mają istotny wpływ na wydajność, co ilustruje poniższe porównanie:

| Typ fuzji | Kiedy stosowana | Zalety | Wady |

|---|---|---|---|

| Fuzja wczesna | Etap wejścia | Wychwytuje korelacje niskiego poziomu | Mniej odporna na brak synchronizacji |

| Fuzja środkowa | Etap przetwarzania wstępnego | Zrównoważone podejście | Bardziej złożona |

| Fuzja późna | Poziom wyjścia | Modularna budowa | Mniejsza spójność kontekstu |

Fuzja wczesna natychmiast łączy surowe dane, wychwytując drobne interakcje, ale gorzej radzi sobie z niesynchronizowanymi wejściami. Fuzja środkowa odbywa się na etapie przetwarzania pośredniego, oferując kompromis między złożonością a wydajnością. Fuzja późna działa na poziomie wyjścia, umożliwiając niezależne przetwarzanie modalności, ale potencjalnie tracąc ważny kontekst między-modalnościowy. Wybór strategii fuzji zależy od specyfiki zastosowania i rodzaju przetwarzanych danych.

Kilka kluczowych technologii napędza współczesne systemy wielomodalnego wyszukiwania AI, umożliwiając efektywne przetwarzanie i integrację różnorodnych typów danych:

Te technologie współdziałają, tworząc systemy zdolne do zrozumienia złożonych relacji między różnymi typami informacji.

Wielomodalne wyszukiwanie AI znajduje przełomowe zastosowania w wielu branżach i dziedzinach. W ochronie zdrowia systemy analizują obrazy medyczne wraz z dokumentacją pacjenta i notatkami klinicznymi, poprawiając trafność diagnoz i rekomendacji leczenia. Platformy e-commerce wykorzystują wyszukiwanie wielomodalne, umożliwiając klientom odnajdywanie produktów przez łączenie opisów tekstowych z odniesieniami wizualnymi lub nawet szkicami. Pojazdy autonomiczne polegają na fuzji danych z kamer, radarów i czujników, by bezpiecznie się poruszać i podejmować decyzje w czasie rzeczywistym. Systemy moderacji treści łączą rozpoznawanie obrazów, analizę tekstu i przetwarzanie dźwięku, skuteczniej identyfikując szkodliwe treści niż podejścia jednokanałowe. Ponadto, wyszukiwanie wielomodalne zwiększa dostępność, pozwalając użytkownikom wyszukiwać za pomocą preferowanej metody wejścia—głosu, obrazu lub tekstu—podczas gdy system rozumie intencje we wszystkich formatach.

Wielomodalne wyszukiwanie AI przynosi znaczące korzyści, które uzasadniają jego większą złożoność i wymagania obliczeniowe. Wyższa dokładność wynika z wykorzystania komplementarnych źródeł informacji, co zmniejsza liczbę błędów typowych dla systemów jednokanałowych. Lepsze zrozumienie kontekstu pojawia się, gdy informacje wizualne, tekstowe i dźwiękowe łączą się, nadając bogatsze znaczenie semantyczne. Lepsze doświadczenie użytkownika osiągane jest dzięki intuicyjnym interfejsom wyszukiwania, akceptującym różne typy wejścia i dostarczającym trafniejsze wyniki. Uczenie międzydziedzinowe umożliwia transfer wiedzy z jednej modalności do drugiej, co pozwala na wykorzystanie doświadczeń pomiędzy różnymi typami danych. Zwiększona odporność oznacza, że system utrzymuje wydajność nawet w przypadku degradacji lub braku jednej z modalności, ponieważ pozostałe mogą kompensować brakujące informacje.

Pomimo zalet, wielomodalne wyszukiwanie AI napotyka istotne wyzwania techniczne i praktyczne. Wyrównanie i synchronizacja danych pozostają trudne, ponieważ różne modalności mają często odmienne cechy czasowe i poziomy jakości, które trzeba odpowiednio zarządzać. Złożoność obliczeniowa znacznie wzrasta przy jednoczesnym przetwarzaniu wielu strumieni danych, wymagając dużych zasobów i specjalistycznego sprzętu. Stronniczość i sprawiedliwość mogą być problemem, jeśli dane treningowe są niezrównoważone między modalnościami lub gdy określone grupy są niedostatecznie reprezentowane w konkretnych typach danych. Prywatność i bezpieczeństwo stają się bardziej złożone przy wielu strumieniach danych, powiększając powierzchnię potencjalnych naruszeń i wymagając ostrożnego zarządzania informacjami wrażliwymi. Ogromne wymagania dotyczące danych sprawiają, że skuteczne trenowanie systemów wielomodalnych wymaga znacznie większych i bardziej zróżnicowanych zbiorów danych niż w przypadku alternatyw jednokanałowych, co bywa kosztowne i czasochłonne.

Wielomodalne wyszukiwanie AI ma istotne znaczenie dla monitoringu AI i śledzenia cytowań, zwłaszcza że systemy AI coraz częściej generują odpowiedzi odnoszące się do informacji z wielu źródeł. Platformy takie jak AmICited.com specjalizują się w monitorowaniu, jak systemy AI cytują i przypisują informacje do oryginalnych źródeł, zapewniając przejrzystość i rozliczalność generowanych przez AI odpowiedzi. Podobnie, FlowHunt.io śledzi generowanie treści przez AI i pomaga organizacjom zrozumieć, jak ich markowe treści są przetwarzane i przywoływane przez systemy wielomodalnego AI. W miarę upowszechniania się wielomodalnego wyszukiwania AI, śledzenie, w jaki sposób systemy te cytują marki, produkty i oryginalne źródła, staje się kluczowe dla firm, które chcą poznać swoją widoczność w wynikach generowanych przez AI. Możliwość monitorowania pomaga organizacjom upewnić się, że ich treści są właściwie reprezentowane i prawidłowo przypisywane, gdy wielomodalne systemy AI syntezują informacje z tekstu, obrazów i innych modalności.

Przyszłość wielomodalnego wyszukiwania AI zmierza w kierunku coraz bardziej zintegrowanego i płynnego łączenia różnorodnych typów danych, wykraczając poza obecne podejścia do fuzji na rzecz bardziej holistycznych modeli, które traktują wszystkie modalności jako wzajemnie powiązane. Zdolności przetwarzania w czasie rzeczywistym będą się rozwijać, umożliwiając wielomodalne wyszukiwanie na strumieniach wideo na żywo, ciągłym dźwięku i dynamicznym tekście bez opóźnień. Zaawansowane techniki augmentacji danych pozwolą przezwyciężyć obecne braki danych poprzez syntetyczne generowanie wielomodalnych przykładów treningowych z zachowaniem spójności semantycznej między modalnościami. Przyszłość przyniesie także modele bazowe trenowane na ogromnych zbiorach danych wielomodalnych, które można efektywnie dostosowywać do konkretnych zadań, neuromorficzne podejścia obliczeniowe lepiej naśladujące biologiczne przetwarzanie wielomodalne oraz federacyjne uczenie wielomodalne umożliwiające trening na rozproszonych źródłach danych z zachowaniem prywatności. Te postępy sprawią, że wielomodalne wyszukiwanie AI stanie się bardziej dostępne, wydajne i gotowe do obsługi coraz bardziej złożonych, rzeczywistych scenariuszy.

Systemy AI unimodalne przetwarzają tylko jeden typ danych wejściowych, na przykład wyszukiwarki obsługujące wyłącznie tekst. Systemy AI wielomodalne natomiast przetwarzają i integrują wiele typów danych—tekst, obrazy, dźwięk i wideo—jednocześnie, umożliwiając głębsze zrozumienie i dokładniejsze wyniki dzięki wykorzystaniu komplementarnych zalet różnych formatów danych.

Wielomodalne wyszukiwanie AI poprawia dokładność poprzez łączenie komplementarnych źródeł informacji, które wychwytują niuanse i relacje niewidoczne dla podejść jednokanałowych. Gdy informacje wizualne, tekstowe i dźwiękowe są łączone, system uzyskuje bogatsze zrozumienie semantyczne i może podejmować bardziej świadome decyzje, opierając się na wielu perspektywach tej samej informacji.

Kluczowe wyzwania to wyrównanie i synchronizacja danych między różnymi modalnościami, znaczna złożoność obliczeniowa, kwestie stronniczości i równości przy niezrównoważonych danych treningowych, problemy prywatności i bezpieczeństwa przy wielu strumieniach danych oraz ogromne wymagania dotyczące danych do skutecznego treningu. Każda modalność ma inne cechy czasowe i poziomy jakości, które muszą być odpowiednio zarządzane.

Opieka zdrowotna korzysta z analizy obrazów medycznych wraz z dokumentacją pacjenta i notatkami klinicznymi. E-commerce wykorzystuje wielomodalne wyszukiwanie do wizualnego odkrywania produktów. Pojazdy autonomiczne opierają się na wielomodalnej fuzji danych z kamer, radarów i czujników. Moderacja treści łączy analizę obrazów, tekstu i dźwięku. Systemy obsługi klienta wykorzystują różne typy wejść dla lepszego wsparcia, a aplikacje dostępności umożliwiają użytkownikom wyszukiwanie przy użyciu preferowanej metody wejścia.

Modele embeddingowe przekształcają różne modalności w numeryczne reprezentacje oddające znaczenie semantyczne. Bazy wektorowe przechowują te embeddingi we wspólnej przestrzeni matematycznej, gdzie można mierzyć i porównywać relacje między różnymi typami danych. Umożliwia to systemowi znajdowanie powiązań między tekstem, obrazami, dźwiękiem i wideo poprzez porównywanie ich pozycji w tym wspólnym semantycznym obszarze.

Systemy AI wielomodalne obsługują wiele wrażliwych typów danych—nagrania rozmów, dane rozpoznawania twarzy, komunikację pisemną i obrazy medyczne—co zwiększa ryzyko naruszenia prywatności. Połączenie różnych modalności stwarza więcej okazji do wycieków danych i wymaga ścisłego przestrzegania regulacji takich jak RODO czy CCPA. Organizacje muszą wdrożyć solidne środki bezpieczeństwa, aby chronić tożsamość użytkowników i wrażliwe informacje we wszystkich modalnościach.

Platformy takie jak AmICited.com monitorują, jak systemy AI cytują i przypisują informacje do oryginalnych źródeł, zapewniając przejrzystość generowanych przez AI odpowiedzi. Organizacje mogą śledzić swoją widoczność w wynikach wielomodalnych wyszukiwarek AI, sprawdzać, czy ich treści są poprawnie reprezentowane i potwierdzać właściwe przypisanie, gdy systemy AI syntezują informacje z tekstu, obrazów i innych modalności.

Przyszłość obejmuje zunifikowane modele, które traktują wszystkie modalności jako wzajemnie powiązane, przetwarzanie w czasie rzeczywistym strumieni wideo i dźwięku na żywo, zaawansowane techniki augmentacji danych pozwalające przezwyciężyć braki danych, modele bazowe trenowane na ogromnych zbiorach wielomodalnych, podejścia neuromorficzne naśladujące biologiczne przetwarzanie oraz federacyjne uczenie, które zachowuje prywatność podczas treningu na rozproszonych źródłach.

Śledź, jak wielomodalne wyszukiwarki AI cytują i przypisują Twoje treści w tekście, obrazach i innych modalnościach dzięki kompleksowej platformie monitorowania AmICited.

Opanuj optymalizację wielomodalnego wyszukiwania AI. Dowiedz się, jak optymalizować obrazy i zapytania głosowe pod wyniki wyszukiwania wspierane przez AI, ze st...

Dowiedz się, czym jest treść multimodalna dla AI, jak działa i dlaczego jest ważna. Poznaj przykłady systemów AI multimodalnej i ich zastosowania w różnych bran...

Dowiedz się, jak optymalizować tekst, obrazy i wideo dla systemów AI multimodalnej. Poznaj strategie poprawy cytowań AI i widoczności w ChatGPT, Gemini i Perple...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.