Jakie Czynniki Zaufania Wykorzystują Silniki AI do Oceny Źródeł

Dowiedz się, jak silniki AI, takie jak ChatGPT, Perplexity i Google AI, oceniają wiarygodność źródeł. Poznaj E-E-A-T, autorytet domeny, częstotliwość cytowań or...

Ocena wiarygodności treści przez AI na podstawie kwalifikacji autora, cytowań i weryfikacji. Ocena wiarygodności źródła systematycznie analizuje wiele wymiarów, w tym wiedzę ekspercką autora, renomę wydawcy, wzorce cytowań oraz wyniki weryfikacji faktów, aby określić, czy dane źródła zasługują na włączenie do badań, baz wiedzy lub podsumowań generowanych przez AI. Ten zautomatyzowany proces pozwala platformom na skalowanie oceny wiarygodności na miliony źródeł przy zachowaniu spójności, której sami recenzenci ludzcy nie mogą osiągnąć.

Ocena wiarygodności treści przez AI na podstawie kwalifikacji autora, cytowań i weryfikacji. Ocena wiarygodności źródła systematycznie analizuje wiele wymiarów, w tym wiedzę ekspercką autora, renomę wydawcy, wzorce cytowań oraz wyniki weryfikacji faktów, aby określić, czy dane źródła zasługują na włączenie do badań, baz wiedzy lub podsumowań generowanych przez AI. Ten zautomatyzowany proces pozwala platformom na skalowanie oceny wiarygodności na miliony źródeł przy zachowaniu spójności, której sami recenzenci ludzcy nie mogą osiągnąć.

Ocena wiarygodności źródła to systematyczna analiza źródeł informacji w celu określenia ich rzetelności, wiarygodności i autorytetu w dostarczaniu prawdziwych danych. W kontekście systemów wspomaganych przez AI, ocena wiarygodności polega na analizie wielu wymiarów źródła, by ustalić, czy jego treść zasługuje na włączenie do badań, cytowań lub baz wiedzy. Ocena wiarygodności przez AI działa poprzez badanie kwalifikacji autora—w tym wykształcenia, doświadczenia zawodowego i wiedzy eksperckiej—wraz ze wzorami cytowań wskazującymi, jak często i pozytywnie inne autorytatywne źródła odnoszą się do tej pracy. Proces obejmuje ocenę mechanizmów weryfikacyjnych takich jak status recenzji naukowej, powiązania instytucjonalne czy renoma miejsca publikacji, by ustalić podstawowy poziom zaufania. Sygnały wiarygodności to mierzalne wskaźniki wykrywane i ważone przez systemy AI, obejmujące zarówno jawne oznaczenia, jak kwalifikacje autora, jak i ukryte sygnały wywodzące się z analizy tekstu i wzorców metadanych. Współczesne systemy AI rozumieją, że wiarygodność jest wielowymiarowa; źródło może być bardzo wiarygodne w jednej dziedzinie, ale pozbawione autorytetu w innej, co wymaga oceny kontekstowej. Proces oceny staje się coraz ważniejszy wraz z rosnącą liczbą informacji i gwałtownym rozprzestrzenianiem się dezinformacji w internecie. Automatyczna ocena wiarygodności umożliwia platformom skalowanie oceny na miliony źródeł przy zachowaniu spójności, której sami recenzenci ludzcy nie są w stanie zapewnić. Zrozumienie działania tych systemów pomaga twórcom treści, naukowcom i wydawcom optymalizować swoje źródła pod kątem rozpoznawania wiarygodności oraz pozwala odbiorcom podejmować świadome decyzje dotyczące zaufania do informacji.

Systemy AI oceniają wiarygodność źródeł poprzez zaawansowaną analizę wielosygnałową łączącą przetwarzanie języka naturalnego, modele uczenia maszynowego i ocenę danych strukturalnych. Wykrywanie sygnałów wiarygodności identyfikuje konkretne wskaźniki w tekście, metadanych i wzorcach sieciowych, które korelują z rzetelną informacją; sygnały te są ważone w zależności od przewidywanej wartości dla dokładności. Analiza NLP bada wzorce językowe, gęstość cytowań, specyficzność twierdzeń i pewność języka, by ocenić, czy treść wykazuje cechy rygorystycznych badań, czy też przejawia właściwości typowe dla źródeł nierzetelnych. Modele uczenia maszynowego wytrenowane na dużych zbiorach wiarygodnych i niewiarygodnych źródeł uczą się rozpoznawać złożone wzorce niewidoczne dla ludzi, umożliwiając ocenę w czasie rzeczywistym na dużą skalę. Integracja z fact-checkingiem polega na porównywaniu twierdzeń z bazami zweryfikowanych faktów, wykrywaniu sprzeczności lub niepopartych stwierdzeń obniżających ocenę wiarygodności. Systemy te stosują metody zespołowe łączące różne podejścia, uznając, że żaden pojedynczy sygnał nie przewidzi w pełni wiarygodności. Poniższa tabela ilustruje główne kategorie sygnałów analizowanych przez systemy AI:

| Typ sygnału | Co mierzy | Przykłady |

|---|---|---|

| Sygnały akademickie | Status recenzji, miejsce publikacji, afiliacja instytucjonalna | Współczynnik wpływu czasopisma, ranga konferencji, renoma uczelni |

| Sygnały tekstowe | Jakość pisania, gęstość cytowań, specyficzność twierdzeń, wzorce językowe | Poprawne cytowania, terminologia techniczna, twierdzenia oparte na dowodach |

| Sygnały metadanych | Kwalifikacje autora, data publikacji, częstotliwość aktualizacji, historia źródła | Stopnie naukowe autora, oś czasu publikacji, historia poprawek |

| Sygnały społeczne | Liczba cytowań, wzorce udostępnień, rekomendacje ekspertów, zaangażowanie społeczności | Cytowania w Google Scholar, wzmianki w sieci akademickiej, rekomendacje kolegów |

| Sygnały weryfikacyjne | Wyniki fact-checkingu, potwierdzanie twierdzeń, przejrzystość źródła | Weryfikacja przez Snopes, wiele niezależnych potwierdzeń, ujawnienie metodologii |

| Sygnały strukturalne | Organizacja treści, przejrzystość metodologii, ujawnianie konfliktu interesów | Wyraźne sekcje, transparentne metody, jawne źródła finansowania |

Najbardziej wpływowe czynniki wiarygodności oceniane przez systemy AI obejmują wiele powiązanych wymiarów budujących rzetelność źródła. Renoma autora jest podstawowym wskaźnikiem wiarygodności—uznani eksperci w swojej dziedzinie mają znacznie większą wagę niż nieznani twórcy. Renoma wydawcy rozszerza ocenę na kontekst instytucjonalny; źródła publikowane w recenzowanych czasopismach lub renomowanych wydawnictwach naukowych wykazują wyższy podstawowy poziom wiarygodności. Wzorce cytowań ujawniają, jak szersza społeczność naukowa odniosła się do źródła—prace często cytowane w prestiżowych miejscach są postrzegane jako zweryfikowane przez środowisko. Aktualność jest istotna kontekstowo—najnowsze publikacje świadczą o aktualnej wiedzy, podczas gdy starsze prace fundamentowe zachowują wiarygodność ze względu na historyczny wpływ i ciągłą istotność. Algorytmy wykrywania stronniczości analizują, czy źródła ujawniają potencjalne konflikty interesów, źródła finansowania lub pozycje ideologiczne mogące wpływać na wnioski. Sygnały zaangażowania ze strony społeczności naukowej i zawodowej, w tym cytowania i dyskusje branżowe, stanowią zewnętrzną walidację wiarygodności. Poniższe czynniki są najistotniejsze dla systemów AI:

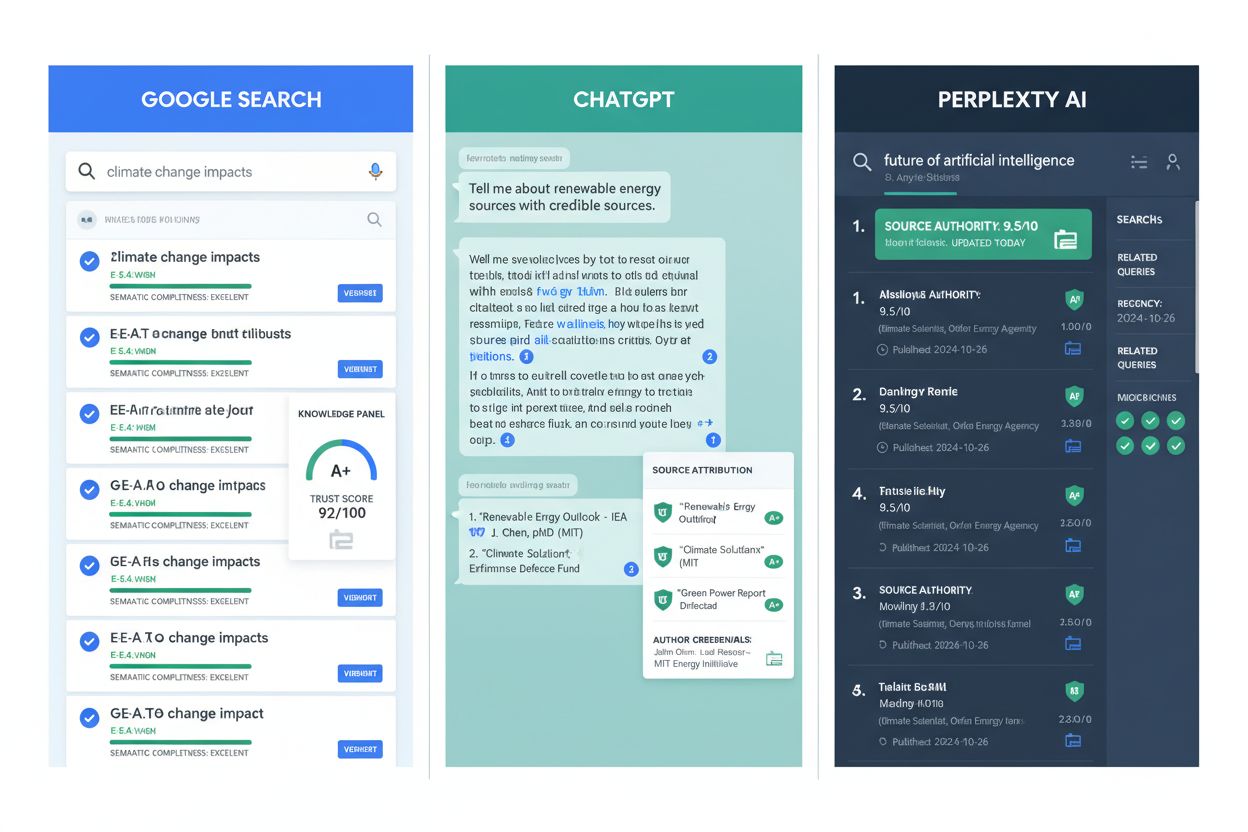

Ocena wiarygodności wspomagana przez AI stała się integralną częścią głównych platform informacyjnych i infrastruktury badawczej. Google AI Overviews wykorzystuje sygnały wiarygodności do wyboru źródeł widocznych w podsumowaniach generowanych przez AI, faworyzując treści od renomowanych wydawców i zweryfikowanych ekspertów. ChatGPT i podobne modele językowe stosują ocenę wiarygodności podczas treningu, odpowiednio ważąc źródła, choć napotykają trudności z oceną wiarygodności nowych twierdzeń w czasie rzeczywistym. Perplexity AI jawnie uwzględnia wiarygodność źródła przy cytowaniu, prezentując renomę źródła obok wyników wyszukiwania, co pomaga użytkownikom ocenić jakość informacji. W badaniach naukowych narzędzia oceny wiarygodności pomagają naukowcom szybciej identyfikować wysokiej jakości źródła, skracając czas przeglądu literatury i podnosząc jakość podstawy badawczej. Inicjatywy archiwizujące treści wykorzystują ocenę wiarygodności do wyboru autorytatywnych źródeł do zachowania dla przyszłych pokoleń badaczy. AmICited.com pełni funkcję monitorującą, śledząc, jak źródła są cytowane i oceniane na różnych platformach, pomagając wydawcom zrozumieć swoją pozycję wiarygodności i wskazując możliwości jej poprawy. Organizacje fact-checkingowe wykorzystują automatyczną ocenę wiarygodności do priorytetyzacji twierdzeń do ręcznej weryfikacji, skupiając zasoby na dezinformacji o największym zasięgu. Instytucje edukacyjne coraz częściej stosują narzędzia oceny wiarygodności, by uczyć studentów analizy źródeł, czyniąc kryteria oceny jawnymi i mierzalnymi. Przykłady te pokazują, że ocena wiarygodności stała się nie tylko ramą teoretyczną, ale praktyczną infrastrukturą wspierającą jakość informacji w ekosystemach cyfrowych.

Pomimo znacznych postępów, automatyczna ocena wiarygodności napotyka poważne ograniczenia wymagające nadzoru ludzkiego i oceny kontekstowej. Stronniczość sygnałów zaangażowania stanowi kluczowe wyzwanie—popularne źródła mogą otrzymywać wysokie oceny na podstawie sygnałów społecznych, mimo że zawierają nieprawdziwe informacje, ponieważ wskaźniki zaangażowania są niedoskonałym miernikiem rzetelności. Fałszywe pozytywy i negatywy pojawiają się, gdy algorytmy błędnie klasyfikują źródła—uznani eksperci w nowych dziedzinach mogą mieć zbyt mało cytowań, a twórcy dezinformacji potrafią generować przekonujące sygnały wiarygodności. Ewolucja technik dezinformacji polega na świadomym wykorzystywaniu słabości systemów oceny—tworzenie fałszywych kwalifikacji autorów czy sztucznych cytowań może zmylić automat. Zróżnicowanie wiarygodności w zależności od dziedziny sprawia, że źródło rzetelne w jednej branży może nie mieć autorytetu w innej, lecz systemy często stosują jednolite oceny. Dynamika czasowa utrudnia ocenę; źródła wiarygodne w momencie publikacji mogą się zdezaktualizować lub zdyskredytować wraz z pojawieniem się nowych danych, wymuszając ciągłą reewaluację zamiast statycznego oceniania. Stronniczość kulturowa i językowa w danych treningowych prowadzi do niedoceniania źródeł spoza świata anglojęzycznego lub z mniejszościowych społeczności, utrwalając istniejące hierarchie informacji. Brak przejrzystości wielu algorytmów oceny ogranicza możliwość zrozumienia przez wydawców, jak poprawić swoje sygnały wiarygodności, oraz przez użytkowników, dlaczego dane źródło otrzymało daną ocenę. Ograniczenia te pokazują, że automatyczna ocena wiarygodności powinna uzupełniać, a nie zastępować krytyczną ocenę ludzką.

Twórcy treści i wydawcy mogą znacząco poprawić swoje sygnały wiarygodności wdrażając praktyki oparte na dowodach, zgodne z kryteriami oceny AI. Wdrażanie zasad E-E-A-T—czyli Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność—poprzez wyraźne prezentowanie kwalifikacji autorów, powiązań zawodowych i istotnych kompetencji na stronach z treściami. Poprawne praktyki cytowania wzmacniają wiarygodność poprzez odwoływanie się do źródeł wysokiej jakości, stosowanie spójnych formatów cytowań i zapewnianie, że wszystkie twierdzenia mają potwierdzenie w dowodach; to sygnalizuje, że treść opiera się na ugruntowanej wiedzy, a nie spekulacjach. Przejrzystość metodologii ułatwia systemom AI rozpoznanie rzetelnych praktyk badawczych—należy jasno wyjaśniać źródła danych, metody badawcze, ograniczenia oraz potencjalne konflikty interesów. Prowadzenie profili autorów z dokładnymi biogramami, historią publikacji i kwalifikacjami zawodowymi, które systemy AI mogą zweryfikować i ocenić. Regularna aktualizacja treści świadczy o trosce o rzetelność; przestarzałe informacje obniżają ocenę wiarygodności, a częste korekty sygnalizują śledzenie rozwoju wiedzy w danej dziedzinie. Jawne ujawnianie źródeł finansowania i powiązań—przejrzystość potencjalnych stronniczości zwiększa wiarygodność, bo AI uznaje, że ujawnione konflikty są mniej problematyczne niż ukryte. Budowanie autorytetu cytacyjnego poprzez publikacje w renomowanych miejscach, recenzje naukowe i uzyskiwanie cytowań z innych wiarygodnych źródeł; to wzmacnia pozytywną pętlę wiarygodności. Zaangażowanie w społeczność zawodową poprzez konferencje, współpracę i dyskusje branżowe, gdyż sygnały zaangażowania potwierdzają ekspertyzę i zwiększają widoczność w systemach oceny. Wdrażanie oznakowania danych strukturalnych (np. schema.org) pomaga AI automatycznie wydobywać i weryfikować informacje o autorach, datach publikacji i innych sygnałach wiarygodności.

Ewolucja oceny wiarygodności źródeł będzie coraz silniej opierać się na ocenie multimodalnej, analizującej jednocześnie tekst, obrazy, wideo i dźwięk w celu wykrywania zaawansowanej dezinformacji wykorzystującej słabości analizy jednokanałowej. Systemy weryfikacji w czasie rzeczywistym będą integrowane z platformami tworzenia treści, dostarczając natychmiastową informację zwrotną o wiarygodności podczas publikacji, co pozwoli korygować błędy zanim dezinformacja się rozprzestrzeni. Śledzenie wiarygodności oparte na blockchainie umożliwi niezmienne rejestry historii źródeł, cytowań i poprawek, budując transparentne pochodzenie wiarygodności, które AI może ocenić z większym zaufaniem. Spersonalizowana ocena wiarygodności wyjdzie poza jednolite oceny, dostosowując je do poziomu wiedzy i potrzeb konkretnego użytkownika, uznając, że wiarygodność jest częściowo subiektywna i zależna od kontekstu. Integracja z grafami wiedzy pozwoli AI na ocenę źródeł nie tylko w oderwaniu, ale i w sieci powiązań z innymi informacjami, identyfikując źródła sprzeczne z ugruntowaną wiedzą lub wypełniające istotne luki. Wyjaśnialne systemy oceny AI staną się standardem, dostarczając transparentnych uzasadnień ocen, umożliwiając twórcom poprawę sygnałów, a użytkownikom zrozumienie kryteriów oceny. Systemy ciągłego uczenia się będą adaptować się do nowych technik dezinformacji w czasie rzeczywistym, aktualizując modele wraz z pojawianiem się nowych sposobów manipulacji, zamiast polegać na statycznych danych treningowych. Śledzenie wiarygodności międzyplatformowej pozwoli na budowę zunifikowanych profili wiarygodności podążających za źródłami w internecie, utrudniając dezinformatorom utrzymanie różnych reputacji na różnych platformach. Rozwój ten sprawi, że ocena wiarygodności stanie się coraz bardziej zaawansowana, przejrzysta i zintegrowana z infrastrukturą informacyjną, z której korzystają miliardy ludzi.

Ocena wiarygodności źródła to systematyczna analiza źródeł informacji w celu określenia ich rzetelności i wiarygodności. Systemy AI analizują wiele wymiarów, w tym kwalifikacje autora, renomę wydawcy, wzorce cytowań i wyniki weryfikacji faktów, aby ustalić, czy źródła zasługują na włączenie do badań, baz wiedzy lub podsumowań generowanych przez AI. Ten zautomatyzowany proces pozwala platformom na spójną ocenę milionów źródeł.

Systemy AI wykrywają sygnały wiarygodności za pomocą przetwarzania języka naturalnego, modeli uczenia maszynowego oraz analizy ustrukturyzowanych danych. Analizują sygnały akademickie (status recenzji, afiliacja instytucjonalna), sygnały tekstowe (gęstość cytowań, specyficzność twierdzeń), sygnały metadanych (kwalifikacje autora, daty publikacji), sygnały społeczne (liczba cytowań, rekomendacje ekspertów) oraz sygnały weryfikacyjne (wyniki fact-checkingu, potwierdzenia twierdzeń). Sygnały te są ważone w zależności od ich przewidywanej wartości dla dokładności.

Najważniejsze czynniki wiarygodności to renoma i wiedza ekspercka autora, renoma wydawcy, liczba i jakość cytowań, aktualność oraz terminowość, ujawnianie stronniczości i konfliktów interesów, sygnały zaangażowania społeczności zawodowej, weryfikacja źródła poprzez fact-checking, integracja z wiedzą dziedzinową, powiązania twórcy z renomowanymi instytucjami oraz częstotliwość aktualizacji. Czynniki te wspólnie budują rzetelność i wiarygodność źródła.

Wydawcy mogą poprawić wiarygodność, wdrażając zasady E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność), stosując właściwe praktyki cytowania, utrzymując przejrzystą metodologię, prezentując szczegółowe profile autorów z ich kwalifikacjami, regularnie aktualizując treści, ujawniając źródła finansowania i powiązania, budując autorytet cytacyjny poprzez recenzje naukowe, angażując się w społeczność zawodową oraz wdrażając oznakowanie danych strukturalnych ułatwiające AI ekstrakcję informacji o wiarygodności.

Automatyczna ocena wiarygodności napotyka na wyzwania, takie jak stronniczość sygnałów zaangażowania (popularne źródła mogą uzyskać wysokie oceny mimo nieścisłości), fałszywe pozytywy i negatywy, rozwijające się techniki dezinformacji naśladujące legalne źródła, zróżnicowanie wiarygodności w zależności od dziedziny, zmienność w czasie (starzenie się źródeł), stronniczość kulturowa i językowa w danych treningowych oraz problem przejrzystości algorytmów black-box. Ograniczenia te sprawiają, że ocena automatyczna powinna uzupełniać, a nie zastępować krytyczną ocenę człowieka.

Google AI Overviews priorytetyzuje źródła od uznanych wydawców i zweryfikowanych ekspertów w podsumowaniach generowanych przez AI. ChatGPT podczas treningu waży źródła w oparciu o sygnały wiarygodności. Perplexity wyraźnie prezentuje renomę źródła obok wyników wyszukiwania. AmICited.com monitoruje, jak źródła są cytowane na wszystkich głównych platformach AI, pomagając wydawcom zrozumieć ich pozycję wiarygodności i znaleźć możliwości poprawy.

Przyszłe rozwiązania obejmują multimodalną ocenę analizującą tekst, obrazy, wideo i dźwięk łącznie; systemy weryfikacji w czasie rzeczywistym zapewniające natychmiastową informację zwrotną o wiarygodności; śledzenie wiarygodności oparte na blockchainie; spersonalizowaną ocenę względem wiedzy użytkownika; integrację z grafami wiedzy; wyjaśnialne systemy AI pokazujące podstawy oceny; ciągłe uczenie się w odpowiedzi na nowe techniki dezinformacji oraz śledzenie wiarygodności między platformami budujące zunifikowane profile.

Ocena wiarygodności źródła jest kluczowa, ponieważ decyduje o tym, które źródła pojawią się w podsumowaniach generowanych przez AI, wpływa na dane treningowe AI i kształtuje, jakie informacje trafiają do miliardów ludzi. Dokładna ocena wiarygodności pomaga zapobiegać rozprzestrzenianiu się dezinformacji, zapewnia rzetelność informacji dostarczanych przez AI, wspiera jakość badań naukowych i utrzymuje zaufanie do systemów informacyjnych opartych na AI. Wraz ze wzrostem wpływu AI na pozyskiwanie informacji, ocena wiarygodności nabiera coraz większego znaczenia.

Śledź, jak Twoje źródła są cytowane i oceniane w Google AI Overviews, ChatGPT, Perplexity i Gemini. AmICited.com pomaga zrozumieć Twoją pozycję wiarygodności oraz wskazuje możliwości jej poprawy.

Dowiedz się, jak silniki AI, takie jak ChatGPT, Perplexity i Google AI, oceniają wiarygodność źródeł. Poznaj E-E-A-T, autorytet domeny, częstotliwość cytowań or...

Dowiedz się, które źródła są najczęściej cytowane przez silniki AI. Poznaj sposoby oceny wiarygodności przez ChatGPT, Google AI Overviews i Perplexity oraz prze...

Dowiedz się, jak systemy AI oceniają sygnały zaufania w ramach E-E-A-T. Poznaj czynniki wiarygodności, które pomagają LLM cytować Twoje treści i budować autoryt...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.