Renderização do Lado do Servidor vs CSR: Impacto na Visibilidade em IA

Descubra como as estratégias de renderização SSR e CSR afetam a visibilidade para crawlers de IA, citações de marca no ChatGPT e Perplexity, e sua presença gera...

Saiba por que crawlers de IA como o ChatGPT não conseguem ver conteúdo renderizado via JavaScript e como tornar seu site visível para sistemas de IA. Descubra estratégias de renderização para visibilidade em IA.

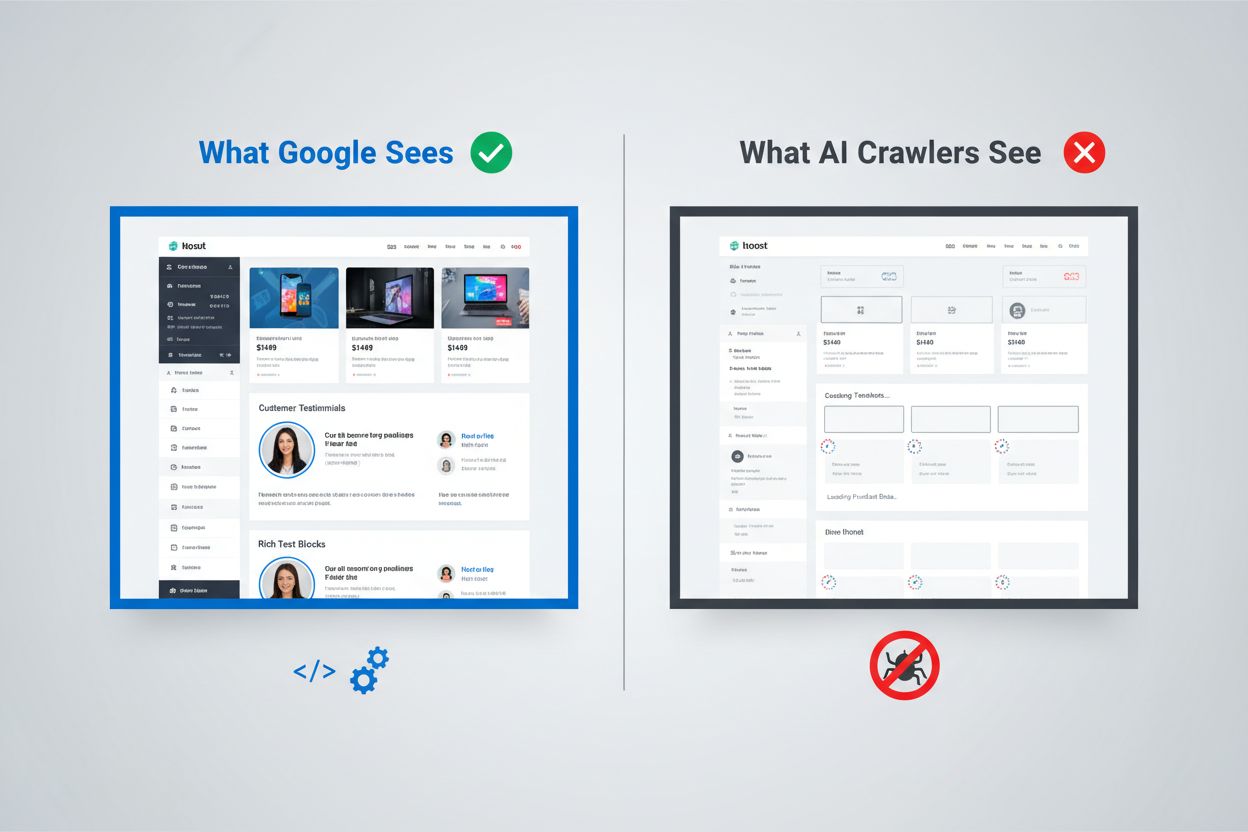

O cenário digital mudou fundamentalmente, mas a maioria das organizações ainda não se adaptou. Enquanto o sofisticado pipeline de renderização do Google consegue executar JavaScript e indexar conteúdo gerado dinamicamente, crawlers de IA como ChatGPT, Perplexity e Claude operam sob restrições completamente diferentes. Isso cria uma lacuna crítica de visibilidade: conteúdo que aparece perfeitamente bem para usuários humanos e até mesmo para o mecanismo de busca do Google pode estar completamente invisível para os sistemas de IA que, cada vez mais, direcionam tráfego e influenciam decisões de compra. Entender essa distinção não é apenas uma curiosidade técnica — está se tornando essencial para manter visibilidade em todo o ecossistema digital. Os riscos são altos, e as soluções são mais complexas do que a maioria das organizações imagina.

A abordagem do Google para renderização de JavaScript representa um dos sistemas mais sofisticados já construídos para indexação da web. O gigante das buscas emprega um sistema de renderização em duas ondas, onde as páginas são primeiramente rastreadas para seu conteúdo HTML estático e, posteriormente, re-renderizadas usando um navegador Chrome headless através de seu Web Rendering Service (WRS). Durante essa segunda onda, o Google executa JavaScript, constrói o DOM (Modelo de Objeto do Documento) completo e captura o estado totalmente renderizado da página. Esse processo inclui cache de renderização, o que significa que o Google pode reutilizar versões previamente renderizadas das páginas para economizar recursos. Todo o sistema é projetado para lidar com a complexidade das aplicações web modernas enquanto mantém a capacidade de rastrear bilhões de páginas. O Google investe enormes recursos computacionais nessa capacidade, executando milhares de instâncias do Chrome headless para processar o conteúdo pesado de JavaScript da web. Para organizações que dependem da Busca do Google, isso significa que seu conteúdo renderizado do lado do cliente tem chance de ser visto — mas só porque o Google construiu uma infraestrutura excepcionalmente cara para suportar isso.

Crawlers de IA operam sob restrições econômicas e arquiteturais fundamentalmente diferentes que tornam a execução de JavaScript impraticável. Restrições de recursos são a principal limitação: executar JavaScript exige iniciar motores de navegador, gerenciar memória e manter estado entre requisições — todas operações caras em escala. A maioria dos crawlers de IA opera com janelas de timeout de 1 a 5 segundos, ou seja, precisam buscar e processar conteúdo extremamente rápido ou abandonar a requisição. A análise de custo-benefício não favorece a execução de JavaScript para sistemas de IA; eles conseguem treinar com muito mais conteúdo apenas processando HTML estático do que renderizando cada página que encontram. Além disso, o pipeline de processamento de dados de treinamento para grandes modelos de linguagem normalmente remove CSS e JavaScript durante a ingestão, focando apenas no conteúdo semântico do HTML. A filosofia arquitetural é fundamentalmente diferente: o Google incorporou a renderização ao seu sistema de indexação porque a relevância da busca depende de entender o conteúdo renderizado, enquanto sistemas de IA priorizam amplitude de cobertura ao invés de profundidade de renderização. Isso não é uma limitação que será facilmente superada — está enraizada na economia fundamental de como esses sistemas operam.

Quando crawlers de IA requisitam uma página, eles recebem o arquivo HTML bruto sem qualquer execução de JavaScript, o que frequentemente significa que eles veem uma versão dramaticamente diferente do conteúdo em relação aos usuários humanos. Single Page Applications (SPAs) construídas com React, Vue ou Angular são particularmente problemáticas porque normalmente fornecem um HTML mínimo e dependem inteiramente do JavaScript para preencher o conteúdo da página. Um crawler de IA requisitando um site de ecommerce feito em React pode receber um HTML contendo tags <div id="root"></div> vazias, sem informações reais de produto, preços ou descrições. O crawler vê o esqueleto da página, mas não a substância. Para sites com muito conteúdo, isso significa que catálogos de produtos, posts de blog, tabelas de preços e seções dinâmicas simplesmente não existem na visão do crawler. Exemplos do mundo real são abundantes: a tabela de comparação de recursos de uma plataforma SaaS pode estar completamente invisível, as recomendações de produtos de um ecommerce podem não ser indexadas e artigos carregados dinamicamente por um site de notícias podem aparecer como páginas em branco. O HTML que crawlers de IA recebem geralmente é apenas o esqueleto da aplicação — o conteúdo real está em pacotes JavaScript que nunca são executados. Isso cria uma situação em que a página carrega perfeitamente no navegador, mas parece quase vazia para sistemas de IA.

O impacto comercial dessa lacuna de renderização vai muito além de preocupações técnicas e afeta diretamente receita, visibilidade e posicionamento competitivo. Quando crawlers de IA não conseguem ver seu conteúdo, várias funções críticas do negócio sofrem:

O efeito cumulativo é que organizações que investem pesado em conteúdo e experiência do usuário podem se tornar invisíveis para uma classe de usuários e sistemas cada vez mais importante. Esse não é um problema que se resolve sozinho — exige ação deliberada.

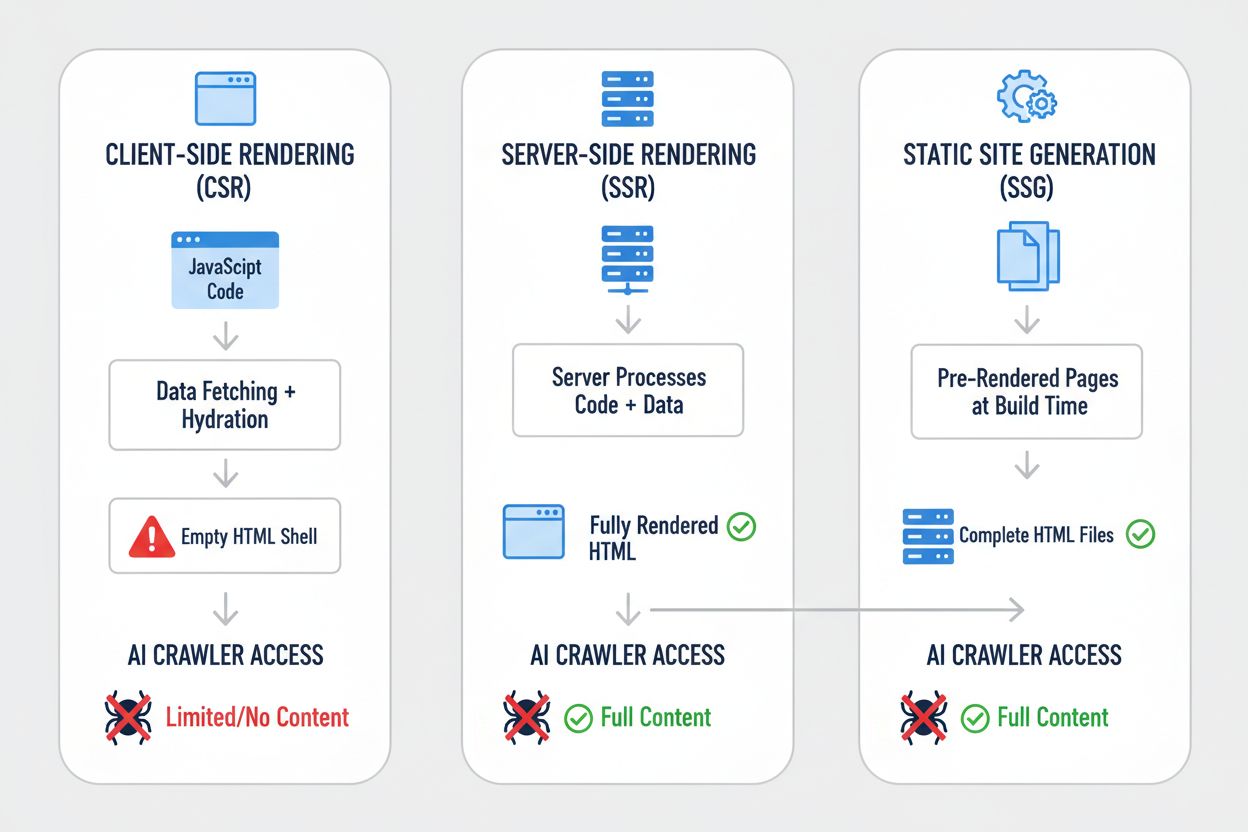

Diferentes estratégias de renderização produzem resultados dramaticamente diferentes quando vistas sob o prisma da visibilidade para crawlers de IA. A escolha da abordagem de renderização determina fundamentalmente o que sistemas de IA podem ver e indexar. Veja como as principais estratégias se comparam:

| Estratégia | O que a IA Vê | Impacto na Visibilidade em IA | Complexidade | Melhor Para |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | HTML completo com todo o conteúdo renderizado | Visibilidade total — IA vê tudo | Alta | Sites com muito conteúdo, aplicações críticas para SEO |

| Static Site Generation (SSG) | Arquivos HTML pré-renderizados | Excelente visibilidade — conteúdo em HTML estático | Média | Blogs, documentação, sites de marketing |

| Client-Side Rendering (CSR) | Estrutura HTML vazia, conteúdo mínimo | Baixa visibilidade — IA vê apenas o esqueleto | Baixa | Dashboards em tempo real, ferramentas interativas |

| Híbrido (SSR + CSR) | HTML inicial + melhorias do lado do cliente | Boa visibilidade — conteúdo central visível | Muito Alta | Aplicações complexas com recursos dinâmicos |

| Serviço de Pré-renderização | HTML renderizado em cache | Boa visibilidade — depende da qualidade do serviço | Média | Sites CSR existentes que precisam de correções rápidas |

| API-First + Markup | Dados estruturados + conteúdo em HTML | Excelente visibilidade — se bem implementado | Alta | Aplicações web modernas, headless CMS |

Cada estratégia representa um equilíbrio diferente entre complexidade de desenvolvimento, desempenho, experiência do usuário e visibilidade em IA. O ponto crítico é que a visibilidade para sistemas de IA está fortemente correlacionada com ter conteúdo em HTML estático — seja esse HTML gerado em tempo de build, em tempo de requisição ou servido de um cache. Organizações devem avaliar sua estratégia de renderização não apenas para experiência do usuário e desempenho, mas explicitamente para visibilidade por crawlers de IA.

Server-Side Rendering (SSR) representa o padrão ouro para visibilidade em IA porque entrega HTML completo e renderizado para cada requisitante — navegadores humanos e crawlers de IA igualmente. Com SSR, o servidor executa o código da aplicação e gera a resposta HTML completa antes de enviá-la ao cliente, o que significa que crawlers de IA recebem a página completa e renderizada já na primeira requisição. Frameworks modernos como Next.js, Nuxt.js e SvelteKit tornaram o SSR muito mais prático do que em gerações anteriores, lidando com a complexidade da hidratação (quando o JavaScript do cliente assume o controle do HTML renderizado no servidor) de forma transparente. Os benefícios vão além da visibilidade em IA: SSR geralmente melhora os Core Web Vitals, reduz o Time to First Contentful Paint e oferece melhor desempenho para usuários em conexões lentas. O trade-off é a carga adicional no servidor e a complexidade de gerenciamento de estado entre servidor e cliente. Para organizações onde a visibilidade em IA é crítica — especialmente sites com muito conteúdo, plataformas de ecommerce e aplicações SaaS — o SSR costuma ser a escolha mais defensável. O investimento em infraestrutura SSR traz retornos em múltiplas dimensões: melhor visibilidade em mecanismos de busca, melhor visibilidade para crawlers de IA, melhor experiência do usuário e melhores métricas de desempenho.

Static Site Generation (SSG) adota uma abordagem diferente, pré-renderizando páginas em tempo de build e gerando arquivos HTML estáticos que podem ser servidos instantaneamente a qualquer requisitante. Ferramentas como Hugo, Gatsby e Astro tornaram o SSG cada vez mais poderoso e flexível, suportando conteúdo dinâmico via APIs e regeneração incremental. Quando um crawler de IA requisita uma página gerada com SSG, recebe um HTML completo e estático com todo o conteúdo — visibilidade perfeita. Os benefícios de desempenho são excepcionais: arquivos estáticos são servidos mais rápido que qualquer renderização dinâmica, e os requisitos de infraestrutura são mínimos. A limitação é que o SSG funciona melhor para conteúdo que não muda frequentemente; é necessário rebuild e redeploy quando o conteúdo é atualizado. Para blogs, sites de documentação, páginas de marketing e aplicações baseadas em conteúdo, o SSG é frequentemente a escolha ideal. A combinação entre excelente visibilidade em IA, desempenho excepcional e requisitos mínimos de infraestrutura torna o SSG atraente para muitos casos de uso. No entanto, para aplicações que exigem personalização em tempo real ou conteúdo que muda frequentemente, o SSG se torna menos prático sem complexidades adicionais como regeneração incremental.

Client-Side Rendering (CSR) permanece popular apesar de seus sérios problemas de visibilidade em IA, principalmente porque oferece a melhor experiência para desenvolvedores e maior flexibilidade para aplicações altamente interativas. Com CSR, o servidor envia HTML mínimo e depende do JavaScript para construir a página no navegador — o que significa que crawlers de IA veem quase nada. Aplicações em React, Vue e Angular normalmente utilizam CSR como abordagem padrão, e muitas organizações construíram todo seu stack tecnológico nesse padrão. O apelo é compreensível: CSR permite experiências ricas e interativas, atualizações em tempo real e navegação fluida do lado do cliente. O problema é que essa flexibilidade tem um custo em visibilidade em IA. Para aplicações que realmente precisam de CSR — dashboards em tempo real, ferramentas colaborativas, aplicações interativas complexas — existem alternativas. Serviços de pré-renderização como o Prerender.io podem gerar snapshots HTML estáticos de páginas CSR e servi-los para crawlers, enquanto os navegadores continuam recebendo a versão interativa. Alternativamente, organizações podem implementar abordagens híbridas, onde o conteúdo crítico é renderizado no servidor enquanto recursos interativos permanecem no cliente. O ponto-chave é que CSR deve ser uma escolha deliberada, feita com total consciência dos trade-offs de visibilidade — não uma suposição padrão.

Implementar soluções práticas exige uma abordagem sistemática que começa pelo entendimento do estado atual e avança até a implementação e monitoramento contínuo. Comece com uma auditoria: use ferramentas como Screaming Frog, Semrush ou scripts personalizados para rastrear seu site como um crawler de IA, examinando o que realmente é visível no HTML bruto. Implemente melhorias de renderização com base nos achados da auditoria — isso pode significar migrar para SSR, adotar SSG para seções apropriadas ou implementar pré-renderização para páginas críticas. Teste cuidadosamente comparando o que crawlers de IA veem com o que navegadores veem; use comandos curl para buscar o HTML bruto e compare com a versão renderizada. Monitore continuamente para garantir que as mudanças de renderização não quebrem a visibilidade ao longo do tempo. Para organizações com sites grandes e complexos, isso pode significar priorizar páginas de alto valor primeiro — páginas de produto, de preços e seções-chave de conteúdo — antes de abordar o site inteiro. Ferramentas como Lighthouse, PageSpeed Insights e soluções de monitoramento personalizadas ajudam a acompanhar o desempenho de renderização e métricas de visibilidade. O investimento em acertar esse ponto traz dividendos em visibilidade de busca, visibilidade em IA e desempenho geral do site.

Testar e monitorar sua estratégia de renderização requer técnicas específicas que revelam o que crawlers de IA realmente veem. O teste mais simples é usar o curl para buscar o HTML bruto sem executar JavaScript:

curl -s https://example.com | grep -i "product\|price\|description"

Isso mostra exatamente o que um crawler de IA recebe — se seu conteúdo crítico não aparece nessa saída, não estará visível para sistemas de IA. Testes baseados em navegador usando o Chrome DevTools mostram a diferença entre o HTML inicial e o DOM totalmente renderizado; abra o DevTools, vá até a aba Network e examine a resposta HTML inicial versus o estado final renderizado. Para monitoramento contínuo, implemente monitoramento sintético que busca suas páginas regularmente como um crawler de IA e alerta caso a visibilidade do conteúdo diminua. Acompanhe métricas como “percentual de conteúdo visível no HTML inicial” e “tempo até a visibilidade do conteúdo” para entender o desempenho da renderização. Algumas organizações implementam dashboards de monitoramento personalizados que comparam a visibilidade frente a concorrentes, fornecendo inteligência competitiva sobre quem está otimizando para IA e quem não está. O ponto-chave é tornar esse monitoramento contínuo e acionável — problemas de visibilidade devem ser detectados e corrigidos rapidamente, não descobertos meses depois quando o tráfego misteriosamente cai.

O futuro das capacidades dos crawlers de IA permanece incerto, mas limitações atuais dificilmente mudarão drasticamente no curto prazo. A OpenAI já experimentou crawlers mais sofisticados como os navegadores Comet e Atlas, capazes de executar JavaScript, mas esses ainda são experimentais e não estão sendo usados em escala para coleta de dados de treinamento. A economia fundamental não mudou: executar JavaScript em escala ainda é caro, e o pipeline de dados de treinamento ainda se beneficia mais da amplitude do que da profundidade. Mesmo que crawlers de IA eventualmente passem a executar JavaScript, a otimização que você faz agora não será em vão — conteúdo renderizado no servidor tem melhor desempenho para usuários, carrega mais rápido e oferece melhor SEO independentemente. A abordagem prudente é otimizar para visibilidade em IA agora ao invés de esperar que as capacidades dos crawlers evoluam. Isso significa tratar visibilidade em IA como prioridade na sua estratégia de renderização, não como algo secundário. Organizações que fizerem essa mudança agora terão vantagem competitiva à medida que sistemas de IA se tornarem cada vez mais importantes para tráfego e visibilidade.

Monitorar sua visibilidade em IA e acompanhar melhorias ao longo do tempo requer as ferramentas e métricas certas. O AmICited.com oferece uma solução prática para acompanhar como seu conteúdo aparece em respostas geradas por IA e monitorar sua visibilidade em diferentes sistemas de IA. Ao rastrear quais páginas suas são citadas, mencionadas ou referenciadas em conteúdos gerados por IA, você entende o impacto real das suas otimizações de renderização. A plataforma ajuda a identificar que conteúdo está visível para sistemas de IA e qual permanece invisível, fornecendo dados concretos sobre a efetividade da sua estratégia de renderização. Conforme você implementa SSR, SSG ou pré-renderização, o AmICited.com permite medir a melhoria real na visibilidade em IA — vendo se seus esforços de otimização se traduzem em mais citações e referências. Esse ciclo de feedback é crucial para justificar o investimento em melhorias de renderização e identificar quais páginas precisam de otimização adicional. Ao combinar o monitoramento técnico do que crawlers de IA veem com métricas de negócio sobre a frequência com que seu conteúdo aparece em respostas de IA, você obtém uma visão completa da performance da sua visibilidade em IA.

Não, o ChatGPT e a maioria dos crawlers de IA não executam JavaScript. Eles veem apenas o HTML bruto do carregamento inicial da página. Qualquer conteúdo injetado via JavaScript após o carregamento permanece completamente invisível para sistemas de IA, diferente do Google, que usa navegadores Chrome headless para renderizar JavaScript.

O Google utiliza navegadores Chrome headless para renderizar JavaScript, similar a como um navegador real funciona. Isso consome muitos recursos, mas o Google possui a infraestrutura para fazer isso em escala. O sistema de renderização em duas ondas do Google primeiro rastreia o HTML estático, depois re-renderiza as páginas executando o JavaScript para capturar o DOM completo.

Desative o JavaScript no seu navegador e carregue seu site, ou use o comando curl para ver o HTML bruto. Se conteúdos importantes estiverem ausentes, os crawlers de IA também não verão. Você também pode usar ferramentas como o Screaming Frog no modo 'Apenas Texto' para rastrear seu site como um crawler de IA faria.

Não. Você também pode usar Geração de Site Estático, serviços de pré-renderização ou abordagens híbridas. A melhor solução depende do tipo de conteúdo e frequência de atualização. SSR é ideal para conteúdo dinâmico, SSG para conteúdo estável e serviços de pré-renderização para sites CSR existentes.

O Google consegue lidar com JavaScript, então seu ranking não deve ser afetado diretamente. No entanto, otimizar para crawlers de IA frequentemente melhora a qualidade geral do site, desempenho e experiência do usuário, o que pode beneficiar indiretamente seu ranking no Google.

Depende da frequência de rastreamento da plataforma de IA. O ChatGPT-User rastreia sob demanda quando usuários solicitam conteúdo, enquanto o GPTBot rastreia raramente com longos intervalos de revisita. Mudanças podem levar semanas para aparecer nas respostas das IAs, mas você pode monitorar o progresso usando ferramentas como AmICited.com.

Serviços de pré-renderização são mais fáceis de implementar e manter com poucas alterações no código, enquanto SSR oferece mais controle e melhor desempenho para conteúdo dinâmico. Escolha com base nos seus recursos técnicos, frequência de atualização do conteúdo e complexidade da aplicação.

Sim, você pode usar o robots.txt para bloquear crawlers de IA específicos, como o GPTBot. No entanto, isso significa que seu conteúdo não aparecerá em respostas geradas por IA, potencialmente reduzindo a visibilidade e o tráfego de ferramentas e assistentes de busca com IA.

Acompanhe como sistemas de IA referenciam sua marca no ChatGPT, Perplexity e Google AI Overviews. Identifique lacunas de visibilidade e meça o impacto de suas otimizações de renderização.

Descubra como as estratégias de renderização SSR e CSR afetam a visibilidade para crawlers de IA, citações de marca no ChatGPT e Perplexity, e sua presença gera...

Aprenda como testar se crawlers de IA como ChatGPT, Claude e Perplexity conseguem acessar o conteúdo do seu site. Descubra métodos de teste, ferramentas e as me...

Aprenda como a prerrenderização torna o conteúdo em JavaScript visível para crawlers de IA como ChatGPT, Claude e Perplexity. Descubra as melhores soluções técn...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.