Busca de IA Multimodal

Saiba como sistemas de busca de IA multimodal processam texto, imagens, áudio e vídeo juntos para entregar resultados mais precisos e relevantes do que abordage...

Saiba como otimizar texto, imagens e vídeo para sistemas de IA multimodal. Descubra estratégias para melhorar citações de IA e visibilidade em ChatGPT, Gemini e Perplexity.

IA Multimodal representa uma mudança fundamental em como sistemas de inteligência artificial processam e entendem informações. Ao contrário dos sistemas unimodais que lidam com texto, imagens ou vídeo de forma independente, a IA multimodal integra múltiplos tipos de dados simultaneamente para criar uma compreensão mais abrangente de informações complexas. Essa abordagem espelha como os humanos naturalmente processam o mundo—não separamos o que vemos do que ouvimos ou lemos, mas sim sintetizamos todos os insumos juntos. O mercado de IA multimodal, avaliado em US$ 1,6 bilhão em 2024, está passando por um crescimento explosivo com uma taxa composta anual de crescimento (CAGR) de 32,7%, refletindo a importância crítica da tecnologia para estratégias de IA corporativa. Analistas do setor projetam que 40% de todas as soluções generativas de IA serão multimodais até 2027, de acordo com pesquisa da Gartner. Essa transição não é apenas incremental; representa uma mudança de paradigma em como organizações aproveitam a IA para vantagem competitiva. A convergência de capacidades de processamento de texto, imagem e vídeo permite que sistemas de IA entreguem insights e capacidades que antes eram impossíveis com abordagens de modalidade única.

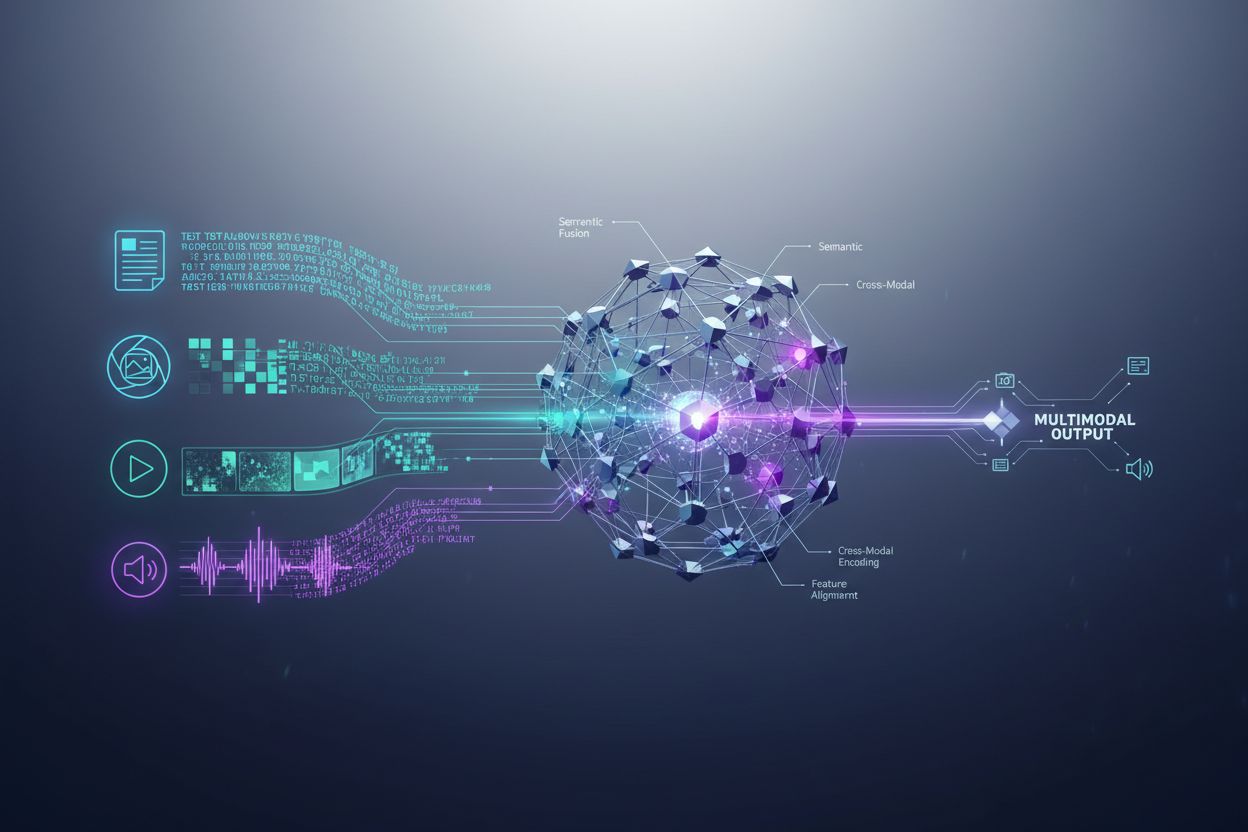

Sistemas de IA multimodal empregam componentes arquiteturais sofisticados para lidar com entradas de dados diversas de forma integrada. Codificadores são redes neurais especializadas que convertem cada tipo de dado—texto, imagens e vídeo—em uma representação numérica unificada chamada embeddings. Esses embeddings capturam o significado semântico de cada modalidade em um espaço matemático compartilhado, permitindo ao sistema comparar e relacionar informações entre diferentes tipos de conteúdo. O mecanismo de fusão então combina esses embeddings, seja por concatenação, adição ou técnicas de fusão aprendidas mais avançadas que determinam quanto cada modalidade deve contribuir para o resultado final. Mecanismos de atenção cruzada permitem ao modelo focar dinamicamente nas informações relevantes entre modalidades; por exemplo, ao analisar a imagem de um produto com texto acompanhante, o sistema pode focar em características visuais específicas que correspondem a descrições textuais. Esse processo em múltiplas etapas permite às soluções multimodais alcançar compreensão contextual que sistemas unimodais não conseguem replicar. A tabela a seguir ilustra as diferenças de capacidade:

| Capacidade | IA Unimodal | IA Multimodal |

|---|---|---|

| Análise de Texto | Excelente | Excelente |

| Compreensão de Imagem | Limitada/Nenhuma | Excelente |

| Processamento de Vídeo | Limitada/Nenhuma | Excelente |

| Raciocínio Cruzado | Não Possível | Excelente |

| Integração de Contexto | Fonte Única | Múltiplas Fontes |

| Precisão no Mundo Real | 60-75% | 85-95% |

| Velocidade de Processamento | Rápida | Otimizada Rápida |

O cenário da IA multimodal é dominado por diversas plataformas poderosas que estabeleceram novos padrões para processamento integrado. O GPT-4o da OpenAI representa um modelo multimodal emblemático, lidando texto, imagens e vídeo com integração nativa entre todas as modalidades. O Google Gemini oferece capacidades multimodais de nível empresarial, com destaque na compreensão de documentos visuais complexos e conteúdo de vídeo de longa duração. O Claude da Anthropic fornece raciocínio multimodal sofisticado com foco em precisão e compreensão detalhada entre entradas de texto e imagem. A tecnologia ImageBind da Meta demonstra uma abordagem arquitetural distinta, criando um espaço de embedding unificado entre seis modalidades, incluindo texto, imagem, áudio, profundidade, térmica e dados de IMU. Essas plataformas representam o estado da arte da tecnologia multimodal, cada uma trazendo inovações arquiteturais e estratégias de otimização distintas. Organizações que selecionam plataformas multimodais devem avaliar não apenas a amplitude de capacidades, mas também a otimização de desempenho, eficiência de custos e integração com fluxos de trabalho já existentes.

A IA multimodal está transformando operações em praticamente todos os setores, proporcionando melhorias mensuráveis em eficiência, precisão e experiência do cliente. Organizações que implementam essas tecnologias relatam resultados notáveis:

Saúde: Radiologistas usam IA multimodal para analisar imagens médicas em conjunto com registros de pacientes e anotações clínicas, melhorando a precisão diagnóstica e reduzindo o tempo de análise em até 40%. Sistemas de IA podem correlacionar achados visuais com histórico médico textual para identificar padrões que humanos poderiam não perceber.

Varejo: Empresas de moda e e-commerce utilizam IA multimodal para combinar descrições de clientes com inventário visual, possibilitando buscas por descrição que aumentam taxas de conversão. Recomendações de produtos melhoram significativamente quando a IA compreende preferências visuais e feedback textual.

Manufatura: Processos de controle de qualidade aceleram dramaticamente com sistemas de inspeção multimodal que combinam detecção visual de defeitos com dados de sensores e registros de manutenção, alcançando catalogação de problemas 100x mais rápida comparada a processos manuais.

Criação de Conteúdo: Empresas de mídia usam IA multimodal para gerar automaticamente legendas, transcrições e metadados para vídeos, com 72% dos executivos de mídia usando IA generativa relatando ROI positivo em seus investimentos.

Atendimento ao Cliente: Chatbots aprimorados com capacidades multimodais processam imagens de problemas enviadas por clientes junto com descrições textuais, oferecendo soluções de suporte mais precisas e contextuais.

Agricultura: Agricultores implementam sistemas multimodais que analisam imagens de culturas, dados meteorológicos e leituras de sensores de solo para otimizar decisões de irrigação, fertilização e manejo de pragas.

Robótica: Sistemas autônomos utilizam percepção multimodal para navegar em ambientes complexos, combinando entrada visual com sinais de áudio e feedback tátil para operação mais segura e inteligente.

Para maximizar a eficácia de sistemas de IA multimodal, o conteúdo textual exige estratégias de otimização deliberadas que aprimorem a legibilidade por máquinas e a compreensão de contexto. Marcação de dados estruturados utilizando padrões schema.org ajuda sistemas de IA a entender relações semânticas dentro do seu conteúdo, permitindo conexões cruzadas mais precisas entre modalidades. Implementar linguagem conversacional ao invés de prosa puramente formal permite que sistemas multimodais entendam melhor intenção e contexto, especialmente quando o texto é processado ao lado de elementos visuais ou em vídeo. Títulos e subtítulos descritivos têm duplo papel: orientam leitores humanos e fornecem sinais estruturais cruciais para que sistemas de IA organizem e priorizem informações. Incluir palavras-chave relevantes em contextos naturais—ao invés de empilhamento forçado de palavras-chave—garante que o conteúdo textual esteja alinhado com a forma como sistemas multimodais identificam relações temáticas entre modalidades. Otimização de metadados, incluindo títulos, descrições e atributos estruturados, fornece sinais explícitos sobre o significado do conteúdo que sistemas multimodais podem utilizar. Organizações também devem considerar como o texto complementa o conteúdo visual; legendas e textos alternativos não são apenas recursos de acessibilidade—são elementos críticos de otimização que permitem à IA multimodal compreender a relação entre informações textuais e visuais.

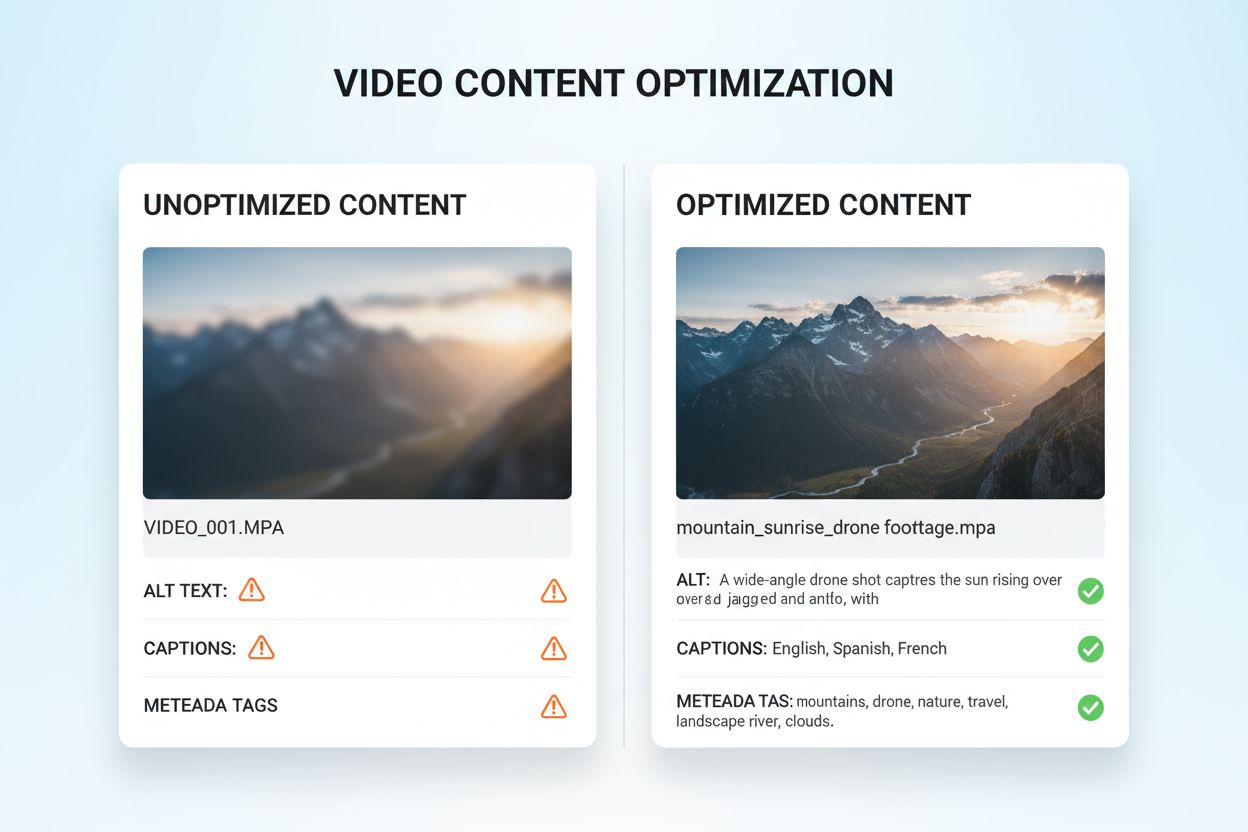

A otimização de conteúdo visual e de vídeo para IA multimodal requer uma abordagem abrangente que vai muito além das práticas tradicionais de SEO. Texto alternativo descritivo é fundamental; em vez de descrições genéricas, o alt text deve capturar o significado semântico, contexto e detalhes relevantes que ajudem sistemas de IA a entender o que a imagem transmite. Convenções de nomeação de arquivos são muito importantes—nomes descritivos como “comparativo-produto-2024.jpg” fornecem contexto crucial que sistemas de IA utilizam para compreender o propósito do conteúdo. Legendas e transcrições em vídeo são elementos essenciais de otimização; permitem que sistemas multimodais correlacionem conteúdo falado com elementos visuais, melhorando dramaticamente a compreensão de materiais em vídeo complexos. Campos de metadados incluindo título, descrição e tags devem ser preenchidos com especificidade e precisão, pois influenciam diretamente como sistemas de IA categorizam e relacionam conteúdo visual a outras modalidades. Compressão de imagens e otimização técnica garante que a qualidade visual permaneça suficientemente alta para análise por IA, mantendo tempos de carregamento rápidos. Dados estruturados para conteúdo visual, incluindo marcação para imagens, vídeos e galerias de mídia, fornecem sinais explícitos de relações entre conteúdos. Organizações também devem considerar metadados temporais para vídeos—marcar momentos-chave, mudanças de cena e transições de tópicos ajuda sistemas multimodais a entender a estrutura narrativa e extrair segmentos relevantes.

Sistemas de IA multimodal empregam duas abordagens arquiteturais principais, cada uma com vantagens e compensações distintas. Arquiteturas unificadas processam todas as modalidades em uma única rede neural integrada que aprende representações conjuntas desde o início do processamento. Essa abordagem normalmente entrega raciocínio cruzado superior, pois o sistema desenvolve compreensão profunda de como as modalidades se relacionam, mas exige mais recursos computacionais e maior tempo de treinamento. Arquiteturas modulares mantêm redes especializadas separadas para cada modalidade, combinando seus resultados por mecanismos de fusão. Essa abordagem oferece maior flexibilidade, permitindo que organizações troquem processadores de modalidades individuais sem re-treinar todo o sistema e normalmente requer menos recursos computacionais. Modelos Mixture of Experts (MoE) representam uma abordagem híbrida emergente, na qual diferentes redes especialistas se especializam em diferentes modalidades ou tarefas, e um mecanismo de roteamento direciona as entradas aos especialistas apropriados. Essa arquitetura atinge melhorias de eficiência de 30-50% comparada a modelos unificados densos, mantendo precisão comparável. A escolha entre abordagens arquiteturais depende do uso específico: arquiteturas unificadas se sobressaem em tarefas complexas que exigem profundo entendimento cruzado, enquanto abordagens modulares são indicadas para cenários que exigem flexibilidade e eficiência de recursos.

A implementação eficaz de IA multimodal exige estruturas robustas de medição que acompanhem tanto o desempenho técnico quanto o impacto nos negócios. Indicadores-chave de performance (KPIs) devem incluir métricas de precisão em cada modalidade, qualidade do raciocínio cruzado, latência de processamento e custo por inferência. Plataformas de análise devem capturar como a IA multimodal influencia métricas de negócios subsequentes: taxas de conversão no varejo, precisão diagnóstica na saúde, eficiência produtiva na manufatura. As organizações precisam implementar rastreamento de atribuição para entender qual modalidade mais contribui para resultados específicos—esse insight orienta esforços de otimização e alocação de recursos. A medição de ROI deve considerar tanto economias de custo diretas (como a catalogação 100x mais rápida relatada pela manufatura) quanto benefícios indiretos como maior satisfação do cliente ou redução de erros. Ferramentas de monitoramento devem acompanhar a degradação de performance do modelo ao longo do tempo, já que o desvio de dados reais pode reduzir a precisão de sistemas multimodais se não for gerenciado ativamente. Para organizações que utilizam conteúdo e insights gerados por IA, rastreamento de citação e atribuição torna-se cada vez mais importante; ferramentas como AmICited.com ajudam a monitorar como sistemas de IA citam fontes e atribuem informações, fornecendo visibilidade dos processos decisórios da IA e garantindo conformidade com requisitos de procedência de conteúdo. Auditorias regulares de desempenho e ciclos de otimização asseguram que os sistemas multimodais continuem entregando valor à medida que as necessidades do negócio e padrões de dados evoluem.

O cenário da IA multimodal continua evoluindo rapidamente, com várias tendências transformadoras remodelando como as organizações irão aproveitar essas tecnologias. Integração de voz representa a próxima fronteira, à medida que sistemas combinam cada vez mais entrada de áudio com dados visuais e textuais, possibilitando compreensão realmente abrangente da comunicação humana e do contexto ambiental. Sistemas de IA agentica—agentes de IA capazes de planejar e executar tarefas em múltiplos passos de forma autônoma—irão utilizar percepção multimodal para navegar cenários complexos do mundo real, desde veículos autônomos até automação de processos empresariais. Capacidades de processamento em tempo real estão avançando dramaticamente, permitindo análise multimodal de transmissões de vídeo ao vivo, fluxos de áudio e dados de sensores simultaneamente, abrindo possibilidades para tomadas de decisão instantâneas em aplicações sensíveis ao tempo. Melhorias de eficiência por meio de técnicas como destilação e quantização tornarão capacidades multimodais sofisticadas acessíveis a organizações com recursos computacionais limitados, democratizando o acesso à IA avançada. Modelos especializados por domínio irão surgir, com sistemas multimodais ajustados para setores específicos como saúde, jurídico ou serviços financeiros, entregando desempenho superior comparado a modelos de propósito geral. A convergência dessas tendências sugere que a IA multimodal deixará de ser vantagem competitiva para se tornar um requisito fundamental para organizações que buscam permanecer relevantes em um cenário cada vez mais movido por IA. Organizações que começam a otimizar seu conteúdo e processos para IA multimodal hoje estarão melhor posicionadas para aproveitar essas capacidades emergentes no futuro.

A IA multimodal processa múltiplos tipos de dados (texto, imagens, áudio, vídeo) simultaneamente, enquanto a IA unimodal tradicional lida apenas com um tipo. Isso possibilita um entendimento de contexto mais rico e resultados mais precisos. Sistemas multimodais compreendem relações entre diferentes modalidades, entregando insights que sistemas de modalidade única não conseguem replicar.

À medida que a IA multimodal se torna o padrão em soluções generativas de IA (projetada para chegar a 40% até 2027), otimizar seu conteúdo garante melhor visibilidade em respostas geradas por IA. Organizações que otimizam em texto, imagem e vídeo veem melhorias nas citações de IA, maior visibilidade em plataformas como ChatGPT e Gemini e melhor desempenho geral do conteúdo.

Acompanhe métricas-chave como precisão entre modalidades, qualidade do raciocínio cruzado, latência de processamento e impacto no negócio (taxas de conversão, engajamento, etc.). Use ferramentas como AmICited.com para monitorar como sistemas de IA citam seu conteúdo e implemente análises para entender quais modalidades mais contribuem para os resultados do seu negócio.

Os principais desafios incluem garantir metadados consistentes entre modalidades, manter alta qualidade em textos alternativos e legendas, alinhar dados temporais em vídeos e gerenciar os recursos computacionais necessários para o processamento. As organizações também devem planejar a preparação de dados (10-20% do orçamento do projeto) e a gestão de mudanças para adaptação das equipes às novas práticas de otimização.

Saúde, varejo, manufatura, criação de conteúdo, atendimento ao cliente, agricultura e robótica têm benefícios significativos. A saúde usa para precisão diagnóstica, o varejo para descoberta de produtos, a indústria para controle de qualidade (catalogação 100x mais rápida) e empresas de mídia reportam 72% de ROI em investimentos em IA generativa.

O AmICited.com monitora como sistemas de IA como ChatGPT, Perplexity e Google AI Overviews citam seu conteúdo em diferentes modalidades. Ele fornece visibilidade em tempo real da sua presença em buscas por IA, ajudando a entender como seus textos, imagens e vídeos são referenciados em respostas geradas por IA.

Arquiteturas unificadas processam todas as modalidades em uma única rede integrada, oferecendo raciocínio cruzado superior, mas exigindo mais recursos computacionais. Arquiteturas modulares mantêm redes separadas para cada modalidade, proporcionando mais flexibilidade e eficiência. Modelos Mixture of Experts (MoE) oferecem uma abordagem híbrida com melhorias de eficiência de 30-50%.

Otimize textos com dados estruturados e linguagem conversacional, adicione textos alternativos e metadados descritivos às imagens, inclua legendas e transcrições para vídeos e use convenções consistentes de nomeação de arquivos. Garanta que todas as modalidades trabalhem juntas para oferecer contexto abrangente e implemente marcação de esquema para ajudar sistemas de IA a entender relações semânticas.

Acompanhe como sistemas de IA multimodal citam seu conteúdo no ChatGPT, Perplexity, Google AI Overviews e outras plataformas. Tenha visibilidade em tempo real de sua presença em buscas por IA.

Saiba como sistemas de busca de IA multimodal processam texto, imagens, áudio e vídeo juntos para entregar resultados mais precisos e relevantes do que abordage...

Saiba o que é conteúdo multimodal para IA, como funciona e por que é importante. Explore exemplos de sistemas de IA multimodal e suas aplicações em diferentes s...

Domine a otimização para busca de IA multimodal. Aprenda como otimizar imagens e consultas de voz para resultados de busca movidos por IA, com estratégias para ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.