Seleção de Fontes por IA

Descubra como sistemas de IA selecionam e classificam fontes para citações. Aprenda sobre os algoritmos, sinais e fatores que determinam quais sites plataformas...

Aprenda sobre o viés de seleção de fontes em IA, como ele afeta modelos de aprendizado de máquina, exemplos do mundo real e estratégias para detectar e mitigar esse problema crítico de equidade.

O viés de seleção de fontes ocorre quando os dados de treinamento não são representativos da população geral ou da distribuição do mundo real, fazendo com que os modelos de IA façam previsões imprecisas para grupos ou cenários sub-representados.

Viés de seleção de fontes é um problema fundamental em inteligência artificial que ocorre quando os dados usados para treinar modelos de aprendizado de máquina não representam com precisão a população ou distribuição do mundo real que eles pretendem atender. Esse tipo de viés surge quando conjuntos de dados são escolhidos de forma a excluir ou sub-representar sistematicamente certos grupos, cenários ou características. Como consequência, os modelos de IA aprendem padrões a partir de dados incompletos ou distorcidos, levando a previsões imprecisas, injustas ou discriminatórias para populações sub-representadas. Compreender esse viés é fundamental para quem desenvolve, implanta ou depende de sistemas de IA, pois impacta diretamente a justiça, a precisão e a confiabilidade da tomada de decisões automatizadas em diversos setores.

O viés de seleção de fontes é distinto de outras formas de viés porque se origina já na etapa de coleta de dados. Em vez de surgir de escolhas algorítmicas ou suposições humanas durante o desenvolvimento do modelo, o viés de seleção de fontes está incorporado na base do conjunto de dados de treinamento. Isso o torna especialmente insidioso, pois modelos treinados em dados de fontes tendenciosas perpetuarão e amplificarão esses vieses em suas previsões, independentemente da sofisticação do algoritmo. O problema se torna ainda mais crítico quando sistemas de IA são implantados em áreas sensíveis como saúde, finanças, justiça criminal e recrutamento, onde previsões tendenciosas podem ter sérias consequências para indivíduos e comunidades.

O viés de seleção de fontes se desenvolve por meio de vários mecanismos distintos durante o processo de coleta e curadoria de dados. O caminho mais comum ocorre por meio do viés de cobertura, em que certas populações ou cenários são sistematicamente excluídos do conjunto de dados de treinamento. Por exemplo, se um sistema de reconhecimento facial é treinado principalmente com imagens de pessoas de pele clara, terá pouca cobertura de rostos de pele escura, levando a taxas de erro mais altas para essas populações. Isso acontece porque os coletores de dados podem ter acesso limitado a populações diversas ou podem, inconscientemente, priorizar certos grupos ao reunir os dados.

Outro mecanismo crítico é o viés de não resposta, também chamado de viés de participação, que ocorre quando certos grupos têm menos probabilidade de participar dos processos de coleta de dados. Considere um conjunto de dados baseado em pesquisas para prever preferências de consumidores: se certos grupos demográficos têm uma probabilidade significativamente menor de responder às pesquisas, suas preferências serão sub-representadas nos dados de treinamento. Isso cria um conjunto de dados que aparenta ser equilibrado, mas na verdade reflete padrões de participação e não as características reais da população. Na saúde, por exemplo, se dados de ensaios clínicos vêm predominantemente de populações urbanas com acesso a instalações médicas avançadas, os modelos de IA resultantes podem não generalizar bem para comunidades rurais ou carentes.

O viés de amostragem representa um terceiro mecanismo, quando não se utiliza a devida randomização durante a coleta de dados. Em vez de selecionar aleatoriamente os dados, os coletores podem escolher as primeiras amostras disponíveis ou usar métodos de amostragem por conveniência. Isso introduz erros sistemáticos porque as amostras escolhidas não representam a população como um todo. Por exemplo, se um modelo de IA para prever inadimplência de empréstimos é treinado com dados de uma região geográfica ou período de tempo específico, pode não prever inadimplências com precisão em outras regiões ou em diferentes condições econômicas.

| Tipo de Viés | Mecanismo | Exemplo do Mundo Real |

|---|---|---|

| Viés de Cobertura | Exclusão sistemática de populações | Reconhecimento facial treinado apenas com rostos claros |

| Viés de Não Resposta | Lacunas de participação na coleta de dados | Modelos de saúde treinados apenas com populações urbanas |

| Viés de Amostragem | Randomização inadequada na seleção | Modelos de empréstimo treinados em uma única região |

| Viés Temporal | Dados de períodos específicos | Modelos treinados antes da pandemia aplicados depois |

| Viés de Diversidade de Fontes | Fontes de dados limitadas | Dados de imagem médica de um único sistema hospitalar |

As consequências do viés de seleção de fontes em sistemas de IA são profundas e de longo alcance, afetando tanto indivíduos quanto organizações. Na saúde, o viés de seleção de fontes levou a sistemas de diagnóstico que apresentam desempenho significativamente pior para determinadas populações de pacientes. Pesquisas documentaram que algoritmos de IA para diagnóstico de câncer de pele apresentam precisão substancialmente menor para pacientes de pele escura, com alguns estudos mostrando apenas metade da precisão diagnóstica em comparação com pacientes de pele clara. Essa disparidade resulta diretamente em diagnósticos tardios, recomendações inadequadas de tratamento e piores desfechos de saúde para populações sub-representadas. Quando os dados de treinamento vêm predominantemente de pacientes de um grupo demográfico, os modelos resultantes aprendem padrões específicos daquele grupo e falham em generalizar para os demais.

Em serviços financeiros, o viés de seleção de fontes em algoritmos de crédito e empréstimo perpetuou discriminações históricas. Modelos treinados com dados históricos de aprovação de crédito que refletem práticas discriminatórias do passado vão reproduzir esses mesmos vieses ao tomar novas decisões de empréstimo. Se certos grupos foram historicamente negados crédito devido à discriminação sistêmica, e esses dados históricos são usados para treinar modelos de IA, os modelos aprenderão a negar crédito a grupos semelhantes no futuro. Isso cria um ciclo vicioso, onde as desigualdades históricas se tornam incorporadas à tomada de decisão algorítmica, afetando o acesso das pessoas ao capital e a oportunidades econômicas.

Recrutamento e seleção é outro domínio crítico em que o viés de seleção de fontes causa danos significativos. Ferramentas de IA usadas na triagem de currículos já demonstraram vieses baseados em raça e gênero percebidos, com estudos indicando que nomes associados a pessoas brancas eram favorecidos em 85% dos casos em certos sistemas. Quando os dados de treinamento vêm de históricos de contratação que refletem discriminação passada ou padrões homogêneos de contratação, os modelos de IA resultantes aprendem a replicar esses padrões. Isso significa que o viés de seleção de fontes em dados de contratação perpetua a discriminação no ambiente de trabalho em grande escala, limitando oportunidades para grupos sub-representados e reduzindo a diversidade da força de trabalho.

Na justiça criminal, o viés de seleção de fontes em sistemas preditivos de policiamento levou à segmentação desproporcional de determinadas comunidades. Quando os dados de treinamento vêm de registros de prisões historicamente tendenciosos contra grupos marginalizados, os modelos resultantes amplificam esses vieses ao prever taxas de criminalidade mais altas nessas comunidades. Isso cria um ciclo de retroalimentação, onde previsões tendenciosas levam a mais policiamento em certas áreas, gerando mais dados de prisões dessas áreas, reforçando ainda mais o viés no modelo.

Detectar o viés de seleção de fontes requer uma abordagem sistemática que combine análise quantitativa, avaliação qualitativa e monitoramento contínuo ao longo do ciclo de vida do modelo. O primeiro passo é realizar uma auditoria abrangente de dados que examine as fontes, métodos de coleta e representatividade dos dados de treinamento. Isso envolve documentar de onde vieram os dados, como foram coletados e se o processo de coleta pode ter excluído sistematicamente certas populações ou cenários. Questione: Todos os grupos demográficos relevantes foram representados no processo de coleta de dados? Houve barreiras de participação que possam ter desestimulado certos grupos? O período de coleta de dados ou o escopo geográfico limitou a representatividade?

A análise de paridade demográfica oferece uma abordagem quantitativa para detectar viés de seleção de fontes. Isso envolve comparar a distribuição de características-chave nos seus dados de treinamento com a distribuição da população real que seu modelo irá atender. Se seus dados de treinamento sub-representam significativamente certos grupos demográficos, faixas etárias, regiões geográficas ou outras características relevantes, há evidência de viés de seleção de fontes. Por exemplo, se seus dados de treinamento contêm apenas 5% de mulheres, mas a população-alvo é composta por 50% de mulheres, isso indica um sério viés de cobertura que provavelmente resultará em um desempenho ruim do modelo para mulheres.

A análise de desempenho por fatia é outra técnica crítica, onde o desempenho do modelo é avaliado separadamente para diferentes grupos demográficos e subpopulações. Mesmo que a precisão geral do modelo pareça aceitável, o desempenho pode variar drasticamente entre os grupos. Se seu modelo atinge 95% de precisão no geral, mas apenas 70% para um determinado grupo demográfico, isso sugere que o viés de seleção de fontes nos dados de treinamento fez com que o modelo aprendesse padrões específicos do grupo majoritário, falhando em aprender padrões relevantes ao grupo minoritário. Essa análise deve ser feita não apenas sobre a precisão geral, mas também sobre métricas de equidade, como probabilidade igualizada e impacto desigual.

Testes adversariais envolvem a criação deliberada de casos de teste para expor potenciais vieses. Isso pode incluir testar seu modelo com dados de populações sub-representadas, casos extremos ou cenários pouco representados nos dados de treinamento. Ao submeter seu modelo a entradas diversas, é possível identificar onde o viés de seleção de fontes criou pontos cegos. Por exemplo, se seu modelo foi treinado principalmente com dados urbanos, teste-o extensivamente com dados rurais para verificar se o desempenho diminui. Se seus dados de treinamento vieram de um período específico, teste o modelo com dados de outros períodos para detectar viés temporal.

Mitigar o viés de seleção de fontes requer intervenção em múltiplas etapas do ciclo de vida de desenvolvimento de IA, começando pela coleta de dados e continuando até a avaliação e implantação do modelo. A abordagem mais eficaz é a mitigação centrada em dados, que combate o viés em sua origem, melhorando a qualidade e a representatividade do conjunto de dados de treinamento. Isso começa com a coleta de dados diversa, onde há um esforço ativo para incluir populações e cenários sub-representados no conjunto de treinamento. Em vez de depender de amostragem por conveniência ou conjuntos de dados existentes, as organizações devem realizar coletas direcionadas para garantir representação adequada de todos os grupos demográficos e casos de uso relevantes.

Técnicas de reamostragem e reponderação oferecem métodos práticos para lidar com desequilíbrios em conjuntos de dados existentes. A superamostragem aleatória duplica exemplos de grupos sub-representados, enquanto a subamostragem aleatória reduz exemplos de grupos super-representados. Abordagens mais sofisticadas, como a amostragem estratificada, garantem representação proporcional em múltiplas dimensões simultaneamente. A reponderação atribui maior importância às amostras sub-representadas durante o treinamento do modelo, instruindo o algoritmo a prestar mais atenção aos padrões dos grupos minoritários. Essas técnicas funcionam melhor quando combinadas com esforços de coleta de dados mais diversos, ao invés de depender apenas da reamostragem de dados limitados.

A geração de dados sintéticos oferece outro caminho para lidar com o viés de seleção de fontes, especialmente quando é difícil ou caro coletar dados reais de populações sub-representadas. Técnicas como Redes Generativas Adversariais (GANs) e Autoencoders Variacionais (VAEs) podem criar exemplos sintéticos realistas para grupos sub-representados. Abordagens mais direcionadas, como SMOTE (Técnica de Sobreamostragem de Minorias Sintéticas), criam exemplos sintéticos interpolando entre instâncias minoritárias existentes. No entanto, dados sintéticos devem ser usados com cautela e validados cuidadosamente, pois podem introduzir seus próprios vieses se não forem gerados com cuidado.

Algoritmos conscientes de equidade representam outra estratégia de mitigação que atua na etapa de treinamento do modelo. Esses algoritmos incorporam explicitamente restrições de equidade no processo de aprendizado, garantindo que o modelo alcance desempenho aceitável em todos os grupos demográficos, não apenas no grupo majoritário. A desenviesamento adversarial, por exemplo, usa uma rede adversarial para garantir que as previsões do modelo não possam ser usadas para inferir características protegidas como raça ou gênero. Regularizações de equidade adicionam penalidades à função de perda que desencorajam comportamentos discriminatórios. Essas abordagens permitem equilibrar explicitamente precisão geral e justiça, escolhendo o equilíbrio que se alinha com suas prioridades éticas.

Monitoramento contínuo e re-treinamento garantem que o viés de seleção de fontes não surja ou piore ao longo do tempo. Mesmo que seu dado inicial seja representativo, a distribuição real atendida pelo modelo pode mudar devido a alterações demográficas, mudanças econômicas ou outros fatores. Implementar sistemas de monitoramento de desempenho que acompanhem separadamente a precisão do modelo para diferentes grupos demográficos permite detectar quando surge viés. Quando há degradação do desempenho, o re-treinamento com dados atualizados que reflitam a distribuição populacional atual pode restaurar a equidade. Esse processo contínuo reconhece que a mitigação de viés não é um esforço pontual, mas uma responsabilidade permanente.

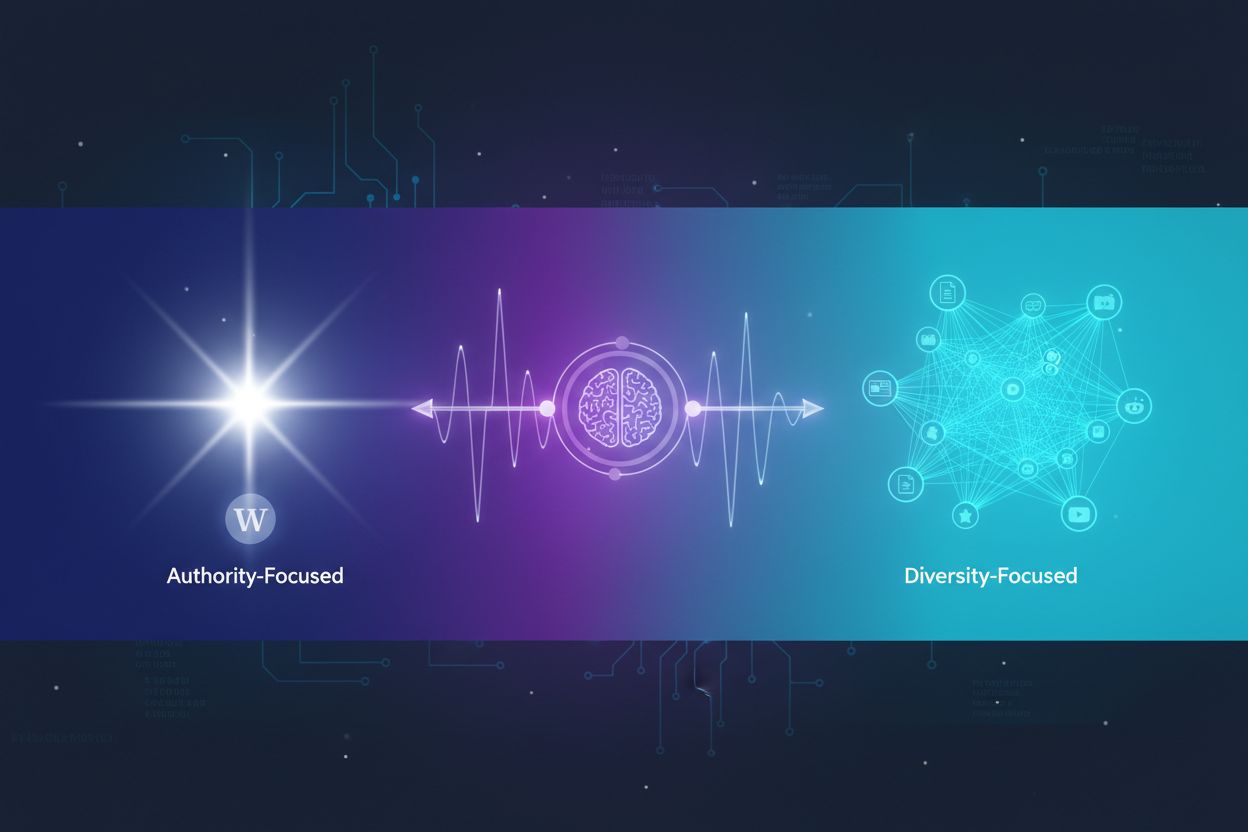

Compreender o viés de seleção de fontes torna-se cada vez mais importante no contexto do monitoramento de respostas de IA e rastreamento de presença de marca. À medida que sistemas de IA como ChatGPT, Perplexity e outros geradores de respostas de IA se tornam fontes primárias de informação para usuários, as fontes que esses sistemas citam e as informações que apresentam são moldadas pelos seus dados de treinamento. Se os dados de treinamento usados para construir esses sistemas de IA apresentam viés de seleção de fontes, as respostas geradas refletirão esse viés. Por exemplo, se os dados de treinamento de um sistema de IA super-representam certos sites, publicações ou perspectivas, enquanto sub-representam outros, o sistema de IA terá maior probabilidade de citar e amplificar informações das fontes super-representadas.

Isso tem implicações diretas para o monitoramento de marca e visibilidade de conteúdo. Se sua marca, domínio ou URLs estão sub-representados nos dados de treinamento dos principais sistemas de IA, seu conteúdo pode ser sistematicamente excluído ou sub-representado nas respostas geradas por IA. Por outro lado, se marcas concorrentes ou fontes de desinformação estão super-representadas nos dados de treinamento, elas receberão visibilidade desproporcional nas respostas de IA. Monitorar como sua marca aparece nas respostas de IA em diferentes plataformas ajuda a entender se o viés de seleção de fontes nesses sistemas está afetando sua visibilidade e reputação. Acompanhar quais fontes são citadas, com que frequência seu conteúdo aparece e se as informações apresentadas são precisas permite identificar possíveis vieses na forma como sistemas de IA representam sua marca e setor.

O viés de seleção de fontes em IA é uma questão crítica de equidade que se origina na etapa de coleta de dados e se propaga por todas as aplicações subsequentes de modelos de aprendizado de máquina. Ele ocorre quando os dados de treinamento excluem ou sub-representam sistematicamente certas populações, cenários ou características, resultando em modelos que fazem previsões imprecisas ou injustas para grupos sub-representados. As consequências são graves e de longo alcance, afetando resultados em saúde, acesso financeiro, oportunidades de emprego e decisões na justiça criminal. Detectar o viés de seleção de fontes exige auditorias de dados abrangentes, análise de paridade demográfica, análise de desempenho por fatia e testes adversariais. Mitigar esse viés demanda uma abordagem multifacetada, incluindo coleta diversificada de dados, reamostragem e reponderação, geração de dados sintéticos, algoritmos conscientes de equidade e monitoramento contínuo. As organizações devem reconhecer que enfrentar o viés de seleção de fontes não é opcional, mas essencial para construir sistemas de IA justos, precisos e confiáveis para todas as populações e casos de uso.

Garanta que sua marca apareça de forma precisa em respostas geradas por IA em ChatGPT, Perplexity e outras plataformas de IA. Acompanhe como os sistemas de IA citam seu conteúdo e identifique possíveis vieses nas respostas de IA.

Descubra como sistemas de IA selecionam e classificam fontes para citações. Aprenda sobre os algoritmos, sinais e fatores que determinam quais sites plataformas...

Descubra como os sistemas de IA decidem entre citar múltiplas fontes ou concentrar-se em fontes autoritativas. Entenda os padrões de citação do ChatGPT, Google ...

Discussão da comunidade sobre como mecanismos de IA lidam com informações conflitantes. Experiências reais de SEOs e criadores de conteúdo analisando as formas ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.