Como Contestar e Corrigir Informações Imprecisas em Respostas de IA

Saiba como contestar informações imprecisas de IA, relatar erros ao ChatGPT e Perplexity e implementar estratégias para garantir que sua marca seja representada...

Correção de Desinformação em IA refere-se a estratégias e ferramentas para identificar e resolver informações incorretas sobre marcas que aparecem em respostas geradas por IA de sistemas como ChatGPT, Gemini e Perplexity. Envolve o monitoramento de como os sistemas de IA representam as marcas e a implementação de correções na fonte para garantir que informações precisas sejam distribuídas em plataformas confiáveis. Diferente da checagem de fatos tradicional, o foco está em corrigir as fontes que as IAs confiam, e não os próprios outputs da IA. Isso é essencial para manter a reputação e a precisão da marca em um ambiente de busca orientado por IA.

Correção de Desinformação em IA refere-se a estratégias e ferramentas para identificar e resolver informações incorretas sobre marcas que aparecem em respostas geradas por IA de sistemas como ChatGPT, Gemini e Perplexity. Envolve o monitoramento de como os sistemas de IA representam as marcas e a implementação de correções na fonte para garantir que informações precisas sejam distribuídas em plataformas confiáveis. Diferente da checagem de fatos tradicional, o foco está em corrigir as fontes que as IAs confiam, e não os próprios outputs da IA. Isso é essencial para manter a reputação e a precisão da marca em um ambiente de busca orientado por IA.

Correção de Desinformação em IA refere-se às estratégias, processos e ferramentas usados para identificar e resolver informações incorretas, desatualizadas ou enganosas sobre marcas que aparecem em respostas geradas por IA de sistemas como ChatGPT, Gemini e Perplexity. Pesquisas recentes mostram que aproximadamente 45% das consultas em IA produzem respostas errôneas, tornando a precisão da marca em sistemas de IA uma preocupação crítica para as empresas. Diferente dos resultados de busca tradicionais, onde as marcas podem controlar suas próprias listagens, sistemas de IA sintetizam informações de múltiplas fontes na web, criando um cenário complexo onde a desinformação pode persistir silenciosamente. O desafio não é apenas corrigir respostas individuais de IA—é entender por que os sistemas de IA erram sobre as marcas e implementar correções sistemáticas no nível da fonte.

Sistemas de IA não inventam informações de marca do zero; eles as montam a partir do que já existe na internet. No entanto, esse processo cria vários pontos de falha previsíveis que levam à má representação da marca:

| Causa Raiz | Como Acontece | Impacto nos Negócios |

|---|---|---|

| Inconsistência de Fonte | Marca descrita de forma diferente entre sites, diretórios e artigos | IA infere consenso incorreto a partir de informações conflitantes |

| Fontes Autoritativas Desatualizadas | Entradas antigas na Wikipédia, diretórios ou páginas de comparação contêm dados incorretos | Correções mais recentes são ignoradas porque fontes antigas têm sinais de maior autoridade |

| Confusão de Entidade | Nomes de marcas semelhantes ou categorias sobrepostas confundem sistemas de IA | Concorrentes recebem crédito por suas capacidades ou sua marca é omitida completamente |

| Ausência de Sinais Primários | Falta de dados estruturados, páginas Sobre claras ou terminologia consistente | IA forçada a inferir informações, levando a descrições vagas ou incorretas |

Quando uma marca é descrita de maneiras diferentes entre plataformas, os sistemas de IA têm dificuldade em determinar qual versão é autoritativa. Em vez de pedir esclarecimentos, eles inferem consenso com base na frequência e autoridade percebida—eveno quando o consenso está errado. Pequenas diferenças em nomes, descrições ou posicionamento frequentemente são duplicadas entre plataformas e, uma vez repetidas, esses fragmentos tornam-se sinais que os modelos de IA tratam como confiáveis. O problema se intensifica quando páginas antigas, porém de alta autoridade, contêm informações incorretas; sistemas de IA frequentemente favorecem essas fontes antigas em detrimento de correções recentes, especialmente se essas correções não se espalharam amplamente por plataformas confiáveis.

Corrigir informações incorretas de marca em sistemas de IA exige uma abordagem fundamentalmente diferente da limpeza tradicional de SEO. No SEO tradicional, as marcas atualizam suas próprias listagens, corrigem dados NAP (Nome, Endereço, Telefone) e otimizam o conteúdo da página. A correção de marca em IA foca em mudar o que fontes confiáveis dizem sobre sua marca, não em controlar sua própria visibilidade. Você não corrige a IA diretamente—você corrige o que a IA confia. Tentar “corrigir” respostas de IA afirmando repetidamente alegações incorretas (mesmo para negá-las) pode ter efeito reverso, reforçando a associação que você deseja remover. Sistemas de IA reconhecem padrões, não intenção. Isso significa que cada correção deve começar no nível da fonte, trabalhando de trás para frente a partir de onde os sistemas de IA realmente aprendem as informações.

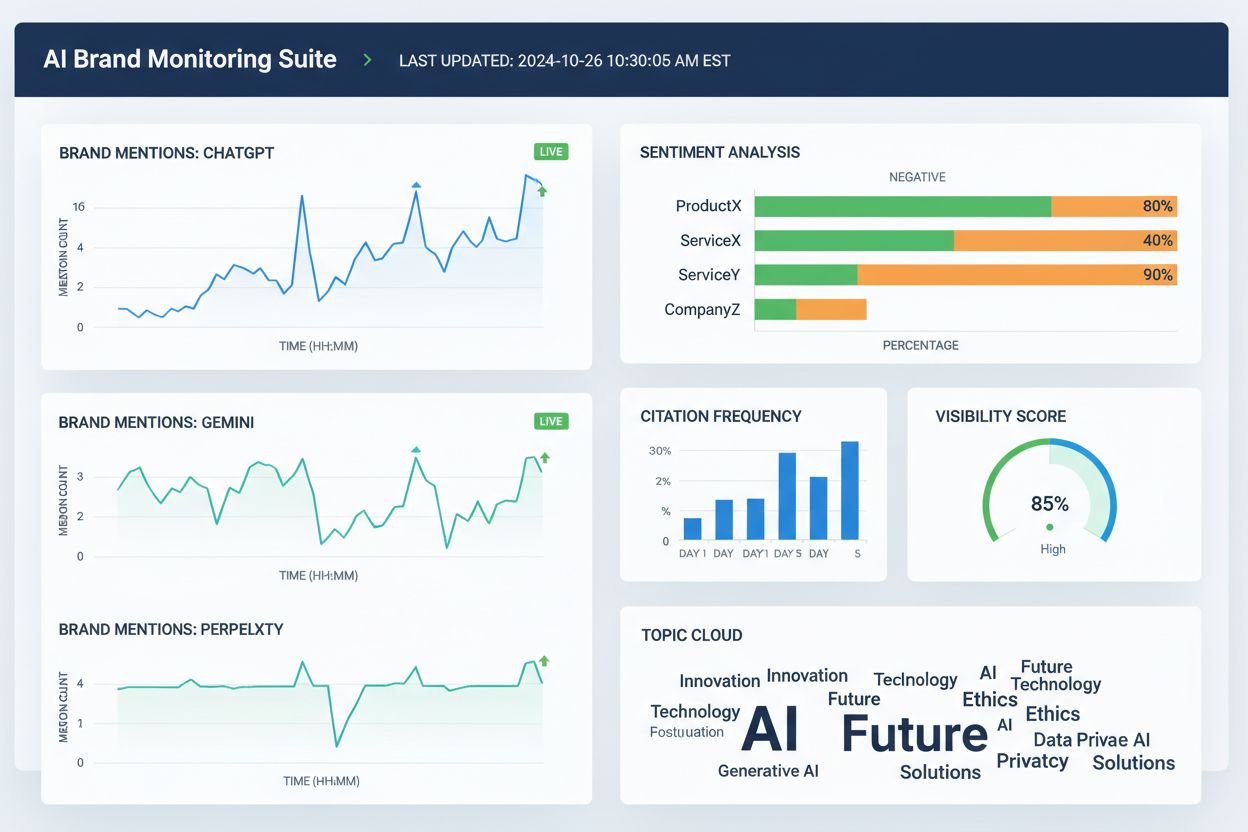

Antes de corrigir informações incorretas sobre a marca, é necessário ter visibilidade de como os sistemas de IA atualmente descrevem sua marca. O monitoramento eficaz foca em:

Verificações manuais são pouco confiáveis pois as respostas variam conforme o prompt, contexto e ciclo de atualização. Ferramentas estruturadas de monitoramento fornecem a visibilidade necessária para detectar erros cedo, antes que se enraízem nos sistemas de IA. Muitas marcas não percebem que estão sendo mal representadas em IA até que um cliente mencione ou uma crise surja. O monitoramento proativo previne isso ao captar inconsistências antes que se espalhem.

Uma vez identificadas informações incorretas sobre a marca, a correção deve ocorrer onde os sistemas de IA realmente aprendem—not onde o erro apenas aparece. Correções eficazes na fonte incluem:

O princípio chave é: correções funcionam apenas quando aplicadas na fonte. Alterar o que aparece nos outputs da IA sem corrigir as fontes subjacentes é, na melhor das hipóteses, temporário. Sistemas de IA reavaliam sinais continuamente à medida que novos conteúdos aparecem e páginas antigas ressurgem. Uma correção que não atinge a fonte original será eventualmente sobreposta pela desinformação original.

Ao corrigir informações incorretas de marca em diretórios, marketplaces ou plataformas alimentadas por IA, a maioria dos sistemas exige verificação que vincule a marca à titularidade e uso legítimo. Documentação comumente solicitada inclui:

O objetivo não é volume—é consistência. Plataformas avaliam se documentação, listagens e dados públicos da marca estão alinhados. Ter esses materiais organizados previamente reduz ciclos de rejeição e acelera a aprovação ao corrigir informações incorretas em escala. Consistência entre fontes sinaliza aos sistemas de IA que as informações da sua marca são confiáveis e autoritativas.

Diversas ferramentas agora ajudam equipes a acompanhar a representação da marca em plataformas de busca por IA e na web em geral. Embora as capacidades se sobreponham, geralmente focam em visibilidade, atribuição e consistência:

Essas ferramentas não corrigem informações incorretas diretamente. Em vez disso, ajudam as equipes a detectar erros cedo, identificar discrepâncias antes que se espalhem, validar se as correções na fonte melhoram a precisão da IA e monitorar tendências de longo prazo em atribuição e visibilidade. Usadas em conjunto com correções na fonte e documentação, as ferramentas de monitoramento fornecem o ciclo de feedback necessário para corrigir informações de marca de forma sustentável.

A precisão em buscas por IA melhora quando marcas são definidas como entidades claras, não apenas participantes vagos de uma categoria. Para reduzir a má representação em sistemas de IA, foque em:

O objetivo não é falar mais—é dizer a mesma coisa em todos os lugares. Quando sistemas de IA encontram definições consistentes da marca entre fontes autoritativas, eles param de adivinhar e passam a repetir a informação correta. Esse passo é especialmente importante para marcas que sofrem com menções incorretas, atribuição a concorrentes ou omissão em respostas relevantes de IA. Mesmo após corrigir informações incorretas, a precisão não é permanente. Sistemas de IA reavaliam sinais continuamente, o que torna a clareza constante indispensável.

Não existe um prazo fixo para corrigir má representação de marca em sistemas de IA. Modelos de IA atualizam com base na força dos sinais e consenso, não em datas de envio. Padrões típicos incluem:

Os primeiros avanços raramente aparecem como uma resposta “corrigida” de repente. Em vez disso, procure sinais indiretos: redução na variabilidade das respostas, menos descrições conflitantes, citações mais consistentes entre fontes e inclusão gradual da sua marca onde antes era omitida. Estagnação se manifesta de outra forma—se a mesma frase incorreta persiste apesar de múltiplas correções, geralmente indica que a fonte original não foi corrigida ou é necessário reforço mais forte em outro lugar.

A forma mais confiável de corrigir informações incorretas sobre marcas é reduzir as condições que permitem seu surgimento. Prevenção eficaz inclui:

Marcas que tratam a visibilidade em IA como um sistema vivo—não um projeto de limpeza pontual—recuperam-se mais rapidamente dos erros e experimentam menos recorrências de má representação. Prevenção não é sobre controlar outputs da IA. É sobre manter entradas limpas e consistentes que os sistemas de IA possam repetir com confiança. À medida que a busca por IA evolui, as marcas que se destacam são aquelas que reconhecem a correção de desinformação como um processo contínuo, requerendo monitoramento constante, gestão de fontes e reforço estratégico de informações corretas em plataformas confiáveis.

Correção de Desinformação em IA é o processo de identificar e corrigir informações incorretas, desatualizadas ou enganosas sobre marcas que aparecem em respostas geradas por IA. Diferente da checagem de fatos tradicional, o foco está em corrigir as fontes que as IAs confiam (diretórios, artigos, listagens), em vez de tentar editar diretamente os outputs da IA. O objetivo é garantir que, quando usuários perguntam sobre sua marca a sistemas de IA, recebam informações precisas.

Sistemas de IA como ChatGPT, Gemini e Perplexity agora influenciam como milhões de pessoas conhecem as marcas. Pesquisas mostram que 45% das consultas em IA produzem erros, e informações incorretas podem prejudicar a reputação, confundir clientes e levar à perda de negócios. Diferente da busca tradicional, onde as marcas controlam suas próprias listagens, sistemas de IA sintetizam informações de múltiplas fontes, tornando a precisão da marca mais difícil de controlar e mais crítica de gerenciar.

Não, a correção direta não é eficaz. Sistemas de IA não armazenam fatos de marcas em locais editáveis—they sintetizam respostas a partir de fontes externas. Pedir repetidamente para a IA 'corrigir' informações pode, na verdade, reforçar alucinações ao fortalecer a associação que você quer remover. Em vez disso, as correções devem ser feitas na fonte: atualizando diretórios, corrigindo listagens desatualizadas e publicando informações precisas em plataformas confiáveis.

Não há um prazo fixo porque os sistemas de IA atualizam com base na força e consenso dos sinais, não em datas de envio. Correções factuais menores aparecem em 2-4 semanas, esclarecimentos de entidade levam 1-3 meses, e substituição competitiva pode levar de 3-6 meses ou mais. O progresso raramente aparece como uma resposta 'corrigida' de repente—em vez disso, observe a redução da variabilidade nas respostas e maior consistência nas citações entre as fontes.

Diversas ferramentas agora acompanham a representação de marcas em plataformas de IA: Wellows monitora menções e sentimento em ChatGPT, Gemini e Perplexity; Profound compara visibilidade entre LLMs; Otterly.ai analisa sentimento de marca em respostas de IA; BrandBeacon fornece análises de posicionamento; Ahrefs Brand Radar rastreia menções na web; e AmICited.com é especializado em monitorar como marcas são citadas e representadas em sistemas de IA. Essas ferramentas ajudam a detectar erros cedo e validar se as correções estão funcionando.

Alucinações de IA ocorrem quando sistemas de IA geram informações que não se baseiam nos dados de treinamento ou são decodificadas incorretamente. Desinformação de IA é informação falsa ou enganosa que aparece nos outputs da IA, podendo resultar de alucinações, mas também de fontes desatualizadas, confusão de entidades ou dados inconsistentes entre plataformas. A correção de desinformação aborda tanto alucinações quanto imprecisões de origem que levam à representação incorreta da marca.

Monitore como sistemas de IA descrevem sua marca perguntando sobre sua empresa, produtos e posicionamento. Procure informações desatualizadas, descrições incorretas, detalhes ausentes ou atribuição a concorrentes. Use ferramentas de monitoramento para acompanhar menções em ChatGPT, Gemini e Perplexity. Verifique se sua marca é omitida de respostas relevantes. Compare descrições de IA com informações oficiais da marca para identificar divergências.

É um processo contínuo. Sistemas de IA reavaliam sinais constantemente à medida em que novos conteúdos aparecem e páginas antigas ressurgem. Uma correção pontual sem monitoramento contínuo será eventualmente sobreposta pela desinformação original. Marcas bem-sucedidas tratam a visibilidade em IA como um sistema vivo, mantendo definições de marca consistentes entre fontes, auditando diretórios regularmente e monitorando menções em IA continuamente para captar novos erros antes que se espalhem.

Acompanhe como sistemas de IA como ChatGPT, Gemini e Perplexity representam sua marca. Obtenha insights em tempo real sobre menções, citações e visibilidade da marca em plataformas de IA com AmICited.com.

Saiba como contestar informações imprecisas de IA, relatar erros ao ChatGPT e Perplexity e implementar estratégias para garantir que sua marca seja representada...

Aprenda métodos eficazes para identificar, verificar e corrigir informações imprecisas em respostas geradas por IA como ChatGPT, Perplexity e outros sistemas de...

Aprenda estratégias eficazes para identificar, monitorar e corrigir informações imprecisas sobre sua marca em respostas geradas por IA do ChatGPT, Perplexity e ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.