Ajuste Fino

Definição de ajuste fino: adaptando modelos de IA pré-treinados para tarefas específicas por meio de treinamento específico do domínio. Saiba como o ajuste fino...

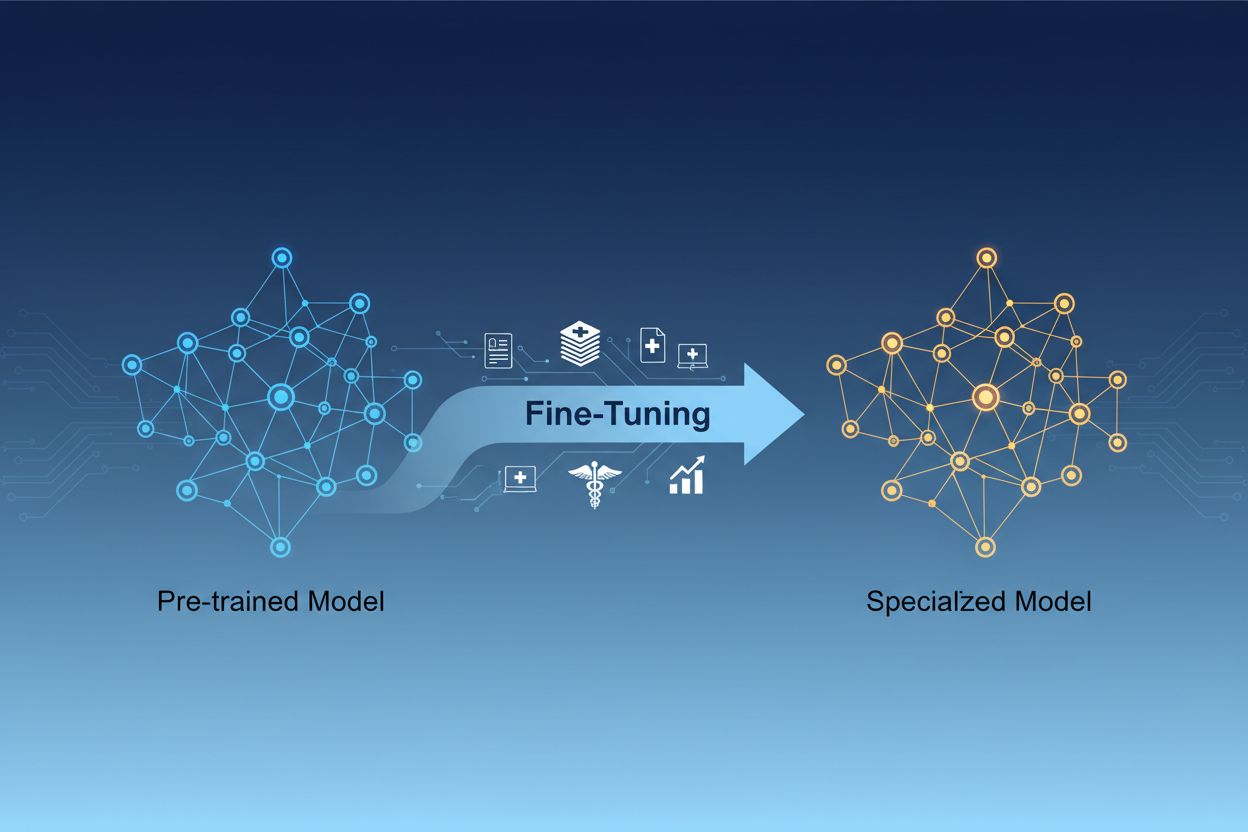

O ajuste fino de modelos de IA é o processo de adaptação de modelos de inteligência artificial pré-treinados para realizar tarefas específicas ou trabalhar com dados especializados, ajustando seus parâmetros por meio de treinamento adicional em conjuntos de dados específicos de domínio. Essa abordagem aproveita o conhecimento já existente enquanto personaliza os modelos para aplicações empresariais específicas, permitindo que as organizações criem sistemas de IA altamente especializados sem o custo computacional de treinar do zero.

O ajuste fino de modelos de IA é o processo de adaptação de modelos de inteligência artificial pré-treinados para realizar tarefas específicas ou trabalhar com dados especializados, ajustando seus parâmetros por meio de treinamento adicional em conjuntos de dados específicos de domínio. Essa abordagem aproveita o conhecimento já existente enquanto personaliza os modelos para aplicações empresariais específicas, permitindo que as organizações criem sistemas de IA altamente especializados sem o custo computacional de treinar do zero.

Ajuste fino de modelo de IA é o processo de pegar um modelo de inteligência artificial pré-treinado e adaptá-lo para executar tarefas específicas ou trabalhar com dados especializados. Em vez de treinar um modelo do zero, o ajuste fino aproveita o conhecimento fundamental já embutido em um modelo pré-treinado e ajusta seus parâmetros por meio de treinamento adicional em conjuntos de dados específicos de domínio ou tarefa. Essa abordagem combina a eficiência do aprendizado por transferência com a personalização necessária para aplicações empresariais específicas. O ajuste fino permite que as organizações criem modelos de IA altamente especializados sem o custo computacional e o investimento de tempo necessários para treinar do zero, tornando-se uma técnica essencial no desenvolvimento moderno de aprendizado de máquina.

A distinção entre ajuste fino e treinamento do zero representa uma das decisões mais importantes no desenvolvimento de aprendizado de máquina. Ao treinar um modelo do zero, você começa com pesos inicializados aleatoriamente e deve ensinar ao modelo tudo sobre padrões de linguagem, características visuais ou conhecimento de domínio usando conjuntos de dados massivos e recursos computacionais substanciais. Essa abordagem pode exigir semanas ou meses de treinamento e acesso a hardware especializado como GPUs ou TPUs. O ajuste fino, por outro lado, começa com um modelo que já entende padrões e conceitos fundamentais, exigindo apenas uma fração dos dados e do poder computacional para adaptá-lo às suas necessidades específicas. O modelo pré-treinado já aprendeu características gerais durante sua fase inicial de treinamento, então o ajuste fino se concentra em ajustar essas características para o seu caso de uso específico. Esse ganho de eficiência torna o ajuste fino a abordagem preferida para a maioria das organizações, pois reduz tanto o tempo de lançamento no mercado quanto os custos de infraestrutura, frequentemente alcançando desempenho superior em comparação com o treinamento de modelos menores do zero.

| Aspecto | Ajuste Fino | Treinamento do Zero |

|---|---|---|

| Tempo de Treinamento | Dias a semanas | Semanas a meses |

| Requisitos de Dados | Milhares a milhões de exemplos | Milhões a bilhões de exemplos |

| Custo Computacional | Moderado (uma única GPU geralmente suficiente) | Extremamente alto (múltiplas GPUs/TPUs necessárias) |

| Conhecimento Inicial | Aproveita pesos pré-treinados | Começa com inicialização aleatória |

| Desempenho | Geralmente superior com poucos dados | Melhor com conjuntos de dados massivos |

| Nível de Especialização Exigido | Intermediário | Avançado |

| Nível de Personalização | Alto para tarefas específicas | Flexibilidade máxima |

| Infraestrutura | Recursos padrão de nuvem | Clusters de hardware especializado |

O ajuste fino tornou-se uma capacidade crítica para organizações que buscam implantar soluções de IA que proporcionem vantagens competitivas. Adaptando modelos pré-treinados ao seu contexto empresarial específico, você pode criar sistemas de IA que compreendem a terminologia do seu setor, preferências dos clientes e requisitos operacionais com notável precisão. Essa personalização permite que empresas alcancem níveis de desempenho que modelos genéricos prontos para uso simplesmente não conseguem igualar, especialmente ao lidar com domínios especializados como saúde, serviços jurídicos ou suporte técnico. O custo-benefício do ajuste fino significa que até mesmo organizações menores agora podem acessar capacidades de IA de nível empresarial sem investimentos massivos em infraestrutura. Além disso, modelos ajustados podem ser implantados mais rapidamente, permitindo que as empresas respondam com agilidade a oportunidades de mercado e pressões competitivas. A capacidade de melhorar continuamente os modelos ajustando-os com novos dados garante que seus sistemas de IA permaneçam relevantes e eficazes à medida que as condições de negócios evoluem.

Principais benefícios de negócios do ajuste fino incluem:

Diversas técnicas consolidadas surgiram como melhores práticas no cenário de ajuste fino, cada uma com vantagens distintas dependendo de seus requisitos. Ajuste fino completo envolve a atualização de todos os parâmetros do modelo pré-treinado, oferecendo máxima flexibilidade e geralmente o melhor desempenho, mas exigindo recursos computacionais significativos e conjuntos de dados maiores para evitar overfitting. Métodos eficientes em parâmetros como LoRA (Low-Rank Adaptation) e QLoRA revolucionaram o campo ao permitir adaptação eficaz do modelo atualizando apenas uma pequena fração dos parâmetros, reduzindo drasticamente os requisitos de memória e o tempo de treinamento. Essas técnicas funcionam adicionando matrizes de baixo rank treináveis às matrizes de pesos do modelo, capturando adaptações específicas sem modificar os pesos originais. Módulos adaptadores representam outra abordagem, inserindo pequenas redes treináveis entre as camadas do modelo pré-treinado congelado, permitindo ajuste fino eficiente com parâmetros adicionais mínimos. Ajuste fino baseado em prompt foca em otimizar prompts de entrada em vez dos pesos do modelo, útil para modelos onde o acesso aos parâmetros é limitado. Ajuste fino por instruções treina modelos para seguir comandos e instruções específicas, particularmente importante para grandes modelos de linguagem que precisam responder adequadamente a solicitações diversas de usuários. A escolha entre essas técnicas depende de restrições computacionais, tamanho do conjunto de dados, requisitos de desempenho e da arquitetura específica do modelo em uso.

O ajuste fino de grandes modelos de linguagem (LLMs) apresenta oportunidades e desafios únicos em comparação ao ajuste fino de modelos menores ou outros tipos de redes neurais. LLMs modernos, como modelos no estilo GPT, contêm bilhões de parâmetros, tornando o ajuste fino completo proibitivo para a maioria das organizações. Essa realidade impulsionou a adoção de técnicas eficientes em parâmetros que permitem adaptação eficaz dos LLMs sem necessidade de infraestrutura de grande escala. Ajuste fino por instrução tornou-se especialmente importante para LLMs, nos quais modelos são treinados em exemplos de instruções emparelhadas com respostas de alta qualidade, permitindo que sigam diretivas de usuários de forma mais eficaz. Aprendizado por Reforço com Feedback Humano (RLHF) representa uma abordagem avançada de ajuste fino em que modelos são refinados com base em preferências e avaliações humanas, melhorando o alinhamento com valores e expectativas humanas. A quantidade relativamente pequena de dados específicos de tarefa necessária para ajustar LLMs—frequentemente apenas centenas ou milhares de exemplos—torna essa abordagem acessível a organizações sem grandes conjuntos de dados rotulados. No entanto, o ajuste fino de LLMs requer atenção cuidadosa à seleção de hiperparâmetros, agendamento de taxa de aprendizado e prevenção de esquecimento catastrófico, onde o modelo perde capacidades previamente aprendidas ao se adaptar a novas tarefas.

Organizações de diversos setores descobriram aplicações poderosas para modelos de IA ajustados que proporcionam valor comercial mensurável. Automação de atendimento ao cliente é um dos casos de uso mais prevalentes, onde modelos são ajustados com tickets de suporte, informações de produtos e estilos de comunicação específicos da empresa para criar chatbots capazes de lidar com consultas com expertise de domínio e consistência de marca. Análise de documentos médicos e jurídicos aproveita o ajuste fino para adaptar modelos de linguagem a terminologias especializadas, exigências regulatórias e formatos específicos do setor, permitindo extração e classificação de informações precisas. Análise de sentimento e moderação de conteúdo podem ser significativamente aprimoradas ao ajustar modelos em exemplos do seu setor ou comunidade, captando padrões e contextos linguísticos sutis que modelos genéricos não percebem. Geração de código e assistência ao desenvolvimento de software se beneficiam do ajuste fino com base no código, convenções de programação e padrões arquiteturais da sua organização, permitindo ferramentas de IA que geram código alinhado aos seus padrões. Sistemas de recomendação são frequentemente ajustados com dados de comportamento do usuário e catálogos de produtos para fornecer sugestões personalizadas que impulsionam engajamento e receita. Reconhecimento de entidades nomeadas e extração de informações de documentos específicos de domínio—como relatórios financeiros, artigos científicos ou especificações técnicas—podem ser drasticamente aprimorados com ajuste fino em exemplos relevantes. Essas aplicações diversas demonstram que o ajuste fino não se limita a um único setor ou caso de uso, mas sim representa uma capacidade fundamental para criar sistemas de IA que proporcionam vantagens competitivas em praticamente todos os domínios empresariais.

O processo de ajuste fino segue um fluxo de trabalho estruturado que começa com preparação cuidadosa e se estende até implantação e monitoramento. Preparação de dados é o primeiro passo crítico, exigindo que você colete, limpe e formate seu conjunto de dados específico de domínio de forma que corresponda à estrutura de entrada/saída esperada pelo modelo pré-treinado. Esse conjunto de dados deve ser representativo das tarefas que seu modelo ajustado executará em produção, e a qualidade importa mais que a quantidade—um conjunto de dados menor, mas de alta qualidade, geralmente supera um maior com rótulos inconsistentes ou ruidosos. Divisão treino-validação-teste garante que você possa avaliar adequadamente o desempenho do modelo, com alocações típicas de 70-80% para treino, 10-15% para validação e 10-15% para teste. Seleção de hiperparâmetros envolve escolher taxas de aprendizado, tamanhos de lote, número de épocas de treinamento e outros parâmetros que controlam o processo de ajuste fino; essas escolhas impactam significativamente o desempenho e a eficiência do treinamento. Inicialização do modelo usa os pesos pré-treinados como ponto de partida, preservando o conhecimento fundamental enquanto permite a adaptação dos parâmetros à sua tarefa específica. Execução do treinamento envolve atualizar iterativamente os parâmetros do modelo com seus dados de treinamento, monitorando o desempenho de validação para detectar overfitting. Avaliação e iteração utiliza seu conjunto de teste para avaliar o desempenho final e determinar se mais ajuste fino, hiperparâmetros diferentes ou mais dados de treinamento melhorariam os resultados. Preparação para implantação inclui otimizar o modelo para velocidade de inferência e eficiência de recursos, potencialmente através de técnicas de quantização ou destilação. Por fim, monitoramento e manutenção em produção garantem que o modelo continue apresentando bom desempenho conforme as distribuições de dados mudam ao longo do tempo, com re-treinamentos periódicos em novos dados para manter a precisão.

O ajuste fino, embora mais eficiente que o treinamento do zero, apresenta seus próprios desafios que os profissionais devem contornar cuidadosamente. Overfitting ocorre quando modelos memorizam os dados de treinamento em vez de aprender padrões generalizáveis, sendo um risco particular ao ajustar em conjuntos de dados pequenos; isso pode ser mitigado com técnicas como parada antecipada, regularização e aumento de dados. Esquecimento catastrófico acontece quando o ajuste fino faz com que modelos percam capacidades previamente aprendidas, especialmente problemático ao adaptar modelos de uso geral para tarefas especializadas; seleção cuidadosa da taxa de aprendizado e técnicas como destilação de conhecimento ajudam a preservar o conhecimento fundamental. Qualidade e rotulagem dos dados representam desafios práticos significativos, pois o ajuste fino requer exemplos rotulados de alta qualidade que representem com precisão seu domínio e casos de uso-alvo. Gestão de recursos computacionais exige equilibrar melhorias de desempenho com tempo de treinamento e custos de infraestrutura, especialmente importante ao trabalhar com grandes modelos. Sensibilidade a hiperparâmetros significa que o desempenho do ajuste fino pode variar drasticamente conforme a taxa de aprendizado, tamanho do lote e outras configurações, exigindo experimentação e validação sistemáticas.

Melhores práticas para ajuste fino bem-sucedido incluem:

As organizações frequentemente enfrentam a escolha entre três abordagens complementares para adaptar modelos de IA a tarefas específicas: ajuste fino, Geração Aumentada por Recuperação (RAG) e engenharia de prompts. Engenharia de prompts envolve criar instruções e exemplos cuidadosamente elaborados para guiar o comportamento do modelo sem modificar o próprio modelo; essa abordagem é rápida e não requer treinamento, mas tem eficácia limitada para tarefas complexas e não pode ensinar informações genuinamente novas aos modelos. RAG aumenta as respostas do modelo recuperando documentos ou dados relevantes de fontes externas antes de gerar respostas, permitindo que os modelos acessem informações atuais e conhecimento específico de domínio sem atualização de parâmetros; essa abordagem funciona bem para tarefas intensivas em conhecimento, mas adiciona latência e complexidade à inferência. Ajuste fino modifica os parâmetros do modelo para incorporar profundamente conhecimento e padrões específicos da tarefa, proporcionando o melhor desempenho para tarefas bem definidas com dados de treinamento suficientes, mas exigindo mais tempo e recursos do que as demais abordagens. A solução ideal geralmente combina essas técnicas: usando engenharia de prompts para prototipagem rápida, RAG para aplicações que exigem acesso a informações atualizadas e ajuste fino para sistemas críticos em desempenho, onde o investimento em treinamento é justificado. O ajuste fino se destaca quando você precisa de comportamento consistente e de alto desempenho em tarefas específicas, quando possui dados de treinamento suficientes e quando os ganhos de desempenho justificam o esforço de desenvolvimento. RAG é melhor para aplicações que exigem acesso a informações atuais ou proprietárias que mudam frequentemente. Engenharia de prompts serve como excelente ponto de partida para exploração e prototipagem antes de investir em abordagens mais intensivas em recursos. Compreender as forças e limitações de cada abordagem permite que as organizações tomem decisões informadas sobre quais técnicas empregar em diferentes componentes de seus sistemas de IA.

O aprendizado por transferência é o conceito mais amplo de aproveitar o conhecimento de uma tarefa para melhorar o desempenho em outra, enquanto o ajuste fino é uma implementação específica do aprendizado por transferência. O ajuste fino pega um modelo pré-treinado e ajusta seus parâmetros em novos dados, enquanto o aprendizado por transferência também pode incluir extração de características, onde você congela os pesos pré-treinados e treina apenas novas camadas. Todo ajuste fino envolve aprendizado por transferência, mas nem todo aprendizado por transferência requer ajuste fino.

O tempo de ajuste fino varia significativamente com base no tamanho do modelo, tamanho do conjunto de dados e hardware disponível. Usando técnicas eficientes em parâmetros como LoRA, um modelo de 13 bilhões de parâmetros pode ser ajustado em aproximadamente 5 horas em uma única GPU A100. Modelos menores ou métodos eficientes podem levar apenas algumas horas, enquanto o ajuste fino completo de modelos grandes pode levar dias ou semanas. A principal vantagem é que o ajuste fino é dramaticamente mais rápido do que treinar do zero, o que pode levar meses.

Sim, o ajuste fino foi projetado especificamente para funcionar de forma eficaz com dados limitados. Modelos pré-treinados já aprenderam padrões gerais, então normalmente você precisa apenas de centenas a milhares de exemplos para um ajuste fino eficaz, em comparação com milhões necessários para treinar do zero. No entanto, a qualidade dos dados importa mais que a quantidade—um conjunto de dados menor, mas de alta qualidade e representativo, terá desempenho melhor do que um conjunto maior com rótulos inconsistentes ou ruidosos.

LoRA (Low-Rank Adaptation) é uma técnica de ajuste fino eficiente em parâmetros que adiciona matrizes de baixo rank treináveis às matrizes de pesos do modelo, em vez de atualizar todos os parâmetros. Essa abordagem reduz os parâmetros treináveis em milhares de vezes, mantendo desempenho comparável ao ajuste fino completo. LoRA é importante porque torna o ajuste fino acessível em hardware padrão, reduz drasticamente os requisitos de memória e permite que as organizações ajustem grandes modelos sem infraestrutura cara.

Overfitting ocorre quando a perda de treinamento diminui, mas a perda de validação aumenta, indicando que o modelo está memorizando os dados de treinamento em vez de aprender padrões generalizáveis. Monitore ambas as métricas durante o treinamento—se o desempenho de validação se estabilizar ou piorar enquanto o desempenho de treinamento continua melhorando, seu modelo provavelmente está sofrendo overfitting. Implemente parada antecipada para interromper o treinamento quando o desempenho de validação parar de melhorar e use técnicas como regularização e aumento de dados para evitar overfitting.

Os custos do ajuste fino incluem recursos computacionais (tempo de GPU/TPU), preparação e rotulagem de dados, infraestrutura de armazenamento e implantação de modelos, além de monitoramento e manutenção contínuos. No entanto, esses custos são tipicamente de 10 a 100 vezes menores do que treinar modelos do zero. Usar técnicas eficientes como LoRA pode reduzir os custos computacionais em 80-90% em comparação ao ajuste fino completo, tornando o ajuste fino uma abordagem econômica para a maioria das organizações.

Sim, o ajuste fino normalmente melhora significativamente a precisão do modelo para tarefas específicas. Ao treinar com dados específicos de domínio, os modelos aprendem padrões e terminologias relevantes que modelos genéricos não captam. Estudos mostram que o ajuste fino pode melhorar a precisão em 10-30% ou mais, dependendo da tarefa e da qualidade do conjunto de dados. A melhoria é mais dramática quando a tarefa de ajuste fino difere da tarefa de pré-treinamento, pois o modelo adapta seus recursos aprendidos aos seus requisitos específicos.

O ajuste fino permite que as organizações mantenham dados sensíveis em sua própria infraestrutura, em vez de enviá-los para APIs de terceiros. Você pode ajustar modelos localmente em dados proprietários ou regulados sem expô-los a serviços externos, garantindo conformidade com regulamentos de proteção de dados como GDPR, HIPAA ou requisitos específicos do setor. Essa abordagem oferece benefícios de segurança e conformidade, mantendo as vantagens de desempenho dos modelos pré-treinados.

Acompanhe como sistemas de IA como GPTs, Perplexity e Google AI Overviews citam e fazem referência à sua marca com a plataforma de monitoramento de IA da AmICited.

Definição de ajuste fino: adaptando modelos de IA pré-treinados para tarefas específicas por meio de treinamento específico do domínio. Saiba como o ajuste fino...

Descubra a adaptação de IA em tempo real – a tecnologia que permite que sistemas de IA aprendam continuamente com eventos e dados atuais. Explore como funciona ...

Compare estratégias de otimização de dados de treinamento e recuperação em tempo real para IA. Saiba quando usar fine-tuning versus RAG, implicações de custo e ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.