Fatores de Ranqueamento em Buscas por IA: Como os LLMs Decidem o Que Citar

Descubra os fatores de ranqueamento em buscas por IA no ChatGPT, Perplexity, Google AI Overviews e Claude. Aprenda como os LLMs ranqueiam conteúdos e são citado...

O grau em que as plataformas de IA divulgam como selecionam e classificam fontes ao gerar respostas. Transparência no ranqueamento de IA refere-se à visibilidade dos algoritmos e critérios que determinam quais fontes aparecem em respostas geradas por IA, diferenciando-se do ranqueamento tradicional dos motores de busca. Essa transparência é fundamental para criadores de conteúdo, editores e usuários que precisam entender como as informações são selecionadas e priorizadas. Sem transparência, os usuários não podem verificar a credibilidade das fontes ou compreender possíveis vieses no conteúdo gerado por IA.

O grau em que as plataformas de IA divulgam como selecionam e classificam fontes ao gerar respostas. Transparência no ranqueamento de IA refere-se à visibilidade dos algoritmos e critérios que determinam quais fontes aparecem em respostas geradas por IA, diferenciando-se do ranqueamento tradicional dos motores de busca. Essa transparência é fundamental para criadores de conteúdo, editores e usuários que precisam entender como as informações são selecionadas e priorizadas. Sem transparência, os usuários não podem verificar a credibilidade das fontes ou compreender possíveis vieses no conteúdo gerado por IA.

Transparência no ranqueamento de IA refere-se à divulgação de como sistemas de inteligência artificial selecionam, priorizam e apresentam fontes ao gerar respostas às consultas dos usuários. Diferente dos motores de busca tradicionais, que exibem listas ranqueadas de links, plataformas modernas de IA como Perplexity, ChatGPT e AI Overviews do Google integram a seleção de fontes ao processo de geração de respostas, tornando os critérios de ranqueamento em grande parte invisíveis para os usuários. Essa opacidade cria uma lacuna crítica entre o que o usuário vê (uma resposta sintetizada) e como essa resposta foi construída (quais fontes foram escolhidas, ponderadas e citadas). Para criadores de conteúdo e editores, essa falta de transparência significa que sua visibilidade depende de algoritmos que eles não podem compreender ou influenciar por métodos tradicionais de otimização. A distinção em relação à transparência dos motores de busca é significativa: enquanto o Google publica fatores gerais de ranqueamento e diretrizes de qualidade, plataformas de IA frequentemente tratam seus mecanismos de seleção de fontes como segredos comerciais proprietários. Os principais interessados afetados incluem criadores de conteúdo buscando visibilidade, editores preocupados com atribuição de tráfego, gestores de marca monitorando reputação, pesquisadores verificando fontes de informação e usuários que precisam entender a credibilidade das respostas geradas por IA. Compreender a transparência no ranqueamento de IA tornou-se essencial para quem produz, distribui ou depende de conteúdo digital em um cenário de informações cada vez mais mediado por IA.

Plataformas de IA utilizam sistemas de Geração Aumentada por Recuperação (RAG), que combinam modelos de linguagem com busca de informações em tempo real para fundamentar respostas em fontes reais, e não apenas dados de treinamento. O processo RAG envolve três etapas principais: recuperação (encontrar documentos relevantes), ranqueamento (ordenar fontes por relevância) e geração (sintetizar informações mantendo citações). Diferentes plataformas adotam abordagens distintas de ranqueamento—Perplexity prioriza autoridade e atualidade das fontes, AI Overviews do Google enfatiza relevância temática e sinais E-E-A-T (Experiência, Expertise, Autoridade, Confiabilidade), enquanto o ChatGPT Search equilibra qualidade das fontes com abrangência das respostas. Os fatores que influenciam a seleção das fontes normalmente incluem autoridade do domínio (reputação estabelecida e perfil de backlinks), atualidade do conteúdo (novidade das informações), relevância temática (alinhamento semântico com a consulta), sinais de engajamento (métricas de interação do usuário) e frequência de citação (quantas vezes fontes são referenciadas por outros sites autoritativos). Os sistemas de IA ponderam esses sinais de forma diferente dependendo da intenção da consulta—consultas factuais podem priorizar autoridade e atualidade, enquanto consultas opinativas podem enfatizar diversidade de perspectivas e engajamento. Os algoritmos de ranqueamento permanecem em grande parte não divulgados, embora a documentação das plataformas ofereça insights limitados sobre seus mecanismos de ponderação.

| Plataforma | Transparência de Citação | Critérios de Seleção de Fontes | Divulgação do Algoritmo de Ranqueamento | Controle do Usuário |

|---|---|---|---|---|

| Perplexity | Alta - citações em linha com links | Autoridade, atualidade, relevância, expertise temática | Moderada - alguma documentação | Média - opções de filtro de fontes |

| Google AI Overviews | Média - fontes citadas listadas | E-E-A-T, relevância temática, atualidade, engajamento | Baixa - divulgação mínima | Baixa - customização limitada |

| ChatGPT Search | Média - fontes listadas separadamente | Qualidade, relevância, abrangência, autoridade | Baixa - algoritmo proprietário | Baixa - sem customização do ranqueamento |

| Brave Leo | Média - atribuição de fontes | Fontes com respeito à privacidade, relevância, autoridade | Baixa - foco em privacidade | Média - opções de seleção de fontes |

| Consensus | Muito Alta - foco acadêmico com métricas | Contagem de citações, status de revisão por pares, atualidade, relevância na área | Alta - padrões acadêmicos transparentes | Alta - filtro por tipo e qualidade de estudo |

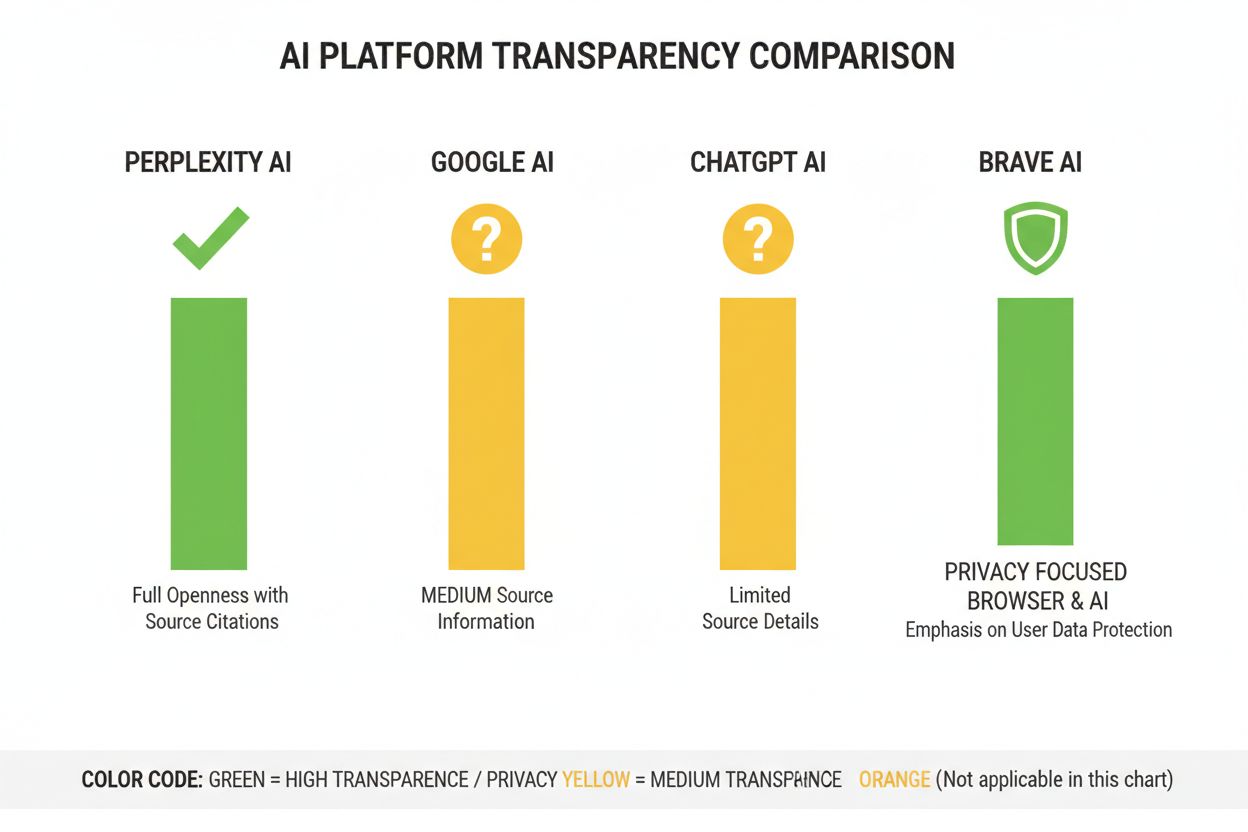

A indústria de IA carece de práticas padronizadas de divulgação sobre como funcionam os sistemas de ranqueamento, criando um cenário fragmentado onde cada plataforma determina seu próprio nível de transparência. O ChatGPT Search da OpenAI oferece explicações mínimas sobre seleção de fontes, sistemas de IA da Meta fornecem documentação limitada, e os AI Overviews do Google divulgam mais que concorrentes, mas ainda retêm detalhes críticos dos algoritmos. As plataformas resistem à divulgação total alegando vantagem competitiva, questões proprietárias e a complexidade de explicar sistemas de aprendizado de máquina ao público geral—porém essa opacidade impede auditoria externa e responsabilidade. O problema da “lavagem de fonte” surge quando sistemas de IA citam fontes que já agregam ou reescrevem conteúdo original, obscurecendo a verdadeira origem da informação e potencialmente amplificando desinformação por múltiplas camadas de síntese. A pressão regulatória está aumentando: a Lei de IA da UE exige que sistemas de IA de alto risco mantenham documentação dos dados de treinamento e dos processos de decisão, enquanto a Política de Responsabilidade da NTIA requer que empresas divulguem capacidades, limitações e casos de uso apropriados de sistemas de IA. Falhas específicas de divulgação incluem as dificuldades iniciais da Perplexity com atribuição correta (posteriormente aprimorada), explicação vaga do Google sobre como os AI Overviews selecionam fontes, e a transparência limitada do ChatGPT sobre por que certas fontes aparecem nas respostas enquanto outras não. A falta de métricas padronizadas para medir transparência dificulta a comparação objetiva das plataformas por usuários e reguladores.

A opacidade dos sistemas de ranqueamento de IA cria desafios significativos de visibilidade para criadores de conteúdo, já que estratégias tradicionais de SEO, pensadas para motores de busca, não se traduzem diretamente em otimização para plataformas de IA. Editores não conseguem entender facilmente por que seu conteúdo aparece em algumas respostas de IA e em outras não, tornando impossível desenvolver estratégias direcionadas para melhorar a visibilidade em respostas geradas por IA. Viés de citação ocorre quando sistemas de IA favorecem desproporcionalmente certas fontes—grandes veículos de notícias, instituições acadêmicas ou sites com alto tráfego—enquanto marginalizam editores menores, criadores independentes e especialistas de nicho que podem ter informações igualmente valiosas. Pequenos editores enfrentam desvantagens particulares porque sistemas de ranqueamento de IA frequentemente atribuem alto peso à autoridade do domínio, e sites novos ou especializados não têm o perfil de backlinks e reconhecimento de marca dos grandes veículos. Pesquisas do Search Engine Land indicam que os AI Overviews reduziram as taxas de cliques para resultados tradicionais de busca em 18-64% dependendo do tipo de consulta, com o tráfego concentrado entre as poucas fontes citadas nas respostas de IA. A distinção entre SEO (Otimização para Mecanismos de Busca) e GEO (Otimização para Motores Generativos) torna-se fundamental—enquanto SEO foca no ranqueamento em buscas tradicionais, a GEO exige entender e otimizar para critérios de seleção de plataformas de IA, que permanecem em sua maioria opacos. Criadores de conteúdo precisam de ferramentas como o AmICited.com para monitorar onde seu conteúdo aparece em respostas de IA, acompanhar frequência de citação e entender sua visibilidade em diferentes plataformas de IA.

A indústria de IA desenvolveu vários frameworks para documentar e divulgar o comportamento dos sistemas, embora a adoção ainda seja inconsistente entre plataformas. Model Cards fornecem documentação padronizada do desempenho dos modelos de aprendizado de máquina, casos de uso pretendidos, limitações e análise de viés—semelhante a rótulos nutricionais para sistemas de IA. Datasheets for Datasets documentam a composição, metodologia de coleta e potenciais vieses dos dados de treinamento, abordando o princípio de que sistemas de IA são tão bons quanto seus dados de treinamento. System Cards adotam uma abordagem mais ampla, documentando o comportamento do sistema de ponta a ponta, incluindo como os componentes interagem, possíveis modos de falha e desempenho no mundo real para diferentes grupos de usuários. A Política de Responsabilidade da NTIA recomenda que empresas mantenham documentação detalhada do desenvolvimento, teste e implementação de sistemas de IA, com ênfase especial em aplicações de alto risco que afetam o bem-estar público. A Lei de IA da UE exige que sistemas de IA de alto risco mantenham documentação técnica, registros de dados de treinamento e logs de desempenho, com requisitos para relatórios de transparência e notificação ao usuário. As melhores práticas do setor cada vez mais incluem:

A Perplexity posicionou-se como a plataforma de IA mais transparente em citações, exibindo links de fontes em linha ao longo das respostas e permitindo que os usuários vejam exatamente quais fontes contribuíram para cada afirmação. A plataforma fornece documentação relativamente clara de sua abordagem de ranqueamento, enfatizando autoridade da fonte, expertise temática e atualidade do conteúdo, embora a ponderação exata desses fatores permaneça proprietária. Os AI Overviews do Google oferecem transparência moderada ao listar fontes citadas ao final das respostas, mas explicam pouco sobre por que certas fontes foram selecionadas em detrimento de outras ou como o algoritmo de ranqueamento pondera diferentes sinais. A documentação do Google enfatiza os princípios E-E-A-T, mas não revela completamente como esses são medidos ou ponderados no processo de ranqueamento em IA. O ChatGPT Search da OpenAI representa um meio-termo, exibindo fontes separadamente do texto da resposta e permitindo que os usuários acessem o conteúdo original, mas oferecendo explicação mínima dos critérios de seleção ou metodologia de ranqueamento. O Brave Leo prioriza transparência com foco na privacidade, informando que utiliza fontes respeitosas à privacidade e não rastreia consultas dos usuários, embora isso implique em explicações menos detalhadas dos mecanismos de ranqueamento. O Consensus se destaca ao focar exclusivamente em pesquisa acadêmica, oferecendo alta transparência por meio de métricas de citação, status de revisão por pares e indicadores de qualidade dos estudos—tornando-o a plataforma mais transparente em termos algorítmicos para consultas voltadas à pesquisa. O controle do usuário varia significativamente: Perplexity permite filtragem de fontes, Consensus possibilita filtro por tipo e qualidade de estudo, enquanto Google e ChatGPT oferecem mínima customização das preferências de ranqueamento. A variação nas abordagens de transparência reflete diferentes modelos de negócio e públicos-alvo, com plataformas acadêmicas priorizando divulgação enquanto plataformas de consumo equilibram transparência e interesses proprietários.

Confiança e credibilidade dependem fundamentalmente de os usuários entenderem como a informação chega até eles—quando sistemas de IA ocultam suas fontes ou lógica de ranqueamento, os usuários não podem verificar afirmações de forma independente ou avaliar a confiabilidade das fontes. A transparência possibilita verificação e checagem de fatos, permitindo que pesquisadores, jornalistas e usuários informados rastreiem afirmações até as fontes originais e avaliem sua precisão e contexto. Os benefícios de prevenção de desinformação e viés são substanciais: quando algoritmos de ranqueamento são visíveis, pesquisadores podem identificar vieses sistemáticos (como favorecimento de certas perspectivas políticas ou interesses comerciais), e plataformas podem ser responsabilizadas por amplificar informações falsas. Responsabilidade algorítmica representa um direito fundamental dos usuários em sociedades democráticas—pessoas merecem entender como sistemas que moldam seu ambiente informacional tomam decisões, especialmente quando esses sistemas influenciam opinião pública, decisões de compra e acesso ao conhecimento. Para pesquisa e trabalho acadêmico, transparência é essencial pois acadêmicos precisam entender a seleção de fontes para contextualizar adequadamente resumos gerados por IA e garantir que não estejam confiando inadvertidamente em conjuntos de fontes enviesados ou incompletos. As implicações de negócios para criadores de conteúdo são profundas: sem entender fatores de ranqueamento, editores não podem otimizar estratégias de conteúdo, criadores menores não podem competir de forma justa com grandes veículos, e todo o ecossistema torna-se menos meritocrático. A transparência também protege usuários contra manipulação—quando critérios de ranqueamento são ocultos, agentes mal-intencionados podem explorar vulnerabilidades desconhecidas para promover conteúdo enganoso, enquanto sistemas transparentes podem ser auditados e aprimorados.

Tendências regulatórias estão conduzindo para a transparência obrigatória: a implementação da Lei de IA da UE em 2025-2026 exigirá documentação e divulgação detalhada para sistemas de IA de alto risco, enquanto regulações semelhantes estão surgindo no Reino Unido, Califórnia e outros lugares. O setor caminha para a padronização das práticas de transparência, com organizações como a Partnership on AI e instituições acadêmicas desenvolvendo frameworks comuns para documentar e divulgar o comportamento de sistemas de IA. A demanda dos usuários por transparência cresce à medida que aumenta a consciência sobre o papel da IA na distribuição de informações—pesquisas indicam que mais de 70% dos usuários querem entender como sistemas de IA selecionam fontes e ranqueiam informações. Inovações técnicas em IA explicável (XAI) tornam cada vez mais viável fornecer explicações detalhadas sobre decisões de ranqueamento sem expor integralmente algoritmos proprietários, usando técnicas como LIME (Local Interpretable Model-agnostic Explanations) e SHAP (SHapley Additive exPlanations). Ferramentas de monitoramento como o AmICited.com tornar-se-ão cada vez mais importantes à medida que as plataformas implementam medidas de transparência, ajudando criadores de conteúdo e editores a acompanhar sua visibilidade em múltiplos sistemas de IA e compreender como mudanças no ranqueamento afetam seu alcance. A convergência entre requisitos regulatórios, expectativas dos usuários e capacidades técnicas sugere que 2025-2026 serão anos decisivos para a transparência no ranqueamento de IA, com as plataformas provavelmente adotando práticas de divulgação mais padronizadas, implementando melhores controles de seleção de fontes para o usuário e oferecendo explicações mais claras da lógica de ranqueamento. O cenário futuro provavelmente contará com transparência em camadas—plataformas acadêmicas e de pesquisa liderando com alta divulgação, plataformas de consumo oferecendo transparência moderada com opções de customização ao usuário e conformidade regulatória tornando-se uma expectativa básica em todo o setor.

Transparência no ranqueamento de IA refere-se ao quão abertamente as plataformas de IA divulgam seus algoritmos para seleção e ranqueamento de fontes em respostas geradas. Isso é importante porque os usuários precisam entender a credibilidade das fontes, criadores de conteúdo precisam otimizar para visibilidade em IA, e pesquisadores precisam verificar fontes de informação. Sem transparência, sistemas de IA podem amplificar desinformação e criar vantagens injustas para veículos estabelecidos em detrimento de pequenos editores.

Plataformas de IA utilizam sistemas de Geração Aumentada por Recuperação (RAG) que combinam modelos de linguagem com recuperação de informações em tempo real. Elas ranqueiam fontes com base em fatores como autoridade do domínio, atualidade do conteúdo, relevância temática, sinais de engajamento e frequência de citação. No entanto, a ponderação exata desses fatores permanece em grande parte proprietária e não divulgada pela maioria das plataformas.

O SEO tradicional foca no ranqueamento em listas de links dos motores de busca, onde o Google publica fatores gerais de ranqueamento. Já a transparência no ranqueamento de IA diz respeito a como as plataformas de IA selecionam fontes para respostas sintetizadas, o que envolve critérios diferentes e é amplamente não divulgado. Enquanto estratégias de SEO são bem documentadas, fatores de ranqueamento em IA permanecem em sua maioria opacos.

Você pode acessar as fontes originais para verificar as afirmações em seu contexto completo, checar se as fontes são de domínios autoritativos, buscar status de revisão por pares (especialmente em conteúdo acadêmico) e cruzar informações entre várias fontes. Ferramentas como o AmICited ajudam a rastrear quais fontes aparecem em respostas de IA e com que frequência seu conteúdo é citado.

Consensus lidera em transparência ao focar exclusivamente em pesquisas acadêmicas revisadas por pares com métricas claras de citação. Perplexity fornece citações de fontes em linha e documentação moderada dos fatores de ranqueamento. Os AI Overviews do Google oferecem transparência média, enquanto o ChatGPT Search e o Brave Leo fornecem divulgação limitada de seus algoritmos de ranqueamento.

Model cards são documentação padronizada do desempenho de sistemas de IA, usos pretendidos, limitações e análise de viés. Datasheets documentam a composição dos dados de treinamento, métodos de coleta e potenciais vieses. System cards descrevem o comportamento do sistema de ponta a ponta. Essas ferramentas ajudam a tornar sistemas de IA mais transparentes e comparáveis, semelhante a rótulos nutricionais para alimentos.

A Lei de IA da UE exige que sistemas de IA de alto risco mantenham documentação técnica detalhada, registros de dados de treinamento e logs de desempenho. Ela exige relatórios de transparência e notificação ao usuário sobre o uso do sistema de IA. Esses requisitos estão pressionando as plataformas de IA a ampliarem a divulgação dos mecanismos de ranqueamento e critérios de seleção de fontes.

AmICited.com é uma plataforma de monitoramento de citações em IA que rastreia como sistemas de IA como Perplexity, Google AI Overviews e ChatGPT citam sua marca e conteúdo. Ela oferece visibilidade sobre quais fontes aparecem em respostas de IA, com que frequência seu conteúdo é citado e como sua transparência no ranqueamento se compara entre diferentes plataformas de IA.

Acompanhe como plataformas de IA como Perplexity, Google AI Overviews e ChatGPT citam o seu conteúdo. Entenda sua transparência no ranqueamento e otimize sua visibilidade em motores de busca de IA com o AmICited.

Descubra os fatores de ranqueamento em buscas por IA no ChatGPT, Perplexity, Google AI Overviews e Claude. Aprenda como os LLMs ranqueiam conteúdos e são citado...

Saiba por que a atualização do conteúdo é crucial para a visibilidade em buscas por IA. Descubra como ChatGPT, Perplexity e outros motores de IA priorizam conte...

Aprenda a metodologia completa passo a passo para realizar uma auditoria de visibilidade em IA. Descubra como medir menções à marca, citações e visibilidade em ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.