Assistentes de IA Ambiente

Saiba o que são assistentes de IA ambiente, como funcionam em casas inteligentes, seu impacto nas decisões de compra e o futuro dos ambientes de vida inteligent...

Ambientes isolados de sandbox projetados para validar, avaliar e depurar modelos e aplicações de inteligência artificial antes da implantação em produção. Esses espaços controlados permitem testar o desempenho de conteúdo de IA em diferentes plataformas, medir métricas e garantir confiabilidade sem afetar sistemas ativos ou expor dados sensíveis.

Ambientes isolados de sandbox projetados para validar, avaliar e depurar modelos e aplicações de inteligência artificial antes da implantação em produção. Esses espaços controlados permitem testar o desempenho de conteúdo de IA em diferentes plataformas, medir métricas e garantir confiabilidade sem afetar sistemas ativos ou expor dados sensíveis.

Um Ambiente de Testes de IA é um espaço computacional controlado e isolado, projetado para validar, avaliar e depurar modelos e aplicações de inteligência artificial antes do envio para sistemas de produção. Ele funciona como um sandbox onde desenvolvedores, cientistas de dados e equipes de QA podem executar modelos de IA com segurança, testar diferentes configurações e medir o desempenho com base em métricas pré-definidas sem afetar sistemas ativos ou expor dados sensíveis. Esses ambientes replicam as condições de produção mantendo o isolamento total, permitindo que as equipes identifiquem problemas, otimizem o comportamento dos modelos e garantam confiabilidade em diversos cenários. O ambiente de teste atua como uma etapa crítica de qualidade no ciclo de desenvolvimento de IA, fazendo a ponte entre a prototipagem experimental e a implantação em nível empresarial.

Um Ambiente de Testes de IA completo é composto por diversas camadas técnicas interconectadas que trabalham juntas para oferecer capacidades plenas de teste. A camada de execução de modelos realiza a inferência e computação, suportando múltiplos frameworks (PyTorch, TensorFlow, ONNX) e tipos de modelo (LLMs, visão computacional, séries temporais). A camada de gestão de dados administra conjuntos de dados de teste, fixtures e geração de dados sintéticos mantendo isolamento e conformidade. O framework de avaliação inclui mecanismos de métricas, bibliotecas de asserção e sistemas de pontuação que comparam as saídas dos modelos aos resultados esperados. A camada de monitoramento e logs captura rastros de execução, métricas de desempenho, dados de latência e logs de erro para análise posterior. A camada de orquestração gerencia fluxos de teste, execução paralela, alocação de recursos e provisionamento do ambiente. Abaixo está uma comparação dos principais componentes arquiteturais entre diferentes tipos de ambientes de teste:

| Componente | Teste de LLM | Visão Computacional | Séries Temporais | Multi-Modal |

|---|---|---|---|---|

| Execução do Modelo | Inferência Transformer | Inferência acelerada por GPU | Processamento sequencial | Execução híbrida |

| Formato de Dados | Texto/tokens | Imagens/tensores | Sequências numéricas | Mídia mista |

| Métricas de Avaliação | Similaridade semântica, alucinação | Acurácia, IoU, F1-score | RMSE, MAE, MAPE | Alinhamento cross-modal |

| Requisitos de Latência | 100-500ms típico | 50-200ms típico | <100ms típico | 200-1000ms típico |

| Método de Isolamento | Container/VM | Container/VM | Container/VM | microVM Firecracker |

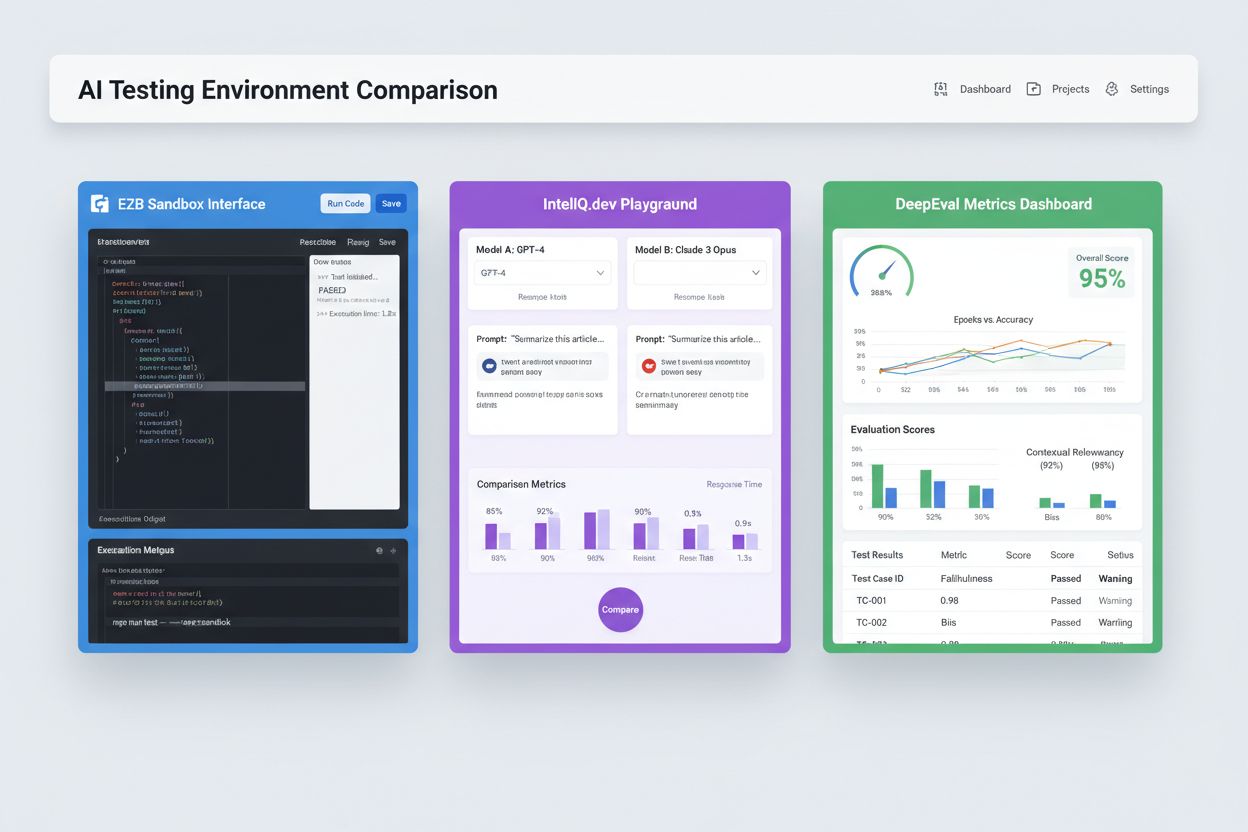

Ambientes modernos de Testes de IA devem suportar ecossistemas de modelos heterogêneos, permitindo que equipes avaliem aplicações em diferentes provedores de LLM, frameworks e destinos de implantação simultaneamente. O teste multiplataforma possibilita que organizações comparem saídas de modelos do GPT-4 da OpenAI, Claude da Anthropic, Mistral e alternativas open-source como Llama no mesmo ambiente de testes, facilitando decisões informadas de seleção de modelo. Plataformas como E2B oferecem sandboxes isolados que executam códigos gerados por qualquer LLM, suportando Python, JavaScript, Ruby e C++ com acesso total ao sistema de arquivos, terminal e instalação de pacotes. O IntelIQ.dev permite comparação lado a lado de múltiplos modelos de IA com interfaces unificadas, permitindo testar prompts com limitações de segurança e templates conscientes de políticas em diferentes provedores. Os ambientes de teste devem lidar com:

Ambientes de Testes de IA atendem a necessidades organizacionais diversas nos setores de desenvolvimento, garantia de qualidade e conformidade. Equipes de desenvolvimento usam ambientes de teste para validar o comportamento do modelo durante o desenvolvimento iterativo, testando variações de prompts, ajustando parâmetros e depurando saídas inesperadas antes da integração. Equipes de ciência de dados utilizam esses ambientes para avaliar desempenho em conjuntos de dados de teste, comparar arquiteturas distintas e medir métricas como acurácia, precisão, recall e F1-score. O monitoramento em produção envolve testes contínuos dos modelos implantados frente a métricas de referência, detectando degradação de desempenho e acionando pipelines de re-treinamento ao ultrapassar limites de qualidade. Equipes de conformidade e segurança utilizam ambientes de teste para garantir que os modelos atendam exigências regulatórias, não gerem saídas tendenciosas e tratem dados sensíveis de forma adequada. Aplicações empresariais incluem:

O cenário de testes em IA inclui plataformas especializadas para diferentes cenários e escalas organizacionais. DeepEval é um framework open-source de avaliação de LLMs com mais de 50 métricas baseadas em pesquisas, incluindo correção de resposta, similaridade semântica, detecção de alucinação e pontuação de toxicidade, com integração nativa ao Pytest para fluxos CI/CD. O LangSmith (da LangChain) oferece observabilidade, avaliação e implantação com rastreamento integrado, versionamento de prompts e gestão de datasets para aplicações com LLMs. O E2B proporciona sandboxes seguros e isolados alimentados por microVMs Firecracker, suportando execução de código com startup inferior a 200ms, sessões de até 24 horas e integração com os principais provedores de LLM. O IntelIQ.dev enfatiza testes com privacidade, criptografia de ponta a ponta, controle de acesso baseado em função e suporte a múltiplos modelos de IA como GPT-4, Claude e alternativas open-source. A tabela a seguir compara as principais capacidades:

| Ferramenta | Foco Principal | Métricas | Integração CI/CD | Suporte Multi-Modelo | Modelo de Preço |

|---|---|---|---|---|---|

| DeepEval | Avaliação de LLM | 50+ métricas | Pytest nativo | Limitado | Open-source + cloud |

| LangSmith | Observabilidade & avaliação | Métricas personalizadas | Via API | Ecossistema LangChain | Freemium + empresarial |

| E2B | Execução de código | Métricas de desempenho | GitHub Actions | Todos os LLMs | Pay-per-use + empresarial |

| IntelIQ.dev | Testes com foco em privacidade | Métricas personalizadas | Construtor de fluxos | GPT-4, Claude, Mistral | Assinatura |

Ambientes empresariais de Testes de IA devem implementar controles rigorosos de segurança para proteger dados sensíveis, manter conformidade regulatória e evitar acessos não autorizados. O isolamento de dados exige que dados de teste nunca vazem para APIs externas ou serviços de terceiros; plataformas como E2B usam microVMs Firecracker para isolamento total do processo sem kernel compartilhado. Padrões de criptografia devem incluir criptografia de ponta a ponta para dados em repouso e em trânsito, com suporte aos requisitos de HIPAA, SOC 2 Tipo 2 e GDPR. Controles de acesso precisam aplicar permissões baseadas em função, registro de auditoria e fluxos de aprovação para cenários de teste sensíveis. Boas práticas incluem: manter datasets de teste separados sem dados de produção, implementar mascaramento de dados para informações pessoalmente identificáveis (PII), usar geração de dados sintéticos para testes realistas sem riscos de privacidade, realizar auditorias regulares de segurança na infraestrutura de testes e documentar todos os resultados para fins de conformidade. Organizações também devem adotar mecanismos de detecção de viés para identificar comportamentos discriminatórios do modelo, utilizar ferramentas de interpretabilidade como SHAP ou LIME para compreender as decisões do modelo, e estabelecer logs de decisão para rastrear como os modelos chegam a determinadas saídas para responsabilização regulatória.

Ambientes de Testes de IA precisam integrar-se perfeitamente aos pipelines de integração e entrega contínua já existentes, possibilitando barreiras automáticas de qualidade e ciclos rápidos de iteração. A integração nativa com CI/CD permite que a execução dos testes seja acionada automaticamente em cada commit, pull request ou intervalos agendados, usando plataformas como GitHub Actions, GitLab CI ou Jenkins. A integração do DeepEval com Pytest permite que desenvolvedores escrevam casos de teste como testes Python padrão, executados nos fluxos CI existentes, com os resultados ao lado dos testes tradicionais de unidade. A avaliação automatizada pode medir métricas de desempenho do modelo, comparar saídas com versões de referência e bloquear implantações caso não atendam limites mínimos de qualidade. A gestão de artefatos envolve o armazenamento de datasets de teste, checkpoints de modelos e resultados de avaliação em sistemas de versionamento ou repositórios de artefatos para reprodutibilidade e trilhas de auditoria. Os padrões de integração incluem:

O cenário dos Ambientes de Testes de IA evolui rapidamente para enfrentar desafios emergentes de complexidade, escala e heterogeneidade dos modelos. O teste agêntico ganha importância à medida que sistemas de IA vão além da inferência de modelo único para fluxos multi-etapas onde agentes usam ferramentas, tomam decisões e interagem com sistemas externos — exigindo novos frameworks de avaliação que meçam conclusão de tarefas, segurança e confiabilidade. Avaliação distribuída permite testes em escala ao executar milhares de instâncias de teste simultâneas na nuvem, fundamental para aprendizado por reforço e treinamento de modelos em larga escala. O monitoramento em tempo real está migrando da avaliação em lote para testes contínuos em produção, detectando degradação de desempenho, drift dos dados e viés emergente em sistemas ativos. Plataformas de observabilidade como o AmICited estão surgindo como ferramentas essenciais para monitoramento e visibilidade abrangentes de IA, oferecendo painéis centralizados que acompanham desempenho, padrões de uso e métricas de qualidade em todo o portfólio de IA. Ambientes de teste futuros vão incorporar cada vez mais remediação automatizada, em que sistemas não só detectam problemas como também acionam pipelines de re-treinamento ou atualizações de modelo automaticamente, e avaliação cross-modal, suportando testes simultâneos de modelos de texto, imagem, áudio e vídeo em frameworks unificados.

Um Ambiente de Testes de IA é um sandbox isolado onde você pode testar modelos, prompts e configurações com segurança, sem afetar sistemas ou usuários reais. A implantação em produção é o ambiente ativo onde os modelos atendem usuários reais. Os ambientes de teste permitem identificar problemas, otimizar desempenho e validar alterações antes de chegarem à produção, reduzindo riscos e garantindo qualidade.

Sim, os ambientes modernos de teste de IA suportam testes com múltiplos modelos. Plataformas como E2B, IntelIQ.dev e DeepEval permitem testar o mesmo prompt ou entrada em diferentes provedores de LLM (OpenAI, Anthropic, Mistral, etc.) ao mesmo tempo, possibilitando comparação direta dos resultados e métricas de desempenho.

Ambientes empresariais de teste de IA implementam múltiplas camadas de segurança, incluindo isolamento de dados (containerização ou microVMs), criptografia de ponta a ponta, controles de acesso baseados em função, registro de auditoria e certificações de conformidade (SOC 2, GDPR, HIPAA). Os dados nunca saem do ambiente isolado a menos que sejam explicitamente exportados, protegendo informações sensíveis.

Ambientes de Testes possibilitam conformidade ao fornecer trilhas de auditoria de todas as avaliações dos modelos, suporte à anonimização e geração de dados sintéticos, aplicação de controles de acesso e manutenção do isolamento completo dos dados de teste em relação aos sistemas de produção. Essa documentação e controle ajudam as organizações a atender requisitos regulatórios como GDPR, HIPAA e SOC 2.

As principais métricas dependem do seu caso de uso: para LLMs, acompanhe precisão, similaridade semântica, taxas de alucinação e latência; para sistemas RAG, meça precisão/recall de contexto e fidelidade; para modelos de classificação, monitore precisão, recall e F1-score; para todos os modelos, observe degradação de desempenho ao longo do tempo e indicadores de viés.

Os custos variam conforme a plataforma: DeepEval é open-source e gratuito; LangSmith oferece um plano gratuito e opções pagas a partir de $39/mês; E2B utiliza preços conforme uso com base no tempo de execução do sandbox; IntelIQ.dev oferece preços por assinatura. Muitas plataformas também oferecem preços empresariais para grandes implantações.

Sim, a maioria dos ambientes modernos de teste suporta integração com CI/CD. O DeepEval integra-se nativamente ao Pytest, o E2B funciona com GitHub Actions e GitLab CI, e o LangSmith oferece integração via API. Isso permite testes automatizados a cada commit de código e aplicação de barreiras de implantação.

Testes ponta a ponta tratam toda sua aplicação de IA como uma caixa-preta, testando a saída final em relação aos resultados esperados. Testes em nível de componente avaliam partes individuais (chamadas de LLM, recuperadores, uso de ferramentas) separadamente, usando rastreamento e instrumentação. Testes em nível de componente oferecem insights mais profundos sobre onde ocorrem os problemas, enquanto testes ponta a ponta validam o comportamento geral do sistema.

O AmICited rastreia como sistemas de IA referenciam sua marca e conteúdo no ChatGPT, Claude, Perplexity e Google AI. Tenha visibilidade em tempo real da sua presença em IA com monitoramento e análises abrangentes.

Saiba o que são assistentes de IA ambiente, como funcionam em casas inteligentes, seu impacto nas decisões de compra e o futuro dos ambientes de vida inteligent...

Saiba o que é um Centro de Excelência de Visibilidade de IA, suas principais responsabilidades, capacidades de monitoramento e como permite que organizações man...

Aprenda como construir e usar bibliotecas de prompts para testes manuais de visibilidade em IA. Guia DIY para testar como sistemas de IA referenciam sua marca n...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.