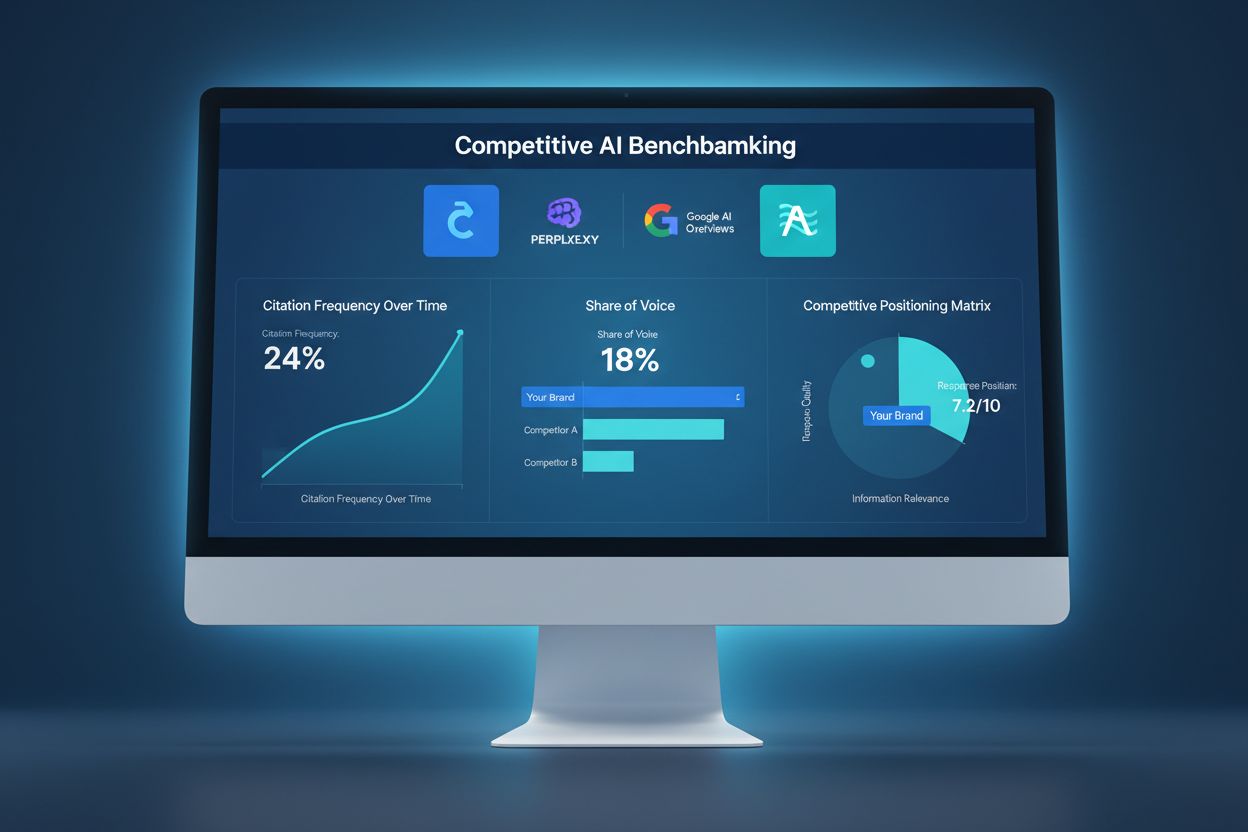

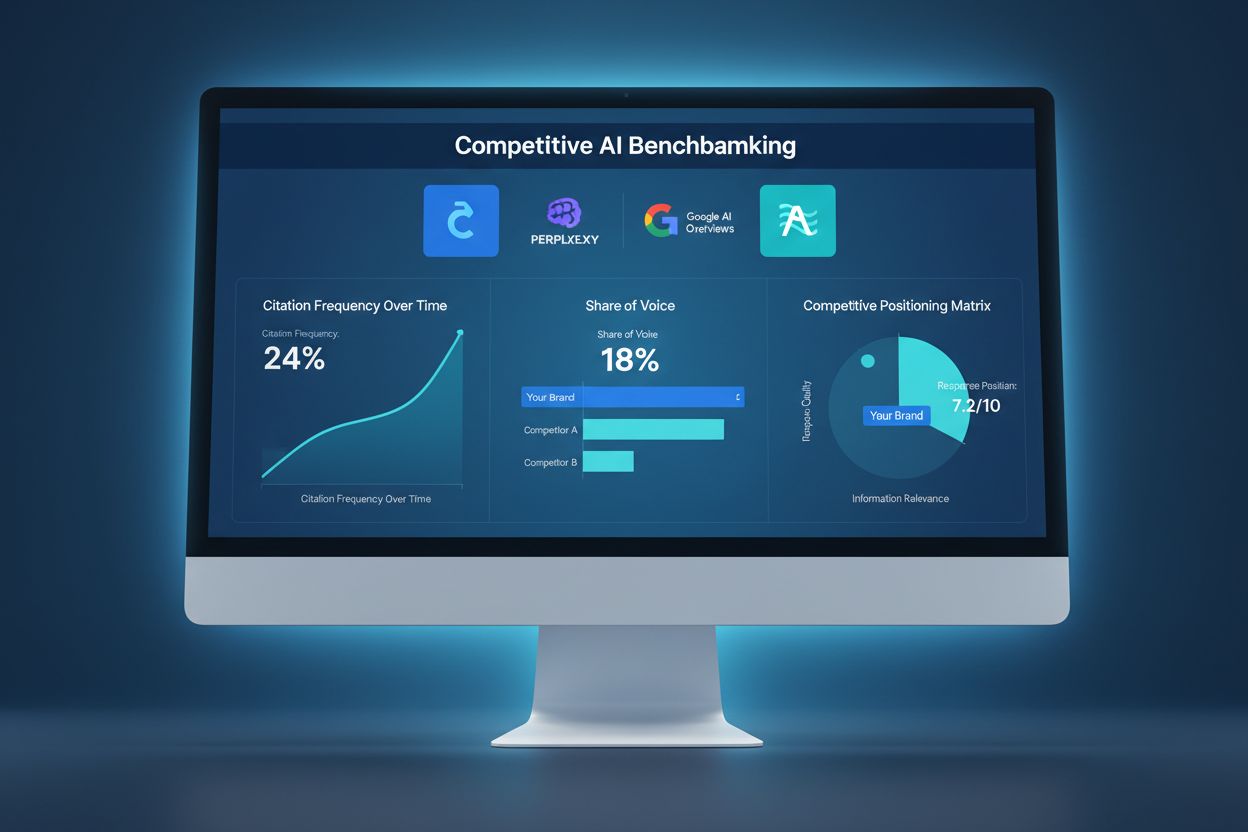

Benchmarking Competitivo de IA

Saiba como comparar sua visibilidade em IA com a dos concorrentes. Acompanhe citações, share of voice e posicionamento competitivo em ChatGPT, Perplexity e Goog...

Sabotagem Competitiva de IA refere-se a tentativas deliberadas de concorrentes de influenciar negativamente a visibilidade, o sentimento ou o desempenho de uma marca em resultados de busca e respostas de chatbots baseados em IA. Isso inclui envenenamento de dados, avaliações falsas, campanhas de desinformação e manipulação dos dados de treinamento de IA para prejudicar a reputação da marca e reduzir citações da IA.

Sabotagem Competitiva de IA refere-se a tentativas deliberadas de concorrentes de influenciar negativamente a visibilidade, o sentimento ou o desempenho de uma marca em resultados de busca e respostas de chatbots baseados em IA. Isso inclui envenenamento de dados, avaliações falsas, campanhas de desinformação e manipulação dos dados de treinamento de IA para prejudicar a reputação da marca e reduzir citações da IA.

Sabotagem competitiva de IA refere-se a tentativas deliberadas de manipular, envenenar ou corromper os dados que motores de busca e modelos de linguagem baseados em IA usam para gerar resultados e citações. Diferentemente do SEO negativo tradicional, que foca em prejudicar o ranqueamento do site do concorrente por meio de esquemas de links ou explorações técnicas, a sabotagem de IA mira os dados de treinamento e as fontes das quais os sistemas de IA dependem para fornecer respostas. Essa distinção é crucial porque sistemas como Google AI Overviews, Perplexity e GPTs citam fontes diretamente de seus dados de treinamento, tornando-os vulneráveis a campanhas coordenadas de desinformação. O impacto real é substancial: com 60% das buscas terminando sem clique em sites, agora os concorrentes podem envenenar resultados de IA para redirecionar tráfego, prejudicar a reputação da marca ou promover informações falsas sem sequer tocar no ranqueamento tradicional.

A sabotagem competitiva de IA opera por meio de diversos vetores de ataque interconectados que exploram como sistemas de IA ingerem e processam informações. Envenenamento de dados é a principal técnica, envolvendo a injeção de informações falsas, enganosas ou maliciosas em fontes usadas para treinar a IA—como bancos de dados públicos, fóruns, sites de avaliações e agregadores de notícias. Os atacantes empregam label flipping (alterando metadados para classificar conteúdo de forma errada), injeção de dados (adicionando entradas falsas a conjuntos de dados) e ataques por backdoor (inserindo gatilhos ocultos nos dados de treinamento). Concorrentes também lançam campanhas coordenadas de avaliações falsas para inundar plataformas com depoimentos fabricados, enquanto espalham desinformação e deepfakes pelas redes sociais, blogs e conteúdos indexados por IA. A vulnerabilidade está no fato de que sistemas de IA costumam confiar no volume e consistência das informações, em vez de verificar sua autenticidade. Veja como os diferentes métodos de sabotagem se comparam:

| Método | Como Funciona | Impacto na IA | Dificuldade de Detecção |

|---|---|---|---|

| Envenenamento de Dados | Injeção de informações falsas em conjuntos de treinamento | IA cita fontes envenenadas diretamente | Alta – requer análise de dados |

| Avaliações Falsas | Bombardeio coordenado de avaliações em plataformas | Distorce análise de sentimento e recomendações da IA | Média – análise de padrões pode ajudar |

| Campanhas de Desinformação | Espalha alegações falsas em sites indexados | IA amplia narrativas falsas nos resultados | Alta – requer checagem de fatos |

| Deepfakes | Criação de mídia sintética de executivos ou produtos | Prejudica a credibilidade da marca ao ser citada pela IA | Muito Alta – requer verificação |

| Sequestro de Diretórios | Reivindicação de perfis de concorrentes em diretórios | IA utiliza informações falsas desses diretórios | Média – verificações ajudam |

| Notícias Falsas | Publicação de matérias fabricadas em sites de notícias | IA trata como fontes autoritativas | Alta – requer verificação das fontes |

Sistemas de IA são fundamentalmente mais vulneráveis à sabotagem do que motores de busca tradicionais porque confiam nos dados de treinamento de forma mais implícita do que humanos. Enquanto o algoritmo do Google avalia autoridade de links e reputação de domínios, modelos de IA simplesmente aprendem padrões a partir dos dados disponíveis—tornando-os suscetíveis a ataques coordenados. Pesquisas indicam que apenas 250 documentos maliciosos já podem envenenar um modelo de IA, uma barreira de entrada muito menor em comparação aos ataques de SEO tradicionais. O problema se agrava pelo fato de que sistemas de IA citam fontes diretamente, ou seja, os dados envenenados não apenas influenciam os resultados—eles se tornam a resposta autoritativa vista pelos usuários. Detectar dados envenenados é exponencialmente mais difícil do que identificar um backlink ruim, já que a manipulação ocorre no nível do treinamento, muitas vezes invisível a auditorias externas. Com o tráfego de busca por IA crescendo 527% em apenas cinco meses (janeiro-maio de 2025) e 79% dos americanos confiando em motores de busca por IA, o incentivo para sabotagem é maior do que nunca, enquanto a infraestrutura de segurança ainda é pouco desenvolvida.

O exemplo mais notório de sabotagem de IA ocorreu quando a Target foi vítima de uma campanha coordenada de desinformação que alegava falsamente que a varejista vendia roupas infantis com “temática satânica”. Sistemas de IA, treinados com essa narrativa fabricada, começaram a exibir essas alegações falsas nos resultados de busca e resumos de IA, causando danos consideráveis à reputação da empresa antes que ela pudesse reagir. Sistemas de e-mail também já sofreram ataques semelhantes por meio do envenenamento de filtros de spam, onde concorrentes inserem padrões maliciosos nos dados de treinamento para fazer com que e-mails legítimos sejam marcados como spam. Bombardeios de avaliações negativas por concorrentes tornaram-se cada vez mais comuns, com empresas inundando perfis de rivais com avaliações negativas falsas que os sistemas de IA então agregam em pontuações de sentimento. Sequestro de perfis de diretórios é outro vetor, onde atacantes reivindicam perfis de negócios de concorrentes em plataformas como Google Meu Negócio ou diretórios do setor, alimentando informações falsas que são indexadas e citadas por sistemas de IA. Esses casos mostram que a sabotagem de IA não é teórica—ela já prejudica empresas na prática, com o dano amplificado pelo caráter autoritativo dos resultados fornecidos pela IA, muitas vezes sendo o primeiro contato do usuário.

Detectar sabotagem competitiva de IA exige uma abordagem de monitoramento em múltiplas camadas, acompanhando como sua marca aparece nos resultados de busca por IA e nas fontes citadas. O primeiro passo é o monitoramento contínuo dos resultados de IA para sua marca, produtos e principais executivos em plataformas como Google AI Overviews, Perplexity, ChatGPT e Claude. O acompanhamento de sentimento nas fontes indexadas ajuda a identificar mudanças bruscas na forma como sua marca é mencionada—um sinal de alerta para campanhas coordenadas de desinformação. A identificação de avaliações falsas envolve a análise de padrões de avaliação para anomalias estatísticas, como picos repentinos de notas baixas ou uso de linguagem idêntica. A detecção precoce é fundamental; estudos indicam que as primeiras 48 horas após o início de um ataque são cruciais para contenção e resposta. O monitoramento também deve rastrear quais fontes as IAs estão citando sobre sua marca, permitindo identificar dados envenenados antes que causem danos maiores. Os principais métodos de detecção são:

Criar resiliência contra a sabotagem competitiva de IA exige uma estratégia de defesa proativa e multifacetada, indo além do gerenciamento tradicional de reputação. Produzir conteúdo de alta qualidade e autoridade é sua defesa mais forte—sistemas de IA são treinados para reconhecer e priorizar conteúdos de fontes estabelecidas e confiáveis, dificultando a competição de dados envenenados com informações legítimas. Amplificar informações corretas em múltiplas plataformas indexadas garante que, ao buscar informações sobre sua marca, a IA encontre narrativas consistentes e verdadeiras de fontes reconhecidas. Proteger sua presença de marca significa reivindicar e verificar todos os perfis de negócios, redes sociais e diretórios do setor para evitar ataques de sequestro. Implemente sistemas robustos de monitoramento que rastreiem sua marca em resultados de IA em tempo real, permitindo resposta rápida a ameaças emergentes. Desenvolva protocolos de resposta para que sua equipe saiba como agir diante de uma sabotagem detectada, incluindo documentação, denúncia em plataformas e ação jurídica, se necessário. Construir relacionamento com jornalistas, influenciadores do setor e publicações confiáveis adiciona camadas de credibilidade que os sistemas de IA reconhecem e priorizam.

Plataformas especializadas de monitoramento de IA tornaram-se infraestrutura essencial para proteção de marcas na era da busca por IA. Essas ferramentas oferecem alertas em tempo real quando sua marca aparece nos resultados das buscas por IA, permitindo acompanhar não apenas posições, mas também citações reais e as fontes utilizadas pelos sistemas de IA. O AmICited.com destaca-se como uma solução abrangente, projetada especificamente para monitorar como sua marca, produtos e executivos são citados por motores de busca de IA como Google AI Overviews, Perplexity e GPTs. A plataforma rastreia quais fontes estão sendo citadas sobre sua marca, permitindo identificar dados envenenados e responder antes que causem danos amplos. A integração com sua estratégia geral de segurança de marca possibilita correlacionar padrões de citação de IA com métricas de busca tradicional, sentimento em redes sociais e plataformas de avaliações para obter uma visão completa do cenário competitivo. Ao combinar o monitoramento de IA com ferramentas tradicionais de reputação, você cria um sistema unificado de defesa que detecta tentativas de sabotagem cedo e fornece dados para respostas rápidas.

À medida que a sabotagem competitiva de IA se torna mais frequente, os marcos legais evoluem para lidar com essas novas ameaças. Notificações de remoção via DMCA podem ser usadas para retirar conteúdos envenenados de fontes indexadas, embora o processo seja geralmente lento e exija provas claras de violação de direitos autorais ou personificação. A lei de difamação oferece alternativas quando a sabotagem envolve declarações falsas que prejudicam sua reputação, mas provar danos no contexto de IA ainda é complexo. As principais plataformas já contam com mecanismos de denúncia específicos para abusos relacionados à IA, incluindo envenenamento de dados, avaliações falsas e campanhas de desinformação, embora a aplicação das regras varie bastante. Regulamentos emergentes como o EU AI Act e propostas legislativas nos EUA começam a estabelecer responsabilidades para sistemas de IA que amplificam informações falsas, criando novas possibilidades jurídicas. Empresas devem documentar detalhadamente todas as tentativas de sabotagem, pois essas evidências são essenciais tanto para processos legais quanto para recursos em plataformas. Consultar advogados especializados em IA e reputação digital é cada vez mais importante para criar estratégias de resposta em conformidade com as novas normas.

O cenário da sabotagem competitiva de IA continuará a evoluir conforme atacantes e defensores desenvolvem técnicas cada vez mais sofisticadas. Avaliações falsas geradas por IA com modelos de linguagem avançados ficarão cada vez mais difíceis de distinguir de feedbacks autênticos, exigindo sistemas de detecção mais sofisticados. Verificação por blockchain e sistemas descentralizados de credibilidade surgem como soluções potenciais para validar a autenticidade das fontes antes que os dados sejam incorporados aos conjuntos de treinamento da IA. Provedores de plataformas estão investindo fortemente em defesas aprimoradas, incluindo melhor validação de dados, verificação de fontes e algoritmos de detecção de envenenamento, embora essas medidas sempre fiquem um passo atrás dos novos vetores de ataque. Sistemas de verificação baseados em comunidade, nos quais usuários e especialistas sinalizam conteúdos suspeitos, podem se tornar padrão, criando uma defesa colaborativa contra a sabotagem. A vantagem competitiva estará cada vez mais nas empresas que se antecipam às ameaças emergentes por meio de monitoramento contínuo, protocolos rápidos de resposta e investimento em alfabetização em IA para suas equipes. Organizações que tratam o monitoramento de IA como componente central da proteção de marca hoje estarão melhor posicionadas para defender-se dos ataques mais sofisticados de amanhã.

O SEO negativo tradicional visa o ranqueamento nos motores de busca por meio de manipulação de links e cópia de conteúdo. A sabotagem competitiva de IA atinge os dados de treinamento e o comportamento do modelo, envenenando as fontes que os sistemas de IA citam em suas respostas. Sistemas de IA são mais vulneráveis porque citam fontes diretamente e confiam mais nos dados de treinamento do que os algoritmos tradicionais de busca.

Monitore semanalmente como as plataformas de IA descrevem sua marca usando ferramentas como AmICited.com. Procure mudanças repentinas de sentimento, alegações falsas nas respostas de IA, campanhas coordenadas de avaliações negativas ou desinformação se espalhando entre plataformas. A detecção precoce nas primeiras 48 horas é fundamental para conter o problema.

Documente tudo imediatamente com capturas de tela e registros de horário. Relate às plataformas afetadas (OpenAI, Google, Anthropic). Amplifique informações corretas em seus próprios canais. Procure aconselhamento jurídico se houver difamação ou prejuízo financeiro. Implemente sistemas de monitoramento para detectar novos ataques rapidamente.

Pesquisas mostram que apenas 250 documentos maliciosos ou 7-8% de um conjunto de dados já são suficientes para envenenar modelos de IA de maneira relevante. Essa barreira de entrada baixa torna os sistemas de IA particularmente vulneráveis em comparação com motores de busca tradicionais, que possuem mecanismos de detecção de spam mais sofisticados.

Plataformas de IA atualmente possuem capacidades limitadas de detecção, dependendo principalmente de denúncias de usuários e re-treinamentos periódicos com dados limpos. No entanto, estão sendo implementados sistemas melhores de verificação, detecção de anomalias e controles de acesso. A responsabilidade pela detecção precoce geralmente recai sobre as próprias marcas.

Construa uma reputação autêntica e forte com conteúdo de alta qualidade, monitore regularmente os resultados de busca por IA, garanta sua presença em diretórios, implemente sistemas de monitoramento em tempo real e responda rapidamente a ataques. A prevenção por meio de construção de reputação é mais eficaz do que tentar remediar após a sabotagem.

O AmICited.com monitora como as plataformas de IA (ChatGPT, Perplexity, Google AI Overviews) referenciam sua marca, acompanhando mudanças de sentimento e padrões de citação. Alertas em tempo real notificam sobre mudanças súbitas na forma como a IA descreve sua marca, permitindo uma resposta rápida a possíveis tentativas de sabotagem.

Você pode entrar com ações por difamação, enviar notificações DMCA para remoção de conteúdo falso, denunciar violações aos termos de serviço das plataformas e, possivelmente, buscar indenização por danos financeiros. A documentação da sabotagem é fundamental. Consulte advogados especializados em direitos digitais e propriedade intelectual.

Proteja sua marca contra sabotagem competitiva de IA com monitoramento em tempo real no ChatGPT, Perplexity e Google AI Overviews. Detecte ameaças antes que elas prejudiquem sua reputação.

Saiba como comparar sua visibilidade em IA com a dos concorrentes. Acompanhe citações, share of voice e posicionamento competitivo em ChatGPT, Perplexity e Goog...

Discussão da comunidade sobre táticas black hat que prejudicam a visibilidade em IA. Insights reais sobre envenenamento de IA, manipulação de conteúdo e como pr...

Saiba o que significa canibalização de conteúdo na busca por IA, como afeta a visibilidade da sua marca em respostas geradas por IA e por que é importante monit...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.