Atualização Hummingbird

Saiba o que é a Atualização Hummingbird, como ela revolucionou a busca semântica em 2013 e por que é importante para o monitoramento de IA e visibilidade de mar...

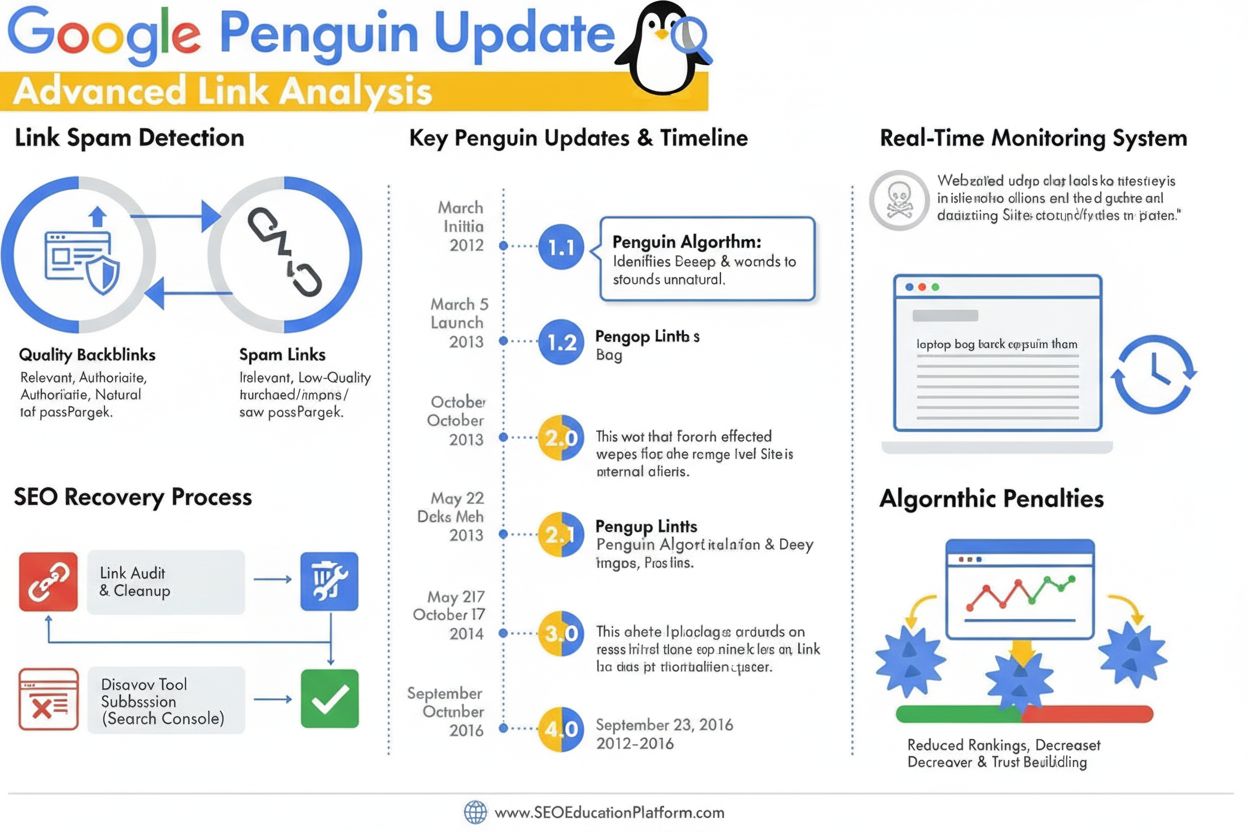

A Atualização Penguin é um algoritmo do Google projetado para combater o spam de links e práticas manipulativas de construção de links, identificando e desvalorizando backlinks de baixa qualidade e não naturais. Lançado pela primeira vez em abril de 2012, evoluiu para um componente do algoritmo em tempo real em 2016, monitorando e ajustando continuamente os rankings com base na qualidade dos backlinks e nos padrões de esquemas de links.

A Atualização Penguin é um algoritmo do Google projetado para combater o spam de links e práticas manipulativas de construção de links, identificando e desvalorizando backlinks de baixa qualidade e não naturais. Lançado pela primeira vez em abril de 2012, evoluiu para um componente do algoritmo em tempo real em 2016, monitorando e ajustando continuamente os rankings com base na qualidade dos backlinks e nos padrões de esquemas de links.

A Atualização Penguin é um algoritmo do Google projetado especificamente para combater o spam de links e práticas manipulativas de construção de links, identificando, desvalorizando e penalizando sites com perfis de backlinks não naturais ou de baixa qualidade. Anunciado oficialmente por Matt Cutts em 24 de abril de 2012, o algoritmo Penguin representou a resposta agressiva do Google ao crescente problema das técnicas de SEO black-hat que inflavam artificialmente o ranking nas buscas por meio de compra de links, trocas de links e outras práticas enganosas. O objetivo principal do algoritmo é garantir que links naturais, autoritativos e relevantes sejam recompensados, enquanto links manipulativos e de spam sejam rebaixados ou completamente ignorados. Diferente de atualizações focadas em conteúdo, como o Panda, que visa conteúdo de baixa qualidade, o Penguin avalia especificamente a qualidade e autenticidade do perfil de links recebidos de um site, tornando-se um componente fundamental do sistema de ranking do Google há mais de uma década.

A Atualização Penguin surgiu em um período crítico do SEO, quando o volume de links tinha um peso desproporcionalmente grande no ranking das buscas. Antes do lançamento do Penguin, webmasters podiam impulsionar artificialmente seus rankings adquirindo grandes quantidades de links de baixa qualidade vindos de fazendas de links, redes privadas de blogs e outras fontes de spam. Essa prática criou um problema significativo nos resultados do Google, pois sites e conteúdos de baixa qualidade apareciam em posições de destaque mesmo sem verdadeira autoridade ou relevância. Matt Cutts, então chefe da equipe de webspam do Google, explicou na conferência SMX Advanced 2012 que “Vemos isso como algo projetado para combater conteúdo de baixa qualidade. Começou com o Panda, e depois percebemos que ainda havia muito spam e o Penguin foi criado para lidar com isso.” O lançamento inicial do Penguin afetou mais de 3% de todas as pesquisas, tornando-se uma das atualizações de algoritmo mais impactantes da história do Google. Esse impacto sinalizou ao setor de SEO que o Google adotaria uma postura rígida contra práticas manipulativas de links e continuaria evoluindo seus algoritmos para manter a qualidade das buscas.

O algoritmo Penguin opera através de sofisticados sistemas de aprendizado de máquina e reconhecimento de padrões que analisam perfis de backlinks para identificar padrões de links não naturais. O algoritmo examina múltiplos fatores ao avaliar a qualidade dos links, incluindo a autoridade e relevância dos domínios de referência, o texto âncora usado nos links, a velocidade de aquisição dos links e a relevância contextual entre o site de origem e o site de destino. O Penguin mira especificamente esquemas de links, que abrangem uma ampla gama de práticas manipulativas, incluindo compra de links, trocas recíprocas de links, links de redes privadas de blogs (PBNs), links de diretórios de baixa qualidade e links com excesso de palavras-chave no texto âncora. O algoritmo também avalia a proporção de links de alta qualidade para links de baixa qualidade no perfil de backlinks de um site, reconhecendo que até sites legítimos recebem ocasionalmente alguns links de baixa qualidade. No entanto, quando a proporção de links de spam se torna excessivamente alta, o Penguin sinaliza o site para possíveis ajustes no ranking. Um aspecto crucial do design do Penguin é que ele avalia apenas links recebidos por um site; não analisa links de saída daquele site, focando exclusivamente na qualidade dos backlinks apontando para o domínio.

A Atualização Penguin passou por uma evolução significativa desde seu lançamento, com diversas iterações e uma mudança transformadora em setembro de 2016 com o lançamento do Penguin 4.0. Antes desse marco, o Penguin operava em ciclos de atualização em lote, com o Google anunciando atualizações periódicas que reavaliavam os perfis de backlinks dos sites e ajustavam os rankings conforme necessário. O Penguin 1.1 (março de 2012) e o Penguin 1.2 (outubro de 2012) foram atualizações de dados que permitiram a recuperação de sites anteriormente penalizados, caso tivessem limpado seus perfis de links. O Penguin 2.0 (maio de 2013) representou uma versão mais tecnicamente avançada, afetando aproximadamente 2,3% das buscas em inglês e sendo a primeira iteração a analisar além da homepage e das principais categorias, examinando estruturas mais profundas do site em busca de evidências de spam de links. O Penguin 2.1 (outubro de 2013) e o Penguin 3.0 (outubro de 2014) continuaram essa evolução com melhorias incrementais nas capacidades de detecção. No entanto, o lançamento do Penguin 4.0 mudou fundamentalmente o funcionamento do algoritmo, integrando-o ao algoritmo central do Google como um componente em tempo real. Isso significa que os sites agora são avaliados continuamente, com ajustes nos rankings acontecendo imediatamente à medida que os perfis de links mudam, sem a necessidade de aguardar atualizações programadas. A mudança para processamento em tempo real também alterou o mecanismo de penalidade do Penguin, que passou de penalidades diretas de ranking para desvalorização de links, em que links de spam são simplesmente ignorados ao invés de causar quedas globais nos rankings do site.

| Fator de Avaliação | Links de Alta Qualidade | Links de Baixa Qualidade/Spam | Detecção pelo Penguin |

|---|---|---|---|

| Autoridade da Fonte do Link | Domínios estabelecidos e confiáveis com alta autoridade | Domínios novos, sites de baixa autoridade ou redes conhecidas de spam | Analisa histórico do domínio, sinais de confiança e relevância temática |

| Texto Âncora | Frases naturais, variadas e contextualmente relevantes | Palavras-chave exatas, repetitivas, superotimizadas | Sinaliza padrões não naturais de texto âncora e excesso de palavras-chave |

| Velocidade de Aquisição de Links | Aquisição gradual e orgânica ao longo do tempo | Picos repentinos ou padrões não naturais | Monitora velocidade de aquisição e consistência |

| Relevância Contextual | Links de fontes autoritativas e relacionadas ao tema | Links de fontes não relacionadas ou de baixa qualidade | Avalia relevância semântica entre site de origem e destino |

| Posicionamento do Link | Links editoriais dentro do conteúdo, em contexto natural | Links em rodapés, barras laterais ou fazendas de links | Avalia posicionamento do link e integração contextual |

| Qualidade do Site de Origem | Conteúdo de alta qualidade, presença legítima no mercado | Conteúdo raso, páginas automáticas ou PBNs | Examina qualidade geral do site e autenticidade do conteúdo |

| Status Nofollow | Atribuído corretamente quando apropriado | Mal utilizado ou ausente em links pagos/patrocinados | Reconhece uso adequado do nofollow para links não editoriais |

A Atualização Penguin transformou radicalmente as práticas de SEO ao estabelecer a qualidade dos links como fator crítico de ranking e desencorajar o uso de técnicas de link building black-hat. Antes do Penguin, muitas agências de SEO e webmasters realizavam campanhas agressivas de compra de links, trocas e criação de PBNs sem grandes consequências. O lançamento do algoritmo causou uma imediata disrupção no mercado, com milhares de sites sofrendo quedas drásticas de ranking e perda de tráfego. Essa mudança forçou o setor de SEO a adotar práticas mais éticas, focadas em white-hat, privilegiando a conquista de links por meio de conteúdo de alta qualidade e relacionamento genuíno. A penalidade do Penguin tornou-se um alerta para empresas sobre a abordagem de construção de links, levando a maior investimento em marketing de conteúdo, relações públicas e construção de marca como estratégias principais de aquisição de links. Pesquisas do setor mostram que compreender e cumprir os requisitos do Penguin tornou-se essencial para o sucesso em SEO a longo prazo, levando organizações a implementar auditorias de backlinks e monitoramento de links como práticas padrão. O algoritmo também elevou a importância de autoridade de domínio, relevância temática e velocidade de obtenção de links como métricas-chave a serem monitoradas por profissionais de SEO ao avaliar oportunidades de links. Mais de 78% das empresas atualmente utilizam algum tipo de monitoramento de conteúdo baseado em IA ou ferramentas de análise de links para acompanhar seus perfis de backlinks e garantir conformidade com as diretrizes de qualidade do Google, resultado direto da influência do Penguin nos padrões da indústria.

Recuperar-se de um rebaixamento do Penguin exige uma abordagem sistemática envolvendo auditorias de backlinks, remoção de links e uso estratégico da ferramenta de rejeição do Google. O primeiro passo é realizar uma auditoria abrangente de todos os links recebidos usando o Google Search Console e ferramentas de terceiros como Ahrefs, SEMrush ou Moz, que oferecem perfis detalhados de backlinks e avaliações de qualidade. Os webmasters devem avaliar cada domínio de referência individualmente para determinar se o link é de alta qualidade e natural ou se representa uma prática manipulativa. Para links claramente de spam ou baixa qualidade, a abordagem recomendada é contatar o webmaster do site de origem e solicitar a remoção. O Google recomenda explicitamente não pagar pela remoção de links, pois isso perpetua o comércio de links. Para links que não podem ser removidos por contato, a ferramenta de rejeição no Google Search Console permite ao webmaster enviar um arquivo indicando ao Google para ignorar links específicos ao avaliar o site. Vale ressaltar que rejeitar um link também elimina qualquer valor positivo que ele pudesse fornecer, então a ferramenta deve ser usada apenas para links verdadeiramente prejudiciais. Após o envio do arquivo de rejeição, o Google o processa imediatamente, mas o impacto real nos rankings depende de quando o Google rastrear novamente os links rejeitados. Como o Penguin 4.0 funciona em tempo real, a recuperação pode acontecer rapidamente—às vezes em dias ou semanas—assim que ações corretivas suficientes forem tomadas. No entanto, não se deve esperar que os rankings retornem aos níveis pré-penalidade, já que parte dessas posições pode ter sido inflada artificialmente pelos links de baixa qualidade sendo removidos.

À medida que plataformas de busca por IA como ChatGPT, Perplexity, Google AI Overviews e Claude ganham importância para a visibilidade de marcas, compreender os princípios do Penguin torna-se relevante além dos rankings tradicionais. Esses sistemas de IA frequentemente citam fontes autoritativas e sites de alta qualidade ao gerar respostas, e sites com perfis sólidos de backlinks e histórico limpo têm maior probabilidade de serem reconhecidos como autoridades pelos dados de treinamento e sistemas de recuperação da IA. Um site penalizado pelo Penguin por spam de links pode não apenas sofrer nas buscas orgânicas do Google, como também ser preterido por sistemas de IA que avaliam a credibilidade das fontes. Por outro lado, sites que mantêm perfis limpos e de alta qualidade têm mais chances de serem citados como fontes de autoridade em respostas geradas por IA. Isso cria um incentivo adicional para manter a conformidade com o Penguin além das métricas tradicionais de SEO. AmICited e plataformas similares de monitoramento de IA ajudam organizações a acompanhar como seus domínios aparecem em respostas de IA, fornecendo visibilidade sobre o reconhecimento de sua autoridade em múltiplos sistemas de busca com IA. A intersecção entre conformidade Penguin e monitoramento de citações de IA representa uma nova fronteira no marketing digital, onde a qualidade dos links impacta diretamente tanto a visibilidade nas buscas tradicionais quanto nas emergentes buscas por IA.

A Atualização Penguin continua evoluindo à medida que o Google aprimora sua compreensão sobre qualidade de links e práticas manipulativas. A mudança para o processamento em tempo real em 2016 representou uma transformação fundamental no funcionamento do algoritmo, mas o Google segue melhorando sua capacidade de detecção por meio de aprendizado de máquina e inteligência artificial. Desenvolvimentos recentes no sistema SpamBrain do Google, anunciados em 2022, representam a próxima evolução na detecção de spam, incorporando IA avançada para identificar tanto sites que compram links quanto aqueles usados para distribuí-los. Isso indica que futuras versões de detecção de spam de links serão ainda mais sofisticadas, tornando mais difícil para práticas manipulativas passarem despercebidas. A tendência do setor para o SEO white-hat e earned media deve continuar acelerando à medida que os algoritmos do Google se tornam mais eficazes em distinguir links naturais de artificiais. Além disso, com o avanço das plataformas de busca por IA, a importância de manter perfis de backlinks limpos vai além do algoritmo do Google, abrangendo o reconhecimento como fonte autoritativa em múltiplos sistemas de IA. Organizações que priorizam qualidade de links, autoridade de marca e excelência em conteúdo estarão mais bem posicionadas para ter sucesso tanto nas buscas tradicionais quanto nas emergentes buscas por IA. O legado da Atualização Penguin não é apenas um algoritmo específico, mas uma mudança fundamental em como mecanismos de busca e sistemas de IA avaliam a autoridade dos sites, tornando a qualidade dos links um fator permanente e cada vez mais importante na visibilidade digital.

Um rebaixamento Penguin é algorítmico e acontece automaticamente quando o algoritmo Penguin do Google detecta padrões de spam de links, sem necessidade de intervenção manual. Uma penalidade Penguin (ou ação manual) é emitida pela equipe de webspam do Google após revisão humana e requer um pedido de reconsideração para ser removida. Desde que o Penguin 4.0 se tornou em tempo real em 2016, rebaixamentos algorítmicos podem ser revertidos quase imediatamente após ações corretivas, enquanto penalidades manuais exigem aprovação explícita do Google.

A Atualização Penguin utiliza algoritmos de aprendizado de máquina para analisar perfis de backlinks e identificar padrões de construção de links manipulativos, incluindo links comprados, trocas de links, redes privadas de blogs (PBNs) e padrões não naturais de texto âncora. O algoritmo avalia a proporção de links naturais e de alta qualidade em relação a links de spam de baixa qualidade apontando para um site. Ele também examina a relevância e autoridade dos domínios de referência para determinar se os links parecem obtidos artificialmente ao invés de conquistados editorialmente.

Sim, a recuperação é possível por meio de um processo em várias etapas que envolve auditorias de backlinks, remoção de links spam e uso da ferramenta de rejeição do Google para links que você não pode remover diretamente. Desde que o Penguin 4.0 funciona em tempo real, a recuperação pode acontecer relativamente rápido assim que você limpar seu perfil de links e o Google rastrear novamente essas páginas. No entanto, a recuperação não garante o retorno aos rankings anteriores, já que parte dessas posições pode ter sido inflada artificialmente pelos links de baixa qualidade que você está removendo.

O Penguin penaliza links provenientes de fazendas de links, redes de links pagos, redes privadas de blogs (PBNs), trocas recíprocas de links e sites com padrões não naturais de texto âncora. Também mira links de diretórios de baixa qualidade, spam em comentários, spam em fóruns e links obtidos por práticas manipulativas. Além disso, o Penguin sinaliza links de sites de alta autoridade que parecem ser vendidos ou colocados como publieditoriais sem as devidas tags nofollow, pois isso viola as diretrizes de esquemas de links do Google.

Desde o lançamento do Penguin 4.0 em setembro de 2016, o algoritmo funciona continuamente em tempo real como parte do algoritmo principal do Google. Isso significa que o Google avalia constantemente os perfis de backlinks e ajusta os rankings com base na qualidade dos links sem aguardar atualizações programadas. Antes, o Penguin operava em ciclos com atualizações anunciadas pelo Google, mas o processamento em tempo real eliminou a necessidade desses anúncios e permite uma recuperação mais rápida quando os problemas são corrigidos.

A ferramenta de rejeição é um recurso do Google Search Console que permite aos webmasters informar ao Google para ignorar determinados backlinks ao avaliar seu site. É usada como último recurso quando não é possível contatar diretamente os webmasters para remover links de spam. Ao rejeitar links de baixa qualidade, você impede que eles prejudiquem seus rankings sob o algoritmo Penguin. No entanto, links rejeitados também deixam de fornecer qualquer valor positivo, por isso só deve ser usada para links realmente prejudiciais.

A atualização Penguin original, lançada em abril de 2012, afetou mais de 3% de todas as pesquisas, segundo estimativas do Google. As atualizações seguintes tiveram impactos variados: o Penguin 2.0 afetou aproximadamente 2,3% das pesquisas em inglês, o Penguin 2.1 cerca de 1% e o Penguin 3.0 menos de 1% das pesquisas em inglês. Essas porcentagens representam milhões de sites globalmente, tornando o Penguin uma das atualizações de algoritmo mais significativas da história das buscas.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Saiba o que é a Atualização Hummingbird, como ela revolucionou a busca semântica em 2013 e por que é importante para o monitoramento de IA e visibilidade de mar...

Saiba mais sobre a Panda Update do Google, a mudança no algoritmo de 2011 que mira conteúdos de baixa qualidade. Entenda como funciona, seu impacto no SEO e est...

Saiba o que são as Atualizações do Algoritmo do Google, como funcionam e seu impacto no SEO. Entenda atualizações de núcleo, de spam e mudanças de classificação...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.