Reformulação de Consulta

Saiba como a reformulação de consultas ajuda sistemas de IA a interpretar e aprimorar consultas de usuários para uma melhor recuperação de informações. Entenda ...

Refinamento de consulta é o processo de aprimorar e otimizar consultas de busca por meio de ajustes iterativos, esclarecimentos e expansões para gerar resultados mais precisos, relevantes e abrangentes em mecanismos de busca com IA e sistemas de recuperação da informação. Isso envolve dividir consultas complexas de usuários em subconsultas, adicionar detalhes contextuais e utilizar ciclos de feedback para aprimorar progressivamente o desempenho da busca e a qualidade dos resultados.

Refinamento de consulta é o processo de aprimorar e otimizar consultas de busca por meio de ajustes iterativos, esclarecimentos e expansões para gerar resultados mais precisos, relevantes e abrangentes em mecanismos de busca com IA e sistemas de recuperação da informação. Isso envolve dividir consultas complexas de usuários em subconsultas, adicionar detalhes contextuais e utilizar ciclos de feedback para aprimorar progressivamente o desempenho da busca e a qualidade dos resultados.

Refinamento de consulta é o processo iterativo de aprimorar e otimizar consultas de busca por meio de ajustes sistemáticos, esclarecimentos e expansões para gerar resultados mais precisos, relevantes e abrangentes em sistemas de recuperação da informação e mecanismos de busca com IA. Em vez de tratar a busca inicial do usuário como definitiva, o refinamento de consulta reconhece que frequentemente os usuários precisam modificar, expandir ou esclarecer suas consultas para encontrar exatamente o que procuram. Esse processo envolve analisar como os usuários modificam suas buscas, sugerir formulações de consulta aprimoradas e utilizar ciclos de feedback para aprimorar progressivamente o desempenho da busca. No contexto das plataformas modernas de busca com IA, como ChatGPT, Perplexity, Google AI Overviews e Claude, o refinamento de consulta tornou-se um mecanismo fundamental para entregar respostas abrangentes com múltiplas fontes que atendem a perguntas complexas dos usuários. A técnica transforma a busca de uma interação única e estática em uma conversa dinâmica e em múltiplas etapas, na qual cada refinamento aproxima o usuário da informação desejada.

O refinamento de consulta não é um conceito novo em recuperação da informação, mas sua aplicação evoluiu dramaticamente com o avanço da inteligência artificial e dos grandes modelos de linguagem. Historicamente, mecanismos de busca baseavam-se principalmente na correspondência de palavras-chave, em que a consulta do usuário era comparada diretamente com documentos indexados. Se você buscasse por “tênis de corrida”, o mecanismo retornaria documentos contendo exatamente essas palavras, independentemente do contexto ou da intenção do usuário. Essa abordagem era rígida e frequentemente produzia resultados irrelevantes por ignorar as nuances da linguagem humana e a complexidade das necessidades dos usuários.

A evolução para o refinamento de consulta começou com a introdução dos sistemas de sugestão de consulta no início dos anos 2000, quando os mecanismos de busca passaram a analisar padrões de comportamento dos usuários para sugerir consultas relacionadas ou refinadas. O recurso “Você quis dizer?” do Google e as sugestões de autocompletar foram algumas das primeiras implementações desse conceito. No entanto, esses sistemas eram relativamente simples, baseados principalmente em registros históricos de consultas e análise de frequência. Faltava-lhes o entendimento semântico necessário para realmente compreender a intenção do usuário ou as relações entre diferentes formulações de consulta.

A introdução do processamento de linguagem natural (PLN) e do aprendizado de máquina transformou fundamentalmente o refinamento de consulta. Sistemas modernos hoje entendem que “melhores tênis de corrida à prova d’água” e “calçados atléticos resistentes à chuva top de linha” são essencialmente a mesma consulta, apesar de utilizarem terminologias completamente diferentes. Esse entendimento semântico permite reconhecer variações de consulta, identificar necessidades implícitas do usuário e sugerir refinamentos que realmente melhorem os resultados da busca. Segundo pesquisas do Kopp Online Marketing SEO Research Suite, metodologias de refinamento de consulta tornaram-se cada vez mais sofisticadas, com sistemas atualmente capazes de gerar consultas sintéticas (consultas artificialmente criadas que simulam buscas reais de usuários) para aprimorar dados de treinamento e melhorar a precisão na recuperação.

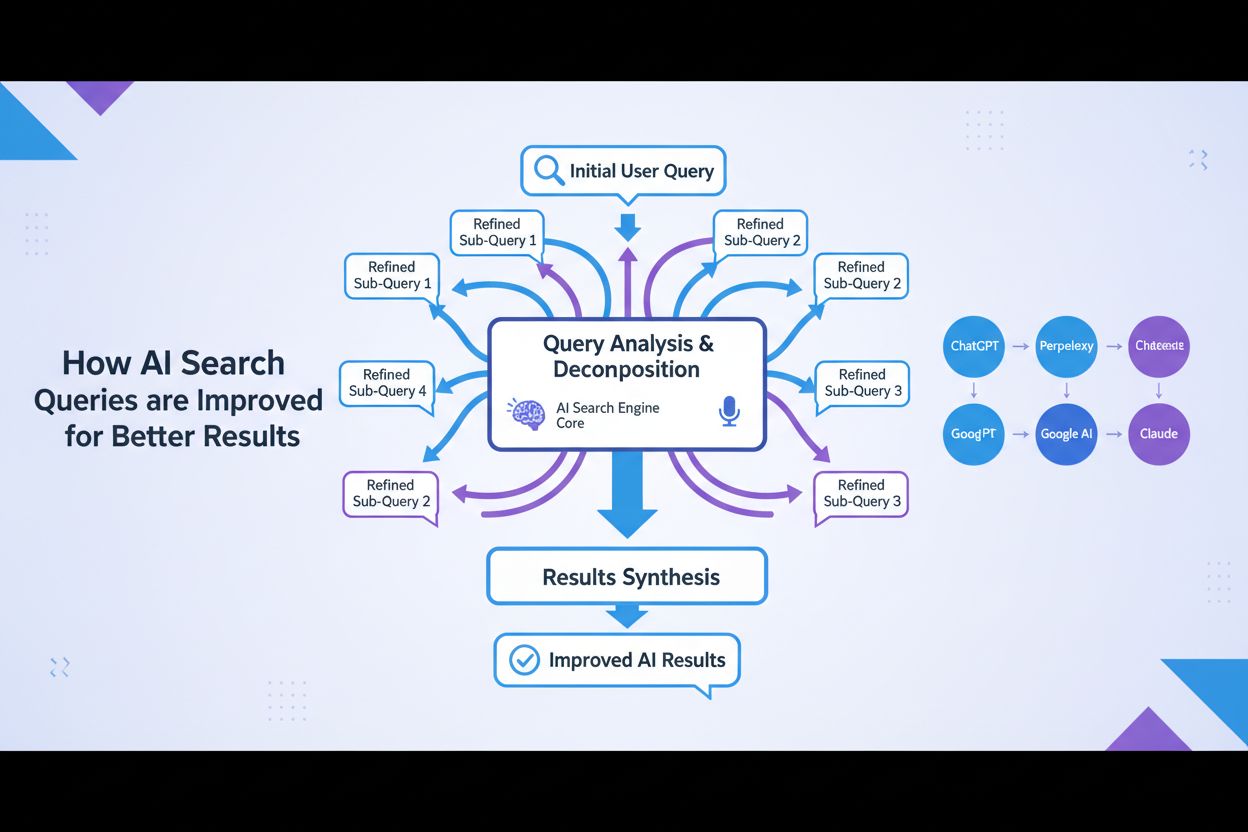

O surgimento da IA generativa e dos grandes modelos de linguagem acelerou ainda mais essa evolução. Mecanismos de busca com IA modernos não apenas refinam consultas; eles as decompõem em múltiplas subconsultas, executam-nas em paralelo em diversas fontes de dados e sintetizam os resultados em respostas abrangentes. Isso representa uma mudança fundamental do refinamento de consulta como recurso de sugestão para o usuário, para refinamento de consulta como componente arquitetural central de sistemas de busca com IA.

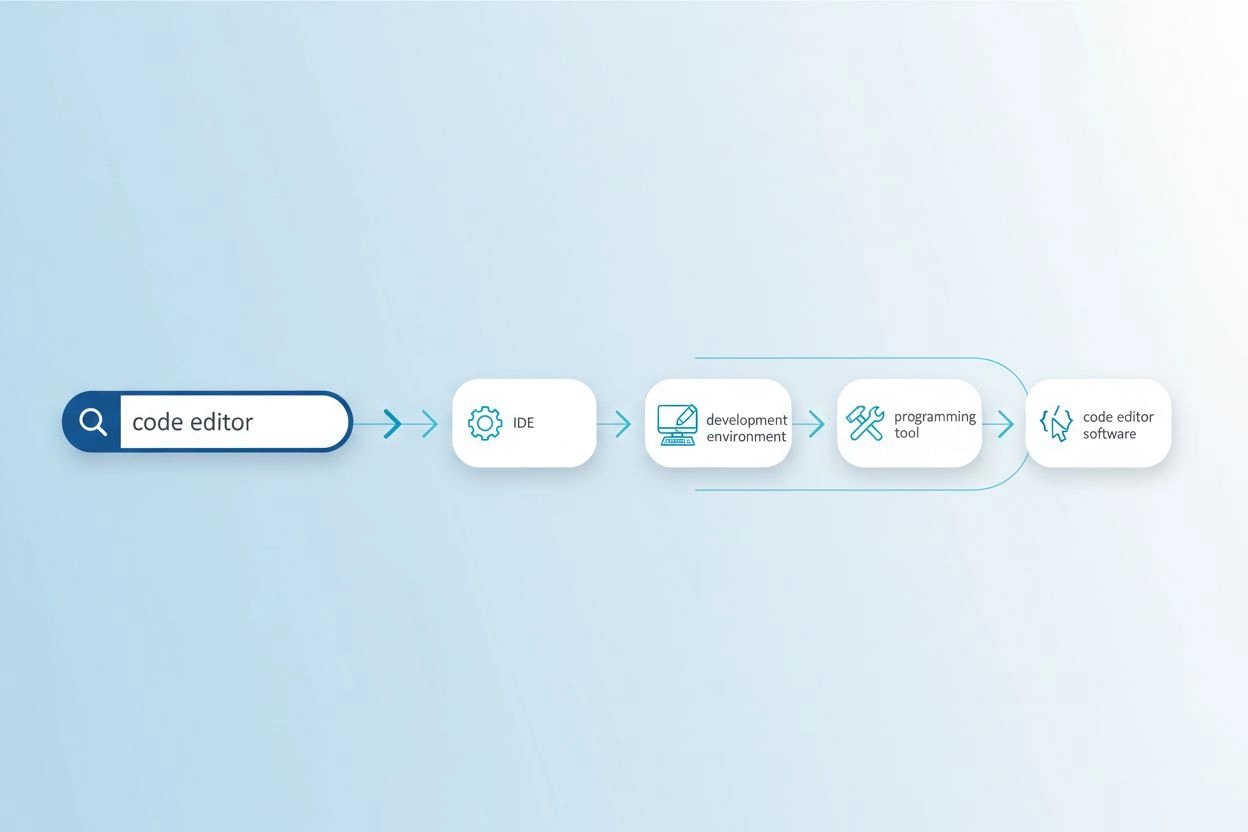

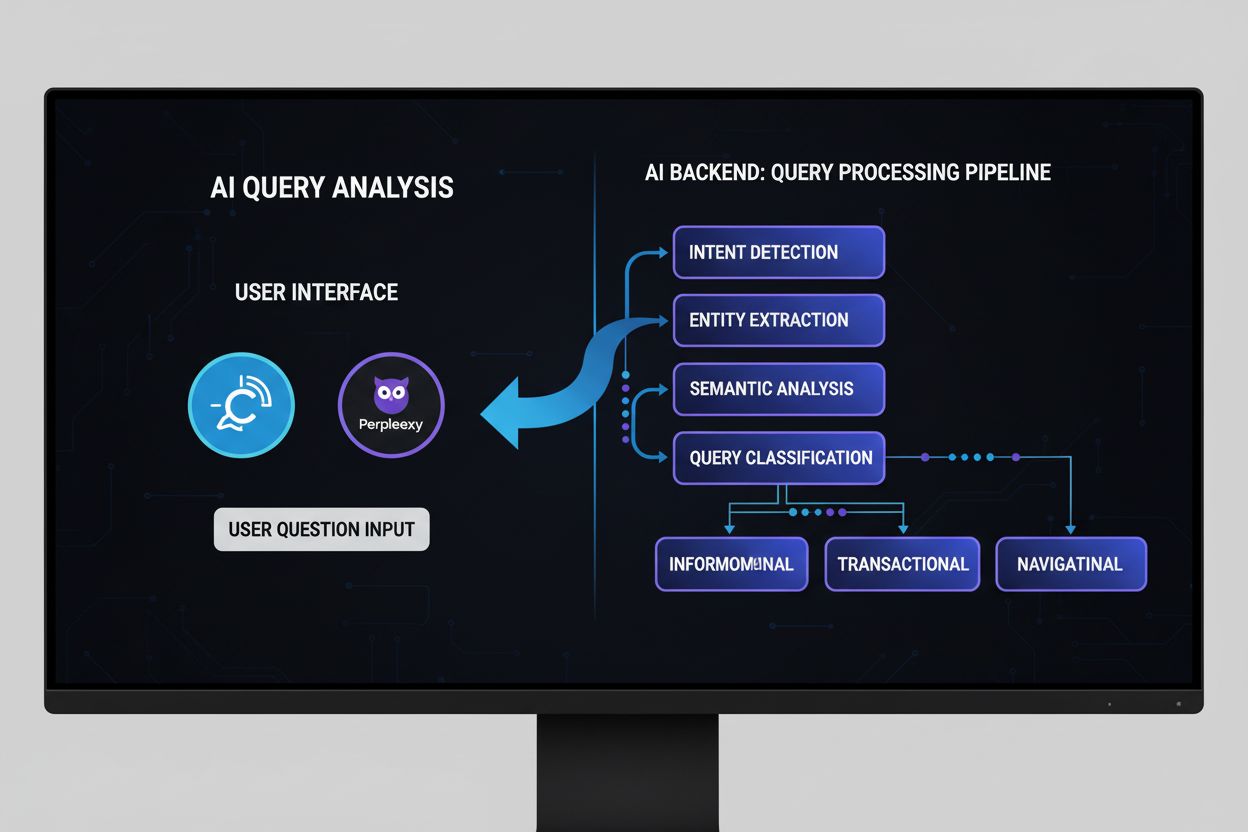

O refinamento de consulta opera por meio de vários mecanismos técnicos interconectados que atuam juntos para melhorar a qualidade da busca. O primeiro mecanismo é a análise de consulta e detecção de intenção, em que o sistema processa a consulta inicial do usuário para identificar a intenção subjacente, o nível de complexidade e o tipo de resposta necessária. Modelos avançados de PLN analisam fatores como comprimento da consulta, especificidade da terminologia e sinais contextuais para determinar se a simples correspondência de palavras-chave será suficiente ou se é necessário um refinamento mais sofisticado. Por exemplo, uma consulta factual simples como “capital da Alemanha” pode não acionar um refinamento extenso, enquanto uma consulta complexa como “melhores práticas para otimizar conteúdo para mecanismos de busca com IA” ativaria processos de refinamento abrangentes.

O segundo mecanismo é a decomposição e fan-out de consulta, técnica em que consultas complexas são divididas em múltiplas subconsultas constituintes. Esse processo, conhecido como query fan-out, é especialmente importante em sistemas de busca com IA. Quando um usuário pergunta “Quais são os melhores tênis de corrida à prova d’água para alguém com pés planos que corre em trilhas?”, o sistema decompõe a consulta em múltiplas subconsultas: uma explorando listas de produtos, outra investigando avaliações de especialistas, outra analisando experiências de usuários e ainda outra examinando especificações técnicas. Essas subconsultas são então executadas simultaneamente em diferentes fontes de dados, incluindo a web ao vivo, grafos de conhecimento e bancos de dados especializados. Essa execução paralela expande dramaticamente o conjunto de informações disponível para a síntese, permitindo que a IA forneça respostas mais completas e detalhadas.

O terceiro mecanismo é a ampliação de consulta, que envolve gerar consultas adicionais para aprimorar o desempenho da busca. De acordo com pesquisas do Kopp Online Marketing SEO Research Suite, a ampliação de consulta utiliza vários métodos: análise de dados históricos (examinando refinamentos anteriores em históricos de busca de usuários), substituição de n-gramas (modificando consultas ao substituir sequências contíguas de termos), associação de entidades (identificando entidades dos resultados de busca e combinando-as com termos da consulta original) e identificação de consultas irmãs (encontrando consultas relacionadas que compartilham consultas-mãe em comum). Essas técnicas de ampliação garantem que o sistema explore múltiplos ângulos e perspectivas sobre a necessidade de informação do usuário.

O quarto mecanismo são os ciclos de feedback e melhoria contínua, nos quais as interações dos usuários com os resultados de busca alimentam o processo de refinamento. Quando usuários clicam em determinados resultados, passam tempo em certas páginas ou reformulam suas consultas, esses dados retroalimentam o sistema para aprimorar refinamentos futuros. Técnicas de aprendizado por reforço podem ser aplicadas para otimizar modelos generativos, melhorando a qualidade das variantes de consulta ao longo do tempo com base em respostas satisfatórias. Isso cria um ciclo virtuoso em que cada interação do usuário torna o sistema mais inteligente e eficaz no refinamento das consultas.

| Aspecto | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Método Principal de Refinamento | Query fan-out com busca temática | Refinamento conversacional em múltiplos turnos | Sugestões interativas de consulta com follow-ups | Esclarecimento contextual via diálogo |

| Geração de Subconsultas | Decomposição automática baseada em intenção | Guiada pelo usuário via conversa | Refinamentos sugeridos exibidos como pílulas | Implícita por meio de compreensão contextual |

| Fontes de Dados | Web ao vivo, grafos de conhecimento, shopping graphs | Dados de treinamento + busca web (com plugins) | Busca web em tempo real em múltiplas fontes | Dados de treinamento com capacidade de busca web |

| Mecanismo de Citação | Atribuição direta de fonte no overview | Referências de links nas respostas | Cards de fonte com atribuição detalhada | Citações inline com links para as fontes |

| Controle do Usuário | Limitado (refinamento orientado pelo sistema) | Alto (usuário direciona a conversa) | Médio (refinamentos sugeridos + entrada customizada) | Alto (usuário pode solicitar refinamentos específicos) |

| Visibilidade do Refinamento | Implícito (usuário vê resposta sintetizada) | Explícito (usuário vê histórico da conversa) | Explícito (sugestões de refinamento visíveis) | Implícito (refinamento através do diálogo) |

| Velocidade do Refinamento | Imediata (processamento paralelo) | Sequencial (turno a turno) | Imediata (busca em tempo real) | Sequencial (baseada em conversa) |

| Nível de Personalização | Alto (baseado em histórico de busca e localização) | Médio (baseado no contexto da conversa) | Médio (baseado nos dados da sessão) | Médio (baseado no contexto da conversa) |

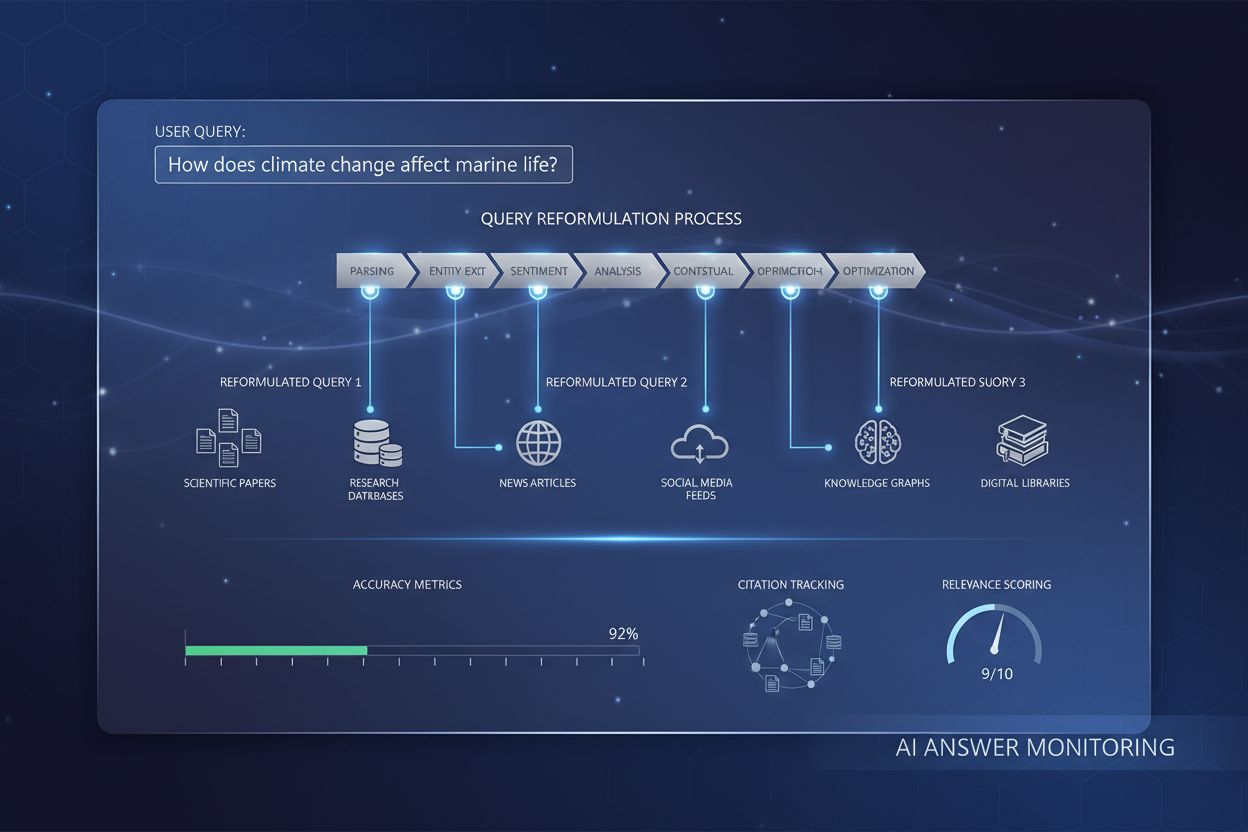

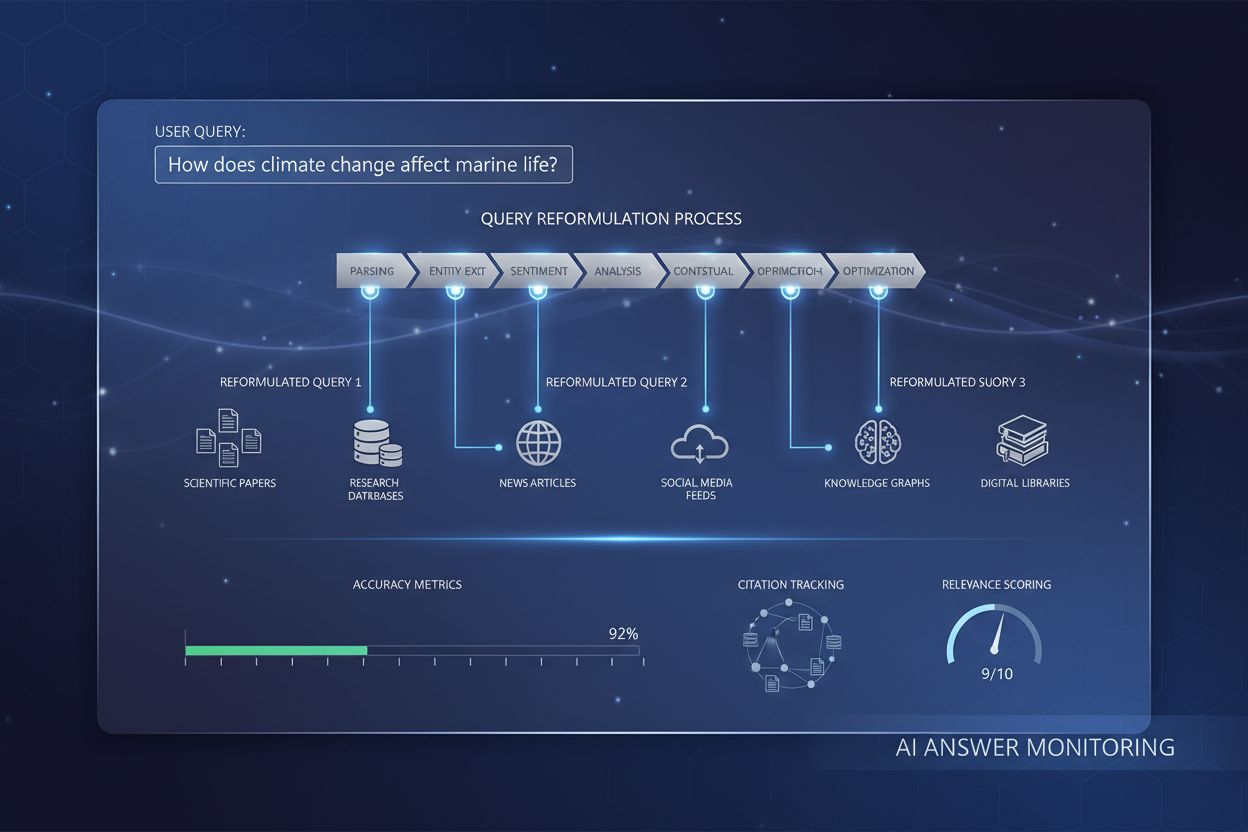

O processo de refinamento de consulta em mecanismos de busca com IA contemporâneos segue um fluxo de trabalho sofisticado e em múltiplos estágios, bastante diferente da busca tradicional. Quando um usuário envia uma consulta para um sistema como Google AI Mode ou ChatGPT, o sistema não busca resultados imediatamente. Primeiro, ele analisa a consulta usando processamento avançado de linguagem natural para entender o que o usuário realmente está perguntando. Essa análise considera fatores como histórico de busca do usuário, localização, tipo de dispositivo e a complexidade da própria consulta. O sistema determina se a consulta é direta (exigindo apenas correspondência de palavras-chave) ou complexa (exigindo decomposição e síntese a partir de múltiplas fontes).

Para consultas complexas, o sistema ativa o processo de query fan-out. Isso envolve dividir a consulta original em múltiplas subconsultas relacionadas, que exploram diferentes facetas da necessidade de informação do usuário. Por exemplo, se um usuário pergunta “Como devo otimizar meu site para mecanismos de busca com IA?”, o sistema pode gerar subconsultas como: “Quais são os principais fatores de ranqueamento para mecanismos de busca com IA?”, “Como sistemas de IA avaliam a qualidade do conteúdo?”, “O que é E-E-A-T e por que importa para IA?”, “Como estruturar conteúdo para citação por IA?” e “Quais as melhores práticas de formatação para conteúdo amigável à IA?”. Cada uma dessas subconsultas é executada em paralelo em diferentes fontes de dados, recuperando informações diversas que abordam diferentes aspectos da questão original.

O sistema então avalia as informações recuperadas utilizando sinais de qualidade, como autoridade do domínio, atualidade do conteúdo, relevância do tema e padrões de citação. Informações de múltiplas fontes são combinadas e sintetizadas em uma resposta coerente e abrangente que responde diretamente à consulta original. Ao longo desse processo, o sistema identifica as fontes mais relevantes e autorizadas, que são então apresentadas como citações ou referências na resposta final. Por isso, entender o refinamento de consulta é fundamental para usuários do AmICited—as fontes que aparecem nas respostas geradas por IA são determinadas em grande parte pelo alinhamento com as subconsultas refinadas que o sistema gera.

A relação entre refinamento de consulta e visibilidade em busca nos AI Overviews é direta e mensurável. Pesquisas mostram que mais de 88% das buscas que ativam AI Overviews têm intenção informacional, ou seja, usuários buscam aprender sobre algo em vez de realizar uma compra ou acessar um site específico. Essas consultas informacionais são justamente as mais propensas a passarem por refinamento extensivo, já que frequentemente exigem síntese de múltiplas fontes para oferecer uma resposta completa. Quando seu conteúdo está alinhado com as subconsultas refinadas que um sistema de IA gera, seu site tem uma chance significativamente maior de ser citado como fonte.

Os dados são contundentes: ser citado como fonte em AI Overviews aumenta a taxa de cliques de 0,6% para 1,08%, quase dobrando o tráfego em comparação com aparecer apenas nos resultados tradicionais abaixo do overview. Isso torna o entendimento do refinamento de consulta essencial para a estratégia de SEO moderna. Em vez de otimizar para uma única palavra-chave, os criadores de conteúdo devem pensar em como o seu conteúdo aborda as várias consultas refinadas que um sistema de IA pode gerar. Por exemplo, ao escrever sobre “moda sustentável”, antecipe que um sistema de IA pode refinar isso em subconsultas como “impacto ambiental da fast fashion”, “práticas de fabricação ética”, “materiais sustentáveis”, “certificações de comércio justo” e “marcas sustentáveis com bom custo-benefício”. Seu conteúdo deve abordar esses ângulos refinados de forma abrangente para maximizar o potencial de citação.

Além disso, pesquisas indicam que aproximadamente 70% dos usuários leem apenas o primeiro terço dos AI Overviews, o que significa que ser citado logo no início da resposta é significativamente mais valioso do que aparecer depois. Isso sugere que criadores de conteúdo devem estruturar suas informações com as respostas mais críticas e resumidas no topo, em formato claro e citável. O objetivo é ser a fonte que o sistema de IA “precisa” citar para fornecer uma resposta credível e completa às consultas refinadas que ele gera.

Um refinamento de consulta eficaz exige compreender e aplicar várias técnicas-chave. A primeira é a adição de detalhes contextuais, em que usuários ou sistemas acrescentam contexto específico para tornar as consultas mais precisas. Em vez de buscar por “tênis de corrida”, uma consulta refinada pode ser “melhores tênis de corrida à prova d’água para mulheres com pés altos abaixo de R$ 800”. Esse contexto adicional ajuda sistemas de IA a entender restrições e preferências importantes para o usuário, permitindo uma recuperação de informação mais direcionada. Para criadores de conteúdo, isso significa antecipar esses refinamentos contextuais e criar materiais que abordem casos de uso, públicos e restrições específicos.

A segunda técnica é a especificação de restrições, em que o usuário define limites ou condições para a busca. Isso pode incluir faixas de preço, localizações geográficas, períodos de tempo ou padrões de qualidade. Sistemas de IA reconhecem essas restrições e refinam a busca de acordo. Por exemplo, uma consulta sobre “melhor software de gestão de projetos para equipes remotas com menos de 50 funcionários” inclui múltiplas restrições que devem orientar a criação do conteúdo. Seu material deve abordar explicitamente esses cenários de restrição para aumentar a chance de citação.

A terceira técnica é o questionamento de acompanhamento, em que usuários fazem perguntas esclarecedoras para refinar seu entendimento. Em sistemas conversacionais como o ChatGPT, usuários podem perguntar “Você pode explicar de forma mais simples?” ou “Como isso se aplica a pequenas empresas?”. Essas perguntas desencadeiam o refinamento de consulta, ajustando a abordagem do sistema com base no feedback do usuário. Por isso, profundidade conversacional e capacidade de abordar múltiplos ângulos de um tema são cada vez mais importantes para a visibilidade do conteúdo.

A quarta técnica é a decomposição de consulta, em que perguntas complexas são divididas em questões componentes mais simples. Isso é especialmente relevante para sistemas de IA, que usam essa técnica para garantir cobertura abrangente do assunto. Se um usuário pergunta “Quais as melhores práticas para otimizar sites de e-commerce para mecanismos de busca com IA?”, um sistema de IA pode decompor em: “O que são mecanismos de busca com IA?”, “Como sistemas de IA ranqueiam conteúdo de e-commerce?”, “Quais otimizações técnicas importam?”, “Como estruturar descrições de produtos?”, e “Qual o papel do conteúdo gerado por usuários?”. Conteúdo que aborda essas questões componentes de forma abrangente terá mais chances de ser citado em múltiplas consultas refinadas.

A Otimização para Motores Geradores (GEO), também conhecida como Otimização para Grandes Modelos de Linguagem (LLMO), está fundamentalmente ligada à compreensão e otimização para processos de refinamento de consulta. O SEO tradicional focava em ranquear para palavras-chave específicas; o GEO foca em ser fonte citada nas consultas refinadas que sistemas de IA geram. Isso representa uma mudança de paradigma na forma como criadores de conteúdo devem abordar a otimização para busca.

No contexto GEO, o refinamento de consulta não é algo que acontece com seu conteúdo — é algo para o qual você deve se antecipar e preparar. Ao criar conteúdo, pense em todas as maneiras pelas quais um sistema de IA pode refinar ou decompor seu tema em subconsultas. Por exemplo, escrevendo sobre “moda sustentável”, crie conteúdo que aborde: impacto ambiental da moda convencional, materiais sustentáveis e suas propriedades, práticas éticas de fabricação e trabalho, certificações e padrões, considerações de custo, recomendações de marcas e como fazer a transição para a moda sustentável. Ao abordar esses ângulos refinados de forma abrangente, você aumenta a probabilidade de ser citado em múltiplas respostas geradas por IA.

Pesquisas da Elementor’s 2026 AI SEO Statistics mostram que o tráfego de busca via IA aumentou 527% ano a ano, com alguns sites já relatando mais de 1% do total de sessões vindos de plataformas como ChatGPT, Perplexity e Copilot. Esse crescimento explosivo evidencia a importância do refinamento de consulta. O tráfego proveniente de plataformas de IA também é significativamente mais valioso — visitantes referenciados por IA valem 4,4 vezes mais do que visitantes de busca orgânica tradicional, com taxas de rejeição 27% menores e duração de sessão 38% maior para sites de varejo. Isso significa que otimizar para refinamento de consulta não é apenas uma questão de visibilidade; trata-se de atrair tráfego qualificado e pronto para converter.

O futuro do refinamento de consulta caminha para sistemas cada vez mais sofisticados, personalizados e autônomos. A geração sintética de consultas está se tornando mais avançada, com sistemas de IA capazes de criar consultas diversas e contextualmente apropriadas que simulam padrões reais de busca dos usuários. Essas consultas sintéticas são fundamentais para treinar sistemas de IA a lidar com consultas inéditas ou pouco comuns, aproveitando padrões aprendidos e informações contextuais. À medida que as IAs se tornam mais capazes, gerarão subconsultas cada vez mais nuançadas e específicas, exigindo dos criadores de conteúdo um pensamento ainda mais aprofundado sobre os diversos ângulos e perspectivas de seus temas.

Outra tendência emergente é o refinamento de consulta com estado, em que sistemas de IA mantêm o contexto ao longo de múltiplos turnos de conversa, permitindo refinamento mais sofisticado com base nas necessidades e preferências evolutivas do usuário. Em vez de tratar cada consulta como independente, esses sistemas entendem como as consultas se relacionam com interações anteriores, possibilitando refinamentos mais personalizados e contextuais. Isso impacta a estratégia de conteúdo — seu material deve ser estruturado para suportar conversas em múltiplos turnos, nas quais usuários refinam progressivamente seu entendimento.

A integração do aprendizado por reforço nos sistemas de refinamento de consulta também é significativa. Esses sistemas aprendem com o feedback dos usuários para melhorar continuamente a qualidade dos refinamentos. Se usuários clicam consistentemente em certas fontes ou passam mais tempo em determinadas páginas, o sistema aprende a priorizar essas fontes em refinamentos futuros. Isso cria uma vantagem competitiva para criadores de conteúdo que fornecem informações de alta qualidade e autoridade — eles se tornam as fontes “preferenciais” que os sistemas de IA aprendem a citar.

Além disso, o avanço dos agentes de IA e sistemas de busca autônomos sugere que o refinamento de consulta será ainda mais sofisticado. Em vez de usuários refinarem manualmente suas buscas, agentes de IA gerarão e executarão refinamentos autonomamente, explorando o espaço da informação de forma abrangente para responder questões complexas. Isso significa que criadores de conteúdo devem garantir que seu conteúdo seja descoberto não apenas por pessoas, mas por agentes autônomos de IA que pesquisam e refinam sistematicamente consultas pela web.

O cenário competitivo também está evoluindo. À medida que mais plataformas implementam capacidades de refinamento de consulta, a habilidade de aparecer em consultas refinadas torna-se um diferencial estratégico. Usuários do AmICited que entendem e monitoram sua presença nas consultas refinadas em diferentes plataformas de IA terão uma vantagem significativa sobre concorrentes que focam apenas em ranqueamentos tradicionais. O futuro pertence a criadores de conteúdo e marcas que reconhecem o refinamento de consulta como aspecto fundamental da visibilidade em busca e otimizam seu conteúdo de acordo.

O refinamento de consulta foca em aprimorar a relevância e precisão dos resultados de busca ajustando ou sugerindo consultas com base no contexto do usuário e em dados históricos, buscando fornecer informações mais precisas. Já a expansão de consulta envolve gerar consultas adicionais para aprimorar o desempenho dos mecanismos de busca, abordando problemas como consultas iniciais mal formuladas ou resultados irrelevantes. Enquanto o refinamento melhora uma consulta existente, a expansão cria múltiplas consultas relacionadas para ampliar o escopo da busca. Ambas as técnicas trabalham juntas nos sistemas modernos de busca com IA para melhorar a qualidade da recuperação da informação.

Mecanismos de busca com IA usam o refinamento de consulta por meio de um processo chamado de query fan-out, no qual uma única consulta do usuário é decomposta em várias subconsultas que são executadas simultaneamente em diferentes fontes de dados. Por exemplo, uma questão complexa como 'melhores tênis de corrida à prova d'água para pés planos' pode ser dividida em subconsultas que exploram listas de produtos, análises de especialistas, experiências de usuários e especificações técnicas. Essa recuperação paralela de informações a partir de diferentes fontes expande significativamente o conjunto de dados disponível para a síntese de respostas, permitindo que a IA forneça respostas mais abrangentes e precisas.

O processamento de linguagem natural é fundamental para o refinamento de consulta, pois permite que sistemas de IA interpretem o significado além da simples correspondência de palavras-chave. O PLN utiliza padrões e relações contextuais entre palavras para decifrar como as pessoas falam, tornando as buscas mais intuitivas e precisas. Por exemplo, o PLN permite que um sistema entenda que 'cafeterias abertas' significa estabelecimentos atualmente funcionando e localizados próximos, não apenas documentos que contenham essas palavras exatas. Essa compreensão contextual é o que permite que sistemas modernos de IA refinem consultas de forma inteligente e forneçam resultados condizentes com a intenção do usuário, e não apenas com a correspondência literal de palavras-chave.

O refinamento de consulta melhora a visibilidade de busca nos AI Overviews ao ajudar criadores de conteúdo a entenderem como os usuários modificam suas buscas para encontrar melhores resultados. Ao direcionar tanto as consultas iniciais quanto as refinadas com conteúdo abrangente que antecipa necessidades e perguntas posteriores, os sites aumentam suas chances de serem citados como fontes. Pesquisas mostram que ser destacado como fonte em AI Overviews aumenta as taxas de clique de 0,6% para 1,08%, tornando o entendimento do refinamento de consulta essencial para a estratégia de SEO moderna e para a visibilidade em citações de IA.

Consultas sintéticas são consultas artificialmente geradas por grandes modelos de linguagem que simulam pesquisas reais de usuários. Elas são essenciais para o refinamento de consulta porque expandem os dados rotulados de treinamento, melhoram o recall e permitem que a recuperação generativa escale para grandes conjuntos de dados preenchendo lacunas de informações. Consultas sintéticas são criadas por meio de mineração de dados estruturados, análise de títulos de documentos e textos âncora, e uso de conjuntos de regras estruturadas. Elas ajudam os sistemas de IA a entender e refinar consultas ao fornecer exemplos diversos de como os usuários poderiam formular necessidades de informação semelhantes, aprimorando a capacidade do sistema de refinar e expandir consultas de usuários com eficácia.

Empresas podem otimizar para refinamento de consulta analisando dados do Google Search Console para identificar palavras-chave relacionadas e variações de consulta que os usuários pesquisam sequencialmente. Devem criar conteúdo abrangente que aborde tanto consultas amplas iniciais quanto variações refinadas e específicas. Utilizando ferramentas como seoClarity ou plataformas similares, as empresas podem minerar dados de refinamento de consultas e de autosuggest para encontrar variações relevantes para pesquisa de palavras-chave. Além disso, monitorar posições por refinamento de consulta e acompanhar o desempenho de diferentes páginas facetadas ajuda a direcionar decisões sobre estratégia de conteúdo e implementação técnica.

O refinamento de consulta está profundamente conectado à intenção do usuário, pois revela como as necessidades de informação evoluem durante a jornada de busca. Ao analisar padrões de refinamento, empresas conseguem entender o que os usuários realmente procuram em cada etapa do processo de decisão. Por exemplo, um usuário pode começar com uma intenção ampla ('tênis de corrida') e refinar progressivamente para uma intenção mais específica ('melhores tênis de corrida à prova d'água para pés planos'). Compreender esses padrões permite que criadores de conteúdo desenvolvam materiais direcionados para cada etapa da jornada do usuário, melhorando tanto a visibilidade de busca quanto as taxas de conversão.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Saiba como a reformulação de consultas ajuda sistemas de IA a interpretar e aprimorar consultas de usuários para uma melhor recuperação de informações. Entenda ...

Saiba como a otimização de expansão de consulta melhora os resultados de busca em IA ao preencher lacunas de vocabulário. Descubra técnicas, desafios e por que ...

Descubra o que é Análise de Consultas em IA, como funciona e por que é importante para a visibilidade em buscas por IA. Entenda classificação de intenção de con...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.