JavaScript SEO

JavaScript SEO otimiza sites renderizados em JavaScript para rastreamento e indexação por mecanismos de busca. Aprenda melhores práticas, métodos de renderizaçã...

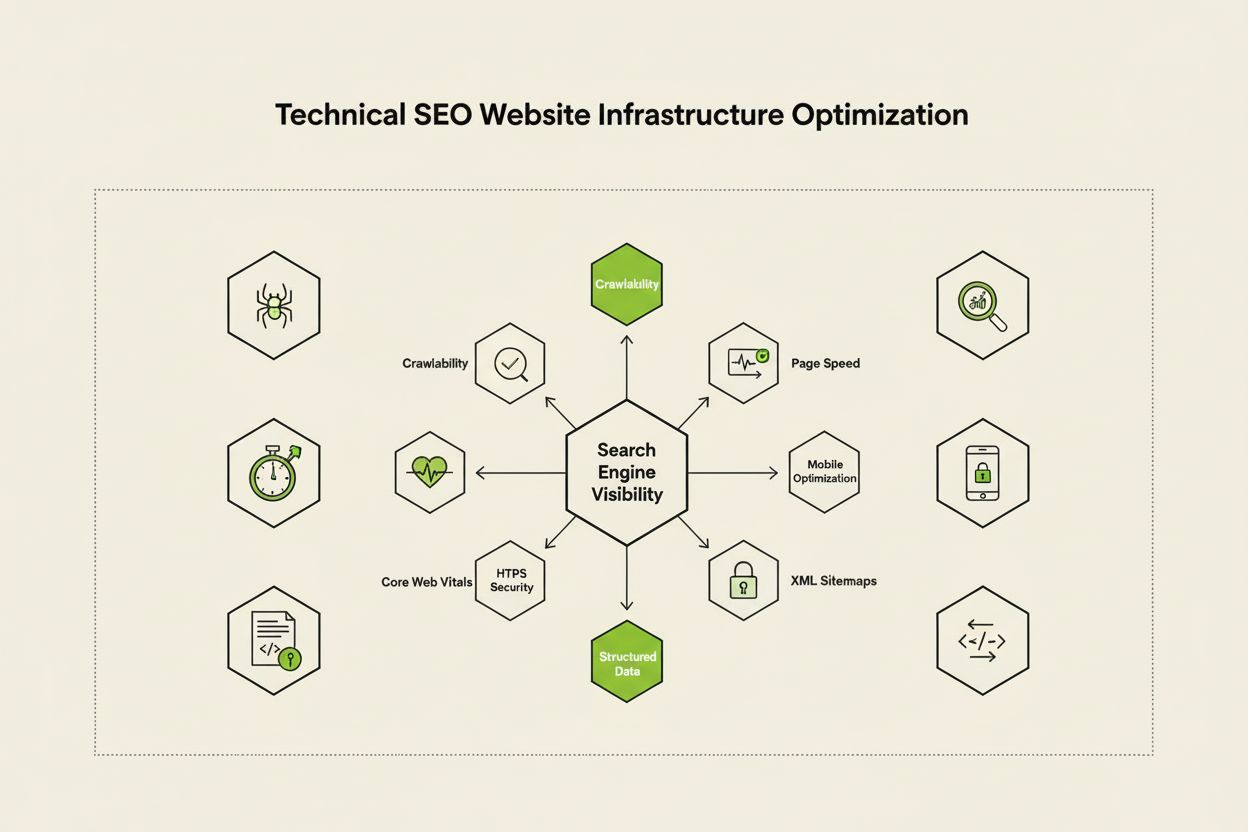

SEO Técnico é o processo de otimizar a infraestrutura de um site para que os mecanismos de busca possam rastrear, renderizar, indexar e fornecer o conteúdo corretamente e de forma eficiente. Engloba velocidade do site, compatibilidade com dispositivos móveis, arquitetura do site, segurança e implementação de dados estruturados para garantir que os mecanismos de busca possam descobrir e ranquear suas páginas.

SEO Técnico é o processo de otimizar a infraestrutura de um site para que os mecanismos de busca possam rastrear, renderizar, indexar e fornecer o conteúdo corretamente e de forma eficiente. Engloba velocidade do site, compatibilidade com dispositivos móveis, arquitetura do site, segurança e implementação de dados estruturados para garantir que os mecanismos de busca possam descobrir e ranquear suas páginas.

SEO Técnico é o processo de otimizar a infraestrutura de back-end de um site para garantir que os mecanismos de busca possam rastrear, renderizar, indexar e fornecer o conteúdo de forma eficiente e correta. Diferente do SEO on-page, que foca em qualidade do conteúdo e otimização de palavras-chave, o SEO técnico aborda os elementos fundamentais que determinam se os buscadores conseguem acessar e entender seu site. Isso inclui velocidade do site, responsividade mobile, arquitetura do site, protocolos de segurança, implementação de dados estruturados e fatores de rastreabilidade. O SEO técnico atua como a base invisível de todas as outras iniciativas de SEO—sem ele, até o conteúdo mais qualificado permanece invisível para buscadores e usuários. Segundo pesquisas do setor, 91% dos profissionais de marketing relataram que o SEO melhorou o desempenho do site em 2024, sendo a otimização técnica parte fundamental para alcançar resultados mensuráveis. A importância do SEO técnico cresceu à medida que os motores de busca se tornam mais sofisticados e plataformas de busca por IA surgem, exigindo que os sites atendam a padrões técnicos cada vez mais rígidos para garantir visibilidade.

O SEO técnico se apoia em quatro pilares interconectados que trabalham juntos para maximizar a visibilidade nos mecanismos de busca. Rastreabilidade determina se o Googlebot e outros rastreadores conseguem acessar as páginas do seu site por meio de links, sitemaps e estruturas de navegação interna. Indexabilidade garante que as páginas rastreadas realmente sejam armazenadas no índice do Google e estejam aptas a aparecer nos resultados de busca. Desempenho e Core Web Vitals medem o quão rápido as páginas carregam e o quão responsivas são às interações dos usuários—fatores que influenciam diretamente os rankings e a experiência do usuário. Otimização mobile garante que seu site funcione perfeitamente em smartphones e tablets, que já representam mais de 60% do tráfego de busca segundo pesquisa da Sistrix. Esses quatro pilares são interdependentes; uma fraqueza em qualquer um deles pode comprometer a eficácia dos outros. Por exemplo, um site rápido no desktop, mas com desempenho ruim no mobile, enfrentará dificuldades para ranquear no índice mobile-first do Google, independentemente de quão bem otimizada esteja sua rastreabilidade. Entender como esses pilares interagem é fundamental para desenvolver uma estratégia de SEO técnico abrangente que trate todos os aspectos da visibilidade nos buscadores.

Embora frequentemente confundidos, rastreabilidade e indexabilidade representam duas etapas distintas no pipeline dos mecanismos de busca. Rastreabilidade refere-se à capacidade do buscador de descobrir e acessar as páginas do seu site ao seguir links internos, backlinks externos e sitemaps XML. Ela responde à pergunta: “O Googlebot consegue chegar a esta página?” Se uma página não for rastreável—talvez por estar bloqueada no robots.txt, escondida atrás de JavaScript ou órfã, sem links internos—ela não pode sequer chegar à etapa de indexação. Indexabilidade, por sua vez, determina se uma página rastreada será realmente armazenada no índice do Google e aparecerá nos resultados de busca. Uma página pode ser perfeitamente rastreável, mas não ser indexada se contiver uma meta tag noindex, tiver conteúdo duplicado ou não atender aos critérios de qualidade do Google. Segundo o guia técnico do Search Engine Land, entender essa diferença é fundamental, pois corrigir problemas de rastreabilidade exige soluções diferentes das usadas para problemas de indexabilidade. Problemas de rastreabilidade costumam envolver a estrutura do site, configuração do robots.txt e links internos, enquanto indexabilidade está mais relacionada a meta tags, tags canônicas, qualidade do conteúdo e problemas de renderização. Ambos devem ser tratados para alcançar visibilidade máxima na busca.

Core Web Vitals são três métricas específicas usadas pelo Google para medir a experiência real do usuário e influenciar diretamente o posicionamento nas buscas. Largest Contentful Paint (LCP) mede a velocidade de carregamento do maior elemento visível na página—o Google recomenda LCP de 2,5 segundos ou menos. Interaction to Next Paint (INP), que substituiu o First Input Delay em 2024, mede a responsividade da página às interações do usuário, como cliques e toques—o objetivo é ficar abaixo de 200 milissegundos. Cumulative Layout Shift (CLS) mede a estabilidade visual, monitorando mudanças inesperadas de layout durante o carregamento—a meta é uma pontuação abaixo de 0,1. Pesquisa da DebugBear indica que sites precisam que 75% dos usuários experimentem desempenho “Bom” em todas as três métricas para obter o benefício máximo no ranking. A transição para o INP como fator de ranqueamento reflete o compromisso do Google em avaliar a responsividade global da página ao longo de toda a interação do usuário, não apenas no carregamento inicial. Otimizar os Core Web Vitals exige abordagem multifacetada: melhorar o LCP envolve otimizar imagens, usar CDNs e adiar JavaScript não crítico; aprimorar o INP requer dividir tarefas longas em JavaScript e otimizar handlers de eventos; já reduzir o CLS depende de reservar espaço para conteúdos dinâmicos e evitar anúncios que mudam o layout. Essas métricas tornaram-se obrigatórias para quem disputa espaço competitivo no SEO, pois páginas com Core Web Vitals ruins sofrem penalidades de ranking e maiores taxas de rejeição.

Arquitetura do site refere-se a como as páginas do seu site estão organizadas, estruturadas e conectadas por links internos. Uma arquitetura bem planejada cumpre funções críticas: ajuda os buscadores a entender a hierarquia do conteúdo, distribui a autoridade de links (link equity) por todo o site, garante que páginas importantes sejam facilmente descobertas e melhora a navegação do usuário. A arquitetura ideal segue uma hierarquia clara, com a homepage no topo, páginas de categoria no segundo nível e páginas de conteúdo individual em níveis mais profundos. A melhor prática determina que todas as páginas importantes estejam acessíveis em até três cliques da página inicial, evitando que o Googlebot desperdice orçamento de rastreamento em páginas profundas e isoladas. Links internos funcionam como a cola da arquitetura do site, guiando usuários e buscadores pelo conteúdo. O uso estratégico de links internos consolida sinais de ranking em páginas prioritárias, estabelece relações temáticas entre conteúdos relacionados e ajuda os buscadores a entender quais páginas são mais relevantes. Por exemplo, um modelo hub-and-spoke—em que uma página pilar abrangente linka para várias páginas de subtemas, que por sua vez retornam o link para a pilar—cria uma estrutura poderosa que sinaliza autoridade temática para os buscadores. Arquitetura ruim, marcada por páginas órfãs, navegação inconsistente e aninhamento profundo, leva os buscadores a desperdiçarem orçamento de rastreamento e dificulta a construção de autoridade temática. Empresas que reestruturam sua arquitetura frequentemente observam grandes melhorias na velocidade de indexação e desempenho no ranking.

Indexação mobile-first significa que o Google utiliza principalmente a versão mobile do seu site para rastreamento, indexação e ranqueamento—não a versão desktop. Essa mudança reflete o fato de que mais de 60% das buscas vêm de dispositivos móveis. Para o SEO técnico, significa que a experiência mobile deve ser impecável: design responsivo que se adapta a todos os tamanhos de tela, navegação adequada ao toque com espaçamento apropriado entre elementos clicáveis, fontes legíveis sem necessidade de zoom e carregamento rápido otimizado para redes móveis. Design responsivo usa layouts fluidos e imagens flexíveis para se ajustar automaticamente a diferentes telas, garantindo funcionalidade consistente em qualquer dispositivo. Erros comuns na otimização mobile incluem intersticiais invasivos (pop-ups) que bloqueiam o conteúdo principal, texto pequeno demais, botões muito próximos dificultando o toque preciso e páginas lentas em redes móveis. O teste Mobile-Friendly do Google e as auditorias do Lighthouse ajudam a identificar esses problemas, mas testes reais em dispositivos são indispensáveis. A relação entre otimização mobile e ranking é direta: páginas com experiências ruins no mobile são penalizadas, enquanto páginas otimizadas ganham mais visibilidade. Para e-commerces, SaaS e publishers, otimização mobile não é opcional—é fundamental para competir nas buscas.

XML sitemaps funcionam como um roteiro para os mecanismos de busca, listando todos os URLs que você deseja indexar junto com metadados como última modificação e prioridade. Um sitemap bem mantido deve incluir apenas URLs canônicos e indexáveis—excluindo redirecionamentos, páginas 404 e conteúdos duplicados. Robots.txt é um arquivo de texto na raiz do site que fornece instruções de rastreamento aos robôs, especificando quais diretórios e arquivos podem ou não ser acessados. Embora o robots.txt possa bloquear rastreamento, ele não impede indexação caso a página seja descoberta por outros meios; para exclusão real, use meta tags noindex. Orçamento de rastreamento refere-se ao número de páginas que o Googlebot rastreia em seu site em determinado período—um recurso finito que deve ser gerenciado estrategicamente. Grandes sites com milhões de páginas precisam otimizar o orçamento garantindo que o Googlebot concentre o rastreamento em conteúdos de valor, evitando desperdício em páginas de baixa prioridade, conteúdos duplicados ou variações geradas por navegação facetada. O desperdício comum de orçamento ocorre quando parâmetros de busca geram infinitas variações de URL, ambientes de homologação são expostos aos robôs ou páginas de conteúdo raso recebem links internos em excesso. Segundo orientações oficiais do Google, gerenciar o orçamento de rastreamento é especialmente importante para grandes sites, pois rastreamento ineficiente pode atrasar a descoberta e indexação de novos conteúdos. Ferramentas como o relatório de estatísticas de rastreamento do Google Search Console e análise de logs de servidor mostram exatamente quais páginas estão sendo visitadas e com que frequência, possibilitando otimização baseada em dados.

Dados estruturados, implementados via schema markup, ajudam os mecanismos de busca a entender o significado e o contexto do seu conteúdo além da simples análise textual. O schema usa vocabulário padronizado (schema.org) para rotular diferentes tipos de conteúdo—produtos, artigos, receitas, eventos, negócios locais e muito mais. Quando bem implementado, o schema possibilita resultados enriquecidos na busca, com o Google exibindo informações como avaliações, preços, tempo de preparo ou datas de eventos diretamente nos resultados. Esse destaque pode melhorar significativamente a taxa de cliques e o engajamento. Cada tipo de conteúdo exige um schema específico: schema de artigo para blogs e notícias, schema de produto para e-commerces, schema de FAQ para perguntas frequentes, schema de Local Business para estabelecimentos físicos e schema de evento para eventos futuros. A implementação geralmente usa o formato JSON-LD, preferido pelo Google. Porém, o schema deve refletir fielmente o conteúdo real da página—uso enganoso ou fictício pode gerar penalidades manuais. Segundo pesquisa do Search Engine Land, apenas páginas com schema válido e relevante possuem direito ao rich result, tornando a precisão da implementação fundamental. Organizações que implementam schema abrangente nas páginas mais importantes costumam ver aumento de visibilidade tanto na busca tradicional quanto em plataformas de IA, já que esses sistemas dependem dos dados estruturados para entender e citar conteúdos com precisão.

HTTPS (Hypertext Transfer Protocol Secure) criptografa os dados transmitidos entre o navegador do usuário e o seu servidor, protegendo informações sensíveis e sinalizando confiabilidade tanto para usuários quanto para mecanismos de busca. O Google confirmou que HTTPS é fator de ranqueamento, e sites sem HTTPS sofrem penalizações diretas e indiretas, como alertas nos navegadores que desencorajam o uso. Implementar HTTPS exige obter um certificado SSL/TLS de uma autoridade certificadora confiável e configurar o servidor para usar HTTPS em todas as páginas. Além do HTTPS básico, headers de segurança como Content-Security-Policy, Strict-Transport-Security e X-Content-Type-Options oferecem proteção adicional contra vulnerabilidades comuns. Erros de conteúdo misto—quando páginas HTTPS carregam recursos em HTTP—comprometem a segurança e podem gerar alertas no navegador. A relação entre segurança e SEO vai além dos rankings: sites seguros constroem confiança, reduzem a rejeição e aumentam conversões. Para lojas virtuais, SaaS com dados de usuário e qualquer site que coleta informações pessoais, segurança é inegociável. Auditorias regulares com o relatório de problemas de segurança do Google Search Console e scanners de vulnerabilidade ajudam a identificar e corrigir problemas antes que afetem rankings ou a confiança do usuário.

| Aspecto | SEO Técnico | SEO On-Page | SEO Off-Page |

|---|---|---|---|

| Foco Principal | Infraestrutura do site, velocidade, rastreabilidade, indexabilidade | Qualidade do conteúdo, palavras-chave, meta tags, headings | Backlinks, menções de marca, sinais sociais |

| Acesso dos Buscadores | Garante que buscadores possam rastrear e indexar páginas | Ajuda buscadores a entender a relevância da página | Constrói autoridade e sinais de confiança |

| Elementos-Chave | Velocidade do site, otimização mobile, Core Web Vitals, arquitetura, HTTPS, dados estruturados | Posicionamento de palavra-chave, profundidade do conteúdo, linkagem interna, meta descriptions | Perfil de backlinks, autoridade de domínio, menções de marca |

| Ferramentas Utilizadas | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Impacto nos Rankings | Fundamental—sem ele, as páginas nem ranqueiam | Direto—melhora relevância para palavras-chave | Significativo—constrói autoridade e confiança |

| Impacto na Experiência do Usuário | Alto—afeta velocidade, usabilidade mobile, acessibilidade | Médio—influencia legibilidade e engajamento | Baixo—indireto via percepção de marca |

| Cronograma de Implementação | Contínuo—exige monitoramento e otimização constantes | Contínuo—exige atualizações de conteúdo | Longo prazo—exige esforços sustentados de link building |

| Medição de ROI | Eficiência de rastreamento, taxa de indexação, Core Web Vitals, rankings | Ranqueamento de palavras-chave, tráfego orgânico, CTR | Crescimento de backlinks, autoridade de domínio, tráfego de referência |

SEO para JavaScript trata dos desafios exclusivos de sites pesados em JavaScript, aplicações de página única (SPAs) e renderização dinâmica de conteúdo. Historicamente, o Googlebot tinha dificuldades com JavaScript porque era preciso renderizar—executar o código JS para construir a página final—o que adicionava complexidade e atrasos ao rastreamento. Hoje, o Googlebot já renderiza a maioria das páginas antes de indexar, mas esse processo traz novas considerações ao SEO técnico. Renderização do lado do servidor (SSR) gera o HTML completo no servidor antes de enviá-lo ao navegador, garantindo que os buscadores vejam todo o conteúdo imediatamente, sem esperar pelo JavaScript. Geração de site estático (SSG) pré-renderiza páginas em tempo de build, criando arquivos HTML estáticos que carregam instantaneamente. Renderização dinâmica entrega HTML pré-renderizado aos buscadores e JavaScript aos usuários, mas o Google considera isso uma solução temporária. O princípio crítico: todo conteúdo essencial, meta tags e dados estruturados devem estar presentes no HTML inicial, não carregados dinamicamente após a execução do JavaScript. Páginas que ocultam conteúdo crítico atrás do JavaScript correm risco de indexação incompleta ou atrasada. Frameworks como React, Vue e Angular requerem atenção especial—muitas empresas usam Next.js ou Nuxt.js justamente para SSR e melhor desempenho em SEO. Testar como o Googlebot vê suas páginas usando a ferramenta de inspeção de URL do Google Search Console e o recurso de visualização renderizada revela se o conteúdo dependente de JS está sendo corretamente indexado.

Implementar SEO técnico de forma eficaz exige uma abordagem sistemática que priorize otimizações de maior impacto. Comece pelos fundamentos: garanta que seu site seja rastreável verificando robots.txt e links internos, confira se páginas importantes estão indexáveis analisando tags noindex e problemas com canônicos, e estabeleça uma linha de base para o desempenho nos Core Web Vitals. Em seguida, otimize o desempenho: comprima e otimize imagens, implemente lazy loading para conteúdos abaixo da dobra, adie JavaScript não crítico e use CDNs para entrega mais rápida. Depois, otimize a estrutura do site: mantenha páginas importantes a até três cliques da homepage, implemente navegação com breadcrumb e schema, e aplique padrões claros de linkagem interna para guiar usuários e buscadores. Implemente dados estruturados para os principais tipos de conteúdo—produtos, artigos, informações de negócios locais ou eventos—usando JSON-LD e validando com o Rich Results Test do Google. Monitore continuamente usando o Search Console para indexação, PageSpeed Insights para Core Web Vitals e logs de servidor para padrões de rastreamento. Estabeleça responsabilidade acompanhando métricas-chave como número de páginas indexadas, Core Web Vitals e eficiência de rastreamento ao longo do tempo. Empresas que tratam SEO técnico como processo contínuo, e não apenas auditoria pontual, superam concorrentes em visibilidade de busca e experiência do usuário.

Com o crescimento de plataformas de busca baseadas em IA como Google AI Overviews, Perplexity, ChatGPT e Claude, a importância do SEO técnico vai além da busca tradicional no Google. Esses sistemas de IA dependem de conteúdo bem indexado e estruturado nos índices dos buscadores para gerar respostas e citações. O SEO técnico garante que seu conteúdo seja descoberto e corretamente interpretado por sistemas de IA de várias formas: indexação adequada disponibiliza o conteúdo para treinamento e recuperação por IA, dados estruturados ajudam esses sistemas a entender contexto e significado, e riqueza semântica faz com que sua página seja reconhecida como relevante e autoritativa. Segundo pesquisas da Conductor e Botify, páginas que aparecem em Overviews de IA geralmente vêm de sites tecnicamente sólidos e ricos semanticamente. A relação é bidirecional: enquanto o SEO tradicional foca em ranquear para palavras-chave, a busca por IA busca fornecer respostas completas citando múltiplas fontes. Isso exige que o SEO técnico atenda aos dois paradigmas—garantindo indexação para a busca tradicional e riqueza semântica para reconhecimento e citação por IA. Organizações que monitoram sua visibilidade em múltiplas plataformas de IA com ferramentas como AmICited conseguem identificar quais otimizações técnicas mais elevam suas taxas de citação e visibilidade em buscas generativas.

SEO técnico eficaz depende do acompanhamento de métricas específicas que indicam a saúde do site e a acessibilidade para buscadores. Número de páginas indexadas mostra quantas páginas pretendidas realmente estão no índice do Google—comparando com o total de páginas indexáveis, é possível calcular a eficiência da indexação. Eficiência de rastreamento mede quão bem o Googlebot utiliza o orçamento de rastreamento, dividindo páginas rastreadas pelo total de páginas do site. Core Web Vitals indicam a qualidade da experiência do usuário em velocidade (LCP), interatividade (INP) e estabilidade visual (CLS). Problemas de usabilidade mobile no Search Console revelam questões como alvos de toque pequenos, erros de viewport ou intersticiais invasivos. Cadeia de redirecionamentos deve ser minimizada para preservar autoridade de links e evitar atrasos no rastreamento. Cobertura de dados estruturados mostra qual percentual das páginas possui schema válido. Métricas de velocidade, como First Contentful Paint (FCP), Time to Interactive (TTI) e Total Blocking Time (TBT), fornecem insights detalhados de desempenho. Defina medições de base para essas métricas, estabeleça metas de melhoria e acompanhe a evolução mensal ou trimestralmente. Mudanças bruscas nessas métricas geralmente sinalizam problemas técnicos antes de afetar o ranking, permitindo ação proativa. Ferramentas como Search Console, PageSpeed Insights, Lighthouse e plataformas como Semrush oferecem painéis completos para monitorar todas essas métricas do site.

O cenário do SEO técnico continua evoluindo com as mudanças nos algoritmos, novas tecnologias e novos comportamentos de usuários. Indexação e ranqueamento movidos por IA vão influenciar ainda mais quais páginas serão indexadas e como serão classificadas, exigindo que o SEO técnico apoie compreensão semântica e reconhecimento de entidades. Edge computing e arquiteturas serverless possibilitam entrega de conteúdo mais rápida e otimização em tempo real na borda da rede, reduzindo latência e melhorando Core Web Vitals. Foco ampliado nos sinais E-E-A-T (Experiência, Expertise, Autoridade, Confiança) exige que o SEO técnico reforce a credibilidade do conteúdo com marcação de autor, datas de publicação e sinais de confiabilidade. Otimização multi-superfície será prática padrão à medida que plataformas de busca por IA proliferam, exigindo que sites otimizem para visibilidade em Google, Perplexity, ChatGPT, Claude e outros emergentes. Analytics com foco em privacidade e coleta de dados primários vão transformar a mensuração do impacto do SEO técnico, substituindo cookies de terceiros por tracking server-side e mensuração baseada em consentimento. Maturação dos frameworks JavaScript continuará melhorando as possibilidades de SEO, com Next.js, Nuxt.js e Remix se tornando padrão para aplicações SEO-friendly. SEO técnico automatizado com IA permitirá detecção e correção mais rápida de problemas, com plataformas sugerindo e aplicando ajustes em rastreabilidade, indexabilidade e desempenho. Organizações que acompanham essas tendências, atualizando continuamente sua infraestrutura técnica e monitorando as melhores práticas emergentes, manterão vantagem competitiva na busca orgânica.

SEO Técnico foca na otimização da infraestrutura de back-end do site—como velocidade do site, rastreabilidade, indexabilidade e configuração do servidor—para ajudar os mecanismos de busca a descobrir e processar o conteúdo. Já o SEO On-Page concentra-se na otimização de elementos individuais das páginas, como posicionamento de palavras-chave, meta tags, headings e qualidade do conteúdo para melhorar a relevância para buscas específicas. Enquanto o SEO técnico garante que os buscadores possam acessar seu site, o SEO on-page garante que eles entendam sobre o que é seu conteúdo e por que ele é relevante para os usuários.

Os Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) e Cumulative Layout Shift (CLS)—são fatores de ranqueamento confirmados que medem a experiência real do usuário. Segundo pesquisa da DebugBear, sites precisam que 75% dos usuários tenham uma experiência 'Boa' em todas as três métricas para receber o maior impulso de ranqueamento. Core Web Vitals ruins podem resultar em penalidades de ranqueamento, redução da taxa de cliques e aumento da taxa de rejeição, afetando diretamente a visibilidade orgânica e o engajamento do usuário.

A rastreabilidade determina se os robôs dos mecanismos de busca conseguem acessar e seguir os links dentro do seu site. Se o Googlebot não puder rastrear suas páginas devido a recursos bloqueados, má estrutura do site ou restrições no robots.txt, essas páginas não poderão ser indexadas ou ranqueadas. Sem uma rastreabilidade adequada, até mesmo conteúdo de alta qualidade permanece invisível para os mecanismos de busca, tornando impossível alcançar visibilidade orgânica independentemente da qualidade do conteúdo ou do perfil de backlinks.

À medida que plataformas de busca movidas por IA como Google AI Overviews e Perplexity se tornam mais relevantes, o SEO técnico permanece fundamental. Esses sistemas de IA dependem de conteúdo bem indexado e estruturado no índice do Google para gerar respostas. O SEO técnico garante que seu conteúdo seja descoberto, renderizado corretamente e semanticamente rico o suficiente para ser citado e referenciado por sistemas de IA. Sem bases técnicas sólidas, seu conteúdo não aparecerá em Overviews de IA nem em outros resultados de busca generativa.

Para a maioria dos sites, recomenda-se realizar uma auditoria técnica completa de SEO a cada trimestre, com monitoramento mensal para questões críticas. Sites corporativos maiores com atualizações frequentes devem auditar mensalmente ou implementar sistemas de monitoramento contínuo. Após grandes mudanças, migrações ou redesigns, auditorias imediatas são essenciais. Auditorias regulares ajudam a detectar problemas cedo, antes que impactem o ranqueamento, garantindo que seu site mantenha rastreabilidade, indexabilidade e desempenho ideais.

A arquitetura do site determina como os mecanismos de busca navegam e entendem a hierarquia de conteúdo do seu site. Uma arquitetura bem otimizada garante que páginas importantes estejam a até três cliques da página inicial, distribui a autoridade de links de forma eficiente e ajuda os buscadores a priorizarem o rastreamento de conteúdos de alto valor. Uma arquitetura ruim pode gerar páginas órfãs, desperdício de orçamento de rastreamento e dificuldade em estabelecer autoridade temática, prejudicando ranqueamento e visibilidade.

A velocidade da página impacta diretamente tanto o ranking de busca quanto o comportamento do usuário. O Google confirmou que os Core Web Vitals—que medem velocidade de carregamento, interatividade e estabilidade visual—são fatores de ranqueamento. Páginas lentas apresentam maiores taxas de rejeição, menor engajamento e menos conversões. Estudos mostram que páginas que carregam em menos de 2,5 segundos têm retenção de usuários e desempenho em ranking significativamente melhores em comparação com páginas mais lentas, tornando a otimização de velocidade fundamental para o sucesso em SEO.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

JavaScript SEO otimiza sites renderizados em JavaScript para rastreamento e indexação por mecanismos de busca. Aprenda melhores práticas, métodos de renderizaçã...

SEO Empresarial é a prática de otimizar sites grandes e complexos com milhares de páginas para mecanismos de busca. Aprenda estratégias, desafios e melhores prá...

YouTube SEO é o processo de otimizar vídeos e canais para alcançar melhores posições nos resultados de busca do YouTube. Aprenda fatores de ranqueamento, estrat...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.