Arquitetura da Informação

Arquitetura da Informação é a prática de organizar e estruturar conteúdo para máxima usabilidade. Saiba como a AI melhora a encontrabilidade, a experiência do u...

Uma arquitetura de rede neural baseada em mecanismos de autoatenção multi-head que processa dados sequenciais em paralelo, possibilitando o desenvolvimento dos modernos grandes modelos de linguagem, como ChatGPT, Claude e Perplexity. Introduzidos no artigo de 2017 ‘Attention is All You Need’, os transformers tornaram-se a tecnologia fundamental que sustenta praticamente todos os sistemas de IA de ponta.

Uma arquitetura de rede neural baseada em mecanismos de autoatenção multi-head que processa dados sequenciais em paralelo, possibilitando o desenvolvimento dos modernos grandes modelos de linguagem, como ChatGPT, Claude e Perplexity. Introduzidos no artigo de 2017 'Attention is All You Need', os transformers tornaram-se a tecnologia fundamental que sustenta praticamente todos os sistemas de IA de ponta.

Arquitetura Transformer é um design revolucionário de rede neural apresentado no artigo de 2017 “Attention is All You Need” por pesquisadores do Google. Ela é fundamentalmente baseada em mecanismos de autoatenção multi-head que permitem aos modelos processar sequências inteiras de dados em paralelo, em vez de sequencialmente. A arquitetura consiste em camadas empilhadas de encoders e decoders, cada uma contendo subcamadas de autoatenção e redes neurais feed-forward, conectadas por conexões residuais e normalização de camada. A Arquitetura Transformer tornou-se a tecnologia fundamental por trás de praticamente todos os grandes modelos de linguagem (LLMs) modernos, incluindo ChatGPT, Claude, Perplexity e Google AI Overviews, tornando-a, sem dúvida, a inovação em redes neurais mais importante da última década.

A importância da Arquitetura Transformer vai muito além de sua elegância técnica. O artigo “Attention is All You Need”, de 2017, já foi citado mais de 208.000 vezes, tornando-se um dos mais influentes da história do aprendizado de máquina. Essa arquitetura mudou fundamentalmente como sistemas de IA processam e compreendem linguagem, possibilitando o desenvolvimento de modelos com bilhões de parâmetros capazes de raciocínio sofisticado, escrita criativa e resolução de problemas complexos. O mercado empresarial de LLMs, construído quase inteiramente sobre tecnologia transformer, foi avaliado em US$ 6,7 bilhões em 2024 e tem previsão de crescimento a uma taxa composta anual de 26,1% até 2034, demonstrando a importância crítica da arquitetura para a infraestrutura moderna de IA.

O desenvolvimento da Arquitetura Transformer representa um momento crucial na história do deep learning, surgindo de décadas de pesquisa em redes neurais para processamento de dados sequenciais. Antes dos transformers, as redes neurais recorrentes (RNNs) e suas variantes, especialmente as redes LSTM (Long Short-Term Memory), dominavam tarefas de processamento de linguagem natural. No entanto, essas arquiteturas tinham limitações fundamentais: processavam sequências de forma sequencial, um elemento por vez, o que as tornava lentas para treinar e dificultava a captura de dependências entre elementos distantes em sequências longas. O problema do gradiente desaparecendo limitava ainda mais a capacidade das RNNs de aprender relações de longo alcance, pois os gradientes se tornavam exponencialmente menores ao retropropagar por muitas camadas.

A introdução dos mecanismos de atenção em 2014 por Bahdanau e colegas foi uma grande inovação, permitindo que modelos focassem em partes relevantes de sequências de entrada, independentemente da distância. No entanto, a atenção era usada inicialmente como um aprimoramento das RNNs, não como substituição. O artigo dos Transformers, em 2017, levou esse conceito adiante, propondo que atenção é tudo que você precisa—ou seja, toda a arquitetura de rede neural poderia ser construída apenas com mecanismos de atenção e camadas feed-forward, eliminando completamente a recorrência. Esse insight se mostrou transformador. Ao eliminar o processamento sequencial, os transformers permitiram massiva paralelização, possibilitando treinamentos em volumes de dados sem precedentes usando GPUs e TPUs. O maior modelo transformer do artigo original, treinado em 8 GPUs por 3,5 dias, demonstrou que escala e paralelização levam a melhorias dramáticas de desempenho.

Após o artigo original, a arquitetura evoluiu rapidamente. O BERT (Bidirectional Encoder Representations from Transformers), lançado pelo Google em 2019, mostrou que encoders transformer podiam ser pré-treinados em enormes corpora de texto e ajustados para tarefas diversas. O maior modelo BERT continha 345 milhões de parâmetros e foi treinado em 64 TPUs especializadas por quatro dias, a um custo estimado de US$ 7.000, alcançando resultados de ponta em diversos benchmarks de compreensão de linguagem. Paralelamente, a série GPT da OpenAI seguiu um caminho diferente, usando arquiteturas apenas de decoder treinadas em tarefas de modelagem de linguagem. O GPT-2, com 1,5 bilhão de parâmetros, surpreendeu a comunidade ao mostrar que a modelagem de linguagem sozinha podia gerar sistemas altamente capazes. O GPT-3, com 175 bilhões de parâmetros, exibiu capacidades emergentes—habilidades que aparecem apenas em larga escala, como aprendizado com poucos exemplos e raciocínio complexo—mudando fundamentalmente as expectativas sobre o que sistemas de IA podem realizar.

A Arquitetura Transformer é composta por vários componentes técnicos interconectados que trabalham juntos para possibilitar processamento paralelo eficiente e compreensão sofisticada de contexto. A camada de embedding de entrada converte tokens discretos (palavras ou subpalavras) em representações vetoriais contínuas, tipicamente de dimensão 512 ou superior. Esses embeddings são então enriquecidos com codificação posicional, que adiciona informações sobre a posição de cada token na sequência usando funções seno e cosseno em diferentes frequências. Essa informação posicional é essencial porque, ao contrário das RNNs, que preservam ordem sequencial pela recorrência, transformers processam todos os tokens simultaneamente e precisam de sinais explícitos de posição para entender a ordem e distâncias relativas das palavras.

O mecanismo de autoatenção é a inovação arquitetural que diferencia os transformers de todos os designs anteriores de redes neurais. Para cada token na sequência de entrada, o modelo calcula três vetores: um vetor de Consulta (Query) (representando o que o token busca), vetores de Chave (Key) (representando que informação cada token contém) e vetores de Valor (Value) (representando a informação a ser passada adiante). O mecanismo de atenção calcula um escore de similaridade entre a Consulta de cada token e as Chaves de todos os tokens via produto escalar, normaliza esses escores usando softmax para criar pesos de atenção entre 0 e 1, e então utiliza esses pesos para criar uma soma ponderada dos vetores Valor. Esse processo permite que cada token foque seletivamente em outros tokens relevantes, possibilitando ao modelo compreender contexto e relações.

A atenção multi-head estende esse conceito ao executar múltiplos mecanismos de atenção em paralelo, normalmente 8, 12 ou 16 heads. Cada head opera em diferentes projeções lineares dos vetores Consulta, Chave e Valor, permitindo ao modelo focar em diferentes tipos de relações e padrões em subespaços de representação distintos. Por exemplo, uma head pode focar em relações sintáticas entre palavras, enquanto outra foca em relações semânticas ou dependências de longo alcance. As saídas de todas as heads são concatenadas e transformadas linearmente, fornecendo ao modelo informações contextuais ricas e multifacetadas. Essa abordagem se mostrou extremamente eficaz, com pesquisas mostrando que diferentes heads especializam-se em fenômenos linguísticos distintos.

A estrutura encoder-decoder organiza esses mecanismos de atenção em um pipeline hierárquico de processamento. O encoder consiste em múltiplas camadas empilhadas (tipicamente 6 ou mais), cada uma contendo uma subcamada de autoatenção multi-head seguida de uma rede feed-forward aplicada por posição. Conexões residuais ao redor de cada subcamada permitem que os gradientes fluam diretamente durante o treinamento, melhorando a estabilidade e permitindo arquiteturas mais profundas. A normalização de camada é aplicada após cada subcamada, normalizando as ativações para manter escalas consistentes em toda a rede. O decoder tem estrutura semelhante, mas inclui uma camada adicional de atenção encoder-decoder que permite ao decoder focar na saída do encoder, possibilitando ao modelo focar em partes relevantes da entrada ao gerar cada token de saída. Em arquiteturas apenas de decoder, como GPT, o decoder gera tokens de saída de forma autoregressiva, com cada novo token condicionado a todos os tokens anteriores.

| Aspecto | Arquitetura Transformer | RNN/LSTM | Redes Neurais Convolucionais (CNN) |

|---|---|---|---|

| Método de Processamento | Processamento paralelo de sequências inteiras usando atenção | Processamento sequencial, um elemento por vez | Operações convolucionais locais em janelas de tamanho fixo |

| Dependências de Longo Alcance | Excelente; atenção conecta tokens distantes diretamente | Ruim; limitado por gradientes desaparecendo e gargalo sequencial | Limitado; campo receptivo local exige muitas camadas |

| Velocidade de Treinamento | Muito rápida; paralelização massiva em GPUs/TPUs | Lenta; processamento sequencial impede paralelização | Rápida para entradas de tamanho fixo; menos adequada para sequências variáveis |

| Requisitos de Memória | Alta; quadrática no comprimento da sequência devido à atenção | Menor; linear no comprimento da sequência | Moderada; depende do tamanho do kernel e profundidade |

| Escalabilidade | Excelente; escala para bilhões de parâmetros | Limitada; difícil treinar modelos muito grandes | Boa para imagens; menos adequada para sequências |

| Aplicações Típicas | Modelagem de linguagem, tradução automática, geração de texto | Séries temporais, predição sequencial (menos comum atualmente) | Classificação de imagens, detecção de objetos, visão computacional |

| Fluxo de Gradiente | Estável; conexões residuais permitem redes profundas | Problemático; gradientes desaparecendo/explodindo | Geralmente estável; conexões locais ajudam o fluxo de gradiente |

| Informação de Posição | Codificação posicional explícita necessária | Implícita via processamento sequencial | Implícita via estrutura espacial |

| LLMs de Estado da Arte | GPT, Claude, Llama, Granite, Perplexity | Raramente usados em LLMs modernos | Não usados para modelagem de linguagem |

A relação entre a Arquitetura Transformer e os grandes modelos de linguagem modernos é fundamental e inseparável. Todo LLM importante lançado nos últimos cinco anos—including GPT-4 da OpenAI, Claude da Anthropic, Llama da Meta, Gemini do Google, Granite da IBM e os modelos de IA da Perplexity—é construído sobre arquitetura transformer. A capacidade de escalar eficientemente tanto o tamanho do modelo quanto os dados de treinamento tem sido essencial para alcançar as capacidades que definem os sistemas de IA modernos. Quando pesquisadores aumentaram o tamanho do modelo de milhões para bilhões e centenas de bilhões de parâmetros, a paralelização e os mecanismos de atenção dos transformers permitiram esse escalonamento sem aumentos proporcionais no tempo de treinamento.

O processo de decodificação autoregressiva usado pela maioria dos LLMs modernos é uma aplicação direta da arquitetura do decoder transformer. Ao gerar texto, esses modelos processam o prompt de entrada pelo encoder (ou, em modelos apenas de decoder, pelo próprio decoder inteiro), e então geram tokens de saída um por vez. Cada novo token é gerado computando distribuições de probabilidade sobre todo o vocabulário usando softmax, com o modelo selecionando o token de maior probabilidade (ou amostrando da distribuição conforme a temperatura). Esse processo, repetido centenas ou milhares de vezes, produz textos coerentes e contextualmente apropriados. O mecanismo de autoatenção permite ao modelo manter o contexto em toda a sequência gerada, possibilitando produzir passagens longas e coerentes com temas, personagens e fluxo lógico consistentes.

As capacidades emergentes observadas em grandes modelos transformer—habilidades que só aparecem em escala suficiente, como aprendizado com poucos exemplos, raciocínio em cadeia e aprendizado em contexto—são consequências diretas do design da arquitetura. A atenção multi-head capta relações diversas e, combinada ao enorme número de parâmetros e ao treinamento em dados variados, permite que esses sistemas executem tarefas para as quais não foram explicitamente treinados. Por exemplo, o GPT-3 foi capaz de realizar aritmética, escrever código e responder perguntas de conhecimentos gerais apesar de ter sido treinado apenas em modelagem de linguagem. Essas propriedades emergentes tornaram os LLMs baseados em transformer o alicerce da revolução da IA moderna, com aplicações que vão de IA conversacional e geração de conteúdo a síntese de código e assistência a pesquisas científicas.

O mecanismo de autoatenção é a inovação arquitetural que distingue fundamentalmente os transformers e explica seu desempenho superior em relação a abordagens anteriores. Para entender a autoatenção, considere o desafio de interpretar pronomes ambíguos na linguagem. Na frase “O troféu não cabe na mala porque ele é muito grande”, o pronome “ele” pode se referir ao troféu ou à mala, mas o contexto deixa claro que se refere ao troféu. Em “O troféu não cabe na mala porque ele é muito pequeno”, o mesmo pronome agora se refere à mala. Um modelo transformer precisa aprender a resolver essas ambiguidades compreendendo as relações entre palavras.

A autoatenção realiza isso por meio de um processo matematicamente elegante. Para cada token na sequência de entrada, o modelo calcula um vetor de Consulta multiplicando o embedding do token por uma matriz de pesos aprendida WQ. Da mesma forma, calcula vetores de Chave (usando WK) e vetores de Valor (usando WV) para todos os tokens. O escore de atenção entre a Consulta de um token e a Chave de outro é calculado como o produto escalar desses vetores, normalizado pela raiz quadrada da dimensão da chave (tipicamente √64 ≈ 8). Esses escores brutos passam por uma função softmax, que os converte em pesos de atenção normalizados que somam 1. Por fim, a saída de cada token é calculada como uma soma ponderada de todos os vetores Valor, onde os pesos são os escores de atenção. Esse processo permite que cada token agregue seletivamente informações de todos os outros tokens, com os pesos aprendidos durante o treinamento para capturar relações significativas.

A elegância matemática da autoatenção permite computação eficiente. Todo o processo pode ser expresso como operações matriciais: Attention(Q, K, V) = softmax(QK^T / √d_k)V, onde Q, K e V são matrizes contendo todos os vetores de consulta, chave e valor, respectivamente. Essa formulação matricial permite aceleração por GPU, possibilitando que transformers processem sequências inteiras em paralelo em vez de sequencialmente. Uma sequência de 512 tokens pode ser processada em aproximadamente o mesmo tempo que um único token em uma RNN, tornando os transformers ordens de magnitude mais rápidos para treinar. Essa eficiência computacional, combinada à capacidade da atenção de capturar dependências de longo alcance, explica por que os transformers se tornaram a arquitetura dominante em modelagem de linguagem.

A atenção multi-head estende o mecanismo de autoatenção ao executar múltiplas operações de atenção em paralelo, cada uma aprendendo diferentes aspectos das relações entre tokens. Em um transformer típico com 8 heads de atenção, os embeddings de entrada são projetados linearmente em 8 subespaços de representação distintos, cada um com suas próprias matrizes de pesos de Consulta, Chave e Valor. Cada head calcula independentemente pesos de atenção e produz vetores de saída. Essas saídas são então concatenadas e transformadas linearmente por uma matriz de pesos final, gerando a saída final da atenção multi-head. Essa arquitetura permite ao modelo focar simultaneamente em informações de diferentes subespaços de representação em diferentes posições.

Pesquisas analisando transformers treinados revelaram que diferentes heads de atenção se especializam em fenômenos linguísticos distintos. Algumas heads focam em relações sintáticas, aprendendo a focar em palavras relacionadas gramaticalmente (por exemplo, verbos focando nos seus sujeitos e objetos). Outras heads focam em relações semânticas, aprendendo a focar em palavras com significados relacionados. Outras ainda capturam dependências de longo alcance, focando em palavras distantes na sequência mas semanticamente relacionadas. Algumas heads aprendem até a focar primariamente no próprio token, agindo como operações de identidade. Essa especialização emerge naturalmente durante o treinamento, sem supervisão explícita, demonstrando o poder da arquitetura multi-head para aprender representações diversas e complementares.

O número de heads de atenção é um hiperparâmetro arquitetural chave. Modelos maiores normalmente usam mais heads (16, 32 ou até mais), permitindo capturar relações mais diversas. No entanto, a dimensionalidade total da atenção costuma ser mantida constante, de modo que mais heads significam menor dimensionalidade por head. Essa escolha equilibra os benefícios de múltiplos subespaços de representação com a eficiência computacional. A abordagem multi-head se mostrou tão eficaz que se tornou padrão em praticamente todas as implementações modernas de transformers, do BERT e GPT a arquiteturas especializadas para visão, áudio e tarefas multimodais.

A arquitetura transformer original, conforme descrita no artigo “Attention is All You Need”, utiliza uma estrutura encoder-decoder otimizada para tarefas sequência-a-sequência, como tradução automática. O encoder processa a sequência de entrada e produz uma sequência de representações ricas em contexto. Cada camada do encoder contém dois componentes principais: uma subcamada de autoatenção multi-head que permite aos tokens focar em outros tokens da entrada, e uma rede feed-forward por posição que aplica a mesma transformação não linear a cada posição independentemente. Essas subcamadas são conectadas por conexões residuais (também chamadas de skip connections), que somam a entrada à saída de cada subcamada. Essa escolha, inspirada nas redes residuais da visão computacional, permite o treinamento de redes muito profundas ao permitir que os gradientes fluam diretamente.

O decoder gera a sequência de saída um token por vez, usando informações tanto do encoder quanto dos tokens já gerados. Cada camada do decoder contém três componentes principais: uma subcamada de autoatenção mascarada que permite a cada token focar apenas em tokens anteriores (impedindo que o modelo “espie” tokens futuros durante o treinamento), uma subcamada de atenção encoder-decoder que permite aos tokens do decoder focar nas saídas do encoder, e uma rede feed-forward por posição. A máscara na subcamada de autoatenção é crucial: impede o fluxo de informação de posições futuras para passadas, garantindo que previsões para a posição i dependam apenas de saídas já conhecidas. Essa estrutura autoregressiva é essencial para gerar sequências um token de cada vez.

A arquitetura encoder-decoder se mostrou especialmente eficaz em tarefas onde entrada e saída possuem estruturas ou tamanhos diferentes, como tradução automática (de um idioma para outro), sumarização (condensação de documentos longos) e perguntas e respostas (geração de respostas a partir de contexto). No entanto, LLMs modernos como GPT utilizam arquiteturas apenas de decoder, onde uma única pilha de camadas de decoder processa tanto o prompt de entrada quanto gera a saída. Essa simplificação reduz a complexidade do modelo e se mostrou igualmente ou mais eficaz para tarefas de modelagem de linguagem, provavelmente porque o modelo pode aprender a usar a autoatenção para processar entrada e gerar saída de forma unificada.

Um desafio crítico na arquitetura transformer é representar a ordem dos tokens em uma sequência. Ao contrário das RNNs, que preservam a ordem sequencial por sua estrutura recorrente, transformers processam todos os tokens em paralelo e não possuem noção intrínseca de posição. Sem informação explícita de posição, um transformer trataria a sequência “O gato sentou no tapete” da mesma forma que “tapete no sentou gato o”, o que seria desastroso para compreensão de linguagem. A solução é a codificação posicional, que adiciona vetores dependentes da posição aos embeddings dos tokens antes do processamento.

O artigo original dos transformers utiliza codificações posicionais senoidais, onde o vetor de posição para a posição pos e dimensão i é calculado como:

Essas funções senoidais criam um padrão único para cada posição, com diferentes frequências para diferentes dimensões. As frequências mais baixas (i menor) variam lentamente com a posição, capturando informações posicionais de longo alcance, enquanto frequências mais altas variam rapidamente, captando detalhes mais finos. Esse design possui várias vantagens: generaliza naturalmente para sequências mais longas do que as vistas no treinamento, fornece transições suaves de posição e permite ao modelo aprender relações de posição relativa. Os vetores de codificação posicional são simplesmente somados aos embeddings antes da primeira camada de atenção, e o modelo aprende a usar essa informação posicional durante o treinamento.

Esquemas alternativos de codificação posicional têm sido propostos e estudados, incluindo representações de posição relativa (que codificam distâncias entre tokens, não posições absolutas) e embeddings posicionais rotativos (RoPE) (que rotacionam vetores de embedding com base na posição). Essas alternativas mostraram melhorias em certos cenários, especialmente para sequências muito longas ou quando ajustando para sequências maiores do que as vistas no treinamento. A escolha da codificação posicional pode impactar significativamente o desempenho do modelo, e este permanece um campo ativo de pesquisa em otimização de transformers.

Compreender a Arquitetura Transformer é essencial para entender como os sistemas de IA modernos geram respostas em plataformas como ChatGPT, Claude, Perplexity e Google AI Overviews. Esses sistemas, todos baseados em tecnologia transformer, processam perguntas de usuários através de múltiplas camadas de autoatenção, permitindo que compreendam contexto e gerem respostas coerentes e relevantes. Quando um usuário faz uma pergunta sobre uma marca, produto ou domínio, os mecanismos de atenção do modelo determinam quais partes dos dados de treinamento são mais relevantes, e o decoder gera uma resposta que pode mencionar ou referenciar essa marca.

Para organizações que usam plataformas de monitoramento de IA como o AmICited, entender a arquitetura transformer fornece contexto crucial para interpretar como e por que marcas aparecem em conteúdos gerados por IA. A capacidade da autoatenção de capturar relações entre conceitos significa que marcas mencionadas nos dados de treinamento podem estar associadas a tópicos, setores ou casos de uso específicos. Quando um usuário consulta um sistema de IA sobre esses tópicos, o mecanismo de atenção pode ativar conexões com sua marca, resultando em menções na resposta gerada. A estrutura multi-head significa que diferentes aspectos da presença da sua marca nos dados de treinamento podem ser capturados por diferentes heads, influenciando quão completamente o modelo entende e representa sua marca.

A dependência da arquitetura transformer em dados de treinamento também explica por que a visibilidade de marca nas saídas da IA depende fortemente da qualidade e quantidade da sua presença online. Modelos treinados em textos da internet terão representações mais ricas de marcas com conteúdo web de alta qualidade, menções frequentes em fontes reputadas e fortes associações semânticas com tópicos relevantes. Organizações que desejam melhorar sua visibilidade em respostas de IA precisam entender que, essencialmente, estão otimizando para inclusão nos dados de treinamento dos futuros modelos transformer. Essa compreensão faz a ponte entre o SEO tradicional (otimização para motores de busca) e o que pode ser chamado de “GEO” (Otimização para Motores Generativos)—otimização para visibilidade em sistemas de IA.

A Arquitetura Transformer continua a evoluir rapidamente, com pesquisadores explorando inúmeras melhorias e variantes. Transformers eficientes buscam resolver a complexidade quadrática de memória da atenção padrão (que cresce com o quadrado do comprimento da sequência) através de técnicas como atenção esparsa, janelas de atenção locais e aproximações lineares. Essas inovações permitem que transformers processem sequências muito mais longas, de milhares a milhões de tokens, abrindo possibilidades para processar documentos inteiros, bases de código ou bases de conhecimento em um único forward pass. Arquiteturas Mixture of Experts (MoE), usadas em modelos como o Switch Transformer do Google, substituem redes densas feed-forward por redes esparsas onde apenas um subconjunto de parâmetros é ativado para cada token, aumentando dramaticamente a capacidade do modelo sem aumento proporcional de computação.

Transformers multimodais expandem a arquitetura para processar e gerar múltiplos tipos de dados simultaneamente. Vision Transformers (ViTs) aplicam a arquitetura transformer a imagens, dividindo-as em patches e tratando cada patch como um token, alcançando resultados de ponta em classificação e detecção de imagens. Modelos multimodais como GPT-4V e Claude 3 processam texto e imagens usando arquiteturas transformer unificadas, possibilitando capacidades como compreensão de imagens e perguntas visuais. Transformers de áudio processam fala e música, enquanto transformers de vídeo lidam com sequências temporais de quadros. Essa capacidade multimodal sugere que transformers podem se tornar a arquitetura universal para todas as tarefas de IA, independentemente do tipo de dado.

As implicações estratégicas do domínio da arquitetura transformer são profundas. Organizações que constroem sistemas de IA precisam entender as capacidades e limitações dos transformers para tomar decisões informadas sobre seleção de modelos, fine-tuning e implantação. A natureza “faminta por dados” da arquitetura significa que qualidade e diversidade dos dados de treinamento são vantagens competitivas críticas. A interpretabilidade do mecanismo de atenção (comparada a outras abordagens de deep learning) cria oportunidades para IA explicável e detecção de vieses, embora os pesos de atenção sozinhos não expliquem todo o comportamento do modelo. A eficiência em escala sugere que modelos cada vez maiores continuarão dominando, ao menos até que surjam avanços fundamentais em arquiteturas alternativas. Para monitoramento de marcas e visibilidade em IA, a dependência da arquitetura transformer em dados de treinamento significa que construção de marca e estratégia de conteúdo no longo prazo continuam essenciais para manter visibilidade nas respostas geradas por IA.

O mercado global de LLMs, construído quase inteiramente sobre a arquitetura transformer, tem previsão de crescer de US$ 8,07 bilhões em 2025 para US$ 84,25 bilhões até 2033, representando uma taxa composta anual superior a 30%. Esse crescimento explosivo reflete o impacto transformador da arquitetura transformer nas capacidades e aplicações de IA. À medida que os transformers continuam melhorando e novas variantes surgem, seu papel como tecnologia fundamental da IA moderna só se aprofundará, tornando o entendimento dessa arquitetura essencial para qualquer pessoa que trabalhe com IA, ciência de dados ou estratégia digital.

A Arquitetura Transformer processa sequências inteiras em paralelo usando autoatenção, enquanto RNNs e LSTMs processam sequências de forma sequencial, um elemento por vez. Essa paralelização torna os transformers significativamente mais rápidos para treinar e melhores em capturar dependências de longo alcance entre palavras ou tokens distantes. Os transformers também evitam o problema do gradiente desaparecendo, que prejudicava as RNNs, permitindo que aprendam de sequências muito mais longas de forma eficaz.

A autoatenção calcula três vetores (Consulta, Chave e Valor) para cada token na sequência de entrada. O vetor de Consulta de um token é comparado com os vetores Chave de todos os tokens para determinar escores de relevância, que são normalizados usando softmax. Esses pesos de atenção são então aplicados aos vetores Valor para criar representações sensíveis ao contexto. Esse mecanismo permite que cada token 'atenda' ou foque em outros tokens relevantes na sequência, permitindo ao modelo compreender o contexto e os relacionamentos.

Os principais componentes incluem: (1) Embeddings de Entrada e Codificação Posicional para representar tokens e suas posições, (2) Camadas de Autoatenção Multi-Head que computam atenção em múltiplos subespaços de representação, (3) Redes Neurais Feed-Forward aplicadas independentemente a cada posição, (4) Pilha de Encoder que processa sequências de entrada, (5) Pilha de Decoder que gera sequências de saída, e (6) Conexões Residuais e Normalização de Camada para estabilidade no treinamento. Esses componentes trabalham juntos para possibilitar processamento paralelo eficiente e compreensão de contexto.

A Arquitetura Transformer se destaca para LLMs porque permite o processamento paralelo de sequências inteiras, reduzindo drasticamente o tempo de treinamento em comparação com RNNs sequenciais. Ela captura dependências de longo alcance de forma mais eficaz através da autoatenção, permitindo que modelos compreendam o contexto em documentos inteiros. A arquitetura também escala eficientemente com conjuntos de dados maiores e mais parâmetros, o que tem se mostrado essencial para treinar modelos com bilhões de parâmetros que demonstram capacidades emergentes.

A atenção multi-head executa múltiplos mecanismos de atenção paralelos (normalmente 8 ou 16 heads) simultaneamente, cada um operando em diferentes subespaços de representação. Cada head aprende a focar em diferentes tipos de relações e padrões nos dados. As saídas de todos os heads são concatenadas e transformadas linearmente, permitindo que o modelo capture informações contextuais diversas. Essa abordagem melhora significativamente a capacidade do modelo de entender relações complexas e melhora o desempenho geral.

A codificação posicional adiciona informações sobre as posições dos tokens aos embeddings de entrada usando funções seno e cosseno em diferentes frequências. Como os transformers processam todos os tokens em paralelo (ao contrário das RNNs sequenciais), precisam de informação explícita de posição para entender a ordem das palavras. Os vetores de codificação posicional são somados aos embeddings dos tokens antes do processamento, permitindo ao modelo aprender como a posição afeta o significado e possibilitando generalização para sequências mais longas do que as vistas durante o treinamento.

O encoder processa a sequência de entrada e cria representações contextuais ricas através de múltiplas camadas de autoatenção e redes feed-forward. O decoder gera a sequência de saída um token por vez, usando atenção encoder-decoder para focar em partes relevantes da entrada. Essa estrutura é particularmente útil para tarefas sequência-a-sequência como tradução automática, mas LLMs modernos geralmente usam arquiteturas apenas de decoder para tarefas de geração de texto.

A Arquitetura Transformer impulsiona os sistemas de IA que geram respostas em plataformas como ChatGPT, Claude, Perplexity e Google AI Overviews. Entender como os transformers processam e geram texto é crucial para plataformas de monitoramento de IA como o AmICited, que rastreiam onde marcas e domínios aparecem em respostas geradas por IA. A capacidade da arquitetura de entender contexto e gerar textos coerentes afeta diretamente como as marcas são mencionadas e representadas nas saídas da IA.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Arquitetura da Informação é a prática de organizar e estruturar conteúdo para máxima usabilidade. Saiba como a AI melhora a encontrabilidade, a experiência do u...

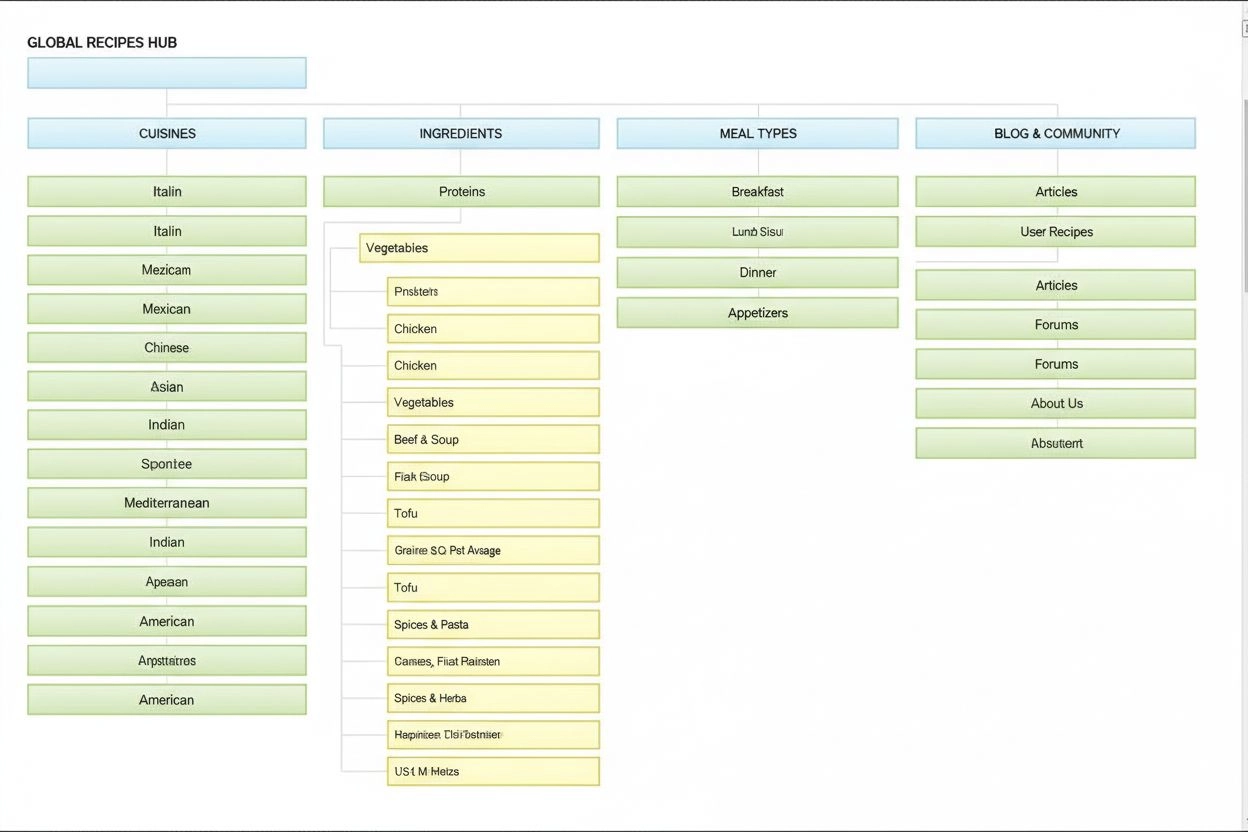

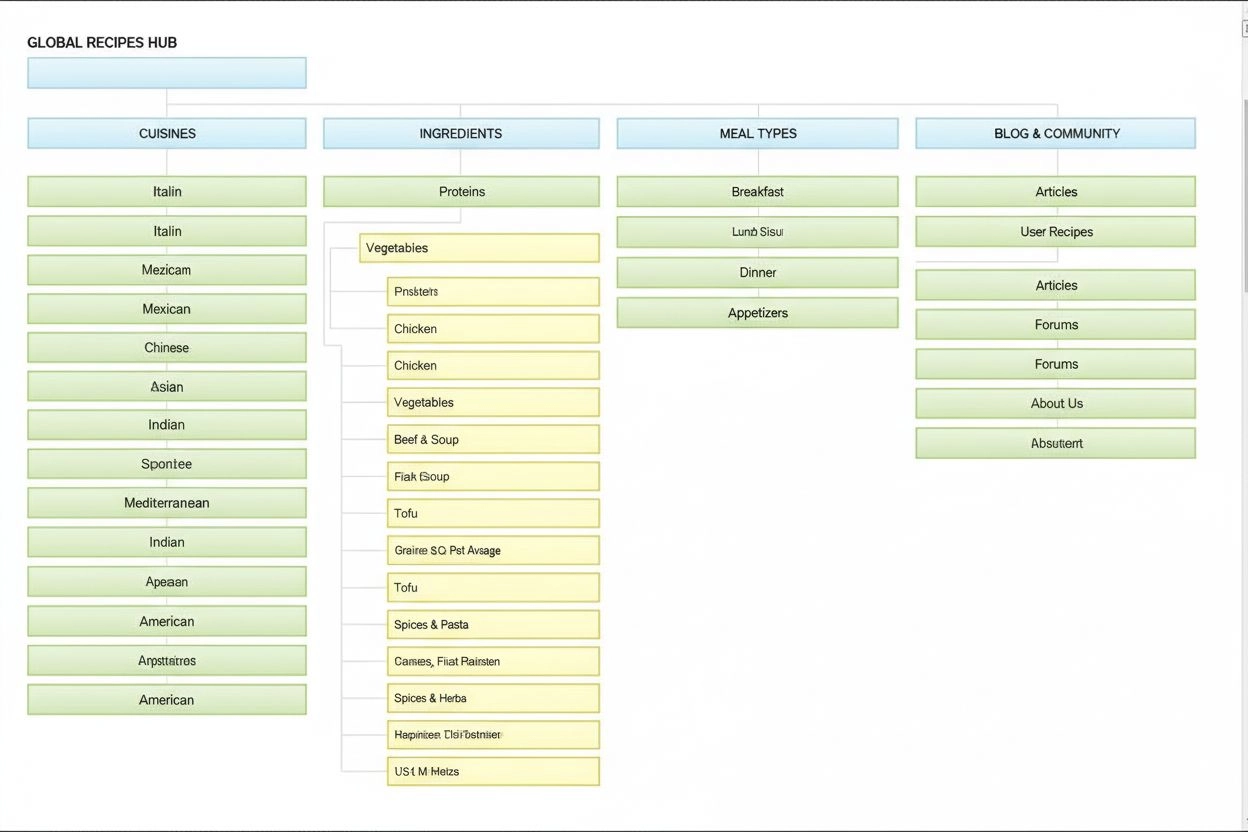

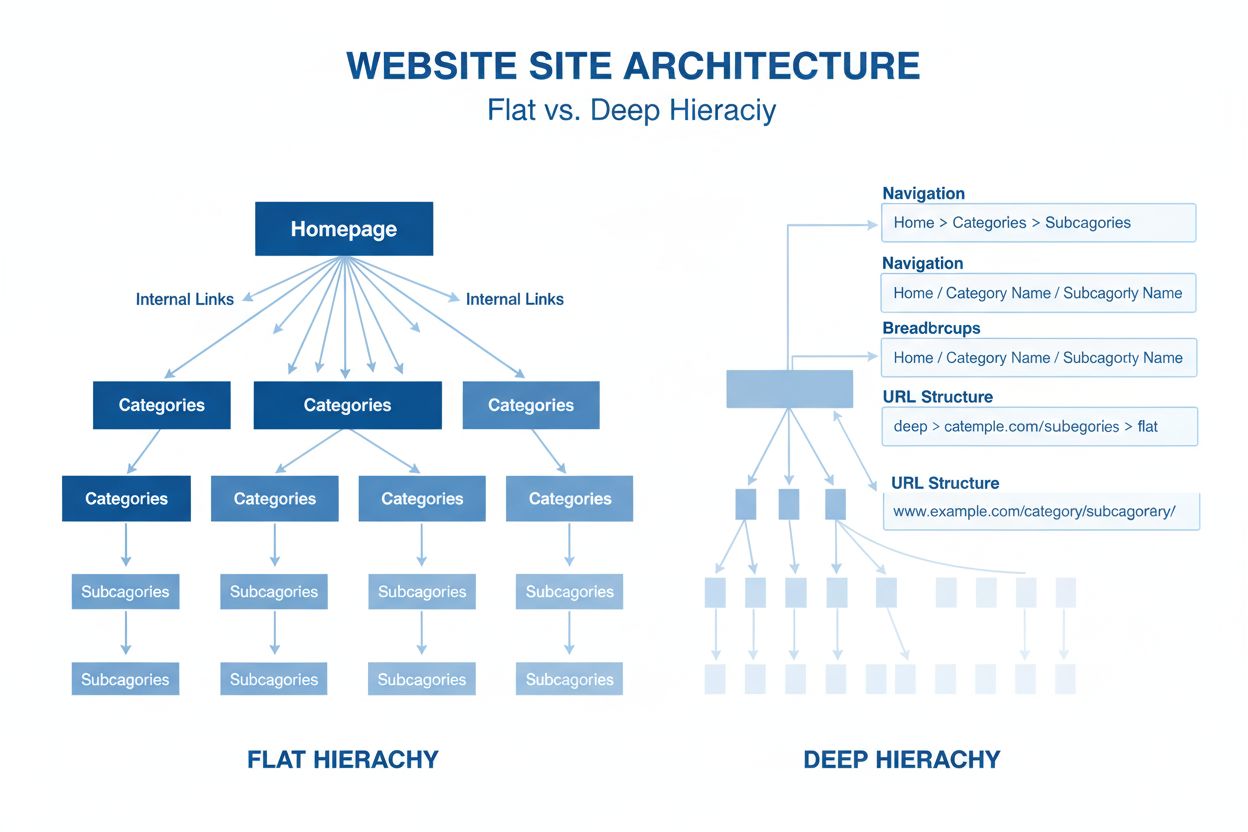

Arquitetura do site é a organização hierárquica das páginas e do conteúdo de um site. Saiba como uma estrutura adequada melhora o SEO, a experiência do usuário ...

O GPT-4 é o avançado LLM multimodal da OpenAI, combinando processamento de texto e imagem. Conheça suas capacidades, arquitetura e impacto no monitoramento de I...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.