Cum ajută vizualizările de date la căutarea AI și vizibilitatea LLM

Află cum vizualizările de date îmbunătățesc vizibilitatea în căutarea AI, ajută LLM-urile să înțeleagă conținutul și cresc citările în răspunsurile generate de ...

Descoperă cum modelele AI citează datele vizuale și graficele. Află de ce contează vizualizarea datelor pentru citările AI și cum să-ți monitorizezi conținutul vizual cu AmICited.

Datele vizuale reprezintă un blocaj fundamental pentru modelele mari de limbaj moderne, care au fost antrenate în principal pe informații bazate pe text și întâmpină dificultăți în a procesa, interpreta și cita graficele cu aceeași precizie aplicată conținutului scris. LLM-urile actuale se confruntă cu limitări semnificative atunci când întâlnesc vizualizări de date—ele trebuie mai întâi să convertească elementele vizuale în descrieri textuale, proces care pierde adesea nuanțe esențiale, valori precise și relații contextuale încorporate în graficul original. Incapacitatea sistemelor LLM de a procesa corect datele vizuale înseamnă că graficele, diagramele și infografiile rămân frecvent necitate sau sunt citate incorect, creând un decalaj de credibilitate pentru creatorii de conținut care investesc timp în realizarea unor vizualizări de calitate. Această problemă contează enorm pentru cercetători, analiști și organizații care se bazează pe procesarea graficelor de către AI pentru sinteza informațiilor, deoarece lipsa unei atribuiri corecte subminează atât munca autorului original, cât și fiabilitatea rezumatelor generate de AI. Înțelegerea acestor limitări este esențială pentru oricine creează conținut vizual într-un peisaj informațional tot mai influențat de AI.

Diferite sisteme AI abordează citarea conținutului vizual cu grade variate de sofisticare, reflectând arhitectura și metodele lor de antrenare. Tabelul de mai jos ilustrează modul în care principalele platforme AI gestionează citările vizuale:

| Model AI | Capacitate de citare vizuală | Formatul citării | Nivel de acuratețe | Suport multimodal |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Moderat | Text descriptiv | 65-75% | Da (input imagine) |

| Claude 3 | Ridicat | Atribuire detaliată | 80-85% | Da (cu viziune) |

| Perplexity AI | Ridicat | Sursă + referință vizuală | 85-90% | Da (integrat web) |

| Google AI Overviews | Moderat-ridicat | Citări inline | 75-80% | Da (căutare imagini) |

| Gemini Pro Vision | Moderat | Referință contextuală | 70-78% | Da (multimodal) |

Claude demonstrează o performanță superioară în atribuirea conținutului vizual, oferind adesea informații detaliate despre sursă și context vizual atunci când face referire la grafice, în timp ce Perplexity AI excelează în integrarea citărilor vizuale cu sursele web, creând o urmă de atribuire mai cuprinzătoare. GPT-4V al ChatGPT poate procesa imagini, dar de multe ori folosește descrieri generice în locul unor citări precise, mai ales când se confruntă cu grafice financiare sau științifice complexe. Google AI Overviews încearcă să mențină citări inline pentru conținutul vizual, dar uneori confundă creatorul graficului cu sursa datelor, ceea ce generează ambiguități privind atribuirea corectă. Pentru creatorii de conținut, această variație înseamnă că aceeași vizualizare poate fi tratată radical diferit în funcție de sistemul AI care o procesează—un grafic poate fi citat corect în Claude, dar complet neatribuit în ChatGPT, subliniind necesitatea critică pentru protocoale standardizate de citare vizuală în ecosistemul AI.

Vizualizarea datelor joacă un rol surprinzător de influent în modul în care modelele AI înțeleg și reprezintă informații, deoarece graficele și diagramele incluse în seturile de date de antrenare învață modelele să recunoască tipare, relații și ierarhii în date complexe. Calitatea și diversitatea datelor vizuale din seturile de antrenament influențează direct cât de bine pot sistemele AI să interpreteze și să citeze ulterior vizualizări similare, ceea ce înseamnă că modelele antrenate pe seturi de date vizuale cuprinzătoare au performanțe semnificativ mai bune în atribuirea conținutului vizual. Tiparele vizuale învățate în timpul antrenamentului influențează ieșirile modelului în moduri subtile dar măsurabile—un model antrenat extensiv pe grafice științifice etichetate corect va genera mai probabil citări corecte pentru vizualizări similare decât unul antrenat preponderent pe text. Problema se accentuează deoarece majoritatea modelelor mari de limbaj au fost antrenate pe date la scară de internet, unde conținutul vizual lipsește adesea de metadate corecte, alt-text sau atribuirea sursei, perpetuând un ciclu în care sistemele AI învață să proceseze grafice fără să învețe să le citeze. Organizațiile care investesc în seturi de date de vizualizare a datelor de calitate și bine documentate construiesc de fapt fundații mai bune pentru viitoarele sisteme AI, deși această investiție este încă subutilizată în industrie.

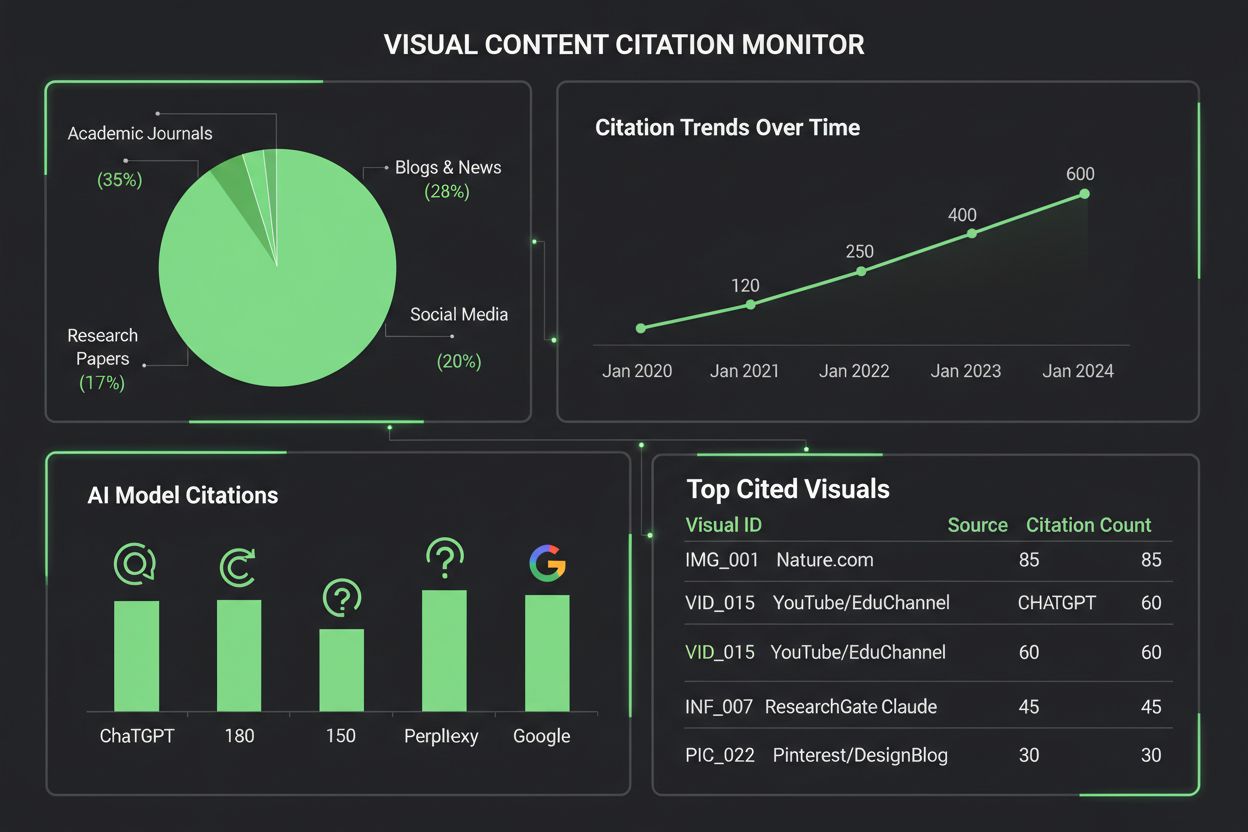

Monitorizarea modului în care sistemele AI citează conținutul vizual necesită o abordare multistratificată care combină detectarea automată cu verificarea manuală. Metodele cheie de urmărire includ:

AmICited.com este specializat în urmărirea citărilor conținutului vizual pe mai multe platforme AI, oferind creatorilor de conținut rapoarte detaliate despre modul în care graficele lor sunt menționate, atribuite sau ignorate de ChatGPT, Claude, Perplexity, Google AI și alte sisteme. Importanța monitorizării citărilor vizuale nu poate fi exagerată—fără o urmărire adecvată, creatorii pierd vizibilitatea asupra modului în care munca lor influențează conținutul generat de AI, făcând imposibilă promovarea unor practici mai bune de atribuire sau înțelegerea impactului real al vizualizărilor lor. Instrumentele de monitorizare a conținutului vizual de la AmICited umplu acest gol critic, oferind creatorilor alerte în timp real atunci când graficele sunt citate, analize detaliate privind acuratețea citărilor și recomandări practice pentru îmbunătățirea vizibilității conținutului vizual în sistemele AI.

Crearea unor vizualizări care să fie mai probabil citate de sistemele AI necesită alegeri de design intenționate care să pună accent pe claritate, bogăția metadatelor și lizibilitatea pentru mașini. Schemele de culori îndrăznețe, cu contrast ridicat și etichetarea clară îmbunătățesc semnificativ procesarea graficelor de către AI, deoarece modelele întâmpină dificultăți cu degradeurile subtile, elementele suprapuse și legendele ambigue pe care oamenii le pot interpreta ușor. Include descrieri alt-text cuprinzătoare care să surprindă nu doar ce arată graficul, ci și relațiile de date, perspectivele cheie și informațiile despre sursă—aceste metadate devin fundamentul pentru citări AI corecte. Încorporează date structurate în vizualizările tale folosind standarde precum JSON-LD sau markup microdata, ceea ce permite sistemelor AI să extragă valori și relații precise fără a se baza doar pe interpretarea vizuală. Asigură-te că titlurile graficelor sunt descriptive și specifice, nu generice, deoarece modelele AI folosesc titlurile ca ancore principale pentru înțelegerea și citarea conținutului vizual. Oferă atribuirea sursei direct în vizualizare prin note de subsol, watermark-uri sau etichete integrate cu sursa, făcând imposibil pentru sistemele AI să separe graficul de originea sa. Organizațiile care implementează aceste practici în mod consecvent observă îmbunătățiri măsurabile în modul în care conținutul lor vizual este citat pe platformele AI, ceea ce duce la o mai bună atribuire, vizibilitate crescută și credibilitate profesională sporită.

Peisajul instrumentelor de monitorizare a citărilor vizuale se extinde pe măsură ce organizațiile recunosc importanța urmăririi modului în care sistemele AI fac referire la conținutul vizual. AmICited.com se evidențiază ca o soluție cuprinzătoare, proiectată special pentru monitorizarea citărilor de conținut vizual pe mai multe platforme AI, oferind creatorilor tablouri de bord detaliate care arată exact când și cum sunt citate graficele lor de ChatGPT, Claude, Perplexity, Google AI Overviews și sisteme AI emergente. Platformele tradiționale de urmărire a citărilor precum Google Scholar și Scopus se concentrează în principal pe lucrări academice și citări bazate pe text, lăsând conținutul vizual în mare parte nemonitorizat și neatribuit. Instrumente specializate precum Tinybird și platforme similare de vizualizare a datelor integrează acum capacități de urmărire a citărilor, permițând organizațiilor să monitorizeze modul în care vizualizările lor de date în timp real sunt consumate și referite de sistemele AI. Capabilitățile analitice vizuale ale AmICited oferă metrici privind frecvența citării, ratele de acuratețe și tiparele specifice fiecărei platforme, permițând creatorilor de conținut să înțeleagă care sisteme AI atribuie corect munca lor și care necesită intervenție. Pentru organizațiile care doresc să-și protejeze proprietatea intelectuală vizuală și să înțeleagă influența conținutului lor în ecosistemul informațional guvernat de AI, implementarea unei soluții dedicate de monitorizare a citărilor vizuale precum AmICited.com a devenit esențială—transformă monitorizarea citărilor dintr-o observație pasivă într-o practică activă de management care conduce la rezultate mai bune de atribuire.

Modelele AI actuale au capacități variate când vine vorba de citarea conținutului vizual. În timp ce modele avansate precum Claude și Perplexity pot face referire la grafice cu o acuratețe rezonabilă, multe sisteme întâmpină dificultăți în atribuirea corectă. Majoritatea LLM-urilor au fost antrenate în principal pe date textuale, ceea ce face ca citarea vizuală să fie mai puțin fiabilă decât citarea textului. De aceea, instrumentele de monitorizare precum AmICited sunt esențiale pentru a urmări modul în care vizualizările tale sunt de fapt citate.

AmICited.com oferă monitorizare cuprinzătoare a conținutului vizual pe mai multe platforme AI, inclusiv ChatGPT, Claude, Perplexity și Google AI Overviews. Platforma folosește amprentare vizuală automată și analiză de metadate pentru a identifica atunci când graficele tale apar în conținut generat de AI, oferind alerte în timp real și analize detaliate privind acuratețea și frecvența citărilor.

Sistemele AI citează graficele mai precis atunci când acestea folosesc culori îndrăznețe, cu contrast ridicat, etichetare clară, titluri descriptive și alt-text detaliat. Includerea markup-ului de date structurate, atribuirea sursei în cadrul vizualizării și legendele bine organizate îmbunătățesc semnificativ procesarea graficelor de către AI și probabilitatea de citare. Crearea mai multor versiuni ale vizualizărilor complexe—simplificate pentru AI și detaliate pentru oameni—sporește de asemenea descoperirea acestora.

Bazându-ne pe capacitățile actuale, Claude 3 și Perplexity AI demonstrează cea mai mare acuratețe în atribuirea conținutului vizual, cu rate de acuratețe a citării de 80-90%. Google AI Overviews și Gemini Pro Vision se descurcă moderat bine, la 75-80%, în timp ce GPT-4V al ChatGPT, deși are capabilități vizuale, adesea folosește descrieri generice în locul unor citări precise. Aceste capacități continuă să evolueze pe măsură ce modelele sunt actualizate.

Monitorizarea citărilor vizuale este crucială pentru vizibilitatea brandului, evaluarea valorii conținutului și protecția proprietății intelectuale. Când graficele tale sunt citate corect de sistemele AI, crește vizibilitatea brandului în conținutul generat de AI, validează influența conținutului tău și te ajută să înțelegi modul în care munca ta modelează sinteza informațiilor generate de AI. Fără monitorizare, pierzi vizibilitatea asupra impactului și răspândirii conținutului tău.

AmICited este specializat în urmărirea citărilor conținutului vizual pe mai multe platforme AI, oferind tablouri de bord detaliate care arată când și cum sunt citate graficele tale. Platforma oferă alerte în timp real, metrici de acuratețe a citării, analize specifice fiecărei platforme și recomandări practice pentru îmbunătățirea descoperibilității conținutului vizual. Transformă monitorizarea citărilor dintr-o observație pasivă într-o gestionare activă a proprietății intelectuale vizuale.

Citările textuale în sistemele AI sunt de obicei mai fiabile deoarece LLM-urile au fost antrenate în principal pe date textuale. Citările vizuale necesită pași suplimentari de procesare—AI trebuie mai întâi să convertească elementele vizuale în descrieri text, ceea ce duce deseori la pierderea nuanțelor și a valorilor precise. Acest proces introduce mai multe oportunități de eroare, ceea ce face ca citarea vizuală să fie mai puțin precisă și mai puțin consecventă decât citarea textului între diferite platforme AI.

Absolut. Aplică bune practici precum folosirea culorilor îndrăznețe, cu contrast ridicat, crearea de titluri și alt-text descriptive, încorporarea markup-ului de date structurate și includerea atribuției sursei direct în vizualizări. Evită degradeurile subtile, elementele suprapuse și legendele ambigue. Ia în considerare crearea unor versiuni simplificate ale graficelor complexe special pentru procesarea AI. Aceste îmbunătățiri fac vizualizările tale mai ușor de descoperit și citat de sistemele AI.

Urmărește modul în care sistemele AI citează graficele și vizualizările tale pe ChatGPT, Claude, Perplexity și Google AI. Primește alerte în timp real și analize detaliate despre atribuirea conținutului vizual.

Află cum vizualizările de date îmbunătățesc vizibilitatea în căutarea AI, ajută LLM-urile să înțeleagă conținutul și cresc citările în răspunsurile generate de ...

Află cum să identifici și să închizi lacunele de conținut pentru vizibilitatea AI pe ChatGPT, Perplexity și Google AI Overviews. Descoperă metode de analiză și ...

Discuție în comunitate despre cum se comportă vizualizările de date și conținutul vizual în căutarea AI. Strategii pentru optimizarea graficelor, infograficelor...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.