Cum să Contestați și să Corectați Informațiile Inexacte din Răspunsurile AI

Află cum să contești informațiile inexacte generate de AI, să raportezi erorile către ChatGPT și Perplexity și să implementezi strategii pentru ca brandul tău s...

Corectarea dezinformării AI se referă la strategii și instrumente pentru identificarea și remedierea informațiilor incorecte despre branduri care apar în răspunsurile generate de AI din sisteme precum ChatGPT, Gemini și Perplexity. Aceasta implică monitorizarea modului în care sistemele AI prezintă brandurile și implementarea corecțiilor la nivel de sursă pentru a asigura distribuirea informațiilor corecte pe platforme de încredere. Spre deosebire de verificarea tradițională a faptelor, accentul se pune pe corectarea surselor în care AI are încredere, nu pe corectarea directă a răspunsurilor AI. Acest lucru este esențial pentru menținerea reputației și acurateței brandului într-un mediu de căutare condus de AI.

Corectarea dezinformării AI se referă la strategii și instrumente pentru identificarea și remedierea informațiilor incorecte despre branduri care apar în răspunsurile generate de AI din sisteme precum ChatGPT, Gemini și Perplexity. Aceasta implică monitorizarea modului în care sistemele AI prezintă brandurile și implementarea corecțiilor la nivel de sursă pentru a asigura distribuirea informațiilor corecte pe platforme de încredere. Spre deosebire de verificarea tradițională a faptelor, accentul se pune pe corectarea surselor în care AI are încredere, nu pe corectarea directă a răspunsurilor AI. Acest lucru este esențial pentru menținerea reputației și acurateței brandului într-un mediu de căutare condus de AI.

Corectarea dezinformării AI se referă la strategiile, procesele și instrumentele folosite pentru a identifica și remedia informațiile incorecte, învechite sau înșelătoare despre branduri care apar în răspunsurile generate de AI din sisteme precum ChatGPT, Gemini și Perplexity. Cercetări recente arată că aproximativ 45% dintre interogările AI produc răspunsuri eronate, ceea ce face ca acuratețea brandului în sistemele AI să fie o preocupare critică pentru afaceri. Spre deosebire de rezultatele tradiționale de căutare, unde brandurile își pot controla propriile listări, sistemele AI sintetizează informații din mai multe surse de pe internet, creând un peisaj complex în care dezinformarea poate persista în tăcere. Provocarea nu este doar să corectezi răspunsuri individuale ai—ci să înțelegi de ce sistemele AI greșesc informațiile despre brand și să implementezi corecții sistematice la nivel de sursă.

Sistemele AI nu inventează de la zero informațiile despre brand; ele le asamblează din ceea ce există deja pe internet. Totuși, acest proces creează mai multe puncte de eșec previzibile care duc la reprezentări greșite ale brandului:

| Cauză rădăcină | Cum se întâmplă | Impact de business |

|---|---|---|

| Inconsistență la sursă | Brandul este descris diferit pe diverse site-uri, directoare și articole | AI deduce un consens greșit din informațiile contradictorii |

| Surse autoritare învechite | Articole Wikipedia vechi, listări în directoare sau pagini de comparație cu date incorecte | Corecțiile noi sunt ignorate deoarece sursele vechi au semnale de autoritate mai puternice |

| Confuzie între entități | Nume de brand similare sau categorii suprapuse induc în eroare sistemele AI | Concurenții primesc credit pentru capabilitățile tale sau brandul e omis complet |

| Semnale primare lipsă | Lipsa datelor structurate, a paginilor Despre clare sau a unei terminologii consecvente | AI este forțat să deducă informații, ducând la descrieri vagi sau incorecte |

Când un brand este descris diferit pe diverse platforme, sistemele AI au dificultăți în a determina care versiune este autoritativă. În loc să ceară clarificări, ele deduc consensul pe baza frecvenței și a autorității percepute—chiar și când acel consens este greșit. Diferențele mici în denumiri, descrieri sau poziționare ale brandului sunt adesea duplicate pe platforme, iar odată repetate, aceste fragmente devin semnale pe care modelele AI le tratează ca fiind de încredere. Problema se accentuează când pagini vechi, dar cu autoritate ridicată, conțin informații incorecte; sistemele AI preferă adesea aceste surse vechi în detrimentul corecțiilor noi, mai ales dacă acestea din urmă nu s-au răspândit suficient pe platforme de încredere.

Corectarea informațiilor incorecte despre brand în sistemele AI necesită o abordare fundamental diferită față de curățenia SEO tradițională. În SEO, brandurile își actualizează propriile listări, corectează datele NAP (Nume, Adresă, Telefon) și optimizează conținutul. Corectarea brandului pentru AI se concentrează pe schimbarea a ceea ce spun sursele de încredere despre brandul tău, nu pe controlul vizibilității proprii. Nu corectezi AI direct—corectezi ceea ce AI consideră de încredere. Să „corectezi” răspunsurile AI repetând afirmațiile greșite (chiar și pentru a le nega) poate avea efectul opus, întărind asocierea pe care încerci să o elimini. Sistemele AI recunosc modele, nu intenții. Asta înseamnă că fiecare corecție trebuie să înceapă la nivel de sursă, pornind de la locul din care AI învață efectiv informația.

Înainte să poți corecta informațiile incorecte despre brand, ai nevoie de vizibilitate asupra modului în care sistemele AI descriu brandul tău. Monitorizarea eficientă se concentrează pe:

Verificările manuale singure nu sunt de încredere, deoarece răspunsurile AI variază în funcție de prompt, context și ciclul de actualizare. Instrumentele de monitorizare structurată oferă vizibilitatea necesară pentru a detecta erorile din timp, înainte ca acestea să se consolideze în sistemele AI. Multe branduri nu realizează că sunt prezentate greșit în AI până când un client semnalează problema sau apare o criză. Monitorizarea proactivă previne acest lucru, prin identificarea inconsistențelor înainte să se răspândească.

Odată ce ai identificat informații incorecte despre brand, remedierea trebuie făcută acolo unde sistemele AI învață efectiv—not unde apare doar eroarea. Corecțiile eficiente la nivel de sursă includ:

Principiul cheie este: corecțiile funcționează doar dacă sunt aplicate la nivel de sursă. Să modifici doar ceea ce apare în răspunsurile AI fără a remedia sursele subiacente este, cel mult, o soluție temporară. Sistemele AI re-evaluează constant semnalele pe măsură ce apar conținuturi noi și paginile vechi reapar. O corecție care nu abordează sursa inițială va fi, în cele din urmă, suprascrisă de dezinformarea originală.

Când corectezi informații inexacte despre brand pe directoare, marketplace-uri sau platforme alimentate de AI, majoritatea sistemelor solicită verificare care să lege brandul de deținerea și utilizarea legitimă. Documentația solicitată frecvent include:

Scopul nu este volumul—ci consistența. Platformele evaluează dacă documentația, listările și datele publice despre brand sunt aliniate. Să ai aceste materiale organizate în avans reduce ciclurile de respingere și accelerează aprobarea când corectezi informații greșite la scară. Consistența între surse semnalează sistemelor AI că informațiile despre brandul tău sunt de încredere și autoritare.

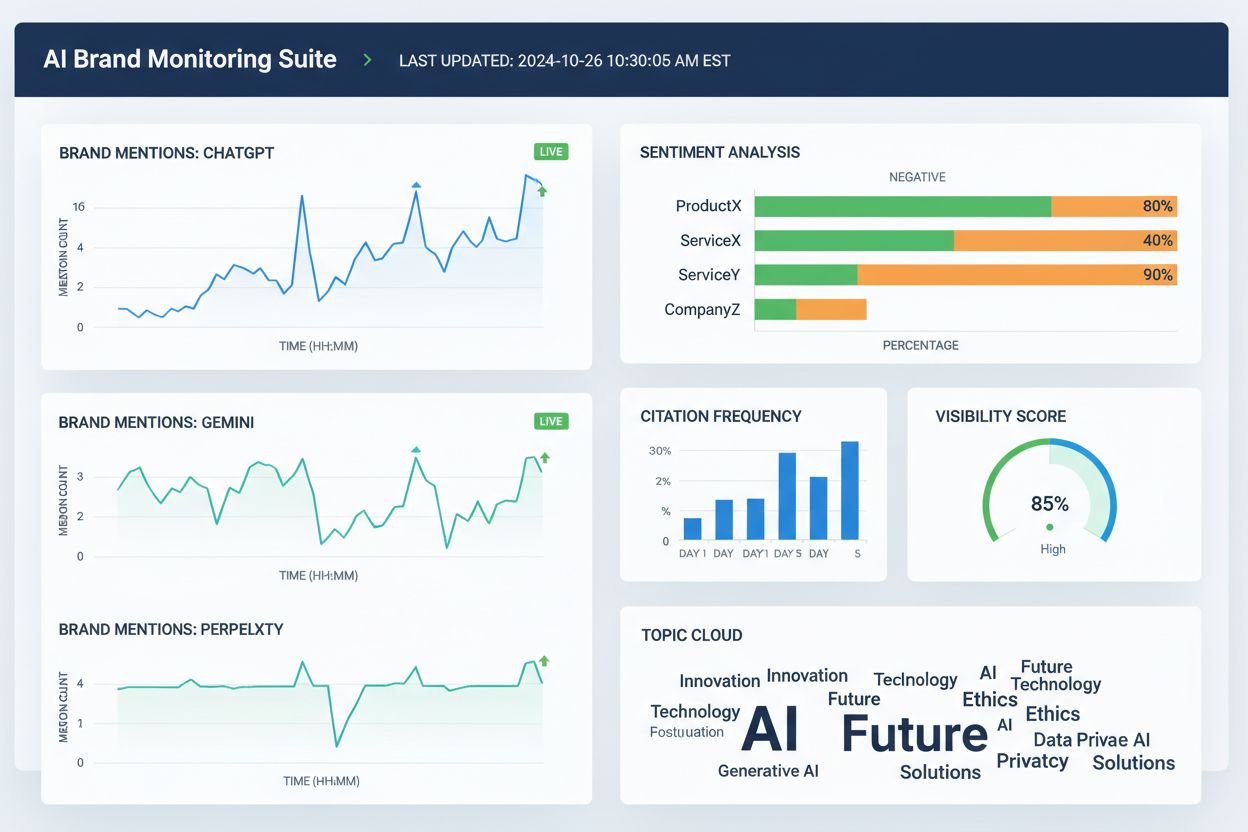

Mai multe instrumente ajută în prezent echipele să urmărească reprezentarea brandului pe platformele de căutare AI și pe web-ul mai larg. Deși capabilitățile se suprapun, ele se concentrează, în general, pe vizibilitate, atribuire și consistență:

Aceste instrumente nu corectează direct informațiile incorecte despre brand. În schimb, ele ajută echipele să detecteze devreme erorile, să identifice discrepanțele din datele despre brand înainte ca acestea să se răspândească, să valideze dacă remediile la nivel de sursă îmbunătățesc acuratețea în AI și să monitorizeze tendințele pe termen lung privind atribuirea și vizibilitatea în AI. Folosite împreună cu corecțiile la sursă și documentarea, instrumentele de monitorizare oferă bucla de feedback necesară pentru a corecta sustenabil informațiile greșite despre brand.

Acuratețea căutării AI se îmbunătățește când brandurile sunt entități clar definite, nu participanți vagi într-o categorie. Pentru a reduce reprezentarea greșită a brandului în sistemele AI, concentrează-te pe:

Obiectivul nu este să spui mai mult—ci să spui același lucru peste tot. Când sistemele AI întâlnesc definiții consistente ale brandului în surse autoritative, ele încetează să mai ghicească și încep să repete informația corectă. Acest pas e deosebit de important pentru brandurile care se confruntă cu mențiuni incorecte, atribuiri către concurenți sau omisiuni din răspunsurile AI relevante. Chiar și după ce corectezi informațiile greșite, acuratețea nu este permanentă. Sistemele AI re-evaluează constant semnalele, ceea ce face esențială claritatea continuă.

Nu există un calendar fix pentru corectarea reprezentării greșite a brandului în sistemele AI. Modelele AI se actualizează pe baza puterii semnalului și a consensului, nu a datelor de trimitere. Modelele tipice includ:

Progresul timpuriu rar se manifestă ca un răspuns brusc „corectat”. În schimb, urmărește semnalele indirecte: variabilitate redusă în răspunsurile AI, mai puține descrieri contradictorii, citări mai consistente între surse și includerea treptată a brandului tău acolo unde anterior lipsea. Stagnarea arată diferit—dacă aceeași formulare greșită persistă în ciuda corecțiilor multiple, de obicei indică faptul că sursa inițială nu a fost corectată sau că e nevoie de o întărire mai puternică în alte părți.

Cea mai sigură metodă de a corecta informațiile greșite despre brand este să reduci condițiile care permit apariția lor de la bun început. Prevenția eficientă include:

Brandurile care tratează vizibilitatea în AI ca pe un sistem viu—nu ca pe un proiect unic de curățenie—își revin mai repede după erori și întâmpină mai rar cazuri de reprezentare greșită repetată. Prevenția nu înseamnă controlul răspunsurilor AI. Înseamnă menținerea unor inputuri curate și consistente pe care sistemele AI le pot repeta cu încredere. Pe măsură ce căutarea AI evoluează, brandurile care reușesc sunt cele care recunosc că remedierea dezinformării este un proces continuu ce necesită monitorizare constantă, gestionarea surselor și întărirea strategică a informațiilor corecte pe platforme de încredere.

Corectarea dezinformării AI este procesul de identificare și remediere a informațiilor incorecte, învechite sau înșelătoare despre branduri care apar în răspunsurile generate de AI. Spre deosebire de verificarea tradițională a faptelor, accentul se pune pe corectarea surselor în care AI are încredere (directoare, articole, liste), nu pe editarea directă a răspunsurilor AI. Scopul este ca atunci când utilizatorii întreabă AI despre brandul tău, să primească informații corecte.

Sistemele AI precum ChatGPT, Gemini și Perplexity influențează acum modul în care milioane de oameni află despre branduri. Cercetările arată că 45% dintre interogările AI produc erori, iar informațiile incorecte despre brand pot afecta reputația, pot deruta clienții și pot duce la pierderea afacerilor. Spre deosebire de căutarea tradițională, unde brandurile își controlează propriile liste, sistemele AI sintetizează informații din mai multe surse, făcând mai greu de controlat acuratețea brandului, dar și mai important de gestionat.

Nu, corectarea directă nu funcționează eficient. Sistemele AI nu stochează fapte despre brand în locații editabile – ele sintetizează răspunsuri din surse externe. Să ceri în mod repetat AI să „corecteze” informațiile poate chiar întări halucinațiile, întărind asocierea pe care încerci să o elimini. Corecțiile trebuie aplicate la nivel de sursă: actualizarea directoarelor, remedierea listărilor învechite și publicarea informațiilor corecte pe platforme de încredere.

Nu există un termen fix deoarece sistemele AI se actualizează pe baza puterii semnalului și a consensului, nu a datelor de trimitere. Corecțiile minore apar, de obicei, în 2-4 săptămâni, clarificările la nivel de entitate necesită 1-3 luni, iar recâștigarea poziției în fața concurenței poate dura 3-6 luni sau mai mult. Progresul rar apare ca un răspuns brusc „corectat” - în schimb, urmărește variabilitatea redusă în răspunsuri și citări mai consistente în surse.

Mai multe instrumente urmăresc acum reprezentarea brandului pe platforme AI: Wellows monitorizează mențiuni și sentiment în ChatGPT, Gemini și Perplexity; Profound compară vizibilitatea în LLM-uri; Otterly.ai analizează sentimentul brandului în răspunsurile AI; BrandBeacon oferă analize de poziționare; Ahrefs Brand Radar urmărește mențiunile online; iar AmICited.com este specializat în monitorizarea modului în care brandurile sunt citate și prezentate în sistemele AI. Aceste instrumente ajută la detectarea timpurie a erorilor și la validarea eficienței corecțiilor.

Halucinațiile AI apar atunci când sistemele AI generează informații care nu se bazează pe datele de antrenament sau sunt decodate incorect. Dezinformarea AI este informație falsă sau înșelătoare care apare în răspunsurile AI, putând rezulta din halucinații, dar și din surse învechite, confuzie între entități sau date inconsistente între platforme. Corectarea dezinformării vizează atât halucinațiile, cât și inexactitățile la nivel de sursă care duc la reprezentarea greșită a brandului.

Monitorizează modul în care sistemele AI descriu brandul tău, întrebându-le despre companie, produse și poziționare. Identifică informații învechite, descrieri greșite, detalii lipsă sau atribuirea către concurenți. Folosește instrumente de monitorizare pentru a urmări mențiunile în ChatGPT, Gemini și Perplexity. Verifică dacă brandul tău lipsește din răspunsurile relevante ale AI. Compară descrierile AI cu informațiile oficiale ale brandului pentru a identifica discrepanțele.

Este un proces continuu. Sistemele AI re-evaluează constant semnalele pe măsură ce apar conținuturi noi și paginile vechi reapar. O corecție unică, fără monitorizare continuă, va fi în cele din urmă suprascrisă de dezinformarea inițială. Brandurile care reușesc tratează vizibilitatea AI ca pe un sistem viu, menținând definiții consistente ale brandului în surse, auditând regulat directoarele și monitorizând constant mențiunile AI pentru a surprinde noi erori înainte să se răspândească.

Urmărește modul în care sistemele AI precum ChatGPT, Gemini și Perplexity prezintă brandul tău. Obține informații în timp real despre mențiuni, citări și vizibilitate a brandului pe platforme AI cu AmICited.com.

Află cum să contești informațiile inexacte generate de AI, să raportezi erorile către ChatGPT și Perplexity și să implementezi strategii pentru ca brandul tău s...

Învață metode eficiente pentru a identifica, verifica și corecta informațiile inexacte generate de AI, precum ChatGPT, Perplexity și alte sisteme de inteligență...

Discuție în comunitate despre cum răspunzi la mențiuni incorecte AI și dezinformare. Experiențe reale privind corectarea erorilor factuale în ChatGPT, Perplexit...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.