Cum să folosești prompt engineering pentru optimizarea motoarelor generative

Află cum prompt engineering îmbunătățește strategia GEO pentru ca brandul tău să fie citat de motoarele AI de căutare precum ChatGPT, Perplexity și Google AI Ov...

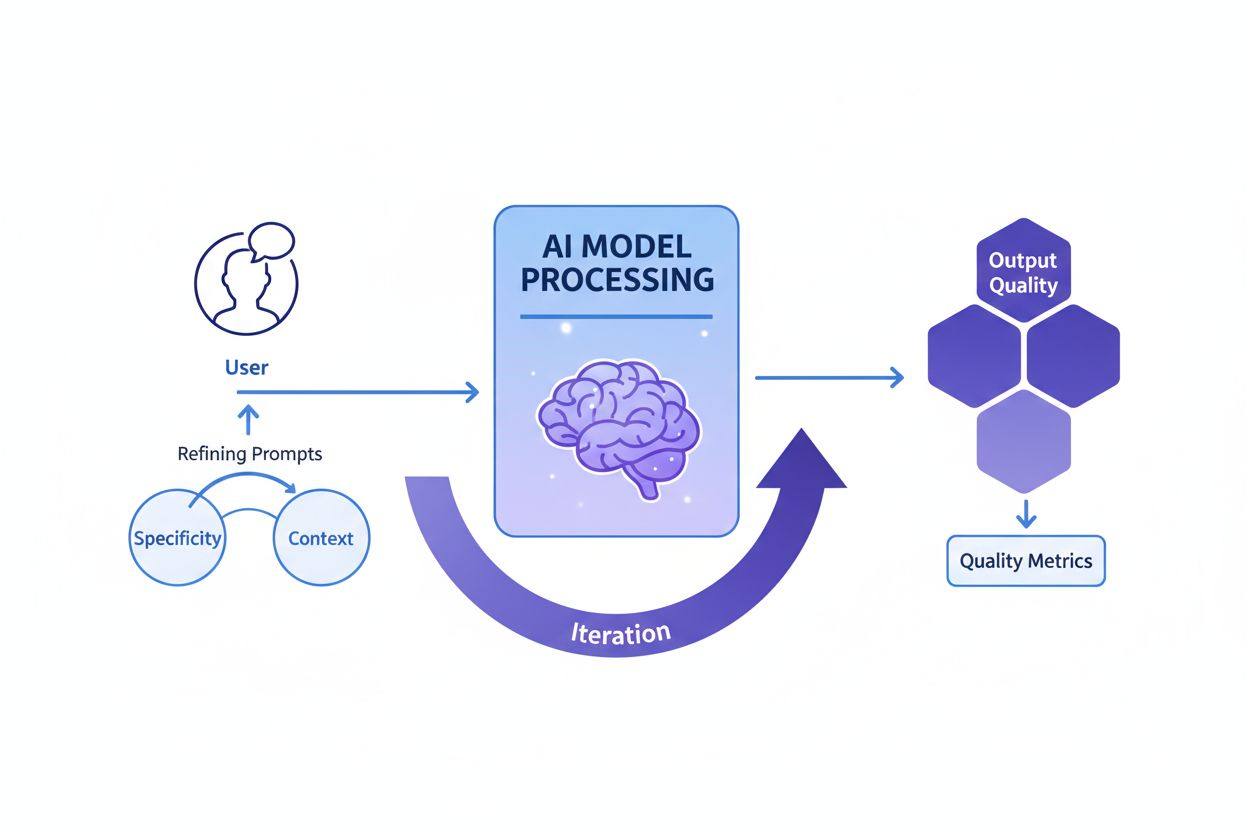

Ingineria prompturilor este procesul de creare, rafinare și optimizare a instrucțiunilor în limbaj natural pentru a ghida modelele generative AI spre producerea unor rezultate dorite, precise și relevante. Acesta implică experimentare iterativă cu formularea, contextul și structura, pentru a maximiza performanța AI fără modificarea modelului de bază.

Ingineria prompturilor este procesul de creare, rafinare și optimizare a instrucțiunilor în limbaj natural pentru a ghida modelele generative AI spre producerea unor rezultate dorite, precise și relevante. Acesta implică experimentare iterativă cu formularea, contextul și structura, pentru a maximiza performanța AI fără modificarea modelului de bază.

Prompt engineering este procesul sistematic de proiectare, rafinare și optimizare a instrucțiunilor în limbaj natural — numite prompturi — pentru a ghida modelele generative AI către producerea de rezultate dorite, precise și relevante contextual. În loc să modifice modelul AI de bază, inginerii de prompturi lucrează cu capabilitățile existente ale modelului, structurând cu atenție inputul lor pentru a influența modul în care modelul procesează informația și generează răspunsuri. Această disciplină a apărut ca o abilitate critică în timpul boom-ului AI generativ din 2023-2025, când organizațiile au realizat că accesul la instrumente AI puternice precum ChatGPT, Claude, Perplexity și Google AI nu era suficient fără expertiză în comunicarea eficientă cu aceste sisteme. Prompt engineering face legătura între intenția umană și capabilitatea AI, transformând obiectivele de business vagi în rezultate AI acționabile și de calitate. Practica este în mod fundamental iterativă, necesitând experimentare continuă, testare și rafinare pentru a obține rezultate optime pentru cazuri de utilizare specifice.

Conceptul de prompt engineering a apărut organic după lansarea publică a ChatGPT în noiembrie 2022, când milioane de utilizatori au început să experimenteze cu modul de a obține rezultate mai bune de la modelele mari de limbaj. Primii utilizatori au descoperit că calitatea rezultatelor AI varia dramatic în funcție de formularea întrebărilor, contextul oferit și specificitatea instrucțiunilor. Această observație a dus la formalizarea prompt engineering ca disciplină distinctă. Până în 2023, mari companii de tehnologie precum OpenAI, Google, Microsoft și Anthropic au început să angajeze ingineri de prompt dedicați, unele poziții depășind salarii de 300.000 USD. Piața globală de prompt engineering era evaluată la aproximativ 222,1 milioane USD în 2023 și se estimează că va ajunge la 2,06 miliarde USD până în 2030, reprezentând o rată de creștere anuală compusă (CAGR) semnificativă. Această creștere rapidă reflectă recunoașterea tot mai mare că prompt engineering nu este o tendință temporară, ci o abilitate fundamentală pentru organizațiile care valorifică AI la scară. Disciplina a evoluat de la experimentare simplă de tip încercare-eroare la o practică sofisticată care integrează tehnici consacrate, cadre de evaluare și bune practici documentate de principalele instituții de cercetare AI și practicieni din industrie.

Prompt engineering eficient se bazează pe mai multe principii fundamentale care diferențiază prompturile de calitate de cele ineficiente. Specificitatea este esențială — cu cât un prompt este mai detaliat și descriptiv, cu atât modelul AI poate înțelege mai bine cerințele exacte și poate genera rezultate aliniate. În loc să ceri unui AI să „scrie despre câini”, un prompt specific ar putea solicita „crează un ghid veterinar de 300 de cuvinte despre problemele de sănătate la golden retriever, destinat proprietarilor de animale cu nivel de lectură clasa a VIII-a, concentrat pe prevenție”. Furnizarea de context este la fel de importantă; oferirea de informații relevante, exemple sau constrângeri ajută modelul să își restrângă focalizarea și să producă răspunsuri mai relevante. Claritatea asigură că instrucțiunile sunt neambigue și comunică direct sarcina dorită fără a cere modelului să interpreteze limbaj vag. Rafinarea iterativă recunoaște că primul prompt rareori produce rezultate optime; inginerii de prompturi de succes testează continuu variații, analizează rezultatele și își ajustează abordarea pe baza acestora. Alinierea tonului și stilului presupune specificarea vocii dorite, nivelului de formalitate și formatului de prezentare pentru a asigura rezultate conforme cu așteptările organizaționale sau ale utilizatorului. Aceste principii se aplică pe toate platformele AI, fie că utilizatorii creează prompturi pentru ChatGPT, Perplexity, Claude sau Google AI Overviews, ceea ce le face universal valoroase pentru oricine dorește să optimizeze interacțiunile cu AI.

Domeniul prompt engineering a dezvoltat numeroase tehnici sofisticate pentru a aborda diferite tipuri de sarcini și niveluri de complexitate. Zero-shot prompting este cea mai directă abordare, oferind AI-ului o instrucțiune sau întrebare clară, fără exemple sau context suplimentar. Această metodă funcționează bine pentru sarcini simple, dar poate avea dificultăți cu raționamentul complex. Few-shot prompting îmbunătățește performanța furnizând modelului unul sau mai multe exemple care demonstrează formatul sau modelul de raționament dorit, practic învățând modelul prin demonstrație. Chain-of-thought (CoT) prompting descompune problemele complexe în pași intermediari de raționament, încurajând modelul să arate pașii și îmbunătățind acuratețea pentru probleme multi-etapă. Prompt chaining împarte o sarcină complexă în subtasks secvențiale, folosind outputul unui prompt ca input pentru următorul, ceea ce crește fiabilitatea și consistența pentru fluxuri de lucru complicate. Tree-of-thought prompting generalizează chain-of-thought explorând simultan mai multe căi de raționament posibile, permițând modelului să evalueze diferite abordări înainte de a selecta cea mai promițătoare. Maieutic prompting implică solicitarea modelului să explice raționamentul, apoi adresarea de întrebări suplimentare pentru a detalia anumite părți, ceea ce ajută la identificarea și corectarea inconsistențelor. Generated knowledge prompting instruiește modelul să genereze mai întâi fapte sau informații relevante înainte de a aborda sarcina principală, condiționând modelul cu context util. Self-refine prompting presupune ca modelul să rezolve o problemă, să-și critice propria soluție și apoi să revizuiască pe baza criticii, repetând până la obținerea unui rezultat satisfăcător. Fiecare tehnică servește scopuri specifice, iar cel mai eficient prompt engineering combină strategic mai multe tehnici adaptate sarcinii.

| Tehnică | Cel mai potrivit pentru | Complexitate | Caz tipic de utilizare | Eficiență |

|---|---|---|---|---|

| Zero-shot Prompting | Sarcini simple, directe | Scăzută | Întrebări de bază, instrucțiuni simple | Bun pentru sarcini simple, limitat pentru raționament complex |

| Few-shot Prompting | Sarcini care cer consistență de format | Medie | Generare conținut, clasificare, formatare | Excelent pentru a demonstra modele de output dorite |

| Chain-of-Thought | Probleme de raționament multi-pas | Mediu-Ridicată | Probleme matematice, deducție logică, analiză | Îmbunătățește semnificativ acuratețea la sarcini complexe |

| Prompt Chaining | Fluxuri complexe cu dependențe | Ridicată | Creare conținut multi-etapă, procesare date | Excelent pentru descompunerea problemelor complexe |

| Tree-of-Thought | Probleme cu mai multe căi de soluționare | Ridicată | Planificare strategică, rezolvare creativă | Superior pentru explorarea alternativelor |

| Generated Knowledge | Sarcini ce necesită context | Medie | Întrebări de domeniu, explicații tehnice | Îmbunătățește relevanța și acuratețea prin context |

| Self-Refine | Aplicații critice calitativ | Ridicată | Scriere profesională, documentație tehnică | Produce rezultate de cea mai înaltă calitate prin iterații |

Pentru a înțelege cum influențează prompturile comportamentul modelelor AI este necesară o cunoaștere de bază a modului în care funcționează modelele mari de limbaj (LLM). Aceste modele procesează textul împărțindu-l în tokeni (unități mici de text), apoi prezic tokenul următor cel mai probabil pe baza tiparelor învățate în timpul antrenării. Promptul servește ca context inițial care modelează toate predicțiile ulterioare. Când un prompt include instrucțiuni specifice, exemple sau constrângeri, acesta restrânge distribuția de probabilitate a posibilelor rezultate, ghidând modelul către răspunsuri aliniate intenției promptului. Parametrii temperature și top-p sampling influențează suplimentar variabilitatea outputului — temperaturi scăzute produc răspunsuri mai deterministe și focalizate, în timp ce temperaturile ridicate cresc creativitatea și diversitatea. Fereastra de context (cantitatea de text pe care modelul o poate considera) limitează cât de multă informație poate fi inclusă într-un prompt; prompturile lungi consumă mai mult din această fereastră, reducând spațiul pentru sarcina propriu-zisă. Inginerii de prompt eficienți înțeleg aceste constrângeri tehnice și proiectează prompturi care să funcționeze în interiorul acestor limite. Pentru organizațiile care monitorizează vizibilitatea brandului pe platforme AI cu instrumente precum AmICited, înțelegerea acestor mecanisme este crucială, deoarece prompturile introduse de utilizatori determină ce informație recuperează și citează sistemele AI. Un prompt bine conceput care cere AI-ului să „listeze primele trei companii în cloud computing” va produce rezultate diferite față de „listează companii inovatoare de cloud computing fondate după 2015”, influențând ce branduri primesc vizibilitate în răspunsurile generate de AI.

Implementarea prompt engineering eficient în mediile organizaționale necesită urmarea unor bune practici stabilite atât din cercetarea academică, cât și din experiența din industrie. Începe simplu și iterează este principiul de bază — începe cu un prompt de bază și adaugă treptat complexitate, testând la fiecare etapă pentru a înțelege ce schimbări îmbunătățesc rezultatele. Fii explicit cu cerințele prin enunțarea clară a formatului dorit al rezultatului, lungimea, tonul și orice constrângeri; prompturile vagi produc rezultate vagi. Furnizează context relevant fără a supraîncărca modelul; include informații care ajută modelul să înțeleagă sarcina, dar evită detaliile inutile care consumă spațiul din fereastra de context. Folosește separatori clari precum “###” sau “—” pentru a delimita secțiuni diferite într-un prompt (instrucțiuni, context, exemple), facilitând modelului înțelegerea structurii. Evită negațiile prin formularea a ceea ce dorești, nu a ceea ce nu dorești; în loc de „nu fi prea formal”, specifică „folosește un ton conversațional”. Testează mai multe variații în mod sistematic, schimbând câte un element pe rând pentru a înțelege ce aduce rezultate mai bune. Documentează prompturile de succes într-un depozit centralizat, creând o bibliotecă de template-uri testate pe care echipele le pot reutiliza și adapta. Monitorizează metrici de performanță precum acuratețea, relevanța, consistența și satisfacția utilizatorului pentru a evalua obiectiv dacă prompturile ating scopul propus. Incorporează bucle de feedback în care feedback-ul utilizatorilor informează direct rafinarea prompturilor, creând un ciclu de îmbunătățire continuă. Organizațiile care implementează aceste practici raportează îmbunătățiri semnificative ale calității și consistenței outputului AI, reducând timpul alocat corectărilor și reviziilor manuale.

Relația dintre prompt engineering și monitorizarea vizibilității AI este tot mai importantă pentru organizațiile care doresc să înțeleagă cum apar brandurile, produsele și conținutul lor în răspunsurile generate de AI. Platforme precum AmICited urmăresc mențiunile brandului pe ChatGPT, Perplexity, Google AI Overviews și Claude, însă prompturile introduse în aceste sisteme determină direct ce informații recuperează și citează AI-ul. Organizațiile care înțeleg prompt engineering pot crea interogări strategice pentru a descoperi cum este reprezentat brandul lor, ce competitori sunt menționați alături de el și dacă conținutul lor este citat corect. De exemplu, o companie poate concepe prompturi de tipul „Care sunt cele mai bune soluții pentru managementul datelor enterprise?” pentru a vedea cum sistemele AI poziționează ofertele lor în raport cu competitorii. Analizând prompturile care generează mențiuni favorabile sau nefavorabile ale brandului, organizațiile pot dezvolta strategii de conținut care să îmbunătățească vizibilitatea în răspunsurile AI. Aceasta reprezintă o nouă frontieră în optimizarea pentru motoarele de căutare (SEO) și managementul brandului, unde modul de comunicare cu sistemele AI devine la fel de important ca optimizarea tradițională pe cuvinte cheie. Companiile care investesc în expertiza de prompt engineering obțin avantaje strategice în peisajul informațional condus de AI, asigurându-se că brandurile lor primesc vizibilitatea și reprezentarea corectă.

Măsurarea eficacității unui prompt necesită definirea unor criterii clare și obiective aliniate cu obiectivele specifice de business. Acuratețea măsoară dacă rezultatele sunt corecte din punct de vedere factual, esențială pentru domenii precum sănătatea, finanțele și serviciile juridice unde erorile pot avea consecințe majore. Relevanța evaluează cât de bine se aliniază rezultatul cu intenția utilizatorului, adesea măsurată prin scoruri de similaritate semantică sau evaluare manuală. Consistența verifică dacă prompturile identice produc răspunsuri similare la rulări multiple, critică pentru aplicații ce necesită comportament previzibil. Completitudinea determină dacă răspunsurile acoperă toate elementele sau informațiile cerute, măsurată ca raport între componentele acoperite și totalul cerut. Specificitatea evaluează nivelul de detaliu din răspunsuri, importantă pentru documentație tehnică și domenii specializate. Lizibilitatea și coerența măsoară claritatea și logica, evaluate prin formule de lizibilitate sau evaluare umană. Satisfacția utilizatorului reflectă cât de mulțumit este utilizatorul final de rezultate, adesea obținută prin sondaje sau feedback încorporat. Organizațiile care implementează cadre de evaluare cuprinzătoare raportează îmbunătățiri de 40-60% în eficacitatea prompturilor prin măsurare și rafinare sistematică. Instrumente precum Portkey, DSPy și Evaluate Library de la Hugging Face oferă metrici automate pentru aceste dimensiuni, iar platformele de A/B testing permit comparația directă a variantelor de prompt. Cele mai sofisticate organizații combină metode de evaluare, ponderând metricile conform priorităților lor pentru a obține un scor global de calitate a promptului.

Piața muncii pentru prompt engineering a cunoscut o creștere explozivă, reflectând importanța critică a acestei abilități în era AI. În 2025, Glassdoor raportează un salariu mediu de bază de aproximativ 123.274 USD anual pentru prompt engineer, cu poziții între 90.000 USD (percentila 25) și peste 335.000 USD pentru roluri specializate la companii AI de top precum Anthropic. Indeed listează peste 110.000 de poziții de prompt engineer deschise, indicând o cerere susținută în toate industriile. Marile companii tech precum Google, Microsoft, Amazon și Meta recrutează activ prompt engineer cu salarii între 110.000 și 250.000 USD. Companiile axate pe AI precum OpenAI, Anthropic, Cohere și Midjourney oferă provocări de vârf cu culturi remote-first și pachete semnificative de acțiuni. Organizațiile enterprise din finanțe, sănătate, asigurări și alte sectoare reglementate angajează prompt engineer pentru integrare AI, deseori sub titluri precum „AI Solutions Architect”. Consultanțele inclusiv Big Four și firme specializate ca Booz Allen Hamilton oferă poziții până la 212.000 USD pentru proiecte guvernamentale și enterprise. Oportunitățile freelance pe platforme precum Upwork și Toptal ajung la 100-300 USD/oră pentru profesioniști cu experiență. Drumul în carieră implică de obicei o diplomă de licență în informatică sau domenii înrudite, însă profesioniști din arii diverse precum scriere, jurnalism și domenii creative au făcut cu succes tranziția spre prompt engineering. Cel mai important, succesul în acest domeniu depinde de abilități demonstrabile cu instrumente AI, un portofoliu care să evidențieze abilități de prompt engineering și învățare continuă pe măsură ce domeniul evoluează.

Prompt engineering este pregătit pentru o evoluție semnificativă odată cu avansarea tehnologiei AI și maturizarea practicilor organizaționale. Prompting-ul multimodal va combina din ce în ce mai mult text, cod, imagini și alte tipuri de date în același prompt, necesitând ca inginerii să înțeleagă interacțiunea între modalități în sistemele AI. Prompturile adaptive care se ajustează automat în funcție de context, comportamentul utilizatorului și feedback în timp real vor deveni mai sofisticate, trecând de la template-uri statice la sisteme dinamice și responsive. Context engineering apare ca o evoluție a prompt engineering, punând accent pe contextul general în care operează prompturile, nu doar pe textul promptului. Prompting-ul axat pe etică și echitate va câștiga importanță pe măsură ce organizațiile prioritizează AI responsabil, cu prompturi proiectate explicit pentru a reduce bias-ul, a asigura transparența și a se alinia cu cerințele de reglementare. Integrarea cu agenți AI va estompa linia dintre prompt engineering și orchestrarea AI la scară largă, prompturile devenind componente ale unor sisteme autonome complexe. Rolul de „prompt engineer” se poate evolua sau contopi cu roluri adiacente precum „AI strategist”, „context engineer” sau „AI product manager”, reflectând maturizarea domeniului. Organizațiile care investesc astăzi în expertiză de prompt engineering vor fi bine poziționate să conducă în economia condusă de AI, pe măsură ce abilitatea de a comunica eficient cu și de a ghida sistemele AI devine tot mai centrală pentru avantajul competitiv. Pentru companiile care folosesc AmICited pentru monitorizarea vizibilității brandului în răspunsurile AI, cunoștințele de prompt engineering vor deveni esențiale pentru optimizarea prezenței în căutările AI și asigurarea reprezentării corecte pe platforme precum ChatGPT, Perplexity, Google AI și Claude.

Prompt engineering diferă fundamental de programarea tradițională: în loc să scrii cod explicit care controlează direct comportamentul, inginerii de prompturi ghidează modelele AI prin instrucțiuni în limbaj natural. Programarea tradițională necesită o sintaxă și o logică precisă, în timp ce prompt engineering se bazează pe rafinament iterativ, furnizarea de context și formulări strategice pentru a orienta rezultatele AI către obiectivele dorite. Ambele cer abilități de rezolvare a problemelor, dar prompt engineering pune accent pe comunicare și experimentare, nu pe sintaxă strictă de cod.

Prompt engineering influențează direct modul în care brandurile apar în răspunsurile generate de AI pe platforme precum ChatGPT, Perplexity, Google AI Overviews și Claude. Prompturile bine concepute pot influența dacă și cum sistemele AI citează, menționează sau recomandă brandurile. Pentru organizațiile care folosesc instrumente precum AmICited pentru a monitoriza vizibilitatea în AI, înțelegerea prompt engineering ajută la prezicerea și optimizarea modului în care brandul lor apare în răspunsurile AI, asigurând o reprezentare corectă și o poziționare competitivă în peisajul căutărilor AI.

Tehnicile cheie includ chain-of-thought prompting (împărțirea problemelor complexe în pași), few-shot prompting (oferirea de exemple), zero-shot prompting (instrucțiuni directe), prompt chaining (împărțirea sarcinilor în subtasks), și tree-of-thought prompting (explorarea mai multor căi de raționament). Eficiența fiecărei tehnici depinde de complexitatea sarcinii, capabilitățile modelului și tipul de rezultat dorit. Cele mai de succes implementări combină mai multe tehnici adaptate cazului specific de utilizare.

Eficacitatea promptului este măsurată cu ajutorul unor metrici precum acuratețea (corectitudinea faptică), relevanța (alinierea cu intenția), consistența (reproducibilitatea), completitudinea (acoperirea elementelor cerute) și satisfacția utilizatorului. Metodele de evaluare includ revizuirea manuală, evaluarea automată cu instrumente precum scorurile BLEU și ROUGE, testarea A/B a variantelor de prompt și colectarea feedback-ului direct de la utilizatori. Organizațiile combină adesea mai multe metrici într-un scor ponderat care reflectă prioritățile lor.

Prompt engineerii au nevoie de abilități puternice de comunicare și scriere, înțelegerea modului în care funcționează modelele mari de limbaj, familiaritate cu concepte AI precum tokenizarea și ferestrele de context și abilități creative de rezolvare a problemelor. Cunoștințele tehnice în Python, SQL sau JavaScript sunt adesea preferate, dar nu întotdeauna obligatorii. Expertiza de domeniu în industrii specifice (sănătate, finanțe, juridic) aduce o compensare premium. Cel mai important, prompt engineerii de succes demonstrează învățare și experimentare continuă.

Prompt engineering este esențial pentru monitorizarea AI deoarece prompturile introduse de utilizatori în sistemele AI determină ce informații recuperează și citează aceste sisteme. Prin înțelegerea prompt engineering, organizațiile pot crea interogări care să le ajute să descopere cum apare brandul, conținutul sau domeniul lor în răspunsurile AI. AmICited urmărește aceste apariții pe multiple platforme AI, făcând cunoștințele de prompt engineering esențiale pentru optimizarea vizibilității brandului în conținutul generat de AI.

Piața muncii pentru prompt engineering rămâne robustă, cu salarii medii de aproximativ 123.274 USD anual conform Glassdoor, cu poziții ce variază între 90.000 și peste 335.000 USD în funcție de experiență și companie. Peste 110.000 de poziții de prompt engineer sunt în prezent deschise pe platformele de joburi. Domeniul evoluează de la un rol specializat către responsabilități mai largi de integrare AI, cu oportunități în companii tech, întreprinderi, consultanță și freelancing. Munca remote este prevalentă, reducând restricțiile geografice.

Prompt engineering se va îndrepta către prompting multimodal (combinarea textului, codului și imaginilor), prompturi adaptive care se ajustează în funcție de context și un accent crescut pe etica și echitatea AI. Pe măsură ce modelele devin mai capabile, prompt engineering se poate contopi cu roluri mai ample de strategie AI și context engineering. Domeniul va pune accent pe practici AI responsabile, reducerea bias-ului și asigurarea transparenței în conținutul generat de AI pe platforme precum cele monitorizate de AmICited.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum prompt engineering îmbunătățește strategia GEO pentru ca brandul tău să fie citat de motoarele AI de căutare precum ChatGPT, Perplexity și Google AI Ov...

Află ce este ingineria prompturilor, cum funcționează cu motoarele de căutare AI precum ChatGPT și Perplexity și descoperă tehnici esențiale pentru a-ți optimiz...

Discuție în comunitate despre dacă marketerii au nevoie de abilități de prompt engineering pentru a optimiza pentru căutarea AI. Înțelegerea modului în care uti...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.