Visuell sökning och AI: Bildoptimering för AI-upptäckt

Lär dig hur visuell sökning och AI förändrar bildupptäckt. Optimera dina bilder för Google Lens, AI-översikter och multimodala LLM:er för att öka synligheten i ...

Lär dig hur Google Lens omvandlar visuell sökning med över 100 miljarder sökningar årligen. Upptäck optimeringsstrategier för att säkerställa att ditt varumärke syns i visuella upptäcktsresultat och fånga trafik med köpintention.

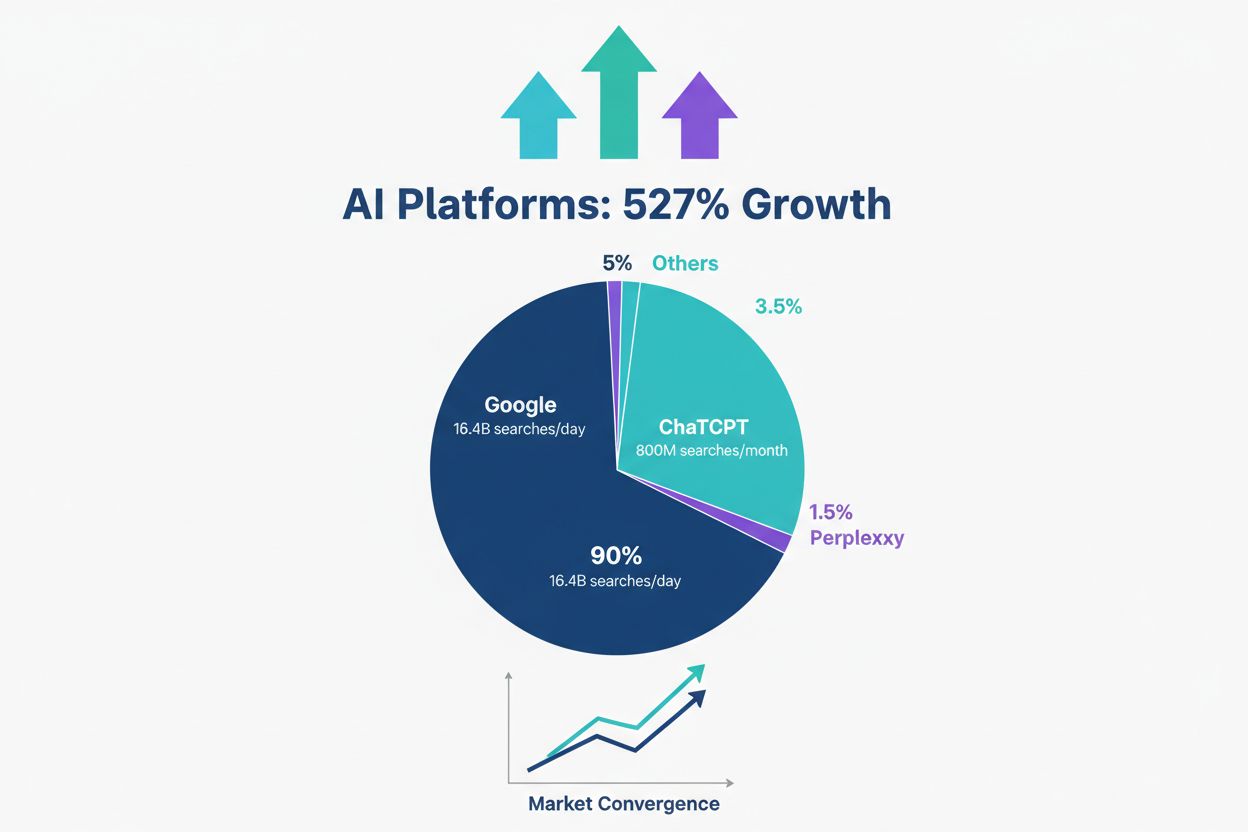

Visuell sökning har i grunden förändrat hur människor upptäcker information online och gått från textbaserade sökningar till kamera-först-interaktioner. Google Lens, företagets flaggskepp för visuell sökning, driver nu nästan 20 miljarder visuella sökningar varje månad, med över 100 miljarder visuella sökningar via Lens och Circle to Search bara under 2024. Denna explosiva tillväxt speglar ett bredare skifte i konsumentbeteende: människor föredrar i allt högre grad att rikta sin kamera mot något de vill veta mer om, istället för att skriva en beskrivning.

Plattformens räckvidd är enorm: 1,5 miljarder människor använder nu Google Lens varje månad, där yngre användare i åldern 18–24 visar de högsta engagemangsgraderna. Vad som gör detta särskilt betydelsefullt för varumärken är att en av fem av dessa visuella sökningar — cirka 20 miljarder sökningar — har direkt köpintention. Detta är inte nyfikna sökningar; det är potentiella kunder som aktivt letar efter att köpa något de sett i verkligheten.

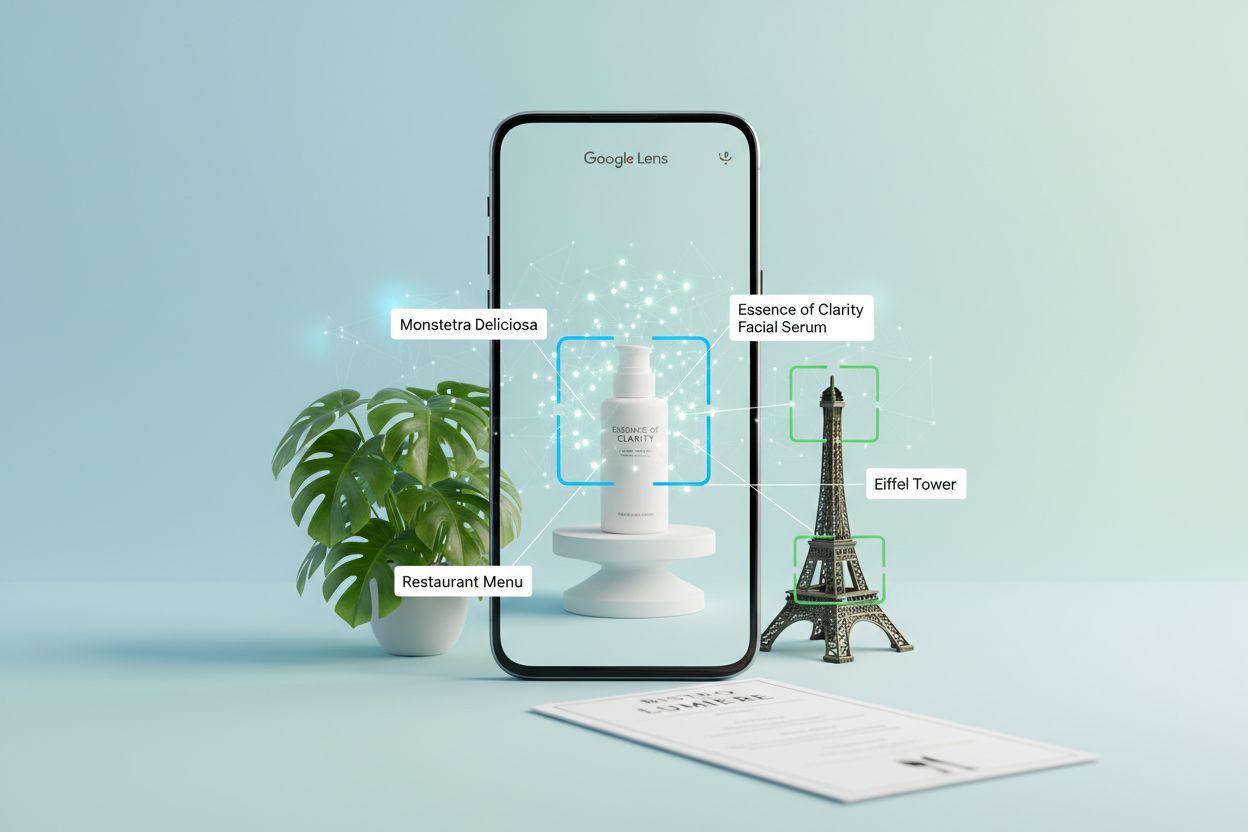

I grunden använder Google Lens tre sammankopplade AI-tekniker för att förstå och besvara visuella frågor. Konvolutionella neurala nätverk (CNN) utgör grunden och analyserar pixelmönster för att identifiera objekt, scener och visuella relationer med anmärkningsvärd precision. Dessa djupinlärningsmodeller tränas på miljarder märkta bilder, vilket gör att de kan känna igen allt från vanliga hushållsartiklar till sällsynta växtarter.

Optisk teckenigenkänning (OCR) hanterar textdetektering och extrahering, vilket gör att Lens kan läsa menyer, skyltar, dokument och handskrivna anteckningar. När du riktar kameran mot en meny på ett främmande språk eller en gattskylt omvandlar OCR den visuella texten till digital data som kan bearbetas och översättas. Naturlig språkbehandling (NLP) tolkar sedan denna text kontextuellt och förstår inte bara vilka ord som finns utan också vad de betyder i förhållande till din fråga.

Den verkliga styrkan ligger i multimodal AI – förmågan att bearbeta flera typer av input samtidigt. Du kan nu rikta kameran mot en produkt, ställa en röstfråga om den och få ett AI-drivet svar som kombinerar visuell förståelse med konverserande sammanhang. Denna integration skapar en sökupplevelse som känns naturlig och intuitiv.

| Funktion | Traditionell textsökning | Google Lens |

|---|---|---|

| Inmatningsmetod | Inskrivna nyckelord | Bild, video eller röst |

| Igenkänningsförmåga | Endast nyckelord | Objekt, text, sammanhang, relationer |

| Svarshastighet | Sekunder | Omedelbart |

| Sammanhangsförståelse | Begränsat till frågetext | Omfattande visuell kontext |

| Realtidskapacitet | Nej | Ja, med livekamera |

| Precision för visuella objekt | Låg (svårt att beskriva) | Hög (direkt visuell matchning) |

De praktiska tillämpningarna av Google Lens sträcker sig långt bortom ren nyfikenhet. Inom shopping fotograferar användare produkter de ser i butiker, på sociala medier eller i videor och hittar sedan omedelbart var de kan köpa dem och jämföra priser mellan återförsäljare. En kund ser en möbel hos en vän, tar ett foto och upptäcker exakt samma vara tillgänglig för köp – allt utan att lämna ögonblicket.

Utbildning är ett annat kraftfullt användningsområde, särskilt på tillväxtmarknader. Studenter fotograferar problem i läroböcker eller material från klassrummet på engelska och använder Lens för att översätta till sitt modersmål, samt få hjälp och förklaringar till läxorna. Detta demokratiserar tillgången till utbildningsresurser över språkbarriärer.

Resor och utforskning drar nytta av Lens för att identifiera landmärken, hitta restauranger och lära sig om kultur. Turister fotograferar okänd arkitektur eller skyltar och får omedelbart historisk kontext och information. Naturentusiaster identifierar växter, djur och insekter under utomhusaktiviteter och förvandlar tillfälliga observationer till lärande.

Produktforskning och jämförelse har blivit sömlöst. Någon ser en handväska de gillar, fotograferar den och Lens visar inte bara exakt samma produkt utan även liknande artiklar i olika prisklasser från närliggande återförsäljare. Denna förmåga har fundamentalt förändrat hur konsumenter handlar och tagit bort friktion från upptäckt till köp.

Möjligheten är enorm: 20 miljarder visuella sökningar med köpintention årligen innebär en massiv kanal som de flesta varumärken helt ignorerar. Medan konkurrenter jagar AI Overview-placering – ett trångt utrymme dominerat av stora publicister och etablerade återförsäljare – är visuell sökning fortfarande relativt outnyttjat territorium med fördelar för de som är först ute.

Varumärken som optimerar för visuell upptäckt får ett konkurrensmässigt övertag som överskrider traditionell SEO. När din produkt syns i Google Lens-resultat konkurrerar du inte på nyckelord eller innehållskvalitet; du konkurrerar på visuell relevans och kontext. En möbelåterförsäljare vars produkter dyker upp i Lens-sökningar för “nattduksbord queen bedroom” fångar kunder just när de är redo att köpa, innan de ens besökt en sökmotor.

Konverteringseffekten är djupgående. Användare av visuell sökning har redan identifierat vad de vill ha – de söker inte bara eller gör research, de köper. Denna trafik med stark intention konverterar i betydligt högre grad än traditionell söktrafik. Dessutom minskar visuell sökning friktionen före köp: kunder kan se exakt hur en produkt ser ut i sitt sammanhang, förstå dess skala i förhållande till kända objekt och fatta trygga köpbeslut.

Den konkurrensmässiga tidsfördelen är verklig. De flesta byråer och varumärken förstår fortfarande inte att visuell sökning existerar som en egen kanal. Företagen som implementerar optimering för visuell sökning nu bygger försprång och marknadsandelar medan konkurrenterna är fokuserade på gårdagens sökparadigm.

Optimering för visuell upptäckt kräver ett fundamentalt annorlunda tillvägagångssätt än traditionell bild-SEO. Här är de viktigaste strategierna:

Var och en av dessa element bidrar till hur Google Lens förstår och rankar ditt visuella innehåll. Ju mer kontext du ger, desto större chans att dina produkter visas i relevanta visuella sökningar.

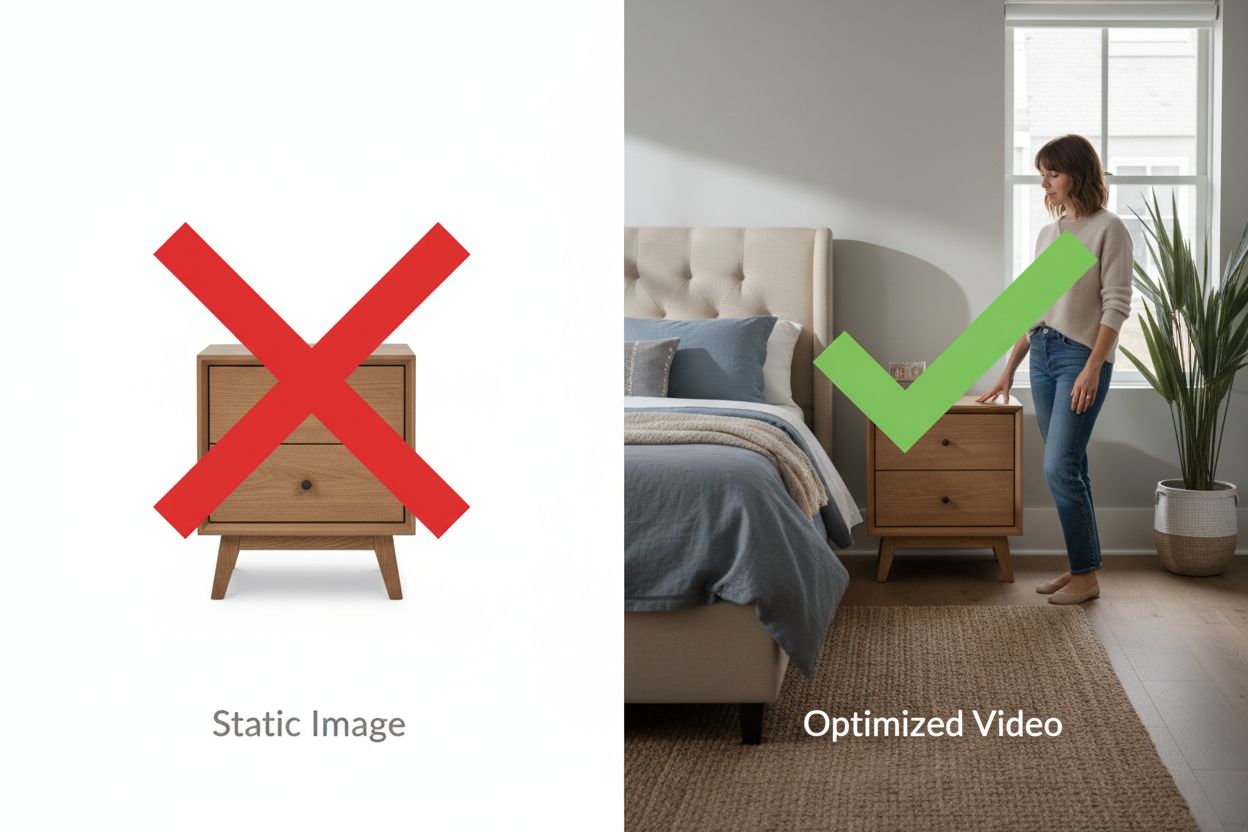

Stillbilder är grundläggande för optimering av visuell sökning; video är din konkurrensfördel. Google Lens extraherar information från videorutor, vilket innebär att en 30-sekunders produktdemonstrationsvideo kan generera dussintals upptäckbara ögonblick som stillbilder inte kan.

Video visar skala på sätt som fotografier inte kan. När du visar ett nattduksbord placerat bredvid en queen size-säng med en person stående intill kan Lens dra slutsatser om exakta mått genom rumsliga relationer. När du visar en produkt i användning – en vattentät väska som klarar regn, ett ståbord som bär dubbla skärmar, ett tält som står emot ösregn – ger du bevis som överträffar påståenden.

Konverteringseffekten är mätbar. E-handelssajter som lägger till produktvideor ser konverteringsökningar på 20–40 % eftersom kunder kan visualisera produkterna i sina egna miljöer innan köp. Samma videor blir upptäckbara i Google Lens-sökningar och driver trafik från en helt ny kanal.

De tekniska kraven är enkla: 15–45 sekunders videor som visar produkter från flera vinklar med tydlig skalkontext, uppladdade direkt på din webbplats (inte YouTube-embeds på produktsidor), med beskrivande filnamn och schema-markup. Du behöver inte Hollywoodkvalitet; autentiska mobilfilmer som visar genuin kontext överträffar ofta sterila studiovideor eftersom kontexten är viktigare än produktionsvärdet.

Att implementera optimering för visuell sökning kräver ett strategiskt angreppssätt. Börja med att granska dina nuvarande visuella tillgångar i Google Search Consoles bildsektion – de flesta varumärken upptäcker att de får tusentals visningar men minimalt med klick, vilket tyder på stor optimeringspotential.

Identifiera dina 50 viktigaste produkter baserat på trafik och intäkter och granska deras nuvarande visuella innehåll. Vilka produkter har flera vinklar? Vilka har videor? Vilka saknar livsstilsbilder? Denna granskning visar var dina optimeringsinsatser kommer att ge högst avkastning. Skapa en innehållsplan som prioriterar produkter med högst sökvolym och kommersiell intention.

Implementeringsplanen sträcker sig över 60–90 dagar. Vecka 1–2 fokuserar på planering och prioritering. Vecka 3–4 innebär innehållsskapande – att filma produktvideor, ta livsstilsbilder och skapa demonstrationsinnehåll. Vecka 5–6 handlar om teknisk optimering: byta filnamn, skriva alt-texter, implementera schema och ladda upp innehåll. Vecka 7–8 fokuserar på uppföljning och iteration, där du spårar vilka produkter och innehållstyper som genererar mest trafik från visuell sökning.

Övervaka Google Search Consoles Performance-rapport filtrerad på “Bild” som söktyp för att följa utvecklingen. Räkna med 30–60 dagar innan meningsfulla trafikökningar syns, eftersom Google behöver tid för att genomsöka och indexera ditt nya visuella innehåll. Spåra konverteringar från bildsökning specifikt med UTM-parametrar eller kanalgruppering i Google Analytics för att mäta avkastning.

Googles plan för visuell sökning fortsätter att expandera i spännande riktningar. Search Live, som lanseras 2025, möjliggör samtal i realtid med Sök – du kan rikta kameran mot en målning och fråga “Vilken stil är detta?” och sedan följa upp med “Vilka är kända konstnärer i den stilen?” och skapa en sömlös, konversationell visuell sökupplevelse.

Multimodala AI-kapaciteter utvecklas ständigt och gör det möjligt för Lens att förstå alltmer komplexa visuella frågor. Istället för att bara identifiera objekt kan Lens nu förstå relationer, sammanhang och nyanserade frågor om vad du ser. Circle to Search-expansionen gör gestbaserad visuell sökning tillgänglig på fler enheter och plattformar, vilket gör visuell upptäckt ännu mer tillgängligt.

Integrering i Googles ekosystem fördjupar möjligheterna. Google Lens är nu inbyggt i Chrome desktop, vilket innebär att visuell sökning är tillgängligt när inspirationen slår till. När dessa möjligheter expanderar globalt och till fler plattformar blir konkurrensfördelen för tidig optimering ännu tydligare.

De varumärken som förbereder sig nu – optimerar sitt visuella innehåll, skapar demonstrationsvideor och implementerar korrekt schema-markup – kommer att dominera resultaten för visuell sökning i takt med att kanalen fortsätter sin explosiva tillväxt. Frågan är inte om visuell sökning blir viktig för ditt företag; det är om du är synlig när kunder söker visuellt efter det du säljer.

Google Lens är Googles teknik för visuell sökning som använder AI för att identifiera objekt, text och scener från bilder eller video. Det använder konvolutionella neurala nätverk (CNN) för objektigenkänning, optisk teckenigenkänning (OCR) för textdetektering och naturlig språkbehandling (NLP) för att förstå sammanhang. Användare kan rikta sin kamera mot något och ställa frågor om det, och får omedelbara AI-drivna svar och relaterad information.

Traditionell bildsökning förlitar sig på nyckelord och metadata för att hitta visuellt liknande bilder. Google Lens förstår det faktiska innehållet i bilder – objekt, relationer, sammanhang och betydelse – vilket gör att det kan matcha produkter och information baserat på visuell likhet snarare än textbeskrivningar. Det gör det mycket effektivare för att hitta saker som är svåra att beskriva med ord, som möbler, mode eller landmärken.

Google Lens hanterar över 100 miljarder visuella sökningar årligen, varav 20 miljarder har direkt köpintention. Användare som genomför visuella sökningar letar aktivt efter att köpa något de har sett, vilket gör denna trafik mycket värdefull. Optimering för visuell upptäckt fångar kunder i deras stund av intention, innan de ens har skrivit in en sökfråga, vilket resulterar i högre konverteringsgrad än traditionell söktrafik.

Google Lens kräver att du öppnar appen och tar ett foto eller laddar upp en bild. Circle to Search är en gestbaserad funktion på Android-enheter som låter dig ringa in, trycka eller markera objekt direkt på skärmen utan att byta app. Båda använder samma underliggande teknik för visuell sökning, men Circle to Search erbjuder en snabbare och smidigare upplevelse för användare som redan tittar på innehåll på sina telefoner.

Optimera för Google Lens genom att visa flera produktvinklar, inkludera referenser med känd storlek (sängar, dörrar, människor) för skalkontext, skriva beskrivande alt-texter, implementera Product- och Video-schema, skapa livsstilsfotografi som visar verklig användning, hålla säsongsprodukter online med slut-i-lager-indikatorer och använda beskrivande filnamn. Varje element hjälper Google Lens att förstå ditt visuella innehåll bättre.

Video är en game-changer för visuell sökning eftersom Google Lens extraherar information från videorutor och skapar flera upptäckbara ögonblick från en enda video. Videor demonstrerar skala, funktionalitet och verklig användning på sätt som stillbilder inte kan. Produkter med demonstrationsvideor har 20–40 % högre konverteringsgrad och syns oftare i resultat för visuell sökning, vilket gör video avgörande för konkurrensfördel.

Räkna med 30–60 dagar innan meningsfulla trafikökningar syns i Google Search Consoles avsnitt för bilder. Google behöver tid för att genomsöka och indexera ditt nya visuella innehåll. Du bör dock övervaka ökningar i visningar inom 30 dagar, vilket indikerar att Google upptäcker och indexerar ditt optimerade innehåll. Förbättringar i konvertering följer vanligtvis inom 60–90 dagar när trafikvolymen ökar.

Ja, du kan spåra trafik från visuell sökning i Google Analytics genom att filtrera på 'Bild' som söktyp i Performance-rapporten i Google Search Console. För mer detaljerad konverteringsspårning, använd UTM-parametrar på produktsidor eller skapa en anpassad kanalgruppering för bildsökningstrafik. Övervaka mätvärden som klickfrekvens, konverteringsgrad och genomsnittligt ordervärde specifikt för trafik från bildsökning för att mäta ROI på dina optimeringsinsatser.

AmICited spårar hur Google Lens, Circle to Search och andra AI-verktyg refererar till ditt varumärke i visuella upptäcktsresultat. Få insikter om din AI-synlighet och optimera din strategi för visuellt innehåll.

Lär dig hur visuell sökning och AI förändrar bildupptäckt. Optimera dina bilder för Google Lens, AI-översikter och multimodala LLM:er för att öka synligheten i ...

Lär dig vad visuell AI-sökning är, hur den fungerar och dess tillämpningar inom e-handel och detaljhandel. Upptäck teknologierna bakom bildbaserad sökning och h...

Utforska hur AI-sökplattformar som ChatGPT och Perplexity omformar söklanskapet. Ta reda på när AI kan matcha Googles konverteringsvolym och vad det betyder för...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.