AI-innehållskonsolidering

Lär dig vad AI-innehållskonsolidering är och hur sammanslagning av liknande innehåll stärker synlighetssignaler för ChatGPT, Perplexity och Google AI Overviews....

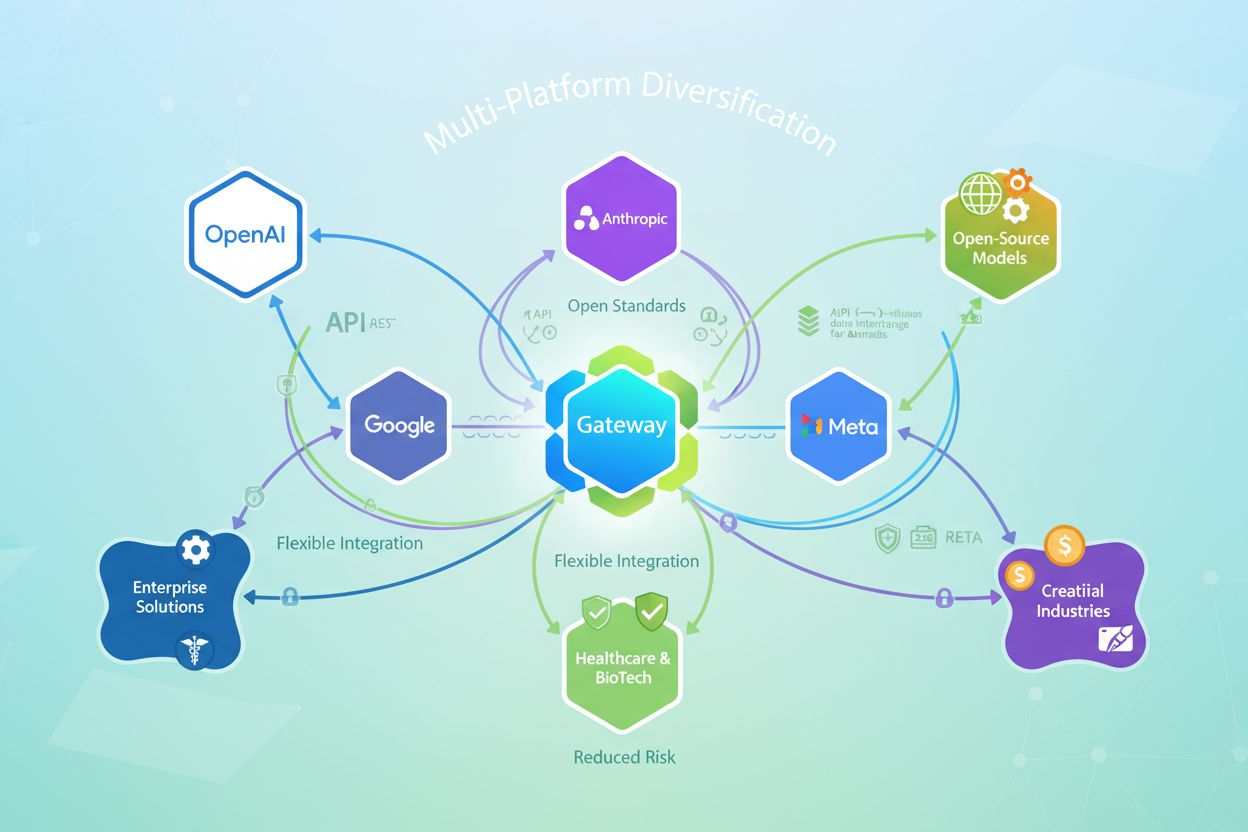

Strategi för att bygga synlighet och tillgång över flera AI-plattformar för att minska beroenderisk, optimera kostnader och behålla strategisk flexibilitet. Organisationer fördelar sina AI-arbetsbelastningar över olika leverantörer istället för att lita på en enda, vilket möjliggör bättre förhandlingsstyrka, förbättrad motståndskraft och förmåga att anta de bästa lösningarna när de uppstår.

Strategi för att bygga synlighet och tillgång över flera AI-plattformar för att minska beroenderisk, optimera kostnader och behålla strategisk flexibilitet. Organisationer fördelar sina AI-arbetsbelastningar över olika leverantörer istället för att lita på en enda, vilket möjliggör bättre förhandlingsstyrka, förbättrad motståndskraft och förmåga att anta de bästa lösningarna när de uppstår.

Leverantörsinlåsning uppstår när en organisation blir så beroende av en enda AI-leverantör att det blir opraktiskt eller orimligt dyrt att byta till alternativ. Detta beroende utvecklas gradvis genom tätt sammankopplade integrationer, proprietära API:er och anpassade implementationer som binder applikationer direkt till en leverantörs ekosystem. Konsekvenserna är allvarliga: organisationer tappar förhandlingsstyrka, möter stigande kostnader och blir oförmögna att anta bättre modeller eller teknologier när de uppstår. När man väl är inlåst krävs omfattande ombyggnad, omskolning och ofta betydande finansiella påföljder för att byta leverantör.

Att förlita sig på en enda AI-plattform skapar flera strategiska sårbarheter som sträcker sig långt bortom den initiala bekvämligheten:

Multimodellsplattformar löser dessa utmaningar genom att skapa ett abstraheringslager mellan applikationer och AI-leverantörer. Istället för att applikationer anropar leverantörernas API:er direkt, interagerar de med ett enhetligt gränssnitt som plattformen hanterar. Denna arkitektur möjliggör intelligent dirigeringslogik som skickar förfrågningar till optimala modeller baserat på kostnad, prestanda, efterlevnadskrav eller tillgänglighet. Plattformen översätter förfrågningar till leverantörsspecifika format, hanterar autentisering och säkerhet samt upprätthåller fullständiga granskningsspår. Multimodellsplattformar på företagsnivå tillför avgörande styrningsfunktioner: centraliserad policyhantering, skydd av känslig data, rollbaserad åtkomstkontroll och realtidsobservation av AI-användningen i hela organisationen.

| Dimension | En-leverantörsplattform | Multimodellsplattform |

|---|---|---|

| Leverantörsfrihet | Låst till en leverantör | Tillgång till 100+ modeller från flera leverantörer |

| Kostnad | Företagsavtal: $50K–$500K+ årligen | 40–60 % lägre kostnad med samma kapacitet |

| Styrning | Begränsad till leverantörens kontroller | Centraliserade policyer för alla leverantörer |

| Datasäkerhet | Direkt exponering mot leverantör | Skyddande lager för känslig data |

| Byteskostnad | Mycket hög (månader, miljoner) | Minimal (ändring i konfiguration) |

| Latensöverlag | Ingen | 3–5 ms (försumbar) |

| Efterlevnad | Beroende av leverantör | Anpassningsbar till krav |

Multimodellsplattformar ger betydande kostnadsfördelar genom konkurrenskraftiga leverantörspriser och intelligent modellval. Organisationer som använder multimodellsplattformar på företagsnivå rapporterar 40–60 % kostnadsbesparingar jämfört med avtal med en enda leverantör, samtidigt som de får tillgång till bättre modeller och omfattande styrning. Plattformen möjliggör dynamiskt modellval—enkla frågor dirigeras till kostnadseffektiva modeller medan dyra, högpresterande modeller reserveras för komplexa uppgifter. Realtidsuppföljning av kostnader och budgethantering förhindrar okontrollerade utgifter, samtidigt som konkurrens mellan leverantörer håller priserna fördelaktiga. Organisationer kan även förhandla bättre priser genom att visa att de enkelt kan byta leverantör, vilket fundamentalt förändrar maktbalansen i leverantörsrelationer.

Multimodellsplattformar på företagsnivå implementerar skyddande lager som en-leverantörslösningar inte kan matcha. Skydd av känslig data upptäcker och förhindrar att konfidentiell information når externa leverantörer, så att företagsdata stannar inom organisationens gränser. Omfattande granskningsloggar skapar transparens för varje AI-interaktion, vilket stödjer efterlevnad av regleringar som GDPR, HIPAA och SOC 2. Organisationer kan upprätthålla konsekventa policyer över samtliga leverantörer—regler för acceptabel användning, datahantering och efterlevnad—utan att vara beroende av varje leverantörs styrningsfunktioner. Enligt Business Digital Index-rapporten 2025 misslyckas 50 % av AI-leverantörerna med grundläggande datasäkerhetskrav, vilket gör mellanliggande styrningslager oumbärliga för reglerade branscher. Multimodellsplattformar blir själva säkerhetsgränsen och erbjuder bättre skydd än direkt åtkomst till leverantörer.

Plattformsdiversifiering skapar operationell resiliens genom redundans och failover-funktioner. Om en AI-leverantör drabbas av avbrott eller prestandanedgång, dirigerar plattformen automatiskt arbetsbelastningar till alternativa leverantörer utan avbrott i tjänsten. Denna redundans är omöjlig med en-leverantörsstrategier, där avbrott direkt påverkar alla beroende applikationer. Multimodellsplattformar möjliggör också prestandaoptimering genom att övervaka realtidslatens och kvalitetsmått, och automatiskt välja den snabbaste eller mest tillförlitliga leverantören för varje förfrågan. Organisationer kan testa nya modeller i produktion med minimal risk, och gradvis styra trafik till bättre alternativ när förtroendet ökar. Resultatet är AI-infrastruktur som förblir tillförlitlig och presterande även när enskilda leverantörer drabbas av störningar.

Hållbar plattformsdiversifiering beror på öppna standarder som förhindrar nya former av inlåsning. Organisationer bör prioritera plattformar som använder standardiserade API:er (REST, GraphQL) istället för proprietära SDK:er, så att applikationer förblir leverantörsoberoende. Modellutbytesformat som ONNX (Open Neural Network Exchange) gör det möjligt att flytta tränade modeller mellan ramverk och plattformar utan omträning. Dataportabilitet innebär att loggar och mätvärden lagras i öppna format—Parquet, JSON, OpenTelemetry—under organisationens kontroll istället för i leverantörslåsta databaser. Öppna standarder ger verklig strategisk frihet: organisationer kan migrera till nya plattformar, anta nya modeller eller självhosta infrastruktur utan att behöva skriva om applikationer. Detta framtidssäkrar AI-strategier mot leverantörsbyten, prisförändringar eller marknadsstörningar.

En lyckad plattformsdiversifiering kräver systematisk utvärdering och styrning. Organisationer bör utvärdera plattformar utifrån stöd för flera leverantörer (integreras de med stora leverantörer och tillåter egna modeller?), öppna API:er och dataformat (kan du exportera data och använda standardbibliotek?), och distributionsflexibilitet (kan du köra lokalt eller över flera moln?). Implementeringen börjar med att välja en multimodellsplattform som matchar organisationens krav och därefter gradvis migrera applikationer till plattformens enhetliga gränssnitt. Skapa styrningsramverk som definierar acceptabel AI-användning, datahanteringspolicyer och efterlevnadskrav—plattformen upprätthåller dessa konsekvent över alla leverantörer. Teamutbildning säkerställer att utvecklare förstår den nya arkitekturen och kan utnyttja plattformens kapacitet effektivt. Kontinuerlig övervakning och optimering identifierar besparingsmöjligheter, prestandaförbättringar och nya användningsområden.

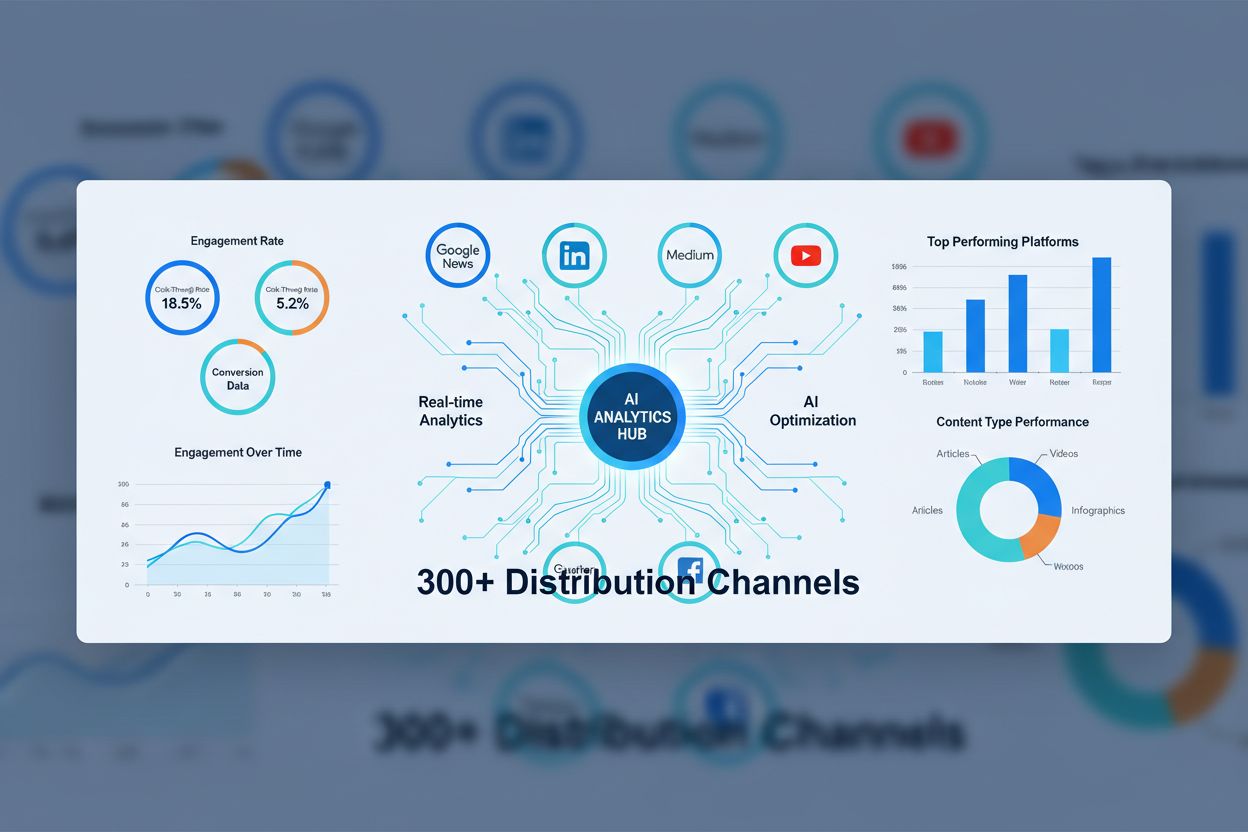

När organisationer diversifierar över flera AI-plattformar blir insyn och kontroll avgörande. AmICited.com fungerar som en nödvändig övervakningslösning särskilt utformad för denna utmaning, och spårar hur AI-system refererar ditt varumärke och innehåll över flera AI-plattformar inklusive ChatGPT, Perplexity, Google AI Overviews och andra. Denna synlighet är avgörande för att förstå ditt AI-avtryck, säkerställa efterlevnad och identifiera optimeringsmöjligheter. FlowHunt.io kompletterar detta tillvägagångssätt genom att tillhandahålla AI-innehållsgenerering och automatisering över flera plattformar, vilket gör det möjligt för organisationer att bibehålla konsekvent kvalitet och styrning i takt med att AI-användningen skalas upp. Tillsammans hjälper dessa lösningar organisationer att bibehålla fullständig insyn i sin AI-plattformsanvändning, kontrollera kostnader, säkerställa efterlevnad och optimera prestanda över hela sin diversifierade AI-infrastruktur. Genom att kombinera övervakning av flera plattformar med intelligent automatisering kan organisationer tryggt skala upp AI-användningen och samtidigt behålla den kontroll och insyn som krävs för verksamhetsdriften.

Leverantörsinlåsning uppstår när en organisation blir så beroende av en enda AI-leverantör att det blir opraktiskt eller orimligt dyrt att byta. Detta beroende utvecklas genom tätt sammankopplade integrationer och proprietära API:er, vilket leder till förlorad förhandlingsstyrka, oförmåga att anta bättre modeller och stigande kostnader. Organisationer bör bry sig eftersom inlåsning begränsar strategisk flexibilitet och skapar långsiktig sårbarhet mot prisändringar och avbrott i tjänsten.

Organisationer som använder företagsplattformar med flera modeller rapporterar 40–60 % kostnadsbesparingar jämfört med avtal med en enda leverantör, samtidigt som de får tillgång till bättre modeller och övergripande styrning. Dessa besparingar kommer från konkurrenskraftiga leverantörspriser, intelligent modellval som dirigerar enkla frågor till kostnadseffektiva modeller och förbättrad förhandlingsstyrka när leverantörer vet att ni enkelt kan byta.

En-leverantörsplattformar låser in organisationer i en leverantörs ekosystem med begränsad styrning och höga byteskostnader. Multimodellsplattformar skapar ett abstraheringslager som möjliggör åtkomst till 100+ modeller från flera leverantörer, centraliserad styrning över alla leverantörer, skydd av känslig data och minimala byteskostnader. Multimodellsplattformar lägger till endast 3–5 ms latens samtidigt som de erbjuder säkerhet och efterlevnad på företagsnivå.

Företagsplattformar med flera modeller implementerar skyddsmekanismer för känslig data som upptäcker och förhindrar att konfidentiell information når externa leverantörer, så att företagsdata hålls inom organisationens gränser. De upprätthåller fullständiga granskningsloggar av varje AI-interaktion, upprätthåller konsekventa policyer över alla leverantörer och blir säkerhetsgränsen istället för att exponera data direkt till leverantörer. Detta är avgörande eftersom 50 % av AI-leverantörerna inte uppfyller grundläggande datasäkerhetsstandarder.

Öppna standarder (REST API:er, GraphQL, ONNX, OpenTelemetry) förhindrar nya former av leverantörsinlåsning genom att säkerställa att applikationer förblir leverantörsoberoende och data förblir portabel. Organisationer bör prioritera plattformar som använder standardiserade API:er istället för proprietära SDK:er, lagra data i öppna format under organisationens kontroll och använda modellutbytesformat som möjliggör att modeller kan flyttas mellan plattformar utan omträning. Detta framtidssäkrar AI-strategier mot leverantörsbyten och marknadsstörningar.

Utvärdera plattformar baserat på stöd för flera leverantörer (integration med stora leverantörer och egna modeller), öppna API:er och dataformat (möjlighet att exportera data och använda standardbibliotek), distributionsflexibilitet (lokal drift eller multi-moln-alternativ) och styrningsmöjligheter (policyhantering, granskningsloggning, efterlevnadsstöd). Prioritera plattformar med hållbara organiska distributionsmekanismer istället för tillfälliga kampanjerbjudanden och bedöm deras meritlista med företagskunder inom din bransch.

Viktiga utmaningar inkluderar att välja rätt multimodellsplattform som är anpassad till organisationens krav, migrera befintliga applikationer till plattformens enhetliga gränssnitt, etablera styrningsramverk som definierar acceptabel AI-användning och efterlevnadskrav samt utbilda team på den nya arkitekturen. Organisationer bör även planera för kontinuerlig övervakning och optimering för att identifiera kostnadsbesparingar och nya användningsområden. Framgång kräver engagemang för det nya tillvägagångssättet istället för att parallellt upprätthålla äldre en-leverantörsintegrationer.

AmICited.com tillhandahåller omfattande övervakning av hur ditt varumärke och innehåll syns över flera AI-plattformar, inklusive ChatGPT, Perplexity, Google AI Overviews och andra. Denna synlighet är avgörande för att förstå ditt AI-avtryck, säkerställa efterlevnad, identifiera optimeringsmöjligheter och behålla kontroll över hur ditt varumärke refereras i AI-genererade svar. AmICited hjälper organisationer att spåra sin närvaro över det diversifierade AI-landskap de byggt.

Spåra hur ditt varumärke visas över flera AI-plattformar med AmICited. Få omfattande insyn i ditt AI-avtryck över ChatGPT, Perplexity, Google AI Overviews och fler.

Lär dig vad AI-innehållskonsolidering är och hur sammanslagning av liknande innehåll stärker synlighetssignaler för ChatGPT, Perplexity och Google AI Overviews....

Lär dig om AI-innehållslicensieringsavtal som styr hur artificiella intelligenssystem använder upphovsrättsligt skyddat innehåll. Utforska licensieringstyper, n...

Lär dig vad AI-innehållssyndikeringsnätverk är, hur de fungerar och varför de är avgörande för modern innehållsdistribution. Upptäck hur AI-optimering förbättra...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.