Transparens i AI-synlighetsinsatser: Bästa praxis för öppenhet

Lär dig väsentlig AI-transparens och de bästa praxis för öppenhet. Upptäck beteendemässiga, verbala och tekniska metoder för öppenhet för att bygga förtroende o...

I vilken grad AI-plattformar avslöjar hur de väljer ut och rankar källor vid generering av svar. Transparens i AI-rankning avser synligheten av algoritmer och kriterier som avgör vilka källor som visas i AI-genererade svar, vilket skiljer sig från traditionell sökmotorrankning. Denna transparens är avgörande för innehållsskapare, publicister och användare som behöver förstå hur information väljs ut och prioriteras. Utan transparens kan användare inte verifiera källors trovärdighet eller förstå potentiella partiskheter i AI-genererat innehåll.

I vilken grad AI-plattformar avslöjar hur de väljer ut och rankar källor vid generering av svar. Transparens i AI-rankning avser synligheten av algoritmer och kriterier som avgör vilka källor som visas i AI-genererade svar, vilket skiljer sig från traditionell sökmotorrankning. Denna transparens är avgörande för innehållsskapare, publicister och användare som behöver förstå hur information väljs ut och prioriteras. Utan transparens kan användare inte verifiera källors trovärdighet eller förstå potentiella partiskheter i AI-genererat innehåll.

Transparens i AI-rankning syftar på öppenheten kring hur artificiella intelligenssystem väljer, prioriterar och presenterar källor när de genererar svar på användarfrågor. Till skillnad från traditionella sökmotorer som visar rankade listor med länkar, integrerar moderna AI-plattformar som Perplexity, ChatGPT och Googles AI Overviews källval i själva svarsgenereringen, vilket gör rankningskriterierna i stort sett osynliga för användare. Denna brist på insyn skapar en kritisk klyfta mellan vad användaren ser (ett syntetiserat svar) och hur det svaret har konstruerats (vilka källor som valts ut, vägts in och citerats). För innehållsskapare och publicister innebär denna brist på transparens att deras synlighet avgörs av algoritmer de inte kan förstå eller påverka med traditionella optimeringsmetoder. Skillnaden från traditionell sökmotortransparens är betydande: medan Google publicerar generella rankningsfaktorer och kvalitetsriktlinjer, ser AI-plattformar ofta sina metoder för källval som företagshemligheter. Påverkade intressenter är bl.a. innehållsskapare som vill synas, publicister som oroar sig för trafik och attribution, varumärkesansvariga som bevakar rykte, forskare som verifierar informationskällor, och användare som behöver förstå trovärdigheten i AI-genererade svar. Att förstå transparens i AI-rankning har blivit avgörande för alla som producerar, distribuerar eller förlitar sig på digitalt innehåll i ett allt mer AI-drivet informationslandskap.

AI-plattformar använder Retrieval-Augmented Generation (RAG)-system som kombinerar språkmodeller med realtidsinhämtning av information för att grunda svaren i faktiska källor istället för enbart träningsdata. RAG-processen består av tre huvudsteg: hämtning (hitta relevanta dokument), rankning (ordna källor efter relevans) och generering (syntetisera information och bibehålla källhänvisningar). Olika plattformar har olika rankningsmetoder—Perplexity prioriterar källauktoritet och aktualitet, Googles AI Overviews betonar ämnesrelevans och E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness), medan ChatGPT Search balanserar källkvalitet med svarens omfattning. Faktorer som påverkar källval inkluderar domänauktoritet (etablerat rykte och länkprofil), innehållets aktualitet, ämnesrelevans (semantisk koppling till frågan), engagemangssignaler (användarinteraktion) och citeringsfrekvens (hur ofta källan refereras av andra auktoritativa sidor). AI-system viktar dessa signaler olika beroende på frågetyp—faktabaserade frågor kan prioritera auktoritet och aktualitet, medan åsiktsfrågor kan väga in mångfald av perspektiv och engagemang. Rankningsalgoritmerna är till största delen odokumenterade, även om plattformarnas dokumentation ger viss inblick i viktningen.

| Plattform | Citeringstransparens | Källvalskriterier | Insyn i rankningsalgoritm | Användarkontroll |

|---|---|---|---|---|

| Perplexity | Hög – direkta källhänvisningar med länkar | Auktoritet, aktualitet, relevans, ämnesexpertis | Måttlig – viss dokumentation | Medel – filtreringsalternativ för källor |

| Google AI Overviews | Medel – citerade källor listas | E-E-A-T, ämnesrelevans, aktualitet, engagemang | Låg – minimal insyn | Låg – begränsad anpassning |

| ChatGPT Search | Medel – källor listas separat | Kvalitet, relevans, omfattning, auktoritet | Låg – företagshemlig algoritm | Låg – ingen anpassning av rankning |

| Brave Leo | Medel – källattribution | Sekretessvänliga källor, relevans, auktoritet | Låg – sekretessfokuserad insyn | Medel – urval av källor |

| Consensus | Mycket hög – akademiskt fokus med mått | Antal citeringar, peer review-status, aktualitet, ämnesrelevans | Hög – akademiska standarder transparenta | Hög – filtrering efter studietyp och kvalitet |

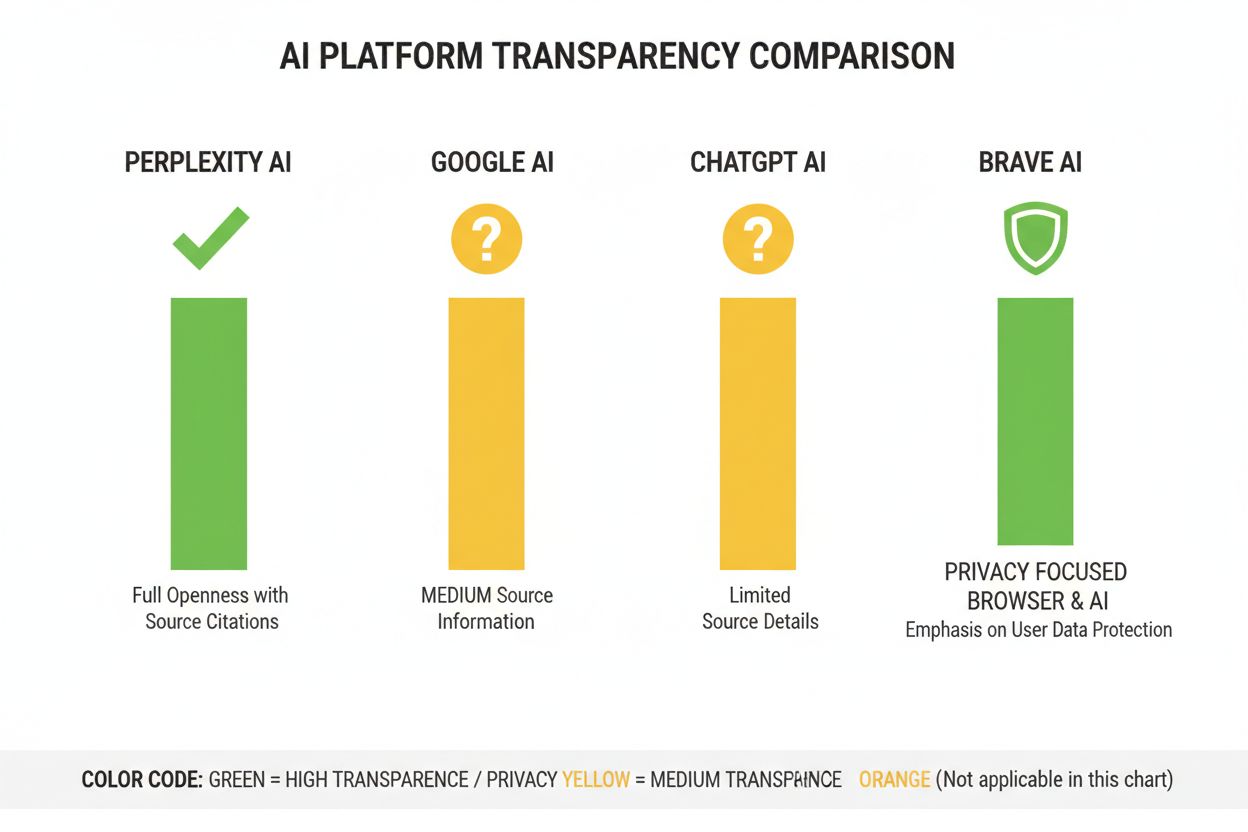

AI-branschen saknar standardiserade informationskrav kring hur rankningssystem fungerar, vilket skapar en fragmenterad miljö där varje plattform själv bestämmer sin transparensnivå. OpenAI:s ChatGPT Search ger minimal förklaring till källval, Metas AI-system erbjuder begränsad dokumentation, och Googles AI Overviews informerar mer än konkurrenterna men undanhåller ändå viktiga algoritmdetaljer. Plattformar motiverar bristen på full insyn med konkurrensskäl, företagshemligheter och svårigheten att förklara maskininlärningssystem för allmänheten—men denna brist på öppenhet förhindrar extern granskning och ansvarstagande. “Source laundering”-problemet uppstår när AI-system citerar källor som själva aggregerar eller omskriver ursprungsinnehåll, vilket döljer informationens verkliga ursprung och kan förstärka desinformation genom flera lager av syntes. Det regulatoriska trycket ökar: EU:s AI-förordning kräver att högrisk-AI-system dokumenterar träningsdata och beslutsprocesser, medan NTIA:s AI Accountability Policy förordar att företag ska redovisa AI-systemens förmågor, begränsningar och lämpliga användningsområden. Exempel på bristande insyn är Perplexitys initiala problem med källhänvisningar (senare förbättrade), Googles vaga förklaring till hur AI Overviews väljer källor, och ChatGPT:s begränsade transparens kring varför vissa källor syns i svaren men inte andra. Avsaknaden av standardiserade mått för att mäta transparens gör det svårt för användare och tillsynsmyndigheter att objektivt jämföra plattformar.

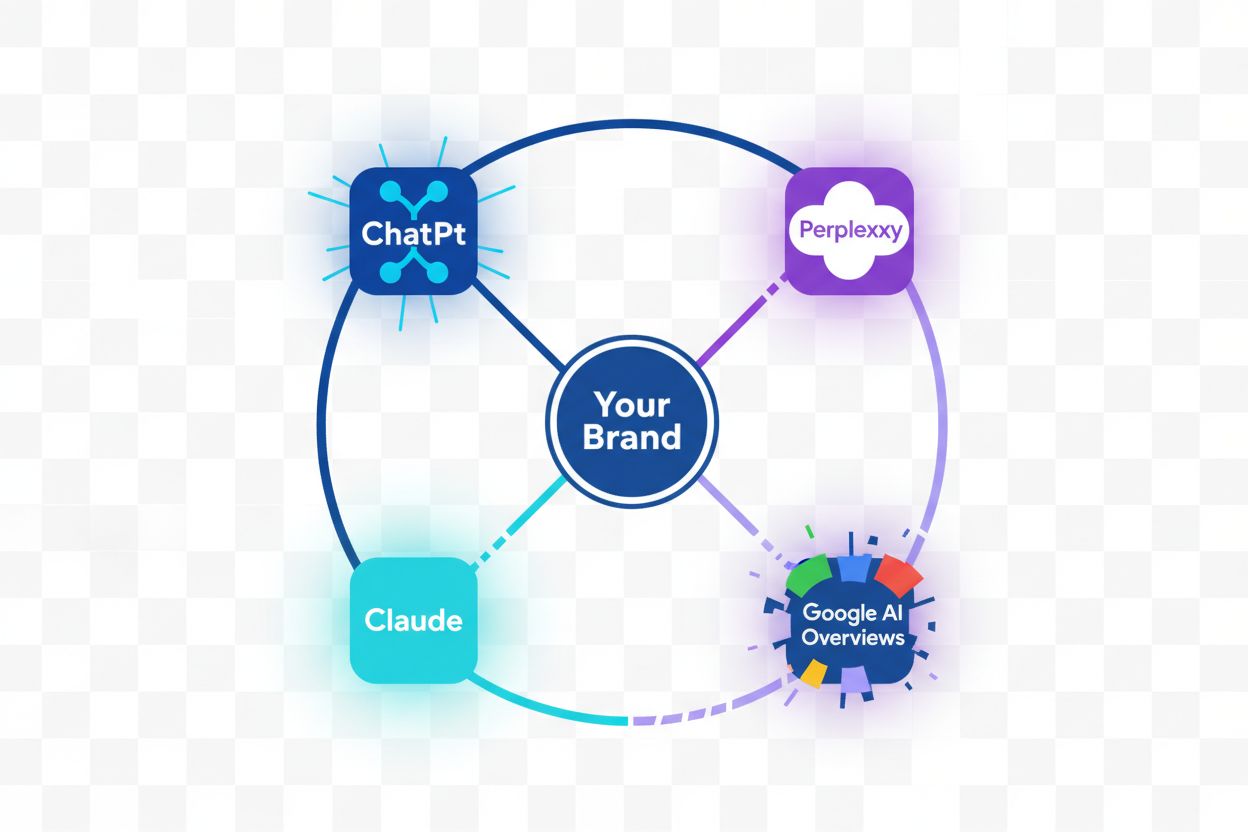

Bristen på insyn i AI-rankningssystem skapar betydande synlighetsutmaningar för innehållsskapare, eftersom traditionella SEO-strategier inte direkt kan överföras till AI-plattformar. Publicister kan inte enkelt förstå varför deras innehåll syns i vissa AI-svar men inte i andra, vilket gör det omöjligt att utveckla riktade strategier för att öka synligheten i AI-genererade svar. Citeringsbias uppstår när AI-system oproportionerligt gynnar vissa källor—etablerade nyhetsmedier, akademiska institutioner eller högt trafikerade webbplatser—samtidigt som mindre publicister, självständiga skapare och nischade experter marginaliseras trots att de kan ha lika värdefull information. Mindre aktörer drabbas särskilt när AI-rankningssystem ofta viktar domänauktoritet högt, och nya eller specialiserade källor saknar de länkar och varumärkesigenkänning som de stora aktörerna har. Forskning från Search Engine Land visar att AI Overviews minskat klickfrekvensen till traditionella sökresultat med 18–64 % beroende på frågetyp, med trafik koncentrerad till de få källor som citeras i AI-svaren. Skillnaden mellan SEO (Search Engine Optimization) och GEO (Generative Engine Optimization) blir allt viktigare—SEO gäller för traditionell sökrankning, medan GEO kräver förståelse och optimering för AI-plattformars urvalskriterier, vilka fortfarande till stor del är okända. Innehållsskapare behöver verktyg som AmICited.com för att övervaka var deras innehåll förekommer i AI-svar, spåra citeringsfrekvens och förstå sin synlighet på olika AI-plattformar.

AI-branschen har tagit fram flera ramverk för att dokumentera och redovisa systembeteende, även om införandet varierar mellan plattformar. Model Cards ger standardiserad dokumentation av maskininlärningsmodellers prestanda, avsedda användningsområden, begränsningar och bias-analys—likt näringsdeklarationer för AI-system. Datasheets for Datasets dokumenterar sammansättning, insamlingsmetodik och potentiella biaser i träningsdata, enligt principen att AI-system bara är så bra som deras data. System Cards tar ett helhetsgrepp och dokumenterar systemens beteende från början till slut, inklusive hur komponenter samverkar, möjliga fel och verklig prestanda över olika användargrupper. NTIA:s AI Accountability Policy rekommenderar att företag håller detaljerad dokumentation över AI-systemens utveckling, testning och införande, särskilt för högriskapplikationer som påverkar allmänheten. EU:s AI-förordning kräver att högrisk-AI-system har teknisk dokumentation, träningsdataregister och prestandaloggar samt transparensrapporter och användarinformation. Allt fler branschpraxis inkluderar:

Perplexity har profilerat sig som den mest citeringstransparenta AI-plattformen, med direkta källhänvisningar i svaren och möjligheten för användare att se exakt vilka källor som bidragit till varje påstående. Plattformen erbjuder relativt tydlig dokumentation kring sin rankningsmetod, där källauktoritet, ämnesexpertis och aktualitet betonas, även om den exakta viktningen är företagshemlig. Googles AI Overviews erbjuder måttlig transparens genom att lista citerade källor i slutet av svaren, men ger begränsad förklaring till varför vissa källor valts ut eller hur algoritmen väger olika signaler. Googles dokumentation betonar E-E-A-T-principerna men avslöjar inte hur dessa mäts eller viktas i AI-rankningen. OpenAI:s ChatGPT Search representerar en mellanväg, där källor redovisas separat från svaret och användare kan klicka sig vidare till originalinnehåll, men där det ges mycket begränsad information om urvalskriterier eller rankningsmetodik. Brave Leo prioriterar sekretessinriktad transparens, med information om att sekretessvänliga källor används och att användarfrågor inte spåras, men med mindre detaljerad förklaring av rankningsmekanismerna. Consensus utmärker sig genom att bara fokusera på akademisk forskning och erbjuda hög transparens genom citeringsmått, peer review-status och kvalitetsindikatorer—vilket gör den till den mest algoritmiskt transparenta plattformen för forskningsfrågor. Användarkontrollen varierar: Perplexity tillåter källfiltrering, Consensus filtrering på studietyp och kvalitet, medan Google och ChatGPT erbjuder minimal anpassning av rankningspreferenser. Variationerna i transparens speglar olika affärsmodeller och målgrupper, där akademiska plattformar prioriterar insyn och konsumentinriktade plattformar balanserar transparens mot företagshemligheter.

Förtroende och trovärdighet bygger på att användare förstår hur information når dem—när AI-system döljer sina källor eller rankningslogik kan användare inte självständigt verifiera påståenden eller bedöma källors tillförlitlighet. Transparens möjliggör verifiering och faktagranskning, så att forskare, journalister och kunniga användare kan spåra påståenden till ursprungskällor och bedöma deras korrekthet och sammanhang. Förebyggande av desinformation och bias är en stor fördel med transparens: när rankningsalgoritmer är synliga kan forskare identifiera systematiska bias (som att vissa politiska åsikter eller kommersiella intressen gynnas), och plattformar kan hållas ansvariga för att förstärka felaktig information. Algoritmisk ansvarsskyldighet är en grundläggande användarrättighet i demokratiska samhällen—människor har rätt att förstå hur system som formar deras informationsmiljö fattar beslut, särskilt när dessa system påverkar opinion, inköp och kunskapstillgång. För forskning och akademiskt arbete är transparens avgörande eftersom forskare måste förstå källvalet för att korrekt kunna tolka AI-genererade sammanfattningar och undvika att omedvetet förlita sig på partiska eller ofullständiga källor. Affärskonsekvenserna för innehållsskapare är stora: utan insyn i rankningsfaktorer kan publicister inte optimera sin strategi, mindre aktörer kan inte konkurrera rättvist med etablerade, och ekosystemet blir mindre meritokratiskt. Transparens skyddar även mot manipulation—när rankningskriterier är dolda kan illasinnade aktörer utnyttja okända svagheter för att sprida missvisande innehåll, medan transparenta system kan granskas och förbättras.

Regulatoriska trender driver mot obligatorisk öppenhet: EU:s AI-förordning som träder i kraft 2025–2026 kräver detaljerad dokumentation och redovisning för högrisk-AI-system, och liknande lagar är på gång i Storbritannien, Kalifornien och andra jurisdiktioner. Branschen rör sig mot standardisering av transparenspraxis, där organisationer som Partnership on AI och akademiska institutioner utvecklar gemensamma ramverk för dokumentation och öppenhet kring AI-system. Användarnas krav på transparens ökar i takt med att medvetenheten om AI:s roll i informationsspridning växer—undersökningar visar att över 70 % av användare vill förstå hur AI-system väljer ut källor och rankar information. Tekniska innovationer inom förklaringsbar AI (XAI) gör det alltmer möjligt att ge detaljerade förklaringar till rankningsbeslut utan att helt avslöja företagshemliga algoritmer, med tekniker som LIME (Local Interpretable Model-agnostic Explanations) och SHAP (SHapley Additive exPlanations). Övervakningsverktyg som AmICited.com blir allt viktigare när plattformar inför transparensåtgärder, och hjälper innehållsskapare och publicister att spåra sin synlighet i olika AI-system och förstå hur rankningsförändringar påverkar deras räckvidd. Sammantaget pekar regulatoriska krav, användarförväntningar och tekniska möjligheter på att 2025–2026 blir avgörande år för transparens i AI-rankning, där plattformar sannolikt antar mer standardiserad öppenhet, inför bättre användarkontroll över källval och ger tydligare förklaringar till rankningslogik. Framtiden kommer troligen att präglas av differentierad transparens—akademiska plattformar leder med hög insyn, konsumentplattformar erbjuder måttlig transparens och anpassningsmöjligheter, och regulatorisk efterlevnad blir ett grundkrav i hela branschen.

Transparens i AI-rankning handlar om hur öppet AI-plattformar redovisar sina algoritmer för att välja ut och ranka källor i genererade svar. Det är viktigt eftersom användare behöver förstå källors trovärdighet, innehållsskapare behöver optimera för AI-synlighet och forskare behöver kunna verifiera informationskällor. Utan transparens kan AI-system förstärka desinformation och ge orättvisa fördelar till etablerade aktörer framför mindre publicister.

AI-plattformar använder Retrieval-Augmented Generation (RAG)-system som kombinerar språkmodeller med realtidsinhämtning av information. De rankar källor utifrån faktorer som domänauktoritet, innehållets aktualitet, ämnesrelevans, engagemangssignaler och citeringsfrekvens. Den exakta viktningen av dessa faktorer är dock i stort sett företagshemligheter och inte offentligt dokumenterade av de flesta plattformar.

Traditionell SEO fokuserar på att ranka i sökmotorers länklistor, där Google publicerar generella rankningsfaktorer. Transparens i AI-rankning handlar om hur AI-plattformar väljer ut källor till syntetiserade svar, vilket innebär andra kriterier och är till stor del odokumenterat. Medan SEO-strategier är välbeskrivna, är AI-rankningsfaktorer fortfarande till stor del dolda.

Du kan klicka dig vidare till ursprungskällorna för att verifiera påståenden i sitt fulla sammanhang, kontrollera om källorna kommer från auktoritativa domäner, leta efter peer review-status (speciellt inom akademiskt innehåll) och jämföra information mellan flera källor. Verktyg som AmICited hjälper till att spåra vilka källor som syns i AI-svar och hur ofta ditt innehåll citeras.

Consensus leder inom transparens genom att fokusera uteslutande på peer review-granskad akademisk forskning med tydliga citeringsmått. Perplexity erbjuder direkta källhänvisningar och måttlig dokumentation av rankningsfaktorer. Googles AI Overviews ger medelhög transparens, medan ChatGPT Search och Brave Leo har begränsad insyn i sina rankningsalgoritmer.

Model cards är standardiserad dokumentation av AI-systemens prestanda, avsedda användningsområden, begränsningar och bias-analys. Datasheets dokumenterar sammansättningen av träningsdata, insamlingsmetoder och potentiella partiskheter. System cards beskriver systemets helhetsbeteende. Dessa verktyg gör AI-system mer transparenta och jämförbara, ungefär som näringsdeklarationer för mat.

EU:s AI-förordning kräver att högrisk-AI-system har detaljerad teknisk dokumentation, register över träningsdata och prestandaloggar. Den kräver transparensrapporter och att användare informeras om AI-system används. Dessa krav driver AI-plattformar mot ökad öppenhet kring rankningsmekanismer och urvalskriterier för källor.

AmICited.com är en plattform för övervakning av AI-citeringar som spårar hur AI-system som Perplexity, Google AI Overviews och ChatGPT citerar ditt varumärke och innehåll. Den ger insyn i vilka källor som syns i AI-svar, hur ofta ditt innehåll citeras och hur din rankningstransparens står sig mellan olika AI-plattformar.

Spåra hur AI-plattformar som Perplexity, Google AI Overviews och ChatGPT citerar ditt innehåll. Förstå din rankningstransparens och optimera din synlighet över AI-sökmotorer med AmICited.

Lär dig väsentlig AI-transparens och de bästa praxis för öppenhet. Upptäck beteendemässiga, verbala och tekniska metoder för öppenhet för att bygga förtroende o...

Upptäck varför höga Google-rankningar inte garanterar AI-synlighet. Lär dig om gapet mellan SEO och AI-citeringar, och hur du optimerar för båda sökkanalerna....

Upptäck kritiska AI-synlighetsblinda fläckar där konkurrenter får fördel. Lär dig ramverk för gap-analys och verktyg för att övervaka AI-närvaro över ChatGPT, P...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.