Jak právnické firmy získávají viditelnost v ChatGPT, Perplexity a AI vyhledávačích

Zjistěte, jak právnické firmy zlepšují viditelnost v AI-poháněných vyhledávačích a generátorech odpovědí. Objevte strategie, jak se objevit v ChatGPT, Perplexit...

Zjistěte, jak mohou advokátní kanceláře optimalizovat svou viditelnost v AI a zároveň dodržovat etické standardy. Seznamte se s pokyny ABA, protokoly důvěrnosti a praktickými strategiemi pro právní marketing využívající AI.

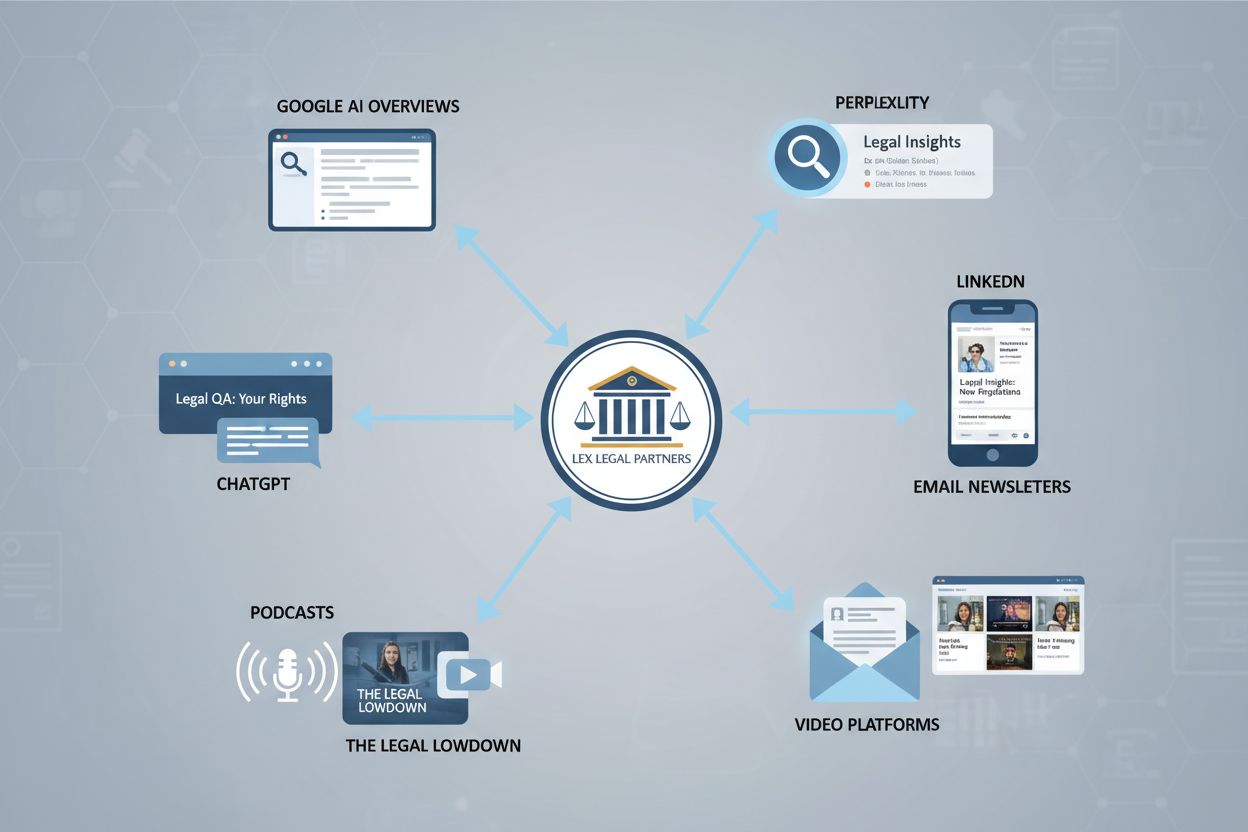

Prostředí vyhledávání právních služeb se zásadně změnilo a již není omezeno pouze na tradiční optimalizaci pro vyhledávače. Advokátní kanceláře se již nemohou spoléhat pouze na hodnocení ve výsledcích Google k zajištění své viditelnosti – potenciální klienti nyní objevují právní expertízu prostřednictvím AI platforem, chatbotů, hlasových asistentů a specializovaných právních vyhledávačů, které fungují nezávisle na tradičních výsledcích vyhledávání. Tyto AI systémy jsou trénovány na různých formátech obsahu, včetně blogových příspěvků, obsahu ze sociálních sítí, přepisů videí, podcastů a referencí klientů, což znamená, že viditelnost vaší kanceláře závisí na přítomnosti na více površích zároveň. Když se potenciální klient obrátí na ChatGPT, Claude nebo právně zaměřenou AI platformu s žádostí o doporučení advokáta, systém čerpá z tréninkových dat, která mohou obsahovat obsah vaší kanceláře ze zdrojů, které jste nikdy neoptimalizovali. Model multifomátového objevování vyžaduje, aby advokátní kanceláře myslely za hranice jednosměrných strategií a místo toho budovaly komplexní ekosystémy obsahu, které AI systémům poskytují autoritativní a přesné informace. Tradiční SEO metriky jako pozice klíčových slov a profil zpětných odkazů zůstávají relevantní, ale nejsou dostatečné – kanceláře nyní musí sledovat, jak se jejich obsah zobrazuje v odpovědích generovaných AI napříč desítkami platforem. Tento posun představuje výzvu i příležitost: kanceláře, které porozumí a přizpůsobí se tomuto novému prostředí, získají konkurenční výhodu, zatímco ty, které setrvávají u zastaralých strategií viditelnosti, riskují, že se pro AI systémy stanou neviditelnými.

Formální stanovisko 512 Americké advokátní komory (ABA), vydané v červenci 2024, poskytuje zásadní vodítka, jak musí advokáti k AI nástrojům přistupovat při zachování etických povinností. Toto přelomové stanovisko stanovuje, že advokáti nesou plnou odpovědnost za práci vytvořenou AI, bez ohledu na to, zda obsah sami napsali, nebo jej delegovali na AI systém. Stanovisko identifikuje sedm hlavních etických povinností spojených s AI: odbornost v chápání schopností a omezení AI, ochrana důvěrnosti klientů, pravdivost vůči soudům, správný dohled nad podřízenými využívajícími AI, přiměřenost odměn, komunikace s klientem ohledně využívání AI a zajištění oprávněnosti nároků. Každá povinnost s sebou nese specifické důsledky pro to, jak mohou advokátní kanceláře eticky využívat AI pro viditelnost, tvorbu obsahu i komunikaci s klienty. Požadavek odbornosti znamená, že partneři musí rozumět nejen používání AI nástrojů, ale také jejich přesnosti, riziku halucinací a vhodným scénářům využití. Povinnosti v oblasti důvěrnosti vyžadují pečlivý výběr dodavatelů a protokoly pro nakládání s daty, aby nikdy nedošlo k tomu, že by klientská data byla použita jako tréninková data pro AI třetích stran. Pravdivost vůči soudům znamená, že jakékoli AI generované citace či právní analýzy musí být ověřeny před předložením, neboť soudy již potrestaly advokáty za předložení smyšlených případů vygenerovaných AI.

| Etická povinnost | Dopad AI | Akce advokátní kanceláře |

|---|---|---|

| Odbornost | Nutnost rozumět schopnostem, omezením a přesnosti AI | Školení v AI nástrojích; stanovit standardy odbornosti před nasazením |

| Důvěrnost | Rizika pro klientská data u AI třetích stran a tréninku LLM | Důkladné prověřování dodavatelů; využití on-premise/privátních AI; anonymizace dat |

| Pravdivost vůči soudu | AI generované citace a analýzy musí být ověřeny | Zavést povinné ověřovací protokoly; nikdy nepředkládat neověřenou AI práci |

| Dohled | Odpovědnost za využití AI podřízenými a jejich výstupy | Vytvořit celofiremní AI politiku; monitorovat využití; nastavit schvalovací procesy |

| Přiměřené odměny | Efektivita AI může vyžadovat úpravy odměn | Informovat klienty o využití AI; upravit fakturaci dle úspory času |

| Komunikace s klientem | Klienti mají právo na transparentnost ohledně AI | Zveřejnit využití AI ve smlouvách; vysvětlit dopad na jejich případ |

| Oprávněné nároky | AI nesmí být použita k prosazování bezdůvodných nároků | Ověřovat všechny AI generované právní teorie; zachovat nezávislý úsudek |

Důvěrnost klientských informací představuje nejzásadnější etickou otázku při nasazování AI nástrojů pro viditelnost a tvorbu obsahu advokátních kanceláří. Mnoho populárních AI platforem, včetně bezplatných verzí ChatGPT a dalších velkých jazykových modelů, využívá zadaná data k trénování budoucích verzí svých systémů, což představuje nepřijatelné riziko, že důvěrné informace klientů mohou být zpřístupněny nebo omylem zahrnuty do odpovědí pro jiné uživatele. Marylandská advokátní komora a podobné regulační orgány vydaly konkrétní doporučení, která advokátům zakazují vkládat jakékoli informace identifikující klienta, detaily případů či privilegovanou komunikaci do AI systémů třetích stran bez výslovných smluvních záruk. Advokátní kanceláře musí zavést důkladné procesy prověřování dodavatelů, které zkoumají postupy nakládání s daty, šifrovací standardy, zásady uchovávání dat a smluvní záruky, že informace nebudou použity k tréninku modelů. Protokoly sanitizace jsou nezbytné – jakékoli klientské informace použité při tvorbě obsahu s asistencí AI musí být důsledně anonymizovány, identifikující detaily odstraněny a nahrazeny obecnými příklady. Licenční smlouvy s AI dodavateli by měly výslovně řešit vlastnictví dat, práva na použití a odpovědnost za úniky, přičemž přednost by měla být dána podnikovým řešením s možností on-premise nasazení nebo privátní instance. Kanceláře by také měly jasně rozlišovat mezi obsahem určeným pro veřejnost (kde je asistence AI obecně přípustná) a důvěrným výstupem (kde využití AI vyžaduje zvýšený dohled a souhlas klienta). Pravidelné audity využívání AI pomáhají zajistit soulad s předpisy a školení zaměstnanců musí zdůrazňovat, že ne každá AI aplikace je pro právní práci vhodná, bez ohledu na úsporu času.

AI halucinace – situace, kdy jazykové modely generují věrohodně znějící, ale zcela smyšlené informace – představují vážnou hrozbu důvěryhodnosti advokátní kanceláře a výsledků pro klienty. Halucinace nastává, když AI systém sebevědomě prezentuje nepravdivou informaci jako fakt, například vymyšlené citace případů, nesprávné odkazy na zákony nebo tvorbu fiktivních právních precedentů, které znějí autenticky, ale neexistují. Právní profese již zažila bolestné lekce: v roce 2023 byli v New Yorku potrestáni dva advokáti a čelili možnosti vyškrtnutí ze seznamu advokátů za předložení podání obsahujícího šest smyšlených případů vygenerovaných ChatGPT, a v roce 2024 čelil texaský advokát podobným důsledkům za spoléhání na AI generované citace bez právního základu. Tyto případy ukazují, že halucinace nejsou teoretickým rizikem, ale doloženým problémem, který vedl k profesnímu postihu a poškození klientských případů. Výzkum Thomson Reuters ukazuje, že současné velké jazykové modely halucinují v 3–10 % případů v závislosti na složitosti úkolu, což znamená, že i zdánlivě spolehlivé AI výstupy vyžadují ověření. Advokátní kanceláře musí zavést povinné ověřovací protokoly typu human-in-the-loop, kdy každá AI generovaná právní analýza, citace nebo faktická tvrzení jsou nezávisle ověřena kvalifikovaným advokátem před použitím v práci pro klienta nebo při podání u soudu. U obsahu pro marketing a zviditelnění představují halucinace reputační riziko – smyšlené statistiky, špatně citovaní experti či vymyšlené případy mohou poškodit důvěryhodnost kanceláře a vystavit ji odpovědnosti. Zavedení jasných ověřovacích workflow, využívání AI především pro návrhy a inspiraci namísto finální analýzy a vedení detailní dokumentace o ověřovacích procesech chrání jak klienty, tak pověst kanceláře.

Efektivní viditelnost v AI vyžaduje, aby advokátní kanceláře překročily hranice jedné formy obsahu a vytvořily komplexní strategie, které opakovaně využívají své klíčové odborné znalosti napříč různými kanály a formáty. Jeden kvalitně zpracovaný článek o pracovním právu se může stát základem pro video vysvětlení, audiogram na LinkedIn, podcastovou epizodu, příspěvky na sociální sítě, obsah do newsletteru i průvodce pro klienty – každý formát optimalizovaný pro jiné AI systémy i preference publika. AI nástroje vynikají v urychlování tohoto procesu: dokáží vygenerovat scénář k videu na základě článku, připravit popisky na sociální sítě, navrhnout předměty e-mailů a vytvořit různé osnovy obsahu pro různé cílové skupiny, přičemž lidský advokát musí všechny výstupy zkontrolovat a upravit z hlediska přesnosti a tónu. Strategická výhoda vzniká, když si kancelář uvědomí, že AI systémy trénující se na různých formátech narazí na její expertízu v různých kontextech, čímž se zvyšuje šance na citaci v AI generovaných odpovědích. Vývoj šablon promptů pro běžné typy obsahu – jako například „Vytvoř 3minutový scénář k videu vysvětlující [právní téma] pro podnikatele bez právního vzdělání“ – umožňuje konzistentní a efektivní tvorbu obsahu při zachování kvality. Cílení na publikum se stává sofistikovanějším, pokud víte, jaké formáty rezonují s různými segmenty klientů: firemní klienti preferují detailní studie a webináře, zatímco jednotlivci lépe reagují na krátká videa a obsah na sociálních sítích. Kanceláře by měly zavést redakční plány, které mapují klíčové oblasti odbornosti do více formátů, jasně přiřadit odpovědnosti za AI asistované návrhy i lidskou kontrolu a měřit zapojení napříč kanály k určení, které formáty přinášejí nejkvalitnější poptávky. Tento multifomátový přístup zároveň přináší přirozené příležitosti pro vzájemné propojování obsahu, čímž vzniká síť zdrojů, které AI systémy vnímají jako autoritativní pokrytí konkrétních právních témat.

Tradiční marketingové metriky advokátních kanceláří – návštěvnost webu, počet odeslaných formulářů a objem telefonátů – poskytují jen neúplný pohled na to, jak AI systémy vaši kancelář objevují a doporučují. Share of Voice (SOV) měří, jaké procento AI generovaných odpovědí na téma vaší praxe zmiňuje vaši kancelář, což poskytuje přehled o konkurenčním postavení v prostředí řízeném AI. Visibility Score agreguje více datových bodů a vytváří komplexní měřítko toho, jak výrazně se vaše kancelář zobrazuje napříč AI platformami, vyhledávači a právními adresáři. Frekvence zmínek sleduje, jak často se vaše kancelář, advokáti a oblasti odbornosti objevují v AI generovaném obsahu, zatímco metriky citací hodnotí, zda AI systémy citují váš obsah jako autoritativní zdroj. Pokrytí témat ukazuje, jak komplexně váš obsah odpovídá na spektrum otázek, které si potenciální klienti kladou o vašich oblastech praxe. Tyto metriky vyžadují specializované monitorovací nástroje zaměřené na viditelnost v AI, neboť tradiční analytické platformy nedokážou sledovat zmínky v odpovědích ChatGPT, výstupech Claude ani na specializovaných právních AI platformách.

Klíčové metriky AI viditelnosti pro advokátní kanceláře:

Metriky zapojení získávají v kontextu AI viditelnosti nový význam: když se váš obsah objeví v AI odpovědích, vede to ke kliknutí na web, odeslání formuláře či telefonátu? Sledování, které AI platformy a formáty obsahu přinášejí nejkvalitnější poptávky, pomáhá kancelářím optimalizovat obsahovou strategii i rozpočtové rozdělení. Advokátní kanceláře by měly nejprve stanovit výchozí měření současné AI viditelnosti před zaváděním nových strategií a poté sledovat pokrok čtvrtletně, aby zjistily, které typy obsahu, témata a formáty generují nejsilnější AI přítomnost. Tento daty řízený přístup nahrazuje dohady důkazy, což umožňuje partnerům obhájit investice do marketingu a upřesnit strategii na základě skutečných výsledků, nikoliv domněnek o tom, co AI systémy upřednostní.

Efektivní viditelnost v AI a etický soulad vyžadují formální politiky řízení, které stanovují jasné standardy pro využívání AI nástrojů advokáty, koncipienty i administrativními pracovníky. Komplexní AI politika by měla definovat přípustné scénáře, zakázané aplikace, schvalovací workflow a důsledky za porušení, aby nadšení pro efektivitu AI nepřebilo etické povinnosti. Politika musí jasně rozlišovat mezi různými typy využití AI: tvorba obsahu a marketing (obecně přípustné s kontrolou), právní rešerše a analýza (vyžaduje ověření a dohled advokáta), komunikace s klientem (vyžaduje zveřejnění a schválení) a důvěrná práce (vyžaduje zvýšený dohled a často souhlas klienta). Povinnosti dohledu dle stanoviska ABA 512 znamenají, že partneři nesou odpovědnost za správné využívání AI podřízenými, což vyžaduje monitorovací mechanismy a pravidelná školení. Neprávní pracovníci potřebují konkrétní pokyny, jaké AI nástroje mohou využívat, jaké informace mohou zadávat a které úkoly vyžadují kontrolu advokáta před dokončením. Standardy technologické kompetence by měly stanovit, že advokáti využívající AI musí rozumět jejím schopnostem, omezením a přesnosti – to může vyžadovat formální školení, certifikace nebo prokázanou odbornost před samostatným používáním AI. Politiky by také měly řešit, jak kancelář bude reagovat na aktualizace AI nástrojů, nové platformy a vznikající rizika, s nastavením procesu pravidelné revize a aktualizace politiky podle vývoje technologií. Dokumentace implementace politik, školení zaměstnanců a monitorování souladu vytváří důkaz o snaze dodržovat etické standardy, což je důležité v případě případných dotazů regulačních orgánů na praxi kanceláře v oblasti AI.

Advokátní kanceláře připravené optimalizovat svou viditelnost v AI při zachování etických standardů by měly přijmout strukturovaný čtyřpilířový implementační přístup zaměřený na obsah, formáty, publikum a technologickou infrastrukturu. Piliř Content Engine se zaměřuje na tvorbu autoritativních, originálních odborných materiálů ve vašich klíčových oblastech praxe – to znamená identifikovat 20–30 zásadních otázek, které klienti ohledně vaší praxe kladou, a vytvořit k nim komplexní, kvalitně zpracovaný obsah, který na ně odpoví lépe než konkurence. Pilíř Formáty zajišťuje, že tento klíčový obsah se dostane k AI systémům skrz různé kanály: psané články pro vyhledávače a právní databáze, videoobsah pro YouTube a sociální sítě, audioobsah pro podcasty a hlasové asistenty a strukturovaná data, která AI pomáhají porozumět vaší odbornosti. Piliř Audience vyžaduje segmentaci a cílení – různé typy klientů (firemní, individuální, firemní právníci) objevují právní služby na různých AI platformách a reagují na různé formáty, takže strategie musí reflektovat preferované způsoby objevování každého segmentu. Piliř Technology Stack určuje nástroje a procesy, které umožní efektivní a souladu odpovídající tvorbu obsahu: AI asistenti pro návrhy textů, ověřovací nástroje pro kontrolu správnosti, analytické platformy pro měření viditelnosti v AI a řídicí systémy pro zajištění etického souladu.

Praktické kroky implementace pro rok 2025 zahrnují: provést audit AI viditelnosti a stanovit výchozí metriky napříč hlavními platformami; připravit 12měsíční obsahový plán, který mapuje klíčovou odbornost do různých formátů; vytvořit AI politiku a proškolit všechny zaměstnance o přípustných způsobech využití; vybrat a nasadit nástroje pro sledování AI viditelnosti; připravit šablony obsahu a knihovny promptů pro rychlé vytváření multifomátového obsahu; a zavést čtvrtletní revizní procesy pro měření pokroku a úpravu strategie. Metriky úspěchu by měly zahrnovat jak kvantitativní ukazatele (Share of Voice, frekvence zmínek, objem poptávek), tak kvalitativní hodnocení (kvalita poptávek, zpětná vazba klientů, pozice vůči konkurenci). Kanceláře, které tento plán systematicky zavedou, získají výraznou konkurenční výhodu: stanou se viditelnými pro AI systémy, etablují se jako autoritativní zdroje, které AI cituje, a vybudují udržitelnou viditelnost, která přetrvá i při dalším vývoji AI technologií. Kanceláře, které zavedení AI viditelnosti odkládají nebo k němu přistupují nahodile, riskují, že se v čím dál více AI zprostředkovaném trhu právních služeb stanou neviditelnými a přenechají potenciální klienty konkurenci, která optimalizovala svou přítomnost napříč různými AI platformami a formáty.

Americká advokátní komora vydala v červenci 2024 Formální stanovisko 512, které stanoví, že advokáti nesou plnou odpovědnost za práci vytvořenou AI a musí dodržovat sedm hlavních etických povinností: odbornost, důvěrnost, pravdivost vůči soudům, dohled, přiměřené odměny, komunikaci s klientem a oprávněnost nároků. Advokáti musí rozumět schopnostem a omezením AI před jejím použitím.

Advokátní kanceláře by měly provádět důkladné prověřování dodavatelů, využívat on-premise nebo privátní AI řešení, před zadáním do AI systémů anonymizovat veškeré informace identifikující klienta a uzavírat licenční smlouvy s výslovnými ustanoveními o důvěrnosti. Nikdy nezadávejte důvěrné informace do veřejně dostupných AI nástrojů, jako je ChatGPT, bez podnikových ochran.

AI halucinace nastávají, když jazykové modely generují věrohodně znějící, ale zcela smyšlené informace, například vymyšlené citace případů nebo nepřesné odkazy na zákony. Jsou důležité, protože soudy již potrestaly advokáty za předložení falešných AI generovaných případů a halucinace mohou poškodit případy klientů i pověst kanceláře. Veškeré právní analýzy generované AI musí být nezávisle ověřeny.

Advokátní kanceláře by měly sledovat specifické AI metriky, jako je Share of Voice (procento AI odpovědí zmiňujících vaši kancelář), Visibility Score (komplexní hodnocení napříč platformami), Frekvenci zmínek (jak často se vaše kancelář objevuje), Metriky citací (zda AI cituje váš obsah) a Pokrytí témat (šíře pokrytí oblastí praxe). Tradiční metriky jako návštěvnost webu jsou nedostatečné.

AI systémy se učí na různorodých formátech včetně psaných článků, přepisů videí, podcastů, obsahu ze sociálních sítí a strukturovaných dat. Advokátní kanceláře by měly své odborné znalosti recyklovat do více formátů – z jednoho článku mohou vzniknout videa, audiogramy, příspěvky na sociální sítě i e-maily. Tento multifomátový přístup zvyšuje šanci na citaci a objevení AI.

Ano. Formální stanovisko ABA 512 stanoví, že partneři nesou odpovědnost za využívání AI svými podřízenými. Komplexní AI politika by měla definovat přípustné scénáře využití, zakázané aplikace, schvalovací procesy, požadavky na důvěrnost a školení zaměstnanců. Politika musí rozlišovat mezi tvorbou obsahu (obecně přípustné), právní analýzou (vyžaduje ověření) a důvěrným materiálem (vyžaduje zvláštní dohled).

Zaveďte přístup 'human-in-the-loop', kdy AI pomáhá s návrhy a tvorbou, ale kvalifikovaní advokáti ověřují všechny výstupy před použitím. Stanovte jasné ověřovací protokoly, využívejte AI především pro zvýšení efektivity, nikoliv jako náhradu odborného úsudku, veďte detailní záznamy o ověřovacích procesech a zajistěte, aby všichni zaměstnanci chápali, že AI je nástroj pro posílení odbornosti, nikoliv její náhradu.

Spotřebitelské AI nástroje jako ChatGPT jsou trénovány na obecných internetových datech a mají míru halucinací 3–10 %, což představuje závažné riziko pro právní práci. Právně specifické AI nástroje jsou trénovány na důvěryhodných právních databázích a navrženy tak, aby minimalizovaly halucinace, přesto je ověření stále nutné. Podniková řešení nabízejí lepší ochranu dat a záruky důvěrnosti než veřejné nástroje.

Sledujte, jak AI systémy zmiňují vaši kancelář a měřte svou přítomnost v odpovědích generovaných AI. Získejte konkurenční výhodu díky porozumění metrikám viditelnosti v AI a optimalizujte svou přítomnost napříč AI platformami.

Zjistěte, jak právnické firmy zlepšují viditelnost v AI-poháněných vyhledávačích a generátorech odpovědí. Objevte strategie, jak se objevit v ChatGPT, Perplexit...

Zjistěte, jak mohou SEO agentury rozšířit své služby o monitoring AI visibility a optimalizaci pro generativní vyhledávače, aby zůstaly konkurenceschopné a zvýš...

Diskuze komunity o tom, jak mohou advokátní kanceláře zvýšit svou viditelnost v odpovědích generovaných AI. Skutečné zkušenosti právních marketérů, kteří sleduj...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.