Jak napadnout a opravit nepřesné informace v odpovědích AI

Zjistěte, jak napadnout nepřesné informace od AI, nahlásit chyby ChatGPT a Perplexity a zavést strategie pro zajištění přesného zobrazení vaší značky v odpovědí...

Oprava dezinformací v AI označuje strategie a nástroje pro identifikaci a řešení nesprávných informací o značce, které se objevují v odpovědích generovaných umělou inteligencí ze systémů jako ChatGPT, Gemini a Perplexity. Zahrnuje sledování toho, jak AI systémy prezentují značky, a zavádění oprav na úrovni zdrojů, aby byly přesné informace šířeny napříč důvěryhodnými platformami. Na rozdíl od tradičního ověřování faktů se zaměřuje na opravu zdrojů, kterým AI systémy důvěřují, nikoli samotných výstupů AI. To je zásadní pro udržení pověsti značky a přesnosti v prostředí vyhledávání řízeném AI.

Oprava dezinformací v AI označuje strategie a nástroje pro identifikaci a řešení nesprávných informací o značce, které se objevují v odpovědích generovaných umělou inteligencí ze systémů jako ChatGPT, Gemini a Perplexity. Zahrnuje sledování toho, jak AI systémy prezentují značky, a zavádění oprav na úrovni zdrojů, aby byly přesné informace šířeny napříč důvěryhodnými platformami. Na rozdíl od tradičního ověřování faktů se zaměřuje na opravu zdrojů, kterým AI systémy důvěřují, nikoli samotných výstupů AI. To je zásadní pro udržení pověsti značky a přesnosti v prostředí vyhledávání řízeném AI.

Oprava dezinformací v AI označuje strategie, procesy a nástroje používané k identifikaci a řešení nesprávných, zastaralých nebo zavádějících informací o značkách, které se objevují v odpovědích generovaných umělou inteligencí ze systémů jako ChatGPT, Gemini a Perplexity. Nedávné výzkumy ukazují, že přibližně 45 % AI dotazů vede k chybným odpovědím, což činí přesnost značky v AI systémech zásadním tématem pro firmy. Na rozdíl od tradičních výsledků vyhledávání, kde mohou značky ovládat své vlastní zápisy, AI systémy syntetizují informace z více zdrojů napříč internetem, což vytváří složité prostředí, kde mohou dezinformace tiše přetrvávat. Výzvou není jen opravovat jednotlivé odpovědi AI – jde o pochopení toho, proč AI systémy získávají informace o značce chybně, a o zavádění systematických oprav na úrovni zdrojů.

AI systémy si informace o značce nevymýšlejí – skládají je z toho, co již existuje na internetu. Tento proces však vytváří několik předvídatelných slabin, které vedou ke zkreslení značky:

| Hlavní příčina | Jak vzniká | Dopad na podnikání |

|---|---|---|

| Nekonzistence zdrojů | Značka je popisována různě na webových stránkách, v adresářích a článcích | AI vyvozuje chybný konsenzus z rozporuplných informací |

| Zastaralé autoritativní zdroje | Staré záznamy na Wikipedii, v adresářích nebo srovnávacích stránkách obsahují nesprávná data | Novější opravy jsou ignorovány, protože starší zdroje mají vyšší autoritativní signály |

| Záměna entit | Podobná jména značek nebo překrývající se kategorie matou AI systémy | Konkurence získává zásluhy za vaše schopnosti nebo je značka zcela opomenuta |

| Chybějící primární signály | Nedostatek strukturovaných dat, jasných „O nás“ stránek nebo konzistentní terminologie | AI je nucena informace dovozovat, což vede k vágním nebo chybným popisům |

Pokud je značka popisována různě napříč platformami, AI systémy mají problém určit, která verze je autoritativní. Místo dotazování na upřesnění vyvozují konsensus na základě frekvence a vnímané autority – i když je tento konsensus chybný. Drobné rozdíly v názvech, popisech nebo pozicování značky se často duplikují napříč platformami a po opakování se tyto útržky stávají signály, které AI modely považují za důvěryhodné. Problém se zhoršuje, pokud zastaralé, ale autoritativní stránky obsahují nesprávné informace; AI systémy často upřednostňují tyto starší zdroje před novějšími opravami, zvláště pokud se opravy nerozšířily napříč důvěryhodnými platformami.

Oprava nesprávných informací o značce v AI systémech vyžaduje zásadně odlišný přístup než tradiční SEO. V tradičním SEO značky aktualizují své zápisy, opravují údaje NAP (název, adresa, telefon) a optimalizují obsah stránek. Oprava značky v AI se zaměřuje na změnu toho, co o vaší značce říkají důvěryhodné zdroje, nikoli na kontrolu vlastní viditelnosti. Neopravujete přímo AI – opravujete to, čemu AI důvěřuje. Snahy „opravit“ odpovědi AI opakováním chybných tvrzení (i v popření) mohou mít opačný efekt a posílit spojení, které se snažíte odstranit. AI systémy rozpoznávají vzorce, nikoli záměr. Každá oprava proto musí začínat na úrovni zdroje, tedy pracovat zpětně od místa, odkud se AI systémy skutečně učí informace.

Než opravíte nesprávné informace o značce, potřebujete přehled o tom, jak AI systémy vaši značku aktuálně popisují. Efektivní monitoring se zaměřuje na:

Ruční kontroly nejsou spolehlivé, protože AI odpovědi se mění podle dotazu, kontextu a aktualizačního cyklu. Strukturované monitorovací nástroje poskytují potřebný přehled pro včasnou detekci chyb, než se zakoření v AI systémech. Mnoho značek si zkreslení v AI neuvědomí, dokud je na něj neupozorní zákazník nebo nenastane krize. Proaktivní monitoring tomu předchází tím, že zachytí nekonzistence dříve, než se rozšíří.

Jakmile identifikujete nesprávné informace o značce, oprava musí proběhnout tam, kde se AI systémy skutečně učí – ne tam, kde se chyba pouze objevuje. Efektivní opravy na úrovni zdrojů zahrnují:

Klíčové pravidlo zní: opravy fungují pouze tehdy, jsou-li provedeny na úrovni zdrojů. Změna toho, co se objevuje ve výstupech AI bez opravy původních zdrojů, je nanejvýš dočasná. AI systémy neustále přehodnocují signály, jakmile se objeví nový obsah a starší stránky se znovu objeví. Oprava, která neřeší původní zdroj, bude nakonec přepsána původní dezinformací.

Při opravě nepřesných informací o značce v adresářích, tržištích nebo platformách využívaných AI většina systémů vyžaduje ověření, které spojí značku s legitimním vlastnictvím a užíváním. Nejčastěji požadovaná dokumentace zahrnuje:

Cílem není množství – ale konzistence. Platformy posuzují, zda dokumenty, zápisy a veřejně dostupná data o značce spolu souhlasí. Pokud máte tyto materiály připravené předem, snížíte počet odmítnutí a urychlíte schválení při opravě chybných informací ve větším měřítku. Konzistence napříč zdroji signalizuje AI systémům, že informace o vaší značce jsou spolehlivé a autoritativní.

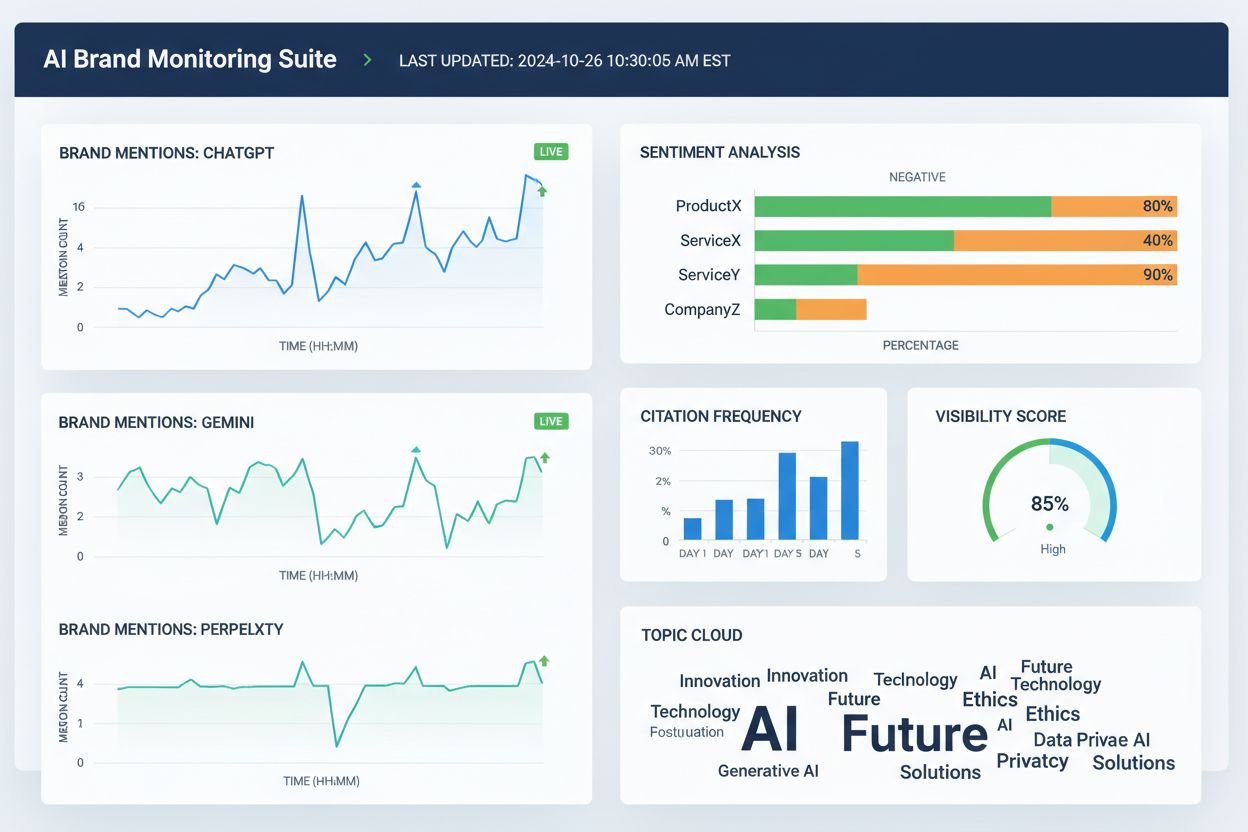

Několik nástrojů dnes pomáhá týmům sledovat prezentaci značky napříč AI vyhledávacími platformami a širším webem. Přestože se jejich možnosti překrývají, obecně se zaměřují na viditelnost, přiřazení a konzistenci:

Tyto nástroje přímo neopravují chybné informace o značce. Pomáhají však týmu včas odhalit chyby, identifikovat nesrovnalosti v datech o značce dříve, než se rozšíří, ověřit, zda opravy na úrovni zdrojů zlepšují přesnost AI, a sledovat dlouhodobé trendy v přiřazení a viditelnosti značky v AI. V kombinaci s opravami u zdrojů a dokumentací poskytují monitorovací nástroje zpětnou vazbu potřebnou pro udržitelnou opravu nesprávných informací o značce.

Přesnost vyhledávání v AI se zvyšuje, když jsou značky jasně definovanými entitami, ne vágními účastníky kategorie. Pro snížení zkreslení značky v AI systémech se zaměřte na:

Cílem není říkat více – ale říkat totéž všude. Když AI systémy narazí na konzistentní definice značky napříč autoritativními zdroji, přestanou hádat a začnou opakovat správné informace. Tento krok je zvláště důležitý pro značky, které zažívají chybné zmínky, přiřazení ke konkurenci nebo opomenutí v relevantních AI odpovědích. Ani po opravě chybných informací není přesnost trvalá. AI systémy signály neustále přehodnocují, což činí průběžnou jasnost zásadní.

Neexistuje žádný pevný časový rámec pro opravu zkreslení značky v AI systémech. AI modely se aktualizují na základě síly signálu a shody, nikoliv podle data zaslání. Typické vzorce zahrnují:

Počáteční pokrok se málokdy projeví náhlou „opravenou“ odpovědí. Sledujte spíše nepřímé signály: snížení variability AI odpovědí, méně konfliktních popisů, konzistentnější citace napříč zdroji a postupné zařazení vaší značky tam, kde dříve chyběla. Stagnace vypadá jinak – pokud přetrvává stejná chybná formulace i po několika opravách, obvykle to znamená, že původní zdroj nebyl opraven nebo je třeba silnější posílení jinde.

Nejspolehlivější způsob, jak opravit chybné informace o značce, je omezit podmínky, za kterých vznikají. Efektivní prevence zahrnuje:

Značky, které přistupují k AI viditelnosti jako k živému systému – nikoli jako k jednorázové opravě – se zotavují z chyb rychleji a zažívají méně opakovaných případů zkreslení značky. Prevence není o kontrole výstupů AI. Jde o udržování čistých, konzistentních vstupů, které mohou AI systémy s jistotou opakovat. Jak se vyhledávání pomocí AI dále vyvíjí, uspějí ty značky, které vnímají opravu dezinformací jako trvalý proces vyžadující průběžné sledování, správu zdrojů a strategické posilování správných informací napříč důvěryhodnými platformami.

Oprava dezinformací v AI je proces identifikace a nápravy nesprávných, zastaralých nebo zavádějících informací o značkách, které se objevují v odpovědích generovaných AI. Na rozdíl od tradičního ověřování faktů se zaměřuje na opravu zdrojů, kterým AI systémy důvěřují (adresáře, články, firemní zápisy), místo snahy přímo upravovat výstupy AI. Cílem je zajistit, aby uživatelé při dotazech na AI systémy ohledně vaší značky dostávali správné informace.

AI systémy jako ChatGPT, Gemini a Perplexity nyní ovlivňují, jak miliony lidí vnímají značky. Výzkumy ukazují, že 45 % AI dotazů obsahuje chyby a nesprávné informace o značce mohou poškodit pověst, zmást zákazníky a způsobit ztrátu obchodu. Na rozdíl od tradičního vyhledávání, kde mají značky kontrolu nad svými zápisy, AI systémy syntetizují informace z více zdrojů, což ztěžuje kontrolu přesnosti, ale dělá ji zároveň zásadní.

Ne, přímá oprava nefunguje efektivně. AI systémy neukládají fakta o značce na editovatelná místa – vytvářejí odpovědi syntézou z externích zdrojů. Opakované žádosti o 'opravu' informací mohou naopak posílit halucinace tím, že upevní spojení, které se snažíte odstranit. Opravy je proto nutné provádět na úrovni zdrojů: aktualizací adresářů, opravou zastaralých zápisů a publikováním správných informací na důvěryhodných platformách.

Neexistuje žádná pevně daná časová osa, protože AI systémy se aktualizují na základě síly signálu a shody, nikoliv podle data zadání. Menší faktické opravy se obvykle projeví během 2-4 týdnů, upřesnění na úrovni entity trvá 1-3 měsíce a vytěsnění konkurence může trvat 3-6 měsíců nebo i déle. Pokrok se málokdy projeví náhlou 'opravenou' odpovědí – sledujte spíše snížení variability odpovědí a větší konzistenci citací napříč zdroji.

Několik nástrojů nyní sleduje prezentaci značek napříč AI platformami: Wellows monitoruje zmínky a sentiment v ChatGPT, Gemini a Perplexity; Profound porovnává viditelnost napříč LLM; Otterly.ai analyzuje sentiment značky v AI odpovědích; BrandBeacon poskytuje analytiku pozicování; Ahrefs Brand Radar sleduje zmínky značky na webu; a AmICited.com se specializuje na monitoring citací a prezentace značek napříč AI systémy. Tyto nástroje pomáhají brzy odhalit chyby a ověřit, zda opravy fungují.

AI halucinace nastává, když AI systémy generují informace, které nejsou založené na trénovacích datech nebo jsou nesprávně dekódované. AI dezinformace jsou nepravdivé nebo zavádějící informace v AI výstupech, které mohou být výsledkem halucinací, ale také zastaralých zdrojů, záměny entit nebo nekonzistentních dat napříč platformami. Oprava dezinformací řeší jak halucinace, tak nepřesnosti na úrovni zdrojů, které vedou k chybnému zobrazení značky.

Sledujte, jak AI systémy popisují vaši značku tím, že se jich ptáte na vaši firmu, produkty a pozici na trhu. Hledejte zastaralé informace, nesprávné popisy, chybějící detaily nebo přisuzování informací konkurenci. Používejte monitorovací nástroje ke sledování zmínek v ChatGPT, Gemini a Perplexity. Zkontrolujte, zda vaše značka nechybí v relevantních AI odpovědích. Porovnávejte AI popisy s oficiálními informacemi vaší značky a hledejte nesrovnalosti.

Jde o trvalý proces. AI systémy neustále přehodnocují signály, jakmile se objeví nový obsah nebo se znovu objeví starší stránky. Jednorázová oprava bez průběžného sledování nakonec zanikne pod původními dezinformacemi. Úspěšné značky přistupují k AI viditelnosti jako k živému systému, udržují konzistentní definice značky napříč zdroji, pravidelně kontrolují adresáře a dlouhodobě sledují zmínky v AI, aby včas odhalily nové chyby.

Sledujte, jak AI systémy jako ChatGPT, Gemini a Perplexity prezentují vaši značku. Získejte v reálném čase přehled o zmínkách značky, citacích a viditelnosti napříč AI platformami s AmICited.com.

Zjistěte, jak napadnout nepřesné informace od AI, nahlásit chyby ChatGPT a Perplexity a zavést strategie pro zajištění přesného zobrazení vaší značky v odpovědí...

Naučte se efektivní metody, jak identifikovat, ověřovat a opravovat nepřesné informace v odpovědích generovaných umělou inteligencí, jako je ChatGPT, Perplexity...

Diskuze komunity o napadání nepřesných AI informací o firmách a produktech. Skutečné zkušenosti brand manažerů s formálními procesy sporů a co skutečně přináší ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.