Viditelnost AI ve finančních službách: Soulad s předpisy a optimalizace

Sledujte, jak se vaše finanční značka objevuje v odpovědích generovaných umělou inteligencí. Zjistěte požadavky na soulad s předpisy, strategie viditelnosti a o...

Regulační požadavky na finanční instituce transparentně zveřejňovat využívání umělé inteligence v rozhodovacích procesech, řízení rizik a zákaznických aplikacích. Zahrnuje očekávání regulátorů jako SEC, CFPB, FINRA a dalších ohledně dokumentace řízení AI, výkonnosti modelů a dopadů na spotřebitele a trhy.

Regulační požadavky na finanční instituce transparentně zveřejňovat využívání umělé inteligence v rozhodovacích procesech, řízení rizik a zákaznických aplikacích. Zahrnuje očekávání regulátorů jako SEC, CFPB, FINRA a dalších ohledně dokumentace řízení AI, výkonnosti modelů a dopadů na spotřebitele a trhy.

Finanční AI zveřejňování označuje regulační požadavky a osvědčené postupy pro finanční instituce ohledně transparentního zveřejňování využívání umělé inteligence v rozhodovacích procesech, řízení rizik a zákaznických aplikacích. Zahrnuje očekávání regulátorů jako SEC, CFPB, FINRA a dalších ohledně dokumentace řízení AI, výkonnosti modelů a potenciálních dopadů na spotřebitele a trhy. V prosinci 2024 Poradní výbor investorů SEC (IAC) předložil formální doporučení, aby agentura vydala pokyny vyžadující po emitentech zveřejňovat informace o dopadu umělé inteligence na jejich společnosti. IAC poukázal na „nedostatek konzistence“ v současných AI zveřejněních, což „může být problematické pro investory hledající jasné a srovnatelné informace“. Pouze 40 % společností v S&P 500 poskytuje zveřejnění týkající se AI a jen 15 % zveřejňuje informace o dohledu představenstva nad AI, přestože 60 % společností v S&P 500 vnímá AI jako zásadní riziko.

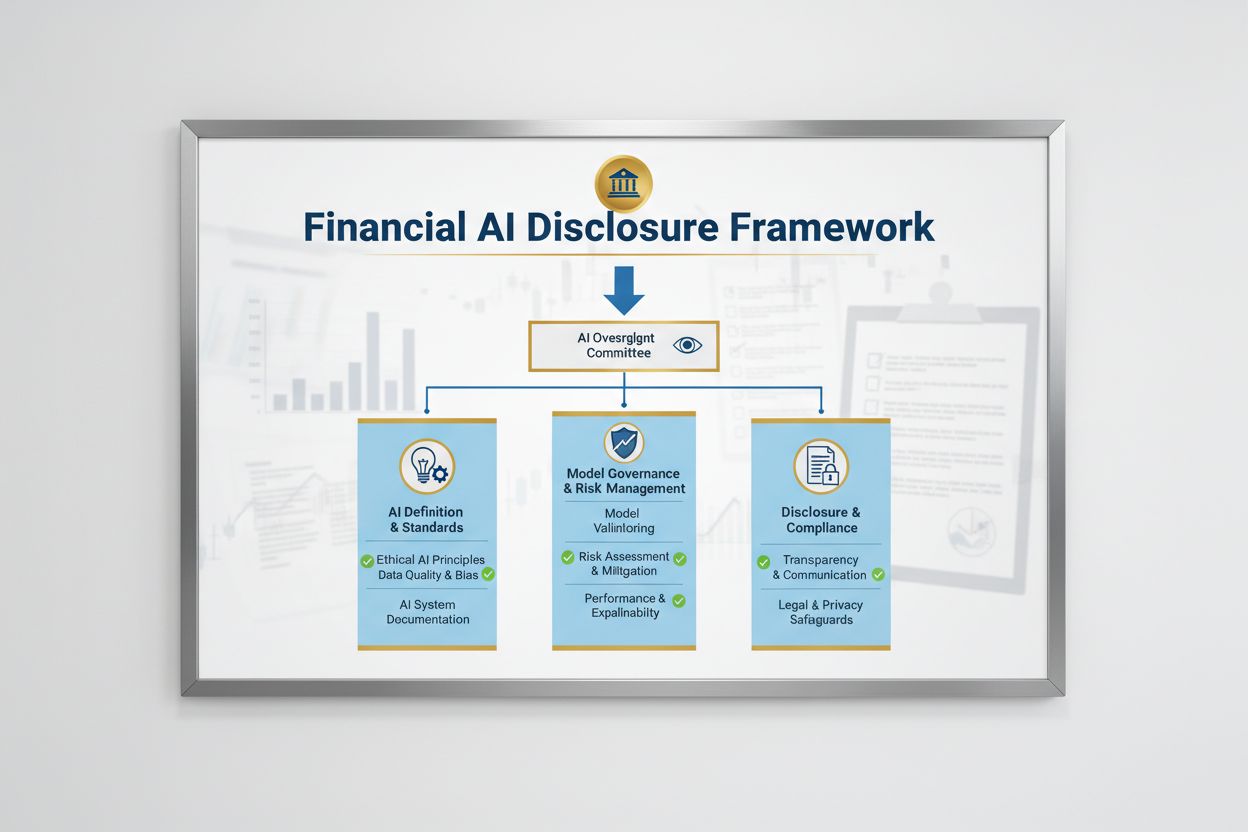

Regulační prostředí pro finanční AI zveřejňování je utvářeno více federálními agenturami, které aplikují stávající technologicky neutrální zákony na AI systémy. Poradní výbor investorů SEC navrhl úvodní rámec se třemi klíčovými pilíři: (1) požadovat po emitentech, aby definovali, co znamená „umělá inteligence“, (2) zveřejnit mechanismy dohledu představenstva nad nasazením AI a (3) reportovat zásadní nasazení AI a jejich dopady na interní provoz a produkty pro klienty. Kromě SEC vydaly pokyny i CFPB, FINRA, OCC a Federální rezervní systém, které zdůrazňují, že stávající zákony na ochranu spotřebitele – včetně zákonů o férovém poskytování úvěrů, ochraně osobních údajů a proti podvodům – platí na AI systémy bez ohledu na použitou technologii. Tyto agentury zaujímají technologicky neutrální přístup, což znamená, že povinnosti podle Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) a standardů UDAAP zůstávají při využití AI beze změny.

| Regulátor | Oblast zaměření | Klíčový požadavek |

|---|---|---|

| SEC | Zveřejňování investorům, střet zájmů | Definovat AI, zveřejnit dohled představenstva, reportovat zásadní nasazení |

| CFPB | Férové úvěrování, ochrana spotřebitele | Zajistit soulad AI modelů s ECOA, poskytovat oznámení o zamítnutí |

| FINRA | Provoz brokerů, komunikace se zákazníky | Nastavit pravidla řízení AI, dohlížet na využití AI ve všech funkcích |

| OCC/Federal Reserve/FDIC | Řízení bankovních modelů, provozní riziko | Validovat AI modely, dokumentovat kontroly, hodnotit spolehlivost |

| FTC | Nekalé praktiky, nakládání s daty | Monitorovat tvrzení týkající se AI, zabránit neférovému využití dat |

Efektivní finanční AI zveřejňování vyžaduje jasný dohled představenstva nad nasazením umělé inteligence a řízením rizik. Doporučení IAC SEC zdůrazňuje, že investoři mají legitimní zájem rozumět tomu, zda existují jasné pravomoci ohledně nasazení AI technologií v rámci interního provozu a produktových řad. Finanční instituce musí vytvořit řídící struktury, které přiřazují odpovědnost za dohled nad AI představenstvu nebo určenému výboru a zajišťují, že AI rizika jsou řízena na nejvyšší úrovni organizace. Tento rámec řízení by měl obsahovat dokumentované politiky a postupy pro vývoj, testování, validaci a nasazení AI s pravidelným reportováním představenstvu o výkonnosti modelů, identifikovaných rizicích a nápravných krocích. Bez jasné odpovědnosti představenstva riskují finanční instituce regulační dohled a možné postihy za nedostatečný dohled nad zásadními AI systémy.

Finanční instituce musí odděleně zveřejnit zásadní dopady nasazení AI na interní provoz a produkty pro klienty. U interního provozu by zveřejnění mělo zahrnovat dopad AI na lidský kapitál (například snižování počtu zaměstnanců nebo potřebu rekvalifikace), přesnost finančního výkaznictví, procesy řízení a kybernetická rizika. U produktů pro klienty by instituce měly zveřejnit investice do platforem poháněných AI, integraci AI do produktů a služeb, regulační dopady využití AI a způsob, jakým AI ovlivňuje cenovou politiku nebo obchodní standardy. SEC doporučuje začlenit tato zveřejnění do stávajících položek Regulation S-K (jako jsou položky 101, 103, 106 a 303) na základě významnosti, namísto vytváření zcela nových kategorií. Tento přístup umožňuje finančním institucím využít stávající rámce zveřejňování a zároveň poskytovat investorům jasné a srovnatelné informace o roli AI v provozu a strategii organizace.

Kvalitní data jsou základem odpovědného nasazení AI ve finančních službách, přesto mnoho institucí bojuje s nastavením odpovídajících rámců pro správu dat splňujících očekávání regulátorů. Finanční instituce musí zajistit, že data používaná k trénování, testování a validaci AI modelů jsou čistá, úplná, standardizovaná a komplexní, s jasnou dokumentací zdrojů, původu a případných omezení. Ochrana dat musí zabránit „otravení dat“ – manipulaci s trénovacími daty za účelem narušení integrity modelu – a chránit před neoprávněným přístupem nebo únikem citlivých informací. Gramm-Leach-Bliley Act (GLBA) stanovuje základní ochranu pro finanční data spotřebitelů, ale mnoho regulátorů i spotřebitelských organizací argumentuje, že tyto ochrany jsou v AI kontextu nedostatečné, zejména vzhledem k rozšíření sběru a využití dat pro trénování modelů. Finanční instituce musí řešit i otázky duševního vlastnictví – zajistit, že mají oprávnění data pro vývoj AI použít a že respektují práva třetích stran. Zavedení robustních rámců správy dat, včetně principů minimalizace dat, řízení přístupů a pravidelných auditů, je nezbytné pro doložení souladu s požadavky regulátorů.

Regulační orgány jasně stanovily, že AI modely používané při finančním rozhodování musí být testovány na předsudky a potenciální diskriminační dopady, bez ohledu na celkovou přesnost nebo výkonnost modelu. Problém „černé skříňky“ – kdy komplexní AI systémy produkují výstupy, které je obtížné nebo nemožné vysvětlit – vytváří významné riziko nesouladu zejména v zákaznických aplikacích, jako je schvalování úvěrů, oceňování nebo detekce podvodů. Finanční instituce musí implementovat procesy na detekci a zmírnění předsudků v celém životním cyklu modelu, včetně testování během vývoje, validace i průběžného monitoringu. Shoda s férovým úvěrováním vyžaduje, aby instituce uměly vysvětlit konkrétní důvody negativních rozhodnutí (například zamítnutí úvěru) a prokázat, že modely nemají nepřiměřený dopad na chráněné skupiny. Testování „méně diskriminačních alternativ“ – metod, které plní stejné podnikatelské cíle s menší zaujatostí – regulátoři stále častěji očekávají. Mnoho institucí proto zavádí vysvětlitelnou AI (xAI), například analýzu významnosti proměnných či rozhodovací stromy, pro lepší transparentnost a odpovědnost při rozhodování poháněném AI.

Finanční instituce využívající AI v zákaznických aplikacích musí dodržovat stávající zákony na ochranu spotřebitele, včetně požadavků na oznámení o zamítnutí, zveřejnění ochrany údajů a férové zacházení. Pokud je AI systém použit k rozhodnutí nebo významnému ovlivnění rozhodnutí o úvěru, pojištění či jiných finančních produktech, mají spotřebitelé právo vědět, proč byli odmítnuti nebo jim byly nabídnuty méně výhodné podmínky. CFPB zdůrazňuje, že věřitelé, na které se vztahuje Equal Credit Opportunity Act (ECOA), nesmí používat „černé skříňky“, kde nelze poskytnout specifické a přesné důvody negativních rozhodnutí. Kromě toho se na AI systémy, které mohou poškodit spotřebitele neprůhledným sběrem údajů, porušením soukromí nebo naváděním k nevhodným produktům, vztahuje standard UDAAP (Unfair or Deceptive Acts or Practices). Finanční instituce musí zajistit, že AI systémy v zákaznickém servisu, doporučování produktů a správě účtů jsou transparentní ohledně využití AI a jasně informují, jak jsou zákaznická data sbírána, využívána a chráněna.

Většina finančních institucí spoléhá na dodavatele třetích stran pro vývoj, nasazení či správu AI systémů, což přináší významné povinnosti v oblasti řízení rizik třetích stran (TPRM). Meziagenturní pokyny federálních bankovních agentur ke vztahům s třetími stranami zdůrazňují, že finanční instituce zůstávají odpovědné za výkon a soulad AI systémů třetích stran, i když model samy nevyvinuly. Efektivní TPRM pro AI vyžaduje důkladnou prověrku před navázáním spolupráce, včetně posouzení řízení dat dodavatele, procesů validace modelu a schopnosti poskytnout transparentnost ohledně fungování modelu. Finanční instituce musí sledovat i riziko koncentrace – potenciální systémové dopady, pokud by se u malého počtu poskytovatelů AI vyskytly výpadky či selhání. Je třeba vyhodnotit i rizika v dodavatelském řetězci, včetně spolehlivosti zdrojů dat a stability infrastruktury třetích stran, a vše dokumentovat. Smlouvy s dodavateli AI by měly obsahovat jasné požadavky na zabezpečení dat, monitoring výkonu modelu, hlášení incidentů a možnost auditu či testování AI systému. Zejména menší finanční instituce mohou mít nedostatek technické expertizy k posouzení komplexních AI systémů, což vytváří potřebu oborových standardů nebo certifikačních programů pro snazší hodnocení dodavatelů.

Finanční instituce působící přes hranice čelí stále složitější mozaice AI regulací, přičemž Zákon o AI Evropské unie je dosud nejkomplexnějším regulačním rámcem. EU AI Act klasifikuje systémy AI používané při posuzování úvěruschopnosti, prevenci podvodů a boji proti praní špinavých peněz jako „vysokorizikové“, což vyžaduje rozsáhlou dokumentaci, testování předsudků, lidský dohled a posouzení shody. OECD a G7 vydaly principy a doporučení pro odpovědné řízení AI ve finančních službách, které kladou důraz na transparentnost, férovost, odpovědnost a lidský dohled. Mnohé z těchto mezinárodních standardů mají mimořádný dosah, což znamená, že finanční instituce obsluhující klienty v EU, Velké Británii nebo jiných regulovaných jurisdikcích je mohou muset dodržovat i v případě, že sídlí jinde. Snahy o harmonizaci regulací pokračují, ale mezi jurisdikcemi stále existují významné rozdíly, což představuje výzvu pro globální finanční instituce. Proaktivní sladění s nejpřísnějšími mezinárodními standardy – například EU AI Act a principy OECD – může institucím pomoci připravit se na budoucí regulační změny a snížit riziko postihů napříč jurisdikcemi.

Finanční instituce by měly zavést komplexní dokumentaci a řízení, aby doložily soulad s očekáváními v oblasti finančního AI zveřejňování. Klíčové osvědčené postupy zahrnují:

Přijetím těchto postupů mohou finanční instituce snížit regulační rizika, posílit důvěru zainteresovaných stran a profilovat se jako lídři v odpovědném nasazení AI v sektoru finančních služeb.

Finanční AI zveřejňování označuje regulační požadavky na finanční instituce transparentně zveřejňovat využívání umělé inteligence v rozhodování, řízení rizik a zákaznických aplikacích. Zahrnuje očekávání regulátorů jako SEC, CFPB, FINRA a dalších ohledně dokumentace řízení AI, výkonnosti modelů a dopadů na spotřebitele a trhy. Poradní výbor investorů SEC v prosinci 2024 doporučil, aby finanční instituce definovaly využití AI, zveřejnily dozor představenstva a reportovaly zásadní nasazení AI.

Finanční instituce musí zveřejňovat využití AI k ochraně investorů, spotřebitelů a integrity trhu. Regulátoři zjistili, že pouze 40 % společností v S&P 500 poskytuje zveřejnění týkající se AI, což vytváří nekonzistentnost a informační mezery pro investory. Požadavky na zveřejňování zajišťují, že zainteresované strany rozumí, jak AI ovlivňuje finanční rozhodování, řízení rizik a výsledky pro spotřebitele. Kromě toho se na AI systémy vztahují i stávající zákony na ochranu spotřebitelů – včetně zákonů o férovém poskytování úvěrů a ochraně dat – což činí zveřejnění nezbytným pro regulační soulad.

Poradní výbor investorů SEC doporučil tři klíčové pilíře pro zveřejňování AI: (1) požadovat po emitentech, aby definovali, co znamená 'umělá inteligence', (2) zveřejnit mechanismy dohledu představenstva nad nasazením AI a (3) reportovat zásadní nasazení AI a jejich dopady na interní provoz a produkty pro klienty. Tato doporučení mají investorům poskytnout jasné a srovnatelné informace o tom, jak AI ovlivňuje provoz finančních institucí a jejich strategii.

Finanční AI zveřejňování se zaměřuje konkrétně na regulační požadavky transparentní komunikace o využití AI vůči vnějším subjektům (investorům, regulátorům, spotřebitelům), zatímco obecné řízení AI označuje interní procesy a kontrolu nad správou AI systémů. Zveřejňování je vnější složkou řízení AI a zajišťuje, že zainteresované strany mají přístup k zásadním informacím o nasazení, rizicích a dopadech AI. Obojí je zásadní pro odpovědné nasazení AI ve finančních službách.

Zveřejnění nasazení AI by mělo zahrnovat jak interní provoz, tak dopady na klienty. U interního provozu by instituce měly zveřejnit dopady na lidský kapitál, finanční výkaznictví, řízení a kybernetická rizika. U produktů pro klienty by měla být zveřejněna investice do platforem poháněných AI, integrace AI do produktů, regulační dopady a způsob, jakým AI ovlivňuje ceny nebo obchodní strategie. Zveřejnění by měla být začleněna do stávajících položek regulačního zveřejňování (například SEC Regulation S-K) na základě významnosti.

Zákony o férovém poskytování úvěrů, včetně Equal Credit Opportunity Act (ECOA) a Fair Credit Reporting Act (FCRA), se vztahují na AI systémy používané při rozhodování o úvěrech bez ohledu na použitou technologii. Finanční instituce musí být schopny vysvětlit konkrétní důvody negativních rozhodnutí (například zamítnutí úvěru) a prokázat, že jejich AI modely nemají nepřiměřený dopad na chráněné skupiny. Regulátoři očekávají, že instituce budou AI modely testovat na předsudky, v případě potřeby zavádět 'méně diskriminační alternativy' a vést dokumentaci o testování férovosti a validaci.

Většina finančních institucí spoléhá na dodavatele třetích stran pro AI systémy, což vytváří významné povinnosti v oblasti řízení rizik třetích stran (TPRM). Finanční instituce zůstávají odpovědné za výkon a soulad AI systémů třetích stran, i když model samy nevyvinuly. Efektivní TPRM pro AI vyžaduje důkladnou prověrku dodavatelů, průběžné monitorování, posouzení řízení dat dodavatele a dokumentaci výkonnosti modelů. Instituce musí také sledovat riziko koncentrace – potenciální systémový dopad, pokud dojde k problémům u malého počtu poskytovatelů AI.

Zákon o AI Evropské unie představuje nejkomplexnější regulační rámec pro AI, klasifikuje finanční AI systémy jako 'vysokorizikové' a vyžaduje rozsáhlou dokumentaci, testování předsudků a lidský dohled. OECD a G7 vydaly také principy pro odpovědné řízení AI. Mnohé z těchto mezinárodních standardů mají mimořádný dosah, což znamená, že finanční instituce poskytující služby klientům v regulovaných jurisdikcích je mohou muset dodržovat. Proaktivní sladění s mezinárodními standardy může institucím pomoci připravit se na budoucí regulační vývoj a snížit riziko sankcí.

Sledujte, jak je vaše finanční instituce zmiňována v AI odpovědích napříč GPTs, Perplexity a Google AI Overviews. Zajistěte, aby vaše značka zůstávala viditelná a přesná v obsahu generovaném AI v oblasti financí.

Sledujte, jak se vaše finanční značka objevuje v odpovědích generovaných umělou inteligencí. Zjistěte požadavky na soulad s předpisy, strategie viditelnosti a o...

Zjistěte zásadní osvědčené postupy transparentnosti a zveřejnění AI. Objevte behaviorální, slovní a technické metody zveřejnění pro budování důvěry a zajištění ...

Zjistěte, jak prezentovat výsledky AI visibility vedení společnosti. Objevte klíčové metriky, návrh dashboardu a osvědčené postupy pro reporting a governance AI...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.