Content SEO

Content SEO je strategická tvorba a optimalizace kvalitního obsahu za účelem zlepšení pozic ve vyhledávačích a organické viditelnosti. Naučte se optimalizovat o...

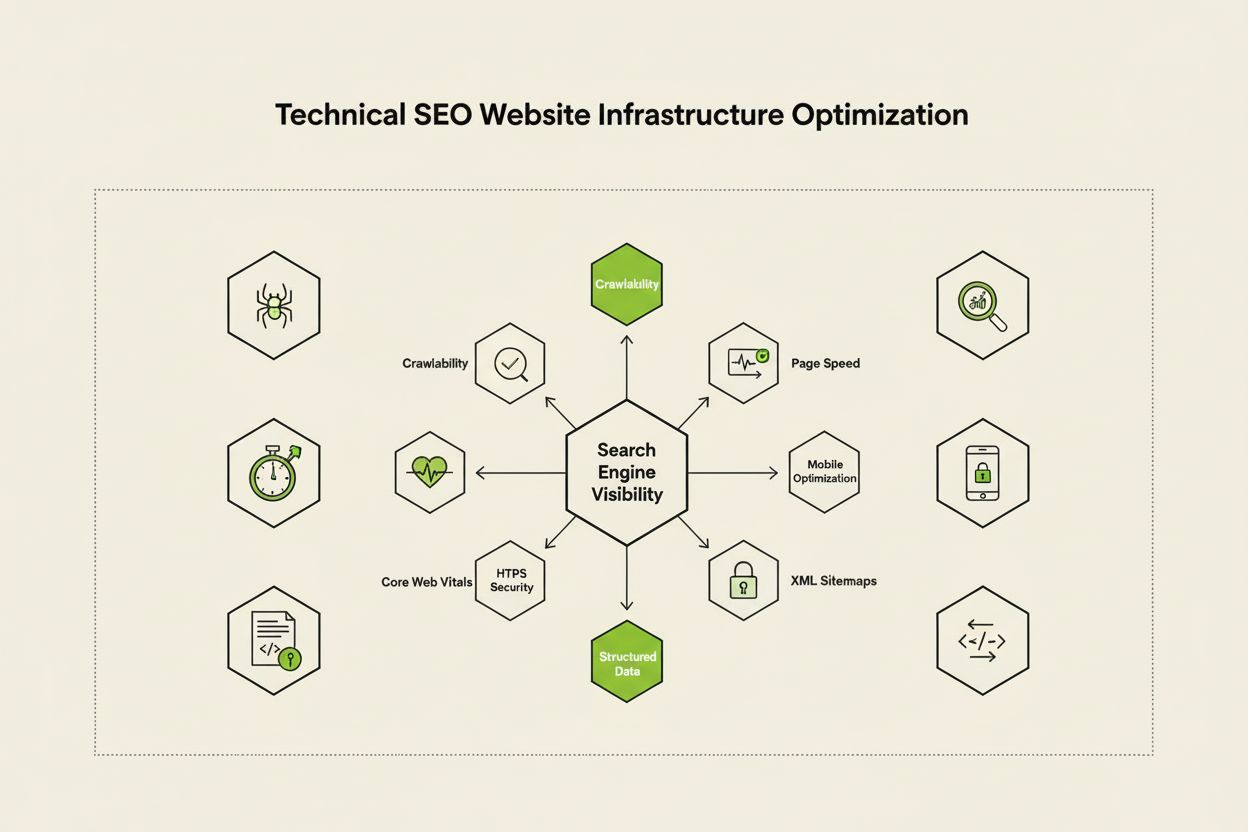

Technické SEO je proces optimalizace infrastruktury webových stránek tak, aby vyhledávače mohly správně a efektivně procházet, vykreslovat, indexovat a poskytovat obsah. Zahrnuje rychlost webu, přívětivost pro mobilní zařízení, architekturu stránek, zabezpečení a implementaci strukturovaných dat, aby vyhledávače mohly vaše stránky objevit a hodnotit.

Technické SEO je proces optimalizace infrastruktury webových stránek tak, aby vyhledávače mohly správně a efektivně procházet, vykreslovat, indexovat a poskytovat obsah. Zahrnuje rychlost webu, přívětivost pro mobilní zařízení, architekturu stránek, zabezpečení a implementaci strukturovaných dat, aby vyhledávače mohly vaše stránky objevit a hodnotit.

Technické SEO je proces optimalizace backendové infrastruktury webových stránek, aby vyhledávače mohly efektivně procházet, vykreslovat, indexovat a správně poskytovat obsah. Na rozdíl od On-Page SEO, které se zaměřuje na kvalitu obsahu a optimalizaci klíčových slov, technické SEO řeší základní prvky, které určují, zda vyhledávače vůbec mohou váš web navštívit a pochopit. Patří sem rychlost webu, mobilní responzivita, architektura webu, bezpečnostní protokoly, implementace strukturovaných dat a faktory ovlivňující crawlabilitu. Technické SEO funguje jako neviditelný základ, na němž závisí všechny ostatní SEO aktivity – bez něj zůstává i ten nejkvalitnější obsah vyhledávačům a uživatelům skrytý. Podle průzkumů z oboru 91 % marketérů uvedlo, že SEO v roce 2024 zlepšilo výkonnost jejich webu, přičemž technická optimalizace hrála klíčovou roli při dosahování měřitelných výsledků. Význam technického SEO roste s tím, jak jsou vyhledávače sofistikovanější a jak se objevují AI platformy pro vyhledávání, které vyžadují stále přísnější technické standardy pro viditelnost.

Technické SEO stojí na čtyřech vzájemně propojených pilířích, které společně maximalizují viditelnost ve vyhledávačích. Crawlabilita určuje, zda Googlebot a další crawleři dokážou přistupovat ke stránkám vašeho webu pomocí odkazů, sitemap a interní navigace. Indexovatelnost zajišťuje, že procházené stránky jsou skutečně uloženy v indexu Googlu a mohou se zobrazit ve výsledcích vyhledávání. Výkon a Core Web Vitals měří, jak rychle se stránky načítají a jak jsou responzivní na uživatelské akce – faktory, které přímo ovlivňují pozice i uživatelskou zkušenost. Optimalizace pro mobily zajistí bezchybnou funkčnost webu na smartphonech a tabletech, které dnes podle výzkumu Sistrix tvoří více než 60 % vyhledávacího provozu. Tyto čtyři pilíře jsou na sobě závislé; slabina v jednom může oslabit účinnost ostatních. Například rychlý desktopový web, který má špatný výkon na mobilech, se bude v mobilním indexu Googlu špatně umisťovat bez ohledu na dobře vyřešenou crawlabilitu. Pochopení vzájemných vazeb těchto pilířů je klíčové pro tvorbu komplexní technické SEO strategie, která pokrývá všechny aspekty viditelnosti ve vyhledávačích.

Ačkoli jsou často zaměňovány, crawlabilita a indexovatelnost jsou dvě odlišné fáze v procesu vyhledávače. Crawlabilita znamená, že vyhledávač může objevit a navštívit stránky vašeho webu sledováním interních odkazů, externích backlinků a XML sitemap. Odpovídá na otázku: „Dostane se Googlebot na tuto stránku?“ Pokud stránka není crawlabilní – například kvůli blokaci v robots.txt, skrytí za JavaScriptem nebo neexistenci interních odkazů – dál v procesu indexace nepostoupí. Indexovatelnost naproti tomu znamená, zda je procházená stránka skutečně uložena v indexu Googlu a může se zobrazit ve výsledcích vyhledávání. Stránka může být dokonale crawlabilní, ale přesto neindexovaná, pokud obsahuje meta tag noindex, je duplicitní nebo nesplňuje kvalitativní kritéria Googlu. Podle komplexního průvodce technickým SEO od Search Engine Land je pochopení tohoto rozdílu zásadní, protože řešení problémů s crawlabilitou vyžaduje jiné postupy než řešení indexačních problémů. Problémy s crawlabilitou většinou souvisí se strukturou webu, nastavením robots.txt a interním odkazováním, zatímco indexační potíže bývají spojeny s meta tagy, kanonizací, kvalitou obsahu a vykreslováním. Pro optimální viditelnost je nutné řešit obě oblasti.

Core Web Vitals jsou tři specifické metriky, které Google používá k měření reálné uživatelské zkušenosti a které přímo ovlivňují pozice ve vyhledávačích. Largest Contentful Paint (LCP) měří, jak rychle se načte největší viditelný prvek na stránce – Google doporučuje LCP do 2,5 sekundy. Interaction to Next Paint (INP), který v roce 2024 nahradil First Input Delay, měří, jak rychle stránka reaguje na uživatelské akce jako kliknutí a tapnutí – cílová hodnota je pod 200 milisekund. Cumulative Layout Shift (CLS) sleduje vizuální stabilitu tím, že měří nečekané změny rozložení během načítání – skóre pod 0,1 je považováno za dobré. Výzkum DebugBear ukazuje, že weby potřebují, aby 75 % uživatelů mělo ve všech třech metrikách hodnocení „Good“, aby získaly maximální výhodu v žebříčcích. Přechod na INP jako hodnoticí faktor odráží snahu Googlu hodnotit celkovou responzivitu stránky během celé interakce, nejen při prvním načtení. Optimalizace Core Web Vitals vyžaduje více kroků: zlepšení LCP spočívá v optimalizaci obrázků, využití CDN a odložení nenačítaného JavaScriptu; zvýšení INP znamená rozdělit dlouhé JS úlohy a optimalizovat event handlery; snížení CLS zahrnuje rezervaci místa pro dynamický obsah a vyhýbání se přesouvajícím reklamám. Tyto metriky jsou dnes pro konkurenceschopné SEO nepostradatelné, protože stránky s nízkými Core Web Vitals čelí penalizacím a vyšší míře opuštění.

Architektura webu popisuje, jak jsou stránky vašeho webu organizovány, strukturovány a propojeny interními odkazy. Dobře navržená architektura plní několik klíčových funkcí: pomáhá vyhledávačům porozumět hierarchii obsahu, rozděluje odkazovou hodnotu (link equity) napříč webem, zajišťuje snadné nalezení důležitých stránek a zlepšuje uživatelskou navigaci. Ideální architektura má jasnou hierarchii s hlavní stránkou na vrcholu, kategoriemi na druhé úrovni a jednotlivými stránkami obsahu v hlubších úrovních. Osvědčeným postupem je, aby všechny důležité stránky byly dostupné do tří kliknutí z hlavní stránky, což zajistí, že Googlebot neplýtvá crawl budgetem na hluboko uložené izolované stránky. Interní odkazy propojují architekturu webu a vedou uživatele i vyhledávače obsahem. Strategické interní odkazy posilují důležité stránky, vytvářejí sémantické vazby mezi tématy a pomáhají vyhledávačům určit, které stránky jsou klíčové. Například model hub-and-spoke – kde pilířová stránka odkazuje na více podstránek, které se zase odkazují zpět na pilíř – je silnou strukturou signalizující tematickou autoritu. Špatná architektura, tedy stránky bez odkazů, nekonzistentní navigace a hluboké vnoření, vede k plýtvání crawl budgetem a ztěžuje budování autority. Firmy, které restrukturalizují architekturu webu, často zaznamenají výrazné zrychlení indexace i zlepšení pozic.

Mobilní indexace znamená, že Google pro procházení, indexování a hodnocení primárně používá mobilní verzi vašeho webu, nikoli desktopovou. Tato zásadní změna odráží skutečnost, že přes 60 % vyhledávání dnes pochází z mobilních zařízení. Pro technické SEO to znamená, že mobilní zážitek musí být bezchybný: responzivní design přizpůsobující se všem velikostem displejů, navigace vhodná pro dotyk s dostatečnými rozestupy mezi prvky, čitelné písmo bez nutnosti zoomování a rychlé načítání optimalizované pro mobilní sítě. Responzivní design využívá flexibilní rozvržení a obrázky, které se automaticky přizpůsobují různým velikostem obrazovek a zaručují konzistentní funkčnost. Typickými chybami v mobilní optimalizaci jsou rušivé překryvy (pop-upy), příliš malé písmo, příliš blízko sebe umístěné tlačítka a pomalé načítání na mobilních sítích. Test Google Mobile-Friendly i Lighthouse tyto chyby odhalí, ale skutečné testování na reálných zařízeních je nezbytné. Vztah mezi mobilní optimalizací a pozicemi je přímý: stránky s nevhodným mobilním zážitkem ztrácejí pozice, zatímco optimalizované stránky získávají větší viditelnost. U e-shopů, SaaS platforem i vydavatelů je optimalizace pro mobily základním předpokladem úspěchu ve vyhledávání.

XML sitemap je mapa stránek, která vyhledávačům poskytuje seznam všech URL určených k indexaci, včetně metadat jako datum poslední změny a priorita stránky. Dobře udržovaná sitemap by měla obsahovat pouze kanonické a indexovatelné URL – bez přesměrování, chyb 404 a duplicit. Robots.txt je textový soubor v kořenovém adresáři webu, který dává vyhledávačům pokyny, které adresáře a soubory mohou či nemohou procházet. Robots.txt může blokovat procházení, ale nezabrání indexaci, pokud je stránka objevena jinak; k opravdovému vyloučení použijte meta tag noindex. Crawl budget je počet stránek, které Googlebot na vašem webu projde v daném časovém období – jde o omezený zdroj, který je třeba řídit strategicky. Velké weby s miliony stránek musí zajistit, aby Googlebot věnoval crawl budget hodnotnému obsahu, ne duplicitám či variantám s parametry. Plýtvání crawl budgetem vzniká při nekontrolovaných variantách URL, zpřístupnění testovacích prostředí nebo nadměrném interním odkazování na slabé stránky. Podle oficiálních doporučení Googlu je správa crawl budgetu zásadní hlavně u velkých webů, protože neefektivní procházení může zpožďovat indexaci nového či aktualizovaného obsahu. Nástroje jako Google Search Console (Crawl Stats) a analýza serverových logů umožní přesně sledovat, které stránky a jak často Googlebot navštěvuje, a optimalizovat crawl budget na základě dat.

Strukturovaná data, implementovaná pomocí schématu, pomáhají vyhledávačům lépe chápat význam a kontext obsahu, než by umožnila samotná analýza textu. Schéma využívá standardizovaný slovník (schema.org) k označování různých typů obsahu – produktů, článků, receptů, událostí, firem atd. Správně implementované schéma umožňuje rozšířené výsledky (rich results), kde Google zobrazuje dodatečné informace jako hvězdičky, ceny, doby vaření či termíny akcí přímo ve výsledcích. Toto zvýšení viditelnosti může výrazně zvýšit proklikovost i zapojení uživatelů. Různé typy obsahu vyžadují různá schémata: Article schema pro blogy a zpravodajství, Product schema pro e-shopy, FAQ schema pro často kladené dotazy, Local Business schema pro kamenné provozovny a Event schema pro události. Implementace obvykle využívá formát JSON-LD, který Google preferuje. Schéma však musí přesně odrážet skutečný obsah stránky – zavádějící či smyšlené schéma vede k penalizacím. Podle výzkumu Search Engine Land mají na rozšířené výsledky nárok jen stránky s platným a relevantním schématem, takže přesnost implementace je klíčová. Firmy, které nasadí komplexní schéma na svých důležitých stránkách, často zaznamenají lepší viditelnost jak v tradičním, tak AI řízeném vyhledávání, protože tyto systémy na strukturovaných datech staví své citace a porozumění obsahu.

HTTPS (Hypertext Transfer Protocol Secure) šifruje data mezi prohlížečem uživatele a vaším serverem, chrání citlivé informace a signalizuje důvěryhodnost jak uživatelům, tak vyhledávačům. Google potvrdil, že HTTPS je hodnoticím faktorem, a weby bez něj čelí jak přímým penalizacím, tak nepřímým – například varováním prohlížeče, která odrazují uživatele. Implementace HTTPS vyžaduje získání SSL/TLS certifikátu od důvěryhodné autority a nastavení serveru tak, aby všechny stránky běžely přes HTTPS. Nad rámec základního HTTPS zvyšují bezpečnost security headers, jako je Content-Security-Policy, Strict-Transport-Security či X-Content-Type-Options. Chyby smíšeného obsahu (kdy HTTPS stránky načítají HTTP zdroje) snižují bezpečnost a mohou vyvolat varování prohlížeče. Vztah mezi bezpečností a SEO jde dál než k pozicím: zabezpečené weby budují důvěru uživatelů, snižují míru opuštění a zvyšují konverze. Pro e-shopy, SaaS platformy a weby sbírající osobní údaje je bezpečnost samozřejmostí. Pravidelné bezpečnostní audity pomocí Google Search Console (Security Issues) a třetích stran pomáhají odhalit a odstranit bezpečnostní problémy dřív, než ovlivní pozice nebo důvěru uživatelů.

| Aspekt | Technické SEO | On-Page SEO | Off-Page SEO |

|---|---|---|---|

| Hlavní zaměření | Infrastruktura webu, rychlost, crawlabilita, indexovatelnost | Kvalita obsahu, klíčová slova, meta tagy, nadpisy | Zpětné odkazy, zmínky o značce, sociální signály |

| Přístup vyhledávače | Zajišťuje, že vyhledávače mohou stránky procházet a indexovat | Pomáhá vyhledávačům pochopit relevanci stránky | Buduje autoritu a signály důvěryhodnosti |

| Klíčové prvky | Rychlost webu, mobilní optimalizace, Core Web Vitals, architektura webu, HTTPS, strukturovaná data | Umístění klíčových slov, hloubka obsahu, interní odkazy, meta popisky | Profil zpětných odkazů, doménová autorita, zmínky o značce |

| Používané nástroje | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Dopad na pozice | Zásadní – bez něj stránky vůbec nemohou být hodnoceny | Přímý – zlepšuje relevanci pro cílová klíčová slova | Významný – buduje autoritu a důvěryhodnost |

| Dopad na UX | Vysoký – ovlivňuje rychlost, použitelnost na mobilech, přístupnost | Střední – ovlivňuje čitelnost a zapojení | Nízký – nepřímo skrze vnímání značky |

| Implementační časová osa | Průběžně – vyžaduje neustálý monitoring a optimalizaci | Průběžně – vyžaduje aktualizace obsahu a optimalizaci | Dlouhodobě – vyžaduje trvalou práci na odkazech |

| Měření ROI | Efektivita procházení, míra indexace, skóre Core Web Vitals, pozice | Pozice na klíčová slova, organická návštěvnost, míra prokliku | Růst zpětných odkazů, doménová autorita, referral návštěvnost |

JavaScript SEO řeší specifické výzvy webů silně závislých na JavaScriptu, single-page aplikací (SPA) a dynamického vykreslování obsahu. Historicky měl Googlebot s JavaScriptem problémy, protože bylo potřeba stránku nejprve vykreslit – tedy spustit JS kód a vytvořit výslednou stránku – což přidávalo složitost i zpoždění. Moderní Googlebot dnes většinu stránek vykresluje před indexací, což však přináší nové technické požadavky. Server-side rendering (SSR) generuje kompletní HTML na serveru, takže vyhledávače ihned vidí veškerý obsah bez čekání na spuštění JS. Static site generation (SSG) předgeneruje stránky při build procesu, výsledkem jsou statické HTML soubory s okamžitým načtením. Dynamické vykreslování poskytuje vyhledávačům předrenderovaný HTML, uživatelům JavaScript – podle Googlu jde však o dočasné řešení. Klíčové pravidlo: všechen zásadní obsah, meta tagy a strukturovaná data musí být viditelná v počátečním HTML, ne dynamicky načtená až po vykonání JavaScriptu. Stránky, které kritický obsah skrývají za JavaScriptem, riskují neúplnou či zpožděnou indexaci. Frameworky jako React, Vue či Angular vyžadují zvláštní pozornost – mnoho firem používá Next.js či Nuxt.js právě kvůli SSR a lepšímu SEO. Testování pohledu Googlebota přes URL Inspection Tool a vykreslený náhled v Google Search Console ukáže, jestli JavaScriptem řízený obsah je opravdu indexován.

Efektivní implementace technického SEO vyžaduje systematický postup s důrazem na největší přínosy. Začněte základními prvky: ověřte crawlabilitu kontrolou robots.txt a interního odkazování, ověřte indexovatelnost kontrolou noindex tagů a kanonizace a stanovte výchozí hodnoty Core Web Vitals. Dále optimalizujte výkon: komprimujte a optimalizujte obrázky, implementujte lazy loading pro obsah pod přehybem, odkládejte nenačítaný JavaScript a využijte CDN pro rychlejší doručování. Poté optimalizujte architekturu webu: zajistěte, aby důležité stránky byly do tří kliknutí od hlavní stránky, implementujte breadcrumb navigaci se schématem a vytvořte srozumitelné vzorce interních odkazů. Implementujte strukturovaná data pro své důležité typy obsahu – produkty, články, lokální informace či události – pomocí JSON-LD a validujte přes Rich Results Test. Nepřetržitě monitorujte pomocí Google Search Console (indexace), PageSpeed Insights (Core Web Vitals) a serverových logů (crawl vzory). Zajistěte odpovědnost sledováním klíčových metrik jako počet indexovaných stránek, skóre Core Web Vitals a efektivita procházení v čase. Organizace, které považují technické SEO za kontinuální proces, ne za jednorázový audit, dosahují trvale lepší viditelnosti i uživatelské zkušenosti než konkurence.

S nástupem AI platforem jako Google AI Overviews, Perplexity, ChatGPT a Claude se význam technického SEO rozšiřuje nad rámec tradičního vyhledávání Google. Tyto AI systémy spoléhají na správně indexovaný a dobře strukturovaný obsah z indexů vyhledávačů pro vytváření odpovědí a citací. Technické SEO zajišťuje, že váš obsah je pro AI systémy objevitelný a správně interpretovaný několika způsoby: správná indexace zpřístupňuje obsah pro trénink i vyhledávání AI, strukturovaná data pomáhají AI chápat kontext a význam obsahu a sémantická bohatost umožňuje AI rozpoznat váš obsah jako autoritativní a relevantní. Podle výzkumů Conductor a Botify pochází stránky v AI Overviews typicky z dobře indexovaných a technicky vyladěných webů se silnými sémantickými signály. Vztah je obousměrný: zatímco tradiční SEO cílí na konkrétní klíčová slova, AI vyhledávání poskytuje komplexní odpovědi často s více citacemi. To znamená, že technické SEO musí sloužit oběma paradigmatům – zajistit indexaci pro tradiční vyhledávání i sémantickou bohatost pro citace v AI systémech. Firmy sledující svou viditelnost napříč AI platformami pomocí nástrojů jako AmICited zjistí, které technické optimalizace nejvíce zvyšují míru citací i viditelnost v generativních výsledcích.

Efektivní technické SEO vyžaduje sledování konkrétních metrik, které vypovídají o zdraví webu a jeho přístupnosti pro vyhledávače. Počet indexovaných stránek ukazuje, kolik zamýšlených stránek je skutečně v indexu Googlu – srovnání s celkovým počtem indexovatelných stránek dává poměr efektivity indexace. Efektivita crawlování měří, jak účinně Googlebot využívá crawl budget, typicky jako podíl procházených stránek k celkovému počtu. Skóre Core Web Vitals vypovídá o kvalitě uživatelského zážitku v oblasti rychlosti načítání (LCP), interaktivity (INP) a stability (CLS). Problémy s mobilní použitelností ve Search Console odhalí chyby jako malá klikací pole, špatně nastavený viewport nebo rušivé překryvy. Délka řetězců přesměrování by měla být minimální, aby se neztrácela odkazová síla a nezdržovalo crawlování. Pokrytí strukturovanými daty ukazuje, jaká část stránek má validní schéma. Metriky rychlosti načítání jako First Contentful Paint (FCP), Time to Interactive (TTI) a Total Blocking Time (TBT) poskytují detailní pohled na výkon. Organizace by měly stanovit výchozí hodnoty těchto metrik, stanovit cíle zlepšení a sledovat vývoj měsíčně či čtvrtletně. Náhlé změny často signalizují technické problémy dříve, než ovlivní pozice, což umožňuje včasnou nápravu. Nástroje jako Google Search Console, PageSpeed Insights, Lighthouse a platformy typu Semrush poskytují komplexní dashboardy pro monitoring napříč celým webem.

Oblast technického SEO se stále vyvíjí v reakci na změny algoritmů vyhledávačů, nové technologie i měnící se chování uživatelů. AI řízená indexace a hodnocení bude čím dál více ovlivňovat, které stránky budou zaindexovány a jak budou řazeny, což vyžaduje technické SEO podporující sémantiku i rozpoznávání entit. Edge computing a serverless architektury umožní rychlejší doručování obsahu a optimalizaci v reálném čase na síťovém okraji, což zkrátí latence a zlepší Core Web Vitals. Silnější důraz na signály E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) znamená, že technické SEO musí podporovat důvěryhodnost přes správné označení autorů, datum publikace a další signály. Multikanálová optimalizace se stane standardem, protože AI platformy se budou rozšiřovat a weby budou muset optimalizovat pro viditelnost napříč Googlem, Perplexity, ChatGPT, Claude a dalšími. Analytika zaměřená na soukromí a sběr dat z první strany promění měření dopadu technického SEO – přechodem od cookies třetích stran k server-side trackingu a měření na základě souhlasu. Zrání JavaScript frameworků dál zlepší SEO možnosti

Technické SEO se zaměřuje na optimalizaci infrastruktury webu – například rychlosti webu, procházení, indexovatelnosti a konfigurace serveru – aby vyhledávače mohly objevit a zpracovat obsah. Naopak On-Page SEO se soustředí na optimalizaci jednotlivých prvků stránky, jako je umístění klíčových slov, meta tagy, nadpisy a kvalita obsahu, aby byla stránka relevantní pro konkrétní vyhledávací dotazy. Zatímco technické SEO zajišťuje, že vyhledávače mají přístup k vašemu webu, On-Page SEO jim umožňuje pochopit, o čem váš obsah je a proč je pro uživatele důležitý.

Core Web Vitals – Largest Contentful Paint (LCP), Interaction to Next Paint (INP) a Cumulative Layout Shift (CLS) – jsou potvrzené hodnoticí faktory, které měří reálnou uživatelskou zkušenost. Podle výzkumu DebugBear potřebují weby, aby 75 % uživatelů mělo ve všech třech metrikách hodnocení 'Good', aby získaly maximální podporu v žebříčcích. Špatné Core Web Vitals mohou vést k penalizacím v hodnocení, nižší proklikovosti a vyšší míře opuštění, což přímo ovlivňuje organickou viditelnost a zapojení uživatelů.

Crawlabilita určuje, zda roboti vyhledávačů mohou přistupovat ke stránkám vašeho webu a sledovat odkazy. Pokud Googlebot nemůže vaše stránky procházet kvůli blokovaným zdrojům, špatné struktuře webu nebo omezením v robots.txt, tyto stránky nemohou být indexovány ani hodnoceny. Bez správné crawlability zůstává i kvalitní obsah pro vyhledávače neviditelný, takže nelze dosáhnout organické viditelnosti bez ohledu na kvalitu obsahu či profil zpětných odkazů.

S rostoucím významem platforem řízených AI, jako jsou Google AI Overviews a Perplexity, zůstává technické SEO zásadní. Tyto AI systémy spoléhají na správně indexovaný a dobře strukturovaný obsah z indexu Googlu, aby mohly generovat odpovědi. Technické SEO zajišťuje, že váš obsah je objevitelný, správně vykreslený a dostatečně sémanticky bohatý, aby jej AI systémy mohly citovat. Bez silných technických základů se váš obsah v AI Overviews ani v jiných výsledcích generativního vyhledávání neobjeví.

Většině webů se doporučuje provést komplexní technický SEO audit čtvrtletně a měsíčně monitorovat kritické problémy. Větší podnikové weby s častými aktualizacemi by měly auditovat měsíčně nebo implementovat kontinuální monitoring. Po zásadních změnách webu, migracích nebo redesignu jsou okamžité audity nezbytné. Pravidelné audity pomáhají včas zachytit problémy, než ovlivní pozice, a zajistit optimální crawlabilitu, indexovatelnost a výkon webu.

Architektura webu určuje, jak vyhledávače navigují a chápou hierarchii obsahu vašeho webu. Dobře optimalizovaná architektura zajistí, že důležité stránky jsou do tří kliknutí od hlavní stránky, efektivně rozděluje odkazovou hodnotu a pomáhá vyhledávačům upřednostnit procházení hodnotného obsahu. Špatná architektura může vést ke stránkám bez odkazů, plýtvání crawl budgetem a obtížnému budování tematické autority, což negativně ovlivňuje pozice i viditelnost.

Rychlost stránky přímo ovlivňuje jak pozice ve vyhledávání, tak chování uživatelů. Google potvrdil, že Core Web Vitals – měřící rychlost načítání, interaktivitu a vizuální stabilitu – jsou hodnoticí faktory. Pomalu načítané stránky mají vyšší míru opuštění, nižší zapojení uživatelů a menší konverze. Studie ukazují, že stránky načtené pod 2,5 sekundy mají výrazně lepší udržení uživatelů i výkonnost v žebříčcích oproti těm pomalejším, takže optimalizace rychlosti je pro úspěch v SEO zásadní.

Začněte sledovat, jak AI chatboti zmiňují vaši značku na ChatGPT, Perplexity a dalších platformách. Získejte užitečné informace pro zlepšení vaší AI prezence.

Content SEO je strategická tvorba a optimalizace kvalitního obsahu za účelem zlepšení pozic ve vyhledávačích a organické viditelnosti. Naučte se optimalizovat o...

JavaScript SEO optimalizuje weby vykreslované JavaScriptem pro procházení a indexaci vyhledávači. Naučte se osvědčené postupy, metody vykreslování a strategie p...

YouTube SEO je proces optimalizace videí a kanálů za účelem dosažení vyššího umístění ve výsledcích vyhledávání na YouTube. Zjistěte hodnoticí faktory, optimali...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.