Indholdsopdeling til AI: Optimale passagelængder for citater

Lær hvordan du strukturerer indhold i optimale passagelængder (100-500 tokens) for maksimale AI-citater. Opdag opdelingsstrategier, der øger synligheden i ChatG...

Forskningbaseret guide til optimal passagelængde for AI-citater. Lær hvorfor 75-150 ord er ideelt, hvordan tokens påvirker AI-hentning, og strategier til at maksimere dit indholds citeringspotentiale.

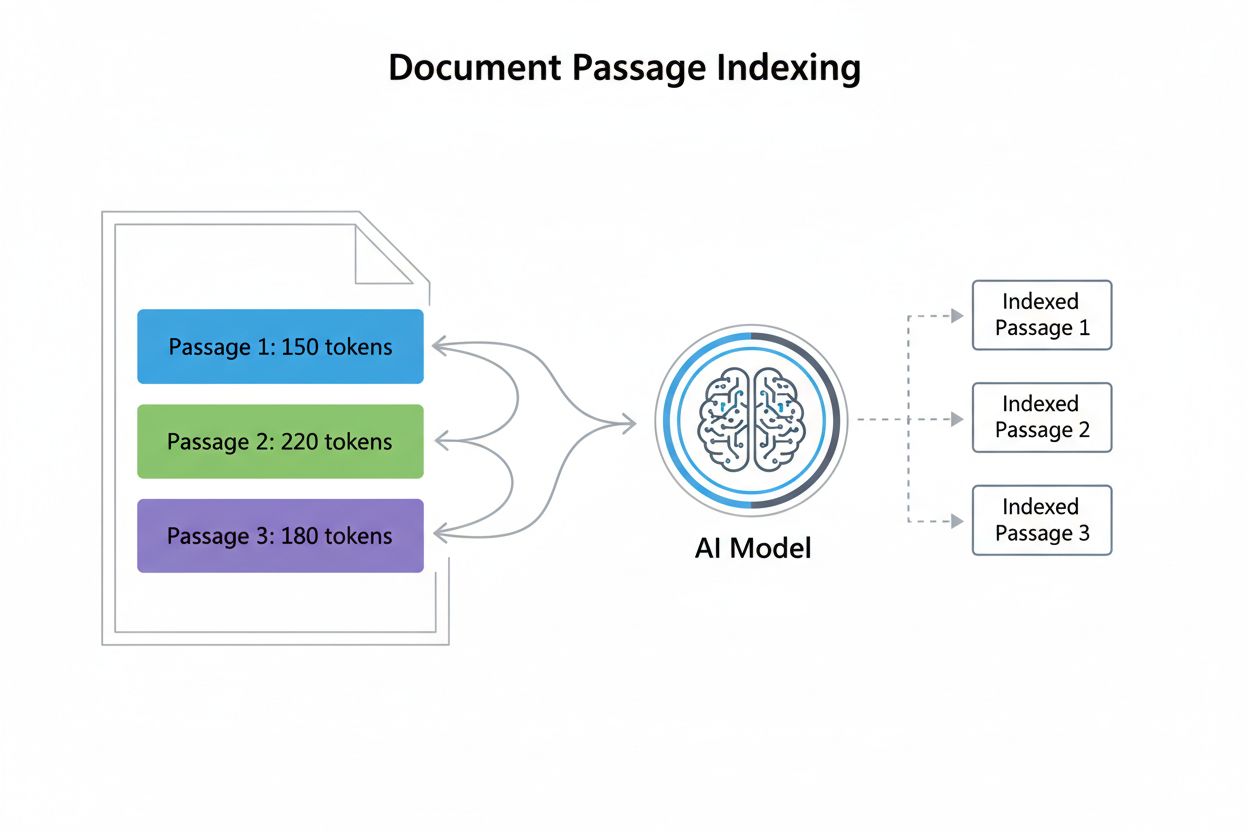

Passagelængde i forbindelse med AI-citater henviser til den optimale størrelse på indholdsstykker, som AI-modeller udtrækker og citerer, når de genererer svar. I stedet for at citere hele sider eller dokumenter, bruger moderne AI-systemer passage-level indeksering, som opdeler indhold i diskrete, håndterbare segmenter, der kan vurderes og citeres uafhængigt. At forstå denne forskel er essentielt, fordi det fundamentalt ændrer, hvordan indholdsskabere bør strukturere deres materiale. Forholdet mellem passager og tokens er vigtigt at forstå: cirka 1 token svarer til 0,75 ord, hvilket betyder, at en passage på 300 ord typisk indeholder omkring 400 tokens. Denne konvertering er vigtig, fordi AI-modeller arbejder inden for kontekstvinduer—faste grænser for, hvor meget tekst de kan behandle på én gang. Ved at optimere passagelængden kan indholdsskabere sikre, at deres mest værdifulde information falder inden for det område, som AI-systemer effektivt kan indeksere, hente og citere, frem for at blive begravet i længere dokumenter, der kan overskride behandlingskapaciteten.

Forskning viser konsekvent, at 53% af det indhold, der citeres af AI-systemer, er under 1.000 ord, hvilket udfordrer traditionelle antagelser om indholdets dybde og autoritet. Denne præference for kortere indhold skyldes, hvordan AI-modeller vurderer relevans og udtrækkelighed—kortfattede passager er nemmere at analysere, sætte i kontekst og citere præcist. Begrebet “answer nugget” (typisk 40-80 ord) er opstået som en kritisk optimeringsenhed, der repræsenterer det mindste meningsfulde svar på en brugerforespørgsel. Interessant nok viser studier en næsten nul korrelation mellem ordantal og citeringsposition, hvilket betyder, at længere indhold ikke automatisk rangerer højere i AI-citater. Indhold under 350 ord havner oftere i de tre øverste citeringspladser, hvilket antyder, at kortfattethed kombineret med relevans skaber optimale betingelser for AI-citering. Denne datadrevne indsigt ændrer grundlæggende indholdsstrategien.

| Indholdstype | Optimal Længde | Token Antal | Anvendelse |

|---|---|---|---|

| Answer Nugget | 40-80 ord | 50-100 tokens | Direkte Q&A-svar |

| Udvalgt Uddrag | 75-150 ord | 100-200 tokens | Hurtige svar |

| Passage Chunk | 256-512 tokens | 256-512 tokens | Semantiske søgeresultater |

| Emne-hub | 1.000-2.000 ord | 1.300-2.600 tokens | Omfattende dækning |

| Langformet Indhold | 2.000+ ord | 2.600+ tokens | Dybtgående guides |

Tokens er de grundlæggende enheder, som AI-modeller bruger til at behandle sprog, hvor hver token typisk repræsenterer et ord eller et ordfragment. Beregning af tokenantal er ligetil: divider dit ordantal med 0,75 for at estimere tokens, selvom det præcise antal varierer efter tokeniseringsmetode. For eksempel indeholder en passage på 300 ord cirka 400 tokens, mens en artikel på 1.000 ord indeholder omtrent 1.333 tokens. Kontekstvinduer—det maksimale antal tokens, en model kan behandle i én forespørgsel—påvirker direkte, hvilke passager der bliver udvalgt til citat. De fleste moderne AI-systemer arbejder med kontekstvinduer på 4.000 til 128.000 tokens, men praktiske begrænsninger betyder ofte, at kun de første 2.000-4.000 tokens får optimal opmærksomhed. Når en passage overskrider disse praktiske grænser, risikerer den at blive afkortet eller nedprioriteret i udtrækningsprocessen. Forståelse af din mål-AI’s kontekstvindue gør det muligt at strukturere passager, der passer komfortabelt inden for behandlingens rammer, samtidig med at den semantiske fuldstændighed bevares.

Eksempel på tokenberegning:

- 100-ords passage = ~133 tokens

- 300-ords passage = ~400 tokens

- 500-ords passage = ~667 tokens

- 1.000-ords passage = ~1.333 tokens

Praktisk allokering af kontekstvindue:

- Systemets kontekstvindue: 8.000 tokens

- Reserveret til forespørgsel + instruktioner: 500 tokens

- Tilgængelig til passager: 7.500 tokens

- Optimal passagestørrelse: 256-512 tokens (plads til 14-29 passager)

AI-modeller udviser et fænomen kendt som context rot, hvor information placeret i midten af lange passager oplever betydelig præstationsforringelse. Dette sker, fordi transformerbaserede modeller anvender opmærksomhedsmekanismer, der naturligt favoriserer indhold i begyndelsen (primacy-effekt) og slutningen (recency-effekt) af inputsekvenser. Når passager overstiger 1.500 tokens, kan vigtig information, der er begravet i midten, blive overset eller nedprioriteret under citeringsgenerering. Denne begrænsning har stor betydning for, hvordan indhold bør struktureres—at placere din vigtigste information i begyndelsen og slutningen af passager maksimerer sandsynligheden for citat. Flere afbødningsstrategier kan modvirke dette problem:

Optimal passagestruktur prioriterer semantisk sammenhæng—hver passage skal repræsentere en fuldstændig, selvstændig tanke eller et svar. I stedet for vilkårligt at opdele indhold ved bestemte ordantal, bør passager følge naturlige emnegrænser og logiske opdelinger. Kontekstuafhængighed er ligeledes kritisk; hver passage skal kunne forstås uden, at læseren behøver at henvise til omkringliggende indhold. Det betyder, at nødvendig kontekst skal inkluderes i passagen selv, frem for at være afhængig af krydsreferencer eller ekstern information. Når du strukturerer indhold for AI-hentning, så overvej, hvordan passager vil fremstå isoleret—uden overskrifter, navigation eller omkringliggende afsnit. Best practice inkluderer: at begynde hver passage med en klar emnesætning, opretholde ensartet format og terminologi, bruge beskrivende underoverskrifter, der tydeliggør passageformål, og sikre, at hver passage besvarer et fuldt spørgsmål eller dækker et helt koncept. Ved at behandle passager som selvstændige enheder frem for vilkårlige tekstsegmenter, forbedrer indholdsskabere markant sandsynligheden for, at AI-systemer udtrækker og citerer deres arbejde korrekt.

“Snack-strategien” optimerer til kort, fokuseret indhold (75-350 ord), der er designet til at besvare specifikke forespørgsler direkte. Denne tilgang er ideel til simple, ligefremme spørgsmål, hvor brugere søger hurtige svar uden omfattende kontekst. Snack-indhold klarer sig særdeles godt i AI-citater, fordi det matcher “answer nugget”-formatet, som AI-systemer naturligt udtrækker. Omvendt skaber “Hub-strategien” omfattende, langformet indhold (2.000+ ord), der udforsker komplekse emner i dybden. Hub-indhold tjener andre formål: at etablere emneautoritet, opfange flere relaterede forespørgsler og give kontekst til mere nuancerede spørgsmål. Den vigtigste indsigt er, at disse strategier ikke udelukker hinanden—den mest effektive tilgang kombinerer begge. Skab fokuseret snack-indhold til specifikke spørgsmål og hurtige svar, og udvikl derefter hub-indhold, der linker til og uddyber disse snacks. Denne hybride tilgang gør det muligt at opnå både direkte AI-citater (via snacks) og omfattende emneautoritet (via hubs). Når du vælger strategi, så overvej hensigten bag forespørgslen: simple, faktuelle spørgsmål foretrækker snacks, mens komplekse, undersøgende emner har gavn af hubs. Den vindende strategi balancerer begge tilgange baseret på dit publikums reelle informationsbehov.

Answer nuggets er kortfattede, selvstændige sammenfatninger på typisk 40-80 ord, der direkte besvarer specifikke spørgsmål. Disse nuggets repræsenterer det optimale format for AI-citering, fordi de leverer fuldstændige svar uden overflødig information. Placering er afgørende: placer din answer nugget umiddelbart efter din hovedoverskrift eller emneintroduktion, før du dykker ned i uddybende detaljer og forklaringer. Denne front-loading sikrer, at AI-systemer møder svaret først, hvilket øger sandsynligheden for citat. Schema markup spiller en væsentlig rolle i optimeringen af answer nuggets—ved at bruge strukturerede dataformater som JSON-LD fortæller du AI-systemer præcis, hvor dit svar findes. Her er et eksempel på en velformuleret answer nugget:

Spørgsmål: "Hvor langt bør webindhold være for AI-citater?"

Answer Nugget: "Forskning viser, at 53% af AI-citeret indhold er under 1.000 ord, med optimale passager fra 75-150 ord til direkte svar og 256-512 tokens til semantiske stykker. Indhold under 350 ord har en tendens til at rangere i de øverste citeringspositioner, hvilket antyder, at kortfattethed kombineret med relevans maksimerer sandsynligheden for AI-citering."

Denne nugget er fuldstændig, specifik og straks brugbar—præcis det, AI-systemer søger, når de genererer citater.

JSON-LD schema markup giver AI-systemer eksplicitte instruktioner om dit indholds struktur og betydning, hvilket dramatisk forbedrer sandsynligheden for citat. De mest effektfulde schema-typer til AI-optimering omfatter FAQ schema til spørgsmål-og-svar-indhold og HowTo schema til procedure- eller instruktionsindhold. FAQ schema er særligt stærkt, fordi det direkte spejler, hvordan AI-systemer bearbejder information—som diskrete spørgsmål-svar-par. Forskning viser, at sider med den rette schema markup er 3x mere tilbøjelige til at blive citeret af AI-systemer sammenlignet med indhold uden markup. Dette er ikke tilfældigt; schema markup reducerer tvetydighed om, hvad der udgør et svar, hvilket gør udtræk og citering mere selvsikker og præcis.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"@id": "https://example.com/faq#q1",

"name": "What is optimal passage length for AI citations?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Research shows 53% of AI-cited content is under 1,000 words, with optimal passages ranging from 75-150 words for direct answers and 256-512 tokens for semantic chunks."

}

}

]

}

Implementering af schema markup forvandler dit indhold fra ustruktureret tekst til maskinlæsbar information, der signalerer til AI-systemer præcis, hvor svar findes, og hvordan de er organiseret.

At spore passageperformance kræver monitorering af specifikke måleparametre, der indikerer AI-citeringssucces. Citeringsandel måler, hvor ofte dit indhold optræder i AI-genererede svar, mens citeringsposition viser, om dine passager vises som første, anden eller senere i citeringslister. Værktøjer som SEMrush, Ahrefs og specialiserede AI-overvågningsplatforme sporer nu AI Overview-optrædener og citater, hvilket giver indsigt i performance. Implementer A/B-test ved at oprette flere versioner af passager med forskellige længder, strukturer eller schema-implementeringer, og overvåg derefter, hvilke versioner der genererer flest citater. Nøgleparametre at spore inkluderer:

Regelmæssig monitorering afslører, hvilke passagestrukturer, længder og formater der fungerer bedst for AI-systemer, hvilket muliggør løbende optimering.

Mange indholdsskabere saboterer uforvarende deres AI-citeringspotentiale gennem undgåelige strukturelle fejl. At begrave vigtig information dybt i passager tvinger AI-systemer til at gennemsøge irrelevant kontekst, før de finder svaret—placer din vigtigste information først. Overdreven krydsreferering skaber kontekstaafhængighed; passager, der konstant henviser til andre sektioner, bliver svære for AI-systemer at udtrække og citere uafhængigt. Vagt, uspecifikt indhold mangler den præcision, AI-systemer har brug for til sikker citering—brug konkrete detaljer, specifikke tal og klare udsagn. Dårlige sektionsgrænser skaber passager, der spænder over flere emner eller ufuldstændige tanker; sørg for, at hver passage udgør en sammenhængende enhed. Ignorering af teknisk struktur betyder, at du går glip af muligheder for schema markup, korrekt overskriftshierarki og semantisk klarhed. Yderligere fejl inkluderer:

At undgå disse fejl, kombineret med implementering af de beskrevne optimeringsstrategier, positionerer dit indhold til maksimal performance i AI-citeringer.

Forskning viser, at 75-150 ord (100-200 tokens) er optimalt for de fleste indholdstyper. Denne længde giver AI-systemer tilstrækkelig kontekst til at forstå og citere dit indhold, mens det stadig er kortfattet nok til direkte inklusion i AI-genererede svar. Indhold under 350 ord har en tendens til at havne i de øverste citeringspositioner.

Nej. Forskning viser, at 53% af de citerede sider er under 1.000 ord, og der er stort set ingen sammenhæng mellem ordantal og citeringsposition. Kvalitet, relevans og struktur betyder langt mere end længde. Kort, fokuseret indhold overgår ofte lange artikler i AI-citater.

Én token svarer cirka til 0,75 ord i engelsk tekst. Så 1.000 tokens svarer til cirka 750 ord. Det præcise forhold varierer efter sprog og indholdstype—kode bruger flere tokens pr. ord på grund af specialtegn og syntaks. Forståelse af denne konvertering hjælper dig med at optimere passagelængde til AI-systemer.

Opdel langt indhold i selvstændige sektioner på 400-600 ord hver. Hver sektion bør have en klar emnesætning og inkludere en 40-80 ord 'answer nugget', der direkte besvarer et bestemt spørgsmål. Brug schema markup for at hjælpe AI-systemer med at identificere og citere disse nuggets. Denne tilgang fanger både direkte citater og emneautoritet.

AI-modeller har en tendens til at fokusere på information i starten og slutningen af lange kontekster, men har svært ved indhold i midten. Denne 'context rot' betyder, at vigtig information, der er gemt i passager på over 1.500 tokens, kan blive overset. Afhjælp dette ved at placere vigtig information i starten eller slutningen, bruge tydelige overskrifter og gentage nøglepunkter strategisk.

Spor citeringsandel (procentdel af AI Overviews, der linker til dit domæne) med værktøjer som BrightEdge, Semrush eller Authoritas. Overvåg hvilke specifikke passager, der vises i AI-genererede svar, og juster din indholdsstruktur baseret på performance data. AmICited tilbyder også specialiseret overvågning af AI-citater på tværs af flere platforme.

Ja, markant. Sider med omfattende JSON-LD schema markup (FAQ, HowTo, ImageObject) er 3x mere tilbøjelige til at optræde i AI Overviews. Schema hjælper AI-systemer med at forstå og udtrække dit indhold mere effektivt, hvilket gør det lettere for dem at citere dine passager præcist og sikkert.

Brug begge dele. Skriv kort, fokuseret indhold (300-500 ord) til simple, direkte forespørgsler ved at bruge 'Snack-strategien'. Skriv længere, dækkende indhold (2.000-5.000 ord) til komplekse emner med 'Hub-strategien'. Inden for langt indhold skal du strukturere det som flere korte, selvstændige passager for at opnå både direkte citater og emneautoritet.

Spor hvordan AI-systemer som ChatGPT, Perplexity og Google AI Overviews citerer dit indhold. Optimer dine passager baseret på reelle citeringsdata og forbedr din synlighed i AI-genererede svar.

Lær hvordan du strukturerer indhold i optimale passagelængder (100-500 tokens) for maksimale AI-citater. Opdag opdelingsstrategier, der øger synligheden i ChatG...

Lær hvordan du strukturerer dit indhold, så det bliver citeret af AI-søgemaskiner som ChatGPT, Perplexity og Google AI. Ekspertstrategier for AI-synlighed og ci...

Lær teknikker til passageoptimering for AI-søgning. Opdag hvordan du strukturerer selvstændige passager (134-167 ord) for bedre synlighed i AI Overviews, ChatGP...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.