Comment configurer robots.txt pour les crawlers IA : guide complet

Découvrez comment configurer robots.txt pour contrôler l'accès des crawlers IA, y compris GPTBot, ClaudeBot et Perplexity. Gérez la visibilité de votre marque d...

La configuration d’un robots.txt avec des règles d’user-agent ciblant spécifiquement les robots d’indexation IA. Un robots.txt spécifique à l’IA permet aux propriétaires de sites web de contrôler la façon dont les systèmes d’intelligence artificielle, les grands modèles de langage et les robots de collecte de données IA accèdent et utilisent leur contenu. Il distingue différents types de crawlers IA—robots d’entraînement, de recherche, et fetchers déclenchés par l’utilisateur—pour offrir un contrôle granulaire sur la visibilité du contenu face aux systèmes IA. Cette configuration est devenue essentielle, car les crawlers IA représentent désormais environ 80 % du trafic des robots sur de nombreux sites web.

La configuration d'un robots.txt avec des règles d’user-agent ciblant spécifiquement les robots d’indexation IA. Un robots.txt spécifique à l’IA permet aux propriétaires de sites web de contrôler la façon dont les systèmes d’intelligence artificielle, les grands modèles de langage et les robots de collecte de données IA accèdent et utilisent leur contenu. Il distingue différents types de crawlers IA—robots d’entraînement, de recherche, et fetchers déclenchés par l’utilisateur—pour offrir un contrôle granulaire sur la visibilité du contenu face aux systèmes IA. Cette configuration est devenue essentielle, car les crawlers IA représentent désormais environ 80 % du trafic des robots sur de nombreux sites web.

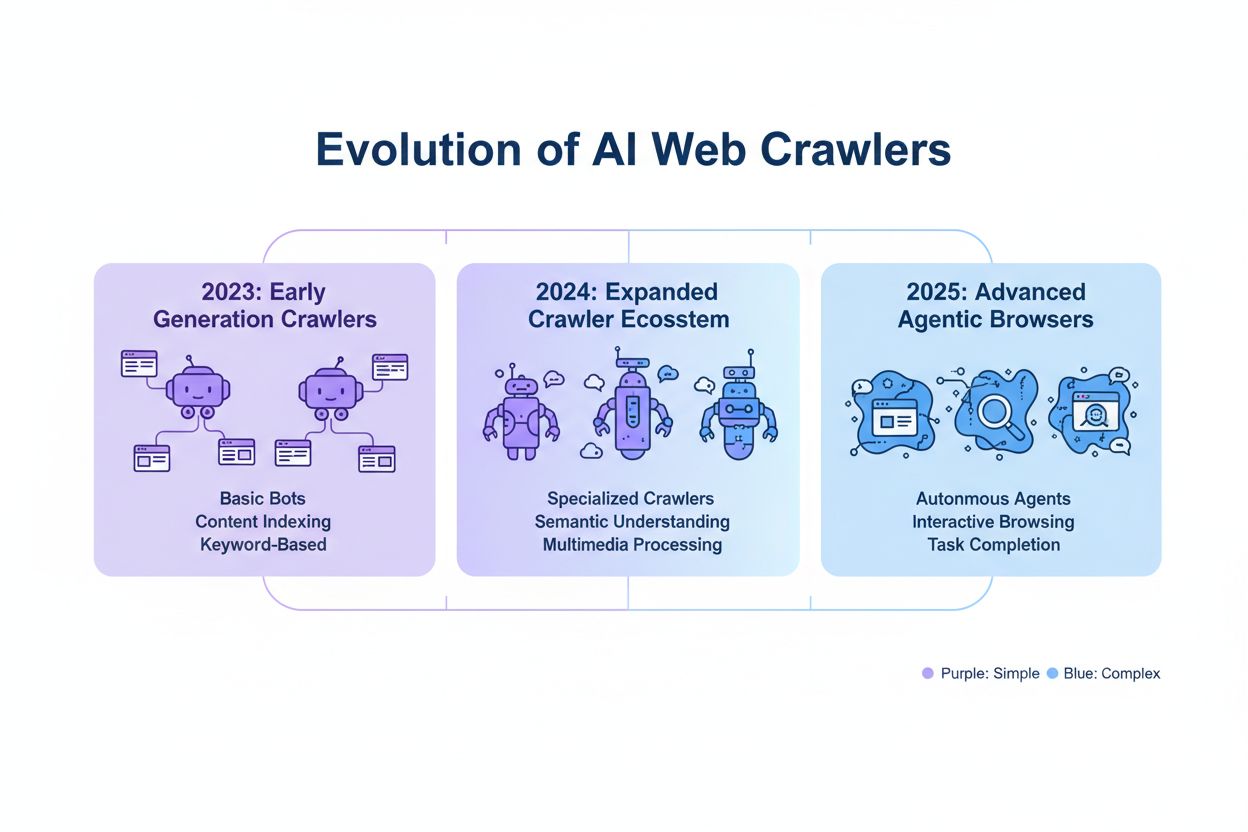

La configuration d’un robots.txt spécifique à l’IA consiste à créer des règles ciblées dans votre fichier robots.txt qui s’adressent spécifiquement aux robots d’indexation et aux bots d’entraînement d’intelligence artificielle, distincts des crawlers des moteurs de recherche traditionnels comme Googlebot. Alors que le robots.txt conventionnel se concentrait historiquement sur la gestion de Googlebot, Bingbot et autres moteurs d’indexation, l’émergence des grands modèles de langage et des systèmes d’entraînement IA a créé une toute nouvelle catégorie de trafic bots nécessitant des stratégies de gestion séparées. Selon des données récentes de novembre 2025, les crawlers IA représentent désormais environ 80 % de l’ensemble du trafic bots sur de nombreux sites éditeurs, faisant passer la configuration robots.txt d’un simple outil SEO à un mécanisme critique de protection du contenu. Cette distinction est importante car les crawlers d’entraînement IA fonctionnent selon des modèles économiques différents de ceux des moteurs de recherche—ils collectent des données pour entraîner des modèles propriétaires plutôt que de générer du trafic référent—ce qui rend l’échange traditionnel entre visibilité dans les recherches et autorisation des crawlers inopérant. Pour les éditeurs, cela signifie que les décisions robots.txt influencent directement la visibilité du contenu auprès des systèmes IA, l’utilisation potentielle non autorisée du contenu propriétaire dans les jeux de données d’entraînement, et les implications globales sur le trafic et les revenus liées à la découverte par l’IA.

Les crawlers IA se répartissent en trois grandes catégories opérationnelles, chacune ayant des caractéristiques, des implications sur le trafic et des enjeux stratégiques différents pour les éditeurs. Les crawlers d’entraînement sont conçus pour collecter de grands volumes de textes destinés au développement de modèles d’apprentissage automatique : ils opèrent avec des besoins importants en bande passante, génèrent une forte charge serveur et n’apportent aucun trafic référent—parmi eux, GPTBot d’OpenAI et ClaudeBot d’Anthropic. Les crawlers de recherche et de citation fonctionnent de façon similaire aux moteurs de recherche traditionnels en indexant le contenu pour la recherche et en fournissant de l’attribution : ils génèrent des volumes de trafic modérés et peuvent apporter du trafic via des citations et liens—dans cette catégorie figurent OAI-SearchBot d’OpenAI et le crawler AI Overviews de Google. Les crawlers déclenchés par l’utilisateur interviennent à la demande lorsque des utilisateurs demandent explicitement une analyse IA d’une page, comme la navigation web de ChatGPT ou l’analyse de document de Claude : ils génèrent un trafic plus faible mais représentent un engagement direct avec votre contenu. Cette catégorisation est stratégique car les crawlers d’entraînement posent les plus grands enjeux de protection du contenu avec peu d’intérêt business, les crawlers de recherche offrent un compromis avec un potentiel référent, et les crawlers déclenchés par l’utilisateur s’alignent généralement sur l’intention utilisateur et peuvent accroître la visibilité du contenu.

| Catégorie de crawler | Objectif | Volume de trafic | Potentiel référent | Risque pour le contenu | Exemples |

|---|---|---|---|---|---|

| Entraînement | Développement de modèles | Très élevé | Aucun | Très élevé | GPTBot, ClaudeBot |

| Recherche/Citation | Indexation & attribution | Modéré | Modéré | Modéré | OAI-SearchBot, Google AI |

| Déclenché par l’utilisateur | Analyse à la demande | Faible | Faible | Faible | ChatGPT Web Browse, Claude |

Les principales sociétés d’IA exploitant des crawlers sont OpenAI, Anthropic, Google, Meta, Apple et Amazon, chacune utilisant des chaînes d’user-agent distinctes permettant leur identification dans les journaux serveur et la configuration robots.txt. OpenAI exploite plusieurs crawlers : GPTBot (user-agent : GPTBot/1.0) pour la collecte de données d’entraînement, OAI-SearchBot (user-agent : OAI-SearchBot/1.0) pour l’indexation de recherche et de citation, et ChatGPT-User (user-agent : ChatGPT-User/1.0) pour la navigation web déclenchée par l’utilisateur. Le crawler principal d’Anthropic est ClaudeBot (user-agent : Claude-Web/1.0 ou anthropic-ai) utilisé pour l’entraînement et la constitution de base de connaissances. Google utilise Google-Extended (user-agent : Google-Extended/1.1) pour Gemini et d’autres produits IA, tandis que Meta utilise facebookexternalhit pour l’analyse de contenu, Apple AppleBot pour Siri et la recherche, et Amazon Amazonbot pour Alexa et la recherche. Pour identifier ces crawlers dans vos logs serveur, examinez l’en-tête User-Agent des requêtes HTTP—la plupart des crawlers IA légitimes incluent le nom de la société et un numéro de version dans ce champ. Pour une sécurité renforcée, vous pouvez vérifier la légitimité du crawler en contrôlant l’adresse IP source via les plages IP publiées par chaque société ; OpenAI publie ses plages d’IP crawler, tout comme Google et d’autres acteurs majeurs, ce qui vous permet de distinguer les crawlers légitimes des user-agents usurpés.

La syntaxe de base pour des règles robots.txt spécifiques à l’IA respecte le format standard robots.txt avec correspondance d’user-agent et directives allow/disallow ciblant des crawlers spécifiques. Pour bloquer GPTBot d’OpenAI pour la collecte de données d’entraînement tout en autorisant leur crawler de recherche, vous pouvez structurer votre robots.txt ainsi :

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Pour un contrôle plus fin, vous pouvez appliquer des règles par chemin, bloquant certaines sections tout en en autorisant d’autres—par exemple, interdire l’accès des crawlers IA à votre contenu payant ou sections de contenu généré par les utilisateurs :

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Vous pouvez regrouper plusieurs user-agents sous un même ensemble de règles pour appliquer des restrictions identiques à plusieurs crawlers, simplifiant ainsi la configuration. Tester et valider votre robots.txt est essentiel : des outils comme le robots.txt tester de Google Search Console et des validateurs tiers permettent de vérifier la correction syntaxique et l’interprétation attendue par les crawlers. Gardez à l’esprit que robots.txt est consultatif et non contraignant—les crawlers conformes respecteront ces règles, mais certains acteurs malveillants ou bots non conformes peuvent les ignorer, nécessitant des mécanismes supplémentaires au niveau serveur pour le contenu sensible.

La décision de bloquer ou autoriser les crawlers IA implique des arbitrages fondamentaux entre protection du contenu et visibilité, qui varient selon votre modèle économique et votre stratégie éditoriale. Bloquer les crawlers d’entraînement comme GPTBot élimine le risque que votre contenu soit utilisé pour l’entraînement de modèles IA propriétaires sans compensation, mais signifie aussi que votre contenu n’apparaîtra pas dans les réponses générées par l’IA, réduisant potentiellement la découverte et le trafic émanant d’utilisateurs interagissant avec des systèmes IA. À l’inverse, autoriser les crawlers d’entraînement augmente la probabilité que votre contenu soit intégré dans des jeux de données IA, potentiellement sans attribution ou compensation, mais peut améliorer la visibilité si ces IA citent ou référencent ultérieurement votre contenu. La décision stratégique doit prendre en compte votre avantage concurrentiel—recherches propriétaires, analyses originales, données uniques justifient un blocage strict, tandis que le contenu pédagogique général ou l’information de commodité peut tirer profit d’une visibilité IA plus large. Les différents types d’éditeurs font face à des arbitrages distincts : les médias d’actualité accepteront les crawlers de recherche pour obtenir du trafic de citation tout en bloquant les crawlers d’entraînement, les éditeurs éducatifs pourront ouvrir l’accès pour élargir leur audience, et les sociétés SaaS bloqueront tous les crawlers IA pour protéger leur documentation propriétaire. Surveillez l’impact de vos choix de blocage via les logs serveur et les analyses de trafic pour vous assurer que votre configuration produit les résultats business attendus.

Bien que robots.txt fournisse un mécanisme clair pour communiquer vos politiques aux crawlers, il reste consultatif et non juridiquement contraignant—les crawlers conformes respecteront vos règles, mais les acteurs non conformes peuvent les ignorer, imposant des couches techniques d’application supplémentaires. La vérification IP et la mise en liste blanche constituent la méthode d’application la plus fiable : en maintenant une liste des adresses IP légitimes publiées par OpenAI, Google, Anthropic et autres grands acteurs IA, vous pouvez vérifier que les requêtes prétendant venir de ces crawlers émanent bien de leur infrastructure. Les règles de pare-feu et le blocage serveur offrent le niveau de protection le plus fort, permettant de rejeter les requêtes de certains user-agents ou plages IP au niveau réseau, avant consommation de ressources serveur. Pour les serveurs Apache, une configuration .htaccess peut appliquer les restrictions :

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Les balises meta dans la section

de vos pages HTML offrent un contrôle granulaire, au niveau de la page, sans modification du robots.txt :<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Analyser régulièrement les logs serveur pour l’activité des crawlers permet d’identifier de nouveaux bots, de vérifier que vos règles sont respectées et de détecter des user-agents usurpés tentant de contourner vos restrictions. Des outils comme Knowatoa et Merkle proposent une validation automatisée et le suivi du comportement des crawlers, offrant une visibilité sur les accès et le respect de vos directives.

La maintenance continue de votre robots.txt spécifique à l’IA est essentielle car le paysage des crawlers IA évolue rapidement, avec l’apparition régulière de nouveaux bots et la modification des chaînes d’user-agent et des comportements. Votre stratégie de suivi doit inclure :

L’évolution rapide des technologies de crawlers IA fait qu’une configuration robots.txt adéquate il y a six mois peut ne plus correspondre à vos besoins actuels ou au niveau de menace du moment, ce qui rend la révision régulière indispensable à une protection efficace du contenu.

La prochaine génération de crawlers IA présente des défis inédits que la configuration robots.txt traditionnelle ne peut pas toujours résoudre efficacement. Les crawlers navigateur agentiques comme ChatGPT Atlas et Google Project Mariner se comportent comme de véritables navigateurs web, exécutant JavaScript, interagissant avec les pages et se rendant indiscernables des utilisateurs humains—ces crawlers peuvent ne pas s’identifier par une chaîne d’user-agent distinctive, rendant le blocage via robots.txt inopérant. De nombreux crawlers émergents adoptent des chaînes d’user-agent Chrome standard pour éviter la détection et le blocage, masquant intentionnellement leur identité pour contourner les règles robots.txt et autres contrôles d’accès. Cette tendance conduit à un passage nécessaire au blocage par IP, obligeant les éditeurs à maintenir des listes blanches d’IP de crawlers légitimes et à bloquer tout autre trafic suspect, faisant évoluer le modèle d’application du filtrage par user-agent vers le contrôle d’accès réseau. L’usurpation de user-agent et les techniques de contournement deviennent de plus en plus courantes, des acteurs malveillants se faisant passer pour des crawlers légitimes ou utilisant des chaînes génériques pour éviter la détection. L’avenir de la gestion des crawlers IA nécessitera probablement une approche multi-couches combinant robots.txt, vérification IP, règles de pare-feu et potentiellement une analyse comportementale pour différencier les crawlers légitimes des acteurs malveillants. Se tenir informé des nouvelles technologies de crawlers et participer aux discussions sectorielles sur l’éthique et les standards des crawlers est essentiel pour les éditeurs souhaitant maintenir des stratégies de protection efficaces.

Mettre en œuvre une configuration robots.txt spécifique à l’IA efficace nécessite une approche globale conciliant protection du contenu et objectifs de visibilité stratégique. Commencez par une politique claire de protection du contenu définissant quelles catégories doivent être bloquées (recherche propriétaire, contenu premium, contenu généré par les utilisateurs) et lesquelles peuvent être exposées aux crawlers IA (articles publics, contenus éducatifs, informations de commodité). Optez pour une stratégie de blocage par paliers différenciant crawlers d’entraînement (généralement bloqués), crawlers de recherche (généralement autorisés avec suivi), et crawlers déclenchés par l’utilisateur (généralement autorisés), plutôt qu’une approche binaire d’autorisation ou blocage global de tous les crawlers IA. Combinez robots.txt et application serveur en mettant en place des règles de pare-feu et une vérification IP pour vos contenus les plus sensibles, car robots.txt seul est insuffisant pour une protection forte. Intégrez la gestion des crawlers IA à votre stratégie SEO et éditoriale globale en tenant compte de l’impact des décisions de blocage sur votre visibilité dans les réponses générées par l’IA, les citations et la recherche propulsée par l’IA—cette intégration garantit que votre configuration robots.txt soutient vos objectifs business. Établissez un rythme de surveillance et de maintenance avec des revues hebdomadaires des logs, une vérification IP mensuelle et des audits trimestriels complets pour garantir l’efficacité de votre configuration à mesure que le paysage des crawlers évolue. Utilisez des outils comme AmICited.com pour surveiller la visibilité de votre contenu à travers les systèmes IA et comprendre l’impact de vos choix de blocage sur la découverte et la citation IA. Selon votre activité : les médias d’actualité devraient typiquement autoriser les crawlers de recherche tout en bloquant les crawlers d’entraînement pour maximiser le trafic de citation ; les éditeurs éducatifs pourront envisager un accès plus large pour accroître leur portée ; les sociétés SaaS devront mettre en place un blocage strict pour la documentation propriétaire. Lorsque le blocage robots.txt s’avère insuffisant face à des user-agents usurpés ou des crawlers non conformes, passez à des règles de pare-feu et au blocage IP pour faire respecter vos politiques de protection du contenu au niveau réseau.

Les robots d’entraînement comme GPTBot et ClaudeBot collectent des données pour le développement de modèles et n’apportent aucun trafic référent, ce qui en fait un risque élevé pour la protection du contenu. Les robots de recherche comme OAI-SearchBot et PerplexityBot indexent le contenu pour la recherche basée sur l’IA et peuvent générer du trafic référent via des citations. La plupart des éditeurs bloquent les robots d’entraînement tout en autorisant les robots de recherche pour équilibrer la protection du contenu et la visibilité.

Google déclare officiellement que le blocage de Google-Extended n’a pas d’impact sur le classement dans la recherche ni sur l’inclusion dans AI Overviews. Cependant, certains webmasters ont exprimé des inquiétudes, il est donc conseillé de surveiller vos performances de recherche après la mise en place des blocages. Les AI Overviews de Google Search suivent les règles standard de Googlebot, pas celles de Google-Extended.

Oui, robots.txt est un fichier à valeur consultative, non contraignant. Les robots respectueux provenant de grandes entreprises respectent généralement les directives de robots.txt, mais certains crawlers les ignorent. Pour une protection renforcée, mettez en place un blocage au niveau du serveur via .htaccess ou des règles de pare-feu, et vérifiez la légitimité des robots grâce aux plages d’adresses IP publiées.

Examinez et mettez à jour votre liste de blocage au moins chaque trimestre. De nouveaux crawlers IA apparaissent régulièrement, donc vérifiez les journaux de serveur chaque mois pour identifier les nouveaux crawlers qui accèdent à votre site. Suivez les ressources communautaires comme le projet ai.robots.txt sur GitHub pour rester informé des nouveaux crawlers et des chaînes d’user-agent.

Cela dépend de vos priorités business. Bloquer les crawlers d’entraînement protège votre contenu contre une utilisation dans l’entraînement de modèles IA sans compensation. Bloquer les crawlers de recherche peut réduire votre visibilité sur des plateformes de découverte pilotées par l’IA comme la recherche ChatGPT ou Perplexity. Beaucoup d’éditeurs optent pour un blocage sélectif ciblant les crawlers d’entraînement tout en autorisant les crawlers de recherche et de citation.

Vérifiez les journaux de votre serveur pour repérer les chaînes d’user-agent des crawlers et assurez-vous que les crawlers bloqués n’accèdent pas à vos pages de contenu. Utilisez des outils d’analyse pour surveiller les modèles de trafic des robots. Testez votre configuration avec Knowatoa AI Search Console ou le robots.txt Tester de Merkle pour valider l’efficacité de vos règles.

Les crawlers navigateur agentiques comme ChatGPT Atlas et Google Project Mariner fonctionnent comme des navigateurs web complets plutôt que de simples clients HTTP. Ils utilisent souvent des chaînes d’user-agent Chrome standards, ce qui les rend indiscernables du trafic navigateur classique. Le blocage par adresse IP devient alors nécessaire pour contrôler l’accès à ces crawlers avancés.

Le robots.txt spécifique à l’IA contrôle l’accès à votre contenu, tandis que des outils comme AmICited surveillent la façon dont les plateformes IA référencent et citent votre contenu. Ensemble, ils offrent une visibilité et un contrôle complets : robots.txt gère l’accès des crawlers, et les outils de monitoring suivent l’impact de votre contenu à travers les systèmes IA.

AmICited suit comment les systèmes IA comme ChatGPT, Claude, Perplexity et Google AI Overviews citent et référencent votre marque. Associez une configuration robots.txt à une surveillance de la visibilité IA pour comprendre l’impact de votre contenu sur les plateformes IA.

Découvrez comment configurer robots.txt pour contrôler l'accès des crawlers IA, y compris GPTBot, ClaudeBot et Perplexity. Gérez la visibilité de votre marque d...

Discussion communautaire sur l'autorisation des bots IA à explorer votre site. Retours d'expérience sur la configuration de robots.txt, la mise en place de llms...

Discussion communautaire sur la configuration de robots.txt pour les crawleurs IA comme GPTBot, ClaudeBot et PerplexityBot. Retours d'expérience de webmasters e...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.