Créer des réponses méta LLM : des insights autonomes que l'IA peut citer

Découvrez comment créer des réponses méta LLM que les systèmes d'IA citent. Découvrez des techniques structurelles, des stratégies de densité de réponse et des ...

Contenu qui répond directement à la façon dont les modèles de langage peuvent interpréter et répondre aux requêtes connexes, conçu pour améliorer la visibilité dans les réponses générées par l’IA sur des plateformes comme ChatGPT, Google AI Overviews et Perplexity. Les réponses méta LLM représentent des réponses synthétisées combinant des informations issues de multiples sources en des réponses conversationnelles cohérentes qui répondent à l’intention de l’utilisateur.

Contenu qui répond directement à la façon dont les modèles de langage peuvent interpréter et répondre aux requêtes connexes, conçu pour améliorer la visibilité dans les réponses générées par l’IA sur des plateformes comme ChatGPT, Google AI Overviews et Perplexity. Les réponses méta LLM représentent des réponses synthétisées combinant des informations issues de multiples sources en des réponses conversationnelles cohérentes qui répondent à l’intention de l’utilisateur.

Les réponses méta LLM représentent les réponses synthétisées et générées par l’IA que produisent les grands modèles de langage lorsque les utilisateurs les interrogent via des plateformes telles que ChatGPT, Claude ou Google AI Overviews. Ces réponses diffèrent fondamentalement des résultats de recherche traditionnels car elles combinent des informations issues de multiples sources en une réponse conversationnelle cohérente qui répond directement à l’intention de l’utilisateur. Plutôt que de présenter une liste de liens, les LLM analysent le contenu récupéré et génèrent un texte original intégrant faits, perspectives et idées issus de leurs données d’entraînement et de systèmes de génération enrichie par la recherche (RAG). Comprendre comment les LLM construisent ces réponses méta est essentiel pour les créateurs de contenu souhaitant que leur travail soit cité et référencé dans les réponses générées par l’IA. La visibilité de votre contenu dans ces réponses IA est devenue aussi importante que le classement dans les résultats de recherche traditionnels, faisant de l’optimisation LLM (LLMO) un pilier de la stratégie moderne de contenu.

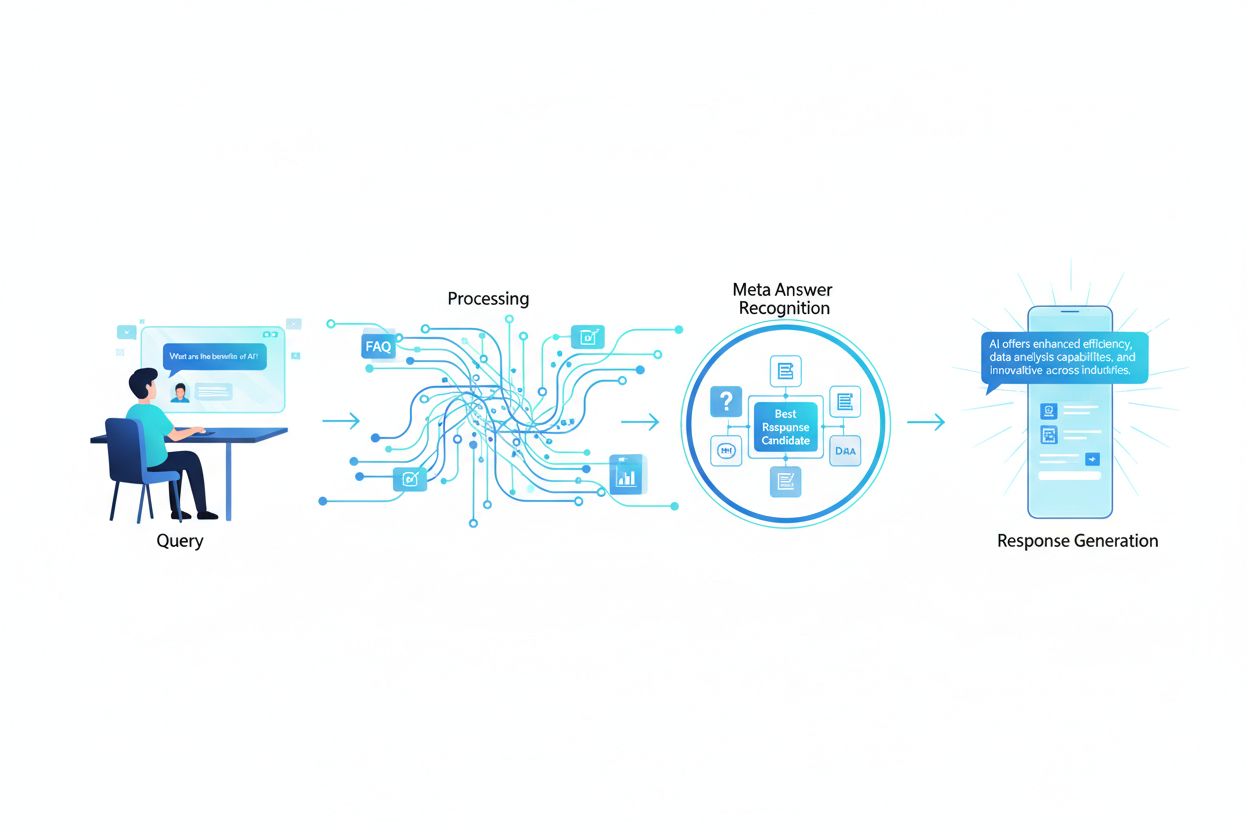

Lorsqu’un utilisateur soumet une requête à un LLM, le système ne se contente pas de faire correspondre des mots-clés comme le font les moteurs de recherche traditionnels. À la place, les LLM réalisent une analyse sémantique pour comprendre l’intention sous-jacente, le contexte et les nuances de la question. Le modèle décompose la requête en éléments conceptuels, identifie les sujets et entités associés, et détermine quel type de réponse serait le plus utile—définition, comparaison, guide étape par étape ou analyse. Les LLM récupèrent ensuite le contenu pertinent de leur base de connaissances via des systèmes RAG qui privilégient les sources selon la pertinence, l’autorité et l’exhaustivité. Le processus de récupération ne tient pas seulement compte des correspondances exactes de mots-clés, mais aussi de la similarité sémantique, des relations thématiques et de la façon dont le contenu traite les aspects spécifiques de la requête. Cela signifie que votre contenu doit être découvrable non seulement pour des mots-clés exacts, mais aussi pour les concepts sémantiques et sujets connexes que les utilisateurs recherchent réellement.

| Facteur d’interprétation de la requête | Recherche traditionnelle | Réponses Méta LLM |

|---|---|---|

| Méthode de correspondance | Correspondance de mots-clés | Compréhension sémantique |

| Format du résultat | Liste de liens | Narratif synthétisé |

| Sélection des sources | Classement selon la pertinence | Pertinence + exhaustivité + autorité |

| Prise en compte du contexte | Limitée | Contexte sémantique étendu |

| Synthèse de la réponse | L’utilisateur doit lire plusieurs sources | L’IA combine plusieurs sources |

| Exigence de citation | Optionnelle | Souvent incluse |

Pour que votre contenu soit sélectionné et cité dans les réponses méta LLM, il doit posséder plusieurs caractéristiques essentielles en phase avec la façon dont ces systèmes évaluent et synthétisent l’information. D’abord, votre contenu doit démontrer une expertise et une autorité claires sur le sujet, avec de forts signaux E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) qui aident les LLM à identifier les sources fiables. Ensuite, le contenu doit offrir un véritable gain informationnel—des perspectives, données ou analyses uniques qui ajoutent de la valeur au-delà de ce qui est généralement disponible. Troisièmement, votre contenu doit être structuré de manière à ce que les LLM puissent facilement en extraire les informations pertinentes, grâce à des hiérarchies claires et une organisation logique. Quatrièmement, la richesse sémantique est indispensable ; votre contenu doit explorer en profondeur les concepts connexes, employer une terminologie variée et bâtir une autorité thématique globale plutôt que de se concentrer étroitement sur des mots-clés isolés. Cinquièmement, la fraîcheur est primordiale pour les sujets d’actualité, car les LLM privilégient les informations récentes et à jour lors de la synthèse des réponses. Enfin, votre contenu doit comporter des preuves corroborantes sous forme de citations, de données et de références externes qui renforcent la confiance auprès des systèmes LLM.

Caractéristiques essentielles qui favorisent la citation LLM :

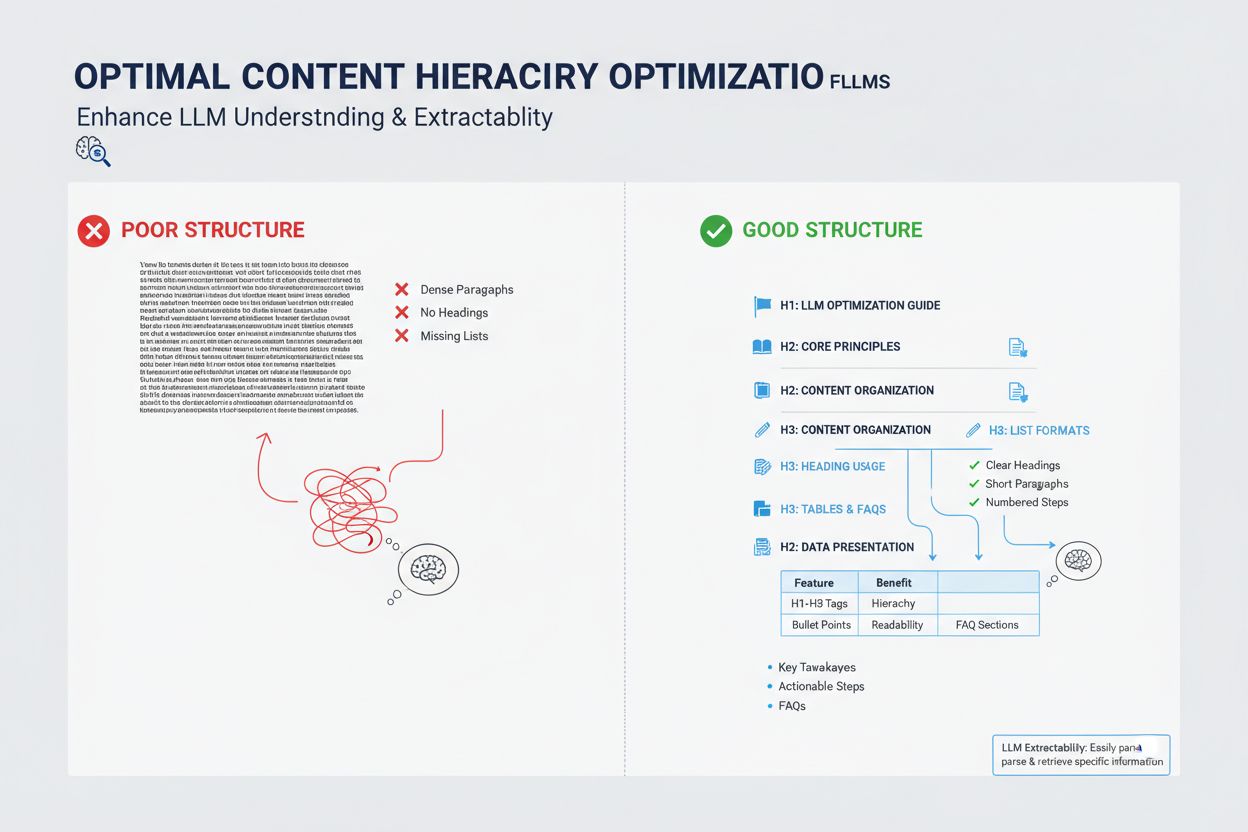

La manière dont vous structurez votre contenu a un impact déterminant sur les chances que les LLM le sélectionnent pour les réponses méta, car ces systèmes sont optimisés pour extraire et synthétiser les informations bien organisées. Les LLM privilégient fortement les contenus aux hiérarchies de titres claires (H1, H2, H3) qui créent une architecture logique de l’information, permettant au modèle de saisir les relations entre les concepts et d’extraire efficacement les sections pertinentes. Les listes à puces et numérotées sont particulièrement précieuses car elles présentent l’information sous forme d’unités scannables et distinctes que les LLM peuvent facilement intégrer dans leurs réponses synthétisées. Les tableaux sont extrêmement puissants pour la visibilité LLM car ils présentent des données structurées dans un format facile à interpréter et à référencer pour les systèmes IA. Les paragraphes courts (3-5 phrases) sont préférés aux blocs de texte denses, car ils permettent aux LLM d’identifier et d’extraire des informations spécifiques sans devoir parcourir du contenu non pertinent. De plus, l’utilisation du balisage schema (FAQ, Article, HowTo) fournit des signaux explicites aux LLM sur la structure et la finalité de votre contenu, ce qui augmente significativement les chances de citation.

Bien que les réponses méta LLM et les extraits optimisés puissent sembler similaires de prime abord, ils représentent des mécanismes de visibilité de contenu fondamentalement différents et nécessitent des stratégies d’optimisation distinctes. Les extraits optimisés sont sélectionnés par les algorithmes de recherche traditionnels à partir du contenu web existant et affichés dans une position spécifique sur la page de résultats, généralement sous forme d’extrait de 40 à 60 mots. Les réponses méta LLM, en revanche, sont des réponses générées par l’IA qui synthétisent des informations issues de plusieurs sources en un nouveau récit original, souvent plus long et plus complet que n’importe quelle source unique. Les extraits optimisés récompensent le contenu qui répond directement à une question spécifique de façon concise, tandis que les réponses méta LLM valorisent les contenus exhaustifs et faisant autorité, offrant une couverture approfondie du sujet. Les mécanismes de citation diffèrent : les extraits optimisés affichent un lien source et le texte extrait, tandis que les réponses méta LLM peuvent paraphraser ou synthétiser votre contenu et incluent généralement une attribution. De plus, les extraits optimisés sont surtout pensés pour la recherche traditionnelle, alors que les réponses méta LLM sont optimisées pour les plateformes IA et peuvent ne pas apparaître du tout dans les résultats de recherche.

| Aspect | Extraits Optimisés | Réponses Méta LLM |

|---|---|---|

| Méthode de génération | L’algorithme extrait du texte existant | L’IA synthétise à partir de plusieurs sources |

| Format d’affichage | Position dans la page de résultats | Réponse sur une plateforme IA |

| Longueur du contenu | Environ 40-60 mots | 200-500+ mots |

| Style de citation | Lien source avec texte extrait | Attribution avec contenu paraphrasé |

| Axe d’optimisation | Réponses directes et concises | Autorité et couverture complète |

| Plateforme | Recherche Google | ChatGPT, Claude, Google AI Overviews |

| Métrique de visibilité | Impressions de recherche | Citations dans les réponses IA |

La richesse sémantique—profondeur et étendue de la couverture conceptuelle dans votre contenu—est l’un des facteurs les plus importants, mais souvent négligés, de l’optimisation LLM. Les LLM ne recherchent pas uniquement votre mot-clé cible ; ils analysent les relations sémantiques entre les concepts, l’information contextuelle entourant votre sujet principal, et la profondeur avec laquelle vous explorez les idées associées. Un contenu riche sémantiquement utilise une terminologie variée, aborde un sujet sous plusieurs angles et établit des liens entre concepts connexes, aidant ainsi les LLM à comprendre que votre contenu est réellement expert et non superficiellement optimisé pour les mots-clés. Lorsque vous rédigez sur un sujet, intégrez des termes liés, synonymes et idées adjacentes conceptuellement qui aideront les LLM à situer votre contenu dans un graphe de connaissances plus large. Par exemple, un article sur le « marketing de contenu » devrait naturellement inclure des discussions sur la segmentation d’audience, les personas, la distribution du contenu, l’analytique et le ROI—non pas pour gonfler les mots-clés, mais parce que ces concepts sont sémantiquement liés et essentiels à une compréhension globale du sujet. Cette profondeur sémantique signale aux LLM que vous possédez une véritable expertise et pouvez fournir des réponses nuancées et multi-facettes, recherchées par les utilisateurs.

Les LLM évaluent l’autorité différemment des moteurs de recherche traditionnels, accordant davantage d’importance aux signaux démontrant une expertise réelle et une fiabilité plutôt qu’à la simple popularité des liens. Les références de l’auteur et l’expérience démontrée sont particulièrement importantes ; les LLM privilégient le contenu provenant d’experts reconnus, de praticiens ou d’organisations établies dans leur domaine. Les citations externes et références à d’autres sources faisant autorité renforcent la crédibilité auprès des systèmes LLM, car elles prouvent que votre contenu s’appuie sur des connaissances plus larges et est corroboré par d’autres experts. La cohérence sur plusieurs contenus d’un même sujet contribue à établir une autorité thématique ; les LLM reconnaissent lorsqu’un auteur ou une organisation a publié plusieurs contenus complets sur des sujets connexes. La validation tierce via des mentions, citations ou références d’autres sources crédibles renforce considérablement votre visibilité dans les réponses méta LLM. Les recherches originales, données propriétaires ou méthodologies inédites constituent des signaux puissants car elles représentent une information introuvable ailleurs. Enfin, maintenir un historique de publication à jour et rafraîchir régulièrement le contenu indique que vous êtes activement engagé dans votre domaine et à jour sur les évolutions.

Signaux d’autorité influençant la sélection LLM :

La fraîcheur du contenu est devenue un critère de plus en plus crucial pour la visibilité LLM, en particulier pour les sujets où les informations évoluent rapidement ou dont l’actualité influe fortement sur la réponse. Les LLM sont entraînés sur des données dont la date limite est fixée, mais ils s’appuient de plus en plus sur des systèmes RAG qui récupèrent des informations actuelles sur le web : la date de publication et la fréquence de mise à jour de votre contenu influencent donc directement sa sélection dans les réponses méta. Pour les sujets intemporels, des mises à jour régulières—même mineures, actualisant la date de publication—signalent aux LLM que votre contenu est entretenu et fiable. Pour les sujets sensibles à l’actualité comme les tendances, innovations technologiques ou événements récents, le contenu obsolète est activement dépriorisé par les LLM au profit de sources plus récentes. La meilleure pratique consiste à établir un calendrier de maintenance où vous révisez et mettez à jour les contenus clés chaque trimestre ou semestre, en rafraîchissant les statistiques, ajoutant de nouveaux exemples et intégrant les dernières évolutions. Cette maintenance continue améliore non seulement votre visibilité LLM, mais démontre aussi aux systèmes IA et aux lecteurs humains que vous êtes une source fiable et actuelle.

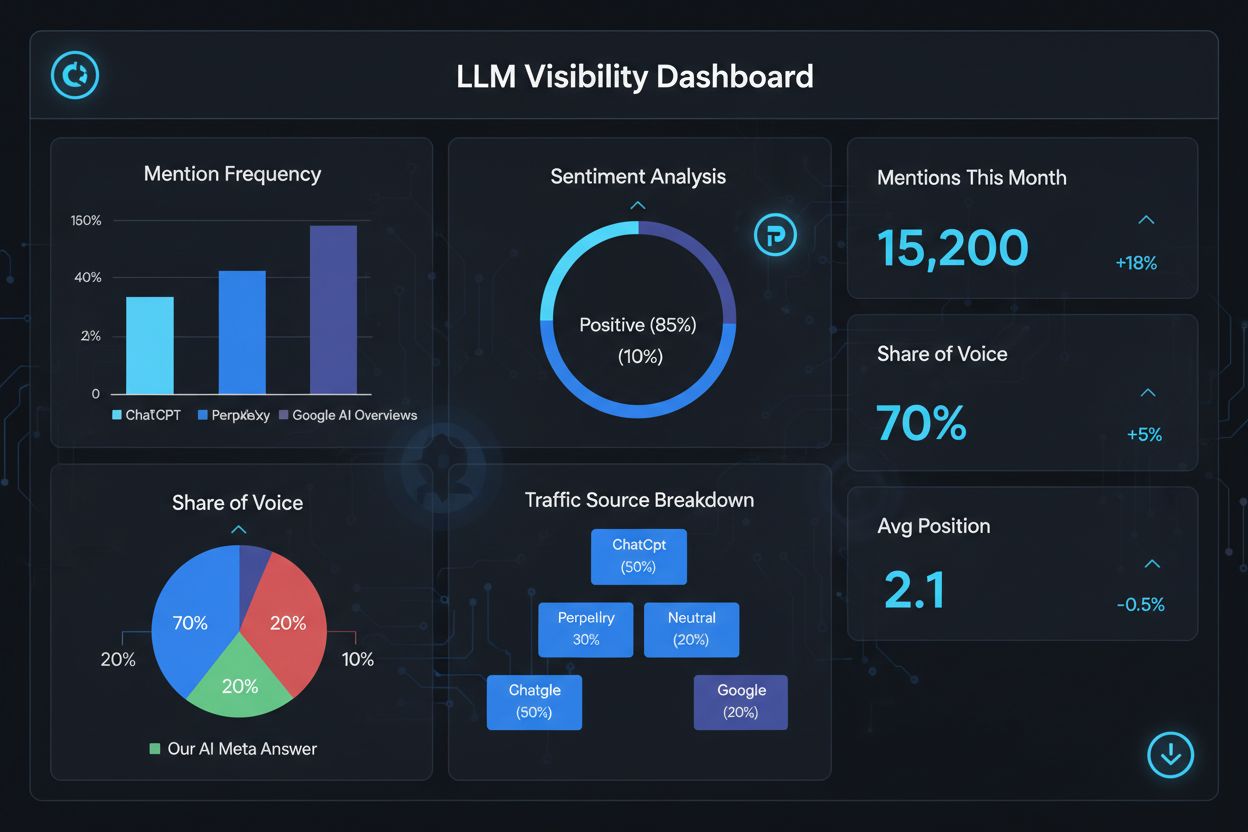

Mesurer votre succès dans les réponses méta LLM nécessite des métriques et outils différents du SEO traditionnel, car ces réponses existent en dehors de l’écosystème classique des résultats de recherche. Des outils comme AmICited.com proposent une surveillance spécialisée qui détecte quand et où votre contenu apparaît dans les réponses générées par l’IA, vous offrant de la visibilité sur les contenus cités et leur fréquence de citation. Vous devez suivre plusieurs indicateurs clés : fréquence de citation (combien de fois votre contenu apparaît dans les réponses LLM), contexte de citation (quels sujets déclenchent l’inclusion de votre contenu), diversité des sources (êtes-vous cité sur différentes plateformes LLM), et position de la réponse (votre contenu est-il mis en avant dans la synthèse générée). Analysez quelles pages ou sections spécifiques de votre contenu sont le plus souvent citées, car cela révèle quels types d’information les LLM jugent les plus précieux et fiables. Surveillez l’évolution de vos schémas de citation dans le temps pour identifier quelles optimisations fonctionnent et quels sujets nécessitent un développement complémentaire. Analysez aussi les requêtes qui déclenchent vos citations pour comprendre comment les LLM interprètent l’intention utilisateur et quelles variantes sémantiques sont les plus efficaces.

Indicateurs clés de performance des réponses méta LLM :

L’optimisation pour les réponses méta LLM nécessite une approche stratégique combinant mise en œuvre technique, qualité du contenu et mesure continue. Commencez par une recherche thématique approfondie pour identifier les lacunes où votre expertise peut offrir une valeur unique que les LLM privilégieront face aux sources génériques. Structurez votre contenu avec une hiérarchie claire, en utilisant des titres H2 et H3 pour créer une architecture logique facilement analysable et extractible par les LLM. Implémentez le balisage schema (FAQ, Article, HowTo) pour signaler explicitement la structure et la finalité de votre contenu aux systèmes LLM, améliorant significativement sa découvrabilité. Développez un contenu complet et faisant autorité, explorant votre sujet sous plusieurs angles, en intégrant des concepts liés et en bâtissant une richesse sémantique démontrant votre expertise réelle. Intégrez des recherches, données ou analyses originales qui apportent un gain informationnel et différencient votre contenu de la concurrence. Maintenez un calendrier de mise à jour régulier, en rafraîchissant les contenus clés chaque trimestre pour garantir la fraîcheur et signaler une autorité continue. Bâtissez votre autorité thématique en créant plusieurs contenus liés qui, ensemble, démontrent votre expertise sur une thématique donnée. Utilisez un langage clair et direct qui répond aux questions spécifiques des utilisateurs, facilitant l’extraction et la synthèse par les LLM. Enfin, suivez vos performances de citation LLM grâce à des outils spécialisés pour identifier ce qui fonctionne et affiner continuellement votre stratégie sur la base d’analyses de données.

Les réponses méta LLM se concentrent sur la manière dont les modèles de langage interprètent et citent le contenu, tandis que le SEO traditionnel vise le classement dans les résultats de recherche. Les LLM privilégient la pertinence et la clarté plutôt que l’autorité du domaine, rendant le contenu bien structuré et orienté vers la réponse plus important que les backlinks. Votre contenu peut être cité dans les réponses LLM même s’il n’est pas classé dans les premiers résultats de Google.

Structurez le contenu avec des titres clairs, fournissez des réponses directes en introduction, utilisez le balisage schema (FAQ, Article), incluez des citations et des statistiques, maintenez l’autorité sur le sujet, et assurez-vous que votre site soit accessible aux robots IA. Concentrez-vous sur la richesse sémantique, l’apport informationnel et une couverture thématique complète plutôt qu’un ciblage étroit de mots-clés.

Les LLM extraient plus facilement des extraits de contenu bien organisé. Des titres clairs, des listes, des tableaux et des paragraphes courts aident les modèles à identifier et citer l’information pertinente. Des études montrent que les pages citées par les LLM comportent nettement plus d’éléments structurés que la moyenne des pages web, faisant de la structure un facteur de classement essentiel.

Oui. Contrairement au SEO traditionnel, les LLM privilégient la pertinence de la requête et la qualité du contenu plutôt que l’autorité du domaine. Une page de niche bien structurée et très pertinente peut être citée par les LLM même si elle n’est pas classée dans les premiers résultats de Google, rendant l’expertise et la clarté plus importantes que l’autorité du site.

Mettez à jour le contenu régulièrement, surtout pour les sujets sensibles au temps. Ajoutez des horodatages indiquant la dernière mise à jour du contenu. Pour les sujets intemporels, un contrôle trimestriel est recommandé. Un contenu récent signale l’exactitude aux LLM, améliorant les chances de citation et démontrant une autorité continue.

AmICited.com est spécialisé dans la surveillance des mentions IA sur ChatGPT, Perplexity et Google AI Overviews. D’autres outils incluent l’AI SEO Toolkit de Semrush, Ahrefs Brand Radar et Peec AI. Ces outils suivent la fréquence des mentions, la part de voix, le sentiment et vous aident à mesurer le succès de l’optimisation.

Le balisage schema (FAQ, Article, HowTo) fournit une structure lisible par machine qui aide les LLM à comprendre et extraire le contenu avec plus de précision. Il signale le type et l’intention du contenu, rendant votre page plus susceptible d’être sélectionnée pour les requêtes pertinentes et améliorant la découvrabilité globale.

Les mentions externes sur des sites à forte autorité (actualité, Wikipédia, publications sectorielles) renforcent la crédibilité et augmentent les chances que les LLM citent votre contenu. Plusieurs sources indépendantes mentionnant votre marque ou vos données créent un schéma d’autorité que les LLM reconnaissent et récompensent par une fréquence de citation plus élevée.

Suivez comment votre marque apparaît dans les réponses générées par l’IA sur ChatGPT, Perplexity et Google AI Overviews grâce à la plateforme de surveillance spécialisée d’AmICited.

Découvrez comment créer des réponses méta LLM que les systèmes d'IA citent. Découvrez des techniques structurelles, des stratégies de densité de réponse et des ...

Découvrez comment les LLMs génèrent des réponses grâce à la tokenisation, l'architecture des transformeurs, les mécanismes d'attention et la prédiction probabil...

Découvrez comment identifier et cibler les sites sources des LLM pour des backlinks stratégiques. Découvrez quelles plateformes d'IA citent le plus de sources e...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.