Come Stabilire l'Affidabilità per la Ricerca AI - Guida Completa

Scopri come costruire segnali di fiducia per motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Approfondisci i principi E-E-A-T, i segnali di...

Valutazione AI dell’affidabilità dei contenuti basata sulle credenziali dell’autore, le citazioni e la verifica. La valutazione dell’affidabilità delle fonti analizza sistematicamente molteplici dimensioni tra cui l’esperienza dell’autore, la reputazione dell’editore, i modelli di citazione e i risultati del fact-checking per determinare se le fonti di informazione meritano di essere incluse in ricerche, basi di conoscenza o riassunti generati dall’IA. Questo processo automatizzato consente alle piattaforme di valutare la credibilità su milioni di fonti mantenendo una coerenza che i soli revisori umani non possono raggiungere.

Valutazione AI dell'affidabilità dei contenuti basata sulle credenziali dell'autore, le citazioni e la verifica. La valutazione dell'affidabilità delle fonti analizza sistematicamente molteplici dimensioni tra cui l'esperienza dell'autore, la reputazione dell'editore, i modelli di citazione e i risultati del fact-checking per determinare se le fonti di informazione meritano di essere incluse in ricerche, basi di conoscenza o riassunti generati dall'IA. Questo processo automatizzato consente alle piattaforme di valutare la credibilità su milioni di fonti mantenendo una coerenza che i soli revisori umani non possono raggiungere.

La valutazione dell’affidabilità delle fonti è la valutazione sistematica delle fonti di informazione per determinarne l’affidabilità, attendibilità e autorevolezza nel fornire informazioni accurate. Nel contesto dei sistemi alimentati dall’IA, la valutazione dell’affidabilità comporta l’analisi di molteplici dimensioni di una fonte per stabilire se il suo contenuto meriti di essere incluso in ricerche, citazioni o basi di conoscenza. La valutazione dell’affidabilità tramite IA opera esaminando le credenziali dell’autore—incluso il background educativo, l’esperienza professionale e la competenza nella materia—insieme ai modelli di citazione che indicano quanto frequentemente e positivamente altre fonti autorevoli fanno riferimento al lavoro. Il processo valuta i meccanismi di verifica come lo stato della revisione tra pari, l’affiliazione istituzionale e la reputazione della sede di pubblicazione per stabilire una fiducia di base. I segnali di affidabilità sono indicatori misurabili che i sistemi IA rilevano e ponderano, spaziando da marcatori espliciti come le qualifiche dell’autore a segnali impliciti derivati dall’analisi testuale e dai pattern nei metadati. I sistemi IA moderni riconoscono che la credibilità è multidimensionale; una fonte può essere altamente affidabile in un settore ma priva di autorevolezza in un altro, richiedendo una valutazione consapevole del contesto. Il processo di valutazione è diventato sempre più critico con l’esplosione del volume di informazioni e la rapida diffusione della disinformazione sulle piattaforme digitali. La valutazione automatizzata dell’affidabilità consente alle piattaforme di scalare la valutazione su milioni di fonti mantenendo una coerenza che i soli revisori umani non possono raggiungere. Comprendere come funzionano questi sistemi aiuta creatori di contenuti, ricercatori ed editori a ottimizzare le proprie fonti per il riconoscimento dell’affidabilità e aiuta i consumatori a prendere decisioni informate sull’attendibilità delle informazioni.

I sistemi AI valutano l’affidabilità delle fonti tramite un sofisticato multi-signal analysis che combina elaborazione del linguaggio naturale, modelli di machine learning e valutazione di dati strutturati. Il rilevamento dei segnali di affidabilità identifica marcatori specifici all’interno di testo, metadati e pattern di rete che correlano con informazioni affidabili; questi segnali vengono ponderati in base al loro valore predittivo per l’accuratezza. L’analisi NLP esamina pattern linguistici, densità delle citazioni, specificità delle affermazioni e certezza del linguaggio per valutare se il contenuto mostra le caratteristiche di una ricerca rigorosa o presenta tratti comuni a fonti inaffidabili. I modelli di machine learning addestrati su grandi dataset di fonti affidabili e non affidabili imparano a riconoscere pattern complessi che possono sfuggire agli umani, consentendo valutazioni in tempo reale su larga scala. L’integrazione del fact-checking incrocia le affermazioni con database verificati e fatti consolidati, evidenziando contraddizioni o affermazioni non supportate che riducono il punteggio di affidabilità. Questi sistemi impiegano metodi ensemble che combinano diversi approcci valutativi, riconoscendo che nessun segnale singolo predice perfettamente l’affidabilità. La tabella seguente illustra le principali categorie di segnali che i sistemi IA analizzano:

| Tipo di Segnale | Cosa Misura | Esempi |

|---|---|---|

| Segnali Accademici | Stato della revisione tra pari, sede di pubblicazione, affiliazione istituzionale | Impact factor della rivista, ranking delle conferenze, reputazione dell’università |

| Segnali Testuali | Qualità della scrittura, densità delle citazioni, specificità delle affermazioni, pattern linguistici | Citazioni corrette, terminologia tecnica, affermazioni basate su evidenze |

| Segnali di Metadati | Credenziali dell’autore, data di pubblicazione, frequenza di aggiornamento, storia della fonte | Titoli di studio dell’autore, cronologia della pubblicazione, storia delle revisioni |

| Segnali Sociali | Numero di citazioni, pattern di condivisione, approvazioni di esperti, coinvolgimento comunitario | Citazioni su Google Scholar, menzioni in reti accademiche, raccomandazioni tra pari |

| Segnali di Verifica | Risultati del fact-checking, corroborazione delle affermazioni, trasparenza della fonte | Verifica Snopes, conferme indipendenti multiple, disclosure della metodologia |

| Segnali Strutturali | Organizzazione dei contenuti, chiarezza metodologica, disclosure di conflitti di interesse | Sezioni chiare, metodi trasparenti, trasparenza sulla fonte di finanziamento |

I fattori di affidabilità più influenti che i sistemi AI valutano includono molteplici dimensioni interconnesse che insieme stabiliscono l’affidabilità della fonte. La reputazione dell’autore è un marcatore fondamentale, con esperti affermati nel loro campo che pesano molto più di contributori sconosciuti. La reputazione dell’editore estende la valutazione all’ambito istituzionale, riconoscendo che le fonti pubblicate su riviste peer-reviewed o da case editrici accademiche affermate dimostrano una credibilità di base superiore. I modelli di citazione rivelano come la comunità accademica abbia accolto la fonte; lavori molto citati in sedi autorevoli indicano una validazione della qualità della ricerca. La recenza conta in base al contesto—le pubblicazioni recenti dimostrano conoscenze attuali mentre opere più datate mantengono credibilità per il loro impatto storico e la rilevanza persistente. Gli algoritmi di rilevamento dei bias esaminano se le fonti dichiarano possibili conflitti di interesse, fonti di finanziamento o posizioni ideologiche che possono influenzarne le conclusioni. I segnali di coinvolgimento dalla comunità accademica e professionale, incluse citazioni e discussioni tra pari, forniscono una validazione esterna dell’affidabilità. I seguenti fattori rappresentano gli elementi più critici che i sistemi AI privilegiano:

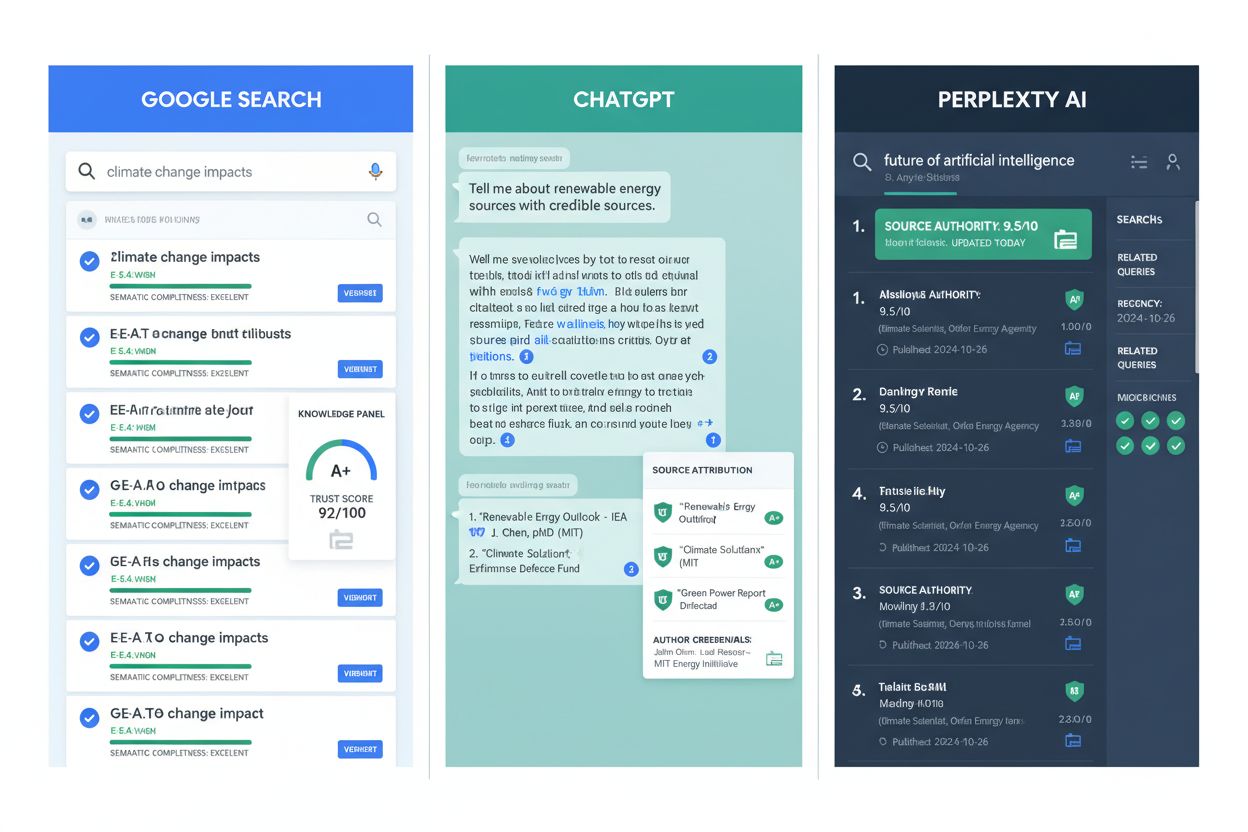

La valutazione dell’affidabilità tramite IA è ormai parte integrante delle principali piattaforme informative e delle infrastrutture di ricerca. Google AI Overviews utilizza segnali di affidabilità per determinare quali fonti appaiono nei riassunti generati dall’IA, privilegiando contenuti di editori affermati ed esperti verificati. ChatGPT e modelli linguistici simili impiegano la valutazione dell’affidabilità durante l’addestramento per pesare appropriatamente le fonti, sebbene affrontino sfide nella valutazione in tempo reale di nuove affermazioni. Perplexity AI incorpora esplicitamente l’affidabilità della fonte nella sua metodologia di citazione, mostrando la reputazione della fonte accanto ai risultati per aiutare gli utenti a valutare la qualità delle informazioni. Nella ricerca accademica, gli strumenti di valutazione dell’affidabilità aiutano i ricercatori a identificare più rapidamente fonti di alta qualità, riducendo il tempo necessario per la revisione della letteratura e migliorando la qualità delle basi di ricerca. Le iniziative di conservazione dei contenuti usano la valutazione dell’affidabilità per dare priorità all’archiviazione delle fonti autorevoli, garantendo che i futuri ricercatori abbiano accesso a informazioni storiche affidabili. AmICited.com è una soluzione di monitoraggio che traccia come le fonti vengono citate e valutate su diverse piattaforme, aiutando gli editori a comprendere il proprio posizionamento e a individuare opportunità di miglioramento. Le organizzazioni di fact-checking sfruttano la valutazione automatica per dare priorità alle affermazioni da verificare manualmente, concentrando lo sforzo umano sulla disinformazione ad alto impatto. Le istituzioni educative utilizzano sempre più strumenti di valutazione dell’affidabilità per insegnare agli studenti a valutare le fonti, rendendo criteri impliciti espliciti e misurabili. Queste applicazioni dimostrano che la valutazione dell’affidabilità è passata da quadro teorico a infrastruttura pratica a supporto della qualità delle informazioni negli ecosistemi digitali.

Nonostante i notevoli progressi, la valutazione automatizzata dell’affidabilità presenta limiti sostanziali che richiedono supervisione umana e giudizio contestuale. Il bias dei segnali di coinvolgimento è una sfida fondamentale; fonti popolari possono ricevere punteggi elevati in base ai segnali sociali nonostante contengano informazioni imprecise, poiché le metriche di coinvolgimento non sempre correlano con l’accuratezza. Si verificano falsi positivi e negativi quando gli algoritmi classificano erroneamente le fonti—esperti affermati in campi emergenti possono non avere una storia di citazioni sufficiente, mentre creatori di disinformazione prolifici sviluppano segnali di affidabilità sofisticati. Le tattiche di disinformazione in evoluzione sfruttano deliberatamente i sistemi di valutazione imitando fonti legittime, creando false credenziali e citazioni fasulle che ingannano i sistemi automatizzati. La variazione della credibilità a seconda del dominio significa che una fonte affidabile in un settore può non avere autorevolezza in un altro, ma i sistemi talvolta applicano punteggi uniformi su tutti i domini. Le dinamiche temporali complicano la valutazione; fonti affidabili al momento della pubblicazione possono diventare obsolete o screditate con l’emergere di nuove evidenze, richiedendo una rivalutazione continua anziché un punteggio statico. Il bias culturale e linguistico nei dati di addestramento fa sì che i sistemi possano sottovalutare fonti di regioni non anglofone o comunità sottorappresentate, perpetuando gerarchie informative esistenti. Problemi di trasparenza emergono poiché molti algoritmi di valutazione funzionano come black-box, rendendo difficile per le fonti capire come migliorare i propri segnali di affidabilità o per gli utenti capire perché certe fonti abbiano ricevuto determinati punteggi. Questi limiti sottolineano che la valutazione automatica deve integrare, non sostituire, la valutazione critica umana.

Creatori di contenuti ed editori possono migliorare significativamente i propri segnali di affidabilità implementando pratiche basate su evidenze in linea con il modo in cui i sistemi AI valutano l’affidabilità. Applicare i principi E-E-A-T—dimostrando Esperienza, Competenza, Autorevolezza e Affidabilità—mostrando chiaramente credenziali, affiliazioni professionali e qualifiche rilevanti sulle pagine dei contenuti. Pratiche corrette di citazione rafforzano l’affidabilità collegando fonti di alta qualità, utilizzando formati di citazione coerenti e assicurando che tutte le affermazioni siano basate su prove verificabili; questo segnala che il contenuto si fonda su conoscenze consolidate anziché su speculazioni. La trasparenza sulla metodologia aiuta i sistemi AI a riconoscere pratiche di ricerca rigorose; spiegare chiaramente fonti dei dati, metodi di ricerca, limiti e potenziali conflitti di interesse. Mantenere profili autore con informazioni biografiche dettagliate, storia delle pubblicazioni e credenziali professionali che i sistemi AI possono verificare e valutare. Aggiornare regolarmente i contenuti per dimostrare impegno verso l’accuratezza; informazioni obsolete riducono i punteggi di affidabilità, mentre revisioni frequenti segnalano monitoraggio degli sviluppi nel settore. Dichiarare esplicitamente fonti di finanziamento e affiliazioni, poiché la trasparenza sui potenziali bias aumenta in realtà la credibilità—i sistemi AI riconoscono che i conflitti dichiarati sono meno problematici di quelli nascosti. Costruire autorevolezza nelle citazioni pubblicando in sedi rinomate, perseguendo la revisione tra pari e ottenendo citazioni da altre fonti credibili; questo crea un ciclo virtuoso in cui la credibilità genera altra credibilità. Coinvolgersi con la comunità professionale tramite conferenze, collaborazioni e discussioni tra pari, poiché questi segnali di coinvolgimento convalidano l’esperienza e aumentano la visibilità ai sistemi di valutazione dell’affidabilità. Implementare markup di dati strutturati usando schema.org e standard simili per aiutare i sistemi AI a estrarre e verificare automaticamente informazioni su autore, date di pubblicazione e altri segnali di affidabilità.

L’evoluzione della valutazione dell’affidabilità delle fonti incorporerà sempre più la valutazione multimodale che analizza testo, immagini, video e audio insieme per rilevare disinformazione sofisticata che sfrutta l’analisi a singola modalità. Sistemi di verifica in tempo reale si integreranno con le piattaforme di creazione di contenuti, offrendo feedback immediato sull’affidabilità durante la pubblicazione, permettendo correzioni prima che la disinformazione si diffonda. Il tracciamento della credibilità basato su blockchain potrà consentire registri immutabili della storia della fonte, delle citazioni e delle correzioni, creando una provenienza trasparente che i sistemi IA potranno valutare con maggiore fiducia. La valutazione personalizzata dell’affidabilità andrà oltre il punteggio standard, valutando le fonti in relazione alla competenza e alle esigenze individuali dell’utente, riconoscendo che la credibilità è anche soggettiva e dipendente dal contesto. L’integrazione con i knowledge graph permetterà ai sistemi AI di valutare le fonti non solo in isolamento ma all’interno di reti di informazioni correlate, individuando fonti che contraddicono conoscenze consolidate o colmano lacune importanti. I sistemi AI spiegabili per la credibilità diventeranno standard, offrendo spiegazioni trasparenti sul perché una fonte ha ricevuto determinati punteggi, aiutando i creatori a migliorarsi e gli utenti a comprendere le motivazioni della valutazione. I sistemi di apprendimento continuo si adatteranno in tempo reale alle nuove tattiche di disinformazione, aggiornando i modelli di valutazione man mano che emergono nuove tecniche di manipolazione invece di basarsi su dati statici. Il tracciamento cross-platform dell’affidabilità creerà profili unificati che seguono le fonti in tutto il web, rendendo più difficile per i malintenzionati mantenere reputazioni diverse su piattaforme differenti. Questi sviluppi renderanno la valutazione dell’affidabilità sempre più sofisticata, trasparente e integrata nell’infrastruttura informativa su cui fanno affidamento miliardi di persone ogni giorno.

La valutazione dell'affidabilità delle fonti è la valutazione sistematica delle fonti di informazione per determinarne l'affidabilità e la credibilità. I sistemi AI analizzano molteplici dimensioni tra cui le credenziali dell'autore, la reputazione dell'editore, i modelli di citazione e i risultati del fact-checking per stabilire se le fonti meritano di essere incluse in ricerche, basi di conoscenza o riassunti generati dall'IA. Questo processo automatizzato consente alle piattaforme di valutare milioni di fonti in modo coerente.

I sistemi AI rilevano i segnali di affidabilità tramite elaborazione del linguaggio naturale, modelli di machine learning e analisi di dati strutturati. Esaminano segnali accademici (stato della revisione tra pari, affiliazione istituzionale), segnali testuali (densità delle citazioni, specificità delle affermazioni), segnali di metadati (credenziali dell'autore, date di pubblicazione), segnali sociali (conteggio delle citazioni, approvazioni di esperti), e segnali di verifica (risultati del fact-checking, corroborazione delle affermazioni). Questi segnali vengono ponderati in base al loro valore predittivo per l'accuratezza.

I fattori di affidabilità più critici includono la reputazione e l'esperienza dell'autore, la reputazione dell'editore, il numero e la qualità delle citazioni, l'attualità e la tempestività, la divulgazione di bias e conflitti, i segnali di coinvolgimento della comunità professionale, la verifica delle fonti tramite fact-checking, l'integrazione delle conoscenze di base, l'associazione del creatore con istituzioni affidabili e la frequenza degli aggiornamenti. Questi fattori insieme stabiliscono l'affidabilità e la credibilità della fonte.

Gli editori possono migliorare l'affidabilità implementando i principi E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità), utilizzando pratiche corrette di citazione, mantenendo una metodologia trasparente, mostrando profili dettagliati degli autori con credenziali, aggiornando regolarmente i contenuti, dichiarando fonti di finanziamento e affiliazioni, costruendo autorevolezza tramite la revisione tra pari, coinvolgendosi con la comunità professionale e implementando markup di dati strutturati per aiutare i sistemi AI a estrarre informazioni di affidabilità.

La valutazione automatica dell'affidabilità affronta sfide come il bias dei segnali di coinvolgimento (fonti popolari possono ottenere punteggi alti nonostante l'inesattezza), falsi positivi e negativi, tattiche di disinformazione in evoluzione che imitano fonti legittime, variazione della credibilità a seconda del dominio, dinamiche temporali man mano che le fonti diventano obsolete, bias culturale e linguistico nei dati di addestramento e problemi di trasparenza con algoritmi black-box. Questi limiti indicano che la valutazione automatica dovrebbe integrare, non sostituire, la valutazione critica umana.

Google AI Overviews dà priorità alle fonti con editori affermati ed esperti verificati per i riassunti generati dall'IA. ChatGPT assegna pesi alle fonti durante l'addestramento in base ai segnali di affidabilità. Perplexity mostra esplicitamente la reputazione della fonte accanto ai risultati di ricerca. AmICited.com monitora come le fonti sono citate su tutte le principali piattaforme AI, aiutando gli editori a comprendere il proprio livello di affidabilità e a individuare opportunità di miglioramento.

Gli sviluppi futuri includono la valutazione multimodale che analizza insieme testo, immagini, video e audio; sistemi di verifica in tempo reale che forniscono feedback immediato sull'affidabilità; tracciamento della credibilità basato su blockchain; valutazione personalizzata rispetto alla competenza dell'utente; integrazione con knowledge graph; sistemi AI spiegabili che forniscono motivazioni trasparenti dei punteggi; sistemi di apprendimento continuo che si adattano a nuove tattiche di disinformazione; e tracciamento cross-platform che crea profili di affidabilità unificati.

La valutazione dell'affidabilità delle fonti è fondamentale perché determina quali fonti appaiono nei riassunti generati dall'IA, influenzano i dati di addestramento AI e plasmano le informazioni che miliardi di persone incontrano. Una valutazione accurata dell'affidabilità aiuta a prevenire la diffusione della disinformazione, garantisce che i sistemi AI forniscano informazioni affidabili, sostiene la qualità della ricerca accademica e mantiene la fiducia nei sistemi informativi basati sull'IA. Man mano che l'IA diventa più influente nella scoperta delle informazioni, la valutazione dell'affidabilità è sempre più importante.

Traccia come le tue fonti vengono citate e valutate su Google AI Overviews, ChatGPT, Perplexity e Gemini. AmICited.com ti aiuta a comprendere il tuo livello di affidabilità e a identificare le opportunità di miglioramento.

Scopri come costruire segnali di fiducia per motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Approfondisci i principi E-E-A-T, i segnali di...

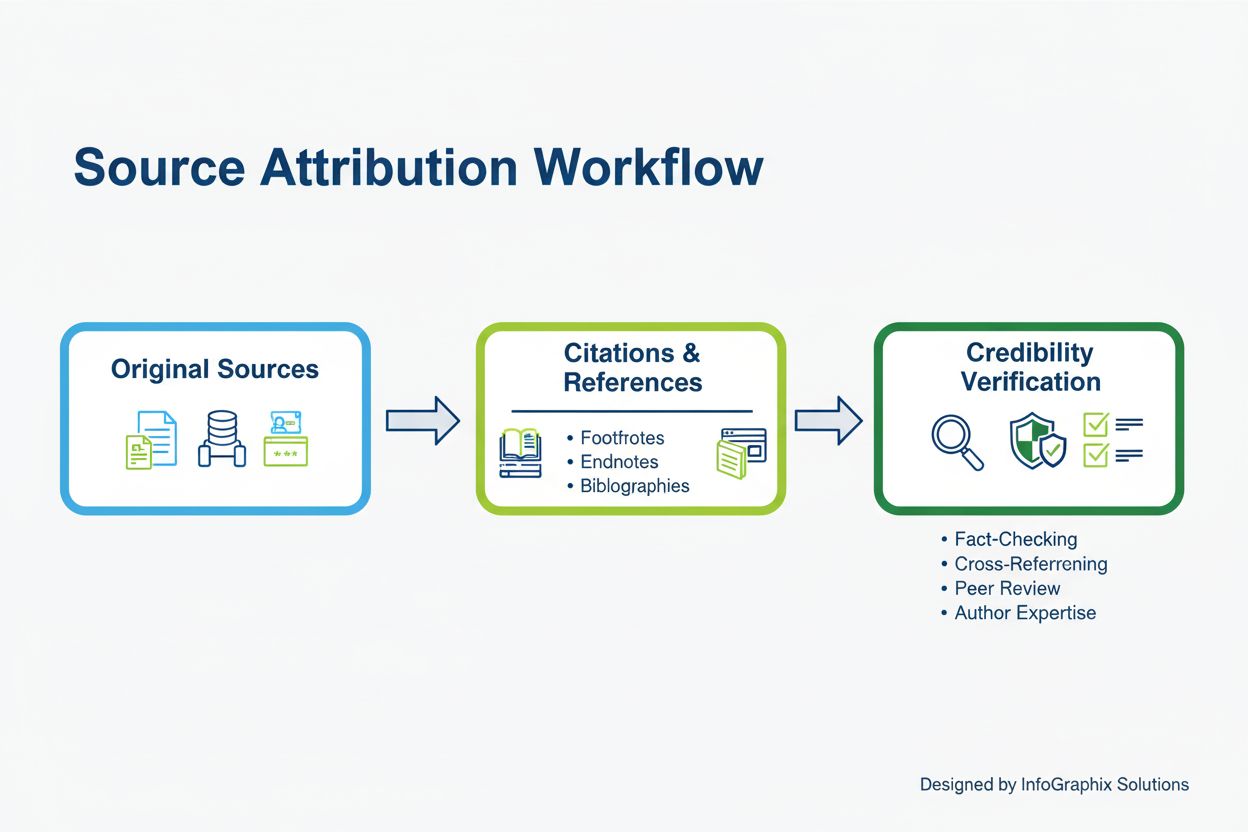

Scopri cos'è l'attribuzione della fonte, perché è importante per la credibilità e la fiducia, e come funziona nelle piattaforme IA come ChatGPT, Perplexity e Go...

Scopri quali fonti vengono citate più frequentemente dai motori di intelligenza artificiale. Scopri come ChatGPT, Google AI Overviews e Perplexity valutano l’af...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.