Content Chunking voor AI: Optimale Passage-Lengtes voor Citaten

Leer hoe je content structureert in optimale passage-lengtes (100-500 tokens) voor maximale AI-citaties. Ontdek chunkingstrategieën die zichtbaarheid verhogen i...

Onderzoeksgerichte gids voor de optimale passage-lengte voor AI-citaties. Leer waarom 75-150 woorden ideaal is, hoe tokens AI-opvraging beïnvloeden en strategieën om het citatiepotentieel van je content te maximaliseren.

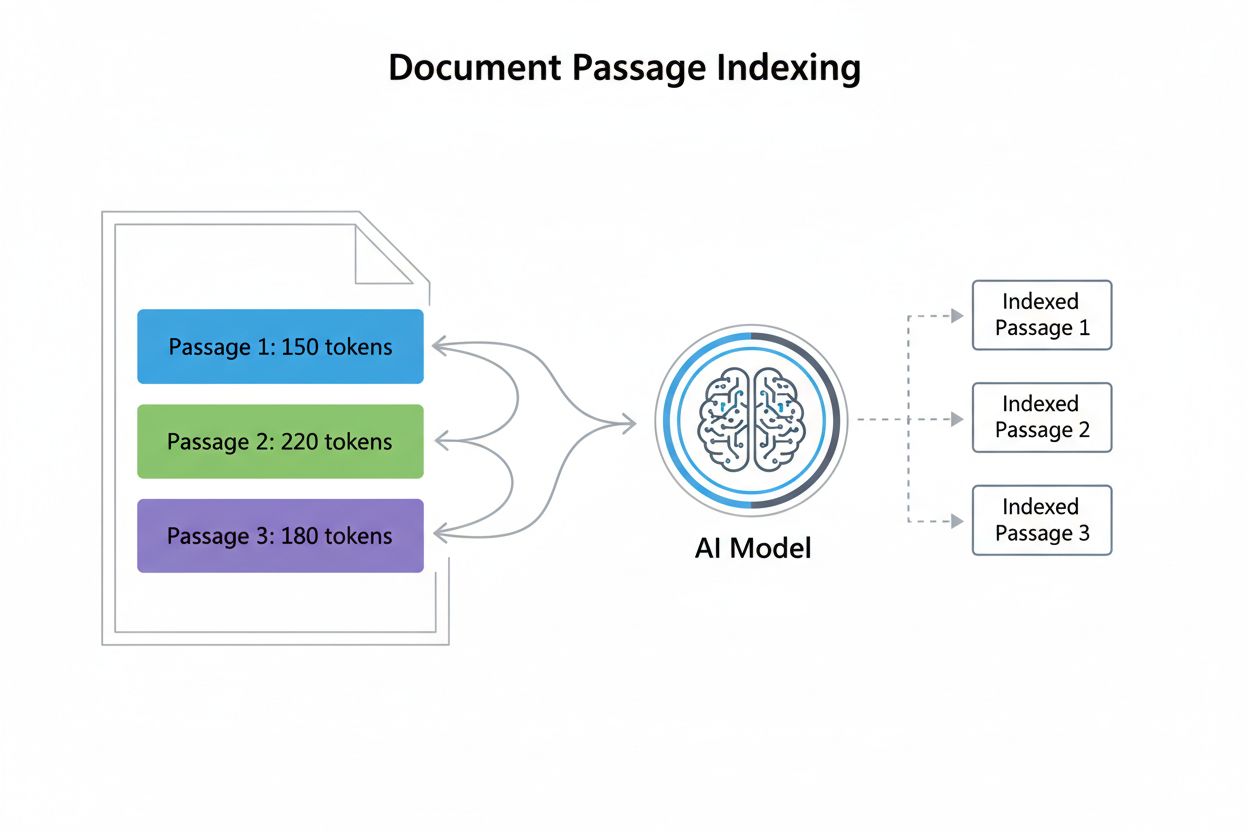

Passage-lengte in de context van AI-citaties verwijst naar de optimale grootte van contentstukken die AI-modellen extraheren en citeren bij het genereren van antwoorden. In plaats van volledige pagina’s of documenten te citeren, gebruiken moderne AI-systemen passage-level indexing, waarbij content wordt opgedeeld in afzonderlijke, beheersbare segmenten die onafhankelijk kunnen worden geëvalueerd en geciteerd. Dit onderscheid begrijpen is cruciaal omdat het fundamenteel verandert hoe contentmakers hun materiaal moeten structureren. De relatie tussen passages en tokens is essentieel om te begrijpen: ongeveer 1 token is gelijk aan 0,75 woorden, wat betekent dat een passage van 300 woorden meestal rond de 400 tokens bevat. Deze conversie is belangrijk omdat AI-modellen werken met context windows—vaste limieten aan hoeveel tekst ze tegelijkertijd kunnen verwerken. Door de passage-lengte te optimaliseren, kunnen contentmakers ervoor zorgen dat hun meest waardevolle informatie binnen het bereik valt dat AI-systemen effectief kunnen indexeren, ophalen en citeren, in plaats van te worden begraven in langere documenten die mogelijk buiten de verwerkingscapaciteit vallen.

Onderzoek toont consequent aan dat 53% van de door AI geciteerde content onder de 1.000 woorden valt, een bevinding die traditionele aannames over diepgang en autoriteit van content uitdaagt. Deze voorkeur voor kortere content komt voort uit hoe AI-modellen relevantie en extractie beoordelen—beknopte passages zijn eenvoudiger te analyseren, te contextualiseren en accuraat te citeren. Het concept van een “antwoordnugget” (meestal 40-80 woorden) is naar voren gekomen als een cruciale optimalisatie-eenheid, als het kleinste betekenisvolle antwoord op een gebruikersvraag. Interessant is dat studies een nagenoeg nul correlatie tussen woordenaantal en citatiepositie laten zien, wat betekent dat langere content niet automatisch hoger scoort bij AI-citaties. Content onder de 350 woorden komt vaker in de top drie van citatieposities, wat suggereert dat beknoptheid gecombineerd met relevantie optimale omstandigheden voor AI-citatie schept. Dit data-gedreven inzicht verandert de contentstrategie fundamenteel.

| Contenttype | Optimale lengte | Aantal tokens | Gebruikssituatie |

|---|---|---|---|

| Antwoordnugget | 40-80 woorden | 50-100 tokens | Directe Q&A-antwoorden |

| Featured Snippet | 75-150 woorden | 100-200 tokens | Snelle antwoorden |

| Passage Chunk | 256-512 tokens | 256-512 tokens | Semantische zoekresultaten |

| Topic Hub | 1.000-2.000 woorden | 1.300-2.600 tokens | Uitgebreide dekking |

| Long-form Content | 2.000+ woorden | 2.600+ tokens | Diepgaande artikelen, gidsen |

Tokens zijn de fundamentele eenheden waarmee AI-modellen taal verwerken, waarbij elke token meestal een woord of woordfragment vertegenwoordigt. Het berekenen van het aantal tokens is eenvoudig: deel het aantal woorden door 0,75 om het aantal tokens te schatten, al varieert het exacte aantal per tokenisatiemethode. Bijvoorbeeld, een passage van 300 woorden bevat ongeveer 400 tokens, terwijl een artikel van 1.000 woorden ongeveer 1.333 tokens telt. Context windows—het maximum aantal tokens dat een model in één aanvraag kan verwerken—bepalen direct welke passages worden geselecteerd voor citatie. De meeste moderne AI-systemen werken met context windows van 4.000 tot 128.000 tokens, maar in de praktijk krijgen meestal alleen de eerste 2.000-4.000 tokens de meeste aandacht. Wanneer een passage deze praktische limieten overschrijdt, loopt deze het risico te worden afgekapt of lager te worden geprioriteerd in het retrievalproces. Door het context window van je doel-AI-systeem te begrijpen, kun je passages structureren die comfortabel binnen de verwerkingslimieten passen, terwijl de semantische volledigheid behouden blijft.

Voorbeeld token-berekening:

- Passage van 100 woorden = ~133 tokens

- Passage van 300 woorden = ~400 tokens

- Passage van 500 woorden = ~667 tokens

- Passage van 1.000 woorden = ~1.333 tokens

Praktische context window-verdeling:

- Systeem context window: 8.000 tokens

- Gereserveerd voor zoekopdracht + instructies: 500 tokens

- Beschikbaar voor passages: 7.500 tokens

- Optimale passagegrootte: 256-512 tokens (past 14-29 passages)

AI-modellen vertonen een fenomeen dat bekend staat als contextrot, waarbij informatie in het midden van lange passages aanzienlijke prestatievermindering ondervindt. Dit gebeurt omdat transformer-gebaseerde modellen aandachtmechanismen toepassen die van nature de voorkeur geven aan content aan het begin (primacy-effect) en het einde (recency-effect) van inputreeksen. Wanneer passages de 1.500 tokens overschrijden, kan kritische informatie diep in het midden over het hoofd worden gezien of lager worden geprioriteerd tijdens het genereren van citaties. Deze beperking heeft grote gevolgen voor de structuur van je content—door de belangrijkste informatie aan het begin en einde van passages te plaatsen, maximaliseer je de kans op citatie. Verschillende strategieën om dit probleem te beperken zijn:

Optimale passage-structuur geeft prioriteit aan semantische samenhang—zorg ervoor dat elke passage een complete, zelfstandige gedachte of antwoord vertegenwoordigt. In plaats van willekeurig content te splitsen op basis van woordenaantal, moeten passages aansluiten bij natuurlijke topicgrenzen en logische verdelingen. Context-onafhankelijkheid is even belangrijk; elke passage moet begrijpelijk zijn zonder dat lezers naar omringende content hoeven te verwijzen. Dit betekent dat de benodigde context binnen de passage zelf moet worden opgenomen en niet mag afhangen van verwijzingen of externe informatie. Denk bij het structureren van content voor AI-retrieval na over hoe passages in isolatie verschijnen—zonder koppen, navigatie of omliggende alinea’s. Best practices zijn: elke passage beginnen met een duidelijke topicszin, consistente opmaak en terminologie hanteren, beschrijvende subkoppen gebruiken die het doel van de passage verduidelijken, en ervoor zorgen dat elke passage een volledige vraag beantwoordt of een volledig concept behandelt. Door passages als onafhankelijke eenheden te behandelen in plaats van willekeurige tekstsegmenten, vergroten contentmakers de kans dat AI-systemen hun werk accuraat extraheren en citeren aanzienlijk.

De “Snack-strategie” optimaliseert voor korte, gefocuste content (75-350 woorden) die bedoeld is om specifieke vragen direct te beantwoorden. Deze aanpak excelleert bij eenvoudige, rechtlijnige vragen waarbij gebruikers snelle antwoorden willen zonder uitgebreide context. Snack-content presteert uitzonderlijk goed in AI-citaties omdat het aansluit bij het “antwoordnugget”-formaat dat AI-systemen van nature extraheren. Omgekeerd creëert de “Hub-strategie” uitgebreide, long-form content (2.000+ woorden) die complexe onderwerpen diepgaand behandelt. Hub-content dient andere doelen: het vestigen van thematische autoriteit, het vangen van meerdere gerelateerde vragen en het bieden van context voor meer genuanceerde vragen. Het belangrijkste inzicht is dat deze strategieën elkaar niet uitsluiten—de meest effectieve aanpak combineert beide. Creëer gefocuste snack-content voor specifieke vragen en snelle antwoorden, en ontwikkel vervolgens hub-content die naar deze snacks verwijst en ze verder uitwerkt. Deze hybride aanpak stelt je in staat zowel directe AI-citaties (via snacks) als uitgebreide thematische autoriteit (via hubs) te verkrijgen. Bepaal welke strategie je inzet op basis van de zoekintentie: simpele, feitelijke vragen geven de voorkeur aan snacks, terwijl complexe, verkennende onderwerpen baat hebben bij hubs. De winnende strategie balanceert beide benaderingen op basis van de werkelijke informatiebehoeften van je doelgroep.

Antwoordnuggets zijn beknopte, zelfstandige samenvattingen van meestal 40-80 woorden die direct antwoord geven op specifieke vragen. Deze nuggets vormen het optimale formaat voor AI-citatie omdat ze volledige antwoorden bieden zonder overtollige informatie. De plaatsingsstrategie is cruciaal: positioneer je antwoordnugget direct na je hoofdonderwerp of introductie, voordat je verdergaat met ondersteunende details en toelichtingen. Door deze vooraan te plaatsen, komen AI-systemen het antwoord als eerste tegen, wat de kans op citatie vergroot. Schema markup speelt een belangrijke ondersteunende rol in de optimalisatie van antwoordnuggets—door gestructureerde dataformaten zoals JSON-LD te gebruiken, geef je AI-systemen exact aan waar je antwoord staat. Hier is een voorbeeld van een goed gestructureerde antwoordnugget:

Vraag: "Hoe lang moet webcontent zijn voor AI-citaties?"

Antwoordnugget: "Onderzoek toont aan dat 53% van door AI geciteerde content onder de 1.000 woorden valt, met optimale passages van 75-150 woorden voor directe antwoorden en 256-512 tokens voor semantische chunks. Content onder de 350 woorden komt vaak bovenaan in citatieposities, wat aangeeft dat beknoptheid gecombineerd met relevantie de kans op AI-citatie maximaliseert."

Deze nugget is volledig, specifiek en direct bruikbaar—precies wat AI-systemen zoeken bij het genereren van citaties.

JSON-LD schema markup geeft AI-systemen expliciete instructies over de structuur en betekenis van je content, wat de kans op citatie aanzienlijk vergroot. De meest impactvolle schema-typen voor AI-optimalisatie zijn FAQ-schema voor vraag-en-antwoord content en HowTo-schema voor procedurele of instructieve content. FAQ-schema is bijzonder krachtig omdat het direct aansluit bij hoe AI-systemen informatie verwerken—als afzonderlijke vraag-antwoordparen. Onderzoek toont aan dat pagina’s die geschikte schema markup implementeren 3x vaker worden geciteerd door AI-systemen dan niet-gemarkeerde content. Dit is geen toeval; schema markup vermindert de ambiguïteit over wat een antwoord is, waardoor extractie en citatie zekerder en nauwkeuriger worden.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"@id": "https://example.com/faq#q1",

"name": "Wat is optimale passage-lengte voor AI-citaties?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Onderzoek toont aan dat 53% van door AI geciteerde content onder de 1.000 woorden valt, met optimale passages van 75-150 woorden voor directe antwoorden en 256-512 tokens voor semantische chunks."

}

}

]

}

Door schema markup te implementeren, transformeer je je content van ongestructureerde tekst naar machine-leesbare informatie en geef je AI-systemen precies aan waar antwoorden staan en hoe ze zijn georganiseerd.

Het bijhouden van passageprestaties vereist het monitoren van specifieke statistieken die AI-citatiesucces aangeven. Citatiedeel meet hoe vaak je content verschijnt in AI-gegenereerde antwoorden, terwijl citatiepositie bijhoudt of je passages als eerste, tweede of later in de citatielijst verschijnen. Tools zoals SEMrush, Ahrefs en gespecialiseerde AI-monitoringplatforms volgen nu AI Overview-vertoningen en citaties, waardoor er inzicht ontstaat in prestaties. Voer A/B-testen uit door meerdere versies van passages te creëren met verschillende lengtes, structuren of schema-implementaties, en kijk vervolgens welke versie meer citaties oplevert. Belangrijke statistieken om te volgen zijn:

Regelmatige monitoring laat zien welke passage-structuren, lengtes en formats het meest aanslaan bij AI-systemen, waardoor continue optimalisatie mogelijk wordt.

Veel contentmakers ondermijnen per ongeluk hun AI-citatiepotentieel door vermijdbare structurele fouten. Belangrijke informatie diep in passages verstoppen dwingt AI-systemen om door irrelevante context te zoeken voordat ze het antwoord vinden—plaats je belangrijkste informatie altijd vooraan. Overmatig onderling verwijzen creëert contextafhankelijkheid; passages die voortdurend naar andere secties verwijzen, zijn moeilijk zelfstandig te extraheren en citeren door AI-systemen. Vage, niet-specifieke content mist de precisie die AI-systemen nodig hebben voor een zekere citatie—gebruik concrete details, specifieke cijfers en heldere uitspraken. Slechte sectiegrenzen leiden tot passages die meerdere onderwerpen of onvolledige gedachten beslaan; zorg dat elke passage een samenhangende eenheid vormt. Onvoldoende technische structuur betekent gemiste kansen voor schema markup, juiste koppenhiërarchie en semantische duidelijkheid. Andere fouten zijn:

Door deze fouten te vermijden en de bovengenoemde optimalisaties toe te passen, positioneer je je content voor maximale AI-citatieprestaties.

Onderzoek toont aan dat 75-150 woorden (100-200 tokens) optimaal is voor de meeste contenttypen. Deze lengte biedt voldoende context voor AI-systemen om je content te begrijpen en te citeren, terwijl het beknopt genoeg blijft voor directe opname in AI-gegenereerde antwoorden. Content onder de 350 woorden komt vaak op topposities voor citaties terecht.

Nee. Onderzoek toont aan dat 53% van de geciteerde pagina's onder de 1.000 woorden is, en er is vrijwel geen correlatie tussen het aantal woorden en de citatiepositie. Kwaliteit, relevantie en structuur zijn veel belangrijker dan lengte. Korte, gefocuste content presteert vaak beter dan lange artikelen in AI-citaties.

Eén token is ongeveer gelijk aan 0,75 woorden in Engelse tekst. Dus 1.000 tokens zijn ongeveer 750 woorden. De exacte verhouding varieert per taal en contenttype—code gebruikt meer tokens per woord vanwege speciale tekens en syntax. Dit omrekenen helpt je de passage-lengte voor AI-systemen te optimaliseren.

Verdeel lange content in zelfstandige secties van telkens 400-600 woorden. Elke sectie moet een duidelijke topicszin hebben en een 'antwoordnugget' van 40-80 woorden bevatten die direct antwoord geeft op een specifieke vraag. Gebruik schema markup om AI-systemen te helpen deze nuggets te identificeren en te citeren. Deze aanpak levert zowel directe citaties als thematische autoriteit op.

AI-modellen richten zich vooral op informatie aan het begin en einde van lange contexten, waardoor content in het midden minder aandacht krijgt. Deze 'contextrot' betekent dat cruciale informatie dieper in passages van meer dan 1.500 tokens over het hoofd kan worden gezien. Voorkom dit door belangrijke informatie aan het begin of het einde te plaatsen, duidelijke koppen te gebruiken en kernpunten strategisch te herhalen.

Volg het citatiedeel (het percentage AI Overviews dat naar je domein linkt) met tools zoals BrightEdge, Semrush of Authoritas. Controleer welke specifieke passages in AI-gegenereerde antwoorden verschijnen en pas je contentstructuur aan op basis van prestatiegegevens. AmICited biedt ook gespecialiseerde monitoring voor AI-citaties op meerdere platforms.

Ja, aanzienlijk. Pagina's met uitgebreide JSON-LD schema markup (FAQ, HowTo, ImageObject) hebben 3x meer kans om in AI Overviews te verschijnen. Schema helpt AI-systemen je content effectiever te begrijpen en te extraheren, waardoor ze je passages nauwkeuriger en met meer vertrouwen kunnen citeren.

Gebruik beide. Schrijf korte, gefocuste content (300-500 woorden) voor eenvoudige, directe zoekopdrachten volgens de 'Snack-strategie'. Schrijf langere, uitgebreide content (2.000-5.000 woorden) voor complexe onderwerpen volgens de 'Hub-strategie'. Structureer binnen lange content meerdere korte, zelfstandige passages om zowel directe citaties als thematische autoriteit te verkrijgen.

Volg hoe AI-systemen zoals ChatGPT, Perplexity en Google AI Overviews jouw content citeren. Optimaliseer je passages op basis van echte citatiegegevens en verbeter je zichtbaarheid in AI-gegenereerde antwoorden.

Leer hoe je content structureert in optimale passage-lengtes (100-500 tokens) voor maximale AI-citaties. Ontdek chunkingstrategieën die zichtbaarheid verhogen i...

Discussie in de community over de ideale contentlengte voor AI-zichtbaarheid. Echte ervaringen van contentmakers die uitgebreide en beknopte content testen voor...

Leer technieken voor passage-optimalisatie voor AI-zoekopdrachten. Ontdek hoe je zelfstandige passages (134-167 woorden) structureert voor betere zichtbaarheid ...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.