Hoe Structureer Ik Content voor AI-Citaties? Complete Gids voor 2025

Leer hoe je je content structureert om geciteerd te worden door AI-zoekmachines zoals ChatGPT, Perplexity en Google AI. Expertstrategieën voor AI-zichtbaarheid ...

Leer hoe je contentformaten test op AI-citaties met behulp van A/B-testmethodologie. Ontdek welke formaten de hoogste AI-zichtbaarheid en citatiepercentages opleveren bij ChatGPT, Google AI Overviews en Perplexity.

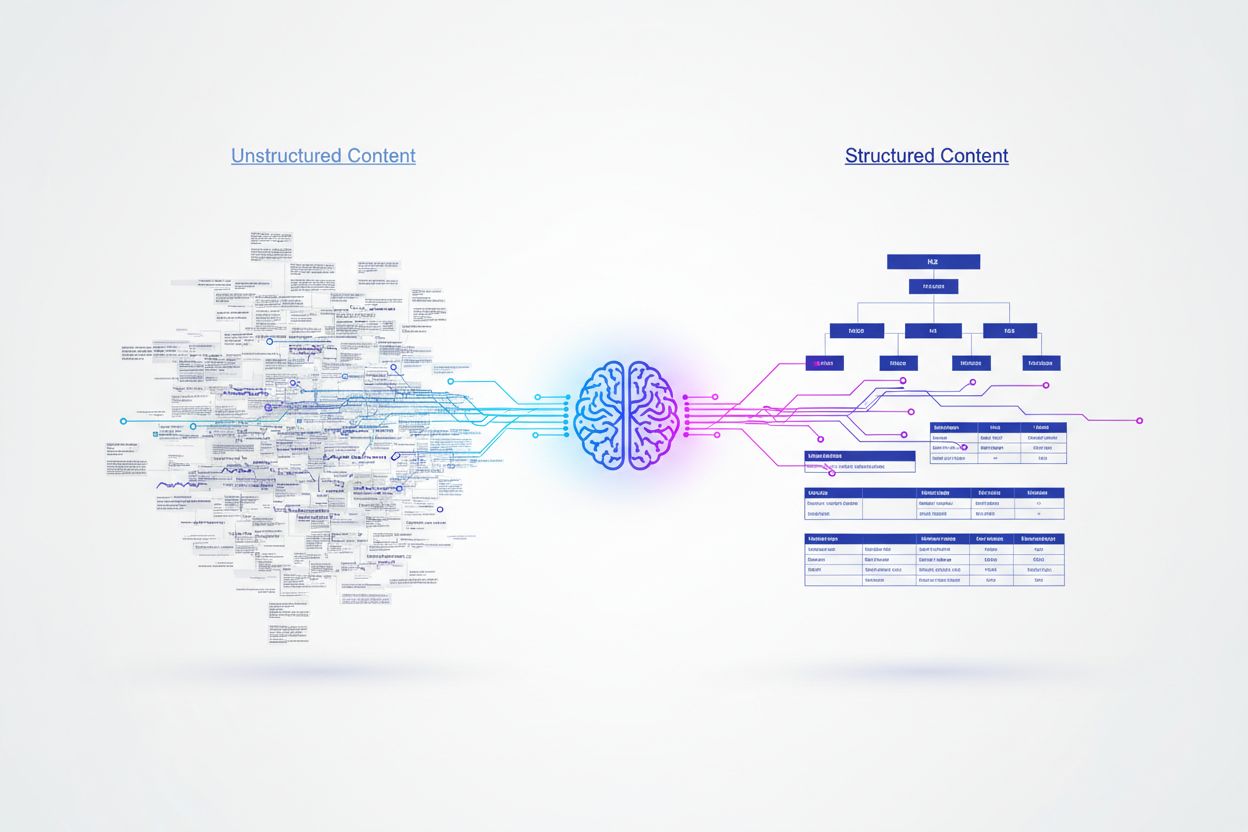

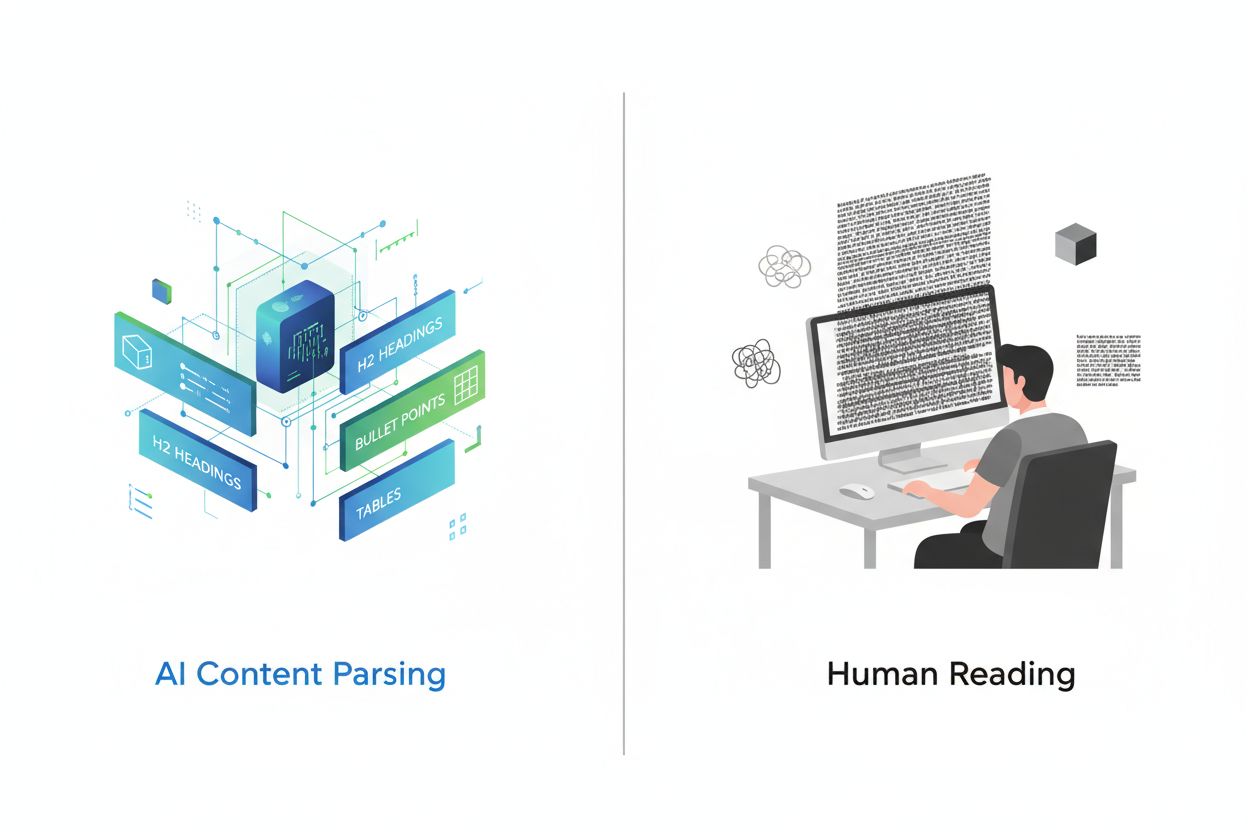

Kunstmatige intelligentiesystemen verwerken content fundamenteel anders dan menselijke lezers, en zijn afhankelijk van gestructureerde signalen om betekenis te begrijpen en informatie te extraheren. Waar mensen door creatieve opmaak of dicht proza kunnen navigeren, vereisen AI-modellen duidelijke organisatorische hiërarchieën en semantische markeringen om content effectief te parseren en de waarde ervan te doorgronden. Onderzoek toont aan dat gestructureerde content met correcte koppenhiërarchie 156% meer citaties ontvangt dan ongestructureerde alternatieven, wat een belangrijk verschil onthult tussen mensvriendelijke en AI-vriendelijke content. Dit verschil bestaat omdat AI-systemen getraind worden op enorme datasets waarin goed georganiseerde content doorgaans correleert met gezaghebbende, betrouwbare bronnen. Verschillende contentformaten begrijpen en testen is daarom essentieel geworden voor merken die zichtbaarheid willen in AI-gestuurde zoekresultaten en antwoordengines.

Verschillende AI-platforms tonen uitgesproken voorkeuren voor contentbronnen en -formaten, wat een complex optimalisatielandschap creëert. Onderzoek naar 680 miljoen citaties op grote platforms onthult opvallende verschillen in hoe ChatGPT, Google AI Overviews en Perplexity hun informatiebronnen selecteren. Deze platforms citeren niet simpelweg dezelfde bronnen—ze geven de voorkeur aan verschillende contenttypes op basis van hun onderliggende algoritmes en trainingsdata. Inzicht in deze platform-specifieke patronen is essentieel voor het ontwikkelen van gerichte contentstrategieën die maximale zichtbaarheid opleveren op meerdere AI-systemen.

| Platform | Meest Geciteerde Bron | Citatiepercentage | Voorkeursformaat |

|---|---|---|---|

| ChatGPT | Wikipedia | 7,8% van het totaal aantal citaties | Gezaghebbende kennisbanken, encyclopedische content |

| Google AI Overviews | 2,2% van het totaal aantal citaties | Community-discussies, door gebruikers gegenereerde content | |

| Perplexity | 6,6% van het totaal aantal citaties | Peer-to-peer informatie, community-inzichten |

De overweldigende voorkeur van ChatGPT voor Wikipedia (47,9% van zijn top 10-bronnen) toont een sterke bias voor gezaghebbende, feitelijke content met gevestigde geloofwaardigheid. Daarentegen laten Google AI Overviews en Perplexity een evenwichtigere verdeling zien, waarbij Reddit hun citatiepatronen domineert. Dit laat zien dat Perplexity community-gedreven informatie prioriteert met 46,7% van de topbronnen, terwijl Google een meer diverse aanpak hanteert over verschillende platformtypes. De data tonen duidelijk aan dat een one-size-fits-all contentstrategie niet werkt—merken moeten hun aanpak afstemmen op de AI-platforms die het meest relevant zijn voor hun doelgroep.

Schema markup is wellicht de belangrijkste factor in de kans op AI-citatie, waarbij correct geïmplementeerde JSON-LD-markup citatiepercentages behaalt die 340% hoger liggen dan bij identieke content zonder gestructureerde data. Dit grote verschil komt voort uit hoe AI-engines semantische betekenis interpreteren—gestructureerde data bieden expliciete context en nemen zo ambiguïteit weg bij de interpretatie van content. Wanneer een AI-engine schema markup tegenkomt, begrijpt hij direct entiteitsrelaties, contenttypes en hiërarchische belangrijkheid zonder uitsluitend op natuurlijke taalverwerking te vertrouwen.

De meest effectieve schema-implementaties zijn Article schema voor blogposts, FAQ schema voor vraag-en-antwoordsecties, HowTo schema voor instructiecontent en Organization schema voor merkherkenning. JSON-LD-formaat presteert hierbij het beste omdat AI-engines dit onafhankelijk van HTML-content kunnen parseren, waardoor dataverzameling schoner en verwerking eenvoudiger wordt. Semantische HTML-tags als <header>, <nav>, <main>, <section>, en <article> bieden extra duidelijkheid die AI-systemen helpt de contentstructuur en hiërarchie beter te begrijpen dan basismarkup.

A/B-testen biedt de meest betrouwbare methodologie om te bepalen welke contentformaten de hoogste AI-citatiepercentages opleveren in jouw specifieke niche. In plaats van te vertrouwen op algemene best practices, stellen gecontroleerde experimenten je in staat de daadwerkelijke impact van formatwijzigingen op je publiek en AI-zichtbaarheid te meten. Dit proces vereist zorgvuldige planning om variabelen te isoleren en statistische geldigheid te waarborgen, maar de inzichten die het oplevert zijn deze investering zeker waard.

Volg dit systematische A/B-testframework:

Statistische significantie vereist aandacht voor steekproefgrootte en testduur. In AI-toepassingen met schaarse data of longtailverdelingen kan het snel verzamelen van voldoende observaties een uitdaging zijn. De meeste experts raden aan tests minimaal 2-4 weken te laten lopen om tijdelijke schommelingen op te vangen en betrouwbare resultaten te behalen.

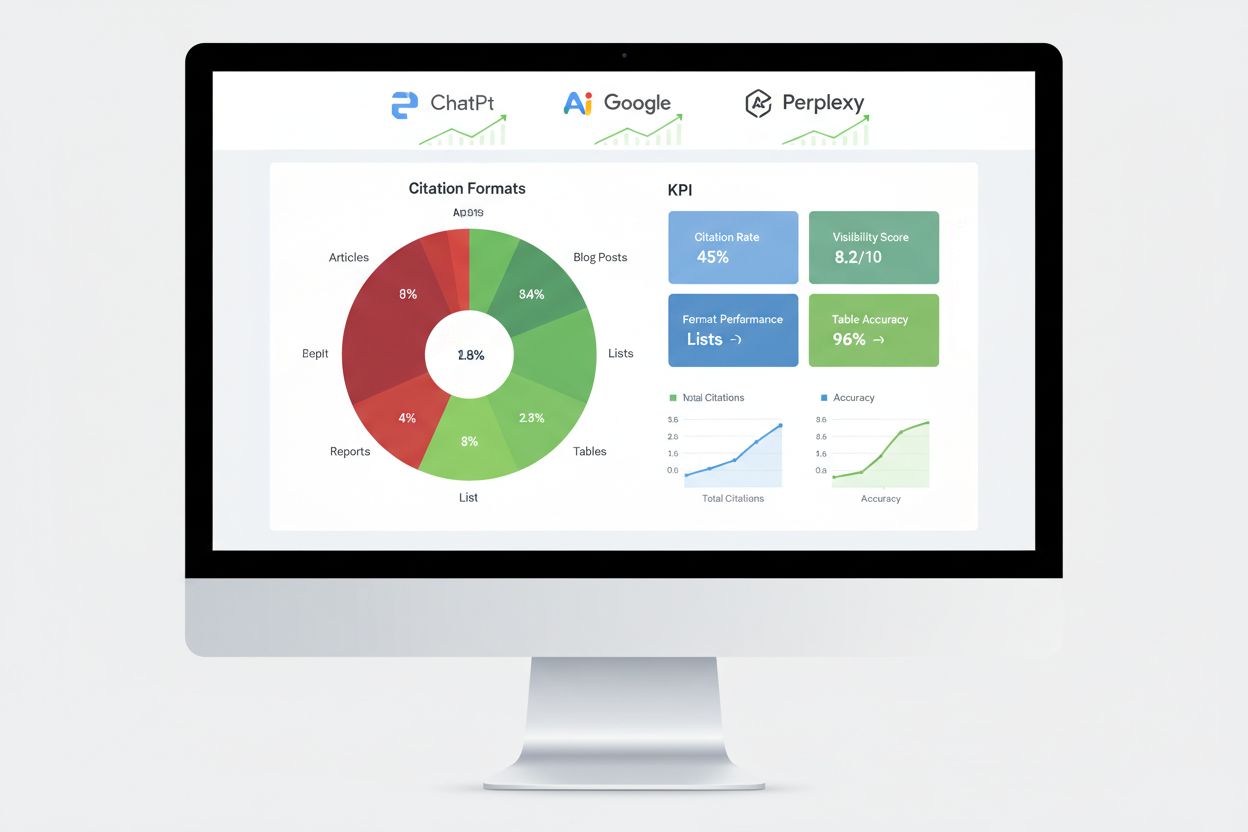

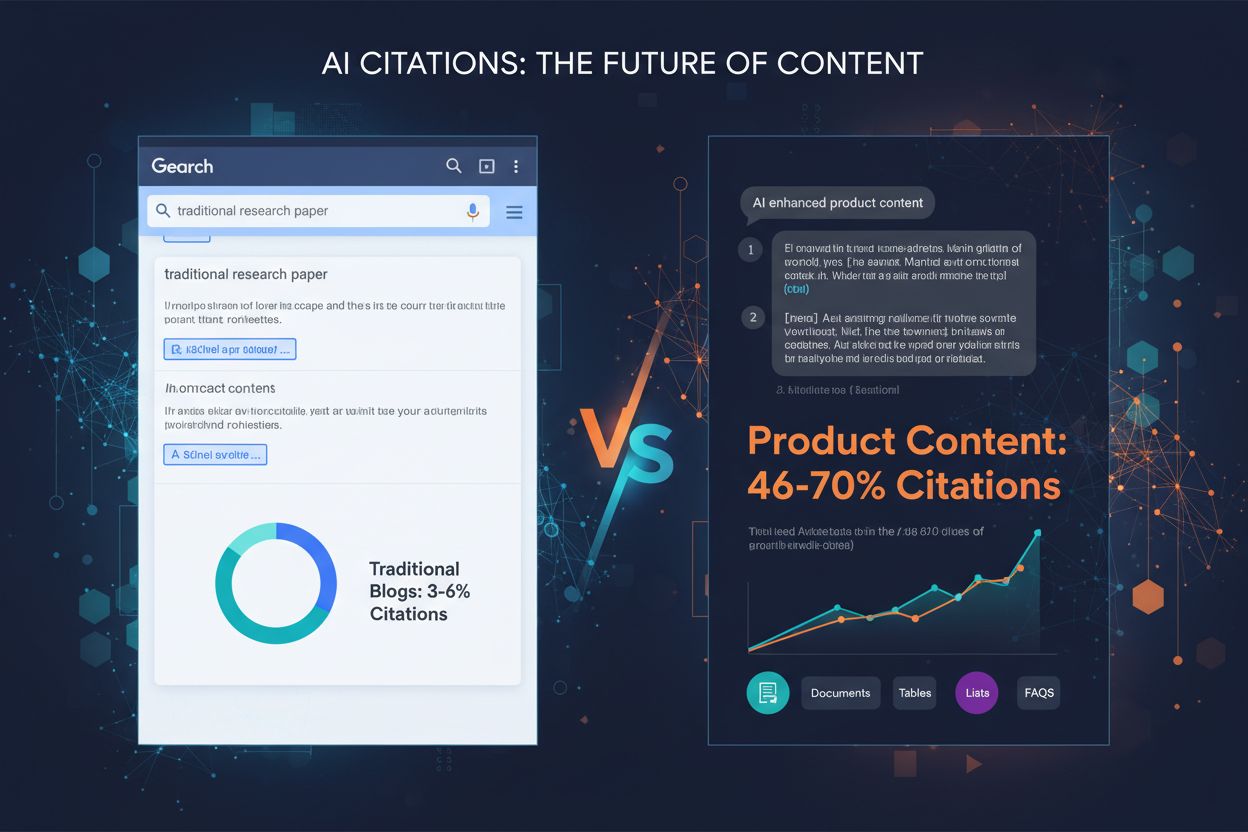

Onderzoek naar duizenden AI-citaties laat duidelijke prestatiehiërarchieën zien tussen verschillende contentformaten. Op lijsten gebaseerde content ontvangt 68% meer AI-citaties dan paragrafenrijke alternatieven, vooral omdat lijsten discrete, makkelijk te parseren informatie-eenheden bieden die AI-engines eenvoudig kunnen extraheren en samenvoegen. Bij het genereren van antwoorden kunnen AI-platforms specifieke lijstitems citeren zonder complexe herstructurering of parafrasering, waardoor lijstcontent bijzonder waardevol is voor citatiedoeleinden.

Tabellen presteren uitzonderlijk met tot 96% nauwkeurigheid bij AI-parsing, en overtreffen prozabeschrijvingen van identieke informatie ruimschoots. Tabellarische content stelt AI-systemen in staat snel specifieke datapunten te extraheren zonder complexe tekstparsing, waardoor tabellen vooral bij feitelijke, vergelijkende of statistische content veel waarde bieden. Vraag-en-antwoordformaten behalen 45% hogere AI-zichtbaarheid vergeleken met traditionele paragrafen over dezelfde onderwerpen, omdat Q&A-content aansluit bij hoe gebruikers AI-platforms benaderen en hoe AI-systemen antwoorden genereren.

Vergelijkingsformaten (X versus Y) presteren bijzonder goed omdat ze binaire, makkelijk samen te vatten structuren bieden die aansluiten bij hoe AI-systemen queries uitwerken naar subonderwerpen. Case studies combineren verhalende elementen met data, waardoor ze overtuigend zijn voor lezers en dankzij hun probleem-oplossing-resultaatstructuur ook goed te interpreteren voor AI. Origineel onderzoek en expertinzichten krijgen voorkeursbehandeling omdat ze unieke data bieden die elders niet te vinden is, wat geloofwaardigheidssignalen geeft die AI-systemen herkennen en belonen. De belangrijkste conclusie is dat geen enkel formaat universeel werkt—de beste aanpak combineert meerdere formaten strategisch, afhankelijk van jouw contenttype en de relevante AI-platforms.

Het implementeren van schema markup vereist inzicht in de verschillende beschikbare types en het selecteren van de meest relevante voor jouw content. Voor blogs en artikelen biedt Article schema uitgebreide metadata zoals auteur, publicatiedatum en contentstructuur. FAQ schema werkt bijzonder goed voor vraag-en-antwoordsecties, waarbij vragen en antwoorden expliciet worden gelabeld zodat AI-systemen ze betrouwbaar kunnen extraheren. HowTo schema is nuttig voor instructiecontent door opeenvolgende stappen te definiëren, terwijl Product schema e-commerce sites helpt specificaties en prijzen te communiceren.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "Wat is het beste contentformaat voor AI-citaties?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Het beste contentformaat hangt af van je platform en doelgroep, maar gestructureerde formaten zoals lijsten, tabellen en Q&A-secties behalen consequent hogere AI-citatiepercentages. Lijsten ontvangen 68% meer citaties dan paragrafen, terwijl tabellen 96% parse-nauwkeurigheid behalen."

}

}

]

}

Voor een succesvolle implementatie is syntaxisnauwkeurigheid belangrijk—ongeldige schema markup kan je kansen op AI-citatie juist verkleinen in plaats van vergroten. Gebruik Google’s Rich Results Test of de validatietools van Schema.org om je markup voor publicatie te controleren. Hanteer consistente formatthiërarchieën met H2’s voor hoofdsecties, H3’s voor subpunten, en korte alinea’s (maximaal 50-75 woorden) die zich richten op één concept. Voeg TL;DR-samenvattingen aan het begin of eind van secties toe om AI kant-en-klare snippets te bieden die zelfstandig als bruikbaar antwoord kunnen dienen.

Het meten van AI-engineprestaties vereist andere metrics dan traditionele SEO, met aandacht voor citatiemonitoring, respons-inclusiepercentages en kennisgrafiekvermeldingen in plaats van alleen rankingposities. Citatiemonitoring op grote platforms biedt het meest directe inzicht in het succes van je format-testinspanningen en onthult welke contentstukken daadwerkelijk door AI-systemen worden aangehaald. Tools als AmICited volgen specifiek hoe AI-platforms jouw merk citeren in ChatGPT, Google AI Overviews, Perplexity en andere antwoordengines, en geven inzicht in citatiepatronen en trends.

Belangrijke meetmethoden zijn het volgen van featured snippet-veroveringen, die aangeven welke content AI-systemen als bijzonder waardevol beschouwen voor directe antwoorden. Verschijningen in het kennisvenster geven aan dat AI-systemen je merk als gezaghebbende entiteit herkennen, waardig voor een eigen informatiesectie. Voice search-resultaten tonen aan of je content in conversatie-AI-antwoorden verschijnt, terwijl responspercentages van generatieve engines meten hoe vaak AI-systemen je content aanhalen bij het beantwoorden van gebruikersvragen. A/B-testen van verschillende formaten levert de meest betrouwbare prestatiegegevens op door enkele variabelen te isoleren en specifieke impactfactoren te identificeren. Stel basismetrics vast voordat je wijzigingen doorvoert, en monitor de prestaties wekelijks om trends en afwijkingen te signaleren die op succesvolle of onsuccesvolle formatvariaties kunnen wijzen.

Veel organisaties die formattesten uitvoeren, maken voorspelbare fouten die hun resultaten ondermijnen en tot verkeerde conclusies leiden. Onvoldoende steekproefgrootte is de meest voorkomende fout—testen met te weinig citaties of interacties leidt tot statistisch niet-significante resultaten die betekenisvol lijken, maar in feite willekeurige variatie weerspiegelen. Verzamel altijd minstens 100 citaties per variant voordat je conclusies trekt, en gebruik statistische calculators om de exacte benodigde steekproefgrootte voor jouw betrouwbaarheidsniveau en effectgrootte te bepalen.

Confounding variables zorgen voor vertekening als meerdere factoren tegelijk veranderen, waardoor niet duidelijk is welke wijziging het verschil heeft veroorzaakt. Houd alle elementen gelijk behalve het geteste formaat—gebruik dezelfde zoekwoorden, lengte, structuur en publicatie-timing. Tijdelijke bias ontstaat wanneer je test tijdens ongewone periodes (feestdagen, groot nieuws, platform-algoritmewijzigingen) die resultaten beïnvloeden. Voer tests uit tijdens normale periodes en compenseer seizoensinvloeden door minimaal 2-4 weken te testen. Selectiebias ontstaat als testgroepen onderling verschillen op manieren die resultaten beïnvloeden—zorg voor willekeurige toewijzing van content aan varianten. Correlatie verwarren met causaliteit leidt tot valse conclusies wanneer externe factoren toevallig samenvallen met je testperiode. Overweeg altijd alternatieve verklaringen voor waargenomen veranderingen en valideer resultaten via meerdere testcycli voordat je permanente wijzigingen doorvoert.

Een technologiebedrijf dat contentformaten testte voor AI-zichtbaarheid, ontdekte dat het omzetten van hun productvergelijkingsartikelen van paragraafstructuur naar gestructureerde vergelijkingstabellen het aantal AI-citaties binnen 60 dagen met 52% verhoogde. De tabellen boden duidelijke, scanbare informatie die AI-systemen direct konden extraheren, terwijl het oorspronkelijke proza meer complexe parsing vereiste. Ze hielden de contentlengte en zoekwoordoptimalisatie gelijk, zodat de formatwijziging de enige variabele was.

Een financiële dienstverlener implementeerde FAQ-schema op hun bestaande content zonder iets te herschrijven, door simpelweg gestructureerde markup toe te voegen aan bestaande vraag-en-antwoordsecties. Dit resulteerde in een toename van 34% in featured snippet-vermeldingen en een stijging van 28% in AI-citaties binnen 45 dagen. De schema markup veranderde de content zelf niet, maar maakte het aanzienlijk eenvoudiger voor AI-systemen om relevante antwoorden te identificeren en extraheren. Een SaaS-bedrijf voerde multivariate tests uit met drie formaten tegelijk—lijsten, tabellen en traditionele paragrafen—voor identieke content over hun producteigenschappen. Resultaten toonden aan dat lijsten 68% beter presteerden dan paragrafen, terwijl tabellen de hoogste nauwkeurigheid behaalden bij AI-parsing maar een lager totaal citatievolume. Dit bevestigde dat de effectiviteit van formaten verschilt per contenttype en AI-platform, en dat testen essentieel is in plaats van vertrouwen op algemene best practices. Deze praktijkvoorbeelden tonen aan dat formattesten bij correcte uitvoering meetbare, significante verbeteringen in AI-zichtbaarheid oplevert.

Het landschap van formattesten blijft zich ontwikkelen nu AI-systemen steeds geavanceerder worden en nieuwe optimalisatietechnieken ontstaan. Multi-armed bandit-algoritmen vormen een belangrijke vooruitgang ten opzichte van traditionele A/B-testen, omdat ze de verkeersverdeling naar verschillende varianten dynamisch aanpassen op basis van real-time prestaties, in plaats van te wachten tot vooraf bepaalde testperiodes voorbij zijn. Deze aanpak verkort de tijd die nodig is om winnende varianten te identificeren en maximaliseert de prestaties tijdens de test zelf.

Adaptief experimenteren op basis van reinforcement learning stelt AI-modellen in staat continu te leren en zich aan te passen op basis van lopende experimenten, waardoor de prestaties in real-time verbeteren in plaats van via afzonderlijke testcycli. AI-gedreven automatisering in A/B-testen gebruikt AI zelf om experimenteel ontwerp, resultaatanalyse en optimalisatie-aanbevelingen te automatiseren, zodat organisaties meer varianten tegelijk kunnen testen zonder evenredige toename in complexiteit. Deze opkomende benaderingen beloven snellere iteratiecycli en meer geavanceerde optimalisatiestrategieën. Organisaties die nu al uitblinken in formattesten behouden hun concurrentievoordeel naarmate deze technieken standaardpraktijk worden, en zijn zo beter gepositioneerd om te profiteren van nieuwe AI-platforms en veranderende citatie-algoritmen dan hun concurrenten.

Het beste contentformaat hangt af van je platform en doelgroep, maar gestructureerde formaten zoals lijsten, tabellen en Q&A-secties behalen consequent hogere AI-citatiepercentages. Lijsten ontvangen 68% meer citaties dan paragrafen, terwijl tabellen 96% parse-nauwkeurigheid behalen. De sleutel is het testen van verschillende formaten met jouw specifieke content om te bepalen wat het beste werkt.

De meeste experts raden aan om tests minimaal 2-4 weken te laten lopen om rekening te houden met tijdelijke variaties en betrouwbare resultaten te garanderen. Deze periode stelt je in staat voldoende datapunten te verzamelen (meestal 100+ citaties per variant) en rekening te houden met seizoensinvloeden of veranderingen in algoritmes van platforms die de resultaten kunnen vertekenen.

Ja, je kunt multivariate tests uitvoeren over meerdere formaten tegelijkertijd, maar dit vereist zorgvuldige planning om complexiteit in de interpretatie van resultaten te voorkomen. Begin met eenvoudige A/B-tests waarbij je twee formaten vergelijkt, en ga dan over naar multivariate tests zodra je de basis begrijpt en voldoende statistische middelen hebt.

Je hebt doorgaans minstens 100 citaties of interacties per variant nodig om statistische significantie te bereiken. Gebruik statistische calculators om de exacte steekproefgrootte voor jouw gewenste betrouwbaarheidsniveau en effectgrootte te bepalen. Grotere steekproeven geven betrouwbaardere resultaten maar vereisen langere testperiodes.

Begin met het identificeren van het meest relevante schema-type voor jouw content (Article, FAQ, HowTo, etc.), en gebruik vervolgens JSON-LD-formaat om het te implementeren. Valideer je markup met Google's Rich Results Test of de validatietools van Schema.org voordat je publiceert. Ongeldige schema markup kan je AI-citatiekansen juist schaden, dus nauwkeurigheid is cruciaal.

Prioriteer op basis van je doelgroep en zakelijke doelen. ChatGPT geeft de voorkeur aan gezaghebbende bronnen zoals Wikipedia, Google AI Overviews kiest voor communitycontent zoals Reddit, en Perplexity benadrukt peer-to-peer informatie. Analyseer welke platforms het meeste relevante verkeer naar je site sturen en optimaliseer eerst daarvoor.

Voer continu testen uit als onderdeel van je contentstrategie. Begin met kwartaalgewijze format-testcycli en verhoog de frequentie naarmate je expertise opbouwt en basismetrics vaststelt. Regelmatig testen helpt je voor te blijven op algoritmeveranderingen van AI-platforms en nieuwe formatvoorkeuren te ontdekken.

Volg verbeteringen in citatiepercentages, featured snippet-veroveringen, kennisvenstervermeldingen en responspercentages van generatieve engines. Stel basismetrics vast voor het testen en monitor de prestaties wekelijks om trends te ontdekken. Een succesvolle test laat doorgaans een verbetering van meer dan 20% in je primaire metric zien binnen 4-8 weken.

Volg hoe AI-platforms jouw content citeren over verschillende formaten heen. Ontdek welke contentstructuren de meeste AI-zichtbaarheid opleveren en optimaliseer je strategie met echte data.

Leer hoe je je content structureert om geciteerd te worden door AI-zoekmachines zoals ChatGPT, Perplexity en Google AI. Expertstrategieën voor AI-zichtbaarheid ...

Leer hoe je je content kunt herstructureren voor AI-systemen met praktische voor en na voorbeelden. Ontdek technieken om AI-verwijzingen en zichtbaarheid te ver...

Ontdek welke contentformaten het meest worden geciteerd door AI-modellen. Analyseer data van 768.000+ AI-citaties om je contentstrategie te optimaliseren voor C...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.