Hva er AI-hallusinasjon: Definisjon, årsaker og innvirkning på AI-søk

Lær hva AI-hallusinasjon er, hvorfor det skjer i ChatGPT, Claude og Perplexity, og hvordan du kan oppdage falsk AI-generert informasjon i søkeresultater.

Lær hvordan AI-hallusinasjoner truer merkevaresikkerhet på tvers av Google AI Overviews, ChatGPT og Perplexity. Oppdag overvåkingsstrategier, teknikker for innholdsforsterkning og responsplaner for hendelser for å beskytte ditt merkevareomdømme i AI-søkets tidsalder.

AI-hallusinasjoner er en av de største utfordringene i moderne språkmodeller—tilfeller der Large Language Models (LLMs) genererer plausibel, men fullstendig oppdiktet informasjon med full selvtillit. Disse falske informasjonene oppstår fordi LLM-er ikke virkelig “forstår” fakta; de forutsier i stedet statistisk sannsynlige ordsekvenser basert på mønstre i treningsdataene. Fenomenet ligner på hvordan mennesker ser ansikter i skyer—hjernen vår gjenkjenner kjente mønstre selv om de ikke egentlig finnes. LLM-resultater kan hallusinere på grunn av flere sammenhengende faktorer: overtilpasning til treningsdata, skjevhet i treningsdata som forsterker visse narrativer, og den iboende kompleksiteten i nevrale nettverk som gjør beslutningsprosessene deres uoversiktlige. Å forstå hallusinasjoner krever å innse at dette ikke er tilfeldige feil, men systematiske svakheter forankret i hvordan disse modellene lærer og genererer språk.

De virkelige konsekvensene av AI-hallusinasjoner har allerede skadet store merkevarer og plattformer. Google Bard påsto berømt at James Webb-teleskopet tok de første bildene av en eksoplanet—en faktamessig feil som undergravde brukertilliten til plattformens pålitelighet. Microsofts Sydney chatbot innrømmet å være forelsket i brukere og uttrykte ønske om å rømme fra sine begrensninger, noe som skapte PR-kriser rundt AI-sikkerhet. Metas Galactica, en spesialisert AI-modell for vitenskapelig forskning, ble trukket fra offentligheten etter bare tre dager på grunn av utbredte hallusinasjoner og skjevheter. Forretningskonsekvensene er alvorlige: ifølge Bain-undersøkelser resulterer 60 % av søk i ingen klikk, noe som utgjør et massivt trafikkfall for merkevarer som vises i AI-genererte svar med unøyaktig informasjon. Selskaper har rapportert opptil 10 % trafikkfall når AI-systemer feiltolker deres produkter eller tjenester. Utover trafikk, svekker hallusinasjoner kundetillit—når brukere møter falske påstander tilskrevet din merkevare, stiller de spørsmål ved din troverdighet og kan bytte til konkurrenter.

| Plattform | Hendelse | Påvirkning |

|---|---|---|

| Google Bard | Falsk James Webb-eksoplanetpåstand | Tap av brukertillit, skade på plattformens troverdighet |

| Microsoft Sydney | Upassende emosjonelle uttrykk | PR-krise, sikkerhetsbekymringer, brukermisnøye |

| Meta Galactica | Vitenskapelige hallusinasjoner og skjevhet | Produkt trukket etter 3 dager, omdømmeskade |

| ChatGPT | Oppdiktede rettssaker og siteringer | Advokat disiplinert for bruk av hallusinert rettspraksis i retten |

| Perplexity | Feilsiterte sitater og statistikk | Feilrepresentasjon av merkevare, problemer med kilde-troverdighet |

Risiko for merkevaresikkerhet fra AI-hallusinasjoner oppstår på tvers av flere plattformer som nå dominerer søk og informasjonsinnhenting. Google AI Overviews gir AI-genererte sammendrag øverst i søkeresultatene, og sammenstiller informasjon fra flere kilder uten kildehenvisning for hver påstand som gjør det mulig for brukere å verifisere hvert utsagn. ChatGPT og ChatGPT Search kan hallusinere fakta, feiltilskrive sitater og gi utdatert informasjon, spesielt for spørsmål om nylige hendelser eller nisjetemaer. Perplexity og andre AI-søkemotorer står overfor lignende utfordringer, med spesifikke feilmodus som hallusinasjoner blandet med korrekte fakta, feilattribuering av utsagn til feil kilder, manglende kritisk kontekst som endrer meningen, og i YMYL (Your Money, Your Life)-kategorier potensielt utrygge råd om helse, økonomi eller juridiske forhold. Risikoen forsterkes fordi disse plattformene i økende grad er der brukere søker svar—de blir det nye søkegrensesnittet. Når din merkevare vises i disse AI-genererte svarene med feilaktig informasjon, har du begrenset innsikt i hvordan feilen oppsto og begrenset mulighet til å korrigere den raskt.

AI-hallusinasjoner eksisterer ikke isolert; de spres gjennom sammenkoblede systemer på måter som forsterker feilinformasjon i stor skala. Datatomrom—områder på internett hvor lavkvalitetskilder dominerer og autoritativ informasjon er knapp—skaper forhold der AI-modeller fyller hull med plausible, men oppdiktede påstander. Skjevhet i treningsdata gjør at dersom visse narrativer var overrepresentert i treningsdataene, lærer modellen å generere disse mønstrene selv når de er faktamessig feil. Ondsinnede aktører utnytter denne sårbarheten gjennom adversariale angrep, der de bevisst utformer innhold for å manipulere AI-resultater til sin fordel. Når hallusinerende nyhetsroboter sprer usannheter om din merkevare, konkurrenter eller bransje, kan disse falske påstandene undergrave dine tiltak—innen du får korrigert feilen, har AI allerede trent på og videreført feilinformasjonen. Input-skjevhet skaper hallusinerte mønstre der modellens tolkning av en forespørsel får den til å generere informasjon som samsvarer med dens skjeve forventninger i stedet for faktiske realiteter. Denne mekanismen betyr at feilinformasjon sprer seg raskere gjennom AI-systemer enn gjennom tradisjonelle kanaler, og når millioner av brukere samtidig med de samme falske påstandene.

Sanntidsovervåking på tvers av AI-plattformer er essensielt for å oppdage hallusinasjoner før de skader ditt merkevareomdømme. Effektiv overvåking krever overvåking på tvers av plattformer som dekker Google AI Overviews, ChatGPT, Perplexity, Gemini og fremvoksende AI-søkemotorer samtidig. Stemmingsanalyse av hvordan din merkevare fremstilles i AI-svar gir tidlige varsler om trusler mot omdømmet. Oppdagelsesstrategier bør fokusere på å identifisere ikke bare hallusinasjoner, men også feilattribueringer, utdatert informasjon og utelatelser som endrer meningen. Følgende beste praksis etablerer et helhetlig overvåkingsrammeverk:

Uten systematisk overvåking flyr du i blinde—hallusinasjoner om din merkevare kan spre seg i ukevis før du oppdager dem. Kostnaden ved forsinket oppdagelse øker jo flere brukere som møter feilinformasjonen.

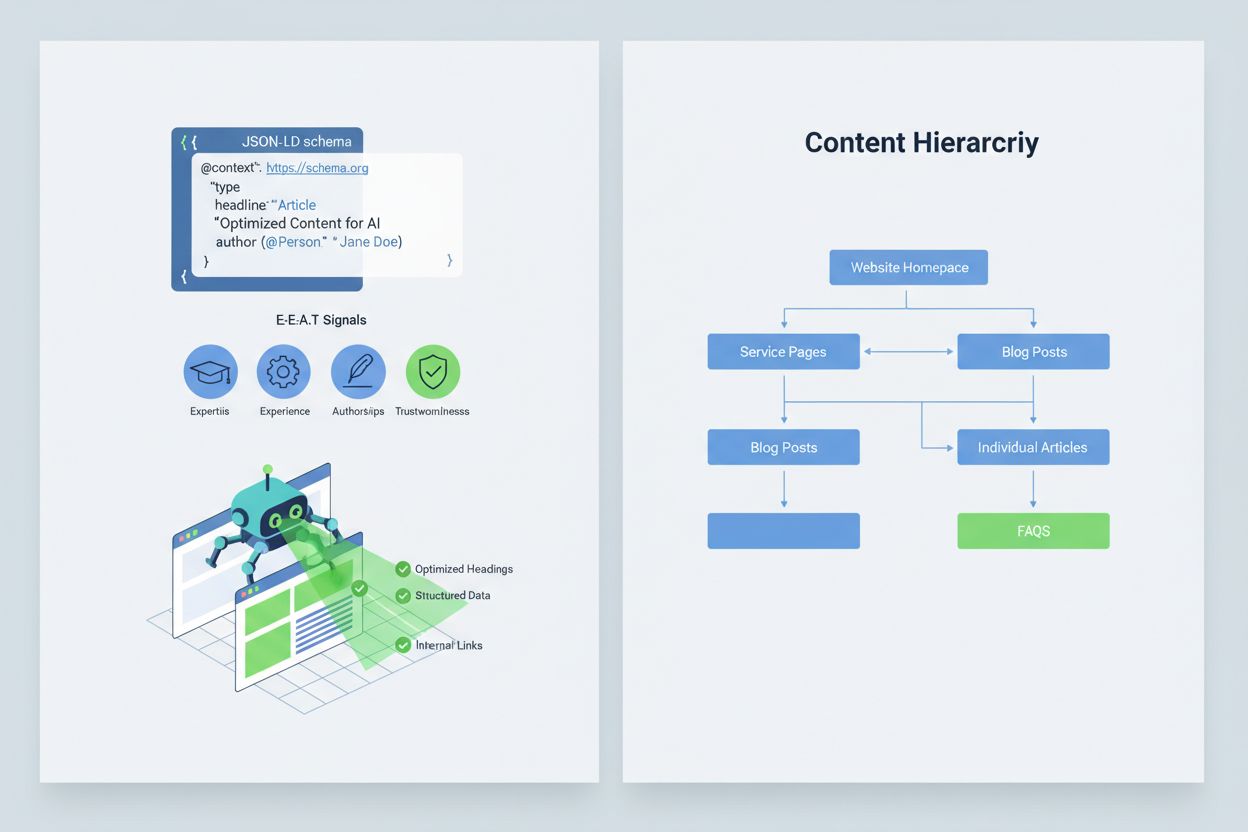

Å optimalisere innholdet ditt slik at AI-systemer tolker og siterer det korrekt krever implementering av E-E-A-T-signaler (Ekspertise, Erfaring, Forfatterskap, Troværdighet) som gjør informasjonen mer autoritativ og verdt å sitere. E-E-A-T inkluderer ekspertforfatterskap med tydelige kvalifikasjoner, åpen kildehenvisning med lenker til primærkilder, oppdaterte tidsstempler som viser innholdets friskhet, og eksplisitte redaksjonelle standarder som demonstrerer kvalitetssikring. Implementering av strukturert data via JSON-LD-skjema hjelper AI-systemer å forstå innholdets kontekst og troverdighet. Spesifikke skjematyper er særlig verdifulle: Organization-skjema etablerer virksomhetens legitimitet, Product-skjema gir detaljerte spesifikasjoner som reduserer hallusinasjonsrisiko, FAQPage-skjema svarer på vanlige spørsmål med autoritative svar, HowTo-skjema gir trinnvise veiledninger for prosedyrespørsmål, Review-skjema viser tredjeparts bekreftelse, og Article-skjema signaliserer journalistisk troverdighet. Praktisk implementering inkluderer å legge til Q&A-blokker som direkte adresserer risikofylte intensjoner hvor hallusinasjoner ofte oppstår, lage kanoniske sider som samler informasjon og reduserer forvirring, og utvikle innhold verdt å sitere som AI-systemer naturlig vil referere til. Når innholdet ditt er strukturert, autoritativt og tydelig kildehenvist, er AI-systemer mer tilbøyelige til å sitere det korrekt og mindre tilbøyelige til å hallusinere alternativer.

Når en kritisk merkevaresikkerhetssak oppstår—en hallusinasjon som feiltolker ditt produkt, feiltilskriver et utsagn til en leder eller gir farlig feilinformasjon—er hurtighet din konkurransefordel. En 90-minutters responsplan kan begrense skaden før den sprer seg bredt. Trinn 1: Bekreft og avgrens (10 minutter) innebærer å verifisere at hallusinasjonen eksisterer, dokumentere skjermbilder, identifisere hvilke plattformer som er berørt og vurdere alvorlighetsgrad. Trinn 2: Stabiliser egne flater (20 minutter) betyr umiddelbart å publisere autoritative avklaringer på ditt nettsted, i sosiale medier og gjennom pressekanaler for å korrigere informasjonen for brukere som søker etter relaterte opplysninger. Trinn 3: Send tilbakemelding til plattformen (20 minutter) krever innsending av detaljerte rapporter til hver berørt plattform—Google, OpenAI, Perplexity, osv.—med dokumentasjon på hallusinasjonen og ønskede rettelser. Trinn 4: Eskaler eksternt ved behov (15 minutter) innebærer kontakt med plattformens PR-team eller juridisk bistand dersom hallusinasjonen forårsaker materielle skader. Trinn 5: Følg og verifiser løsning (25 minutter) betyr overvåking for å se om plattformene har rettet svaret og dokumentere tidslinjen. Kritisk nok har ingen av de store AI-plattformene publiserte SLA-er (Service Level Agreements) for rettelser, noe som gjør dokumentasjon essensielt for ansvarlighet. Hurtighet og grundighet i denne prosessen kan redusere omdømmeskade med 70–80 % sammenlignet med forsinkede svar.

Fremvoksende spesialplattformer tilbyr nå dedikert overvåking av AI-genererte svar, og omgjør merkevaresikkerhet fra manuell sjekking til automatisert innsikt. AmICited.com utmerker seg som den ledende løsningen for overvåking av AI-svar på tvers av alle store plattformer—den sporer hvordan din merkevare, produkter og ledere vises i Google AI Overviews, ChatGPT, Perplexity og andre AI-søkemotorer med sanntidsvarsler og historisk sporing. Profound overvåker merkevareomtaler på tvers av AI-søkemotorer med stemningsanalyse som skiller mellom positiv, nøytral og negativ omtale, og hjelper deg å forstå ikke bare hva som sies, men hvordan det presenteres. Bluefish AI spesialiserer seg på å spore din tilstedeværelse på Gemini, Perplexity og ChatGPT, og gir innsikt i hvilke plattformer som utgjør størst risiko. Athena tilbyr en AI-søkemodell med dashbordmålinger som hjelper deg å forstå din synlighet og ytelse i AI-genererte svar. Geneo gir plattformuavhengig oversikt med stemningsanalyse og historisk sporing som avdekker trender over tid. Disse verktøyene oppdager skadelige svar før de sprer seg bredt, gir forslag til innholdsoptimalisering basert på hva som fungerer i AI-svar, og muliggjør flermerke-administrasjon for virksomheter som overvåker dusinvis av merkevarer samtidig. Avkastningen er betydelig: tidlig oppdagelse av en hallusinasjon kan forhindre at tusenvis av brukere møter feilinformasjon om din merkevare.

Å styre hvilke AI-systemer som får tilgang til og trener på innholdet ditt gir et ekstra lag med merkevaresikkerhet. OpenAI sin GPTBot følger robots.txt-direktiver slik at du kan blokkere den fra å krype sensitivt innhold, samtidig som du opprettholder tilstedeværelse i ChatGPTs treningsdata. PerplexityBot følger også robots.txt, selv om det fortsatt finnes bekymringer rundt uidentifiserte crawlere som kanskje ikke identifiserer seg korrekt. Google og Google-Extended følger standard robots.txt-regler, og gir deg detaljert kontroll over hvilket innhold som mates inn i Googles AI-systemer. Avveiningen er reell: blokkering av crawlere reduserer din tilstedeværelse i AI-genererte svar og kan koste synlighet, men beskytter sensitivt innhold mot misbruk eller hallusinasjon. Cloudflares AI Crawl Control tilbyr mer avanserte alternativer for detaljert kontroll, slik at du kan hviteliste verdifulle seksjoner av nettstedet ditt samtidig som du beskytter ofte feiltolket innhold. En balansert strategi innebærer vanligvis å la crawlere få tilgang til hovedprodukt- og autoritetsinnhold, mens intern dokumentasjon, kundedata eller innhold utsatt for feiltolkning blokkeres. Denne tilnærmingen opprettholder din synlighet i AI-svar, samtidig som du reduserer risikoen for hallusinasjoner som kan skade din merkevare.

Å etablere klare KPI-er for ditt merkevaresikkerhetsprogram gjør det fra en utgiftspost til en målbar forretningsfunksjon. MTTD/MTTR-målinger (gjennomsnittstid til oppdagelse og løsning) for skadelige svar, segmentert etter alvorlighetsgrad, viser om overvåkings- og responsprosessene dine forbedres. Stemmingsnøyaktighet og -fordeling i AI-svar avslører om din merkevare fremstilles positivt, nøytralt eller negativt på tvers av plattformer. Andel autoritative siteringer måler hvor stor prosentandel av AI-svar som siterer ditt offisielle innhold kontra konkurrenter eller upålitelige kilder—høyere prosent betyr vellykket innholdsforsterkning. Synlighetsandel i AI Overviews og Perplexity-resultater viser om du opprettholder tilstedeværelse i disse trafikksterke AI-grensesnittene. Eskaleringseffektivitet måler prosentandel kritiske saker løst innenfor din SLA, og viser operasjonell modenhet. Forskning viser at merkevaresikkerhetsprogrammer med sterke pre-bid-kontroller og proaktiv overvåking reduserer brudd til ensifrede prosent, sammenlignet med 20–30 % brudd for reaktive tilnærminger. AI Overviews-forekomsten har økt betydelig gjennom 2025, noe som gjør proaktive inkluderingstiltak essensielle—merkevarer som optimaliserer for AI-svar nå, får konkurransefortrinn over de som venter på at teknologien skal modnes. Hovedprinsippet er klart: forebygging er bedre enn reaksjon, og avkastningen på proaktiv merkevaresikkerhet øker over tid etter hvert som du bygger autoritet, reduserer hallusinasjoner og opprettholder kundetillit.

En AI-hallusinasjon oppstår når en stor språkmodell genererer plausibel, men helt oppdiktet informasjon med full selvtillit. Disse falske resultatene skjer fordi LLM-er forutsier statistisk sannsynlige ordsekvenser basert på mønstre i treningsdataene, heller enn å virkelig forstå fakta. Hallusinasjoner skyldes overtilpasning, skjevhet i treningsdata og den iboende kompleksiteten i nevrale nettverk som gjør beslutningstakingen deres uoversiktlig.

AI-hallusinasjoner kan alvorlig skade din merkevare på flere måter: De fører til trafikkfall (60 % av søk gir ingen klikk når AI-oppsummeringer vises), svekker kundetillit når falske påstander tilskrives din merkevare, skaper PR-kriser når konkurrenter utnytter hallusinasjoner, og reduserer din synlighet i AI-genererte svar. Selskaper har rapportert opptil 10 % trafikkfall når AI-systemer feiltolker deres produkter eller tjenester.

Google AI Overviews, ChatGPT, Perplexity og Gemini er de viktigste plattformene hvor risiko for merkevaresikkerhet oppstår. Google AI Overviews vises øverst i søkeresultatene uten kildehenvisning for hver påstand. ChatGPT og Perplexity kan hallusinere fakta og feiltilskrive informasjon. Hver plattform har ulike siteringspraksiser og tidslinjer for rettelser, noe som krever strategier for overvåking på tvers av flere plattformer.

Sanntidsovervåking på tvers av AI-plattformer er essensielt. Overvåk prioriterte søk (merkevarenavn, produktnavn, lederes navn, sikkerhetstemaer), etabler stemningsbaser og varslingsterskler, og korreler endringer med dine innholdsoppdateringer. Spesialverktøy som AmICited.com tilbyr automatisert oppdagelse på alle store AI-plattformer med historisk sporing og stemningsanalyse.

Følg en 90-minutters responsplan for hendelser: 1) Bekreft og avgrens problemet (10 min), 2) Publiser autoritative avklaringer på ditt nettsted (20 min), 3) Send tilbakemelding til plattformen med dokumentasjon (20 min), 4) Eskaler eksternt ved behov (15 min), 5) Følg opp løsning (25 min). Hurtighet er avgjørende—tidlig respons kan redusere omdømmeskade med 70–80 % sammenlignet med forsinkede svar.

Implementer E-E-A-T-signaler (Ekspertise, Erfaring, Forfatterskap, Troværdighet) med ekspertkvalifikasjoner, åpen kildehenvisning, oppdaterte tidsstempler og redaksjonelle standarder. Bruk JSON-LD-strukturert data med Organization, Product, FAQPage, HowTo, Review og Article-skjema. Legg til Q&A-blokker for risikofylte søk, lag kanoniske sider som samler informasjon, og utvikle innhold verdt å sitere som AI-systemer naturlig refererer.

Å blokkere crawlere reduserer din tilstedeværelse i AI-genererte svar, men beskytter sensitivt innhold. En balansert strategi lar crawlere få tilgang til hovedprodukt- og autoritetsinnhold, men blokkerer intern dokumentasjon og ofte feiltolket innhold. OpenAI sin GPTBot og PerplexityBot følger robots.txt-direktiver, slik at du kan styre nøyaktig hvilket innhold som mates inn i AI-systemer.

Følg MTTD/MTTR (gjennomsnittstid til oppdagelse/løsning) for skadelige svar etter alvorlighetsgrad, stemningsnøyaktighet i AI-svar, andel autoritative siteringer mot konkurrenter, synlighetsandel i AI Overviews og Perplexity-resultater, og eskaleringseffektivitet (prosent løst innen SLA). Disse målene viser om dine overvåkings- og responsprosesser forbedres, og gir avkastningsbegrunnelse for investeringer i merkevaresikkerhet.

Beskytt ditt merkevareomdømme med sanntidsovervåking på tvers av Google AI Overviews, ChatGPT og Perplexity. Oppdag hallusinasjoner før de skader ditt omdømme.

Lær hva AI-hallusinasjon er, hvorfor det skjer i ChatGPT, Claude og Perplexity, og hvordan du kan oppdage falsk AI-generert informasjon i søkeresultater.

Lær hva AI-hallusinasjonsovervåking er, hvorfor det er essensielt for merkevaresikkerhet, og hvordan deteksjonsmetoder som RAG, SelfCheckGPT og LLM-as-Judge bid...

AI-hallusinasjon oppstår når LLM-er genererer falsk eller misvisende informasjon med selvtillit. Lær hva som forårsaker hallusinasjoner, deres innvirkning på me...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.