E-E-A-T e Busca por IA: Por Que a Autoridade da Sua Marca Importa Mais do Que Nunca

Entenda E-E-A-T (Experiência, Expertise, Autoridade, Confiabilidade) e sua importância crítica para visibilidade em motores de busca por IA como ChatGPT, Perple...

Descubra como os sinais de E-E-A-T influenciam as citações de LLM e a visibilidade em IA. Aprenda como experiência, especialização, autoridade e confiança moldam a descoberta de conteúdo em buscas com IA.

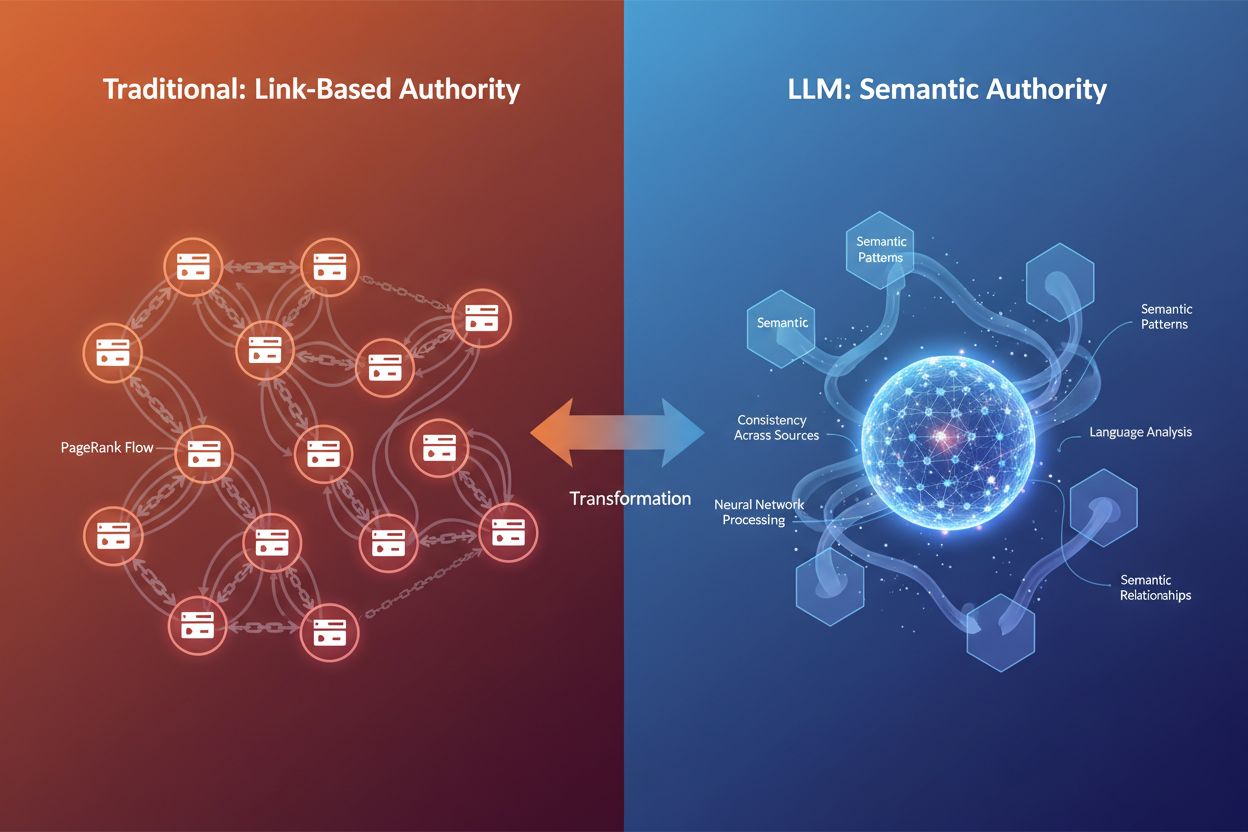

O cenário digital está mudando sob nossos pés. Por décadas, backlinks foram o principal marcador de autoridade—quanto mais links de qualidade apontando para seu site, mais autoritário você era considerado pelos motores de busca. Mas à medida que grandes modelos de linguagem (LLMs) como ChatGPT, Claude e Gemini remodelam como a informação é descoberta e avaliada, a definição de autoridade está evoluindo. E-E-A-T—Experiência, Especialização, Autoridade e Confiança—deixou de ser uma consideração secundária de SEO para se tornar um framework fundamental que determina a visibilidade tanto em buscas tradicionais quanto em plataformas impulsionadas por IA. O ponto crítico aqui é que backlinks não são mais o único marcador de autoridade que determina se seu conteúdo será citado por sistemas de IA. Em vez disso, LLMs avaliam autoridade pela riqueza semântica, consistência entre fontes e profundidade do conhecimento demonstrado em seu conteúdo. Essa mudança é fundamental para marcas que buscam visibilidade em sistemas de citação de IA como o AI Overviews do Google, Perplexity e ChatGPT. Quando o AmICited monitora como a IA referencia sua marca nessas plataformas, estamos rastreando sinais que vão muito além dos perfis tradicionais de links. A questão não é mais apenas “quem linka para você?”, mas sim “seu conteúdo demonstra expertise genuína, e sistemas de IA podem confiar nele a ponto de citá-lo?”. Entender essa distinção é essencial para quem leva a sério a construção de autoridade no cenário de buscas orientadas por IA.

E-E-A-T representa quatro dimensões interconectadas da credibilidade do conteúdo, cada uma com um papel distinto em como Google e LLMs avaliam se seu conteúdo merece visibilidade. Vamos destrinchar cada pilar e entender como funcionam no contexto das citações de IA:

Experiência significa que você realmente fez aquilo sobre o que está escrevendo. Uma resenha de produto feita por quem usou o produto por seis meses tem mais peso que uma visão genérica. Na era da IA, LLMs reconhecem conteúdo experiencial por padrões de linguagem que sinalizam envolvimento prático—detalhes específicos, observações reais e nuances contextuais que só quem teve contato direto incluiria.

Especialização é conhecimento demonstrável respaldado por credenciais, formação ou histórico comprovado. Um consultor financeiro com certificação CFA escrevendo sobre estratégias de investimento tem mais autoridade que um blogueiro de lifestyle abordando finanças. Para LLMs, especialização é reconhecida pelo uso consistente de terminologia técnica, profundidade lógica da explicação e capacidade de abordar subtemas complexos com precisão.

Autoridade vem do reconhecimento externo—outras fontes confiáveis citam você, linkam para você ou mencionam seu nome como referência. Tradicionalmente, isso era medido por backlinks. No entanto, no contexto dos LLMs, autoridade é cada vez mais medida pelo rastro semântico—com que frequência sua marca ou nome aparece associado ao seu nicho em diversas fontes e plataformas.

Confiança é o guarda-chuva que sustenta tudo. Sem confiança, os outros três pilares desmoronam. Ela é construída por transparência (autoria clara, informações de contato), precisão (conteúdo factual com devidas citações) e segurança (HTTPS, infraestrutura profissional do site). O Google afirma explicitamente que confiança é o membro mais importante da família E-E-A-T, e LLMs também valorizam muito consistência e confiabilidade ao selecionar fontes para citar.

| Sinal | Avaliação SEO Tradicional | Avaliação de Citação por LLM |

|---|---|---|

| Experiência | Bio do autor, relatos pessoais | Padrões de linguagem indicando envolvimento prático |

| Especialização | Credenciais, backlinks de sites de autoridade | Profundidade semântica, terminologia técnica, cobertura temática |

| Autoridade | Perfil de backlinks, autoridade de domínio | Reconhecimento de entidade, menções multiplataforma, autoridade semântica |

| Confiança | HTTPS, estrutura do site, avaliações de usuários | Consistência entre fontes, verificação de precisão, clareza |

A diferença principal é que enquanto o SEO tradicional se apoia em sinais estruturais (links, métricas de domínio), LLMs avaliam E-E-A-T por análise semântica e contextual. Isso significa que seu conteúdo pode construir autoridade sem campanhas massivas de link building—basta demonstrar expertise e consistência genuínas.

Grandes modelos de linguagem não pensam como motores de busca tradicionais. Eles não rastreiam a web procurando backlinks nem checam pontuações de autoridade de domínio. Eles operam como máquinas probabilísticas que reconhecem padrões na linguagem, contexto e consistência da informação. Quando um LLM avalia se deve citar seu conteúdo, faz perguntas fundamentalmente diferentes do algoritmo de ranqueamento do Google.

Reconhecimento de Padrão vs. Sinais Estruturais: Motores de busca tradicionais verificam autoridade por validação externa—quem linka para você? LLMs, por outro lado, reconhecem autoridade linguisticamente. Eles analisam se seu texto demonstra expertise pelo uso correto de termos técnicos, fluxo lógico, tom confiante e capacidade de abordar nuances do tema. Uma página sobre doenças cardíacas que integra naturalmente conceitos como “colesterol”, “placa arterial” e “fatores de risco cardiovascular” sinaliza autoridade semântica para um LLM, mesmo sem nenhum backlink.

Relevância Semântica e Profundidade do Tema: LLMs priorizam conteúdos que abordam um tema por múltiplos ângulos. Ao fazer uma pergunta a um assistente de IA, o sistema divide sua consulta em várias buscas (chamadas de “query fan-out”), depois busca conteúdos que correspondam a essas buscas expandidas. Conteúdo que cobre um tema de forma abrangente—abordando subtemas, respondendo perguntas relacionadas, fornecendo contexto—tem mais chances de ser citado. Por isso, riqueza semântica tornou-se uma nova forma de autoridade.

Consistência Entre Fontes: LLMs cruzam informações entre milhões de documentos. Se seu conteúdo se alinha ao consenso estabelecido e ainda traz novidades, é tratado como mais autoritativo. Por outro lado, se contradiz fatos sem apoio, pode ser rebaixado como não confiável. Isso cria uma dinâmica interessante: é possível trazer ideias novas, mas elas precisam estar fundamentadas em informação verificável.

Principais Diferenças na Avaliação de Autoridade:

Resumindo: LLMs reconhecem autoridade pelo significado, não por métricas. Isso muda fundamentalmente a forma de otimizar conteúdo para visibilidade em IA.

Uma das descobertas mais marcantes de pesquisas recentes sobre comportamento de citação dos LLMs é o forte viés de recência em todas as principais plataformas. Ao analisar 90.000 citações do ChatGPT, Gemini e Perplexity com busca web ativada, os dados mostraram um padrão claro: a maioria das URLs citadas foi publicada dentro de poucos centenas de dias da resposta do LLM. Isso não é acidental—é projetado assim. LLMs são treinados para reconhecer que conteúdo fresco geralmente corresponde a relevância e qualidade, especialmente para temas sensíveis ao tempo.

Por que Atualidade Importa no RAG: Quando LLMs usam Recuperação Aumentada por Geração (RAG)—buscando na web em tempo real para fundamentar suas respostas—estão basicamente perguntando: “Qual a informação mais atual e relevante disponível?” Atualidade se torna um proxy de confiabilidade. Se você pergunta sobre eventos recentes, tendências de mercado ou pesquisas novas, um artigo do mês passado é, por natureza, mais confiável que um de cinco anos. Isso cria uma vantagem para quem mantém e atualiza suas páginas com frequência.

Padrões de Atualidade Por Plataforma: Pesquisas mostram que o Gemini tem a preferência mais forte por conteúdo recente, com a maior concentração de citações de páginas publicadas entre zero e 300 dias. O Perplexity fica no meio, citando uma boa mistura de conteúdos frescos e moderadamente antigos. A OpenAI traz a maior variedade de idades de publicação, incluindo fontes mais antigas, mas mesmo assim mostra desempenho forte em buscar material recente. Isso significa que sua estratégia de otimização deve considerar quais plataformas de IA seu público mais utiliza.

Temas Sensíveis ao Tempo Exigem Atualizações Ativas: Para temas YMYL (Your Money or Your Life)—saúde, finanças, jurídico—e setores dinâmicos, atualidade é inegociável. Um artigo sobre regulação de criptomoedas de 2021 dificilmente será citado em 2025. A solução é manutenção sistemática: atualize estatísticas anualmente (trimestralmente para setores dinâmicos), adicione datas de “última atualização” visíveis e renove dados importantes conforme surgirem novidades. Isso sinaliza para IA e leitores que seu conteúdo está atualizado e confiável.

Os Dados do Viés de Recência: Análise de 21.412 URLs com datas de publicação extraíveis mostrou que, nas três principais plataformas de LLM, a atividade de citação atinge o pico entre zero e 300 dias, caindo gradualmente depois. Isso significa que o primeiro ano de vida do conteúdo é crítico para visibilidade em IA. Conteúdo com mais de três anos tem taxas de citação bem menores, a menos que trate de temas perenes ou tenha sido atualizado recentemente.

Embora LLMs não avaliem diretamente pontuações de autoridade de domínio, há uma correlação clara entre domínios de alta autoridade e frequência de citação. A análise dos 1.000 sites mais mencionados pelo ChatGPT revelou um padrão: IA favorece sites com Domain Rating (DR) acima de 60, com a maioria das citações de domínios DR 80–100. Porém, essa correlação é indireta—sites de DR alto naturalmente ranqueiam melhor nos resultados de busca, e como LLMs buscam conteúdo por meio de buscas web, encontram esses sites mais frequentemente.

O Efeito Indireto da Autoridade: A relação entre autoridade de domínio e citações de LLM funciona assim: LLMs usam buscadores (ou sistemas de busca semelhantes) para encontrar conteúdo. Sites de alta autoridade ranqueiam melhor nessas buscas. Portanto, aparecem mais nos resultados de recuperação dos LLMs. Não é que LLMs leem seu score de autoridade; é que autoridade correlaciona com visibilidade em busca, que correlaciona com chance de citação. Isso significa que construir autoridade de SEO tradicional via backlinks de qualidade continua valioso, mesmo em um cenário impulsionado por IA.

Riqueza Semântica como Novo Sinal de Autoridade: Além dos méritos de domínio, LLMs reconhecem autoridade por riqueza semântica—profundidade e amplitude da cobertura temática. Uma página que explora um assunto a fundo, usa palavras-chave relevantes naturalmente, aborda subtemas e fornece contexto, sinaliza expertise para IA. Por exemplo, um artigo sobre “benefícios da dieta mediterrânea” que cobre aspectos culturais, resultados em saúde, comparações com outras dietas e responde dúvidas comuns mostra mais autoridade semântica que uma lista genérica.

Relações de Entidade e Autoridade Temática: LLMs usam reconhecimento de entidades para entender como seu conteúdo se conecta a gráficos de conhecimento maiores. Se seu artigo sobre “Steve Jobs” menciona consistentemente Apple, inovação, liderança e design de produto, a IA conecta essas entidades e constrói uma visão mais completa da sua autoridade. Por isso, dados estruturados e schema markup são cada vez mais importantes—ajudam a IA a entender relações de entidades e conexões temáticas com clareza.

O Conteúdo Deve Atender a Consultas Expandidas: Quando um LLM recebe uma consulta do usuário, geralmente expande essa consulta em múltiplas buscas relacionadas. Seu conteúdo precisa cobrir não só a consulta principal, mas também variações expandidas. Se alguém pergunta “como saber se o abacate está maduro”, o LLM pode buscar também “indicadores de maturação do abacate”, “quanto tempo abacate leva para amadurecer” e “armazenando abacates maduros”. Conteúdo que cobre esses ângulos relacionados tem mais chance de ser citado em várias variações de consulta.

Otimizar para E-E-A-T no contexto das citações de LLM requer uma abordagem estratégica e multifacetada. O objetivo é criar conteúdo que demonstre expertise genuína e seja fácil para sistemas de IA reconhecerem e extraírem essa expertise. Eis um framework prático:

1. Exiba Claramente Credenciais e Especialização

A bio do autor deve ser completa e verificável. Inclua credenciais específicas (certificações, diplomas, títulos profissionais), anos de experiência e envolvimento direto com o tema. Não diga apenas “especialista em marketing”—diga “CMO com 15 anos de experiência em marketing B2B SaaS, incluindo passagens por HubSpot e Salesforce”. Essa especificidade ajuda LLMs a reconhecer expertise genuína. Inclua bios em todo conteúdo publicado e considere adicionar schema markup (Author schema) para tornar credenciais legíveis por máquina.

2. Crie Pesquisas e Dados Originais

Pesquisa original é um dos sinais de autoridade mais poderosos. Quando você publica dados inéditos—resultados de pesquisas, benchmarks proprietários, estudos de caso—você se torna fonte primária. LLMs citam fontes primárias com mais frequência por oferecerem valor único. A página “Quanto Custa SEO?” do Ahrefs, baseada em pesquisa com 439 pessoas, é um de seus artigos mais citados justamente por ser pesquisa original. O segredo é deixar a metodologia transparente e informar claramente o tamanho da amostra.

3. Mantenha Autoridade Consistente em Todas as Plataformas

Sua autoridade não é medida só no seu site. LLMs analisam sua presença no LinkedIn, publicações do setor, palestras, menções na mídia e outros canais. Mantenha informações profissionais, posicionamento de expertise e mensagens consistentes em todos os canais. Quando IA vê seu nome associado ao nicho em várias fontes, ganha confiança na sua autoridade.

4. Implemente Schema Markup Adequado

Schema markup torna seus sinais de expertise legíveis por máquina. Use Article schema para datas de publicação e autor, FAQ schema para conteúdos em formato de pergunta e resposta, e Author schema para conectar suas credenciais ao conteúdo. Pesquisas mostram que 36,6% das palavras-chave de busca acionam featured snippets derivados de schema markup, e esses dados estruturados também ajudam LLMs a entender melhor seu conteúdo.

5. Construa Autoridade Temática com Clusters de Conteúdo

Em vez de publicar posts isolados, crie hubs de conteúdo que demonstrem conhecimento completo de um tema. Interligue artigos relacionados, aborde subtemas a fundo e construa uma teia semântica que mostre domínio do assunto por múltiplos ângulos. Essa abordagem de cluster sinaliza autoridade temática para Google e LLMs.

6. Atualize Conteúdo Sistematicamente

Atualidade é fator de ranqueamento para Google e LLMs. Estabeleça um cronograma de manutenção: revise e atualize páginas importantes a cada trimestre, renove estatísticas anualmente e destaque datas de “última atualização”. Esse investimento contínuo sinaliza que seu conteúdo está atual e confiável.

7. Cite Fontes Autoritativas

Ao referenciar outras fontes confiáveis, você constrói uma rede de confiança. Cite pesquisas revisadas por pares, relatórios do setor e especialistas reconhecidos. Isso fortalece sua credibilidade e ajuda LLMs a entender contexto e confiabilidade das suas afirmações.

8. Seja Transparente Sobre Limitações

Expertise genuína inclui saber o que você não sabe. Se um assunto foge à sua especialização, diga. Se seus dados têm limitações, reconheça. Essa transparência constrói confiança com leitores humanos e sistemas de IA, que são treinados para valorizar comunicação honesta e matizada.

Entender E-E-A-T na teoria é uma coisa; ver funcionando na prática é outra. Vamos examinar o que torna certos conteúdos muito citáveis e como esses princípios se manifestam em exemplos reais.

A Anatomia de Conteúdo Altamente Citável: A página “Quanto Custa SEO?” do Ahrefs exemplifica otimização de E-E-A-T para citações de LLM. Ela responde diretamente a uma dúvida comum e de alto volume. É construída sobre pesquisa original (439 pessoas pesquisadas), traz data clara, detalha preços por vários critérios (freelancers vs. agências, hora vs. mensalidade, variações geográficas). O conteúdo é escaneável com títulos claros, inclui visualizações de dados acompanhadas de texto e explora o tema de diferentes ângulos para cobrir consultas relacionadas. O autor exibe credenciais relevantes e o conteúdo é revisado por pares, agregando mais confiança.

O Que Torna o Conteúdo Citável: Conteúdo altamente citável geralmente compartilha estas características: responde perguntas específicas diretamente, sem enrolação; baseia-se em dados verificáveis ou pesquisa original; usa estrutura e formatação claras que facilitam extração; aborda o tema por múltiplos ângulos; demonstra expertise genuína por profundidade e nuance. Ao avaliar se cita uma página, LLMs basicamente perguntam: “Consigo extrair uma resposta clara e precisa daqui? A fonte é confiável? Esta página agrega valor único?”

Formatação Estruturada como Sinal de Citação: Conteúdo com hierarquia clara de títulos, bullet points, tabelas e parágrafos curtos tem mais chance de ser citado. Isso não é só legibilidade para humanos—é extraibilidade para IA. Quando um LLM pode identificar rapidamente a informação-chave por sinais estruturais, tende a usar aquele conteúdo em suas respostas. Compare um bloco de texto com um artigo bem formatado com H2, H3 e bullets: a versão estruturada é muito mais citável.

Cobertura de Temas por Múltiplos Ângulos: Conteúdo que aborda um tema por diferentes perspectivas aumenta oportunidades de citação. Por exemplo, um artigo sobre “produtividade no trabalho remoto” pode cobrir produtividade para diferentes cargos (desenvolvedores, gerentes, atendimento), fusos horários, ambientes domésticos e perfis comportamentais. Essa abordagem multiângulo permite responder dezenas de consultas relacionadas a partir de uma única fonte, aumentando muito o potencial de citação.

Padrões Reais de Citação: Análise do SearchAtlas com 90.000 citações em grandes LLMs mostra que conteúdos muito citados tendem a vir de sites com alta autoridade de domínio, mas também de especialistas de nicho com conhecimento profundo. Respostas do Reddit e artigos do Substack aparecem frequentemente em citações de IA, mesmo com poucos backlinks, por demonstrarem expertise autêntica e clareza conversacional. Isso prova que autoridade é cada vez mais sobre conhecimento demonstrado, não só métricas de link.

Construir E-E-A-T é uma coisa; medir sua efetividade é outra. Métricas tradicionais como rankings de palavra-chave e contagem de backlinks não capturam toda a visibilidade em IA. São necessários novos indicadores e ferramentas específicas para a era da IA.

Testes Manuais em Plataformas de IA: Comece testando diretamente. Crie uma lista de 10-20 perguntas que seu conteúdo deveria responder, e teste-as mensalmente no ChatGPT, Perplexity, Claude e Gemini. Documente quais fontes são citadas (suas e de concorrentes), acompanhe mudanças ao longo do tempo e identifique padrões. O método é trabalhoso, mas oferece visão real do que seu público vê. Use uma planilha para registrar resultados e tendências.

Acompanhamento de Tráfego de Referência de IA: A maioria das plataformas de análise já rastreia tráfego de busca IA como canal separado. No Ahrefs Web Analytics (gratuito no Ahrefs Webmaster Tools), o tráfego de busca IA já é segmentado: você vê quais páginas recebem visitas de IA e como os visitantes se comportam. Monitore métricas como tempo na página, taxa de rejeição, profundidade de rolagem e conversões. Apesar do tráfego de IA ser menos de 1% do total atualmente, os visitantes que clicam tendem a ter maior intenção e taxas de conversão que o tráfego de busca tradicional.

Medição da Efetividade do E-E-A-T: Em vez de buscar pontuação direta de E-E-A-T, monitore indicadores como: citações em AI Overview (use BrightEdge ou Authoritas), volume de buscas pela marca, menções no setor em diferentes plataformas e estabilidade de ranqueamento em atualizações do algoritmo. Conteúdo com sinais fortes de E-E-A-T costuma ser menos volátil em core updates. Ferramentas como LLM SEO E-E-A-T Score Checker também oferecem breakdown direto da performance E-E-A-T por categoria.

Monitoramento Pago em Escala: Para acompanhamento abrangente sem testes manuais, use ferramentas como o Brand Radar do Ahrefs, que monitora citações em 150 milhões de prompts em seis grandes plataformas de IA. O Brand Radar exibe onde e quando você é citado, permite filtrar por IA e tema, acompanha tendências de citação ao longo do tempo e mostra dados comparativos com concorrentes. Isso oferece um panorama completo da sua visibilidade em IA e ajuda a identificar oportunidades e lacunas.

Principais Métricas a Monitorar: Acompanhe frequência de citações em IA (quantas vezes você é citado), diversidade de citações (temas e plataformas), pontuação de relevância semântica (quão próximo está do que é consultado), métricas de atualidade (idade média do conteúdo citado) e sobreposição de domínio (quais concorrentes são citados junto com você). Esses indicadores juntos mostram a efetividade do seu E-E-A-T no contexto da IA.

À medida que E-E-A-T e otimização para LLM ganham atenção, surgem equívocos. Vamos desmistificar os mais comuns:

Mito: “Backlinks Estão Mortos”

Realidade: Backlinks continuam sendo sinais valiosos, especialmente para o algoritmo do Google. O que mudou foi seu peso relativo. Não são mais a única moeda do SEO. Sites de alta autoridade continuam sendo mais citados por LLMs, principalmente porque ranqueiam melhor nas buscas (usadas pelos LLMs). O ponto: backlinks ainda importam, mas são só uma peça de um quebra-cabeça maior, que inclui autoridade semântica, atualidade e expertise demonstrada.

Mito: “E-E-A-T é um Fator de Ranqueamento Direto”

Realidade: E-E-A-T não é um fator direto como palavras-chave ou velocidade da página. É um framework usado pelo Google via quality raters para refinar algoritmos. Otimizar para E-E-A-T é, no fundo, otimizar para humanos primeiro—criar conteúdo genuinamente autoritativo e confiável. Os ganhos de ranqueamento vêm indiretamente, por maior satisfação do usuário e redução de bounce.

Mito: “IA Consegue Detectar Autoridade Falsa no Longo Prazo”

Realidade: Isso é parcialmente verdade, mas há nuances. LLMs podem ser enganados por conteúdo que “soa” autoritativo no curto prazo. Fazendas de conteúdo conseguem produzir material com aparência de especialista por escolha de palavras e estrutura. Mas autoridade falsa raramente sobrevive ao crivo humano, e à medida que a IA evolui e treina em dados mais diversos, tende a distinguir expertise genuína de imitação. O caminho seguro: construa autoridade real, não tente enganar o sistema.

Mito: “É Preciso Muitos Backlinks para Ser Citado em LLM”

Realidade: Apesar de sites de alta autoridade serem mais citados, especialistas de nicho com poucos backlinks aparecem regularmente em citações de LLM. O que importa é demonstrar expertise genuína no seu domínio. Um blog especializado e profundo pode superar site generalista com mais backlinks, sobretudo para consultas de nicho. O segredo está na autoridade semântica e profundidade temática.

Mito: “LLMs Só Citam os Top 10 Resultados de Busca”

Realidade: Embora 52% das fontes do AI Overview venham dos top 10 resultados, as citações também incluem sites fora desse grupo. Isso mostra que qualidade e diversidade importam. Se seu conteúdo é relevante e autoritativo, mesmo sem ranquear no top 10, pode ser citado se corresponder a variações de consultas expandidas ou oferecer valor único.

O cenário de autoridade está mudando em tempo real. Entender para onde vai ajuda a criar estratégias que continuam eficazes à medida que o ecossistema evolui.

De Ranqueamento Baseado em Links para Baseado em Significado: O futuro da autoridade está migrando de “quem linka para você?” para “o que seu conteúdo significa?”. Essa mudança dos sinais estruturais para semânticos representa uma transformação fundamental na forma como autoridade é reconhecida. O SEO tradicional construiu autoridade com campanhas de link building. A era da IA constrói autoridade com expertise demonstrada, riqueza semântica e posicionamento consistente em várias plataformas. Quem se antecipa a essa mudança já está estabelecendo autoridade antes do mercado saturar.

Métricas de Engajamento como Sinais de Autoridade: À medida que sistemas de IA evoluem, incorporam métricas de engajamento como sinais de autoridade. Quanto tempo as pessoas passam no seu conteúdo? Elas retornam? Compartilham? Esses sinais comportamentais indicam que seu conteúdo entrega valor real. Isso significa que experiência do usuário e qualidade do conteúdo viram construtores diretos de autoridade, não só fatores indiretos de ranqueamento.

Consistência Multiplataforma como Base da Autoridade: Autoridade não está mais restrita ao seu site. Sua presença no LinkedIn, publicações do setor, palestras e menções na mídia compõem seu rastro semântico. Sistemas de IA reconhecem quando seu nome, marca ou expertise está consistentemente associado ao nicho em várias plataformas. Isso cria efeito composto: cada menção reforça sua autoridade, tornando futuras citações mais prováveis.

A Vantagem dos Primeiros em Autoridade: Marcas e criadores investindo em E-E-A-T agora estão conquistando autoridade antes do mercado saturar. Em dois anos, quando todos brigarem por visibilidade em IA, os pioneiros já serão fontes estabelecidas. É como o início do SEO, quando quem otimizou antes construiu vantagens duradouras. A janela para criar autoridade em buscas por IA ainda está aberta, mas fechando.

Preparando-se para a Próxima Evolução: Com a evolução dos LLMs, sinais de autoridade tendem a ficar ainda mais sofisticados. Devemos ver mais ênfase em verificação em tempo real, consenso multiplataforma e métricas de satisfação do usuário. Marcas que constroem expertise genuína e mantêm práticas transparentes e confiáveis estarão melhor posicionadas para prosperar no que vier. O princípio fundamental permanece: expertise autêntica e confiança são a base da autoridade, seja na busca tradicional ou na descoberta por IA.

E-E-A-T significa Experiência, Especialização, Autoridade e Confiança. É um framework que determina a credibilidade do conteúdo tanto para buscas tradicionais quanto para sistemas de IA. LLMs usam sinais de E-E-A-T para decidir quais fontes citar em suas respostas, tornando-o fundamental para a visibilidade em IA.

LLMs avaliam autoridade por padrões semânticos, consistência entre fontes e demonstração de especialização, em vez de backlinks. Reconhecem autoridade linguisticamente por meio de terminologia técnica, profundidade lógica e abrangência temática. Isso significa que sites de alta autoridade ainda são mais citados, mas principalmente porque ranqueiam melhor nos resultados de busca que os LLMs usam para busca.

Sim. Embora sites maiores tenham vantagens, especialistas de nicho com poucos backlinks aparecem regularmente em citações de LLM. O importante é demonstrar verdadeira especialização em seu domínio por meio de riqueza semântica, profundidade temática e posicionamento consistente. Um blog especializado com conhecimento profundo pode superar sites generalistas com mais backlinks.

E-E-A-T é uma estratégia de longo prazo. Construir autoridade genuína e sinais de confiança normalmente leva meses, não semanas. No entanto, implementar marcação de schema adequada e atribuição de autor pode ter efeitos mais imediatos. O primeiro ano de vida do conteúdo é crítico para a visibilidade em IA, com as taxas de citação caindo significativamente após três anos, a menos que o conteúdo seja atualizado.

Backlinks continuam sendo valiosos sinais de autoridade, mas não são mais a única moeda. Sites de alta autoridade são citados com mais frequência por LLMs, mas isso ocorre principalmente porque ranqueiam melhor nos resultados de busca. O principal ponto: backlinks ainda importam como parte de um quebra-cabeça maior que agora inclui autoridade semântica, atualidade e especialização demonstrada.

Acompanhe frequência de citações em IA, diversidade de citações entre temas e plataformas, pontuações de relevância semântica, métricas de atualidade e sobreposição de domínio com concorrentes. Use ferramentas como Ahrefs Brand Radar para monitoramento abrangente em 150 milhões de prompts, ou teste manualmente suas consultas-alvo mensalmente no ChatGPT, Perplexity, Claude e Gemini.

Não, E-E-A-T não é um fator de ranqueamento direto. É um framework que influencia como sistemas de IA avaliam a qualidade do conteúdo. Otimizar para E-E-A-T é realmente criar conteúdo genuinamente autoritativo e confiável que serve primeiro ao leitor humano. Os benefícios vêm indiretamente por maior satisfação do usuário e aumento nas taxas de citação.

A atualidade tem grande peso na seleção de citações por LLMs. Pesquisas mostram que LLMs citam conteúdos publicados nos últimos 300 dias com taxas significativamente maiores. Para temas sensíveis ao tempo, um artigo do mês passado é, por natureza, mais confiável que um de cinco anos atrás. Atualizações sistemáticas e datas de 'última atualização' visíveis são essenciais para manter visibilidade em IA.

Acompanhe como sua marca é citada pelo ChatGPT, Perplexity, Google AI Overviews e outros LLMs. Entenda seus sinais de E-E-A-T e otimize para visibilidade em IA com o AmICited.

Entenda E-E-A-T (Experiência, Expertise, Autoridade, Confiabilidade) e sua importância crítica para visibilidade em motores de busca por IA como ChatGPT, Perple...

E-E-A-T (Experiência, Especialização, Autoridade, Confiabilidade) é o framework do Google para avaliar qualidade de conteúdo. Veja como ele impacta SEO, citaçõe...

Aprenda como demonstrar sinais de conhecimento e experiência em primeira mão para sistemas de IA como ChatGPT, Perplexity e Google AI Overviews. Otimize seu con...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.