Cartão de Referência de Crawlers de IA: Todos os Bots em um Relance

Guia completo de referência sobre crawlers e bots de IA. Identifique GPTBot, ClaudeBot, Google-Extended e mais de 20 outros crawlers de IA com user agents, taxa...

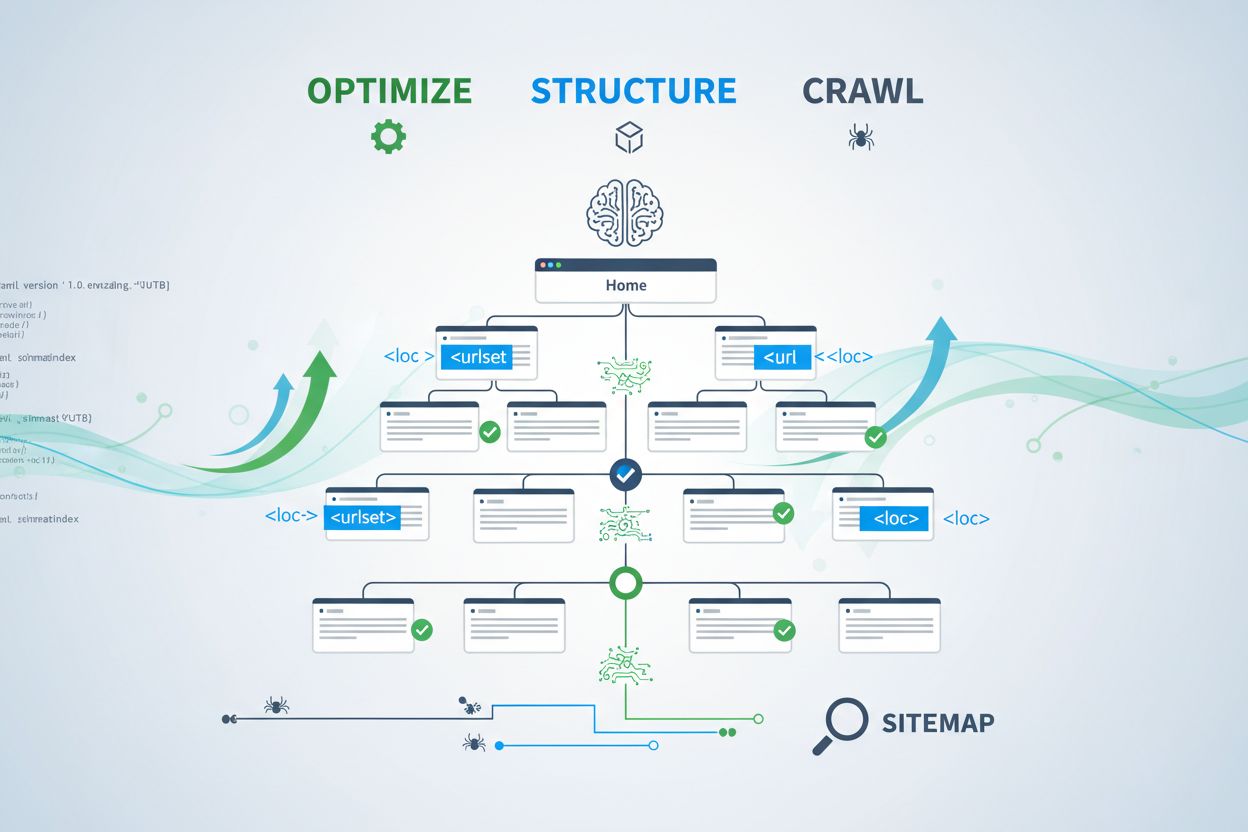

Aprenda como otimizar sitemaps XML para crawlers de IA como GPTBot e ClaudeBot. Domine as melhores práticas de sitemap para aumentar a visibilidade em respostas AI e indexação por LLMs.

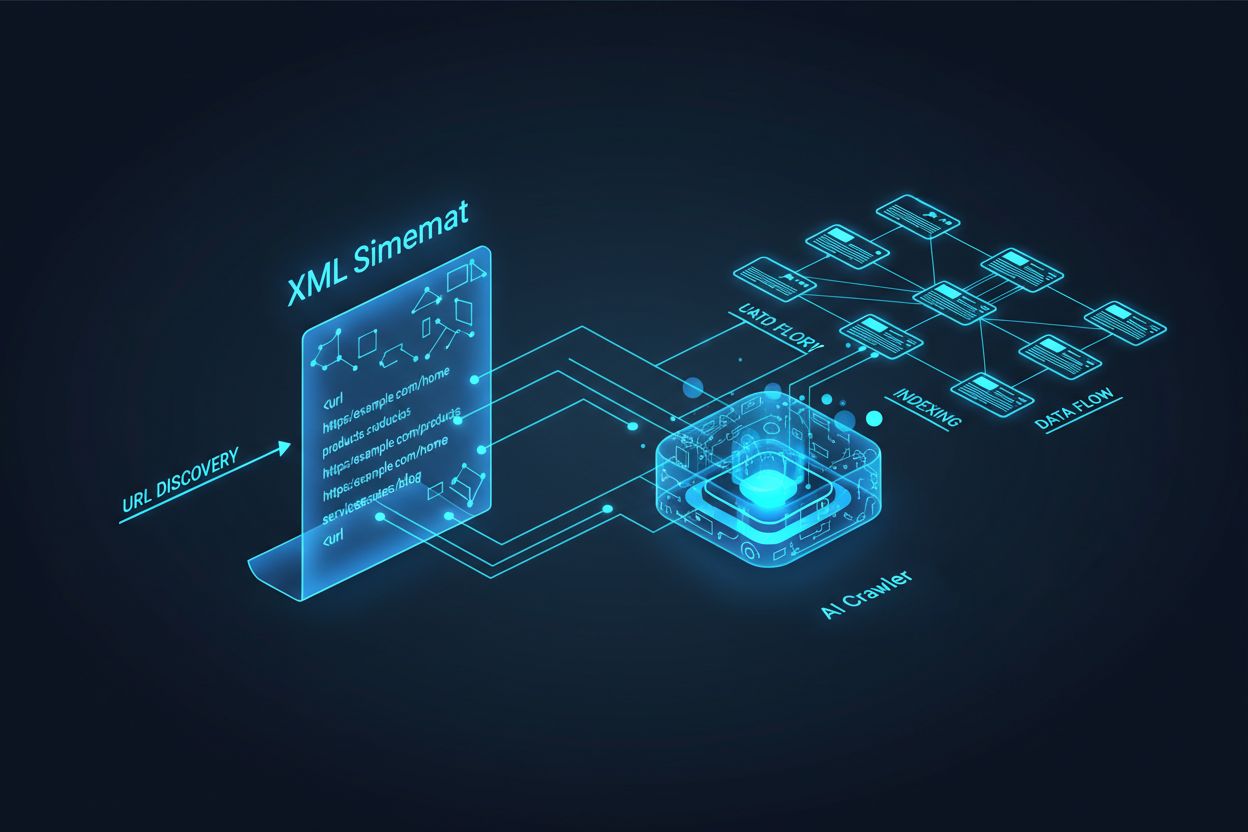

Crawlers de IA como GPTBot, ClaudeBot e PerplexityBot operam de maneira fundamentalmente diferente dos bots tradicionais de motores de busca. Enquanto o Googlebot indexa páginas para ranqueamento em resultados de busca, crawlers de IA extraem conhecimento para treinar e alimentar grandes modelos de linguagem que impulsionam buscas conversacionais e respostas geradas por IA. Sem um sitemap XML devidamente otimizado, seu conteúdo permanece invisível para esses sistemas críticos, independentemente de quão bem escrito ou autoritativo seja. Pense no seu sitemap como um mapa rodoviário que diz exatamente aos sistemas de IA onde está seu conteúdo mais valioso e como ele está organizado.

A distinção entre crawlers de busca tradicionais e crawlers de IA é crucial para entender por que a otimização de sitemap é mais importante do que nunca. Motores de busca tradicionais como o Google focam em ranquear páginas individuais para palavras-chave específicas, enquanto crawlers de IA priorizam a captura de conhecimento e entendimento semântico. Veja como eles diferem:

| Aspecto | Crawlers Tradicionais (Googlebot) | Crawlers de IA (GPTBot, ClaudeBot) |

|---|---|---|

| Propósito Principal | Ranquear páginas nos resultados de busca | Extrair conhecimento para treinamento de LLM e respostas em tempo real |

| Foco | Metadados, links internos, sinais de ranqueamento | Estrutura do conteúdo, significado semântico, densidade de fatos |

| Prioridade de Rastreamento | Baseada em PageRank e recência | Baseada em autoridade, relevância temática e valor do conhecimento |

| Impacto de Citação | Gera tráfego por meio de links azuis | Determina se seu conteúdo aparece em respostas geradas por IA |

| Manipulação de JavaScript | Executa e renderiza JavaScript | Frequentemente ignora JavaScript; prioriza HTML renderizado no servidor |

Essa diferença fundamental significa que otimizar apenas para SEO tradicional já não é suficiente. Seu sitemap agora deve servir a dois propósitos: ajudar motores de busca tradicionais a entenderem a estrutura do seu site e, simultaneamente, guiar sistemas de IA para seus ativos de conhecimento mais valiosos.

Um sitemap XML funciona como o projeto do seu site, dizendo explicitamente aos crawlers quais páginas existem e como elas se relacionam com sua estratégia de conteúdo. Para sistemas de IA, os sitemaps cumprem uma função ainda mais crítica do que para a busca tradicional. Crawlers de IA usam sitemaps para entender a arquitetura temática do seu site, identificar conteúdo de alta prioridade e determinar quais páginas merecem análise mais profunda. Quando seu sitemap é abrangente e bem organizado, os sistemas de IA conseguem descobrir e avaliar seu conteúdo de forma mais eficiente para inclusão em respostas generativas. Por outro lado, um sitemap incompleto ou desatualizado cria pontos cegos que impedem os sistemas de IA de encontrar suas páginas mais importantes. O impacto é direto: páginas fora do sitemap têm chances significativamente menores de serem citadas por sistemas de IA, independentemente da qualidade ou relevância.

Criar um sitemap eficaz para crawlers de IA requer mais do que simplesmente listar todas as URLs do seu site. Seu sitemap deve ser estrategicamente curado para incluir apenas páginas que agreguem valor real para usuários e sistemas de IA. Aqui estão as principais melhores práticas:

Um sitemap bem estruturado funciona como um filtro de qualidade, mostrando aos sistemas de IA que seu conteúdo foi cuidadosamente selecionado e que cada URL merece atenção. Essa abordagem estratégica aumenta significativamente suas chances de ser citado em respostas geradas por IA.

A recência é um dos fatores de ranqueamento mais fortes em sistemas de busca movidos por IA. Quando crawlers de IA avaliam quais fontes citar em respostas geradas, eles valorizam muito o frescor do conteúdo. O timestamp lastmod em seu sitemap XML é o principal sinal que informa aos sistemas de IA quando seu conteúdo foi atualizado pela última vez. Timestamps desatualizados ou ausentes podem fazer até mesmo conteúdos autoritativos perderem prioridade para fontes mais recentes. Se seu sitemap mostra que uma página não é atualizada há anos, sistemas de IA podem assumir que a informação está obsoleta e escolher o conteúdo do concorrente. Por outro lado, timestamps lastmod precisos que refletem atualizações reais sinalizam aos crawlers de IA que sua informação é atual e confiável. Para temas sensíveis ao tempo como preços, regulamentações ou tendências do setor, manter timestamps precisos é ainda mais crítico. Atualizações automáticas de timestamps via CMS garantem que toda alteração de conteúdo seja imediatamente refletida no seu sitemap, maximizando sua visibilidade em respostas geradas por IA.

Enquanto sitemaps convidam crawlers a indexar seu conteúdo, arquivos robots.txt controlam quais partes do site os crawlers podem acessar. Esses dois arquivos devem trabalhar em harmonia para maximizar sua visibilidade em IA. Um erro comum é criar um sitemap abrangente e ao mesmo tempo bloquear crawlers de IA no arquivo robots.txt, criando uma contradição que confunde os crawlers e reduz sua visibilidade. Seu robots.txt deve permitir explicitamente crawlers de IA importantes como GPTBot, ClaudeBot e PerplexityBot a acessar seu conteúdo. Você pode usar o robots.txt estrategicamente para bloquear apenas páginas que não devem ser indexadas, como painéis de administração, páginas de login ou versões duplicadas de conteúdo. O ponto-chave é garantir que as regras do robots.txt estejam alinhadas com sua estratégia de sitemap — se uma página está no sitemap, ela deve ser acessível segundo o robots.txt. Auditorias regulares dos dois arquivos ajudam a identificar configurações erradas que podem limitar silenciosamente sua visibilidade em IA.

As estratégias de otimização de IA mais eficazes tratam sitemaps e dados estruturados como sistemas complementares que se reforçam. Quando seu sitemap destaca uma página como importante e essa página inclui schema markup relevante, você envia sinais consistentes aos crawlers de IA sobre o propósito e valor da página. Por exemplo, se seu sitemap prioriza um guia passo-a-passo, essa página deve incluir a marcação HowTo schema, fornecendo informações estruturadas sobre os passos. Da mesma forma, páginas de produtos no seu sitemap devem incluir Product schema com preço, disponibilidade e informações de avaliações. Esse alinhamento cria um quadro de dados coerente que sistemas de IA podem interpretar e confiar facilmente. Quando sitemaps e dados estruturados entram em conflito ou divergem, crawlers de IA ficam incertos sobre o real propósito da página, reduzindo a probabilidade de citação. Ao garantir que sua estratégia de sitemap esteja alinhada com sua implementação de schema, você cria um sinal unificado que aumenta dramaticamente suas chances de ser incluído em respostas geradas por IA.

Diferentes tipos de conteúdo exigem estratégias de sitemap distintas para maximizar a visibilidade em IA. Posts de blog, páginas de produtos, descrições de serviços e conteúdos de FAQ cumprem papéis diferentes e devem ser otimizados de acordo:

| Tipo de Conteúdo | Estratégia de Sitemap | Schema Markup Recomendado | Considerações de Prioridade |

|---|---|---|---|

| Posts de Blog & Artigos | Incluir com datas precisas de publicação e atualização | Article, NewsArticle, BlogPosting | Priorizar conteúdo recente e evergreen; atualizar lastmod regularmente |

| Páginas de Produto | Incluir com atualizações de estoque; considerar sitemap separado de produtos | Product, Offer, AggregateRating | Destacar mais vendidos e novos produtos; atualizar preços com frequência |

| Páginas de Serviço | Incluir com datas de atualização dos serviços | Service, LocalBusiness, ProfessionalService | Priorizar serviços principais; atualizar disponibilidade e preços |

| Páginas de FAQ | Incluir com datas de atualização do conteúdo | FAQPage, Question, Answer | Priorizar FAQs abrangentes; atualizar respostas quando a informação mudar |

| Conteúdo em Vídeo | Incluir em sitemap de vídeo com thumbnail e duração | VideoObject, Video | Incluir transcrições; atualizar contagens de visualização e engajamento |

| Conteúdo em Imagem | Incluir em sitemap de imagem com legendas | ImageObject, Product (para imagens de produto) | Otimizar alt text; incluir legendas descritivas |

Essa abordagem diferenciada garante que cada tipo de conteúdo receba a otimização adequada para descoberta por IA. Ao adaptar sua estratégia de sitemap à sua combinação de conteúdo, você maximiza as chances de os sistemas de IA encontrarem e citarem seus ativos mais valiosos.

O padrão llms.txt, proposto no final de 2024, representa uma abordagem experimental para ajudar sistemas de IA a entender a estrutura de sites. Diferente do sitemap XML, o llms.txt é um arquivo em Markdown que fornece um índice legível por humanos do seu site. Ele lista suas páginas e recursos mais importantes em um formato mais fácil de ser interpretado por modelos de linguagem. Embora o conceito seja promissor, evidências atuais sugerem que llms.txt tem impacto mínimo na visibilidade em IA comparado ao sitemap XML tradicional. Crawlers de IA importantes como GPTBot e ClaudeBot continuam a depender principalmente de sitemaps XML para descoberta de URLs e sinais de recência. Em vez de substituir seu sitemap XML, o llms.txt deve ser visto como uma ferramenta suplementar que pode fornecer contexto adicional aos sistemas de IA. Se decidir implementar o llms.txt, certifique-se de que ele complemente, e não substitua, sua estratégia principal de sitemap, e foque primeiro em aperfeiçoar seu sitemap XML com timestamps precisos e curadoria estratégica de conteúdo.

Mesmo sites bem intencionados frequentemente cometem erros críticos em sitemaps que limitam silenciosamente sua visibilidade em IA. Entender e evitar esses erros é essencial para maximizar sua presença em respostas geradas por IA:

Corrigir esses erros comuns pode melhorar imediatamente sua visibilidade em IA. Comece auditando seu sitemap atual com base nesta lista e corrigindo os problemas identificados.

Manter um sitemap otimizado requer monitoramento e validação contínuos. Diversas ferramentas podem ajudar a garantir que seu sitemap permaneça eficaz para crawlers de IA. O Google Search Console fornece validação embutida de sitemap e mostra quantas URLs o Google indexou a partir do seu sitemap. O Screaming Frog SEO Spider permite rastrear todo o seu site e comparar os resultados com o sitemap, identificando URLs ausentes ou quebradas. Validadores de sitemap XML verificam a sintaxe do seu sitemap e garantem conformidade com o protocolo XML sitemap. Para grandes empresas, plataformas dedicadas como Semrush e Ahrefs incluem recursos de análise de sitemap que acompanham mudanças ao longo do tempo. Auditorias regulares — de preferência mensais — ajudam a identificar problemas antes que afetem sua visibilidade em IA. Programe lembretes para revisar seu sitemap sempre que fizer mudanças significativas no conteúdo, lançar novas seções ou atualizar a arquitetura do site.

Entender como crawlers de IA interagem com seu sitemap requer monitoramento e análise ativa. Os logs do seu servidor contêm dados valiosos sobre quais crawlers de IA visitam seu site, com que frequência rastreiam e quais páginas priorizam. Ao analisar esses logs, você pode identificar padrões e otimizar seu sitemap de acordo. Ferramentas como AmICited.com ajudam a monitorar com que frequência seu conteúdo é citado por sistemas de IA como ChatGPT, Claude, Perplexity e os AI Overviews do Google, fornecendo feedback direto sobre a eficácia do seu sitemap. O Google Analytics pode ser configurado para rastrear tráfego de referência proveniente de sistemas de IA, mostrando quais páginas geram mais visibilidade impulsionada por IA. Ao correlacionar esses dados com a estrutura do seu sitemap, é possível identificar quais tipos de conteúdo e tópicos mais ressoam com os sistemas de IA. Essa abordagem orientada por dados permite refinar continuamente sua estratégia de sitemap, priorizando conteúdo que gera mais citações e visibilidade em IA.

Além da otimização básica, estratégias avançadas podem melhorar significativamente sua visibilidade em IA. Criar sitemaps separados para diferentes tipos de conteúdo — como sitemaps dedicados para blogs, produtos e vídeos — permite aplicar estratégias de otimização específicas. A geração dinâmica de sitemap, onde seu sitemap é atualizado em tempo real conforme o conteúdo muda, garante que crawlers de IA sempre vejam seu conteúdo mais atual. Para grandes sites empresariais com milhares de páginas, implementar hierarquias de sitemap e priorização estratégica ajuda crawlers de IA a focarem no conteúdo mais valioso. Algumas organizações criam sitemaps específicos para IA que destacam apenas seu conteúdo de maior autoridade e mais digno de citação, sinalizando aos sistemas de IA quais páginas merecem atenção prioritária. Integrar sua estratégia de sitemap ao seu sistema de gerenciamento de conteúdo garante que a otimização aconteça automaticamente, sem necessidade de atualizações manuais. Essas abordagens avançadas exigem mais sofisticação técnica, mas podem trazer melhorias significativas na visibilidade em IA para organizações com ecossistemas de conteúdo complexos.

O cenário dos crawlers de IA continua evoluindo rapidamente, com novos crawlers surgindo regularmente e padrões como llms.txt ganhando adoção. Tornar sua estratégia de sitemap à prova do futuro significa construir flexibilidade em seus sistemas e manter-se informado sobre desenvolvimentos do setor. Implemente sistemas de geração de sitemap que possam acomodar novos requisitos de crawlers sem reconfiguração manual. Monitore anúncios de grandes empresas de IA sobre novos crawlers e atualize suas estratégias de robots.txt e sitemap conforme necessário. Considere o valor a longo prazo da visibilidade em IA versus controle de conteúdo — enquanto algumas organizações optam por bloquear crawlers de IA, a tendência sugere que citações por IA se tornarão cada vez mais importantes para a visibilidade da marca. Desenvolva políticas claras de como sua organização gerenciará o acesso de crawlers de IA e o uso do conteúdo. Ao tratar seu sitemap como um documento vivo que evolui junto com o cenário de IA, você garante que seu conteúdo continue sendo descoberto e citado à medida que mecanismos de busca e descoberta continuam a se transformar.

Você deve atualizar seu sitemap sempre que publicar novo conteúdo ou fizer mudanças significativas em páginas existentes. O ideal é implementar uma geração automática de sitemap para que as atualizações ocorram imediatamente. Para sites com alterações frequentes, recomenda-se atualização diária. Para sites estáticos, revisões mensais são suficientes.

A maioria dos principais crawlers de IA como GPTBot e ClaudeBot respeita as diretivas do robots.txt, mas nem todos. A melhor prática é permitir explicitamente os crawlers de IA no seu arquivo robots.txt em vez de confiar no comportamento padrão. Monitore os logs do servidor para verificar se os crawlers estão agindo conforme o esperado.

Sitemaps XML são arquivos legíveis por máquina que listam todas as suas URLs com metadados como timestamps lastmod. O llms.txt é um padrão mais recente baseado em Markdown projetado para fornecer aos sistemas de IA um índice legível por humanos. Os sitemaps XML são atualmente mais importantes para visibilidade em IA, enquanto o llms.txt deve ser visto como suplementar.

Verifique os logs do seu servidor por user agents como 'GPTBot', 'ClaudeBot', 'PerplexityBot' e 'Google-Extended'. Você também pode usar ferramentas como AmICited.com para monitorar com que frequência seu conteúdo é citado por sistemas de IA, o que indica rastreamento e indexação bem-sucedidos.

Sim, criar sitemaps separados para blogs, produtos, vídeos e imagens permite aplicar estratégias de otimização específicas para cada tipo. Isso também ajuda os crawlers de IA a entender melhor a estrutura do seu conteúdo e pode melhorar a eficiência de rastreamento em sites grandes.

Sitemaps XML devem conter no máximo 50.000 URLs por arquivo. Para sites maiores, use índices de sitemap para organizar vários arquivos. Crawlers de IA conseguem lidar com grandes sitemaps, mas dividi-los em seções lógicas melhora a eficiência de rastreamento e facilita o gerenciamento.

Timestamps lastmod sinalizam atualização do conteúdo para crawlers de IA. Recência é um forte fator de ranqueamento em sistemas de IA, então timestamps precisos ajudam seu conteúdo a competir por citações. Sempre use sistemas automáticos para atualizar timestamps apenas quando o conteúdo realmente mudar — nunca defina timestamps falsos manualmente.

Sim, um sitemap mal mantido pode prejudicar significativamente sua visibilidade em IA. Links quebrados, URLs desatualizadas, timestamps imprecisos e cobertura incompleta reduzem suas chances de ser citado por sistemas de IA. Auditorias e manutenção regulares são essenciais para proteger sua visibilidade em IA.

Acompanhe com que frequência seu conteúdo é citado pelo ChatGPT, Claude, Perplexity e Google AI Overviews. Otimize sua estratégia de sitemap com base em dados reais de citações por IA.

Guia completo de referência sobre crawlers e bots de IA. Identifique GPTBot, ClaudeBot, Google-Extended e mais de 20 outros crawlers de IA com user agents, taxa...

Saiba quais crawlers de IA permitir ou bloquear no seu robots.txt. Guia abrangente cobrindo GPTBot, ClaudeBot, PerplexityBot e mais de 25 crawlers de IA com exe...

Aprenda como identificar e monitorar crawlers de IA como GPTBot, PerplexityBot e ClaudeBot em seus logs de servidor. Descubra strings de user-agent, métodos de ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.