Prerrenderização para Crawlers de IA: Tornando Conteúdo em JavaScript Acessível

Aprenda como a prerrenderização torna o conteúdo em JavaScript visível para crawlers de IA como ChatGPT, Claude e Perplexity. Descubra as melhores soluções técn...

Descubra como as estratégias de renderização SSR e CSR afetam a visibilidade para crawlers de IA, citações de marca no ChatGPT e Perplexity, e sua presença geral em buscas por IA.

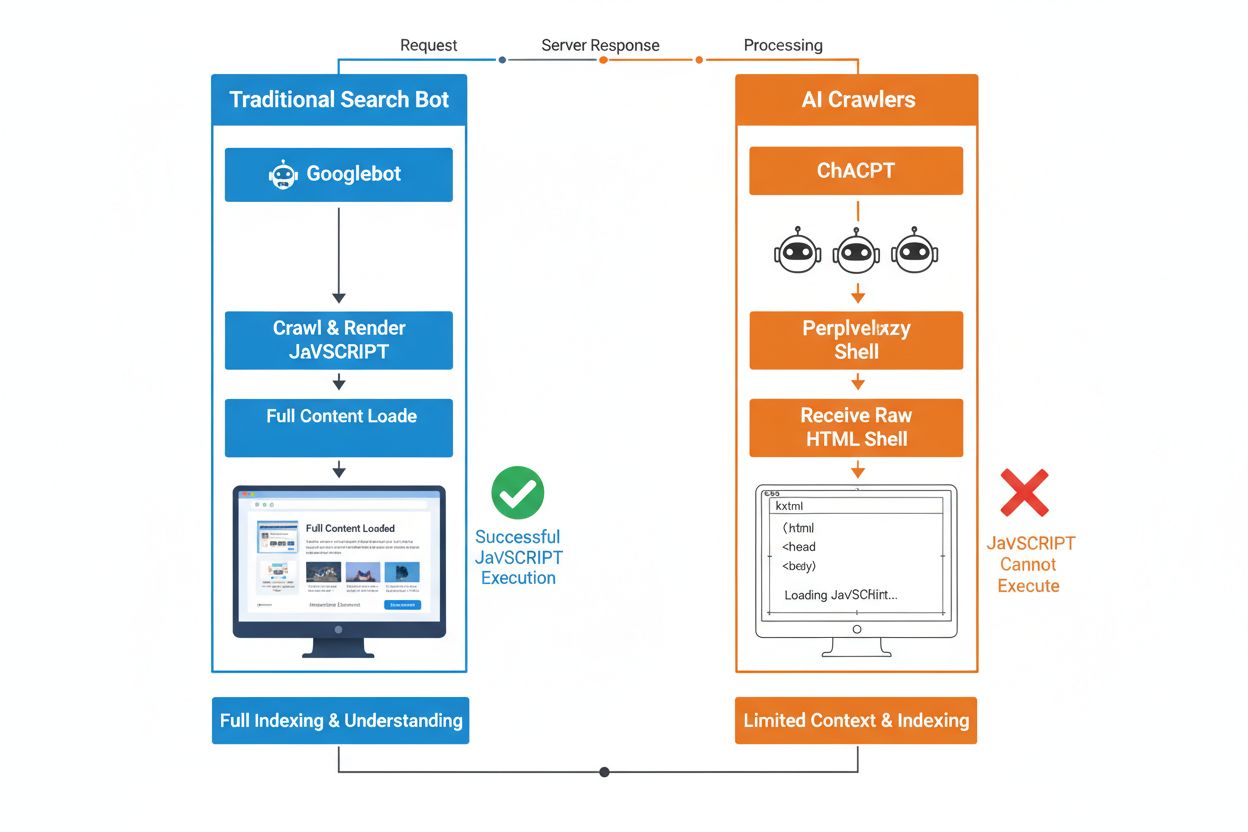

A diferença fundamental entre bots de busca tradicionais e crawlers de IA está na abordagem à execução de JavaScript. Enquanto Googlebot e outros motores de busca tradicionais conseguem renderizar JavaScript (ainda que com restrições de recursos), crawlers de IA como GPTBot, ChatGPT-User e OAI-SearchBot não executam JavaScript de forma alguma—eles veem apenas o HTML bruto entregue no carregamento inicial da página. Essa distinção crítica significa que, se o conteúdo do seu site depende de JavaScript do lado do cliente para ser renderizado, os sistemas de IA receberão um snapshot incompleto ou em branco de suas páginas, sem detalhes de produtos, informações de preços, avaliações e outros conteúdos dinâmicos que os usuários veem em seus navegadores. Entender essa lacuna é essencial porque resultados de busca impulsionados por IA estão rapidamente se tornando o principal canal de descoberta para quem busca informações.

A Renderização do Lado do Servidor (SSR) melhora fundamentalmente a visibilidade em IA ao entregar HTML totalmente renderizado diretamente do servidor na requisição inicial, eliminando a necessidade de crawlers de IA executarem JavaScript. Com SSR, todo o conteúdo crítico—títulos, corpo do texto, informações de produto, metadados e dados estruturados—está presente no HTML que os bots recebem, tornando-se imediatamente acessível para ingestão em corpora de treinamento de IA e índices de busca. Essa abordagem garante entrega consistente de conteúdo para todos os crawlers, velocidades de indexação mais rápidas e total visibilidade de metadados, dos quais os sistemas de IA dependem para entender e citar corretamente seu conteúdo. A tabela a seguir ilustra como diferentes estratégias de renderização impactam a visibilidade para crawlers de IA:

| Tipo de Renderização | O que Crawlers de IA Veem | Velocidade de Indexação | Completude do Conteúdo | Visibilidade de Metadados |

|---|---|---|---|---|

| Renderização do Lado do Servidor (SSR) | HTML totalmente renderizado com todo o conteúdo | Rápido (imediato) | Completo | Excelente |

| Renderização do Lado do Cliente (CSR) | Shell HTML mínimo, sem conteúdo dinâmico | Lento (se renderizado) | Incompleto | Ruim |

| Geração de Site Estático (SSG) | HTML pré-gerado e em cache | Muito rápido | Completo | Excelente |

| Híbrido/Incremental | Mistura de rotas estáticas e dinâmicas | Moderado a rápido | Bom (se páginas críticas pré-renderizadas) | Bom |

A Renderização do Lado do Cliente (CSR) apresenta desafios significativos para a visibilidade em IA porque obriga os crawlers a esperar pela execução de JavaScript—algo que bots de IA simplesmente não fazem devido a restrições de recursos e tempos limites curtos. Quando um site baseado em CSR carrega, a resposta HTML inicial contém apenas um shell mínimo com spinners de carregamento e elementos placeholders, enquanto o conteúdo real é carregado de forma assíncrona via JavaScript. Crawlers de IA impõem tempos limites rigorosos de 1-5 segundos e não executam scripts, o que significa que capturam um snapshot vazio ou quase vazio da página, sem descrições de produtos, preços, avaliações e outras informações críticas. Isso gera um problema em cascata: snapshots de conteúdo incompletos levam a chunking e embeddings de baixa qualidade, reduzindo a chance de suas páginas serem selecionadas para inclusão em respostas geradas por IA. Para e-commerces, plataformas SaaS e aplicações com muito conteúdo que dependem de CSR, isso se traduz diretamente em perda de visibilidade em AI Overviews, respostas do ChatGPT e respostas do Perplexity—os principais canais de descoberta na era da IA.

O motivo técnico pelo qual bots de IA não executam JavaScript decorre de restrições fundamentais de escalabilidade e recursos inerentes à sua arquitetura. Crawlers de IA priorizam velocidade e eficiência em vez de completude, operando sob tempos limites rigorosos porque precisam processar bilhões de páginas para treinar e atualizar modelos de linguagem. Executar JavaScript requer iniciar navegadores headless, alocar memória e aguardar operações assíncronas—luxos que não escalam quando é preciso rastrear no volume necessário ao treinamento de LLM. Assim, sistemas de IA focam em extrair HTML limpo e semanticamente estruturado que está imediatamente disponível, tratando conteúdo estático como a versão canônica do seu site. Essa escolha de design reflete uma verdade fundamental: sistemas de IA são otimizados para entrega de HTML estático, não para renderizar frameworks complexos de JavaScript como React, Vue ou Angular.

O impacto em respostas geradas por IA e na visibilidade da marca é profundo e afeta diretamente os resultados do seu negócio. Quando crawlers de IA não conseguem acessar seu conteúdo devido à renderização JavaScript, sua marca se torna invisível em AI Overviews, ausente em citações e fora dos resultados de busca alimentados por LLM—mesmo que você tenha bom ranqueamento no Google tradicional. Para e-commerces, isso significa que detalhes de produtos, preços e disponibilidade nunca chegam aos sistemas de IA, resultando em recomendações de produtos incompletas ou imprecisas e perda de oportunidades de vendas. Empresas SaaS perdem visibilidade em comparativos de funcionalidades e páginas de preços que poderiam gerar leads qualificados via ferramentas de pesquisa baseadas em IA. Sites de notícias e conteúdo veem seus artigos excluídos de resumos de IA, reduzindo o tráfego de referência de plataformas como ChatGPT e Perplexity. A diferença entre o que humanos veem e o que sistemas de IA veem cria um problema de visibilidade em dois níveis: seu site pode parecer saudável em métricas de SEO tradicionais, mas ao mesmo tempo estar invisível para o canal de descoberta que mais cresce.

Pré-renderização e soluções híbridas oferecem maneiras práticas de combinar os benefícios de ambas as abordagens de renderização sem exigir uma reformulação completa da arquitetura. Em vez de escolher entre a interatividade do CSR e a rastreabilidade do SSR, equipes modernas implementam combinações estratégicas com propósitos distintos:

Essas abordagens permitem manter experiências ricas e interativas para usuários, assegurando ao mesmo tempo que crawlers de IA recebam HTML completo e totalmente renderizado. Frameworks como Next.js, Nuxt e SvelteKit tornam a renderização híbrida acessível sem necessidade de grande desenvolvimento customizado. O segredo é identificar quais páginas geram aquisição, receita ou redução de suporte—essas páginas críticas devem sempre ser pré-renderizadas ou renderizadas no servidor para garantir visibilidade em IA.

A estratégia de renderização afeta diretamente como sistemas de IA referenciam e citam sua marca, tornando essencial monitorar sua visibilidade nas plataformas de IA. Ferramentas como AmICited.com acompanham como sistemas de IA citam sua marca no ChatGPT, Perplexity, Google AI Overviews e outras plataformas baseadas em LLM, revelando se seu conteúdo realmente está chegando a esses sistemas. Quando seu site usa CSR sem pré-renderização, os dados do AmICited frequentemente mostram uma diferença gritante: você pode ranquear bem na busca tradicional, mas receber zero citações em respostas geradas por IA. Esse monitoramento revela o verdadeiro custo das escolhas de renderização em JavaScript—não apenas em eficiência de rastreamento, mas em perda de visibilidade de marca e oportunidades de citação. Ao implementar SSR ou pré-renderização e depois acompanhar os resultados via AmICited, você pode quantificar o impacto direto das decisões de renderização na visibilidade em IA, facilitando a justificativa do investimento em engenharia para partes interessadas focadas em tráfego e conversões.

Auditar e otimizar sua estratégia de renderização para visibilidade em IA exige uma abordagem sistemática, passo a passo. Comece identificando quais páginas geram mais valor: páginas de produtos, preços, documentação principal e posts de blog com alto tráfego devem ser prioridade. Use ferramentas como Screaming Frog (em modo “Texto Apenas”) ou Chrome DevTools para comparar o que bots veem versus o que usuários veem—se conteúdo crítico estiver ausente no código-fonte da página, ele depende de JavaScript e está invisível para crawlers de IA. Em seguida, escolha a estratégia de renderização de acordo com a necessidade de atualização do conteúdo: páginas estáticas podem usar SSG, conteúdos frequentemente atualizados se beneficiam de SSR ou ISR, e funcionalidades interativas podem ser adicionadas com JavaScript sobre HTML renderizado no servidor. Depois, teste com bots de IA reais enviando suas páginas para ChatGPT, Perplexity e Claude para verificar se conseguem acessar seu conteúdo. Por fim, monitore os logs de rastreamento em busca de user-agents de IA (GPTBot, ChatGPT-User, OAI-SearchBot) para confirmar que esses bots estão rastreando com sucesso suas páginas pré-renderizadas ou renderizadas no servidor. Essa abordagem iterativa transforma a renderização de um detalhe técnico em uma alavanca mensurável de visibilidade.

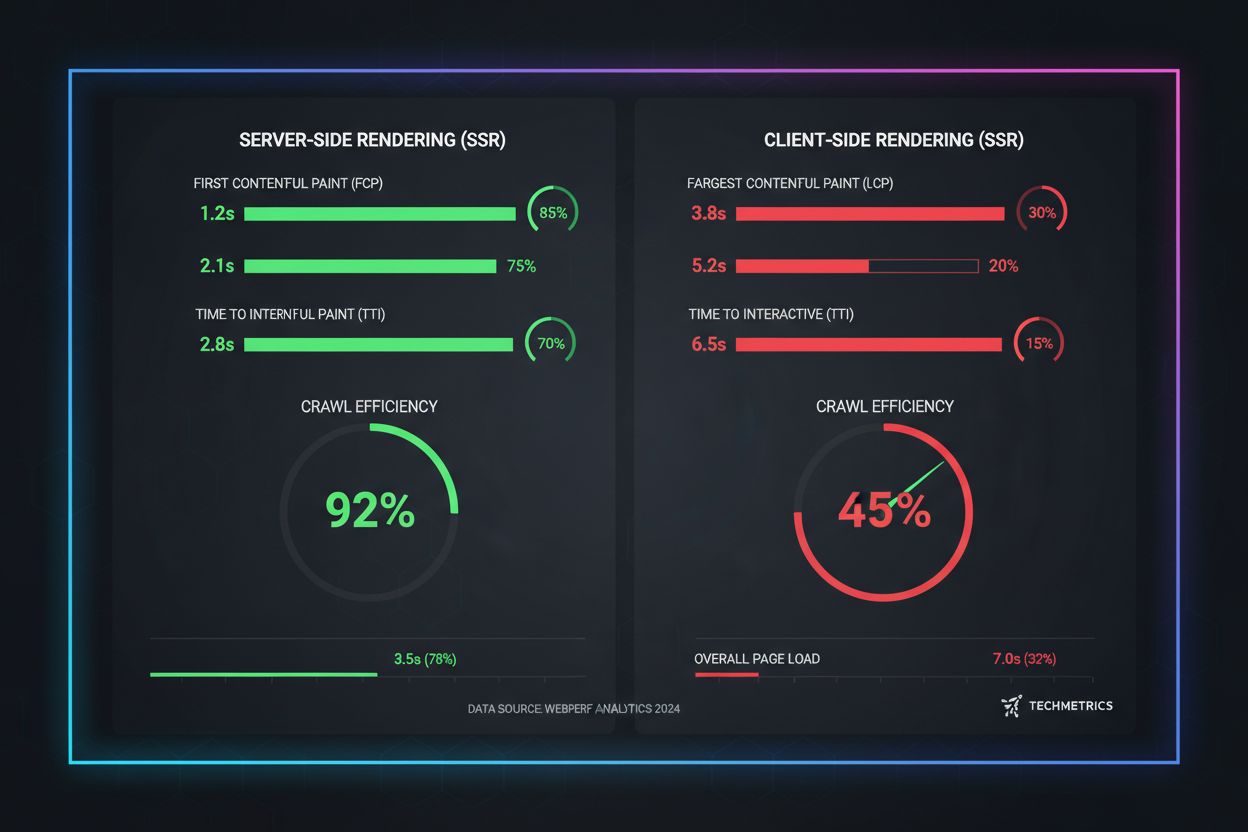

Métricas reais de desempenho revelam as diferenças dramáticas entre as abordagens de renderização quando o assunto é rastreabilidade por IA. Páginas SSR e pré-renderizadas atingem First Contentful Paint (FCP) em 0,5-1,5 segundos, enquanto sites CSR frequentemente exigem 2-4 segundos ou mais para download e execução do JavaScript. Para crawlers de IA operando com tempos limites de 1-5 segundos, essa diferença significa a diferença entre visibilidade total e invisibilidade completa. A eficiência do rastreamento melhora drasticamente com SSR: um e-commerce pré-renderizado pode ser totalmente rastreado e indexado em horas, enquanto um equivalente CSR pode levar semanas, já que os crawlers lutam com o overhead da renderização JavaScript. As melhorias na velocidade de indexação são igualmente significativas—sites SSR veem novo conteúdo indexado em 24-48 horas, enquanto sites CSR frequentemente enfrentam atrasos de 7-14 dias. Para conteúdo sensível ao tempo como notícias, lançamentos de produtos ou ofertas por tempo limitado, esse atraso resulta diretamente em perda de visibilidade durante o período crítico de busca ativa dos usuários.

O futuro do SEO é inseparável da visibilidade em buscas por IA, tornando a estratégia de renderização um investimento crítico de longo prazo em vez de um detalhe técnico. A busca impulsionada por IA cresce exponencialmente—13,14% de todos os resultados do Google já ativam AI Overviews, e plataformas como ChatGPT recebem mais de quatro bilhões de visitas mensais, com Perplexity e Claude ganhando adoção rapidamente. À medida que sistemas de IA se tornam o principal canal de descoberta para cada vez mais usuários, as decisões de renderização que você toma hoje determinarão sua visibilidade amanhã. O monitoramento contínuo é essencial porque o comportamento dos crawlers de IA, limites de tempo e suporte a JavaScript evoluem à medida que esses sistemas amadurecem. Equipes que tratam a renderização como uma migração pontual costumam ficar invisíveis novamente em poucos meses, conforme as plataformas de IA mudam suas estratégias de rastreamento. Em vez disso, inclua a otimização de renderização no seu ciclo trimestral de planejamento, realize verificações de visibilidade em IA em seus testes de regressão e utilize ferramentas como o AmICited para acompanhar se sua marca mantém visibilidade à medida que o cenário de IA muda. As marcas que vencem na busca por IA são aquelas que tratam a estratégia de renderização como uma vantagem competitiva central, não uma dívida técnica a ser resolvida depois.

Crawlers de IA como GPTBot e ChatGPT-User operam sob restrições rígidas de recursos e tempos limites curtos (1-5 segundos), pois precisam processar bilhões de páginas para treinar modelos de linguagem. Executar JavaScript exige iniciar navegadores headless e aguardar operações assíncronas—luxos que não escalam no volume necessário para o treinamento de LLM. Em vez disso, os sistemas de IA focam em extrair HTML limpo e estático que está disponível imediatamente.

A Renderização do Lado do Servidor entrega HTML totalmente renderizado na requisição inicial, tornando todo o conteúdo imediatamente acessível para crawlers de IA sem execução de JavaScript. Isso garante que detalhes do seu produto, preços, avaliações e metadados cheguem de forma confiável aos sistemas de IA, aumentando as chances de sua marca ser citada em respostas geradas por IA e aparecer em AI Overviews.

A Renderização do Lado do Servidor (SSR) renderiza as páginas sob demanda quando uma requisição chega, enquanto a pré-renderização gera arquivos HTML estáticos no momento do build. A pré-renderização funciona melhor para conteúdo que não muda com frequência, enquanto o SSR é mais adequado para conteúdo dinâmico que é atualizado regularmente. Ambas as abordagens garantem que crawlers de IA recebam HTML completo sem execução de JavaScript.

Sim, mas com limitações significativas. Você pode usar ferramentas de pré-renderização para gerar snapshots HTML estáticos das suas páginas CSR, ou implementar renderização híbrida onde páginas críticas são renderizadas no servidor enquanto páginas menos importantes permanecem no cliente. No entanto, sem essas otimizações, sites CSR são em grande parte invisíveis para crawlers de IA.

Use ferramentas como Screaming Frog (modo Texto Apenas), Chrome DevTools ou Google Search Console para comparar o que os bots veem versus o que os usuários veem. Se conteúdo crítico estiver ausente no código fonte da página, ele depende de JavaScript e está invisível para crawlers de IA. Você também pode testar diretamente com ChatGPT, Perplexity e Claude para verificar se conseguem acessar seu conteúdo.

Páginas SSR e pré-renderizadas normalmente atingem First Contentful Paint (FCP) em 0,5-1,5 segundos, enquanto sites CSR frequentemente exigem 2-4+ segundos. Como crawlers de IA operam com tempos limites de 1-5 segundos, renderização mais rápida se traduz diretamente em melhor rastreabilidade por IA. A melhora nos Core Web Vitals também beneficia a experiência do usuário e o ranqueamento tradicional de SEO.

O AmICited monitora como sistemas de IA citam sua marca no ChatGPT, Perplexity e Google AI Overviews. Ao acompanhar sua visibilidade em IA antes e depois de implementar SSR ou pré-renderização, você pode quantificar o impacto direto das decisões de renderização nas citações da marca e presença em buscas por IA.

Depende dos requisitos de atualização do seu conteúdo e das prioridades do negócio. Conteúdo estático se beneficia de SSG, conteúdo frequentemente atualizado de SSR, e funcionalidades interativas podem usar JavaScript sobre HTML renderizado no servidor. Comece identificando páginas de alto valor (produtos, preços, documentação) e priorize essas para SSR ou pré-renderização primeiro.

Monitore como ChatGPT, Perplexity e Google AI Overviews referenciam sua marca. Entenda o real impacto da sua estratégia de renderização nas citações de IA.

Aprenda como a prerrenderização torna o conteúdo em JavaScript visível para crawlers de IA como ChatGPT, Claude e Perplexity. Descubra as melhores soluções técn...

Guia completo de referência sobre crawlers e bots de IA. Identifique GPTBot, ClaudeBot, Google-Extended e mais de 20 outros crawlers de IA com user agents, taxa...

Aprenda como testar se crawlers de IA como ChatGPT, Claude e Perplexity conseguem acessar o conteúdo do seu site. Descubra métodos de teste, ferramentas e as me...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.