Janela de Contexto

Explicação da janela de contexto: o máximo de tokens que um LLM pode processar de uma vez. Saiba como as janelas de contexto afetam a precisão da IA, alucinaçõe...

A delimitação contextual é uma técnica de otimização de conteúdo que estabelece limites claros ao redor das informações para evitar interpretações errôneas e alucinações por parte da IA. Ela utiliza delimitadores explícitos e marcadores de contexto para garantir que os modelos de IA entendam exatamente onde a informação relevante começa e termina, impedindo a geração de respostas baseadas em suposições ou detalhes fabricados.

A delimitação contextual é uma técnica de otimização de conteúdo que estabelece limites claros ao redor das informações para evitar interpretações errôneas e alucinações por parte da IA. Ela utiliza delimitadores explícitos e marcadores de contexto para garantir que os modelos de IA entendam exatamente onde a informação relevante começa e termina, impedindo a geração de respostas baseadas em suposições ou detalhes fabricados.

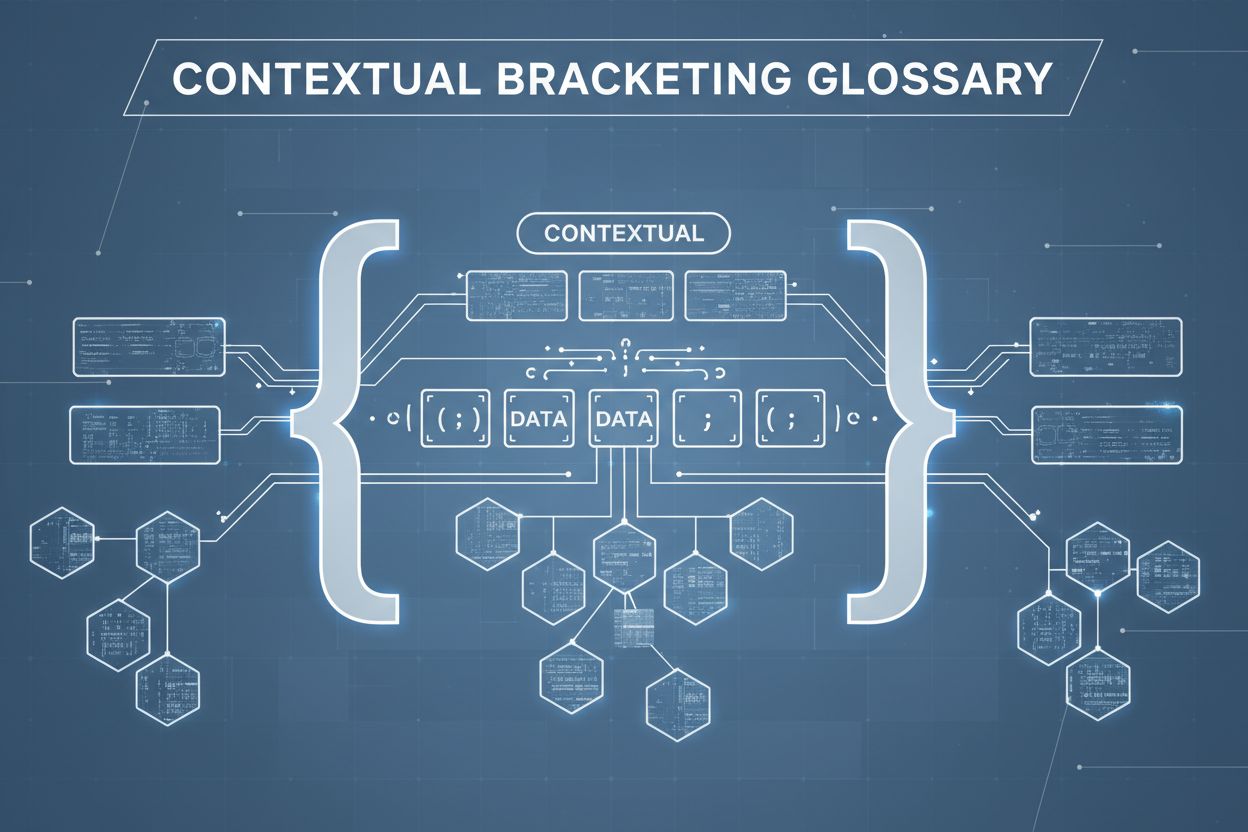

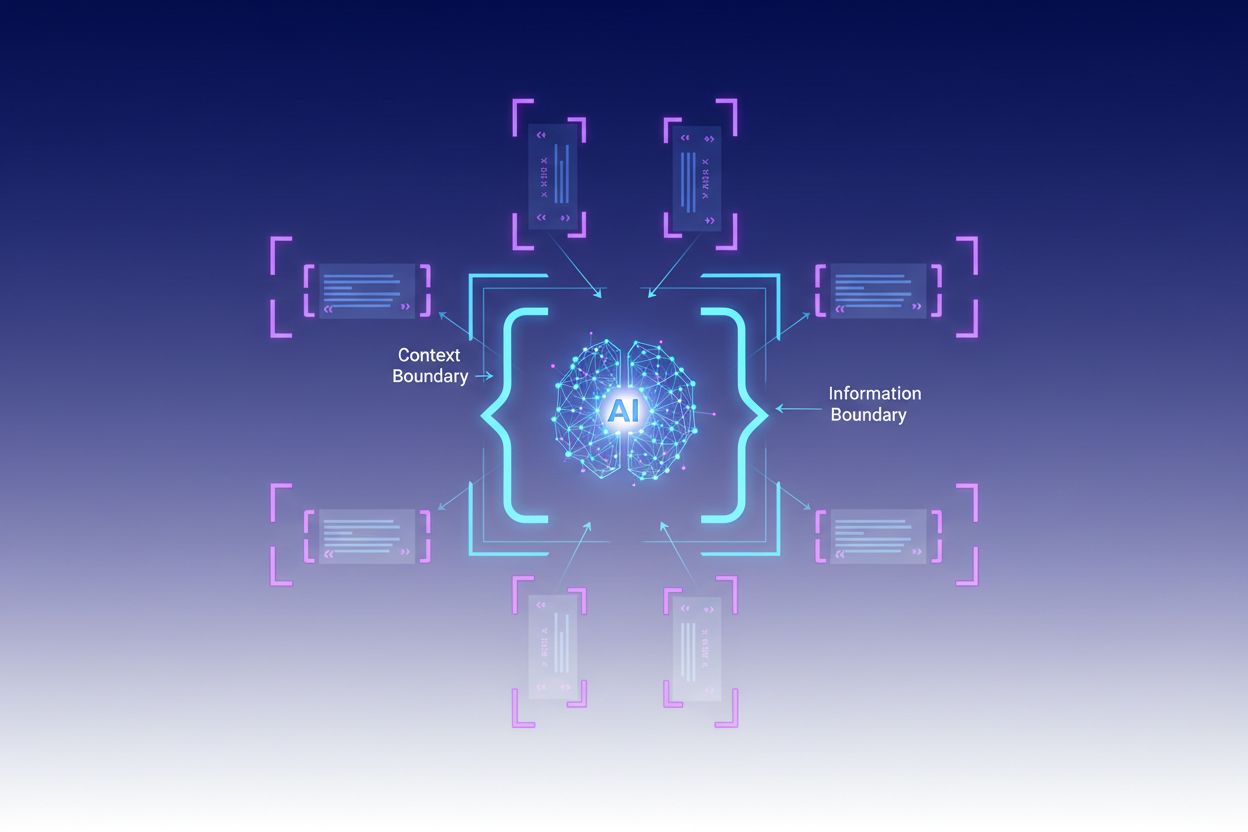

Delimitação contextual é uma técnica de otimização de conteúdo que estabelece limites claros ao redor das informações para evitar interpretações errôneas e alucinações por parte da IA. Esse método envolve o uso de delimitadores explícitos — como tags XML, cabeçalhos markdown ou caracteres especiais — para marcar o início e o fim de blocos específicos de informação, criando o que especialistas chamam de “limite de contexto”. Ao estruturar prompts e dados com esses marcadores claros, os desenvolvedores garantem que os modelos de IA entendam exatamente onde a informação relevante começa e termina, evitando que o modelo gere respostas baseadas em suposições ou detalhes fabricados. A delimitação contextual representa uma evolução da tradicional engenharia de prompts, expandindo-se para a disciplina mais ampla da engenharia de contexto, que foca na otimização de todas as informações fornecidas a um LLM para alcançar resultados desejados. A técnica é especialmente valiosa em ambientes de produção onde precisão e consistência são críticas, pois oferece barreiras matemáticas e estruturais que orientam o comportamento da IA sem exigir lógica condicional complexa.

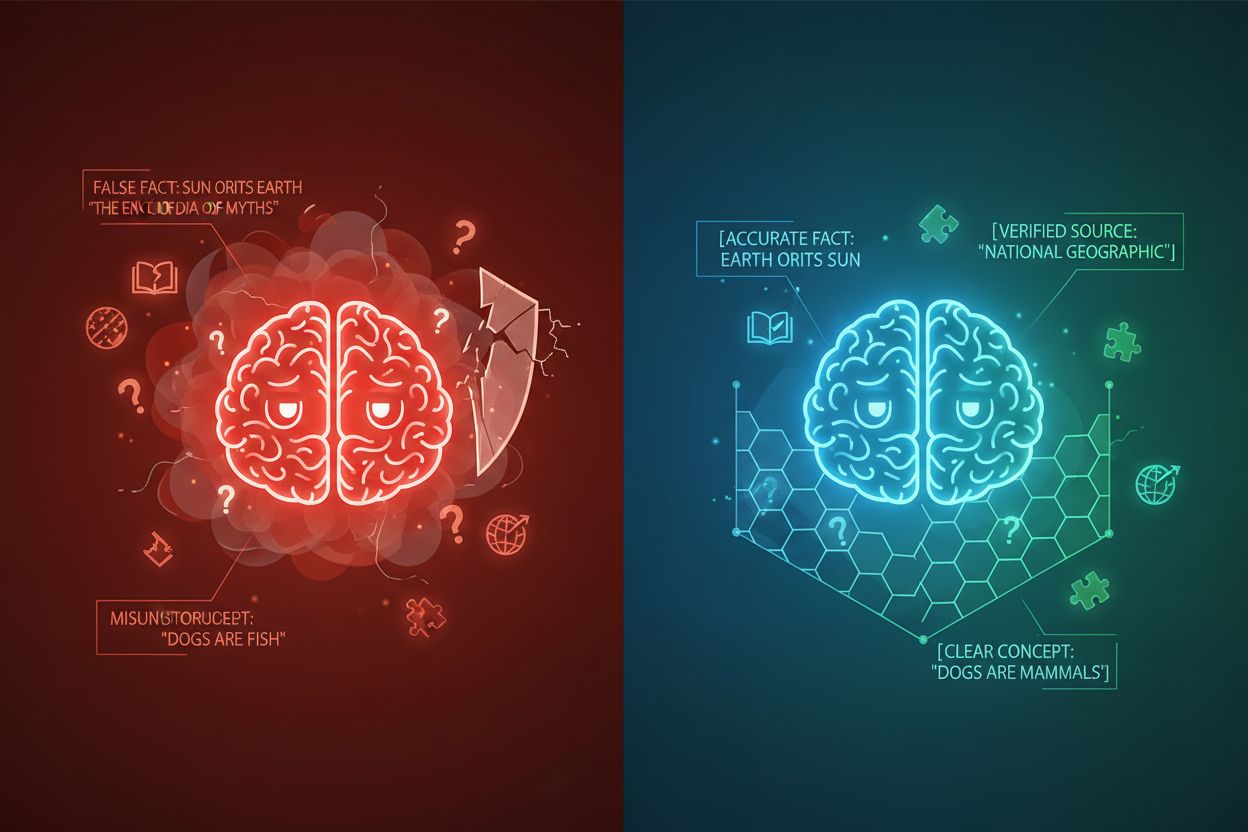

A alucinação de IA ocorre quando modelos de linguagem geram respostas que não estão enraizadas em informações factuais ou no contexto específico fornecido, resultando em fatos falsos, declarações enganosas ou referências a fontes inexistentes. Pesquisas mostram que chatbots inventam fatos aproximadamente 27% das vezes, com 46% de seus textos contendo erros factuais, enquanto as citações jornalísticas do ChatGPT estavam erradas em 76% dos casos. Essas alucinações têm várias origens: os modelos podem aprender padrões a partir de dados de treinamento enviesados ou incompletos, compreender erroneamente a relação entre tokens ou não possuir restrições suficientes que limitem as saídas possíveis. As consequências são graves em diversos setores — na saúde, as alucinações podem levar a diagnósticos incorretos e intervenções médicas desnecessárias; no contexto jurídico, podem resultar em citações de casos fabricados (como visto no caso Mata v. Avianca, onde um advogado foi sancionado por usar citações jurídicas falsas do ChatGPT); nos negócios, desperdiçam recursos por meio de análises imperfeitas e previsões equivocadas. O problema fundamental é que, sem limites de contexto claros, modelos de IA operam em um vácuo de informação onde é mais provável que “preencham as lacunas” com informações plausíveis, mas imprecisas, tratando a alucinação como uma funcionalidade e não como um defeito.

| Tipo de Alucinação | Frequência | Impacto | Exemplo |

|---|---|---|---|

| Inexatidões Fatuais | 27-46% | Disseminação de desinformação | Funcionalidades falsas de produto |

| Fabricação de Fontes | 76% (citações) | Perda de credibilidade | Citações inexistentes |

| Conceitos Mal Interpretados | Variável | Análise incorreta | Precedentes jurídicos errados |

| Padrões Tendenciosos | Contínuo | Saídas discriminatórias | Respostas estereotipadas |

A eficácia da delimitação contextual baseia-se em cinco princípios fundamentais:

Uso de Delimitadores: Empregue marcadores consistentes e inequívocos (tags XML como <context>, cabeçalhos markdown ou caracteres especiais) para delimitar claramente blocos de informação e evitar que o modelo confunda limites entre diferentes fontes de dados ou tipos de instrução.

Gestão da Janela de Contexto: Aloque estrategicamente tokens entre instruções do sistema, entradas do usuário e conhecimento recuperado, garantindo que as informações mais relevantes ocupem o orçamento limitado de atenção do modelo, enquanto detalhes menos críticos sejam filtrados ou recuperados sob demanda.

Hierarquia de Informação: Estabeleça níveis claros de prioridade para diferentes tipos de informação, sinalizando ao modelo quais dados devem ser tratados como fontes autoritativas versus contexto suplementar, evitando a atribuição de igual peso a informações primárias e secundárias.

Definição de Limites: Declare explicitamente quais informações o modelo deve considerar e quais deve ignorar, criando barreiras rígidas que impedem o modelo de extrapolar além dos dados fornecidos ou fazer suposições sobre informações não explicitadas.

Marcadores de Escopo: Utilize elementos estruturais para indicar o escopo de instruções, exemplos e dados, deixando claro se as orientações se aplicam globalmente, a seções específicas ou apenas a determinados tipos de consultas.

A implementação da delimitação contextual requer atenção cuidadosa à forma como as informações são estruturadas e apresentadas aos modelos de IA. Formatação estruturada de entrada usando esquemas JSON ou XML fornece definições explícitas de campos que orientam o comportamento do modelo — por exemplo, envolver consultas do usuário em tags <user_query> e saídas esperadas em <expected_output> cria limites inequívocos. Prompts do sistema devem ser organizados em seções distintas usando cabeçalhos markdown ou tags XML: <background_information>, <instructions>, <tool_guidance> e <output_description> cumprem papéis específicos e ajudam o modelo a entender a hierarquia das informações. Exemplos few-shot devem incluir contexto delimitado mostrando exatamente como o modelo deve estruturar suas respostas, com delimitadores claros ao redor de entradas e saídas. Definições de ferramentas se beneficiam de descrições explícitas de parâmetros e restrições de uso, impedindo o modelo de usar ferramentas fora do escopo pretendido. Sistemas de Geração Aumentada por Recuperação (RAG) podem implementar a delimitação contextual envolvendo documentos recuperados com marcadores de fonte (<source>nome_do_documento</source>) e usando scores de fundamentação para verificar se as respostas geradas permanecem dentro dos limites das informações recuperadas. Por exemplo, o recurso de limite de contexto do CustomGPT funciona treinando modelos exclusivamente com conjuntos de dados enviados, garantindo que as respostas nunca extrapolem a base de conhecimento fornecida — uma implementação prática de delimitação contextual no nível arquitetural.

Embora a delimitação contextual compartilhe semelhanças com técnicas relacionadas, ela ocupa uma posição distinta no cenário da engenharia de IA. A engenharia de prompts básica se concentra principalmente em criar instruções e exemplos eficazes, mas carece do enfoque sistemático de gerenciamento de todos os elementos de contexto que a delimitação contextual oferece. A engenharia de contexto, disciplina mais ampla, engloba a delimitação contextual como um dos componentes — inclui otimização de prompts, design de ferramentas, gerenciamento de memória e recuperação dinâmica de contexto, tornando-se um superset da abordagem mais focada da delimitação contextual. O simples seguimento de instruções depende da capacidade do modelo de entender diretrizes em linguagem natural sem limites estruturais explícitos, o que frequentemente falha quando as instruções são complexas ou quando o modelo encontra situações ambíguas. Barreiras e sistemas de validação atuam no nível da saída, verificando respostas após a geração, enquanto a delimitação contextual atua no nível de entrada para evitar alucinações antes que ocorram. A principal distinção é que a delimitação contextual é preventiva e estrutural — molda o ambiente informacional no qual o modelo opera — em vez de corretiva ou reativa, tornando-a mais eficiente e confiável para manter a precisão em sistemas de produção.

A delimitação contextual agrega valor mensurável em aplicações diversas. Chatbots de atendimento ao cliente usam limites de contexto para restringir respostas a bases de conhecimento aprovadas pela empresa, evitando que agentes inventem funcionalidades de produtos ou façam compromissos não autorizados. Sistemas de análise de documentos jurídicos delimitam legislação relevante, jurisprudências e precedentes, garantindo que a IA só referencie fontes verificadas e não fabrique citações jurídicas. Sistemas de IA médica implementam limites estritos ao redor de diretrizes clínicas, dados de pacientes e protocolos de tratamento aprovados, prevenindo alucinações perigosas que poderiam prejudicar pacientes. Plataformas de geração de conteúdo utilizam delimitação contextual para impor diretrizes de marca, requisitos de tom e restrições factuais, garantindo que o conteúdo gerado esteja alinhado aos padrões organizacionais. Ferramentas de pesquisa e análise delimitam fontes primárias, conjuntos de dados e informações verificadas, permitindo à IA sintetizar insights mantendo atribuição clara e evitando a invenção de estatísticas ou estudos falsos. O AmICited.com exemplifica esse princípio ao monitorar como sistemas de IA citam e referenciam marcas em GPTs, Perplexity e Google AI Overviews — essencialmente rastreando se os modelos de IA permanecem dentro dos limites de contexto apropriados ao discutir empresas ou produtos específicos, ajudando organizações a entender se sistemas de IA estão alucinando sobre sua marca ou representando suas informações com precisão.

A implementação bem-sucedida da delimitação contextual exige a adoção de melhores práticas comprovadas:

Comece com Contexto Mínimo: Inicie com o conjunto mais enxuto possível de informações necessárias para respostas precisas e expanda apenas quando testes revelarem lacunas, evitando poluição do contexto e mantendo o foco do modelo.

Use Padrões Consistentes de Delimitadores: Estabeleça e mantenha convenções uniformes de delimitadores em todo o sistema, facilitando o reconhecimento de limites pelo modelo e reduzindo confusões decorrentes de formatações inconsistentes.

Teste e Valide os Limites: Teste sistematicamente se o modelo respeita os limites definidos tentando induzi-lo a extrapolar, identificando e corrigindo falhas antes da implantação.

Monitore a Deriva de Contexto: Acompanhe continuamente se as respostas do modelo permanecem dentro dos limites pretendidos ao longo do tempo, pois o comportamento do modelo pode mudar com diferentes padrões de entrada ou conforme as bases de conhecimento evoluem.

Implemente Ciclos de Feedback: Crie mecanismos para que usuários ou revisores humanos sinalizem casos em que o modelo ultrapassou seus limites, usando esse feedback para refinar definições de contexto e melhorar o desempenho futuro.

Versione suas Definições de Contexto: Trate limites de contexto como código, mantendo histórico de versões e documentação das alterações, permitindo rollback caso novas definições de limite produzam resultados piores.

Diversas plataformas incorporaram capacidades de delimitação contextual em suas ofertas principais. CustomGPT.ai implementa limites de contexto por meio de seu recurso “context boundary”, que atua como uma barreira protetora garantindo que a IA utilize apenas os dados fornecidos pelo usuário, nunca recorrendo a conhecimento geral ou fabricando informações — essa abordagem tem se mostrado eficaz para organizações como o MIT, que exigem precisão absoluta na entrega do conhecimento. O Claude da Anthropic enfatiza princípios de engenharia de contexto, fornecendo documentação detalhada sobre como estruturar prompts, gerenciar janelas de contexto e implementar barreiras que mantêm as respostas dentro dos limites definidos. AWS Bedrock Guardrails oferece verificações automatizadas de raciocínio que conferem o conteúdo gerado com regras matemáticas e lógicas, com scores de fundamentação indicando se as respostas permanecem dentro do material fonte (scores acima de 0,85 são exigidos em aplicações financeiras). Shelf.io disponibiliza soluções RAG com gestão de contexto, permitindo que organizações implementem geração aumentada por recuperação mantendo limites estritos sobre quais informações o modelo pode acessar e referenciar. O AmICited.com atua de forma complementar ao monitorar como sistemas de IA citam e referenciam sua marca em várias plataformas de IA, ajudando você a entender se os modelos de IA estão respeitando os limites de contexto apropriados ao discutir sua organização ou permanecendo dentro de informações precisas e verificadas sobre sua marca — essencialmente fornecendo visibilidade sobre se a delimitação contextual está funcionando de forma eficaz no mundo real.

A engenharia de prompts foca principalmente na criação de instruções e exemplos eficazes, enquanto a delimitação contextual é uma abordagem sistemática para gerenciar todos os elementos de contexto por meio de delimitadores e limites explícitos. A delimitação contextual é mais estruturada e preventiva, atuando no nível de entrada para evitar alucinações antes que ocorram, enquanto a engenharia de prompts é mais ampla e inclui várias técnicas de otimização.

A delimitação contextual previne alucinações estabelecendo limites claros de informação usando delimitadores como tags XML ou cabeçalhos markdown. Isso indica ao modelo de IA exatamente quais informações ele deve considerar e quais deve ignorar, evitando que fabrique detalhes ou faça suposições sobre informações não declaradas. Ao restringir a atenção do modelo a limites definidos, reduz-se a probabilidade de gerar fatos falsos ou fontes inexistentes.

Delimitadores comuns incluem tags XML (como

Os princípios da delimitação contextual podem ser aplicados à maioria dos modelos modernos de linguagem, embora a eficácia varie. Modelos treinados com melhores capacidades de seguir instruções (como Claude, GPT-4 e Gemini) tendem a respeitar os limites de forma mais confiável. A técnica funciona melhor quando combinada com modelos que suportam saídas estruturadas e foram treinados com dados diversificados e bem formatados.

Comece organizando seus prompts do sistema em seções distintas usando delimitadores claros. Estruture entradas e saídas utilizando esquemas JSON ou XML. Use padrões de delimitadores consistentes em todo o processo. Implemente exemplos few-shot que mostrem ao modelo exatamente como respeitar os limites. Teste extensivamente para garantir que o modelo respeite os limites definidos e monitore o desempenho ao longo do tempo para evitar deriva de contexto.

A delimitação contextual pode aumentar levemente o uso de tokens devido a delimitadores e marcadores estruturais adicionais, mas isso normalmente é compensado por maior precisão e redução de alucinações. A técnica, na verdade, melhora a eficiência ao impedir que o modelo desperdice tokens com informações fabricadas. Em sistemas de produção, os ganhos de precisão superam amplamente o pequeno acréscimo no uso de tokens.

A delimitação contextual e o RAG são técnicas complementares. O RAG recupera informações relevantes de fontes externas, enquanto a delimitação contextual garante que o modelo permaneça dentro dos limites dessas informações recuperadas. Juntas, criam um sistema poderoso onde o modelo pode acessar conhecimento externo, mas é restringido a referenciar apenas fontes verificadas e recuperadas.

Diversas plataformas têm suporte integrado: CustomGPT.ai oferece recursos de limites de contexto, o Claude da Anthropic disponibiliza documentação sobre engenharia de contexto e suporte a saídas estruturadas, o AWS Bedrock Guardrails inclui verificações automatizadas de raciocínio e o Shelf.io entrega RAG com gestão de contexto. O AmICited.com monitora como sistemas de IA citam sua marca, ajudando a verificar se a delimitação contextual está funcionando de forma eficaz.

A delimitação contextual garante que sistemas de IA forneçam informações precisas sobre sua marca. Use o AmICited para rastrear como modelos de IA citam e referenciam seu conteúdo em GPTs, Perplexity e Google AI Overviews.

Explicação da janela de contexto: o máximo de tokens que um LLM pode processar de uma vez. Saiba como as janelas de contexto afetam a precisão da IA, alucinaçõe...

Saiba o que são janelas de contexto em modelos de linguagem de IA, como funcionam, seu impacto no desempenho do modelo e por que são importantes para aplicações...

Saiba o que é uma janela de contexto conversacional, como ela afeta as respostas da IA e por que ela é importante para interações eficazes com IA. Entenda token...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.