Janela de Contexto

Explicação da janela de contexto: o máximo de tokens que um LLM pode processar de uma vez. Saiba como as janelas de contexto afetam a precisão da IA, alucinaçõe...

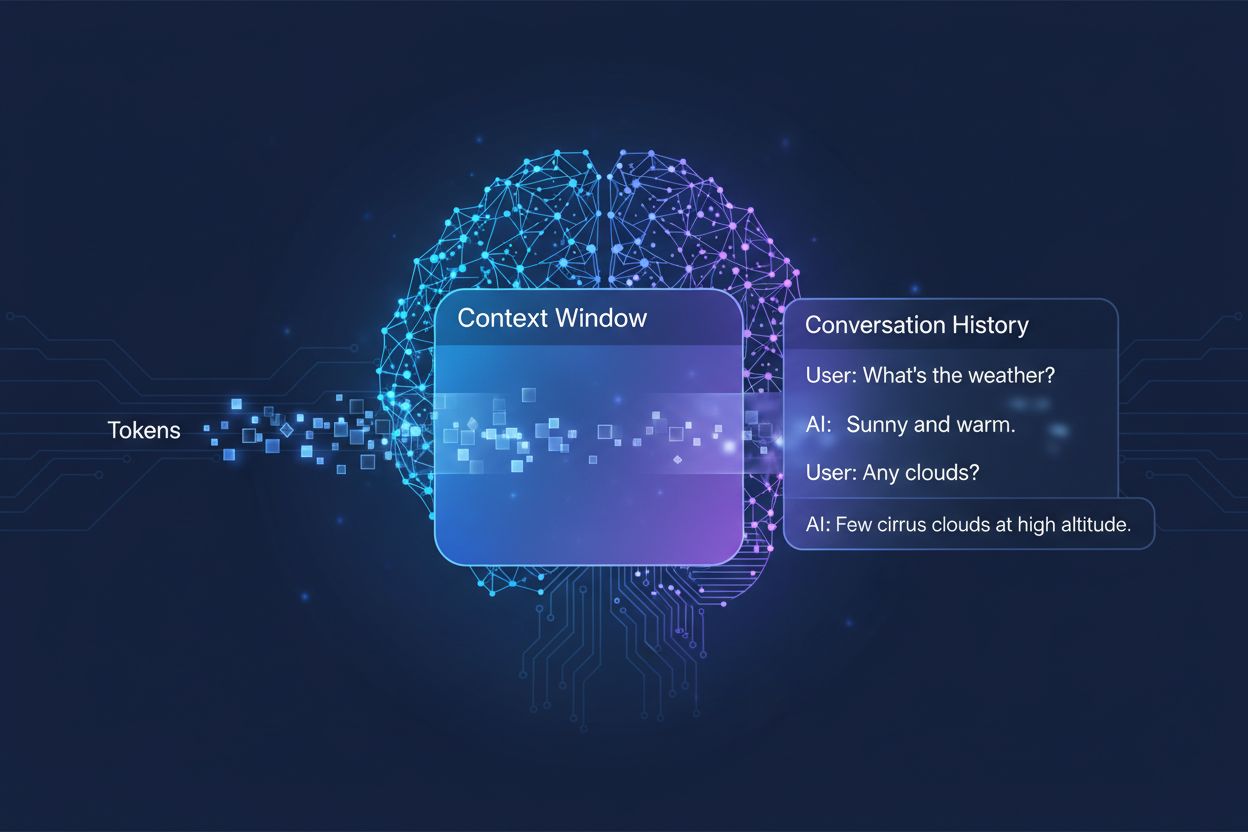

A quantidade de conversa anterior que um sistema de IA considera ao gerar respostas, medida em tokens. Ela determina quanto texto uma IA pode processar simultaneamente e impacta diretamente a qualidade e a coerência de suas respostas em conversas de múltiplos turnos.

A quantidade de conversa anterior que um sistema de IA considera ao gerar respostas, medida em tokens. Ela determina quanto texto uma IA pode processar simultaneamente e impacta diretamente a qualidade e a coerência de suas respostas em conversas de múltiplos turnos.

Uma janela de contexto é a quantidade máxima de texto que um modelo de linguagem de IA pode processar e referenciar de uma só vez durante uma conversa ou tarefa. Pense nela como a memória de trabalho do modelo—assim como os humanos só conseguem manter uma quantidade limitada de informações em sua consciência imediata, os modelos de IA só podem “ver” uma certa quantidade de texto antes e depois de sua posição atual. Essa capacidade é medida em tokens, que são pequenas unidades de texto que normalmente representam palavras ou fragmentos de palavras (em média, uma palavra em inglês equivale a aproximadamente 1,5 tokens). Entender a janela de contexto do seu modelo é crucial porque ela determina diretamente quanta informação a IA pode considerar ao gerar respostas, tornando-se uma restrição fundamental para a eficácia do modelo em conversas complexas de múltiplos turnos ou documentos extensos.

Modelos de linguagem modernos, especialmente os de arquitetura baseada em transformers, processam texto convertendo-o em tokens e analisando simultaneamente as relações entre todos os tokens dentro da janela de contexto. A arquitetura transformer, apresentada no artigo seminal de 2017 “Attention is All You Need”, utiliza um mecanismo chamado autoatenção para determinar quais partes da entrada são mais relevantes entre si. Esse mecanismo de atenção permite que o modelo avalie a importância de diferentes tokens em relação uns aos outros, possibilitando que ele compreenda contexto e significado em toda a janela. No entanto, esse processo se torna computacionalmente caro à medida que a janela de contexto cresce, já que o mecanismo de atenção precisa calcular relações entre todos os tokens—um problema de escalonamento quadrático. A tabela a seguir ilustra como diferentes modelos de IA líderes se comparam em suas capacidades de janela de contexto:

| Modelo | Janela de Contexto (Tokens) | Data de Lançamento |

|---|---|---|

| GPT-4 | 128.000 | março de 2023 |

| Claude 3 Opus | 200.000 | março de 2024 |

| Gemini 1.5 Pro | 1.000.000 | maio de 2024 |

| GPT-4 Turbo | 128.000 | novembro de 2023 |

| Llama 2 | 4.096 | julho de 2023 |

Essas capacidades variadas refletem diferentes escolhas de projeto e compensações computacionais feitas por cada organização, com janelas maiores possibilitando aplicações mais sofisticadas, porém exigindo mais poder de processamento.

A busca por janelas de contexto maiores representa um dos avanços mais significativos na capacidade da IA na última década. Os primeiros redes neurais recorrentes (RNNs) e modelos long short-term memory (LSTM) tinham dificuldades com contexto, pois processavam texto de forma sequencial e tinham dificuldade de reter informações de partes distantes da entrada. A grande virada ocorreu em 2017 com a introdução da arquitetura Transformer, que permitiu o processamento paralelo de sequências inteiras e melhorou drasticamente a capacidade do modelo de manter contexto em textos longos. Essa base levou ao GPT-2 de 2019, que apresentou geração de linguagem impressionante com uma janela de contexto de 1.024 tokens, seguido pelo GPT-3 de 2020 com 2.048 tokens, e finalmente o GPT-4 de 2023 com 128.000 tokens. Cada avanço foi importante porque expandiu o que era possível: janelas maiores permitiram que os modelos lidassem com documentos mais longos, mantivessem coerência em conversas de múltiplos turnos e compreendessem relações sutis entre conceitos distantes no texto. O crescimento exponencial do tamanho das janelas de contexto reflete tanto as inovações arquiteturais quanto o aumento dos recursos computacionais disponíveis para os principais laboratórios de IA.

Janelas de contexto maiores expandem fundamentalmente o que os modelos de IA podem realizar, permitindo aplicações que antes eram impossíveis ou muito limitadas. Veja os principais benefícios:

Maior continuidade em conversas: Os modelos podem manter consciência de todo o histórico de conversas, reduzindo a necessidade de reexplicar o contexto e permitindo diálogos de múltiplos turnos mais naturais e coerentes, que parecem realmente contínuos em vez de fragmentados.

Processamento de documentos em escala: Janelas maiores permitem que a IA analise documentos inteiros, artigos científicos ou bases de código em uma única passagem, identificando padrões e relações em todo o conteúdo sem perder informações das seções anteriores.

Melhor raciocínio e análise: Com mais contexto disponível, os modelos conseguem realizar tarefas de raciocínio mais sofisticadas que exigem entender relações entre múltiplos conceitos, tornando-os mais eficazes para pesquisa, análise e resolução de problemas complexos.

Menor necessidade de reintrodução de contexto: Os usuários não precisam mais resumir ou reintroduzir informações manualmente; o modelo pode referenciar todo o histórico da conversa, reduzindo atritos e aumentando a eficiência em fluxos de trabalho colaborativos.

Melhor desempenho em tarefas complexas: Aplicações como revisão de documentos jurídicos, análise de prontuários médicos e auditoria de código se beneficiam significativamente da capacidade de considerar um contexto abrangente, levando a resultados mais precisos e completos.

Fluxos de trabalho multidocumento sem interrupções: Profissionais podem trabalhar com vários documentos relacionados ao mesmo tempo, permitindo que o modelo faça referências cruzadas e identifique conexões que seriam impossíveis com janelas de contexto menores.

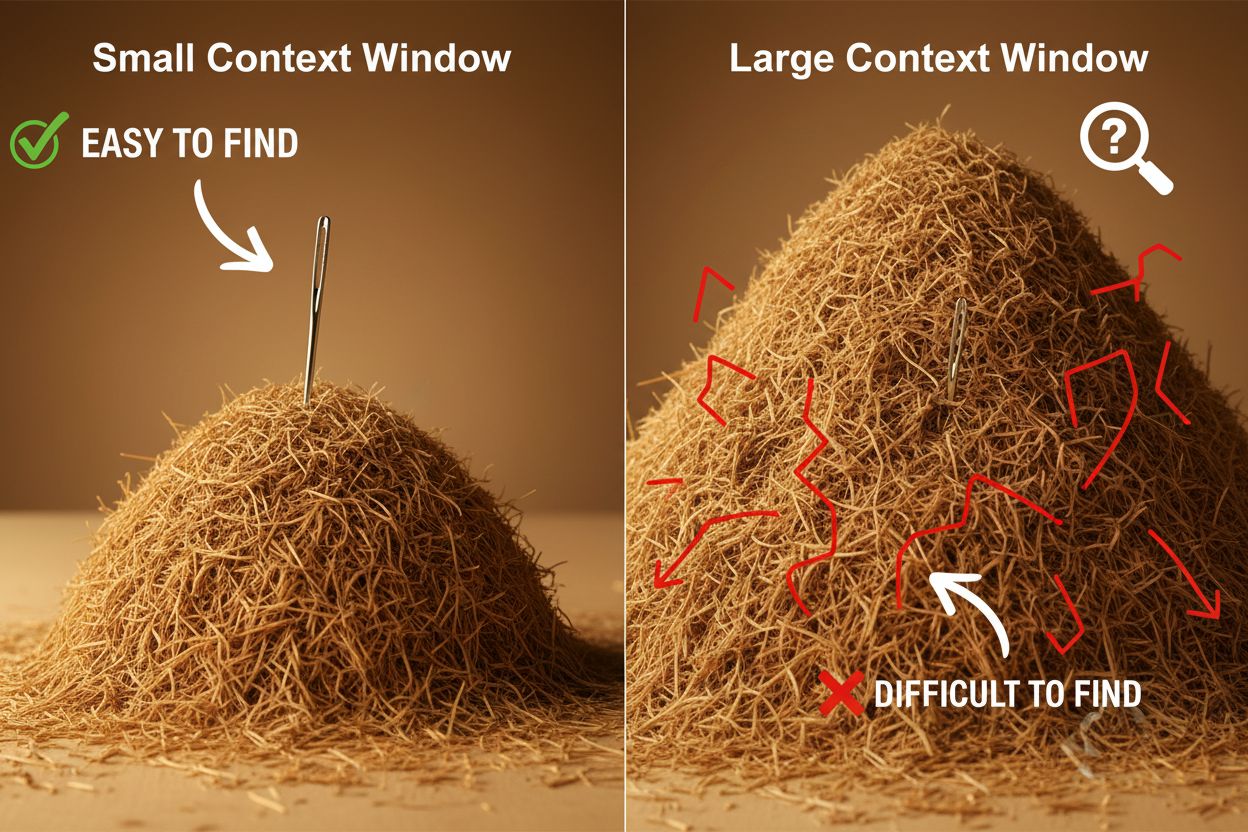

Apesar das vantagens, janelas de contexto grandes introduzem desafios técnicos e práticos importantes que desenvolvedores e usuários precisam considerar cuidadosamente. O desafio mais evidente é o custo computacional: processar sequências longas requer exponencialmente mais memória e processamento devido ao escalonamento quadrático do mecanismo de atenção, tornando janelas maiores substancialmente mais caras de operar. Essa demanda maior também cria problemas de latência, já que janelas de contexto longas significam respostas mais lentas—um problema crítico para aplicações em tempo real, onde os usuários esperam respostas rápidas. Outro problema sutil, mas importante, é o fenômeno da “agulha no palheiro”, em que os modelos têm dificuldade para localizar e utilizar informações relevantes quando estas estão perdidas em uma janela de contexto muito grande, às vezes com desempenho pior do que em janelas menores. Além disso, ocorre a degradação do contexto (context rot), quando informações do início de uma janela longa perdem influência na saída do modelo, à medida que o mecanismo de atenção pode priorizar tokens mais recentes. Esses desafios mostram que simplesmente maximizar o tamanho da janela de contexto nem sempre é a melhor solução para todos os casos.

Compreender a degradação do contexto é essencial para trabalhar de forma eficaz com janelas de contexto grandes: à medida que as sequências ficam mais longas, os tokens do início tendem a ter influência cada vez menor sobre a saída do modelo, o que significa que informações críticas podem ser efetivamente “esquecidas” mesmo estando tecnicamente dentro da janela. Isso acontece porque o orçamento de atenção—a capacidade do modelo de realmente considerar todos os tokens—fica diluído em uma faixa maior de texto. Felizmente, várias técnicas sofisticadas surgiram para enfrentar essas limitações. A Geração com Recuperação (RAG) resolve isso armazenando informações em bancos de dados externos e recuperando apenas as partes mais relevantes quando necessário, ampliando efetivamente a base de conhecimento do modelo sem exigir uma janela de contexto enorme. Técnicas de compactação de contexto resumem ou comprimem informações menos relevantes, preservando os detalhes mais importantes e reduzindo o uso de tokens. Abordagens de anotação estruturada incentivam os usuários a organizar as informações de forma hierárquica, facilitando para o modelo priorizar e localizar conceitos-chave. Essas soluções funcionam sendo estratégicas sobre quais informações entram na janela de contexto e como elas são organizadas, em vez de tentar colocar tudo na memória ao mesmo tempo.

As janelas de contexto ampliadas dos modelos de IA modernos desbloquearam inúmeras aplicações reais que antes eram impraticáveis ou impossíveis. Sistemas de suporte ao cliente agora podem revisar todo o histórico de tickets e documentação relacionada em uma única solicitação, permitindo respostas mais precisas e apropriadas ao contexto, sem exigir que o cliente reexplique sua situação. Análise de documentos e pesquisa foi transformada por modelos capazes de ler artigos científicos, contratos jurídicos ou especificações técnicas inteiras, identificando informações-chave e respondendo perguntas detalhadas sobre conteúdos que levariam horas para serem revisados por humanos. Revisão de código e desenvolvimento de software se beneficiam de janelas grandes o suficiente para conter arquivos inteiros ou até múltiplos arquivos relacionados, permitindo que a IA compreenda padrões arquiteturais e forneça sugestões mais inteligentes. Criação de conteúdo longo e fluxos de escrita iterativos tornam-se mais eficientes quando o modelo pode manter consciência do tom, estilo e arco narrativo de todo o documento ao longo do processo de edição. Análise de transcrições de reuniões e síntese de pesquisas aproveitam janelas grandes para extrair insights de horas de conversa ou dezenas de documentos, identificando temas e conexões difíceis de perceber manualmente. Essas aplicações demonstram que o tamanho da janela de contexto se traduz diretamente em valor prático para profissionais de diversos setores.

A trajetória do desenvolvimento de janelas de contexto sugere que estamos caminhando para expansões ainda mais dramáticas no curto prazo, com o Gemini 1.5 Pro já demonstrando uma janela de contexto de 1.000.000 de tokens e laboratórios de pesquisa explorando capacidades ainda maiores. Além do tamanho bruto, o futuro provavelmente envolve janelas de contexto dinâmicas que ajustam inteligentemente seu tamanho conforme a tarefa, alocando mais capacidade quando necessário e reduzindo-a para consultas simples, melhorando a eficiência e reduzindo custos. Pesquisadores também avançam em mecanismos de atenção mais eficientes que reduzem o custo computacional de janelas maiores, potencialmente quebrando a barreira do escalonamento quadrático que atualmente limita o tamanho do contexto. À medida que essas tecnologias amadurecem, podemos esperar que as janelas de contexto deixem de ser uma limitação e passem a ser um problema resolvido, permitindo que desenvolvedores concentrem-se em outros aspectos da capacidade e confiabilidade da IA. A convergência entre janelas maiores, maior eficiência e gestão de contexto mais inteligente provavelmente definirá a próxima geração de aplicações de IA, permitindo casos de uso que ainda nem imaginamos.

Uma janela de contexto é a quantidade total de texto (medida em tokens) que um modelo de IA pode processar de uma vez, enquanto limite de tokens refere-se ao número máximo de tokens que o modelo pode lidar. Esses termos frequentemente são usados de forma intercambiável, mas janela de contexto refere-se especificamente à memória de trabalho disponível durante uma inferência, enquanto limite de tokens também pode se referir a restrições de saída ou limites de uso da API.

Janelas de contexto maiores geralmente melhoram a qualidade das respostas ao permitir que o modelo considere mais informações relevantes e mantenha melhor a continuidade da conversa. No entanto, janelas extremamente grandes às vezes podem prejudicar a qualidade devido à degradação do contexto, quando o modelo tem dificuldade em priorizar informações importantes em meio a grandes quantidades de texto. O tamanho ideal da janela de contexto depende da tarefa específica e de quão bem as informações estão organizadas.

Janelas de contexto maiores exigem mais poder computacional devido ao escalonamento quadrático do mecanismo de atenção em modelos transformadores. O mecanismo de atenção precisa calcular relações entre cada token e todos os outros tokens, então dobrar a janela de contexto praticamente quadruplica os requisitos computacionais. Por isso, janelas de contexto maiores são mais caras de executar e produzem tempos de resposta mais lentos.

O problema da 'agulha no palheiro' ocorre quando um modelo de IA tem dificuldade em localizar e utilizar informações relevantes (a 'agulha') quando elas estão enterradas em uma janela de contexto muito grande (o 'palheiro'). Os modelos às vezes apresentam desempenho pior com janelas extremamente grandes porque o mecanismo de atenção fica diluído em meio a tanta informação, dificultando identificar o que realmente é importante.

Para maximizar a efetividade da janela de contexto, organize as informações de forma clara e hierárquica, coloque as informações mais importantes no início ou no fim do contexto, utilize formatos estruturados como JSON ou markdown, e considere usar Geração com Recuperação (RAG) para carregar dinamicamente apenas as informações mais relevantes. Evite sobrecarregar o modelo com detalhes irrelevantes que consomem tokens sem agregar valor.

Janela de contexto é a capacidade técnica do modelo para processar texto de uma só vez, enquanto histórico de conversa é o registro real das mensagens anteriores em uma conversa. O histórico da conversa deve caber dentro da janela de contexto, mas a janela de contexto também inclui espaço para prompts do sistema, instruções e outros metadados. Um histórico de conversa pode ser maior que a janela de contexto, exigindo sumarização ou truncamento.

Atualmente, nenhum modelo de IA possui janelas de contexto verdadeiramente ilimitadas, pois todos têm restrições arquiteturais e computacionais. No entanto, alguns modelos como Gemini 1.5 Pro oferecem janelas extremamente grandes (1.000.000 de tokens), e técnicas como Geração com Recuperação (RAG) podem efetivamente ampliar a base de conhecimento do modelo além de sua janela de contexto ao recuperar informações dinamicamente conforme necessário.

O tamanho da janela de contexto afeta diretamente os custos da API, pois janelas maiores exigem mais recursos computacionais para processar. A maioria dos provedores de API de IA cobra com base no uso de tokens, portanto, usar uma janela de contexto maior significa mais tokens processados e custos mais altos. Alguns provedores também cobram taxas premium por modelos com janelas de contexto maiores, tornando importante escolher o tamanho certo do modelo para suas necessidades.

O AmICited acompanha como sistemas de IA como ChatGPT, Perplexity e Google AI Overviews citam e referenciam seu conteúdo. Entenda sua visibilidade em IA e monitore as menções à sua marca nas plataformas de IA.

Explicação da janela de contexto: o máximo de tokens que um LLM pode processar de uma vez. Saiba como as janelas de contexto afetam a precisão da IA, alucinaçõe...

Saiba o que são janelas de contexto em modelos de linguagem de IA, como funcionam, seu impacto no desempenho do modelo e por que são importantes para aplicações...

Discussão da comunidade sobre janelas de contexto em IA e suas implicações para o marketing de conteúdo. Entendendo como os limites de contexto afetam o process...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.