O que é busca vetorial e como ela funciona?

Saiba como a busca vetorial utiliza embeddings de aprendizado de máquina para encontrar itens semelhantes com base no significado, em vez de palavras-chave exat...

Busca vetorial é um método de encontrar itens semelhantes em um conjunto de dados representando-os como vetores matemáticos e comparando-os usando métricas de distância como similaridade do cosseno ou distância euclidiana. Essa abordagem permite compreensão semântica além da correspondência de palavras-chave, possibilitando que sistemas descubram relações e similaridades baseadas em significado e não apenas em coincidências exatas de texto.

Busca vetorial é um método de encontrar itens semelhantes em um conjunto de dados representando-os como vetores matemáticos e comparando-os usando métricas de distância como similaridade do cosseno ou distância euclidiana. Essa abordagem permite compreensão semântica além da correspondência de palavras-chave, possibilitando que sistemas descubram relações e similaridades baseadas em significado e não apenas em coincidências exatas de texto.

Busca vetorial é um método de encontrar itens semelhantes em um conjunto de dados representando-os como vetores matemáticos e comparando-os usando métricas de distância para medir similaridade semântica. Diferente da busca tradicional baseada em palavras-chave, que depende de coincidências exatas de texto, a busca vetorial compreende o significado e o contexto dos dados ao convertê-los em representações numéricas de alta dimensão chamadas embeddings vetoriais. Essa abordagem permite que sistemas descubram relações e similaridades baseadas em conteúdo semântico, e não apenas em características superficiais, tornando-se especialmente poderosa em aplicações que requerem compreensão contextual. A busca vetorial tornou-se fundamental para sistemas de IA modernos, possibilitando busca semântica, motores de recomendação, detecção de anomalias e geração aumentada por recuperação (RAG) em plataformas como ChatGPT, Perplexity, Google AI Overviews e Claude.

No seu núcleo, a busca vetorial transforma dados em representações numéricas onde a proximidade no espaço indica similaridade semântica. Cada ponto de dado—seja texto, imagem ou áudio—é convertido em um vetor, que é basicamente um array de números representando características ou significado. Por exemplo, a palavra “restaurante” pode ser representada como [0.2, -0.5, 0.8, 0.1], onde cada número captura diferentes aspectos do significado semântico da palavra. O princípio fundamental é que itens semanticamente semelhantes terão vetores posicionados próximos uns dos outros nesse espaço de alta dimensão, enquanto itens diferentes estarão distantes. Essa estrutura matemática permite que computadores comparem conceitos baseados em significado ao invés de coincidências exatas de palavras-chave, permitindo que uma busca por “melhores locais para jantar” retorne resultados para “restaurantes mais bem avaliados” mesmo sem sobreposição exata de palavras.

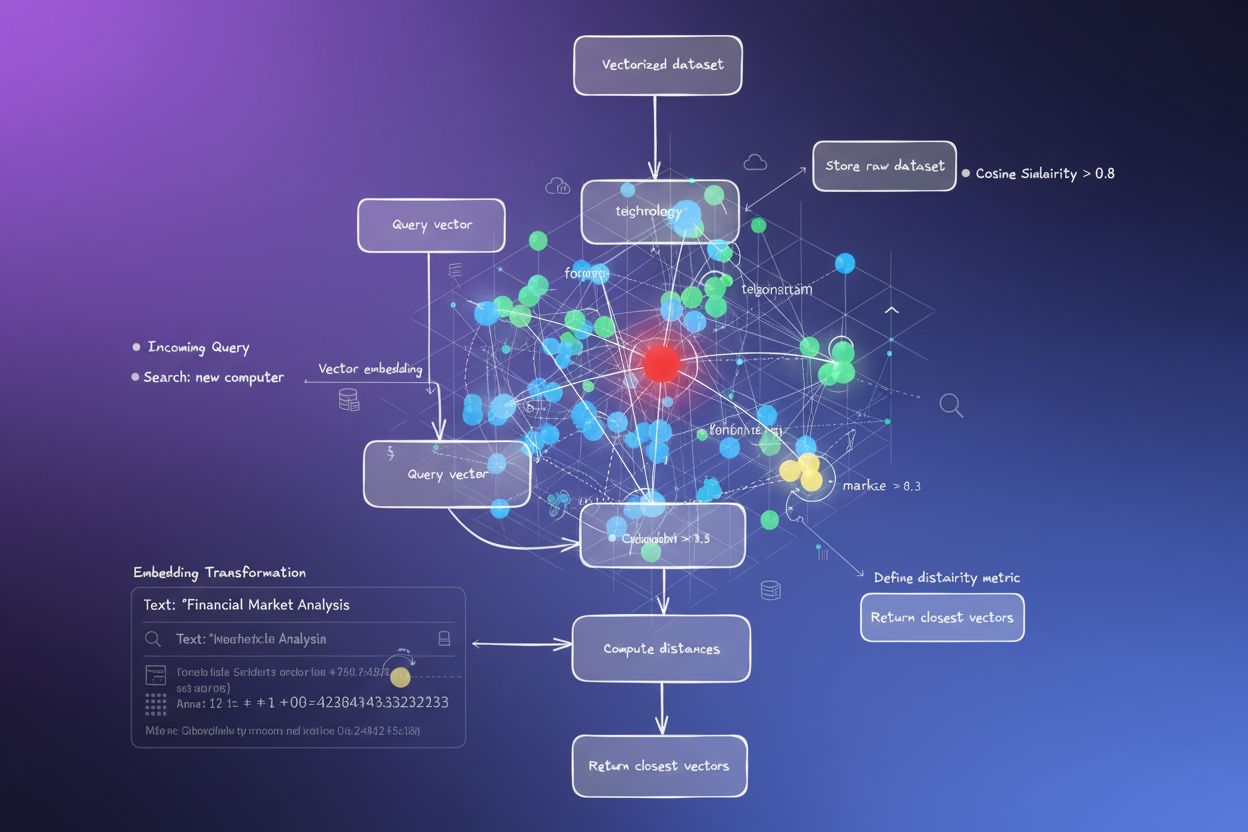

O processo de converter dados em vetores é chamado de embedding, realizado por modelos de aprendizado de máquina treinados em grandes conjuntos de dados. Esses modelos aprendem a mapear conceitos semelhantes para locais próximos no espaço vetorial por meio da exposição a bilhões de exemplos. Modelos comuns de embedding incluem Word2Vec, que aprende relações de palavras a partir do contexto; BERT (Bidirectional Encoder Representations from Transformers), que captura significado contextual; e CLIP (Contrastive Language-Image Pre-training), que lida com dados multimodais. Os embeddings resultantes normalmente variam de 100 a mais de 1.000 dimensões, criando uma rica representação matemática de relações semânticas. Quando um usuário faz uma busca, sua consulta é convertida em um vetor usando o mesmo modelo de embedding, e o sistema então calcula as distâncias entre o vetor de consulta e todos os vetores armazenados para identificar os itens mais semelhantes.

A busca vetorial depende de métricas de distância para quantificar o quão semelhantes dois vetores são. As três principais métricas são similaridade do cosseno, distância euclidiana e similaridade por produto escalar, cada uma com propriedades matemáticas e usos distintos. Similaridade do cosseno mede o ângulo entre dois vetores, variando de -1 a 1, onde 1 indica direção idêntica (máxima similaridade) e 0 indica vetores ortogonais (nenhuma relação). Essa métrica é especialmente valiosa para aplicações de PLN porque foca na direção semântica independentemente da magnitude do vetor, sendo ideal para comparar documentos de diferentes tamanhos. Distância euclidiana calcula a distância em linha reta entre vetores em um espaço multidimensional, considerando tanto magnitude quanto direção. Essa métrica é sensível à escala, sendo útil quando a magnitude dos vetores carrega informação relevante, como em sistemas de recomendação em que a frequência de compra importa.

A similaridade por produto escalar combina aspectos das duas métricas, considerando magnitude e direção, além de oferecer eficiência computacional. Muitos modelos de linguagem de grande porte usam produto escalar durante o treinamento, tornando-o a escolha apropriada para essas aplicações. A seleção da métrica correta é crucial—pesquisas mostram que usar a mesma métrica utilizada para treinar seu modelo de embedding produz resultados ótimos. Por exemplo, o modelo all-MiniLM-L6-v2 foi treinado usando similaridade do cosseno, então utilizar essa métrica no índice proporcionará os resultados mais precisos. Organizações que implementam busca vetorial devem alinhar cuidadosamente sua métrica escolhida ao modelo de embedding e ao caso de uso para garantir precisão e desempenho.

| Aspecto | Busca Vetorial | Busca por Palavras-chave | Busca Híbrida |

|---|---|---|---|

| Método de Correspondência | Similaridade semântica baseada em significado | Coincidência exata de palavra ou frase | Combina correspondência semântica e de palavras-chave |

| Compreensão da Consulta | Compreende intenção e contexto | Exige que palavras-chave estejam presentes | Aproveita ambas abordagens para resultados abrangentes |

| Tratamento de Sinônimos | Encontra automaticamente sinônimos e termos relacionados | Perde sinônimos salvo se explicitamente indexados | Captura sinônimos pelas duas abordagens |

| Desempenho em Consultas Ambíguas | Excelente—compreende intenção | Ruim—exige palavras-chave precisas | Muito bom—abrange ambas interpretações |

| Custo Computacional | Maior—requer embedding e cálculos de similaridade | Menor—simples comparação de strings | Moderado—executa ambas buscas em paralelo |

| Escalabilidade | Requer bancos de dados vetoriais especializados | Funciona com bancos de dados tradicionais | Requer sistemas compatíveis com busca híbrida |

| Casos de Uso | Busca semântica, recomendações, RAG, detecção de anomalias | Busca por frase exata, dados estruturados | Busca corporativa, monitoramento de IA, rastreamento de marcas |

| Exemplo | Buscar “ideias de jantar saudável” encontra “preparo de refeições nutritivas” | Só encontra resultados com as palavras exatas “saudável” e “jantar” | Encontra tanto coincidências exatas quanto conteúdo semanticamente relacionado |

Implementar a busca vetorial envolve várias etapas interconectadas que transformam dados brutos em representações semânticas pesquisáveis. O primeiro passo é a ingestão e pré-processamento dos dados, onde documentos, imagens ou outros dados são limpos e normalizados. Em seguida ocorre a transformação vetorial, onde um modelo de embedding converte cada item em um vetor numérico, normalmente com 100 a mais de 1.000 dimensões. Esses vetores são então armazenados em um banco de dados vetorial ou estrutura de índice otimizada para dados de alta dimensão. Quando uma consulta chega, ela passa pelo mesmo processo de embedding para criar um vetor de consulta. O sistema então usa métricas de distância para calcular escores de similaridade entre o vetor da consulta e todos os vetores armazenados, ranqueando os resultados conforme a proximidade com a consulta.

Para tornar esse processo eficiente em escala, sistemas empregam algoritmos Approximate Nearest Neighbor (ANN) como HNSW (Hierarchical Navigable Small World), IVF (Índice de Arquivo Invertido) ou ScaNN (Scalable Nearest Neighbors). Esses algoritmos trocam precisão perfeita por velocidade, permitindo buscas entre milhões ou bilhões de vetores em milissegundos ao invés de segundos. O HNSW, por exemplo, organiza vetores em uma estrutura de grafo multinível onde os níveis superiores contêm conexões de longo alcance para travessia rápida, enquanto os inferiores mantêm conexões curtas para precisão. Essa abordagem hierárquica reduz a complexidade da busca de O(n) linear para O(log n) logarítmica, tornando a busca vetorial em grande escala viável. A escolha do algoritmo depende de fatores como tamanho do conjunto de dados, volume de consultas, requisitos de latência e recursos computacionais disponíveis.

A busca vetorial tornou-se essencial para plataformas de monitoramento de IA como o AmICited que rastreiam menções de marcas em sistemas de IA. O monitoramento tradicional baseado em palavras-chave perderia menções parafraseadas, referências contextuais e variações semânticas de nomes de marca ou URLs de domínio. A busca vetorial permite que essas plataformas detectem quando sua marca é mencionada em respostas geradas por IA mesmo quando a redação exata é diferente. Por exemplo, se seu domínio é “amicited.com”, a busca vetorial pode identificar menções como “plataforma de monitoramento de prompts de IA” ou “visibilidade de marca em IA generativa” como relacionadas ao seu negócio, mesmo sem menções explícitas à URL. Essa compreensão semântica é crucial para um rastreamento abrangente de citações de IA em ChatGPT, Perplexity, Google AI Overviews e Claude.

O mercado de tecnologia de busca vetorial está crescendo rapidamente, refletindo o reconhecimento do seu valor pelo setor empresarial. Segundo pesquisas de mercado, o mercado de bancos de dados vetoriais foi avaliado em US$ 1,97 bilhão em 2024 e tem projeção de atingir US$ 10,60 bilhões até 2032, crescendo a uma taxa anual composta (CAGR) de 23,38%. Além disso, a Databricks relatou crescimento de 186% na adoção de bancos de dados vetoriais apenas no primeiro ano após o lançamento público da busca vetorial em dezembro de 2023. Essa rápida adoção demonstra que as empresas cada vez mais reconhecem a busca vetorial como infraestrutura crítica para aplicações de IA. Para organizações que monitoram sua presença em sistemas de IA, a busca vetorial fornece a compreensão semântica necessária para capturar todas as menções relevantes, e não apenas coincidências exatas de palavras-chave.

O desempenho da busca vetorial em escala depende criticamente de técnicas sofisticadas de indexação que equilibram velocidade, precisão e uso de memória. O HNSW (Hierarchical Navigable Small World) tornou-se uma das abordagens mais populares, organizando vetores em um grafo multinível onde cada camada contém conexões de alcance progressivamente menor. O algoritmo inicia as buscas na camada superior, com conexões de longo alcance para travessia rápida, e desce por camadas com conexões cada vez mais precisas. Pesquisas mostram que o HNSW alcança desempenho de ponta com taxas de recall superiores a 99% mantendo latências de consulta abaixo de um milissegundo. No entanto, o HNSW exige memória significativa—benchmarks mostram que indexar 1 milhão de vetores pode exigir de 0,5GB a 5GB dependendo dos parâmetros, tornando a otimização de memória importante em implantações de grande escala.

O IVF (Índice de Arquivo Invertido) oferece uma abordagem alternativa ao agrupar vetores e indexá-los por centróides de clusters. Essa técnica reduz o espaço de busca ao focar nos clusters relevantes em vez de pesquisar todos os vetores. O ScaNN (Scalable Nearest Neighbors), desenvolvido pelo Google Research, é otimizado especificamente para busca por produto interno e oferece excelente desempenho para sistemas de recomendação. A Product Quantization (PQ) comprime vetores dividindo-os em subvetores e quantizando cada um independentemente, reduzindo o uso de memória em 10 a 100 vezes ao custo de alguma precisão. Organizações que implementam busca vetorial devem escolher cuidadosamente técnicas de indexação conforme seus requisitos específicos—seja priorizando precisão de recall, velocidade de busca, eficiência de memória ou uma combinação desses fatores. O campo segue evoluindo rapidamente, com novos algoritmos e técnicas de otimização surgindo regularmente para enfrentar os desafios computacionais das operações vetoriais de alta dimensão.

A definição e aplicação da busca vetorial continuam evoluindo à medida que sistemas de IA se tornam mais sofisticados e a adoção corporativa se acelera. A direção futura aponta para sistemas de busca híbrida, que combinam busca vetorial com busca tradicional por palavras-chave e capacidades avançadas de filtragem. Essas abordagens híbridas aproveitam a compreensão semântica da busca vetorial mantendo a precisão e familiaridade da busca por palavras-chave, entregando resultados superiores para consultas complexas. Além disso, a busca vetorial multimodal está emergindo como capacidade crítica, permitindo que sistemas busquem simultaneamente em texto, imagens, áudio e vídeo por meio de espaços de embedding unificados. Esse desenvolvimento possibilitará experiências de busca mais intuitivas e abrangentes em diferentes tipos de dados.

Para organizações que monitoram sua presença em sistemas de IA, a evolução da busca vetorial traz profundas implicações. À medida que plataformas de IA como ChatGPT, Perplexity, Google AI Overviews e Claude passam a depender cada vez mais da busca vetorial para recuperação e ranqueamento de conteúdo, compreender como sua marca aparece semanticamente torna-se tão importante quanto a visibilidade tradicional por palavras-chave. A mudança para compreensão semântica significa que monitoramento de marca e rastreamento de citações em IA precisam evoluir além da simples detecção de palavras-chave para captar menções contextuais e relações semânticas. Organizações que investirem na compreensão da busca vetorial e suas aplicações estarão mais bem posicionadas para otimizar sua visibilidade em sistemas de IA generativa. A convergência da tecnologia de busca vetorial com plataformas de monitoramento de IA representa uma mudança fundamental em como marcas entendem e gerenciam sua presença no cenário informacional impulsionado por IA.

A busca tradicional por palavras-chave procura por coincidências exatas de palavras em documentos, enquanto a busca vetorial compreende significado semântico e contexto. A busca vetorial converte o texto em representações numéricas chamadas embeddings, permitindo encontrar resultados relevantes mesmo quando as palavras-chave exatas não coincidem. Por exemplo, ao buscar por 'fones de ouvido sem fio' usando busca vetorial, também serão retornados resultados para 'fones Bluetooth' porque compartilham significado semântico semelhante, ao passo que a busca por palavra-chave perderia essa conexão.

Embeddings vetoriais são representações numéricas de dados (texto, imagens, áudio) convertidos em arrays de números que capturam significado semântico. Eles são criados usando modelos de aprendizado de máquina como Word2Vec, BERT ou modelos baseados em transformers que aprendem a mapear conceitos semelhantes próximos uns dos outros em um espaço de alta dimensão. Por exemplo, as palavras 'rei' e 'rainha' teriam embeddings posicionados próximos porque compartilham relações semânticas, enquanto 'rei' e 'banana' estariam distantes.

As três principais métricas de distância são similaridade do cosseno (mede o ângulo entre vetores), distância euclidiana (mede a distância em linha reta) e similaridade por produto escalar (considera magnitude e direção). A similaridade do cosseno é a mais comum para aplicações de PLN porque foca na direção semântica independentemente da magnitude do vetor. A escolha da métrica deve corresponder à usada no treinamento do seu modelo de embedding para máxima precisão.

A busca vetorial permite que plataformas de monitoramento de IA como o AmICited rastreiem menções de marcas em sistemas de IA (ChatGPT, Perplexity, Google AI Overviews, Claude) compreendendo contexto semântico em vez de apenas coincidências exatas de palavras-chave. Isso possibilita detectar menções parafraseadas, conceitos relacionados e referências contextuais à sua marca, proporcionando visibilidade abrangente de como seu domínio aparece em respostas geradas por IA em múltiplas plataformas.

Algoritmos ANN como HNSW (Hierarchical Navigable Small World) permitem buscas rápidas por similaridade entre milhões de vetores ao encontrar vizinhos aproximados em vez de exatos. Esses algoritmos usam estruturas de grafos hierárquicos para reduzir a complexidade da busca de linear para logarítmica, tornando a busca vetorial viável em larga escala. O HNSW organiza vetores em grafos multiníveis, onde conexões de longo alcance ficam nos níveis superiores para travessia mais rápida.

Empresas geram enormes quantidades de dados não estruturados (e-mails, documentos, chamados de suporte) que a busca tradicional por palavras-chave não consegue organizar de forma eficiente. A busca vetorial permite compreensão semântica desses dados, alimentando aplicações como busca inteligente, sistemas de recomendação, detecção de anomalias e geração aumentada por recuperação (RAG). Segundo pesquisas de mercado, o mercado de bancos de dados vetoriais deve crescer de US$ 2,65 bilhões em 2025 para US$ 8,95 bilhões até 2030, refletindo a adoção corporativa.

Bancos de dados vetoriais são sistemas especializados otimizados para armazenar, indexar e consultar dados vetoriais de alta dimensão. Eles implementam técnicas de indexação eficientes como HNSW, IVF (Índice de Arquivo Invertido) e ScaNN para permitir buscas rápidas por similaridade em escala. Exemplos incluem Milvus, Pinecone, Weaviate e Zilliz Cloud. Esses bancos de dados lidam com a complexidade computacional das operações vetoriais, possibilitando que organizações construam buscas semânticas e aplicações de IA prontas para produção sem gerenciar a complexidade da infraestrutura.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Saiba como a busca vetorial utiliza embeddings de aprendizado de máquina para encontrar itens semelhantes com base no significado, em vez de palavras-chave exat...

A busca semântica interpreta o significado e o contexto da consulta usando PLN e aprendizado de máquina. Saiba como ela difere da busca por palavras-chave, impu...

Descubra como os embeddings vetoriais permitem que sistemas de IA entendam o significado semântico e façam a correspondência entre conteúdo e consultas. Explore...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.