Cum să configurezi robots.txt pentru crawlere AI: Ghid complet

Află cum să configurezi robots.txt pentru a controla accesul crawlerelor AI inclusiv GPTBot, ClaudeBot și Perplexity. Gestionează vizibilitatea brandului tău în...

Configurarea robots.txt cu reguli pentru user-agent care vizează în mod specific crawlerii AI. AI-specific robots.txt permite proprietarilor de site-uri să controleze modul în care sistemele de inteligență artificială, modelele lingvistice mari și boții de antrenament AI accesează și utilizează conținutul lor. Distingând între diferite tipuri de crawlere AI—crawlere de antrenament, crawlere de căutare și crawlere declanșate de utilizatori—permite control granular asupra vizibilității conținutului pentru sistemele AI. Această configurare a devenit esențială deoarece crawlerii AI reprezintă acum aproximativ 80% din traficul de boți către multe site-uri.

Configurarea robots.txt cu reguli pentru user-agent care vizează în mod specific crawlerii AI. AI-specific robots.txt permite proprietarilor de site-uri să controleze modul în care sistemele de inteligență artificială, modelele lingvistice mari și boții de antrenament AI accesează și utilizează conținutul lor. Distingând între diferite tipuri de crawlere AI—crawlere de antrenament, crawlere de căutare și crawlere declanșate de utilizatori—permite control granular asupra vizibilității conținutului pentru sistemele AI. Această configurare a devenit esențială deoarece crawlerii AI reprezintă acum aproximativ 80% din traficul de boți către multe site-uri.

Configurarea AI-specific robots.txt se referă la practica de a crea reguli țintite în fișierul robots.txt care vizează în mod specific crawlerele și boții de antrenament AI, distinct de crawlerele tradiționale ale motoarelor de căutare precum Googlebot. În timp ce robots.txt convențional s-a concentrat istoric pe gestionarea Googlebot, Bingbot și a altor indexatori de căutare, apariția modelelor lingvistice mari și a sistemelor de antrenament AI a generat o nouă categorie de trafic de boți care necesită strategii de management separate. Potrivit datelor recente din noiembrie 2025, crawlerele AI reprezintă acum aproximativ 80% din tot traficul de boți către multe site-uri de publisheri, schimbând fundamental importanța configurării robots.txt de la un instrument opțional de SEO la un mecanism critic de protecție a conținutului. Această distincție contează deoarece crawlerele de antrenament AI funcționează după modele de business diferite față de motoarele de căutare—ele colectează date pentru a antrena modele proprietare, nu pentru a genera trafic de referință—făcând ca schimbul tradițional de a permite crawlerele pentru vizibilitate în căutări să nu mai fie valabil. Pentru publisheri, aceasta înseamnă că deciziile robots.txt influențează direct vizibilitatea conținutului pentru sistemele AI, potențiala utilizare neautorizată a conținutului proprietar în seturi de date de antrenament și impactul general asupra traficului și veniturilor generate de descoperirea AI.

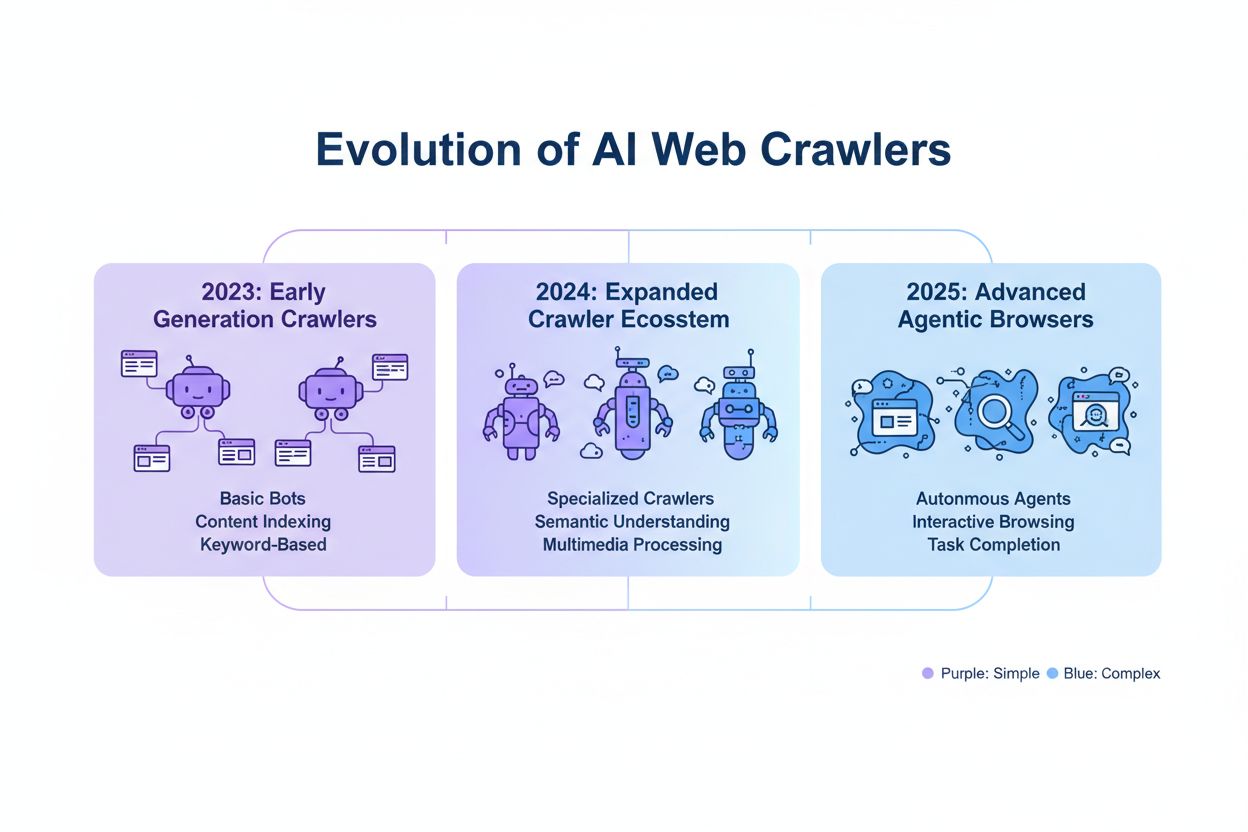

Crawlerele AI se încadrează în trei categorii operaționale distincte, fiecare cu caracteristici, implicații de trafic și considerente strategice diferite pentru publisheri. Crawlerele de antrenament sunt concepute pentru a colecta volume mari de date text pentru dezvoltarea modelelor de învățare automată; acestea operează de obicei cu cerințe mari de lățime de bandă, generează încărcare semnificativă pe server și nu furnizează trafic de referință—exemple: GPTBot de la OpenAI și ClaudeBot de la Anthropic. Crawlerele de căutare și citare funcționează asemănător motoarelor de căutare tradiționale, indexând conținutul pentru regăsire și asigurând atribuirea; ele generează volume moderate de trafic și pot aduce trafic de referință prin citări și linkuri—această categorie include OAI-SearchBot de la OpenAI și crawlerul AI Overviews de la Google. Crawlerele declanșate de utilizatori operează la cerere, când utilizatorii solicită explicit analiză AI a unei pagini web, cum ar fi funcția de navigare web a ChatGPT sau analiza de documente a lui Claude; acestea generează volume mai mici de trafic, dar reprezintă interacțiune directă cu conținutul tău. Această clasificare contează strategic deoarece crawlerele de antrenament prezintă cele mai mari riscuri pentru protecția conținutului cu beneficii minime de business, crawlerele de căutare oferă un compromis cu potențial de referință, iar crawlerele declanșate de utilizatori se aliniază de regulă cu intenția utilizatorului și pot crește vizibilitatea conținutului.

| Categoria de Crawler | Scop | Volum de trafic | Potențial de referință | Risc pentru conținut | Exemple |

|---|---|---|---|---|---|

| Antrenament | Dezvoltare de modele | Foarte mare | Niciunul | Foarte mare | GPTBot, ClaudeBot |

| Căutare/Citare | Indexare & atribuire | Moderat | Moderat | Moderat | OAI-SearchBot, Google AI |

| Declanșat de utilizator | Analiză la cerere | Scăzut | Scăzut | Scăzut | ChatGPT Web Browse, Claude |

Companiile AI majore care operează crawlere includ OpenAI, Anthropic, Google, Meta, Apple și Amazon, fiecare cu stringuri user-agent distincte, ce permit identificarea în logurile de server și configurarea robots.txt. OpenAI operează mai multe crawlere: GPTBot (user-agent: GPTBot/1.0) pentru colectarea datelor de antrenament, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) pentru indexare și citare, și ChatGPT-User (user-agent: ChatGPT-User/1.0) pentru navigare web la cerere. Crawlerul principal al Anthropic este ClaudeBot (user-agent: Claude-Web/1.0 sau anthropic-ai) folosit pentru antrenament și dezvoltarea bazei de cunoștințe. Google operează Google-Extended (user-agent: Google-Extended/1.1) pentru Gemini și alte produse AI, Meta folosește facebookexternalhit pentru analiză de conținut, Apple operează AppleBot pentru Siri și funcții de căutare, iar Amazon folosește Amazonbot pentru Alexa și căutare. Pentru a identifica acești crawlere în logurile serverului, examinează headerul User-Agent din cererile HTTP—majoritatea crawlerelor AI legitime includ numele companiei și numărul versiunii. Pentru securitate sporită, poți verifica legitimitatea crawlerului prin compararea adresei IP a cererii cu intervalele publicate de fiecare companie; OpenAI, Google și alți furnizori majori publică aceste intervale, permițându-ți să distingi între crawlere legitime și user-agent-uri falsificate.

Sintaxa de bază pentru regulile AI-specific robots.txt respectă formatul standard robots.txt cu potrivire user-agent și directive allow/disallow direcționate către crawlere specifice. Pentru a bloca GPTBot-ul OpenAI de la colectarea datelor de antrenament, dar a permite crawlerul lor de căutare, ai structura robots.txt astfel:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Pentru un control mai granular, poți aplica reguli pe anumite căi pentru a bloca accesul crawlerelor AI la conținut cu plată sau la secțiuni cu conținut generat de utilizatori:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Poți grupa mai multe user-agent-uri sub același set de reguli pentru a aplica restricții identice mai multor crawlere, reducând astfel complexitatea configurației. Testarea și validarea configurației robots.txt este esențială; instrumente precum robots.txt tester din Google Search Console și validatoare terțe pot verifica dacă regulile tale sunt sintactic corecte și vor fi interpretate corect de crawlere. Ține minte că robots.txt are rol consultativ și nu este obligatoriu—crawlerele conforme vor respecta regulile, dar actorii malițioși sau boții neconformi le pot ignora complet, fiind necesare mecanisme suplimentare de protecție la nivel de server pentru conținutul sensibil.

Decizia de a bloca sau permite crawlerele AI implică compromisuri fundamentale între protecția conținutului și vizibilitate, care diferă semnificativ în funcție de modelul de business și strategia de conținut. Blocarea crawlerelor de antrenament precum GPTBot elimină riscul ca conținutul tău să fie folosit la antrenarea modelelor AI fără compensație, dar înseamnă și că acesta nu va apărea în răspunsuri generate de AI, reducând potențial descoperirea și traficul din partea utilizatorilor AI. Pe de altă parte, permiterea crawlerelor de antrenament crește probabilitatea ca conținutul să fie inclus în seturi de date de antrenament AI, posibil fără atribuție sau compensație, dar poate crește vizibilitatea dacă aceste sisteme AI citează sau fac referire la conținutul tău. Decizia strategică ar trebui să ia în calcul avantajul competitiv al conținutului—cercetarea proprietară, analizele originale și datele unice justifică blocare mai strictă, în timp ce conținutul educațional evergreen sau informația comună pot beneficia de vizibilitate AI extinsă. Tipuri diferite de publisheri au calcule diferite: organizațiile de știri pot permite crawlere de căutare pentru trafic din citări, dar bloca pe cele de antrenament; publisherii educaționali pot permite acces mai larg pentru a crește acoperirea, iar companiile SaaS pot bloca toate crawlerele AI pentru a-și proteja documentația proprietară. Monitorizarea impactului deciziilor de blocare prin loguri de server și analitice de trafic este esențială pentru a valida dacă configurația îți atinge obiectivele de business.

Deși robots.txt oferă un mecanism clar de comunicare a politicilor pentru crawlere, este fundamental consultativ și nu are forță legală—crawlerele conforme vor respecta regulile, dar actorii neconformi le pot ignora, necesitând niveluri tehnice suplimentare de aplicare. Verificarea IP și allowlisting-ul reprezintă cea mai fiabilă metodă de aplicare; menținând o listă de adrese IP legitime publicate de OpenAI, Google, Anthropic și alți mari furnizori AI, poți verifica dacă cererile pretinzând că vin de la aceste crawlere provin cu adevărat de pe infrastructura lor. Regulile de firewall și blocarea la nivel de server oferă cel mai puternic mecanism de aplicare, permițând respingerea cererilor de la anumite user-agent-uri sau intervale de IP la nivel de rețea, înainte ca acestea să consume resurse de server. Pentru serverele Apache, configurația .htaccess poate impune restricții pentru crawlere:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta tag-urile din secțiunea head a HTML-ului oferă control granular, la nivel de pagină, asupra accesului crawlerelor fără a modifica robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Verificarea regulată a logurilor de server pentru activitatea crawlerelor te ajută să identifici crawlere noi, să verifici dacă regulile tale sunt respectate și să detectezi user-agent-uri falsificate care încearcă să ocolească restricțiile. Instrumente precum Knowatoa și Merkle oferă validare și monitorizare automate a configurației robots.txt și comportamentului crawlerelor, oferind vizibilitate asupra crawlerelor care accesează site-ul și dacă acestea respectă directivele tale.

Mentenanța continuă a configurației tale AI-specific robots.txt este esențială deoarece peisajul crawlerelor AI evoluează rapid, cu crawlere noi care apar constant și crawlere existente care își modifică stringurile user-agent și comportamentul. Strategia ta de monitorizare ar trebui să includă:

Evoluția rapidă a tehnologiei crawlerelor AI înseamnă că o configurație robots.txt care era potrivită în urmă cu șase luni s-ar putea să nu mai reflecte nevoile sau riscurile actuale, făcând revizuirea regulată și adaptarea esențiale pentru menținerea protecției eficiente a conținutului.

Noua generație de crawlere AI aduce provocări pe care configurarea tradițională robots.txt nu le mai poate gestiona eficient. Crawlerele de tip browser agentic, precum ChatGPT Atlas și Google Project Mariner, operează ca browsere web complete, randând JavaScript, executând interacțiuni de utilizator și comportându-se identic cu utilizatorii umani—aceste crawlere nu se identifică prin stringuri user-agent distinctive, făcând blocarea bazată pe robots.txt ineficientă. Multe crawlere emergente adoptă stringuri user-agent standard de Chrome pentru a evita detectarea și blocarea, mascându-și identitatea pentru a ocoli regulile robots.txt și alte controale de acces. Această tendință determină trecerea către blocarea pe bază de IP ca o necesitate emergentă, unde publisherii trebuie să mențină allowlist-uri cu IP-urile crawlerelor legitime și să blocheze tot traficul din surse suspecte, schimbând fundamental modelul de aplicare de la potrivirea user-agent la controlul accesului la nivel de rețea. User-agent-urile falsificate și tehnicile de evitare devin tot mai frecvente, actorii rău-intenționați pretinzând că sunt crawlere legitime sau folosind stringuri generice pentru a scăpa de detecție. Viitorul managementului crawlerelor AI va necesita o abordare multi-strat, combinând configurarea robots.txt, verificarea IP, reguli de firewall și, eventual, analiză comportamentală pentru a distinge crawlerele legitime de actorii malițioși. A rămâne informat despre tehnologiile emergente și a participa la discuții de industrie despre etica și standardele crawlerelor este esențial pentru publisherii care doresc să mențină strategii eficiente de protecție a conținutului.

Implementarea unei configurații eficiente AI-specific robots.txt necesită o abordare cuprinzătoare care să echilibreze protecția conținutului cu obiectivele strategice de vizibilitate. Începe cu o politică clară de protecție a conținutului care să definească ce categorii de conținut trebuie blocate (cercetare proprietară, conținut premium, conținut generat de utilizatori) versus ce poate fi expus crawlerelor AI (articole publice, conținut educațional, informație comună). Aplică o strategie de blocare pe niveluri care să distingă între crawlerele de antrenament (de regulă se blochează), crawlerele de căutare (de regulă se permit cu monitorizare) și crawlerele declanșate de utilizatori (de regulă se permit), în loc să aplici o abordare generală de tip totul permis sau totul blocat. Combină robots.txt cu mecanisme de aplicare la nivel de server implementând reguli de firewall și verificare IP pentru cel mai sensibil conținut, recunoscând că robots.txt singur nu este suficient pentru o protecție robustă. Integrează managementul crawlerelor AI în strategia ta SEO și de conținut luând în calcul cum deciziile de blocare îți afectează vizibilitatea în răspunsuri generate de AI, citări și funcții de căutare AI—această integrare asigură că robots.txt îți susține și nu subminează obiectivele generale de business. Stabilește o cadență de monitorizare și mentenanță cu revizuiri săptămânale ale logurilor, verificare lunară a IP-urilor și audituri trimestriale pentru a te asigura că configurația rămâne eficientă pe măsură ce peisajul crawlerelor evoluează. Folosește instrumente precum AmICited.com pentru a monitoriza vizibilitatea conținutului tău în sistemele AI și pentru a înțelege impactul deciziilor de blocare asupra descoperirii și citării AI. Pentru diferite tipuri de publisheri: organizațiile de știri ar trebui să permită de regulă crawlerele de căutare și să blocheze pe cele de antrenament pentru a maximiza traficul din citări; publisherii educaționali pot permite acces mai larg pentru creșterea acoperirii; iar companiile SaaS ar trebui să implementeze blocare strictă pentru documentația proprietară. Când blocarea robots.txt nu este suficientă din cauza user-agent-urilor falsificate sau a crawlerelor neconforme, treci la reguli de firewall și blocare pe bază de IP pentru a-ți aplica politicile de protecție a conținutului la nivel de rețea.

Crawlerele de antrenament precum GPTBot și ClaudeBot colectează date pentru dezvoltarea modelelor și nu generează trafic de referință, ceea ce le face cu risc ridicat pentru protecția conținutului. Crawlerele de căutare precum OAI-SearchBot și PerplexityBot indexează conținutul pentru căutarea AI și pot trimite trafic de referință prin citări. Majoritatea editorilor blochează crawlerele de antrenament și permit crawlerelor de căutare pentru a echilibra protecția conținutului cu vizibilitatea.

Google afirmă oficial că blocarea Google-Extended nu afectează clasamentul în căutări sau includerea în AI Overviews. Totuși, unii webmasteri au raportat îngrijorări, așa că monitorizează performanța în căutări după aplicarea blocărilor. AI Overviews din Google Search respectă regulile standard Googlebot, nu pe cele Google-Extended.

Da, robots.txt are rol consultativ și nu este obligatoriu. Crawlerele responsabile ale companiilor mari respectă în general directivele robots.txt, însă unele crawlere le pot ignora. Pentru protecție suplimentară, implementează blocare la nivel de server prin .htaccess sau reguli de firewall și verifică autenticitatea crawlerelor folosind intervalele de IP publicate.

Revizuiește și actualizează lista de blocare cel puțin trimestrial. Apar constant noi crawlere AI, așa că verifică lunar jurnalele de server pentru a identifica crawlere noi care accesează site-ul. Urmărește resursele comunității precum proiectul GitHub ai.robots.txt pentru actualizări privind crawlerele emergente și user-agent-urile acestora.

Depinde de prioritățile afacerii tale. Blocarea crawlerelor de antrenament îți protejează conținutul de a fi inclus în modele AI fără compensație. Blocarea crawlerelor de căutare îți poate reduce vizibilitatea pe platforme AI precum ChatGPT search sau Perplexity. Mulți editori aleg blocarea selectivă, vizând crawlerele de antrenament și permițându-le pe cele de căutare și citare.

Verifică jurnalele de server pentru stringurile user-agent ale crawlerelor și asigură-te că cele blocate nu accesează paginile de conținut. Folosește instrumente de analiză pentru a monitoriza tiparele de trafic de boți. Testează configurația cu Knowatoa AI Search Console sau Merkle robots.txt Tester pentru a valida că regulile funcționează conform intenției.

Crawlerele de tip browser agentic, precum ChatGPT Atlas și Google Project Mariner, operează ca browsere web complete, nu doar ca clienți HTTP simpli. Acestea folosesc adesea stringuri user-agent standard de Chrome, ceea ce le face imposibil de distins de traficul obișnuit de browser. Pentru a controla accesul acestor crawlere avansate devine necesară blocarea pe bază de IP.

AI-specific robots.txt controlează accesul la conținutul tău, în timp ce instrumente precum AmICited monitorizează modul în care platformele AI fac referire și citează conținutul tău. Împreună, oferă vizibilitate și control complete: robots.txt gestionează accesul crawlerelor, iar instrumentele de monitorizare urmăresc impactul conținutului tău pe platformele AI.

AmICited urmărește modul în care sistemele AI precum ChatGPT, Claude, Perplexity și Google AI Overviews citează și fac referire la brandul tău. Combină configurarea robots.txt cu monitorizarea vizibilității AI pentru a înțelege impactul conținutului tău pe platformele AI.

Află cum să configurezi robots.txt pentru a controla accesul crawlerelor AI inclusiv GPTBot, ClaudeBot și Perplexity. Gestionează vizibilitatea brandului tău în...

Discuție în comunitate despre configurarea robots.txt pentru crawlerele AI precum GPTBot, ClaudeBot și PerplexityBot. Experiențe reale de la webmasteri și speci...

Află ce crawlere AI să permiți sau să blochezi în robots.txt. Ghid cuprinzător despre GPTBot, ClaudeBot, PerplexityBot și peste 25 de crawlere AI, cu exemple de...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.