Hur Får Advokatbyråer AI-synlighet i ChatGPT, Perplexity och AI-sökmotorer

Lär dig hur advokatbyråer förbättrar sin synlighet i AI-drivna sökmotorer och svarsgeneratorer. Upptäck strategier för att synas i ChatGPT, Perplexity och Googl...

Upptäck hur advokatbyråer kan optimera AI-synlighet samtidigt som de upprätthåller etiska normer. Lär dig ABA-riktlinjer, sekretessprotokoll och praktiska strategier för AI-driven juridisk marknadsföring.

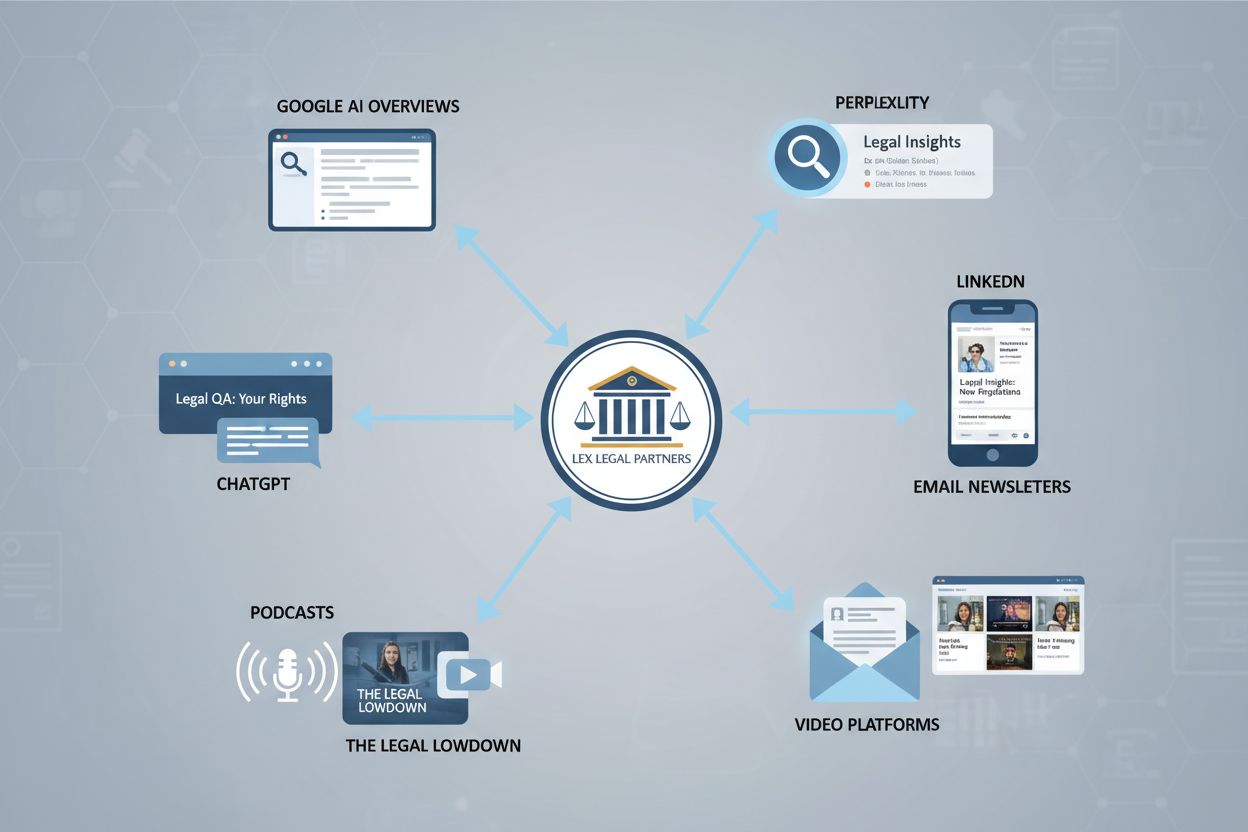

Landskapet för upptäckt av juridiska tjänster har förändrats i grunden bortom traditionell sökmotoroptimering. Advokatbyråer kan inte längre enbart förlita sig på Google-placeringar för att säkerställa synlighet—potentiella klienter hittar nu juridisk expertis via AI-drivna plattformar, chattbottar, röstassistenter och specialiserade juridiska forskningstjänster som verkar oberoende av traditionella sökresultat. Dessa AI-system tränas på olika innehållsformat som blogginlägg, innehåll från sociala medier, videotranskriptioner, poddar och klientomdömen, vilket innebär att din byrås synlighet beror på närvaro på flera ytor samtidigt. När en potentiell klient frågar ChatGPT, Claude eller en juridikspecifik AI-plattform om advokatrekommendationer hämtar systemet från träningsdata som kan inkludera din byrås innehåll från källor du aldrig optimerat för. Denna multi-surface-upptäcktsmodell kräver att advokatbyråer tänker bortom enkanalstrategier och istället utvecklar omfattande innehållsekosystem som förser AI-system med auktoritativ, korrekt information. Traditionella SEO-mått som sökordsrankningar och länkprofiler är fortfarande relevanta men otillräckliga—byråer måste nu övervaka hur deras innehåll visas i AI-genererade svar på dussintals plattformar. Denna förändring innebär både en utmaning och en möjlighet: byråer som förstår och anpassar sig till detta nya landskap får ett konkurrensförsprång, medan de som klamrar sig fast vid föråldrade synlighetsstrategier riskerar att bli osynliga för AI-drivna upptäcktsmekanismer.

American Bar Associations Formella Uttalande 512, utfärdat i juli 2024, ger avgörande vägledning för hur advokater måste närma sig AI-verktyg samtidigt som de upprätthåller etiska skyldigheter. Detta banbrytande uttalande fastslår att advokater är fullt ansvariga för AI-genererat arbetsmaterial, oavsett om de själva har skrivit innehållet eller delegerat det till ett AI-system. Uttalandet identifierar sju centrala etiska skyldigheter som berör AI-användning: kompetens i att förstå AI:s kapacitet och begränsningar, upprätthållande av klientsekretess, uppriktighet mot domstol, korrekt tillsyn över underställdas AI-användning, rimliga avgifter, kommunikation med klienter om AI-användning samt säkerställande av att anspråk förblir berättigade. Varje skyldighet har specifika konsekvenser för hur advokatbyråer etiskt kan använda AI för synlighet, innehållsskapande och klientkommunikation. Kompetenskravet innebär att delägare måste förstå inte bara hur man använder AI-verktyg, utan även deras noggrannhet, risker för hallucinationer och lämpliga användningsområden. Sekretesskraven innebär noggrant urval av leverantörer och datasäkerhetsprotokoll för att säkerställa att klientinformation aldrig blir träningsdata för tredje parts AI-system. Uppriktighet mot domstol innebär att all AI-genererad citat eller juridisk analys måste verifieras innan inlämning, då domstolar redan har sanktionerat advokater för att ha presenterat påhittad rättspraxis genererad av AI.

| Etisk skyldighet | AI-konsekvens | Åtgärd för advokatbyrå |

|---|---|---|

| Kompetens | Måste förstå AI-kapacitet, begränsningar och noggrannhet | Genomför utbildning i AI-verktyg; fastställ kompetensstandarder före införande |

| Sekretess | Klientdata riskerar tredje parts AI-leverantörer och LLM-träning | Noggrann leverantörsgranskning; använd lokala eller privata AI-lösningar; sanera data |

| Uppriktighet mot domstol | AI-genererade citat och juridisk analys måste verifieras | Inför obligatoriska verifieringsprotokoll; lämna aldrig in overifierat AI-material |

| Tillsyn | Ansvar för underställdas AI-användning och resultat | Skapa byråövergripande AI-policyer; övervaka användning; införa godkännandeprocesser |

| Rimliga avgifter | AI-effektivitet kan kräva avgiftsjusteringar | Kommunicera AI-användning till klienter; justera debitering för effektivitetsvinster |

| Klientkommunikation | Klienter har rätt till transparens om AI-inblandning | Redovisa AI-användning i uppdragsbrev; förklara hur det påverkar deras ärende |

| Berättigade anspråk | AI får inte användas för att driva oseriösa argument | Verifiera alla AI-genererade juridiska teorier; behåll oberoende bedömning |

Klientsekretess är den viktigaste etiska aspekten vid användning av AI-verktyg för advokatbyråers synlighet och innehållsskapande. Många populära AI-plattformar, inklusive gratisversioner av ChatGPT och andra stora språkmodeller, använder inskickad data för att träna framtida versioner av sina system, vilket innebär en oacceptabel risk att konfidentiell klientinformation kan exponeras eller av misstag refereras i svar till andra användare. Maryland State Bar Association och liknande tillsynsorgan har utfärdat specifik vägledning som varnar advokater för att mata in klientidentifierande information, ärendedetaljer eller privilegierad kommunikation i AI-system från tredje part utan uttryckliga avtalsmässiga skydd. Advokatbyråer måste införa rigorösa leverantörsgranskningsprocesser som undersöker datahanteringsrutiner, krypteringsstandarder, datalagringspolicyer och avtalsgarantier om att information inte används för modellträning. Saneringsprotokoll blir avgörande—all klientinformation som används i AI-assisterat innehåll måste noggrant anonymiseras, med identifierande detaljer borttagna och utbytta mot generiska exempel. Licensavtal med AI-leverantörer bör uttryckligen reglera dataägande, användningsrättigheter och ansvar vid överträdelser, med företräde för företagslösningar som erbjuder lokal installation eller privata instanser. Byråer bör också fastställa tydliga riktlinjer som skiljer på publikt innehåll (där AI-assistans oftast är acceptabelt) och konfidentiellt arbetsmaterial (där AI-användning kräver ökad vaksamhet och klientgodkännande). Regelbundna granskningar av AI-verktygsanvändning säkerställer regelefterlevnad, och personalutbildning måste betona att inte alla AI-applikationer är lämpliga för juridiskt arbete, oavsett effektivitetsvinster.

AI-hallucinationer—tillfällen då språkmodeller genererar trovärdiga men helt påhittade uppgifter—utgör ett allvarligt hot mot advokatbyråers trovärdighet och klientresultat. En hallucination uppstår när ett AI-system självsäkert presenterar falsk information som fakta, såsom att hitta på rättsfall, felcitera lagar eller skapa fiktiva rättspraxis som låter äkta men inte existerar. Juristbranschen har redan fått smärtsamma lärdomar: 2023 blev två New York-advokater sanktionerade och riskerade uteslutning efter att ha lämnat in en inlaga med sex påhittade fall genererade av ChatGPT, och 2024 mötte en Texas-advokat liknande konsekvenser för att ha förlitat sig på AI-genererade citat utan juridisk grund. Dessa incidenter visar att hallucinationer inte är teoretiska risker utan dokumenterade problem som lett till disciplinåtgärder och skadat klienters ärenden. Thomson Reuters forskning visar att nuvarande stora språkmodeller hallucinerar i 3–10 % av fallen beroende på uppgiftens komplexitet, vilket innebär att även till synes tillförlitliga AI-resultat kräver verifiering. Advokatbyråer måste införa obligatoriska human-in-the-loop-verifieringsprotokoll där all AI-genererad juridisk analys, citat eller faktauppgifter oberoende verifieras av kvalificerade advokater innan användning i klientarbete eller inlagor till domstol. För synlighets- och marknadsföringsinnehåll innebär hallucinationer ett rykterisk—påhittad statistik, felciterade experter eller uppdiktade exempel kan underminera byråns trovärdighet och utsätta den för ansvar. Att upprätta tydliga verifieringsflöden, använda AI främst för utkast och idéarbete snarare än slutlig analys, samt att föra detaljerade register över verifieringsprocesserna skyddar både klienter och byråns rykte.

Effektiv AI-synlighet kräver att advokatbyråer går bortom innehållsskapande i ett format och utvecklar heltäckande strategier som återanvänder kärnkompetens i flera kanaler och format. En enda välresearchad artikel om arbetsrätt kan bli basen för en video, ett audiogram för LinkedIn, ett poddavsnitt, inlägg på sociala medier, e-postnyhetsbrev och klientanpassade guider—varje format optimerat för olika AI-system och publikpreferenser. AI-verktyg är mycket effektiva för att påskynda denna återanvändningsprocess: de kan generera videomanus från artiklar, skapa inläggstexter för sociala medier, utforma e-postämnesrader och ta fram olika upplägg för olika målgrupper, men mänskliga advokater måste granska och förfina allt innehåll för noggrannhet och ton. Den strategiska fördelen uppstår när byråer inser att AI-system som tränas på olika innehållsformat stöter på din expertis i flera sammanhang, vilket ökar sannolikheten för citering i AI-genererade svar. Att utveckla promptmallar för vanliga innehållstyper—såsom “Skapa ett 3-minuters videomanus som förklarar [juridiskt ämne] för företagsägare utan juridisk bakgrund”—möjliggör konsekvent och effektiv innehållsproduktion med bibehållen kvalitet. Målgruppsanpassningen blir mer sofistikerad när du förstår vilka format som tilltalar olika klientsegment: företagsklienter föredrar fördjupade white papers och webbinarier, medan privatpersoner ofta svarar bättre på korta videor och innehåll för sociala medier. Byråer bör skapa redaktionella kalendrar som kopplar kärnkompetensområden till flera format, ge tydligt ansvar för AI-assisterat utkast och mänsklig granskning, och mäta engagemang över kanaler för att identifiera vilka format som genererar flest kvalificerade förfrågningar. Detta multiformatupplägg ger också naturliga möjligheter att länka samman innehåll, och skapa ett nät av resurser som AI-system känner igen som auktoritativ bevakning av specifika juridiska ämnen.

Traditionella marknadsföringsmått för advokatbyråer—webbtrafik, formulärinlämningar och telefonsamtal—ger en ofullständig bild av hur AI-system upptäcker och rekommenderar din byrå. Share of Voice (SOV) mäter vilken andel av AI-genererade svar om ditt rättsområde som nämner din byrå, vilket ger insikt i konkurrensläget i det AI-drivna upptäcktslandskapet. Visibility Score samlar flera datapunkter för att skapa ett omfattande mått på hur framträdande din byrå syns på AI-plattformar, sökmotorer och juridiska kataloger. Mention Frequency följer hur ofta din byrå, advokater och expertområden nämns i AI-genererat innehåll, medan Citation Metrics mäter om AI-system citerar ditt innehåll som auktoritativa källor. Topic Coverage visar hur heltäckande din byrås innehåll besvarar hela spektrumet av frågor potentiella klienter ställer om dina rättsområden. Dessa nyckeltal kräver specialiserade övervakningsverktyg framtagna för AI-synlighet, eftersom traditionella analysplattformar inte kan spåra omnämnanden i ChatGPT-svar, Claude-resultat eller specialiserade juridiska AI-plattformar.

Viktiga AI-synlighetsmått för advokatbyråer:

Engagemangsmått får ny betydelse i AI-synlighetssammanhang: när ditt innehåll visas i AI-svar, leder det till klick till din webbplats, formulärinlämningar eller telefonsamtal? Att spåra vilka AI-plattformar och innehållsformat som genererar de högst kvalificerade leads hjälper byråer att optimera sin innehållsstrategi och budgetfördelning. Advokatbyråer bör upprätta baslinjemätningar av nuvarande AI-synlighet innan nya strategier införs, och därefter följa upp kvartalsvis för att identifiera vilka innehållstyper, ämnen och format som ger starkast AI-närvaro. Detta datadrivna tillvägagångssätt ersätter gissningar med fakta, så att delägare kan motivera marknadsinvesteringar och förfina strategier baserat på faktisk prestation snarare än antaganden om vad AI-system prioriterar.

Effektiv AI-synlighet och etisk regelefterlevnad kräver formella styrningspolicyer som fastställer tydliga standarder för hur advokater, paralegals och stödfunktioner får använda AI-verktyg i sitt arbete. En omfattande AI-policy bör reglera tillåtna användningsområden, förbjudna applikationer, godkännandeprocesser och konsekvenser vid överträdelse, så att entusiasm för AI-effektivitet inte går före etiska skyldigheter. Policyn måste tydligt skilja mellan olika kategorier av AI-användning: innehållsskapande och marknadsföring (oftast acceptabelt med granskning), juridisk forskning och analys (kräver verifiering och advokatgranskning), klientkommunikation (kräver transparens och godkännande) samt konfidentiellt arbetsmaterial (kräver ökad vaksamhet och ofta klientgodkännande). Tillsynsskyldighet enligt ABA Formellt Uttalande 512 innebär att delägare ansvarar för att underställda använder AI korrekt, vilket kräver övervakningsmekanismer och regelbunden utbildning. Icke-juridisk personal behöver specifika riktlinjer kring vilka AI-verktyg de får använda, vilken information de får mata in och vilka uppgifter som kräver advokatgranskning innan slutförande. Kompetenskrav bör ange att advokater som använder AI-verktyg måste förstå deras kapacitet, begränsningar och noggrannhet—detta kan kräva formell utbildning, certifiering eller bevisad kompetens innan självständig användning tillåts. Policys bör även reglera hur byrån hanterar AI-uppdateringar, nya plattformar och framväxande risker, samt införa en process för regelbunden policyöversyn i takt med teknikutvecklingen. Dokumentation av policyimplementering, personalutbildning och efterlevnad skapar bevis för god tro att upprätthålla etiska standarder, vilket är viktigt om tillsynsmyndigheter ifrågasätter byråns AI-praktik.

Advokatbyråer som vill optimera AI-synlighet och samtidigt upprätthålla etiska normer bör anta ett strukturerat fyrpelarupplägg som omfattar innehåll, format, målgrupp och teknikinfrastruktur. Innehållsmotorn fokuserar på att utveckla auktoritativ, originell expertis inom dina kärnområden—detta innebär att identifiera de 20–30 viktigaste frågor klienter ställer om din verksamhet och skapa heltäckande, välresearchat innehåll som besvarar dessa frågor bättre än konkurrenterna. Format-pelaren säkerställer att detta kärninnehåll når AI-system via flera kanaler: skrivna artiklar för sökmotorer och juridiska databaser, videoinnehåll för YouTube och sociala plattformar, ljudinnehåll för poddar och röstassistenter samt strukturerad data som hjälper AI-system att förstå din expertis. Målgrupp-pelaren kräver segmentering och riktad kommunikation—olika klienttyper (företagskunder, privatpersoner, bolagsjurister) upptäcker juridiska tjänster via olika AI-plattformar och reagerar på olika innehållsformat, så din strategi måste möta varje segments föredragna upptäcktsvägar. Teknikstack-pelaren omfattar de verktyg och processer som möjliggör effektivt och regelrätt innehållsskapande: AI-skrivassistenter för utkast, verifieringsverktyg för noggrannhetskontroll, analysplattformar för mätning av AI-synlighet och styrsystem för etisk efterlevnad.

Konkret genomförande för 2025 inkluderar: att utföra en AI-synlighetsanalys för att fastställa baslinjemått över stora plattformar; ta fram en 12-månadersinnehållskalender som kopplar kärnkompetens till flera format; upprätta AI-styrningspolicyer och utbilda all personal i tillåten användning; välja och implementera verktyg för övervakning av AI-synlighet; skapa innehållsmallar och promptbibliotek för multiformatproduktion; samt införa kvartalsvisa uppföljningar för att mäta framsteg och justera strategin. Framgångsmått bör omfatta både kvantitativa mått (Share of Voice, omnämnandefrekvens, leadvolym) och kvalitativa bedömningar (leads-kvalitet, kundfeedback, konkurrensläge). Byråer som genomför denna plan systematiskt får ett tydligt konkurrensförsprång: de blir synliga för AI-drivna upptäcktsmekanismer, etablerar sig som auktoritativa källor som AI-system citerar och bygger hållbar synlighet även när AI-tekniken utvecklas. Byråerna som väntar eller närmar sig AI-synlighet slumpartat riskerar att bli osynliga i en alltmer AI-medierad marknad för juridiska tjänster och förlorar potentiella klienter till konkurrenter som optimerat sin närvaro på flera AI-plattformar och i olika format.

American Bar Association utfärdade Formellt Uttalande 512 i juli 2024, som fastställer att advokater är fullt ansvariga för AI-genererat arbetsmaterial och måste upprätthålla sju kärnetiska skyldigheter: kompetens, sekretess, uppriktighet mot domstol, tillsyn, rimliga avgifter, klientkommunikation och berättigade anspråk. Advokater måste förstå AI:s kapacitet och begränsningar innan användning.

Advokatbyråer bör genomföra noggrann leverantörsgranskning, använda lokala eller privata AI-lösningar, sanera all klientidentifierande information innan den matas in i AI-system och upprätta licensavtal med uttryckliga sekretessbestämmelser. Mata aldrig in konfidentiell information i gratis offentliga AI-verktyg som ChatGPT utan företagskydd.

AI-hallucinationer uppstår när språkmodeller genererar trovärdiga men helt påhittade uppgifter, såsom att hitta på rättsfall eller felcitera lagar. De är viktiga eftersom domstolar redan har sanktionerat advokater för att ha lämnat in AI-genererade falska fall, och hallucinationer kan skada klientens ärenden och byråns rykte. All AI-genererad juridisk analys måste verifieras oberoende.

Advokatbyråer bör följa AI-specifika mått såsom Share of Voice (procent av AI-svar som nämner din byrå), Visibility Score (omfattande mått över plattformar), Mention Frequency (hur ofta din byrå syns), Citation Metrics (om AI citerar ditt innehåll) och Topic Coverage (bredd av rättsområdesbevakning). Traditionella mått som webbtrafik är otillräckliga.

AI-system tränas på olika format inklusive skrivna artiklar, videotranskriptioner, poddar, sociala medier och strukturerad data. Advokatbyråer bör återanvända sin expertis i flera format—en enda artikel kan bli videor, audiogram, inlägg på sociala medier och e-postinnehåll. Detta multiformatsupplägg ökar sannolikheten för AI-citering och upptäckt.

Ja. ABA:s Formella Uttalande 512 fastslår att delägare bär ansvar för underställdas AI-användning. Omfattande AI-policyer bör reglera tillåtna användningsområden, förbjudna applikationer, godkännandeprocesser, sekretesskrav och personalutbildning. Policyerna måste skilja mellan innehållsskapande (oftast acceptabelt), juridisk analys (kräver verifiering) och konfidentiellt arbete (kräver ökad vaksamhet).

Inför ett human-in-the-loop-upplägg där AI hjälper till med utkast och idéer, men kvalificerade advokater verifierar allt innan användning. Upprätta tydliga verifieringsprotokoll, använd AI främst för effektivisering snarare än att ersätta professionell bedömning, för detaljerade register över verifieringsprocesser och säkerställ att hela personalen förstår att AI är ett verktyg för att förstärka expertis, inte ersätta den.

Konsument-AI-verktyg som ChatGPT tränas på allmän internetdata och hallucinerar i 3–10 % av fallen, vilket innebär allvarliga risker för juridiskt arbete. Juridikspecifika AI-verktyg är tränade på betrodda juridiska databaser och utformade för att begränsa hallucinationer, även om verifiering fortfarande krävs. Företagslösningar erbjuder bättre dataskydd och sekretessgarantier än gratis offentliga verktyg.

Följ hur AI-system refererar till din byrå och mät din närvaro i AI-genererade svar. Få ett konkurrensförsprång genom att förstå dina AI-synlighetsmått och optimera din närvaro på olika AI-plattformar.

Lär dig hur advokatbyråer förbättrar sin synlighet i AI-drivna sökmotorer och svarsgeneratorer. Upptäck strategier för att synas i ChatGPT, Perplexity och Googl...

Lär dig vad juridisk AI-synlighet innebär för advokatbyråer. Upptäck hur du optimerar din närvaro i AI-genererade juridiska svar, hanterar citeringsmått och byg...

Diskussion i communityt om hur advokatbyråer kan förbättra sin synlighet i AI-genererade svar. Riktiga erfarenheter från juridiska marknadsförare som spårar AI-...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.