Jak se liší AI vyhledávání od tradičního vyhledávání? Kompletní průvodce

Objevte klíčové rozdíly mezi AI vyhledávači a tradičním vyhledáváním. Zjistěte, jak se ChatGPT, Perplexity a Google AI Overviews liší od výsledků založených na ...

Objevte zásadní rozdíly mezi AI tréninkovými roboty a vyhledávacími roboty. Zjistěte, jak ovlivňují viditelnost vašeho obsahu, optimalizační strategie a AI citace.

Vyhledávací roboti jako Googlebot a Bingbot tvoří páteř tradičních vyhledávačů. Tito automatizovaní roboti systematicky procházejí web, objevují a indexují obsah, aby určili, co se zobrazí na stránkách s výsledky vyhledávání (SERP). Googlebot, provozovaný Googlem, je nejznámější a nejaktivnější vyhledávací robot, následuje Bingbot od Microsoftu a YandexBot od Yandexu. Tito roboti mají pokročilé schopnosti, které jim umožňují spouštět JavaScript, vykreslovat dynamický obsah a chápat složité struktury webů. Navštěvují weby často v závislosti na autoritě webu, čerstvosti obsahu a historii aktualizací, přičemž weby s vysokou autoritou jsou procházeny častěji. Hlavním cílem vyhledávacích robotů je indexace obsahu pro účely řazení ve vyhledávání, což znamená, že hodnotí stránky podle relevance, kvality a uživatelských signálů.

| Typ robota | Primární účel | Podpora JavaScriptu | Frekvence procházení | Cíl |

|---|---|---|---|---|

| Googlebot | Indexace pro pořadí ve vyhledávání | Ano (s omezeními) | Často, dle autority | Pořadí a viditelnost |

| Bingbot | Indexace pro pořadí ve vyhledávání | Ano (s omezeními) | Pravidelně, dle aktualizací | Pořadí a viditelnost |

| YandexBot | Indexace pro pořadí ve vyhledávání | Ano (s omezeními) | Pravidelně, dle signálů webu | Pořadí a viditelnost |

AI tréninkoví roboti představují zásadně odlišnou kategorii webových botů, jejichž cílem je sběr dat pro trénink velkých jazykových modelů (LLM), nikoli pro vyhledávací indexaci. GPTBot, provozovaný OpenAI, je nejvýznamnější AI tréninkový robot, následovaný ClaudeBot od Anthropic, PetalBot od Huawei a CCBot od Common Crawl. Na rozdíl od vyhledávacích robotů, které usilují o řazení obsahu, AI tréninkoví roboti se zaměřují na sběr kvalitních, kontextově bohatých informací pro zlepšení znalostní báze a generování odpovědí AI modelů. Tito roboti obvykle pracují méně často než vyhledávací roboti, často navštíví web jen jednou za několik týdnů či měsíců a upřednostňují kvalitu obsahu před jeho množstvím. Tento rozdíl je zásadní: zatímco váš obsah může být důkladně indexován Googlebotem pro viditelnost ve vyhledávání, GPTBot jej může pro trénink AI modelů projít jen částečně nebo zřídka.

| Typ robota | Primární účel | Podpora JavaScriptu | Frekvence procházení | Cíl |

|---|---|---|---|---|

| GPTBot | Sběr dat pro trénink LLM | Ne | Zřídka, selektivně | Kvalita tréninkových dat |

| ClaudeBot | Sběr dat pro trénink LLM | Ne | Zřídka, selektivně | Kvalita tréninkových dat |

| PetalBot | Sběr dat pro trénink LLM | Ne | Zřídka, selektivně | Kvalita tréninkových dat |

| CCBot | Sběr dat pro Common Crawl | Ne | Zřídka, selektivně | Kvalita tréninkových dat |

Technické rozdíly mezi vyhledávacími a AI tréninkovými roboty mají zásadní dopad na viditelnost obsahu. Nejpodstatnější rozdíl je spouštění JavaScriptu: vyhledávací roboti jako Googlebot dokáží spouštět JavaScript (s určitými omezeními), což jim umožňuje vidět dynamicky vykreslený obsah. AI tréninkoví roboti naopak JavaScript vůbec nespouštějí—zpracovávají jen surový HTML při prvním načtení stránky. Tento zásadní rozdíl znamená, že obsah načítaný dynamicky pomocí client-side skriptů zůstává pro AI roboty zcela neviditelný. Dále vyhledávací roboti respektují crawl budget a upřednostňují stránky podle architektury webu a vnitřního prolinkování, zatímco AI roboti procházejí selektivněji s důrazem na kvalitu. Vyhledávací roboti obecně přísně dodržují robots.txt, zatímco někteří AI roboti v minulosti nebyli v souladu tak transparentní. Frekvence procházení se dramaticky liší: vyhledávací roboti navštěvují aktivní weby několikrát týdně nebo i denně, zatímco AI tréninkoví roboti přicházejí jen jednou za několik týdnů či měsíců. Vyhledávací roboti jsou navrženi tak, aby rozuměli signálům pro pořadí a uživatelské zkušenosti, zatímco AI roboti se zaměřují na extrakci čistého, dobře strukturovaného textu pro trénink modelů.

| Vlastnost | Vyhledávací roboti | AI tréninkoví roboti |

|---|---|---|

| Spouštění JavaScriptu | Ano (s omezeními) | Ne |

| Frekvence procházení | Vysoká (několikrát týdně) | Nízká (jednou za pár týdnů) |

| Zpracování obsahu | Plné vykreslení stránky | Pouze surový HTML |

| Dodržování robots.txt | Přísné | Různorodé |

| Fokus crawl budgetu | Priorita dle autority | Výběr dle kvality |

| Zpracování dynamického obsahu | Dokáže vykreslit a indexovat | Zcela přehlíží |

| Primární cíl | Pořadí & viditelnost ve vyhledávání | Sběr tréninkových dat |

| Tolerance timeoutu | Delší (umožňuje složité vykreslení) | Krátká (1–5 sekund) |

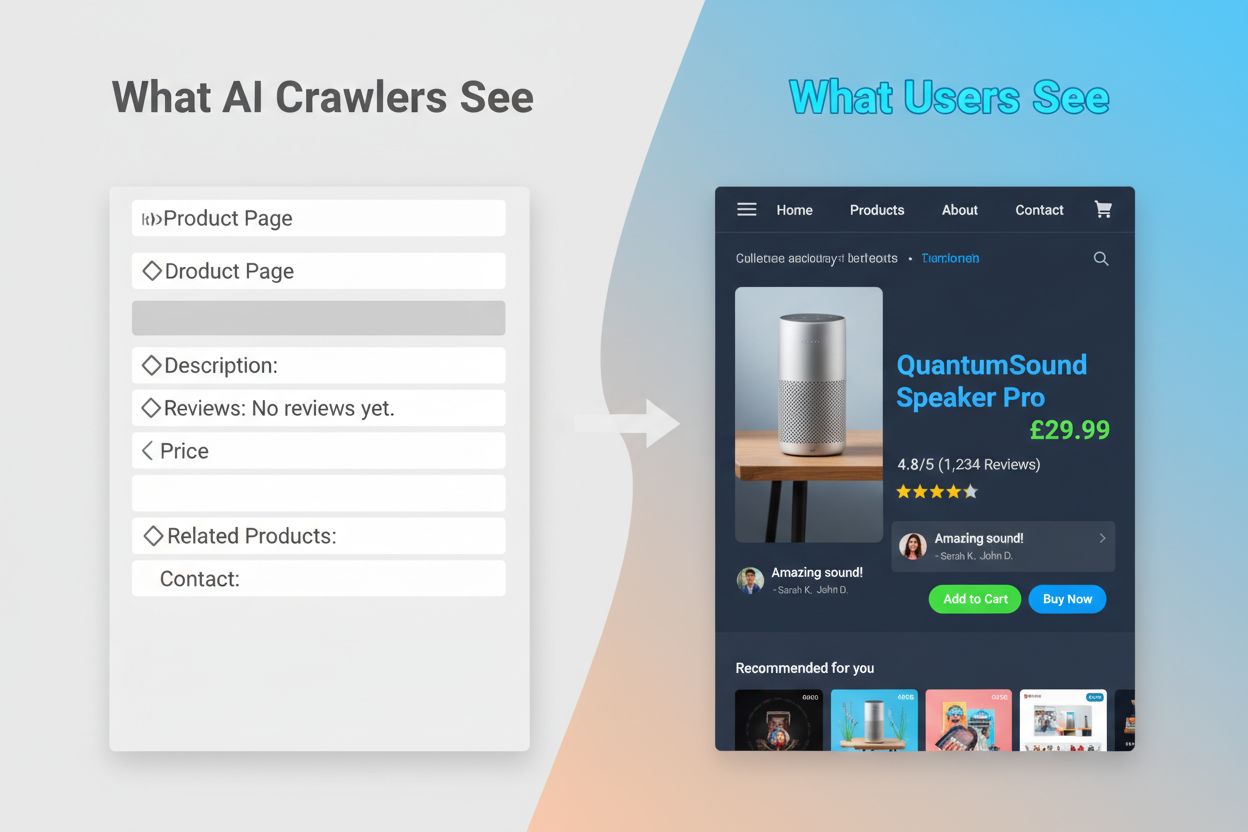

Neschopnost AI robotů spouštět JavaScript vytváří zásadní mezeru ve viditelnosti, která se dotýká mnoha moderních webů. Pokud web závisí na JavaScriptu pro dynamické načítání obsahu—například popisů produktů, recenzí, cen či obrázků—stává se tento obsah pro AI roboty neviditelný. To je zvláště problematické u single-page aplikací (SPA) postavených na Reactu, Vue nebo Angularu, kde většina obsahu přichází client-side až po načtení základního HTML. Například e-shop může zobrazovat dostupnost a ceny produktů přes JavaScript, což znamená, že GPTBot vidí jen prázdnou stránku nebo základní HTML kostru. Podobně weby využívající lazy-loading obrázků či nekonečné rolování budou mít tyto prvky AI roboty zcela přehlédnuty. Dopad na podnikání je značný: pokud jsou detaily produktů, zákaznické recenze nebo klíčový obsah skryty za JavaScriptem, AI systémy jako ChatGPT a Perplexity k nim při generování odpovědí nemají přístup. Tím vzniká situace, kdy váš obsah může být skvěle hodnocen v Googlu, ale v AI generovaných odpovědích zcela chybět—fakticky se tak stáváte neviditelnými pro rostoucí skupinu uživatelů, kteří spoléhají na AI při hledání informací.

Praktické důsledky těchto technických rozdílů jsou zásadní a často nepochopené majiteli webů. Váš web může dosahovat vynikajících pozic v Googlu, zatímco je současně téměř neviditelný pro ChatGPT, Perplexity a další AI systémy. Vzniká tak paradox, kdy úspěch v tradičním SEO nezaručuje viditelnost v AI. Pokud uživatelé položí ChatGPT otázku o vašem oboru nebo produktu, AI může citovat vaši konkurenci místo vás, prostě proto, že jejich obsah byl pro AI roboty lépe dostupný. Vztah mezi tréninkovými daty a AI citacemi přidává další vrstvu složitosti: obsah, který byl použit pro trénink AI modelu, může mít preferenční postavení v jeho výsledcích, což znamená, že blokování AI tréninkových robotů může snížit vaši viditelnost v AI odpovědích. Pro vydavatele a tvůrce obsahu to znamená, že strategické rozhodnutí povolit nebo blokovat AI roboty má skutečný dopad na budoucí návštěvnost. Web, který blokuje GPTBot kvůli ochraně obsahu, může zároveň snížit šanci na výskyt v odpovědích ChatGPT. Naopak, zpřístupnění obsahu AI robotům poskytuje tréninková data, ale negarantuje citace či návštěvnost—jde tedy o skutečné strategické dilema bez dokonalého řešení.

Porozumění tomu, kteří roboti přistupují na váš web a jak často jej navštěvují, je klíčem k optimalizaci obsahové strategie. Analýza logů je hlavní metodou identifikace aktivity robotů, protože umožňuje segmentovat a zpracovávat serverové logy a zjistit, kteří boti navštívili váš web, jak často a které stránky upřednostňovali. Analýzou User-Agent řetězců v serverových logách můžete rozlišit Googlebot, GPTBot, OAI-SearchBot a další roboty a odhalit vzory jejich chování. Klíčové metriky ke sledování zahrnují frekvenci procházení (jak často který robot navštěvuje), hloubku procházení (kolik vrstev struktury webu robot projde) a crawl budget (celkový počet procházených stránek v daném čase). Nástroje jako Google Search Console a Bing Webmaster Tools poskytují pohled na aktivitu vyhledávacích robotů, zatímco specializovaná řešení jako AmICited.com umožňují komplexní monitoring AI robotů napříč platformami včetně ChatGPT, Perplexity a Google AI Overviews. AmICited.com konkrétně sleduje, jak AI systémy odkazují na vaši značku a obsah, a poskytuje přehled o tom, které AI platformy vás citují a jak často. Znalost těchto vzorců vám pomůže včas odhalit technické problémy, optimalizovat rozdělení crawl budgetu a učinit informovaná rozhodnutí o přístupu robotů a optimalizaci obsahu.

Optimalizace pro tradiční vyhledávací roboty vyžaduje zaměření na osvědčené technické SEO základy, které zajistí, že váš obsah bude objevitelný a indexovatelný. Následující strategie zůstávají zásadní pro silnou viditelnost ve vyhledávání:

Vyhledávače jako Google se stále více zaměřují na efektivitu procházení; zástupci Googlu uvádějí, že Googlebot bude v budoucnu procházet méně. To znamená, že váš web by měl být co nejpřehlednější, s jasnou hierarchií a efektivním vnitřním prolinkováním, které roboty dovede přímo k vašim nejdůležitějším stránkám.

Optimalizace pro AI tréninkové roboty vyžaduje jiný přístup zaměřený na kvalitu, srozumitelnost a dostupnost obsahu, nikoli na signály pro pořadí. Protože AI roboti upřednostňují dobře strukturovaný, kontextově bohatý obsah, vaše strategie by měla klást důraz na komplexnost a čitelnost. Vyhněte se obsahu závislému na JavaScriptu pro klíčové informace—zajistěte, aby detaily produktů, ceny, recenze a důležitá data byly v surovém HTML, kde je AI roboti najdou. Vytvářejte komplexní, hloubkové články, které téma důkladně pokrývají a poskytují kontext, ze kterého se AI může učit. Používejte jasné formátování s nadpisy, odrážkami a číslovanými seznamy, které rozčlení text a usnadní jeho zpracování. Pište srozumitelně, bez zbytečného žargonu, který by mohl AI zmást. Dodržujte správnou hierarchii nadpisů (H1, H2, H3), aby AI roboti chápali strukturu a vztahy v obsahu. Zařaďte relevantní metadata a schema markup, které poskytují kontext o obsahu. Zajistěte rychlé načtení stránky, protože AI roboti mají krátké timeouty (obvykle 1–5 sekund) a pomalé stránky mohou zcela přeskočit.

Hlavní rozdíl oproti optimalizaci pro vyhledávání spočívá v tom, že AI roboti neřeší signály pro pořadí, zpětné odkazy ani hustotu klíčových slov. Místo toho oceňují obsah, který je přehledný, dobře organizovaný a informačně bohatý. Stránka, která nemusí být v Googlu dobře hodnocena, může být pro AI modely velmi cenná, pokud obsahuje komplexní, dobře strukturované informace o tématu.

Prostředí webového procházení se rychle mění a AI roboti získávají stále větší význam pro viditelnost obsahu i povědomí o značce. Jak AI vyhledávací nástroje typu ChatGPT, Perplexity a Google AI Overviews získávají na popularitě, možnost být těmito systémy objeven a citován bude stejně důležitá jako tradiční SEO pozice. Rozdíl mezi tréninkovými a vyhledávacími roboty se pravděpodobně stane jemnějším, přičemž firmy mohou jasněji oddělovat sběr dat a vyhledávání, podobně jako OpenAI se svým GPTBot a OAI-SearchBot. Majitelé webů budou muset vyvinout strategie, které vyváží tradiční SEO optimalizaci s AI viditelností a pochopí, že jde o doplňující, nikoli konkurenční cíle. Vznik specializovaných nástrojů a řešení pro monitoring usnadní sledování aktivity robotů na tradičních i AI platformách a umožní dělat rozhodnutí o přístupu robotů a optimalizaci obsahu na základě dat. Ti, kteří již nyní optimalizují pro vyhledávací i AI roboty, získají konkurenční výhodu a zajistí, že jejich obsah bude objevován v různých kanálech, jak se prostředí vyhledávání dále vyvíjí. Budoucnost viditelnosti obsahu závisí na pochopení a optimalizaci pro celé spektrum robotů, které váš obsah objevují a využívají.

Vyhledávací roboti jako Googlebot indexují obsah kvůli pořadí ve vyhledávání a dokáží spustit JavaScript, aby viděli dynamický obsah. AI tréninkoví roboti jako GPTBot sbírají data pro trénink LLM a obvykle neumí spouštět JavaScript, takže přehlédnou dynamicky načítaný obsah. Tento zásadní rozdíl znamená, že váš web může být dobře hodnocen v Googlu, ale téměř neviditelný pro ChatGPT.

Ano, můžete použít robots.txt k blokování konkrétních AI robotů jako GPTBot a zároveň povolit vyhledávací roboty. To však může snížit vaši viditelnost v AI generovaných odpovědích a souhrnech. Strategická volba závisí na tom, zda upřednostňujete ochranu obsahu před potenciální AI návštěvností.

AI roboti jako GPTBot zpracovávají pouze surový HTML při prvním načtení stránky a nespouští JavaScript. Obsah načítaný dynamicky skripty—například detaily produktů, recenze nebo obrázky—zůstává pro ně zcela neviditelný. To je zásadní omezení pro moderní weby, které se silně spoléhají na client-side rendering.

AI tréninkoví roboti obvykle navštěvují méně často než vyhledávací roboti, s delšími intervaly mezi návštěvami. Upřednostňují obsah s vysokou autoritou a mohou stránku procházet pouze jednou za několik týdnů či měsíců. Tento nepravidelný vzor procházení odráží jejich zaměření na kvalitu před kvantitou.

Detaily produktů, zákaznické recenze, obrázky načítané až při zobrazení stránky, interaktivní prvky (záložky, karusely, modální okna), cenové informace a veškerý obsah skrytý za JavaScriptem jsou nejvíce zranitelné. U e-commerce a SPA webů to může představovat významnou část klíčového obsahu.

Zajistěte, aby klíčový obsah byl v surovém HTML, zlepšete rychlost webu, používejte přehlednou strukturu a formátování se správnou hierarchií nadpisů, implementujte schema markup a vyhýbejte se kritickému obsahu závislému na JavaScriptu. Cílem je zpřístupnit obsah jak tradičním, tak AI robotům.

Nástroje pro analýzu logů, Google Search Console, Bing Webmaster Tools a specializovaná řešení pro monitoring robotů jako AmICited.com vám pomohou sledovat chování robotů. AmICited.com konkrétně monitoruje, jak AI systémy odkazují na vaši značku napříč ChatGPT, Perplexity a Google AI Overviews.

Potenciálně ano. Zatímco blokováním tréninkových robotů můžete chránit svůj obsah, může to snížit vaši viditelnost v AI vyhledávání a souhrnech. Navíc obsah, který byl již zpracován před blokací, zůstává ve vytrénovaných modelech. Rozhodnutí vyžaduje vyvážení ochrany obsahu a možného úbytku AI návštěvnosti.

Sledujte, jak AI systémy odkazují na vaši značku napříč ChatGPT, Perplexity a Google AI Overviews. Získejte okamžité informace o své AI viditelnosti a optimalizujte svou obsahovou strategii.

Objevte klíčové rozdíly mezi AI vyhledávači a tradičním vyhledáváním. Zjistěte, jak se ChatGPT, Perplexity a Google AI Overviews liší od výsledků založených na ...

Zjistěte, co je GPTBot, jak funguje a zda byste měli povolit nebo zablokovat webového crawlera OpenAI. Pochopte dopad na viditelnost vaší značky ve vyhledávání ...

Crawlabilita je schopnost vyhledávačů přistupovat a procházet stránky webu. Zjistěte, jak roboti fungují, co je blokuje a jak optimalizovat web pro tradiční i A...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.