Abschnittslängen in KI-Systemen verstehen

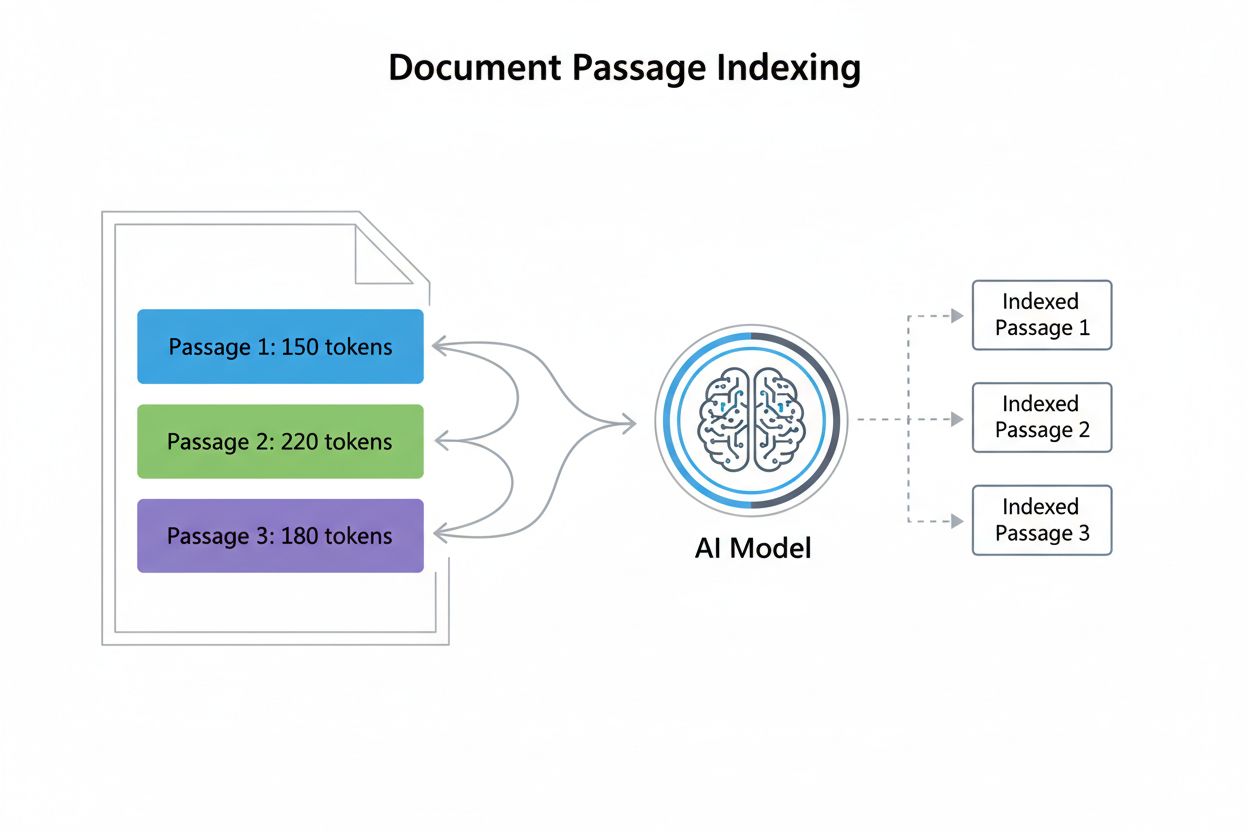

Abschnittslänge im Kontext von KI-Zitaten bezieht sich auf die optimale Größe von Inhaltseinheiten, die KI-Modelle beim Generieren von Antworten extrahieren und zitieren. Anstatt ganze Seiten oder Dokumente zu zitieren, nutzen moderne KI-Systeme das Abschnitts-Indexing, bei dem Inhalte in diskrete, handhabbare Segmente unterteilt werden, die unabhängig bewertet und zitiert werden können. Dieses Verständnis ist entscheidend, da es grundlegend beeinflusst, wie Content Creator ihre Inhalte strukturieren sollten. Die Beziehung zwischen Abschnitten und Tokens ist dabei essenziell: Etwa 1 Token entspricht 0,75 Wörtern, ein 300-Wörter-Abschnitt enthält also rund 400 Tokens. Diese Umrechnung ist wichtig, weil KI-Modelle innerhalb von Kontextfenstern arbeiten – festen Limits, wie viel Text sie gleichzeitig verarbeiten können. Durch Optimierung der Abschnittslänge stellen Sie sicher, dass Ihre wertvollsten Informationen im Bereich liegen, den KI-Systeme effektiv indexieren, abrufen und zitieren können, anstatt in längeren Dokumenten unterzugehen, die die Verarbeitungsgrenzen überschreiten.

Die Daten hinter der optimalen Abschnittslänge

Untersuchungen zeigen konsistent, dass 53 % der von KIs zitierten Inhalte unter 1.000 Wörter lang sind – ein Ergebnis, das traditionelle Annahmen über Inhaltsumfang und Autorität infrage stellt. Diese Vorliebe für kürzere Inhalte rührt daher, wie KIs Relevanz und Extrahierbarkeit bewerten: Knackige Abschnitte lassen sich leichter analysieren, kontextualisieren und präzise zitieren. Das Konzept des „Antwort-Nuggets“ (typischerweise 40-80 Wörter) hat sich als zentrale Optimierungseinheit etabliert und steht für die kleinste sinnvolle Antwort auf eine Nutzerfrage. Interessanterweise zeigen Studien eine nahezu Null-Korrelation zwischen Wortzahl und Zitationsposition – längere Inhalte landen also nicht automatisch weiter oben bei KI-Zitaten. Inhalte unter 350 Wörtern erreichen häufiger die Top-3-Zitationsplätze, was darauf hindeutet, dass Kürze und Relevanz optimale Bedingungen für KI-Zitate schaffen. Diese datengetriebene Erkenntnis verändert Content-Strategien grundlegend.

| Inhaltstyp | Optimale Länge | Token-Anzahl | Anwendungsfall |

|---|---|---|---|

| Antwort-Nugget | 40-80 Wörter | 50-100 Tokens | Direkte Q&A-Antworten |

| Featured Snippet | 75-150 Wörter | 100-200 Tokens | Schnelle Antworten |

| Abschnitts-Chunk | 256-512 Tokens | 256-512 Tokens | Semantische Suchergebnisse |

| Themen-Hub | 1.000-2.000 Wörter | 1.300-2.600 Tokens | Umfassende Abdeckung |

| Long-Form-Content | 2.000+ Wörter | 2.600+ Tokens | Tiefgehende Analysen, Leitfäden |

Token-Zählung und Kontextfenster

Tokens sind die Grundeinheiten, mit denen KI-Modelle Sprache verarbeiten; jedes Token steht in der Regel für ein Wort oder ein Wortfragment. Die Berechnung der Token-Anzahl ist einfach: Teilen Sie Ihre Wortzahl durch 0,75, um die ungefähre Token-Anzahl zu erhalten (exakte Werte variieren je nach Tokenisierungsmethode). Ein 300-Wörter-Abschnitt enthält beispielsweise etwa 400 Tokens, ein 1.000-Wörter-Artikel etwa 1.333 Tokens. Kontextfenster – die maximale Anzahl an Tokens, die ein Modell in einer Anfrage verarbeiten kann – bestimmen direkt, welche Abschnitte für Zitate ausgewählt werden. Die meisten modernen KIs arbeiten mit Kontextfenstern von 4.000 bis 128.000 Tokens, praktisch erhalten jedoch meist nur die ersten 2.000-4.000 Tokens optimale Aufmerksamkeit. Überschreitet ein Abschnitt diese praktischen Grenzen, wird er im Retrieval-Prozess möglicherweise abgeschnitten oder zurückgestellt. Wenn Sie das Kontextfenster Ihrer Ziel-KI kennen, können Sie Abschnitte so strukturieren, dass sie bequem in die Verarbeitungsgrenzen passen und dabei semantisch vollständig bleiben.

Beispiel Token-Berechnung:

- 100-Wörter-Abschnitt = ~133 Tokens

- 300-Wörter-Abschnitt = ~400 Tokens

- 500-Wörter-Abschnitt = ~667 Tokens

- 1.000-Wörter-Abschnitt = ~1.333 Tokens

Praktische Kontextfenster-Zuteilung:

- Kontextfenster des Systems: 8.000 Tokens

- Reserviert für Anfrage + Instruktionen: 500 Tokens

- Verfügbar für Abschnitte: 7.500 Tokens

- Optimale Abschnittsgröße: 256-512 Tokens (passt für 14-29 Abschnitte)

Das „Lost in the Middle“-Problem

KI-Modelle zeigen ein Phänomen, das als Kontextverfall bekannt ist, bei dem Informationen in der Mitte langer Abschnitte deutlich an Performance verlieren. Ursache ist, dass transformerbasierte Modelle Aufmerksamkeitsmechanismen anwenden, die Inhalte am Anfang (Primacy-Effekt) und Ende (Recency-Effekt) einer Eingabesequenz bevorzugen. Überschreiten Abschnitte 1.500 Tokens, werden wichtige Informationen in der Mitte häufig übersehen oder bei der Zitatgenerierung zurückgestellt. Diese Einschränkung hat große Auswirkungen auf die Inhaltsstruktur – wenn Sie die wichtigsten Informationen an den Anfang und das Ende stellen, maximieren Sie die Zitationswahrscheinlichkeit. Folgende Gegenmaßnahmen helfen, das Problem zu minimieren:

- Platzieren Sie kritische Informationen zu Beginn des Abschnitts

- Wiederholen Sie Schlüsselpunkte am Ende des Abschnitts

- Teilen Sie lange Inhalte in mehrere kürzere Abschnitte

- Verwenden Sie klare Abschnittsüberschriften für natürliche Abgrenzungen

- Nutzen Sie eine hierarchische Struktur: Hauptpunkte vor Detailinfos

- Vermeiden Sie, Antworten in der Mitte von Erklärungen zu verstecken

Abschnittsstruktur für maximale KI-Auffindbarkeit

Eine optimale Abschnittsstruktur legt Wert auf semantische Kohärenz – jeder Abschnitt sollte einen vollständigen, in sich geschlossenen Gedanken oder eine Antwort darstellen. Abschnitte sollten nicht willkürlich nach Wortzahl, sondern an natürlichen Themen- und Logikgrenzen unterteilt werden. Kontextunabhängigkeit ist ebenso wichtig: Jeder Abschnitt muss verständlich sein, ohne dass Leser (oder KI) auf umgebende Inhalte zurückgreifen müssen. Notwendiger Kontext sollte daher im Abschnitt selbst enthalten sein, nicht durch Verweise oder externe Infos. Strukturieren Sie Ihre Inhalte für KI-Retrieval so, dass Abschnitte auch isoliert sinnvoll sind – ohne Überschriften, Navigation oder angrenzende Absätze. Best Practices: Beginnen Sie jeden Abschnitt mit einem klaren Themensatz, achten Sie auf einheitliche Formatierung und Terminologie, nutzen Sie beschreibende Unterüberschriften und stellen Sie sicher, dass jeder Abschnitt eine vollständige Frage beantwortet oder ein vollständiges Konzept abdeckt. Wenn Sie Abschnitte als eigenständige Einheiten und nicht als willkürlich getrennte Textsegmente betrachten, steigt die Wahrscheinlichkeit, dass KI-Systeme Ihre Arbeit exakt extrahieren und zitieren, erheblich.

Vergleich: Kurze vs. lange Inhaltsstrategien

Die „Snack-Strategie“ optimiert auf kurze, fokussierte Inhalte (75-350 Wörter), die gezielt einzelne Anfragen beantworten. Diese Herangehensweise eignet sich besonders für einfache, direkte Fragen, bei denen Nutzer schnelle Antworten ohne viel Kontext suchen. Snack-Content performt bei KI-Zitaten herausragend, weil er dem „Antwort-Nugget“-Format entspricht, das KIs bevorzugt extrahieren. Im Gegensatz dazu erstellt die „Hub-Strategie“ umfassende, lange Inhalte (2.000+ Wörter), die komplexe Themen in der Tiefe behandeln. Hub-Content dient der Etablierung von Themenautorität, der Abdeckung mehrerer verwandter Anfragen und der Bereitstellung von Kontext für differenzierte Fragen. Der wichtigste Punkt: Beide Ansätze schließen sich nicht aus – am effektivsten ist die Kombination. Erstellen Sie gezielte Snacks für konkrete Fragen und rasche Antworten und entwickeln Sie ergänzend Hubs, die auf diese Snacks verweisen und sie vertiefen. So erreichen Sie sowohl direkte KI-Zitate (durch Snacks) als auch umfassende thematische Autorität (durch Hubs). Wählen Sie die Strategie je nach Anfrage-Intention: Für einfache, faktenbasierte Fragen eignen sich Snacks, für komplexe, explorative Themen Hubs. Die beste Strategie balanciert beide Ansätze aus und richtet sich nach den tatsächlichen Informationsbedürfnissen Ihrer Zielgruppe.

Praktische Umsetzung – Antwort-Nuggets

Antwort-Nuggets sind prägnante, eigenständige Zusammenfassungen von in der Regel 40-80 Wörtern, die gezielt bestimmte Fragen beantworten. Sie stellen das optimale Format für KI-Zitate dar, da sie vollständige Antworten ohne unnötige Informationen liefern. Die Platzierung ist entscheidend: Positionieren Sie Ihr Antwort-Nugget unmittelbar nach der Hauptüberschrift oder der Themeneinführung, noch bevor Sie in Details und Erklärungen einsteigen. So begegnet das KI-System der Antwort zuerst und die Zitationswahrscheinlichkeit steigt. Schema-Markup unterstützt die Optimierung zusätzlich – mit strukturierten Datenformaten wie JSON-LD zeigen Sie KIs exakt, wo Ihre Antwort steht. Beispiel für ein gut strukturiertes Antwort-Nugget:

Frage: "Wie lang sollten Webinhalte für KI-Zitate sein?"

Antwort-Nugget: "Forschung zeigt, dass 53 % der von KIs zitierten Inhalte unter 1.000 Wörter lang sind, mit optimalen Abschnitten zwischen 75-150 Wörtern für direkte Antworten und 256-512 Tokens für semantische Chunks. Inhalte unter 350 Wörtern landen häufiger auf den Top-Zitationspositionen – Kürze plus Relevanz maximiert die KI-Zitationswahrscheinlichkeit."

Dieses Nugget ist vollständig, spezifisch und sofort verwertbar – genau das, was KIs für Zitate suchen.

Schema-Markup und strukturierte Daten

JSON-LD-Schema-Markup gibt KIs explizite Hinweise auf Struktur und Bedeutung Ihrer Inhalte und erhöht damit deutlich die Zitationswahrscheinlichkeit. Am wirkungsvollsten für KI-Optimierung sind FAQ-Schema für Frage-Antwort-Inhalte und HowTo-Schema für Anleitungen oder Schritt-für-Schritt-Prozesse. FAQ-Schema ist besonders effektiv, weil es exakt dem Informationsverarbeitungsstil von KIs entspricht – als diskrete Frage-Antwort-Paare. Untersuchungen zeigen: Seiten mit passendem Schema-Markup werden dreimal häufiger von KIs zitiert als unmarkierte Inhalte. Das ist kein Zufall; Schema-Markup verringert die Unklarheit darüber, was eine Antwort ist, und erleichtert das Extrahieren und Zitieren.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"@id": "https://example.com/faq#q1",

"name": "Was ist die optimale Abschnittslänge für KI-Zitate?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Forschung zeigt, dass 53 % der von KIs zitierten Inhalte unter 1.000 Wörter lang sind, mit optimalen Abschnitten zwischen 75-150 Wörtern für direkte Antworten und 256-512 Tokens für semantische Chunks."

}

}

]

}

Mit Schema-Markup verwandeln Sie Ihre Inhalte von unstrukturiertem Text in maschinenlesbare Information und signalisieren KIs unmissverständlich, wo Antworten stehen und wie sie organisiert sind.

Messung und Optimierung der Abschnitts-Performance

Die Überwachung der Abschnitts-Performance erfordert das Tracken spezifischer Metriken, die den Erfolg bei KI-Zitaten anzeigen. Zitationsanteil misst, wie häufig Ihre Inhalte in KI-generierten Antworten erscheinen, Zitationsposition zeigt, ob Ihre Abschnitte an erster, zweiter oder späterer Stelle in Zitationslisten stehen. Tools wie SEMrush, Ahrefs und spezialisierte KI-Monitoring-Plattformen erfassen inzwischen AI-Overview-Erscheinungen und Zitate und machen die Performance sichtbar. Führen Sie A/B-Tests durch, indem Sie mehrere Varianten von Abschnitten mit unterschiedlicher Länge, Struktur oder Schema umsetzen und beobachten, welche Versionen mehr Zitate generieren. Zu verfolgende Kennzahlen:

- Zitationshäufigkeit (wie oft Ihre Inhalte zitiert werden)

- Zitationsposition (Rang unter den zitierten Quellen)

- Query-Abdeckung (für welche Anfragen erscheinen Ihre Zitate)

- Klickrate aus KI-Zitaten

- Genauigkeit der Abschnittsextraktion (wird der beabsichtigte Abschnitt zitiert?)

- Umsetzungsrate von Schema-Markup

Kontinuierliches Monitoring zeigt, welche Abschnittsstrukturen, Längen und Formate bei KIs am besten ankommen – so optimieren Sie laufend weiter.

Häufige Fehler bei der Abschnittsoptimierung

Viele Content Creator sabotieren ungewollt ihr KI-Zitationspotenzial durch vermeidbare Strukturfehler. Wichtige Informationen zu tief im Abschnitt zu verstecken zwingt KIs, unnötigen Kontext zu durchsuchen – stellen Sie das Entscheidende immer an den Anfang. Zuviel Querverweise machen Abschnitte kontextabhängig; häufige Verweise auf andere Bereiche erschweren der KI das eigenständige Extrahieren und Zitieren. Vage, unspezifische Inhalte bieten KIs nicht die Präzision, die sie für ein sicheres Zitat brauchen – setzen Sie auf konkrete Details, Zahlen und klare Aussagen. Schwache Abschnittsgrenzen führen zu Abschnitten, die mehrere Themen oder unvollständige Gedanken enthalten; jeder Abschnitt sollte eine in sich geschlossene Einheit sein. Ignorieren der technischen Struktur verschenkt Chancen für Schema-Markup, saubere Überschriftenhierarchie und semantische Klarheit. Weitere Fehler:

- Uneinheitliche Terminologie zwischen Abschnitten (erschwert KI-Parsing)

- Mehrere Fragen in einem Abschnitt (reduziert Zitationsklarheit)

- Veraltete Informationen nicht aktualisieren (schadet Glaubwürdigkeit)

- Vernachlässigte mobile Formatierung (beeinflusst KI-Parsing)

- Zu viele Werbeformulierungen (senkt Zitationswahrscheinlichkeit)

- Abschnitte über 512 Tokens ohne klare Unterteilung

Wenn Sie diese Fehler vermeiden und gleichzeitig die oben beschriebenen Optimierungsstrategien umsetzen, positionieren Sie Ihre Inhalte für maximale KI-Zitationsperformance.