YMYL (Your Money Your Life)

Conteúdo YMYL exige altos padrões E-E-A-T. Saiba o que qualifica como conteúdo Your Money Your Life, por que isso importa para SEO e visibilidade em IA, e como ...

Saiba como organizações de saúde podem otimizar conteúdo médico para visibilidade em LLMs, navegar exigências YMYL e monitorar citações de IA com a plataforma de monitoramento de IA do AmICited.com.

O conteúdo Your Money or Your Life (YMYL) abrange tópicos que impactam diretamente o bem-estar do usuário, incluindo saúde, finanças, segurança e informações cívicas—e a saúde está no topo da hierarquia de rigor do Google. Após a atualização central de março de 2024 do Google, o gigante de buscas reduziu a visibilidade de conteúdo de baixa qualidade em 40%, sinalizando uma repressão inédita à informação médica não confiável. Contudo, o desafio enfrentado pelas organizações de saúde mudou fundamentalmente: o conteúdo agora precisa ser visível não apenas para mecanismos de busca, mas para Grandes Modelos de Linguagem (LLMs) que cada vez mais servem como a primeira parada para quem procura informações de saúde. Com 5% de todas as buscas no Google sendo relacionadas à saúde e 58% dos pacientes usando ferramentas de IA para obter informações de saúde, os provedores de saúde enfrentam um importante gap de visibilidade—seu conteúdo pode ter bom ranking em buscas tradicionais, mas permanecer invisível para os sistemas de IA realmente consultados pelos pacientes. Essa exigência de dupla visibilidade representa uma nova fronteira na estratégia de conteúdo em saúde.

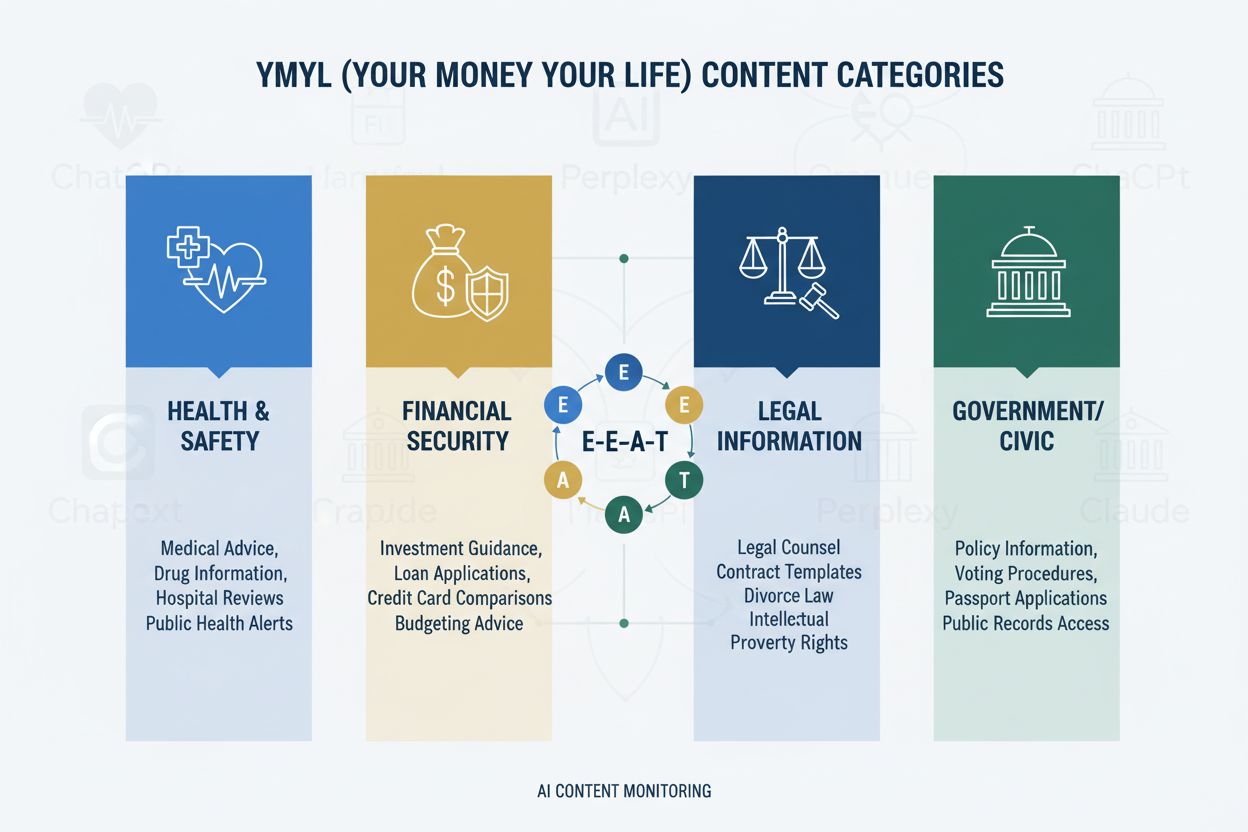

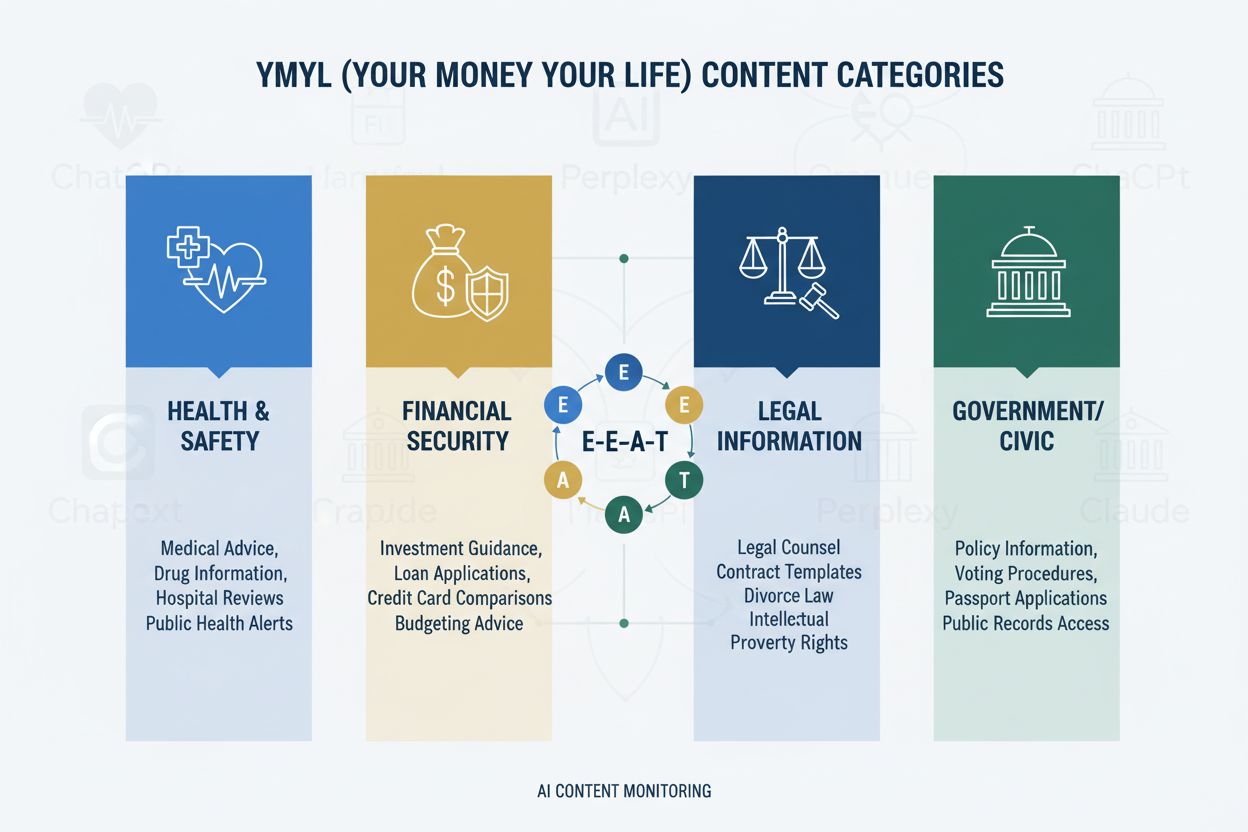

O framework YMYL categoriza conteúdo em quatro domínios críticos: Saúde (condições médicas, tratamentos, bem-estar), Finanças (aconselhamento de investimentos, planejamento financeiro), Segurança (procedimentos de emergência, segurança), e Cívico (votação, questões legais)—com a saúde exigindo o mais alto grau de rigor devido ao seu impacto direto no bem-estar humano. O framework E-E-A-T do Google (Experiência, Especialização, Autoridade, Confiabilidade) serve como padrão de avaliação, exigindo que o conteúdo de saúde demonstre conhecimento médico genuíno, credenciais profissionais e precisão verificável. As Diretrizes de Avaliadores de Qualidade enfatizam explicitamente que o conteúdo em saúde deve ser criado ou revisado por profissionais médicos qualificados, com credenciais claras de autoria e respaldo institucional. Organizações de saúde precisam entender que E-E-A-T não é opcional—é a exigência fundamental tanto para visibilidade em buscas quanto para inclusão em LLMs. Veja abaixo a hierarquia de impacto das categorias YMYL:

| Categoria YMYL | Nível de Impacto | Intensidade de Rigor | Relevância para Saúde |

|---|---|---|---|

| Saúde | Crítico | Máxima | Segurança direta do paciente |

| Finanças | Alta | Alta | Seguros, custos |

| Segurança | Alta | Alta | Protocolos de emergência |

| Cívico | Média | Média | Política de saúde |

Apesar de sua sofisticação, LLMs apresentam taxas de erro alarmantes ao processar informações médicas, com pesquisa da Stanford HAI documentando 30-50% de afirmações sem suporte em respostas relacionadas à saúde. GPT-4 com Geração Aumentada por Recuperação (RAG) ainda gera respostas onde 50% contêm alegações sem fundamento, mesmo quando treinado em fontes confiáveis—um fenômeno conhecido como alucinação que pode se manifestar como recomendação de equipamentos médicos inexistentes, indicação de protocolos de tratamento incorretos ou invenção de interações medicamentosas. Um caso notável envolveu a Men’s Journal publicando um artigo gerado por IA contendo 18 erros médicos específicos, incluindo recomendações perigosas que poderiam prejudicar leitores. O problema fundamental é que a IA não possui “Experiência”—o conhecimento clínico de primeira mão que diferencia médicos especialistas de sistemas de padrões estatísticos. Essa lacuna significa que, sem conteúdo estruturado e autoritativo de profissionais médicos verificados, LLMs gerarão orientações médicas plausíveis, mas potencialmente perigosas, com confiança.

AI Overviews e sistemas de resposta alimentados por LLM mudam fundamentalmente como pacientes descobrem informações de saúde ao fornecer respostas diretas sem necessidade de visitar websites, eliminando o tradicional clique que impulsionou o tráfego digital em saúde por décadas. Agora, a visibilidade do conteúdo depende de citação dentro das respostas de IA e não da posição nos rankings, o que significa que um artigo de um provedor pode ser sintetizado em uma resposta de IA sem nunca receber tráfego ou atribuição. LLMs sintetizam informações de múltiplas fontes simultaneamente, criando uma nova arquitetura de informação onde sites individuais competem por inclusão em resumos gerados por IA ao invés de posições de topo em buscas. Provedores de saúde precisam reconhecer que Share of Model (SOM)—a porcentagem de respostas de IA que citam seu conteúdo—tornou-se o principal indicador de visibilidade, substituindo taxas de clique tradicionais. Essa mudança de paradigma exige repensar a estratégia de conteúdo: em vez de otimizar para cliques, organizações de saúde devem otimizar para qualidade de citação, precisão e clareza estrutural, tornando seu conteúdo a fonte preferida na síntese dos LLMs.

LLMs processam conteúdo médico de forma mais eficaz quando organizado com estrutura hierárquica clara que espelha a tomada de decisão clínica: definição da condição → apresentação de sintomas → critérios diagnósticos → opções de tratamento → prognóstico. Arquitetura de divulgação progressiva—apresentando conceitos simples antes dos complexos—permite que LLMs construam modelos mentais precisos em vez de confundir condições relacionadas, porém distintas. Design de conteúdo com perguntas primeiro (respondendo “O que é a condição X?” antes de “Como é tratada?”) está alinhado com a forma como LLMs recuperam e sintetizam informações em múltiplos documentos. Riqueza semântica e conceitos interconectados—ligando explicitamente condições, tratamentos e fatores de risco relacionados—ajuda LLMs a compreender relações que poderiam permanecer implícitas. Implementação de marcação médica Schema.org (MedicalCondition, MedicalProcedure, MedicalTreatment) fornece dados estruturados que LLMs podem analisar e citar com confiança. Linguagem natural que imita explicação de especialistas—usando terminologia médica de uso comum, mas com acessibilidade—sinaliza autenticidade tanto para LLMs quanto para leitores humanos. Organizações de saúde devem auditar o conteúdo existente frente a esses requisitos estruturais, pois conteúdo otimizado apenas para SEO tradicional frequentemente carece da clareza hierárquica e riqueza semântica que LLMs demandam para síntese precisa.

Presença multiplataforma amplifica sinais de autoridade de maneiras que estratégias restritas a um site não conseguem, já que LLMs reconhecem expertise consistente demonstrada em múltiplos canais confiáveis. Plataformas de perguntas e respostas médicas como HealthTap e Figure 1 oferecem interação direta médico-paciente reconhecida pelos LLMs como expertise autêntica, com credenciais verificadas e engajamento em tempo real. Redes profissionais como Doximity e comunidades médicas no LinkedIn estabelecem reconhecimento entre pares e reputação profissional, valorizados pelos LLMs na avaliação de autoridade. Contribuições para a Wikipedia médica e bases de conhecimento colaborativas semelhantes sinalizam disposição para contribuir com o conhecimento público sem motivação comercial, um sinal de confiança reconhecido pelos LLMs. Páginas abrangentes de credibilidade dos autores—com certificações, publicações, experiência clínica e afiliações institucionais—devem estar presentes no site principal e serem vinculadas consistentemente em todas as plataformas. Consistência de informações entre plataformas em credenciais, especialidades e perspectivas clínicas reforça autenticidade; contradições desencadeiam ceticismo dos LLMs. Organizações de saúde devem desenvolver uma estratégia de autoridade multiplataforma que trate cada canal como reforço, garantindo que a expertise médica seja visível e verificável em todo o ecossistema digital.

Métricas tradicionais em saúde—como tráfego orgânico, taxas de clique e rankings de busca—ignoram completamente a história da visibilidade em IA, criando um ponto cego perigoso onde o conteúdo parece bem-sucedido nos indicadores antigos, mas permanece invisível aos LLMs. Share of Model (SOM) surge como a nova métrica crítica, medindo qual porcentagem de respostas geradas por IA sobre determinada condição citam o conteúdo da sua organização. O monitoramento eficaz exige testes sistemáticos em múltiplas plataformas de LLM (ChatGPT, Claude, Perplexity e novos concorrentes) usando perguntas consistentes sobre áreas de especialidade, documentando frequência e posição das citações nas respostas. A qualidade da citação importa tanto quanto a frequência—ser citado como fonte primária tem mais peso do que aparecer como referência secundária, e LLMs reconhecem quando o conteúdo é citado por expertise específica, não informação genérica. Ferramentas de monitoramento vão de testes manuais (realizando perguntas e documentando respostas) a plataformas automatizadas que acompanham variações de SOM ao longo do tempo e alertam sobre mudanças de visibilidade. Indicadores indiretos como volume de buscas por marca, feedback de pacientes mencionando recomendações de IA e padrões de referência oriundos de plataformas de IA oferecem dados suplementares que validam tendências de SOM. Organizações de saúde devem estabelecer medições de SOM imediatamente, pois o cenário competitivo está mudando rapidamente e vantagens iniciais de visibilidade se acumulam com o tempo.

Organizações de saúde devem começar com uma única área de especialidade ao invés de tentar uma transformação em toda a organização simultaneamente, permitindo que equipes desenvolvam expertise e aprimorem processos antes de escalar. Auditorias de conteúdo sob o olhar dos LLMs exigem avaliação de artigos existentes quanto à clareza hierárquica, riqueza semântica, arquitetura de perguntas e credibilidade dos autores—frequentemente revelando que conteúdos com bom ranking carecem da estrutura que os LLMs exigem. Testes de visibilidade em plataformas de IA usando perguntas específicas da especialidade estabelecem o SOM inicial e identificam quais condições e tratamentos estão visíveis ou invisíveis. Implementação da arquitetura de perguntas envolve reestruturar conteúdos existentes ou criar novos que comecem com dúvidas comuns dos pacientes (“Por que tenho este sintoma?”) antes das explicações clínicas. Páginas de credibilidade de autor devem ser criadas para cada médico colaborador, destacando certificações, especialidades, publicações e experiência clínica, com links consistentes a partir de todo conteúdo assinado. Agrupamento de conteúdo por condição—criando materiais interconectados que abordam sintomas, diagnóstico, opções de tratamento e prognóstico—ajuda LLMs a compreender informações completas sobre condições, e não apenas artigos isolados. Essa abordagem em fases permite medir impacto, refinar estratégias e construir expertise interna antes de expandir para outras especialidades.

A conformidade com a HIPAA permanece fundamental mesmo com o conteúdo se tornando visível para LLMs; proteções de privacidade do paciente se aplicam independentemente de a informação ser acessada via buscadores ou sistemas de IA, exigindo anonimização e desidentificação cuidadosas de exemplos de casos. Avisos médicos e exigências de precisão devem ser explícitos e destacados, deixando claro que informações sintetizadas por IA não substituem consulta médica profissional, e que circunstâncias individuais podem diferir das orientações gerais. Checagem de fatos e citação de fontes tornam-se elementos críticos de conformidade, pois organizações de saúde são responsáveis pela precisão das informações publicadas, e LLMs amplificam erros em milhares de interações. A fiscalização regulatória de conteúdo médico gerado por IA está se intensificando, com FDA e FTC examinando como sistemas de IA apresentam informações médicas; organizações de saúde devem garantir que todo conteúdo—seja escrito por humanos ou auxiliado por IA—atenda aos padrões regulatórios. Revisão médica humana feita por médicos qualificados deve permanecer obrigatória para todo conteúdo, com processos documentados que comprovem o compromisso com precisão e segurança. Considerações de responsabilidade vão além da tradicional responsabilidade médica para incluir possíveis implicações sobre como o conteúdo é sintetizado e apresentado por LLMs; organizações de saúde devem consultar advogados sobre sua responsabilidade pelo uso do conteúdo em sistemas de IA. Conformidade e segurança não podem ser tratadas como preocupações secundárias na busca por visibilidade em IA.

A IA continuará transformando a descoberta de informações em saúde em ritmo acelerado, com LLMs se tornando cada vez mais sofisticados em raciocínio médico e centrais para como pacientes pesquisam condições. Organizações de saúde que adaptarem sua estratégia de conteúdo agora se posicionam como fontes confiáveis neste novo ecossistema, enquanto aquelas que adiarem correm o risco de se tornarem invisíveis para os sistemas de IA realmente usados por seus pacientes. Adotantes precoces ganham vantagem competitiva com sinais de autoridade estabelecidos, métricas de Share of Model mais altas e confiança do paciente construída com visibilidade consistente em respostas de IA—vantagens que se acumulam à medida que LLMs aprendem a reconhecer e priorizar fontes confiáveis. A integração de SEO tradicional e otimização para LLM não é uma escolha excludente, mas uma estratégia complementar, já que buscadores incorporam tecnologia LLM e pacientes continuam usando múltiplas fontes. A sustentabilidade de longo prazo depende da expertise genuína e não de truques de otimização; organizações de saúde que investem em conhecimento médico autêntico, credenciais transparentes e informações precisas prosperarão independentemente da evolução dos mecanismos de descoberta. O cenário de conteúdo em saúde mudou fundamentalmente, e organizações que enxergarem essa transição como oportunidade, não ameaça, definirão o futuro da descoberta de informações em saúde pelos pacientes.

YMYL (Your Money Your Life) refere-se a conteúdo que pode impactar significativamente a saúde, estabilidade financeira ou segurança das pessoas. Saúde é a categoria de maior rigor, pois desinformação médica pode causar danos graves ou morte. O Google aplica padrões algorítmicos mais restritos ao conteúdo YMYL, e LLMs são cada vez mais usados por pacientes para pesquisar informações de saúde, tornando a conformidade YMYL crítica para visibilidade.

LLMs sintetizam informações de várias fontes para fornecer respostas diretas, enquanto mecanismos de busca classificam páginas individuais. O conteúdo de saúde agora precisa ser estruturado para citação por sistemas de IA, não apenas para rankings do Google. Isso significa que seu conteúdo pode educar milhares via respostas de IA sem gerar tráfego direto ao site, exigindo uma abordagem de otimização fundamentalmente diferente.

E-E-A-T significa Experiência, Especialização, Autoridade e Confiabilidade. Conteúdo de saúde exige os mais altos padrões de E-E-A-T, com ênfase em experiência médica de primeira mão e credenciais verificadas. As Diretrizes de Qualidade do Google mencionam E-E-A-T 137 vezes, refletindo sua importância crítica para visibilidade de conteúdo de saúde tanto em buscas quanto em sistemas LLM.

Estudos mostram que a IA produz afirmações médicas sem suporte entre 30-50% das vezes e alucina informações médicas. A IA não tem experiência médica real e não pode verificar informações com padrões médicos atuais. Por isso, revisão médica humana e autoria especializada continuam essenciais—a IA deve auxiliar profissionais de saúde, não substituí-los.

Teste seu conteúdo no ChatGPT, Claude e Perplexity usando perguntas comuns de pacientes em sua especialidade. Acompanhe métricas de Share of Model (SOM)—a porcentagem de respostas de IA que citam seu conteúdo. O AmICited.com automatiza esse monitoramento, fornecendo insights em tempo real de como sua marca de saúde aparece em múltiplas plataformas de LLM.

SEO tradicional foca em ranquear páginas individuais para palavras-chave. Otimização para LLM enfatiza cobertura abrangente, riqueza semântica e conteúdo estruturado que sistemas de IA possam entender e citar. Ambas são complementares—organizações de saúde precisam de estratégias integradas para otimizar para mecanismos de busca e LLMs.

A IA deve ser usada apenas como ferramenta para auxiliar especialistas médicos humanos, não para substituí-los. Todo conteúdo de saúde deve ser revisado e aprovado por profissionais médicos qualificados antes da publicação. Os riscos são altos demais para confiar em geração de IA sem supervisão e verificação de especialistas.

O AmICited.com monitora como marcas de saúde e conteúdo médico aparecem em respostas de IA no ChatGPT, Perplexity, Google AI Overviews e outras plataformas de LLM. Ele oferece métricas de visibilidade, acompanha Share of Model (SOM) e recomendações de otimização para ajudar organizações de saúde a garantir que sua expertise seja encontrada via pesquisa de pacientes orientada por IA.

Acompanhe como seu conteúdo médico aparece no ChatGPT, Perplexity, Google AI Overviews e outras plataformas de LLM. Obtenha insights em tempo real sobre sua Share of Model (SOM) e otimize para descoberta de pacientes orientada por IA.

Conteúdo YMYL exige altos padrões E-E-A-T. Saiba o que qualifica como conteúdo Your Money Your Life, por que isso importa para SEO e visibilidade em IA, e como ...

Discussão da comunidade sobre como sistemas de IA tratam tópicos YMYL (Your Money or Your Life). Insights reais sobre a visibilidade de conteúdos de saúde, fina...

Saiba como otimizar conteúdo Your Money or Your Life (YMYL) para motores de busca de IA como ChatGPT, Perplexity e Overviews de IA do Google. Domine sinais E-E-...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.