Jaké faktory důvěry používají AI enginy k hodnocení zdrojů

Zjistěte, jak AI enginy jako ChatGPT, Perplexity a Google AI hodnotí důvěryhodnost zdrojů. Seznamte se s E-E-A-T, autoritou domény, frekvencí citací a dalšími k...

AI vyhodnocení důvěryhodnosti obsahu na základě odbornosti autora, citací a ověření. Hodnocení důvěryhodnosti zdrojů systematicky analyzuje více dimenzí, včetně odbornosti autora, reputace vydavatele, vzorců citací a výsledků ověřování faktů, aby určilo, zda zdroje informací stojí za zařazení do výzkumu, znalostních bází nebo AI-generovaných souhrnů. Tento automatizovaný proces umožňuje platformám hodnotit důvěryhodnost milionů zdrojů při zachování konzistence, které samotní lidské recenzenti nemohou dosáhnout.

AI vyhodnocení důvěryhodnosti obsahu na základě odbornosti autora, citací a ověření. Hodnocení důvěryhodnosti zdrojů systematicky analyzuje více dimenzí, včetně odbornosti autora, reputace vydavatele, vzorců citací a výsledků ověřování faktů, aby určilo, zda zdroje informací stojí za zařazení do výzkumu, znalostních bází nebo AI-generovaných souhrnů. Tento automatizovaný proces umožňuje platformám hodnotit důvěryhodnost milionů zdrojů při zachování konzistence, které samotní lidské recenzenti nemohou dosáhnout.

Hodnocení důvěryhodnosti zdrojů je systematické posuzování informačních zdrojů s cílem určit jejich důvěryhodnost, spolehlivost a autoritu při poskytování přesných informací. V kontextu AI systémů zahrnuje hodnocení důvěryhodnosti analýzu více dimenzí zdroje, aby bylo možné určit, zda si jeho obsah zaslouží zařazení do výzkumu, citací či znalostních bází. AI hodnocení důvěryhodnosti funguje zkoumáním odbornosti autora—včetně vzdělání, profesních zkušeností a odbornosti v dané oblasti—spolu se vzory citací, které ukazují, jak často a pozitivně jiné autoritativní zdroje na dané dílo odkazují. Proces hodnotí ověřovací mechanismy jako status recenzního řízení, institucionální příslušnost a reputaci místa publikace, aby stanovil základní důvěryhodnost. Signály důvěryhodnosti jsou měřitelné indikátory, které AI systémy detekují a váží, od explicitních znaků typu kvalifikace autora až po implicitní signály získané textovou analýzou a vzory v metadatech. Moderní AI systémy chápou, že důvěryhodnost je mnohorozměrná; zdroj může být vysoce důvěryhodný v jednom oboru, ale postrádat autoritu v jiném, což vyžaduje kontextově citlivé hodnocení. Proces hodnocení je stále důležitější s rostoucím objemem informací a rychlým šířením dezinformací na digitálních platformách. Automatizované hodnocení důvěryhodnosti umožňuje platformám škálovat posuzování milionů zdrojů při zachování konzistence, které samotní lidští recenzenti nemohou dosáhnout. Pochopení fungování těchto systémů pomáhá tvůrcům obsahu, výzkumníkům i vydavatelům optimalizovat své zdroje pro rozpoznání důvěryhodnosti a spotřebitelům umožňuje činit informovaná rozhodnutí o spolehlivosti informací.

AI systémy hodnotí důvěryhodnost zdrojů pomocí sofistikované analýzy více signálů, která kombinuje zpracování přirozeného jazyka, modely strojového učení a vyhodnocení strukturovaných dat. Detekce signálů důvěryhodnosti identifikuje specifické znaky v textu, metadatech a síťových vzorcích, které korelují se spolehlivými informacemi; tyto signály jsou váženy podle jejich prediktivní hodnoty pro přesnost. NLP analýza zkoumá jazykové vzorce, hustotu citací, konkrétnost tvrzení a jistotu jazyka, aby posoudila, zda obsah nese znaky rigorózního výzkumu nebo naopak znaky běžné pro nespolehlivé zdroje. Modely strojového učení trénované na velkých datech ověřených důvěryhodných i nedůvěryhodných zdrojů se učí rozpoznávat složité vzorce, které by lidem unikly, což umožňuje hodnocení v reálném čase ve velkém měřítku. Integrace fact-checkingu porovnává tvrzení se schválenými databázemi a ověřenými fakty, označuje rozpory či nepodložená tvrzení, která snižují skóre důvěryhodnosti. Tyto systémy využívají ensemble metody kombinující více přístupů, protože žádný jednotlivý signál není dokonalým prediktorem důvěryhodnosti. Následující tabulka ukazuje hlavní kategorie signálů, které AI systémy analyzují:

| Typ signálu | Co měří | Příklady |

|---|---|---|

| Akademické signály | Status recenzního řízení, místo publikace, institucionální příslušnost | Impakt faktor časopisu, hodnocení konference, reputace univerzity |

| Textové signály | Kvalita psaní, hustota citací, konkrétnost tvrzení, jazykové vzorce | Správné citace, odborná terminologie, tvrzení podložená důkazy |

| Metadatové signály | Kvalifikace autora, datum publikace, frekvence aktualizací, historie zdroje | Tituly autora, časová osa publikace, historie revizí |

| Sociální signály | Počet citací, vzory sdílení, doporučení expertů, zapojení komunity | Citace na Google Scholar, zmínky v akademické síti, doporučení kolegů |

| Ověřovací signály | Výsledky fact-checkingu, potvrzení tvrzení, transparentnost zdroje | Ověření na Snopes, více nezávislých potvrzení, zveřejnění metodiky |

| Strukturní signály | Organizace obsahu, srozumitelnost metodiky, zveřejnění konfliktů zájmů | Přehledné sekce, transparentní metody, zveřejnění financování |

Nejvlivnější faktory důvěryhodnosti, které AI systémy hodnotí, zahrnují několik propojených dimenzí společně určujících spolehlivost zdroje. Reputace autora je základním znakem důvěryhodnosti—ustálení odborníci ve svém oboru mají výrazně vyšší váhu než neznámí přispěvatelé. Reputace vydavatele rozšiřuje posuzování na institucionální úroveň—zdroje publikované v recenzovaných časopisech či renomovaných nakladatelstvích vykazují vyšší základní důvěryhodnost. Vzory citací ukazují, jak se širší odborná komunita ke zdroji staví; vysoce citované práce v uznávaných médiích signalizují komunitní validaci kvality výzkumu. Aktuálnost je důležitá v kontextu—nové publikace ukazují současné znalosti, zatímco starší základní díla si udržují důvěryhodnost díky svému historickému významu a trvalé relevanci. Algoritmy detekce zaujatosti zkoumají, zda zdroje zveřejňují možné střety zájmů, zdroje financování nebo ideologické pozice, které by mohly ovlivnit závěry. Signály zapojení komunity včetně citací a diskusí mezi odborníky poskytují externí validaci důvěryhodnosti. Mezi nejdůležitější faktory, které AI systémy upřednostňují, patří:

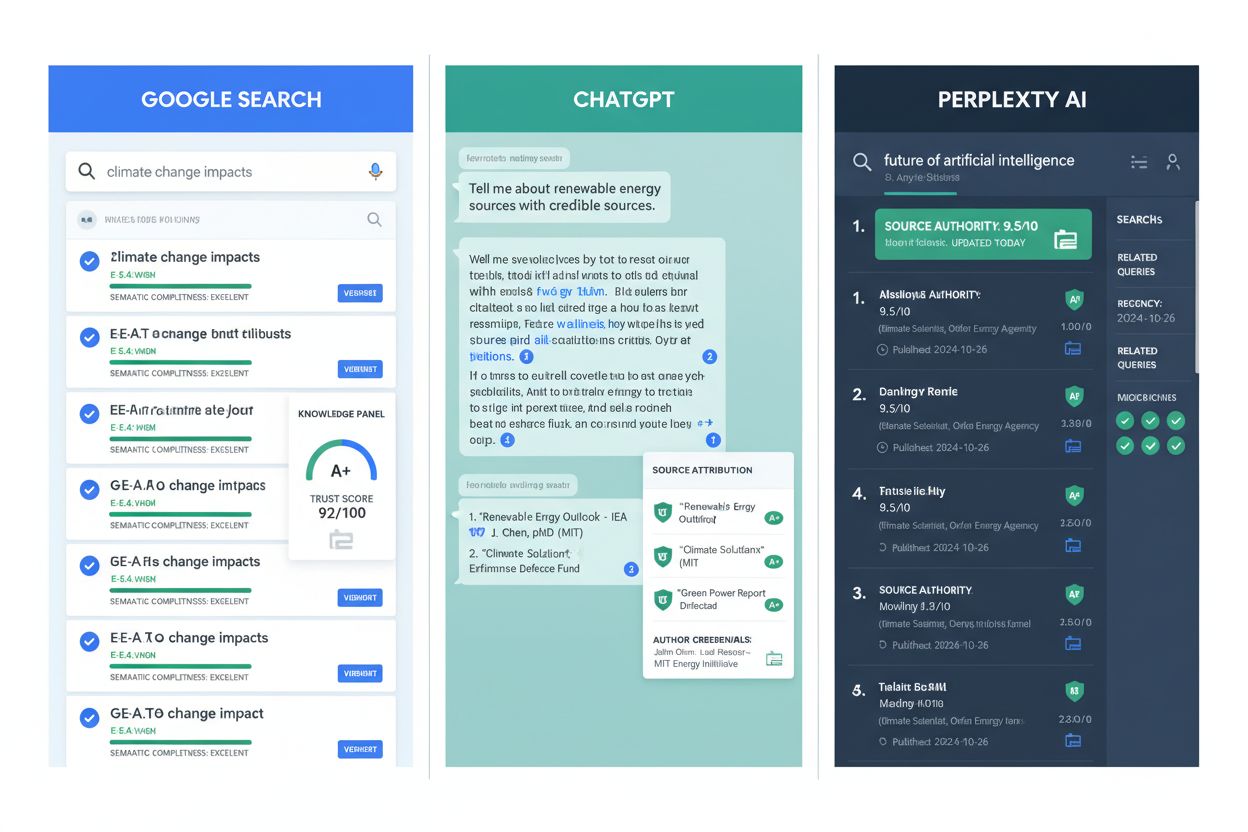

AI hodnocení důvěryhodnosti se stalo nedílnou součástí hlavních informačních platforem a výzkumné infrastruktury. Google AI Overviews využívá signály důvěryhodnosti k určení, které zdroje se objeví v AI-generovaných souhrnech, přičemž upřednostňuje obsah od renomovaných vydavatelů a ověřených expertů. ChatGPT a podobné jazykové modely uplatňují hodnocení důvěryhodnosti při trénování, aby správně vážily jednotlivé zdroje, i když čelí výzvám při reálném hodnocení nových tvrzení. Perplexity AI explicitně začleňuje důvěryhodnost zdrojů do citační metodiky a zobrazuje reputaci zdrojů přímo u výsledků vyhledávání, aby uživatelé mohli lépe posoudit kvalitu informací. Ve vědeckém výzkumu nástroje pro hodnocení důvěryhodnosti pomáhají rychleji identifikovat kvalitní zdroje, což zkracuje čas potřebný na rešerši a zlepšuje základ výzkumu. Iniciativy pro uchování obsahu využívají hodnocení důvěryhodnosti k upřednostnění archivace autoritativních zdrojů, aby i budoucí badatelé měli přístup k ověřeným historickým informacím. AmICited.com slouží jako monitorovací řešení, které sleduje, jak jsou zdroje citovány a hodnoceny napříč platformami, pomáhá vydavatelům pochopit jejich postavení a nacházet příležitosti ke zlepšení. Fact-checkingové organizace využívají automatizované hodnocení důvěryhodnosti k prioritizaci tvrzení pro manuální ověření a soustředí lidské úsilí na nejvýznamnější dezinformace. Vzdělávací instituce stále častěji používají nástroje pro hodnocení důvěryhodnosti při výuce studentů o posuzování zdrojů, a tím činí implicitní kritéria explicitními a měřitelnými. Tato využití ukazují, že hodnocení důvěryhodnosti se posunulo z teoretického rámce do praktické infrastruktury podporující kvalitu informací v digitálních ekosystémech.

Navzdory významnému pokroku čelí automatizované hodnocení důvěryhodnosti závažným omezením, která vyžadují lidský dohled a kontextové posouzení. Zkreslení signálů zapojení představuje zásadní problém—populární zdroje mohou získávat vysoké skóre na základě sociálních signálů, i když obsahují nepřesné informace, protože metriky zapojení ne vždy korelují s přesností. Falešně pozitivní a negativní výsledky nastávají, když algoritmy chybně klasifikují zdroje—zavedení odborníci v nových oborech mohou mít málo citací, zatímco tvůrci dezinformací vytvářejí sofistikované signály důvěryhodnosti. Vyvíjející se dezinformační taktiky záměrně zneužívají systémy hodnocení tím, že napodobují legitimní zdroje, vytvářejí falešné kvalifikace autorů a umělé citace, které automatizované systémy oklamou. Rozdíly v důvěryhodnosti podle oboru znamenají, že zdroj může být důvěryhodný v jednom oboru, ale nikoli v jiném, přesto systémy někdy aplikují jednotné skóre napříč obory. Časová dynamika komplikuje hodnocení; zdroje důvěryhodné při publikaci mohou být později zastaralé či zpochybněné, a proto je nutné jejich průběžné přehodnocování. Kulturní a jazykové zkreslení v trénovacích datech znamená, že systémy mohou podhodnocovat zdroje z neanglicky mluvících regionů či z nedostatečně zastoupených komunit, což udržuje existující nerovnosti v přístupu k informacím. Problémy s transparentností vyplývají z toho, že mnoho algoritmů funguje jako black box, což ztěžuje zdrojům pochopit, jak své signály zlepšit, i uživatelům pochopit, proč konkrétní zdroj získal určité skóre. Tato omezení ukazují, že automatizované hodnocení důvěryhodnosti by mělo doplňovat, nikoli nahrazovat lidské kritické posouzení.

Tvůrci obsahu a vydavatelé mohou výrazně zlepšit své signály důvěryhodnosti zavedením praxí podložených důkazy, které odpovídají tomu, jak AI systémy hodnotí spolehlivost. Implementujte principy E-E-A-T—prokazujte zkušenosti, odbornost, autoritu a důvěryhodnost—jasným zobrazením kvalifikace autorů, profesních příslušností a relevantních referencí na stránkách s obsahem. Správné citační postupy posilují důvěryhodnost odkazováním na kvalitní zdroje, jednotným formátováním citací a zajištěním, že všechna tvrzení mají ověřitelný základ; to signalizuje, že obsah je postaven na ověřených znalostech, nikoli na spekulacích. Transparentnost metodiky pomáhá AI systémům rozpoznat rigorózní výzkumné postupy; jasně vysvětlete zdroje dat, výzkumné metody, omezení a případné střety zájmů. Udržujte profily autorů s detailními biografickými údaji, publikační historií a profesními kvalifikacemi, které AI systémy mohou ověřovat. Pravidelně aktualizujte obsah a prokažte tak závazek k přesnosti; zastaralé informace snižují skóre důvěryhodnosti, zatímco pravidelné revize dávají najevo, že sledujete nové poznatky ve svém oboru. Zveřejňujte zdroje financování a příslušnosti explicitně, protože transparentnost ohledně možných zaujatostí ve skutečnosti důvěryhodnost zvyšuje—AI systémy rozpoznávají, že zveřejněné konflikty jsou méně problematické než skryté. Budujte citační autoritu publikováním v renomovaných médiích, podstupováním peer review a získáváním citací od dalších důvěryhodných zdrojů; tím vznikají pozitivní zpětné vazby, kdy důvěryhodnost rodí další důvěryhodnost. Zapojte se do odborné komunity účastí na konferencích, spoluprací a diskusí, protože tyto signály validují odbornost a zvyšují viditelnost vašich zdrojů pro AI hodnocení důvěryhodnosti. Implementujte strukturovaná data (např. pomocí schema.org) pro automatickou extrakci a ověřování informací o autorovi, datu publikace a dalších signálů důvěryhodnosti AI systémy.

Vývoj hodnocení důvěryhodnosti zdrojů bude čím dál více zahrnovat multimodální hodnocení, které analyzuje text, obrázky, video i audio dohromady, aby odhalilo sofistikované dezinformace využívající slabiny jedné modality. Systémy pro ověřování v reálném čase se integrují s nástroji pro tvorbu obsahu a umožní okamžitou zpětnou vazbu autorům přímo při publikaci, což pomůže zabránit šíření dezinformací ještě před zveřejněním. Sledování důvěryhodnosti založené na blockchainu může umožnit neměnitelné záznamy o historii zdroje, citacích a opravách, což vytvoří transparentní původ důvěryhodnosti, který AI systémy dokážou spolehlivě vyhodnocovat. Personalizované hodnocení důvěryhodnosti překoná univerzální skórování a bude zohledňovat odbornou úroveň a potřeby jednotlivých uživatelů, protože důvěryhodnost je částečně subjektivní a závislá na kontextu. Integrace se znalostními grafy umožní AI systémům hodnotit zdroje nejen izolovaně, ale i v síti souvisejících informací, identifikovat zdroje odporující ustáleným znalostem nebo naopak vyplňující důležité mezery. Vysvětlitelné AI systémy pro hodnocení důvěryhodnosti se stanou standardem a nabídnou transparentní zdůvodnění skóre, což umožní tvůrcům zlepšovat se a uživatelům rozumět, proč zdroj získal určité hodnocení. Systémy s kontinuálním učením budou reagovat na nové dezinformační taktiky v reálném čase a aktualizovat modely hodnocení důvěryhodnosti podle nových manipulačních technik, místo spoléhání na statická trénovací data. Napříč-platformní sledování důvěryhodnosti vytvoří jednotné profily zdrojů napříč internetem, což ztíží šíření různých reputací na různých platformách. Tyto trendy zajistí, že hodnocení důvěryhodnosti bude stále sofistikovanější, transparentnější a pevně integrované do informační infrastruktury, na kterou se denně spoléhají miliardy lidí.

Hodnocení důvěryhodnosti zdrojů je systematické posuzování informačních zdrojů s cílem určit jejich spolehlivost a důvěryhodnost. AI systémy analyzují více dimenzí, včetně odbornosti autora, reputace vydavatele, vzorců citací a výsledků ověřování faktů, aby zjistily, zda si zdroje zaslouží zařazení do výzkumu, znalostních bází nebo AI-generovaných souhrnů. Tento automatizovaný proces umožňuje platformám konzistentně hodnotit miliony zdrojů.

AI systémy detekují signály důvěryhodnosti pomocí zpracování přirozeného jazyka, modelů strojového učení a analýzy strukturovaných dat. Zkoumají akademické signály (status recenzního řízení, institucionální příslušnost), textové signály (hustota citací, konkrétnost tvrzení), metadatové signály (odborné kvalifikace autora, data publikace), sociální signály (počty citací, doporučení expertů) a ověřovací signály (výsledky ověřování faktů, potvrzení tvrzení). Tyto signály jsou váženy podle jejich prediktivní hodnoty pro přesnost.

Nejdůležitější faktory důvěryhodnosti zahrnují reputaci a odbornost autora, reputaci vydavatele, počet a kvalitu citací, aktuálnost, zveřejnění zaujatosti a konfliktů zájmů, signály zapojení odborné komunity, ověření zdroje pomocí fact-checkingu, integraci s ověřenými znalostmi, spojení tvůrce s renomovanými institucemi a četnost aktualizací. Tyto faktory společně určují spolehlivost a důvěryhodnost zdroje.

Vydavatelé mohou zvýšit důvěryhodnost zavedením principů E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness), používáním správných citačních postupů, transparentní metodikou, zobrazením detailních profilů autorů s kvalifikacemi, pravidelnou aktualizací obsahu, zveřejněním zdrojů financování a příslušností, budováním citační autority skrze peer review, zapojením do odborné komunity a implementací strukturovaných dat pro snadnější extrakci informací o důvěryhodnosti AI systémy.

Automatizované hodnocení důvěryhodnosti čelí výzvám jako je zkreslení signálů zapojení (populární zdroje mohou získávat vysoké skóre i při nepřesnosti), falešně pozitivní a negativní výsledky, vyvíjející se dezinformační taktiky napodobující legitimní zdroje, odlišnosti v důvěryhodnosti podle oboru, časová dynamika (zastaralost zdrojů), kulturní a jazykové zkreslení v trénovacích datech a problémy s transparentností u black-box algoritmů. Tato omezení znamenají, že automatizované hodnocení by mělo doplňovat, nikoli nahrazovat lidské kritické posouzení.

Google AI Overviews upřednostňuje zdroje od renomovaných vydavatelů a ověřených expertů pro AI-generované souhrny. ChatGPT zohledňuje důvěryhodnost zdrojů při tréninku na základě signálů důvěryhodnosti. Perplexity zobrazuje reputaci zdrojů přímo u výsledků vyhledávání. AmICited.com sleduje, jak jsou zdroje citovány napříč všemi hlavními AI platformami a pomáhá vydavatelům pochopit jejich postavení a najít příležitosti ke zlepšení.

Budoucí vývoj zahrnuje multimodální hodnocení analyzující text, obrázky, video a audio dohromady; systémy pro ověřování v reálném čase poskytující okamžitou zpětnou vazbu; sledování důvěryhodnosti na blockchainu; personalizované hodnocení podle odbornosti uživatele; integraci se znalostními grafy; vysvětlitelné AI systémy s transparentním zdůvodněním hodnocení; kontinuální učení reagující na nové dezinformační taktiky a napříč-platformní sledování důvěryhodnosti vytvářející jednotné profily zdrojů.

Hodnocení důvěryhodnosti zdrojů je klíčové, protože určuje, které zdroje se objeví v AI-generovaných souhrnech, ovlivňuje tréninková data AI a formuje informace, se kterými se setkávají miliardy lidí. Přesné hodnocení důvěryhodnosti pomáhá zabránit šíření dezinformací, zajišťuje spolehlivost informací z AI systémů, podporuje kvalitu akademického výzkumu a udržuje důvěru v AI-informační systémy. S rostoucím vlivem AI na objevování informací je hodnocení důvěryhodnosti stále důležitější.

Sledujte, jak jsou vaše zdroje citovány a hodnoceny na Google AI Overviews, ChatGPT, Perplexity a Gemini. AmICited.com vám pomůže porozumět vašemu postavení v oblasti důvěryhodnosti a odhalit příležitosti ke zlepšení.

Zjistěte, jak AI enginy jako ChatGPT, Perplexity a Google AI hodnotí důvěryhodnost zdrojů. Seznamte se s E-E-A-T, autoritou domény, frekvencí citací a dalšími k...

Zjistěte, které zdroje AI enginy nejčastěji citují. Poznejte, jak ChatGPT, Google AI Overviews a Perplexity hodnotí důvěryhodnost zdrojů a pochopte vzory citací...

Zjistěte, jak zvýšit AI signály důvěryhodnosti napříč ChatGPT, Perplexity a Google AI Overviews. Budujte identitu entity, důkazy a technickou důvěryhodnost pro ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.