Transparenz in AI-Transparenzbemühungen: Offenlegungs-Best Practices

Erfahren Sie wesentliche Best Practices für AI-Transparenz und Offenlegung. Entdecken Sie Verhaltens-, verbale und technische Offenlegungsmethoden, um Vertrauen...

Das Ausmaß, in dem KI-Plattformen offenlegen, wie sie Quellen auswählen und einstufen, wenn sie Antworten generieren. Transparenz bei der KI-Rangfolge bezieht sich auf die Sichtbarkeit der Algorithmen und Kriterien, die bestimmen, welche Quellen in KI-generierten Antworten erscheinen, und unterscheidet sich damit von der traditionellen Suchmaschinen-Rangfolge. Diese Transparenz ist entscheidend für Content-Ersteller, Publisher und Nutzer, die nachvollziehen müssen, wie Informationen ausgewählt und priorisiert werden. Ohne Transparenz können Nutzer die Glaubwürdigkeit von Quellen nicht überprüfen oder mögliche Verzerrungen in KI-generierten Inhalten erkennen.

Das Ausmaß, in dem KI-Plattformen offenlegen, wie sie Quellen auswählen und einstufen, wenn sie Antworten generieren. Transparenz bei der KI-Rangfolge bezieht sich auf die Sichtbarkeit der Algorithmen und Kriterien, die bestimmen, welche Quellen in KI-generierten Antworten erscheinen, und unterscheidet sich damit von der traditionellen Suchmaschinen-Rangfolge. Diese Transparenz ist entscheidend für Content-Ersteller, Publisher und Nutzer, die nachvollziehen müssen, wie Informationen ausgewählt und priorisiert werden. Ohne Transparenz können Nutzer die Glaubwürdigkeit von Quellen nicht überprüfen oder mögliche Verzerrungen in KI-generierten Inhalten erkennen.

Transparenz bei der KI-Rangfolge bezeichnet die Offenlegung, wie künstliche Intelligenz Systeme Quellen auswählt, priorisiert und präsentiert, wenn Antworten auf Nutzeranfragen generiert werden. Anders als traditionelle Suchmaschinen, die sortierte Linklisten anzeigen, integrieren moderne KI-Plattformen wie Perplexity, ChatGPT und Googles AI Overviews die Quellenauswahl direkt in den Antwortprozess, wodurch die Ranking-Kriterien für Nutzer weitgehend unsichtbar bleiben. Diese Intransparenz schafft eine entscheidende Lücke zwischen dem, was Nutzer sehen (eine zusammengefasste Antwort), und dem, wie diese Antwort entstanden ist (welche Quellen ausgewählt, gewichtet und zitiert wurden). Für Content-Ersteller und Publisher bedeutet dieser Mangel an Transparenz, dass ihre Sichtbarkeit von Algorithmen abhängt, die sie weder verstehen noch durch klassische Optimierungsmethoden beeinflussen können. Der Unterschied zur Transparenz traditioneller Suchmaschinen ist erheblich: Während Google allgemeine Rankingfaktoren und Qualitätsrichtlinien veröffentlicht, behandeln KI-Plattformen ihre Quellenauswahl-Mechanismen oft als Geschäftsgeheimnis. Betroffen sind vor allem Content-Ersteller, die Sichtbarkeit anstreben, Publisher, die sich um Traffic-Attribution sorgen, Markenverantwortliche, die ihre Reputation überwachen, Forschende, die Informationsquellen prüfen, und Nutzer, die die Glaubwürdigkeit KI-generierter Antworten einschätzen müssen. Transparenz bei der KI-Rangfolge zu verstehen, ist für alle, die digitale Inhalte produzieren, verbreiten oder nutzen, in einer zunehmend KI-vermittelten Informationslandschaft unerlässlich.

KI-Plattformen verwenden Retrieval-Augmented Generation (RAG)-Systeme, die Sprachmodelle mit Echtzeit-Informationsbeschaffung kombinieren, damit Antworten auf echten Quellen statt ausschließlich auf Trainingsdaten beruhen. Der RAG-Prozess umfasst drei Hauptphasen: Retrieval (Auffinden relevanter Dokumente), Ranking (Reihenfolge nach Relevanz), und Generierung (Synthese der Informationen unter Beibehaltung der Zitate). Unterschiedliche Plattformen setzen verschiedene Ranking-Ansätze um—Perplexity priorisiert Quellautorität und Aktualität, Googles AI Overviews betonen thematische Relevanz und E-E-A-T-Signale (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit), während ChatGPT Search Quellenqualität und Antwort-Vollständigkeit ausbalanciert. Faktoren, die die Quellenauswahl beeinflussen, sind typischerweise Domain-Autorität (etablierter Ruf und Backlink-Profil), Aktualität der Inhalte (Informationsfrische), thematische Relevanz (semantische Übereinstimmung mit der Anfrage), Engagement-Signale (Nutzerinteraktionen) und Zitierhäufigkeit (wie oft Quellen von anderen autoritativen Seiten referenziert werden). KI-Systeme gewichten diese Signale je nach Suchintention unterschiedlich—faktische Anfragen bevorzugen meist Autorität und Aktualität, während meinungsbasierte Anfragen auf Vielfalt und Engagement setzen. Die Ranking-Algorithmen bleiben weitgehend undokumentiert, auch wenn Plattformdokumentationen begrenzte Einblicke in die Gewichtung bieten.

| Plattform | Zitations-Transparenz | Kriterien der Quellenauswahl | Offenlegung des Ranking-Algorithmus | Nutzerkontrolle |

|---|---|---|---|---|

| Perplexity | Hoch – Inline-Zitate mit Links | Autorität, Aktualität, Relevanz, thematische Expertise | Mittel – teilweise Dokumentation | Mittel – Quellfilterung möglich |

| Google AI Overviews | Mittel – Quellen werden aufgeführt | E-E-A-T, thematische Relevanz, Aktualität, Engagement | Gering – kaum Offenlegung | Gering – wenig Anpassungsmöglichkeiten |

| ChatGPT Search | Mittel – Quellen separat gelistet | Qualität, Relevanz, Vollständigkeit, Autorität | Gering – proprietärer Algorithmus | Gering – keine Anpassung |

| Brave Leo | Mittel – Quellenzuordnung | Datenschutzfreundliche Quellen, Relevanz, Autorität | Gering – Privacy-Fokus, wenig Einblick | Mittel – Quellenauswahl möglich |

| Consensus | Sehr hoch – Fokus auf Wissenschaft mit Metriken | Zitationsanzahl, Peer-Review-Status, Aktualität, Fachrelevanz | Hoch – akademische Standards transparent | Hoch – Filter nach Studientyp und Qualität |

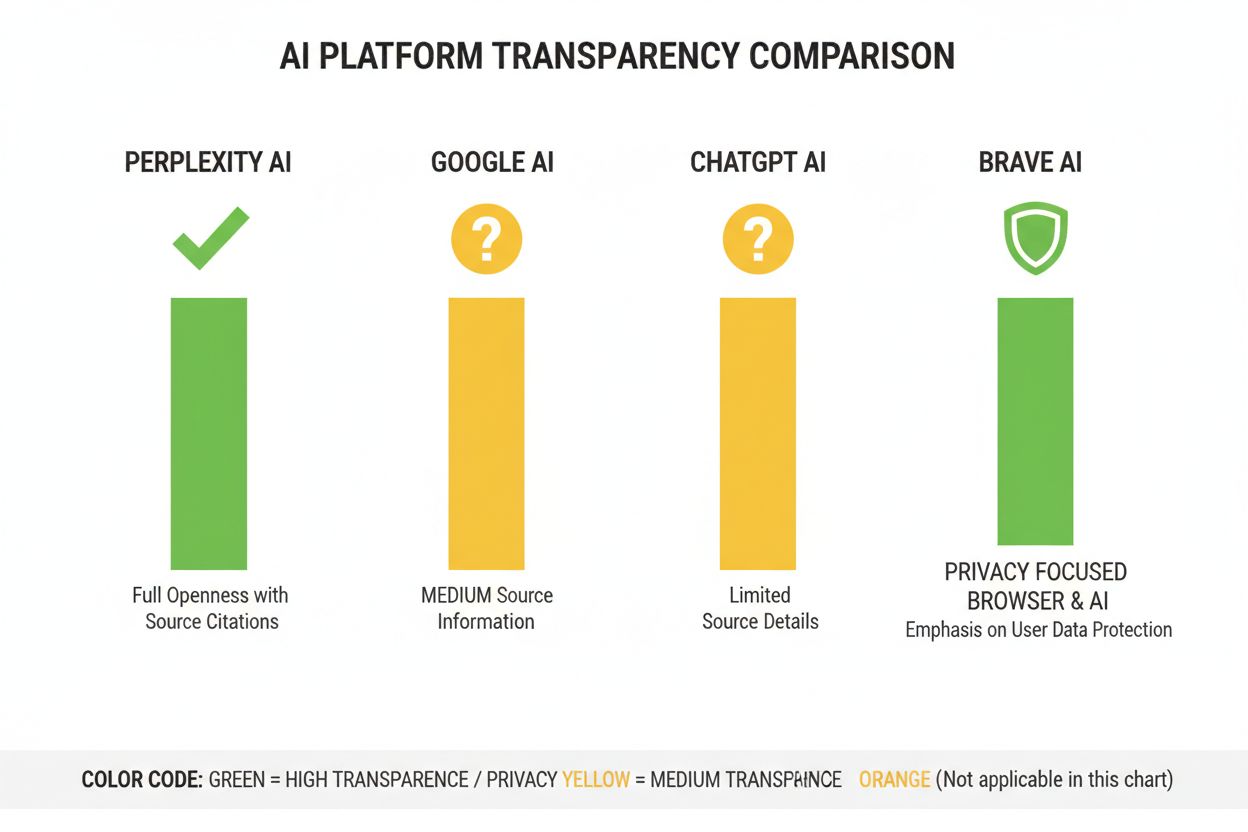

In der KI-Branche fehlen standardisierte Offenlegungspraktiken darüber, wie Rankingsysteme funktionieren, sodass jede Plattform ihr eigenes Transparenzniveau bestimmt. OpenAIs ChatGPT Search liefert nur minimale Erklärungen zur Quellenauswahl, Metas KI-Systeme bieten wenig Dokumentation, und Googles AI Overviews legen zwar mehr offen als Konkurrenzprodukte, halten aber kritische algorithmische Details zurück. Plattformen lehnen vollständige Offenlegung mit Verweis auf Wettbewerbsvorteile, Geschäftsgeheimnisse und die Komplexität von Machine-Learning-Systemen ab—diese Intransparenz verhindert jedoch externe Prüfungen und Verantwortlichkeit. Das „Source Laundering“-Problem entsteht, wenn KI-Systeme Quellen zitieren, die ihrerseits Inhalte aggregieren oder umschreiben, wodurch der wahre Ursprung von Informationen verschleiert und Fehlinformationen durch mehrfache Synthese verstärkt werden können. Der EU AI Act verpflichtet Hochrisiko-KI-Systeme zur Dokumentation von Trainingsdaten und Entscheidungsprozessen, während die NTIA AI Accountability Policy Unternehmen zur Offenlegung von Fähigkeiten, Grenzen und Anwendungsfällen ihrer KI-Systeme auffordert. Beispiele für mangelnde Offenlegung sind Perplexitys anfängliche Schwierigkeiten mit korrekter Attribution (später verbessert), Googles vage Erklärungen zur Quellenauswahl in AI Overviews und ChatGPTs eingeschränkte Transparenz darüber, warum bestimmte Quellen erscheinen und andere nicht. Das Fehlen standardisierter Metriken zur Messung der Transparenz erschwert Nutzern und Aufsichtsbehörden den objektiven Vergleich von Plattformen.

Die Intransparenz von KI-Ranking-Systemen führt zu erheblichen Sichtbarkeitsproblemen für Content-Ersteller, da klassische SEO-Strategien für Suchmaschinen nicht direkt auf die Optimierung für KI-Plattformen übertragbar sind. Publisher können nicht nachvollziehen, warum ihre Inhalte in manchen KI-Antworten erscheinen und in anderen nicht, was gezielte Strategien zur Verbesserung der Sichtbarkeit unmöglich macht. Zitations-Bias entsteht, wenn KI-Systeme bestimmte Quellen bevorzugen—etablierte Medienhäuser, akademische Institutionen oder reichweitenstarke Websites—während kleinere Publisher, unabhängige Ersteller und Nischenexperten, die ebenso wertvolle Informationen bieten, benachteiligt werden. Gerade kleinere Publisher sind im Nachteil, da KI-Rankings oft stark auf Domain-Autorität setzen und neue oder spezialisierte Seiten meist weder Backlink-Profile noch Markenbekanntheit etablierter Anbieter besitzen. Laut Search Engine Land haben AI Overviews die Klickrate auf klassische Suchergebnisse je nach Suchtyp um 18–64 % verringert, wobei der Traffic sich auf die wenigen in KI-Antworten zitierten Quellen konzentriert. Der Unterschied zwischen SEO (Search Engine Optimization) und GEO (Generative Engine Optimization) wird entscheidend—während SEO auf klassische Suchmaschinen abzielt, verlangt GEO ein Verständnis der KI-Auswahlkriterien, die weiterhin undurchsichtig bleiben. Content-Ersteller benötigen Tools wie AmICited.com, um zu überwachen, wo ihre Inhalte in KI-Ergebnissen erscheinen, wie oft sie zitiert werden und wie ihre Sichtbarkeit auf verschiedenen KI-Plattformen ausfällt.

Die KI-Branche hat mehrere Rahmenwerke zur Dokumentation und Offenlegung von Systemverhalten entwickelt, deren Umsetzung jedoch plattformübergreifend unterschiedlich ist. Model Cards bieten standardisierte Dokumentationen zur Leistung von Machine-Learning-Modellen, Anwendungsfällen, Grenzen und Bias-Analysen – ähnlich wie Nährwertangaben bei Lebensmitteln. Datasheets for Datasets dokumentieren Zusammensetzung, Erhebungsmethoden und mögliche Verzerrungen in Trainingsdaten und machen deutlich, dass KI-Systeme nur so gut wie ihr Trainingsmaterial sind. System Cards verfolgen einen breiteren Ansatz und dokumentieren das Verhalten gesamter Systeme, einschließlich Komponenteninteraktionen, möglichen Fehlerquellen und realer Leistung für verschiedene Nutzergruppen. Die NTIA AI Accountability Policy empfiehlt Unternehmen, detaillierte Dokumentationen über Entwicklung, Test und Einsatz von KI-Systemen zu führen – mit speziellem Fokus auf Hochrisiko-Anwendungen im öffentlichen Interesse. Der EU AI Act schreibt vor, dass Hochrisiko-KI-Systeme technische Dokumentation, Trainingsdatenaufzeichnungen und Leistungsprotokolle führen sowie Transparenzberichte und Nutzerhinweise bereitstellen. Zu den Best Practices der Branche gehören zunehmend:

Perplexity positioniert sich als die zitations-transparenteste KI-Plattform und zeigt während der gesamten Antwort Inline-Quellenlinks an, sodass Nutzer genau nachvollziehen können, welche Quelle zu welchem Statement beigetragen hat. Die Plattform dokumentiert ihren Ranking-Ansatz relativ klar und betont Quellautorität, thematische Expertise und Aktualität, auch wenn die genaue Gewichtung proprietär bleibt. Googles AI Overviews bieten mittlere Transparenz, indem sie die zitierten Quellen am Ende der Antwort auflisten, aber kaum offenlegen, warum bestimmte Quellen ausgewählt wurden oder wie der Ranking-Algorithmus verschiedene Signale gewichtet. Googles Dokumentation hebt E-E-A-T-Prinzipien hervor, legt aber nicht offen, wie diese gemessen oder im Ranking gewichtet werden. OpenAIs ChatGPT Search nimmt eine Mittelstellung ein, listet Quellen separat vom Antworttext und ermöglicht das Anklicken der Originalartikel, liefert aber kaum Erklärungen zu Auswahlkriterien oder Ranking-Methodik. Brave Leo setzt auf datenschutzorientierte Transparenz, gibt an, dass nur privacy-freundliche Quellen genutzt und Nutzeranfragen nicht getrackt werden—auf Kosten einer detaillierten Erklärung der Ranking-Mechanismen. Consensus hebt sich ab, indem der Fokus ausschließlich auf wissenschaftlicher Forschung liegt und durch Zitationsmetriken, Peer-Review-Status und Studienqualitätsindikatoren hohe Transparenz für forschungsbezogene Anfragen bietet. Die Nutzerkontrolle variiert stark: Perplexity erlaubt Quellfilterung, Consensus Filter nach Studientyp und Qualität, während Google und ChatGPT kaum Anpassungsmöglichkeiten für das Ranking bieten. Die Unterschiede spiegeln verschiedene Geschäftsmodelle und Zielgruppen wider: Akademisch orientierte Plattformen priorisieren Offenlegung, während Endnutzer-orientierte Plattformen Transparenz und Geschäftsgeheimnisse abwägen.

Vertrauen und Glaubwürdigkeit hängen grundlegend davon ab, dass Nutzer verstehen, wie Informationen zu ihnen gelangen—wenn KI-Systeme ihre Quellen oder Ranking-Logik verschleiern, können Behauptungen nicht unabhängig überprüft und Quellen nicht auf Zuverlässigkeit bewertet werden. Transparenz ermöglicht Verifikation und Faktenprüfung, sodass Forschende, Journalist:innen und informierte Nutzer Aussagen auf Originalquellen zurückverfolgen und deren Genauigkeit sowie Kontext bewerten können. Die Vorteile bei der Vermeidung von Fehlinformationen und Bias sind beträchtlich: Werden Ranking-Algorithmen offengelegt, lassen sich systematische Verzerrungen (etwa zugunsten bestimmter politischer oder kommerzieller Interessen) erkennen und Plattformen für die Verbreitung falscher Informationen verantwortlich machen. Algorithmische Verantwortlichkeit ist ein grundlegendes Nutzerrecht in demokratischen Gesellschaften—Menschen haben ein Recht darauf zu wissen, wie Systeme, die ihre Informationsumgebung prägen, Entscheidungen treffen, insbesondere wenn diese Systeme öffentliche Meinungen, Kaufentscheidungen oder Wissenszugänge beeinflussen. Für Forschung und Wissenschaft ist Transparenz essenziell, da Forschende die Quellenauswahl nachvollziehen müssen, um KI-generierte Zusammenfassungen richtig einzuordnen und nicht unbeabsichtigt auf verzerrte oder unvollständige Quellen zu vertrauen. Die Geschäftsauswirkungen für Content-Ersteller sind erheblich: Ohne Kenntnisse der Ranking-Faktoren können Publisher ihre Content-Strategie nicht optimieren, kleinere Anbieter nicht fair mit etablierten konkurrieren und das gesamte Ökosystem wird weniger meritokratisch. Transparenz schützt außerdem vor Manipulation—bei verborgenen Ranking-Kriterien können Schwachstellen unbemerkt missbraucht werden, während transparente Systeme überprüft und verbessert werden können.

Regulatorische Entwicklungen treiben eine verpflichtende Transparenz voran: Der EU AI Act wird ab 2025–2026 detaillierte Dokumentations- und Offenlegungspflichten für Hochrisiko-KI-Systeme vorschreiben, ähnliche Regelungen stehen im Vereinigten Königreich, in Kalifornien und anderen Regionen an. Die Branche bewegt sich auf eine Standardisierung der Transparenzpraktiken zu, etwa durch Initiativen der Partnership on AI und akademische Rahmenwerke zur Dokumentation und Offenlegung von KI-Systemverhalten. Nutzer verlangen zunehmend Transparenz, da das Bewusstsein für die Rolle von KI in der Informationsverbreitung wächst—Umfragen zufolge möchten über 70 % der Nutzer verstehen, wie KI-Systeme Quellen auswählen und Informationen einstufen. Technische Innovationen im Bereich Explainable AI (XAI) machen es zunehmend möglich, detaillierte Erklärungen für Ranking-Entscheidungen zu liefern, ohne Geschäftsgeheimnisse vollständig offenzulegen, etwa durch Methoden wie LIME (Local Interpretable Model-agnostic Explanations) und SHAP (SHapley Additive Explanations). Monitoring-Tools wie AmICited.com werden wichtiger, da Plattformen Transparenzmaßnahmen implementieren und Content-Ersteller sowie Publisher ihre Sichtbarkeit über verschiedene KI-Systeme hinweg verfolgen und Ranking-Veränderungen nachvollziehen können. Das Zusammenspiel aus Regulatorik, Nutzererwartungen und technischen Möglichkeiten deutet darauf hin, dass 2025–2026 entscheidende Jahre für die Transparenz bei der KI-Rangfolge werden—mit zunehmender Standardisierung, mehr Nutzerkontrolle bei der Quellenauswahl und klareren Erklärungen der Ranking-Logik. Die Zukunft dürfte gestufte Transparenz bieten: Akademische Plattformen gehen mit hoher Offenlegung voran, Verbraucher-Plattformen bieten mittlere Transparenz mit Anpassungsoptionen und regulatorische Compliance wird zur Grundvoraussetzung in der Branche.

Transparenz bei der KI-Rangfolge beschreibt, wie offen KI-Plattformen ihre Algorithmen zur Auswahl und Einstufung von Quellen in generierten Antworten offenlegen. Sie ist wichtig, weil Nutzer die Glaubwürdigkeit von Quellen verstehen müssen, Content-Ersteller für KI-Sichtbarkeit optimieren wollen und Forschende Informationsquellen verifizieren müssen. Ohne Transparenz können KI-Systeme Fehlinformationen verstärken und etablierten Medienhäusern unfaire Vorteile gegenüber kleineren Publishern verschaffen.

KI-Plattformen nutzen Retrieval-Augmented Generation (RAG)-Systeme, die Sprachmodelle mit Echtzeit-Informationsbeschaffung kombinieren. Sie stufen Quellen nach Faktoren wie Domain-Autorität, Aktualität der Inhalte, thematischer Relevanz, Engagement-Signalen und Häufigkeit von Zitationen ein. Die genaue Gewichtung dieser Faktoren bleibt jedoch bei den meisten Plattformen weitgehend proprietär und nicht offengelegt.

Traditionelles SEO konzentriert sich auf die Platzierung in Linklisten von Suchmaschinen, wobei Google allgemeine Rankingfaktoren veröffentlicht. Transparenz bei der KI-Rangfolge betrifft, wie KI-Plattformen Quellen für zusammengefasste Antworten auswählen – das geschieht nach anderen Kriterien und bleibt meist unausgesprochen. Während SEO-Strategien gut dokumentiert sind, bleiben KI-Rankingfaktoren überwiegend undurchsichtig.

Sie können die Originalquellen aufrufen, um Behauptungen im Gesamtkontext zu überprüfen, prüfen, ob es sich um autoritative Domains handelt, auf Peer-Review-Status achten (insbesondere bei wissenschaftlichen Inhalten) und Informationen aus mehreren Quellen abgleichen. Tools wie AmICited helfen dabei, nachzuverfolgen, welche Quellen in KI-Antworten erscheinen und wie oft Ihre Inhalte zitiert werden.

Consensus ist führend in Sachen Transparenz, da der Fokus ausschließlich auf begutachteter wissenschaftlicher Forschung mit klaren Zitationsmetriken liegt. Perplexity bietet Inline-Quellenangaben und moderate Dokumentation der Rankingfaktoren. Googles AI Overviews bieten mittlere Transparenz, während ChatGPT Search und Brave Leo ihre Ranking-Algorithmen nur begrenzt offenlegen.

Model Cards sind standardisierte Dokumentationen zu Leistung, beabsichtigten Einsatzzwecken, Grenzen und Bias-Analysen von KI-Systemen. Datasheets dokumentieren Zusammensetzung, Erhebungsmethoden und mögliche Verzerrungen der Trainingsdaten. System Cards beschreiben das Verhalten kompletter Systeme. Diese Tools machen KI-Systeme transparenter und vergleichbar – ähnlich wie Nährwertangaben bei Lebensmitteln.

Der EU AI Act verlangt von Hochrisiko-KI-Systemen die Führung detaillierter technischer Dokumentationen, Trainingsdaten-Aufzeichnungen und Leistungsprotokolle. Er schreibt Transparenzberichte und Nutzerhinweise über den Einsatz von KI-Systemen vor. Diese Anforderungen drängen KI-Plattformen zu mehr Offenlegung ihrer Ranking-Mechanismen und Kriterien der Quellenauswahl.

AmICited.com ist eine Plattform zur Überwachung von KI-Zitierungen, die verfolgt, wie KI-Systeme wie Perplexity, Google AI Overviews und ChatGPT Ihre Marke und Inhalte zitieren. Sie bietet Einblicke, welche Quellen in KI-Antworten erscheinen, wie oft Ihre Inhalte zitiert werden und wie Ihre Ranking-Transparenz im Vergleich zu verschiedenen KI-Plattformen aussieht.

Verfolgen Sie, wie KI-Plattformen wie Perplexity, Google AI Overviews und ChatGPT Ihre Inhalte zitieren. Verstehen Sie Ihre Ranking-Transparenz und optimieren Sie Ihre Sichtbarkeit über KI-Suchmaschinen hinweg mit AmICited.

Erfahren Sie wesentliche Best Practices für AI-Transparenz und Offenlegung. Entdecken Sie Verhaltens-, verbale und technische Offenlegungsmethoden, um Vertrauen...

Entdecken Sie die besten Inhaltsformate für KI-Suchmaschinen wie ChatGPT, Perplexity und Google AI Overviews. Erfahren Sie, wie Sie Ihre Inhalte für KI-Sichtbar...

Erfahren Sie, was eine Enterprise-AI-Transparenzstrategie ist und warum große Organisationen umfassende Ansätze benötigen, um KI-Systeme im großen Maßstab zu üb...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.