Cómo Manejar el Contenido Duplicado para Motores de Búsqueda de IA

Aprende a gestionar y prevenir el contenido duplicado al usar herramientas de IA. Descubre etiquetas canónicas, redirecciones, herramientas de detección y mejor...

La lógica de deduplicación con IA se refiere a los procesos y algoritmos automatizados que los sistemas de inteligencia artificial utilizan para identificar, analizar y eliminar información redundante o duplicada procedente de múltiples fuentes. Estos sistemas emplean técnicas de aprendizaje automático, procesamiento de lenguaje natural y comparación de similitud para reconocer contenido idéntico o altamente similar en diversos repositorios de datos, garantizando la calidad de los datos, reduciendo los costes de almacenamiento y mejorando la precisión en la toma de decisiones.

La lógica de deduplicación con IA se refiere a los procesos y algoritmos automatizados que los sistemas de inteligencia artificial utilizan para identificar, analizar y eliminar información redundante o duplicada procedente de múltiples fuentes. Estos sistemas emplean técnicas de aprendizaje automático, procesamiento de lenguaje natural y comparación de similitud para reconocer contenido idéntico o altamente similar en diversos repositorios de datos, garantizando la calidad de los datos, reduciendo los costes de almacenamiento y mejorando la precisión en la toma de decisiones.

La lógica de deduplicación con IA es un proceso algorítmico sofisticado que identifica y elimina registros duplicados o casi duplicados de grandes conjuntos de datos utilizando técnicas de inteligencia artificial y aprendizaje automático. Esta tecnología detecta automáticamente cuándo varias entradas representan la misma entidad—ya sea una persona, producto, documento o información—a pesar de variaciones en el formato, la ortografía o la presentación. El objetivo principal de la deduplicación es mantener la integridad de los datos y prevenir la redundancia que puede distorsionar el análisis, inflar los costes de almacenamiento y comprometer la precisión en la toma de decisiones. En el mundo actual impulsado por los datos, donde las organizaciones procesan millones de registros a diario, la deduplicación efectiva se ha vuelto esencial para la eficiencia operativa y la obtención de conocimientos fiables.

La deduplicación con IA emplea múltiples técnicas complementarias para identificar y agrupar registros similares con notable precisión. El proceso comienza analizando atributos de los datos—como nombres, direcciones, correos electrónicos y otros identificadores—y comparándolos con umbrales de similitud establecidos. Los sistemas modernos de deduplicación utilizan una combinación de comparación fonética, algoritmos de similitud de cadenas y análisis semántico para detectar duplicados que los sistemas tradicionales basados en reglas podrían pasar por alto. El sistema asigna puntuaciones de similitud a las coincidencias potenciales, agrupando los registros que superan el umbral configurado en grupos que representan la misma entidad. Los usuarios mantienen el control sobre el nivel de inclusividad de la deduplicación, permitiéndoles ajustar la sensibilidad según su caso de uso específico y su tolerancia a los falsos positivos.

| Método | Descripción | Mejor para |

|---|---|---|

| Similitud fonética | Agrupa cadenas que suenan igual (ej., “Smith” vs “Smyth”) | Variaciones de nombres, confusión fonética |

| Similitud ortográfica | Agrupa cadenas similares en ortografía | Errores tipográficos, pequeñas variaciones de escritura |

| Similitud TFIDF | Aplica el algoritmo de frecuencia de término-inversa frecuencia de documento | Coincidencia general de textos, similitud de documentos |

El motor de deduplicación procesa los registros en múltiples pasadas, identificando primero coincidencias obvias y luego examinando progresivamente variaciones más sutiles. Este enfoque por capas garantiza una cobertura exhaustiva manteniendo la eficiencia computacional, incluso al procesar conjuntos de datos con millones de registros.

La deduplicación moderna con IA aprovecha incrustaciones vectoriales y análisis semántico para comprender el significado de los datos en lugar de solo comparar características superficiales. El procesamiento de lenguaje natural (PLN) permite a los sistemas comprender el contexto y la intención, permitiéndoles reconocer que “Roberto”, “Bob” y “Rob” se refieren a la misma persona a pesar de sus diferentes formas. Los algoritmos de coincidencia difusa calculan la distancia de edición entre cadenas, identificando registros que difieren solo por unos pocos caracteres—crucial para detectar errores tipográficos y de transcripción. El sistema también analiza metadatos como marcas de tiempo, fechas de creación e historial de modificaciones para aportar señales adicionales de confianza al determinar si los registros son duplicados. Las implementaciones avanzadas incorporan modelos de aprendizaje automático entrenados con conjuntos de datos etiquetados, mejorando continuamente la precisión a medida que procesan más datos y reciben retroalimentación sobre las decisiones de deduplicación.

La lógica de deduplicación con IA se ha vuelto indispensable en prácticamente todos los sectores que gestionan operaciones de datos a gran escala. Las organizaciones aprovechan esta tecnología para mantener conjuntos de datos limpios y fiables que impulsan análisis precisos y una toma de decisiones informada. Las aplicaciones prácticas abarcan numerosas funciones empresariales críticas:

Estas aplicaciones demuestran cómo la deduplicación impacta directamente en el cumplimiento normativo, la prevención del fraude y la integridad operativa en diversas industrias.

Los beneficios financieros y operativos de la deduplicación con IA son sustanciales y medibles. Las organizaciones pueden reducir significativamente los costes de almacenamiento eliminando datos redundantes, logrando en algunas implementaciones reducciones del 20-40% en los requisitos de almacenamiento. La mejora en la calidad de los datos se traduce directamente en mejores análisis y toma de decisiones, ya que los análisis basados en datos limpios producen conocimientos y previsiones más fiables. Investigaciones indican que los científicos de datos dedican aproximadamente el 80% de su tiempo a la preparación de datos, siendo los registros duplicados un gran contribuyente a esta carga—la automatización de la deduplicación recupera tiempo valioso de los analistas para tareas de mayor valor. Los estudios muestran que el 10-30% de los registros en bases de datos típicas contienen duplicados, representando una fuente significativa de ineficiencia y error. Más allá de la reducción de costes, la deduplicación refuerza el cumplimiento y la adherencia regulatoria asegurando un registro exacto y previniendo envíos duplicados que podrían desencadenar auditorías o sanciones. Las ganancias en eficiencia operativa se traducen en consultas más rápidas, menor carga computacional y mayor fiabilidad del sistema.

A pesar de su sofisticación, la deduplicación con IA no está exenta de desafíos y limitaciones que las organizaciones deben gestionar cuidadosamente. Los falsos positivos—identificar incorrectamente registros distintos como duplicados—pueden provocar pérdida de datos o fusión de registros que deberían permanecer separados, mientras que los falsos negativos permiten que duplicados reales pasen desapercibidos. La deduplicación se vuelve exponencialmente más compleja al tratar con datos multiformato que abarcan diferentes sistemas, idiomas y estructuras, cada uno con convenciones de formato y estándares de codificación propios. Surgen preocupaciones de privacidad y seguridad cuando la deduplicación requiere analizar información personal sensible, siendo necesario implementar cifrado robusto y controles de acceso para proteger los datos durante el proceso de coincidencia. La precisión de los sistemas de deduplicación está limitada fundamentalmente por la calidad de los datos de entrada; basura que entra produce basura que sale, y los registros incompletos o corruptos pueden confundir incluso a los algoritmos más avanzados.

La deduplicación con IA se ha convertido en un componente crítico de las plataformas modernas de monitorización de respuestas de IA y sistemas de búsqueda que agregan información de múltiples fuentes. Cuando los sistemas de IA sintetizan respuestas a partir de numerosos documentos y fuentes, la deduplicación garantiza que la misma información no se cuente varias veces, lo que inflaría artificialmente las puntuaciones de confianza y distorsionaría los rankings de relevancia. La atribución de fuentes se vuelve más significativa cuando la deduplicación elimina fuentes redundantes, permitiendo a los usuarios ver la verdadera diversidad de evidencia que respalda una respuesta. Plataformas como AmICited.com emplean lógica de deduplicación para proporcionar un seguimiento transparente y preciso de fuentes, identificando cuándo múltiples fuentes contienen información esencialmente idéntica y consolidándolas adecuadamente. Esto evita que las respuestas de IA parezcan tener un respaldo más amplio del real, manteniendo la integridad de la atribución de fuentes y la credibilidad de las respuestas. Al filtrar fuentes duplicadas, la deduplicación mejora la calidad de los resultados de búsqueda de IA y asegura que los usuarios reciban perspectivas genuinamente diversas en lugar de variaciones de la misma información repetida en múltiples fuentes. En última instancia, la tecnología refuerza la confianza en los sistemas de IA al ofrecer representaciones más limpias y honestas de la evidencia subyacente a las respuestas generadas por IA.

La deduplicación con IA y la compresión de datos ambos reducen el volumen de datos, pero funcionan de manera diferente. La deduplicación identifica y elimina registros exactos o casi duplicados, manteniendo solo una instancia y reemplazando las demás con referencias. Por el contrario, la compresión de datos codifica la información de manera más eficiente sin eliminar duplicados. La deduplicación opera a nivel macro (archivos o registros completos), mientras que la compresión trabaja a nivel micro (bits y bytes individuales). Para organizaciones con una gran cantidad de datos duplicados, la deduplicación normalmente proporciona mayores ahorros en almacenamiento.

La IA utiliza múltiples técnicas sofisticadas para detectar duplicados no exactos. Los algoritmos fonéticos reconocen nombres que suenan igual (por ejemplo, 'Smith' vs 'Smyth'). La coincidencia difusa calcula la distancia de edición para encontrar registros que difieren solo por unos pocos caracteres. Las incrustaciones vectoriales convierten el texto en representaciones matemáticas que capturan el significado semántico, permitiendo al sistema reconocer contenido parafraseado. Los modelos de aprendizaje automático entrenados con conjuntos de datos etiquetados aprenden patrones de lo que constituye un duplicado en contextos específicos. Estas técnicas trabajan en conjunto para identificar duplicados a pesar de variaciones en la ortografía, formato o presentación.

La deduplicación puede reducir significativamente los costes de almacenamiento al eliminar datos redundantes. Las organizaciones suelen lograr reducciones del 20-40% en los requisitos de almacenamiento tras implementar una deduplicación efectiva. Estos ahorros se acumulan con el tiempo a medida que los nuevos datos se deduplican de manera continua. Más allá de la reducción directa de costes, la deduplicación también disminuye los gastos asociados a la gestión de datos, operaciones de backup y mantenimiento de sistemas. Para grandes empresas que procesan millones de registros, estos ahorros pueden sumar cientos de miles de dólares anualmente, convirtiendo la deduplicación en una inversión de alto retorno.

Sí, los sistemas modernos de deduplicación con IA pueden operar entre diferentes formatos de archivo, aunque requiere un procesamiento más sofisticado. El sistema debe primero normalizar los datos de diversos formatos (PDFs, documentos de Word, hojas de cálculo, bases de datos, etc.) en una estructura comparable. Las implementaciones avanzadas utilizan reconocimiento óptico de caracteres (OCR) para documentos escaneados y analizadores específicos de formato para extraer contenido significativo. Sin embargo, la precisión de la deduplicación puede variar según la complejidad del formato y la calidad de los datos. Las organizaciones suelen obtener los mejores resultados cuando la deduplicación se aplica a datos estructurados en formatos consistentes, aunque la deduplicación entre formatos es cada vez más viable con técnicas modernas de IA.

La deduplicación mejora los resultados de búsqueda de la IA asegurando que las clasificaciones de relevancia reflejen una verdadera diversidad de fuentes en vez de variaciones de la misma información. Cuando múltiples fuentes contienen contenido idéntico o casi idéntico, la deduplicación las consolida, evitando una inflación artificial de las puntuaciones de confianza. Esto ofrece a los usuarios representaciones más limpias y honestas de la evidencia que respalda las respuestas generadas por IA. La deduplicación también mejora el rendimiento de la búsqueda al reducir el volumen de datos que el sistema debe procesar, permitiendo respuestas más rápidas a las consultas. Al filtrar fuentes redundantes, los sistemas de IA pueden centrarse en perspectivas e información genuinamente diversas, entregando así resultados de mayor calidad y más confiables.

Los falsos positivos ocurren cuando la deduplicación identifica incorrectamente registros distintos como duplicados y los fusiona. Por ejemplo, fusionar los registros de 'John Smith' y 'Jane Smith', que son personas diferentes pero comparten apellido. Los falsos positivos son problemáticos porque resultan en pérdida permanente de datos; una vez que los registros se fusionan, recuperar la información original y distinta se vuelve difícil o imposible. En aplicaciones críticas como la salud o los servicios financieros, los falsos positivos pueden tener consecuencias graves, incluyendo historiales médicos incorrectos o transacciones fraudulentas. Las organizaciones deben calibrar cuidadosamente la sensibilidad de la deduplicación para minimizar los falsos positivos, aceptando a menudo algunos falsos negativos (duplicados no detectados) como una opción más segura.

La deduplicación es esencial para plataformas de monitorización de contenido con IA como AmICited, que rastrean cómo los sistemas de IA referencian marcas y fuentes. Al monitorear respuestas de IA en múltiples plataformas (GPTs, Perplexity, Google AI), la deduplicación evita que la misma fuente se cuente varias veces si aparece en diferentes sistemas o formatos. Esto garantiza una atribución precisa y previene la inflación de métricas de visibilidad. La deduplicación también ayuda a identificar cuando los sistemas de IA recurren a un conjunto limitado de fuentes aunque parezcan tener evidencia diversa. Al consolidar fuentes duplicadas, estas plataformas ofrecen una visión más clara de cuáles fuentes únicas realmente influyen en las respuestas de la IA.

Los metadatos —información sobre los datos como fechas de creación, marcas de tiempo de modificación, información del autor y propiedades de archivos— desempeñan un papel crucial en la detección de duplicados. Los metadatos ayudan a establecer el ciclo de vida de los registros, revelando cuándo se crearon, actualizaron o accedieron los documentos. Esta información temporal ayuda a distinguir entre versiones legítimas de documentos en evolución y duplicados reales. La información del autor y las asociaciones departamentales aportan contexto sobre el origen y propósito del registro. Los patrones de acceso indican si los documentos están en uso activo o son obsoletos. Los sistemas avanzados de deduplicación integran el análisis de metadatos con el análisis de contenido, utilizando ambas señales para determinar duplicados con mayor precisión y decidir qué versión debe conservarse como fuente autorizada.

AmICited rastrea cómo sistemas de IA como GPTs, Perplexity y Google AI mencionan tu marca en múltiples fuentes. Garantiza una atribución precisa de las fuentes y previene que el contenido duplicado distorsione tu visibilidad en IA.

Aprende a gestionar y prevenir el contenido duplicado al usar herramientas de IA. Descubre etiquetas canónicas, redirecciones, herramientas de detección y mejor...

Aprende cómo los URLs canónicos previenen problemas de contenido duplicado en sistemas de búsqueda con IA. Descubre las mejores prácticas para implementar canón...

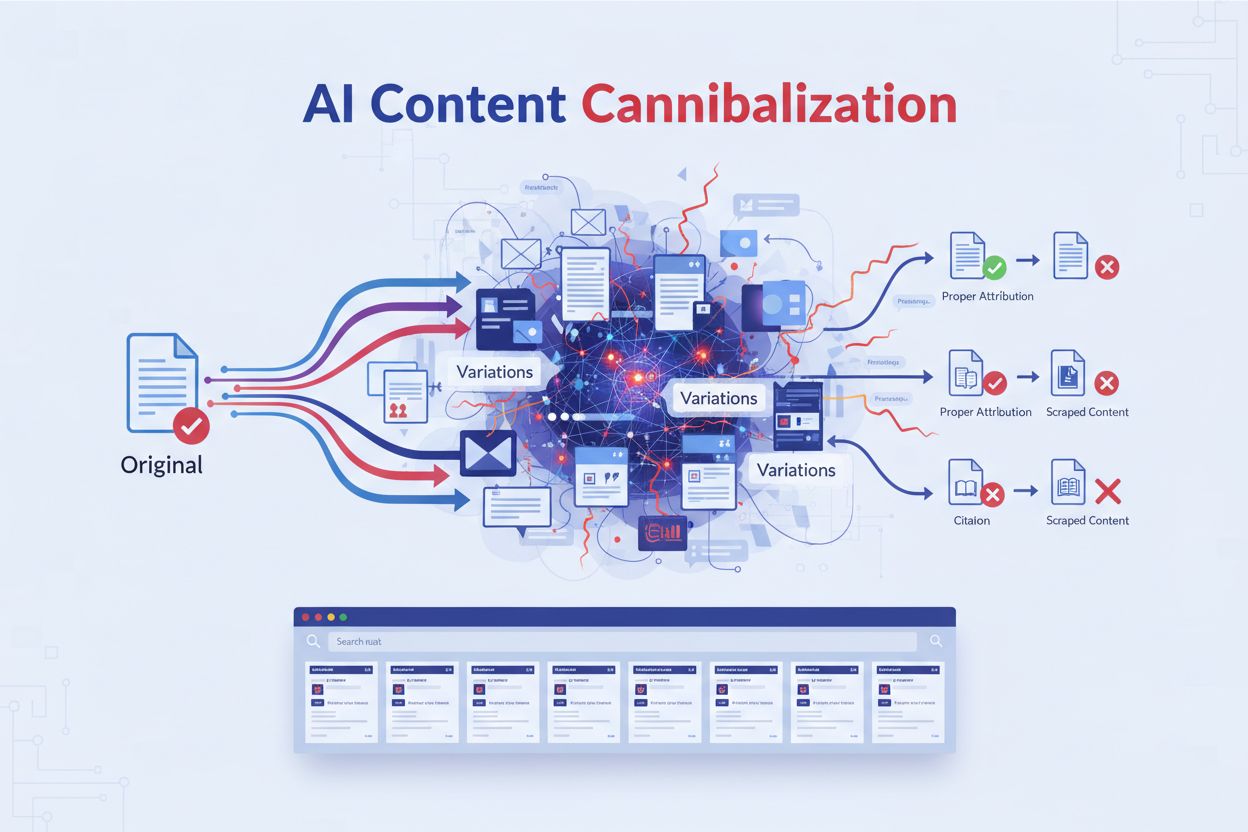

Aprende qué es la canibalización de contenido por IA, cómo se diferencia del contenido duplicado, por qué perjudica el posicionamiento y estrategias para proteg...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.