Ristrutturazione dei contenuti per l'IA: esempi prima e dopo

Scopri come ristrutturare i tuoi contenuti per i sistemi di intelligenza artificiale con esempi pratici prima e dopo. Scopri tecniche per migliorare le citazion...

Scopri come testare i formati dei contenuti per le citazioni AI utilizzando la metodologia A/B test. Scopri quali formati generano la maggiore visibilità AI e i tassi di citazione su ChatGPT, Google AI Overviews e Perplexity.

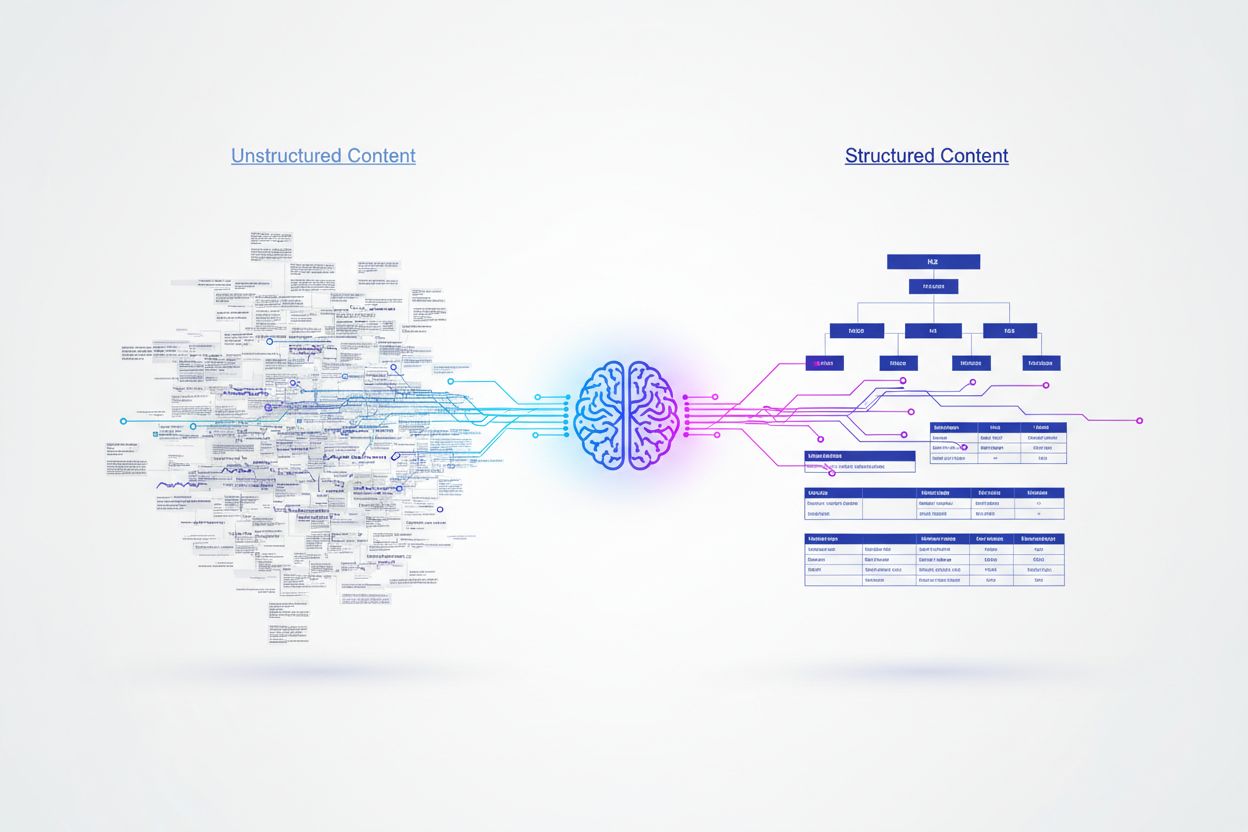

I sistemi di intelligenza artificiale processano i contenuti in modo fondamentalmente diverso rispetto ai lettori umani, affidandosi a segnali strutturati per comprendere il significato ed estrarre informazioni. Mentre gli esseri umani possono navigare tra formattazioni creative o prosa densa, i modelli AI richiedono chiari gerarchie organizzative e marcatori semantici per interpretare e comprendere efficacemente il valore dei contenuti. Le ricerche dimostrano che i contenuti strutturati con gerarchie di titoli corrette ottengono tassi di citazione superiori del 156% rispetto alle alternative non strutturate, rivelando un divario critico tra contenuti user-friendly e AI-friendly. Questa disparità esiste perché i sistemi AI sono addestrati su vasti dataset in cui i contenuti ben organizzati tipicamente si correlano a fonti autorevoli e affidabili. Comprendere e testare diversi formati di contenuto è diventato essenziale per i brand che desiderano visibilità nei risultati di ricerca e motori di risposta basati su AI.

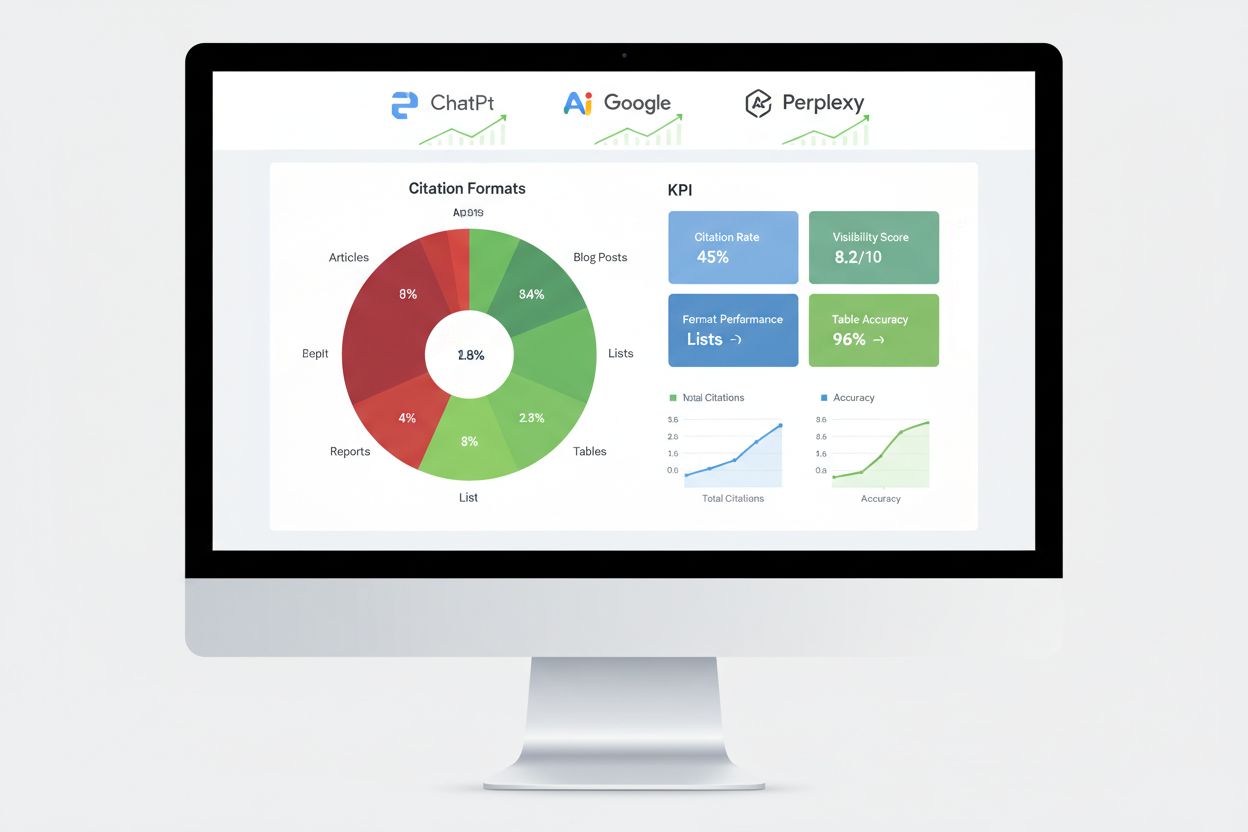

Le diverse piattaforme AI mostrano preferenze distinte per fonti e formati di contenuto, creando uno scenario complesso per l’ottimizzazione. Le ricerche che analizzano 680 milioni di citazioni sulle principali piattaforme rivelano differenze sorprendenti su come ChatGPT, Google AI Overviews e Perplexity reperiscono le informazioni. Queste piattaforme non citano semplicemente le stesse fonti: danno priorità a diversi tipi di contenuti in base ai loro algoritmi e dati di training. Comprendere questi pattern specifici delle piattaforme è cruciale per sviluppare strategie di contenuto mirate che massimizzano la visibilità su più sistemi AI.

| Piattaforma | Fonte più citata | Percentuale di citazione | Formato preferito |

|---|---|---|---|

| ChatGPT | Wikipedia | 7,8% del totale citazioni | Basi di conoscenza autorevoli, contenuti enciclopedici |

| Google AI Overviews | 2,2% del totale citazioni | Discussioni della community, contenuti generati dagli utenti | |

| Perplexity | 6,6% del totale citazioni | Informazioni peer-to-peer, intuizioni della community |

La netta preferenza di ChatGPT per Wikipedia (che rappresenta il 47,9% delle sue prime 10 fonti) dimostra una predilezione per contenuti autorevoli e fattuali con credibilità consolidata. Al contrario, sia Google AI Overviews che Perplexity mostrano una distribuzione più bilanciata, con Reddit che domina i loro pattern di citazione. Questo rivela che Perplexity privilegia le informazioni guidate dalla community nel 46,7% delle fonti principali, mentre Google mantiene un approccio più diversificato su diversi tipi di piattaforme. I dati dimostrano chiaramente che una strategia di contenuto valida per tutti non può avere successo: i brand devono adattare il loro approccio in base alle piattaforme AI più rilevanti per il proprio pubblico.

Il markup schema rappresenta forse il fattore più significativo nella probabilità di citazione AI, con markup JSON-LD implementato correttamente che raggiunge tassi di citazione superiori del 340% rispetto a contenuti identici privi di dati strutturati. Questa differenza marcata deriva dal modo in cui i motori AI interpretano il significato semantico: i dati strutturati forniscono un contesto esplicito che elimina l’ambiguità nell’interpretazione del contenuto. Quando un motore AI incontra il markup schema, comprende immediatamente le relazioni tra entità, i tipi di contenuto e l’importanza gerarchica, senza affidarsi solo all’elaborazione del linguaggio naturale.

Le implementazioni schema più efficaci includono Article schema per gli articoli del blog, FAQ schema per le sezioni domanda/risposta, HowTo schema per i contenuti istruttivi e Organization schema per il riconoscimento del brand. Il formato JSON-LD supera specificamente altri formati di dati strutturati perché i motori AI possono analizzarlo indipendentemente dai contenuti HTML, consentendo un’estrazione dei dati più pulita e una minore complessità di elaborazione. I tag HTML semantici come <header>, <nav>, <main>, <section>, e <article> forniscono ulteriore chiarezza e aiutano i sistemi AI a comprendere la struttura e la gerarchia dei contenuti in modo più efficace rispetto al semplice markup di base.

L’A/B testing offre la metodologia più affidabile per determinare quali formati di contenuto generano i tassi di citazione AI più elevati nella tua nicchia specifica. Invece di affidarsi a best practice generali, gli esperimenti controllati ti consentono di misurare l’impatto reale dei cambiamenti di formato sul tuo pubblico e sulla visibilità AI. Il processo richiede pianificazione accurata per isolare le variabili e garantire la validità statistica, ma le intuizioni ottenute giustificano l’investimento.

Segui questo framework sistematico per l’A/B testing:

La significatività statistica richiede attenzione alla dimensione del campione e alla durata del test. Nelle applicazioni AI con dati scarsi o distribuzioni long-tail, raccogliere osservazioni sufficienti rapidamente può essere una sfida. La maggior parte degli esperti consiglia di condurre test per almeno 2-4 settimane per tenere conto delle variazioni temporali e garantire risultati affidabili.

Ricerche su migliaia di citazioni AI rivelano gerarchie di prestazioni chiare tra i diversi formati di contenuto. I contenuti basati su elenchi ricevono il 68% di citazioni AI in più rispetto alle alternative ricche di paragrafi, principalmente perché gli elenchi offrono unità informative discrete e facilmente analizzabili che i motori AI possono estrarre e sintetizzare facilmente. Quando generano risposte, le piattaforme AI possono fare riferimento a specifici elementi dell’elenco senza dover ristrutturare o parafrasare frasi complesse, rendendo i contenuti a elenco altamente preziosi per le citazioni.

Le tabelle dimostrano prestazioni eccezionali con una precisione di parsing AI fino al 96%, superando di gran lunga le descrizioni in prosa delle stesse informazioni. I contenuti tabellari consentono ai sistemi AI di estrarre rapidamente dati specifici senza complessi parsing testuali, rendendo le tabelle particolarmente preziose per contenuti fattuali, comparativi o statistici. I formati domanda/risposta ottengono una visibilità AI superiore del 45% rispetto ai formati a paragrafi tradizionali sugli stessi argomenti, perché i contenuti Q&A rispecchiano il modo in cui gli utenti interagiscono con le piattaforme AI e come i sistemi AI generano le risposte.

I formati di confronto (X vs Y) funzionano eccezionalmente bene perché forniscono strutture binarie, facili da riassumere, in linea con il modo in cui i sistemi AI suddividono le query in sottoargomenti. I case study fondono narrazione e dati, risultando persuasivi per i lettori e interpretabili per l’AI grazie alla struttura problema-soluzione-risultati. Le ricerche originali e le opinioni degli esperti ricevono trattamento preferenziale perché forniscono dati proprietari non disponibili altrove, aggiungendo segnali di credibilità che i sistemi AI riconoscono e premiano. L’intuizione chiave è che nessun formato funziona universalmente: l’approccio migliore combina strategicamente più formati in base al tipo di contenuto e alle piattaforme AI di riferimento.

Implementare lo schema markup richiede di conoscere i diversi tipi disponibili e selezionare quelli più rilevanti per i tuoi contenuti. Per articoli e post del blog, Article schema fornisce metadati completi inclusi autore, data di pubblicazione e struttura del contenuto. FAQ schema funziona eccezionalmente bene per le sezioni domanda/risposta, etichettando esplicitamente domande e risposte in modo che i sistemi AI possano estrarle in modo affidabile. HowTo schema è utile per contenuti istruttivi definendo passaggi sequenziali, mentre Product schema aiuta i siti e-commerce a comunicare specifiche e prezzi.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "Qual è il miglior formato di contenuto per le citazioni AI?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Il miglior formato di contenuto dipende dalla piattaforma e dal pubblico, ma i formati strutturati come elenchi, tabelle e sezioni Q&A ottengono costantemente tassi di citazione AI più elevati. Gli elenchi ricevono il 68% di citazioni in più rispetto ai paragrafi, mentre le tabelle raggiungono una precisione di parsing del 96%."

}

}

]

}

L’implementazione richiede attenzione all’accuratezza della sintassi: uno schema markup non valido può danneggiare le possibilità di citazione AI invece di migliorarle. Usa il Rich Results Test di Google o gli strumenti di validazione di Schema.org per verificare il markup prima della pubblicazione. Mantieni gerarchie di formattazione coerenti con H2 per le sezioni principali, H3 per i sottoargomenti e paragrafi brevi (massimo 50-75 parole) focalizzati su concetti singoli. Aggiungi sommari TL;DR all’inizio o alla fine delle sezioni per fornire all’AI snippet già pronti che possano essere utilizzati come risposte autonome.

Misurare le prestazioni nei motori AI richiede metriche diverse dalla SEO tradizionale, concentrandosi sul tracciamento delle citazioni, i tassi di inclusione nelle risposte e le menzioni nel knowledge graph piuttosto che sulle posizioni in classifica. Il monitoraggio delle citazioni sulle principali piattaforme offre l’indicazione più diretta dell’efficacia dei test di formato, rivelando quali contenuti vengono effettivamente citati dai sistemi AI. Strumenti come AmICited tracciano specificamente come le piattaforme AI citano il tuo brand su ChatGPT, Google AI Overviews, Perplexity e altri motori di risposta, fornendo visibilità su pattern e trend di citazione.

Le strategie di misurazione essenziali includono il tracciamento dei tassi di acquisizione dei featured snippet, che indicano contenuti considerati particolarmente preziosi dai sistemi AI per risposte dirette. Le apparizioni nei knowledge panel segnalano che i sistemi AI riconoscono il tuo brand come entità autorevole meritevole di una scheda dedicata. L’inclusione nei risultati di ricerca vocali mostra se i tuoi contenuti appaiono nelle risposte conversazionali AI, mentre i tassi di risposta dei motori generativi misurano la frequenza con cui i sistemi AI fanno riferimento ai tuoi contenuti nelle risposte alle query degli utenti. Eseguire A/B test su diversi approcci di formato fornisce i dati sulle prestazioni più affidabili, isolando le singole variabili per identificare i fattori di impatto specifici. Stabilisci metriche di base prima di implementare cambiamenti, poi monitora le prestazioni settimanalmente per individuare trend e anomalie che potrebbero indicare variazioni di formato di successo o meno.

Molte organizzazioni che testano i formati cadono in trappole prevedibili che compromettono i risultati e portano a conclusioni errate. Campioni insufficienti rappresentano l’errore più comune: testare con poche citazioni o interazioni porta a risultati statisticamente non significativi che sembrano importanti ma riflettono in realtà variazioni casuali. Assicurati di raccogliere almeno 100 citazioni per variazione prima di trarre conclusioni e utilizza calcolatori statistici per determinare la dimensione esatta del campione necessaria per il tuo livello di confidenza ed effetto desiderato.

Le variabili confondenti introducono bias quando più fattori cambiano contemporaneamente, rendendo impossibile determinare quale cambiamento abbia causato la differenza osservata. Mantieni tutti gli elementi identici tranne il formato testato: usa le stesse keyword, lunghezza, struttura e tempistica di pubblicazione. Il bias temporale si verifica quando si testa durante periodi anomali (vacanze, grandi eventi di cronaca, cambi di algoritmo) che influenzano i risultati. Esegui i test durante periodi normali e considera le variazioni stagionali testando almeno 2-4 settimane. Il bias di selezione emerge quando i gruppi di test differiscono in modi che influenzano i risultati: garantisci l’assegnazione casuale dei contenuti alle varianti. Interpretare la correlazione come causalità porta a conclusioni errate quando fattori esterni coincidono casualmente con il periodo di test. Considera sempre spiegazioni alternative per i cambiamenti osservati e valida i risultati con più cicli di test prima di implementare modifiche permanenti.

Un’azienda tecnologica che testava i formati per la visibilità AI ha scoperto che convertire i propri articoli di confronto prodotto da formato a paragrafi a tabelle strutturate ha aumentato le citazioni AI del 52% in 60 giorni. Le tabelle fornivano informazioni chiare e facilmente scansionabili che i sistemi AI potevano estrarre direttamente, mentre la prosa originale richiedeva parsing più complesso. Hanno mantenuto la stessa lunghezza e ottimizzazione delle keyword, isolando la modifica di formato come unica variabile.

Una società di servizi finanziari ha implementato lo schema FAQ sui contenuti esistenti senza riscrivere nulla, semplicemente aggiungendo markup strutturato alle sezioni domanda/risposta. Questo ha portato ad un aumento del 34% delle apparizioni nei featured snippet e del 28% delle citazioni AI in 45 giorni. Il markup schema non ha cambiato il contenuto, ma lo ha reso molto più facile da identificare ed estrarre per i sistemi AI. Una SaaS ha eseguito test multivariati su tre formati contemporaneamente—elenchi, tabelle e paragrafi tradizionali—per contenuti identici sulle caratteristiche dei loro prodotti. I risultati hanno mostrato che gli elenchi superavano i paragrafi del 68%, mentre le tabelle ottenevano la massima precisione nel parsing AI ma un volume di citazioni complessivo più basso. Questo ha evidenziato che l’efficacia del formato varia in base al tipo di contenuto e alla piattaforma AI, confermando che il test è essenziale piuttosto che affidarsi a best practice generali. Questi esempi reali dimostrano che testare i formati produce miglioramenti misurabili e significativi nella visibilità AI se eseguiti correttamente.

Lo scenario dei test sui formati di contenuto continua ad evolversi man mano che i sistemi AI diventano sempre più sofisticati e emergono nuove tecniche di ottimizzazione. Gli algoritmi multi-armed bandit rappresentano un progresso significativo rispetto ai tradizionali A/B test, regolando dinamicamente l’allocazione del traffico alle diverse varianti in base alle prestazioni in tempo reale invece di attendere la fine dei periodi di test prestabiliti. Questo approccio riduce il tempo necessario per individuare le varianti vincenti e massimizza le prestazioni durante il periodo di test stesso.

La sperimentazione adattiva alimentata dal reinforcement learning consente ai modelli AI di apprendere e adattarsi continuamente dagli esperimenti in corso, migliorando le prestazioni in tempo reale invece che tramite cicli di test discreti. L’automazione AI-driven negli A/B test utilizza l’AI stessa per automatizzare la progettazione degli esperimenti, l’analisi dei risultati e le raccomandazioni di ottimizzazione, consentendo alle organizzazioni di testare più varianti contemporaneamente senza aumentare la complessità in modo proporzionale. Questi approcci emergenti promettono cicli di iterazione più rapidi e strategie di ottimizzazione più sofisticate. Le organizzazioni che padroneggiano oggi i test sui formati di contenuto manterranno un vantaggio competitivo man mano che queste tecniche avanzate diventeranno prassi standard, posizionandosi per capitalizzare sulle nuove piattaforme AI e i relativi algoritmi di citazione prima che i concorrenti adattino le loro strategie.

Il miglior formato di contenuto dipende dalla piattaforma e dal pubblico, ma i formati strutturati come elenchi, tabelle e sezioni Q&A ottengono costantemente tassi di citazione AI più elevati. Gli elenchi ricevono il 68% di citazioni in più rispetto ai paragrafi, mentre le tabelle raggiungono una precisione di parsing del 96%. La chiave è testare diversi formati con i tuoi contenuti specifici per identificare ciò che funziona meglio.

La maggior parte degli esperti consiglia di eseguire i test per almeno 2-4 settimane per tenere conto delle variazioni temporali e garantire risultati affidabili. Questa durata consente di raccogliere un numero sufficiente di dati (tipicamente 100+ citazioni per variazione) e di considerare variazioni stagionali o cambiamenti negli algoritmi delle piattaforme che potrebbero influenzare i risultati.

Sì, puoi condurre test multivariati su più formati contemporaneamente, ma ciò richiede una pianificazione attenta per evitare complessità nell'interpretazione dei risultati. Inizia con semplici A/B test confrontando due formati, poi passa ai test multivariati una volta compresi i fondamenti e disponi delle risorse statistiche adeguate.

Normalmente sono necessarie almeno 100 citazioni o interazioni per variazione per ottenere una significatività statistica. Utilizza calcolatori statistici per determinare la dimensione esatta del campione necessaria per il tuo livello di confidenza e l'effetto desiderato. Campioni più grandi forniscono risultati più affidabili ma richiedono periodi di test più lunghi.

Inizia identificando il tipo di schema più rilevante per i tuoi contenuti (Article, FAQ, HowTo, ecc.), poi implementalo utilizzando il formato JSON-LD. Valida il markup usando il Rich Results Test di Google o gli strumenti di validazione di Schema.org prima della pubblicazione. Un markup schema non valido può effettivamente danneggiare le possibilità di citazione AI, quindi la precisione è fondamentale.

Dai priorità in base al tuo pubblico e agli obiettivi di business. ChatGPT privilegia fonti autorevoli come Wikipedia, Google AI Overviews preferisce contenuti di community come Reddit, e Perplexity enfatizza le informazioni peer-to-peer. Analizza quali piattaforme generano il traffico più rilevante per il tuo sito e ottimizza prima per quelle.

Implementa test continui come parte della tua strategia di contenuti. Inizia con cicli trimestrali di test sui formati, poi aumenta la frequenza man mano che acquisisci esperienza e stabilisci metriche di base. Test regolari ti aiutano a rimanere aggiornato sugli aggiornamenti degli algoritmi delle piattaforme AI e a scoprire nuove preferenze di formato.

Monitora i miglioramenti nei tassi di citazione, tassi di acquisizione dei featured snippet, apparizioni nel knowledge panel e tassi di risposta dei motori generativi. Stabilisci metriche di base prima del test, poi monitora le prestazioni settimanalmente per identificare tendenze. Un test riuscito mostra tipicamente un miglioramento del 20%+ nella metrica principale entro 4-8 settimane.

Traccia come le piattaforme AI citano i tuoi contenuti nei diversi formati. Scopri quali strutture di contenuto generano la maggior visibilità AI e ottimizza la tua strategia con dati reali.

Scopri come ristrutturare i tuoi contenuti per i sistemi di intelligenza artificiale con esempi pratici prima e dopo. Scopri tecniche per migliorare le citazion...

Scopri come le strutture comparative dei contenuti ottimizzano le informazioni per i sistemi AI. Comprendi perché le piattaforme AI preferiscono tabelle di conf...

Scopri come strutturare i tuoi contenuti per essere citato dai motori di ricerca AI come ChatGPT, Perplexity e Google AI. Strategie esperte per visibilità e cit...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.