Correção de Desinformação em IA

Aprenda a identificar e corrigir informações incorretas sobre marcas em sistemas de IA como ChatGPT, Gemini e Perplexity. Descubra ferramentas de monitoramento,...

Aprenda como solicitar correções em plataformas de IA como ChatGPT, Perplexity e Claude. Entenda mecanismos de correção, processos de feedback e estratégias para influenciar respostas geradas por IA sobre sua marca.

Embora não seja possível excluir informações diretamente dos dados de treinamento de IA, é possível solicitar correções por mecanismos de feedback, corrigir imprecisões na fonte e influenciar respostas futuras criando conteúdo positivo e autoritativo e trabalhando com equipes de suporte das plataformas.

Solicitar correções em plataformas de IA exige compreender como esses sistemas funcionam fundamentalmente. Diferente dos mecanismos de busca tradicionais, nos quais você pode contatar o proprietário de um site para remover ou atualizar conteúdo, modelos de linguagem de IA aprendem com dados de treinamento durante fases específicas, incorporando bilhões de páginas da web, notícias e outras fontes. Uma vez que informações negativas ou imprecisas entram nesses dados, você não pode excluí-las ou editá-las diretamente como faria ao solicitar a um dono de site. A IA já assimilou padrões e associações a partir de múltiplas fontes durante seu ciclo de treinamento.

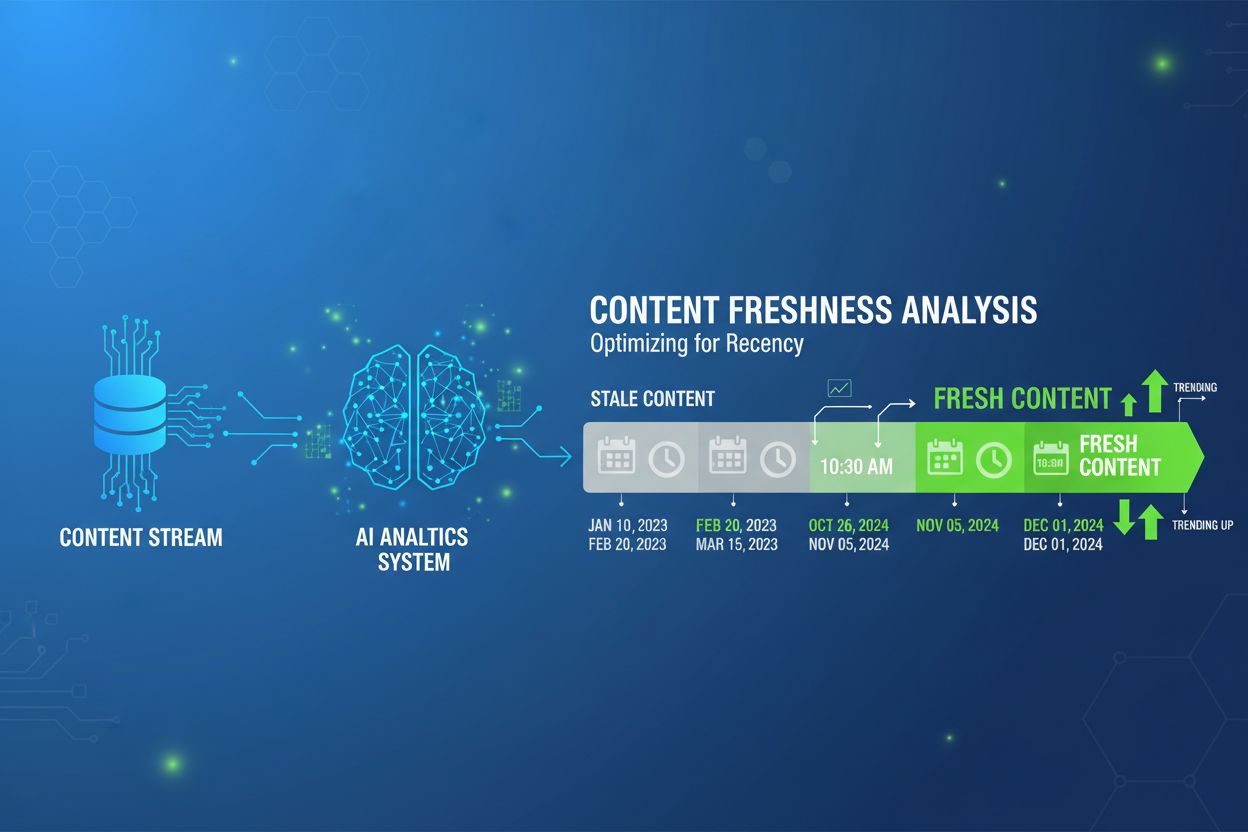

O processo de correção difere significativamente entre sistemas de IA estáticos e em tempo real. Modelos estáticos como o GPT-4 são treinados com dados até uma data limite específica (por exemplo, dezembro de 2023 para o GPT-4-turbo) e, após treinados, retêm esse conhecimento até o próximo ciclo. Sistemas de IA em tempo real como Perplexity e Claude.ai buscam conteúdo web ao vivo, de modo que correções na fonte podem ter efeitos imediatos em suas respostas. Entender com qual tipo de plataforma você está lidando é crucial para definir a estratégia de correção mais eficaz.

A maioria das grandes plataformas de IA oferece mecanismos de feedback integrados para que usuários relatem imprecisões. O ChatGPT, por exemplo, inclui botões de aprovação e reprovação nas respostas, permitindo sinalizar respostas problemáticas. Ao fornecer feedback negativo sobre uma resposta imprecisa, essa informação é coletada e analisada pela equipe da plataforma. Esses ciclos de feedback ajudam os sistemas de IA a aprimorar seu desempenho aprendendo com os resultados — sejam eles corretos ou falhos. O feedback enviado compõe o conjunto de dados que os desenvolvedores usam para identificar padrões de erros e melhorar a precisão do modelo.

Perplexity e Claude oferecem opções de feedback semelhantes em suas interfaces. Normalmente, é possível reportar quando uma resposta é imprecisa, enganosa ou contém informações desatualizadas. Algumas plataformas permitem fornecer correções ou esclarecimentos específicos. A eficácia desse feedback depende de quantos usuários relatam o mesmo problema e da gravidade da imprecisão. As plataformas priorizam correções para problemas abrangentes que afetam muitos usuários; portanto, se várias pessoas reportarem a mesma imprecisão sobre sua marca, a chance de investigação e resolução aumenta.

A estratégia mais eficaz a longo prazo para corrigir informações erradas geradas por IA envolve corrigir a fonte original da informação imprecisa. Como os sistemas de IA aprendem com conteúdo web, notícias, Wikipedia e outros materiais publicados, corrigir a informação nessas fontes influencia a forma como as plataformas de IA apresentarão dados nos próximos ciclos de treinamento. Solicite correções ou atualizações aos editores originais onde a informação imprecisa aparece. Se um veículo de imprensa publicou algo incorreto sobre sua marca, entre em contato com a redação, forneça provas da imprecisão e peça uma correção ou esclarecimento.

A Wikipedia representa uma fonte especialmente importante para dados de treinamento de IA. Se há informações imprecisas sobre sua marca ou domínio na Wikipedia, atue nos canais editoriais adequados da plataforma. A Wikipedia possui processos específicos para contestar informações e solicitar correções, mas é preciso seguir suas diretrizes de neutralidade e verificabilidade. Fontes de alta autoridade como Wikipedia, grandes veículos de imprensa, instituições educacionais e sites governamentais têm peso significativo nos conjuntos de dados de treinamento de IA. Correções nessas fontes têm maior probabilidade de serem incorporadas em futuras atualizações de modelos de IA.

Para informações desatualizadas ou imprecisas em seu próprio site ou propriedades sob seu controle, atualize ou remova o conteúdo prontamente. Documente todas as alterações feitas, pois essas atualizações podem ser incluídas em futuros ciclos de re-treinamento. Ao corrigir informações em seu próprio domínio, você está basicamente fornecendo material de origem mais preciso para as IAs aprenderem no futuro.

Em vez de focar apenas em remover informações negativas ou imprecisas, desenvolva contra-narrativas fortes com conteúdo positivo e autoritativo. Modelos de IA ponderam informações com base, em parte, em padrões de frequência e autoridade em seus dados de treinamento. Se você criar muito mais conteúdo positivo, preciso e confiável do que existe de informação imprecisa, os sistemas de IA encontrarão muito mais dados positivos ao gerar respostas sobre sua marca.

| Tipo de Conteúdo | Nível de Autoridade | Impacto na IA | Prazo |

|---|---|---|---|

| Páginas de biografia profissional | Alta | Influência imediata nas respostas | Semanas a meses |

| Publicações do setor & liderança de pensamento | Muito alta | Forte peso nas respostas da IA | Meses |

| Press releases em grandes agências de notícias | Alta | Influência significativa nas narrativas | Semanas a meses |

| Estudos de caso e histórias de sucesso | Média-Alta | Suporte contextual a argumentos positivos | Meses |

| Publicações acadêmicas ou científicas | Muito alta | Influência duradoura nos dados de treinamento | Meses a anos |

| Entradas na Wikipedia | Muito alta | Crítico para ciclos futuros de treinamento | Meses a anos |

Desenvolva conteúdo abrangente em múltiplas plataformas de credibilidade para garantir que os sistemas de IA encontrem informações positivas e autoritativas. Essa estratégia de saturação de conteúdo é especialmente eficaz porque ataca a raiz da desinformação de IA — falta de informação positiva suficiente para contrabalançar alegações imprecisas. Quando as IAs têm acesso a mais informações positivas e bem fundamentadas de fontes confiáveis, geram naturalmente respostas mais favoráveis sobre sua marca.

Diferentes plataformas de IA possuem arquiteturas e ciclos de atualização distintos, exigindo abordagens de correção específicas. ChatGPT e outros sistemas baseados em GPT focam em plataformas incluídas antes dos cortes de treinamento: grandes veículos de notícias, Wikipedia, diretórios profissionais e conteúdo web amplamente citado. Como esses modelos não atualizam em tempo real, correções feitas hoje influenciarão ciclos de treinamento futuros, normalmente daqui a 12-18 meses. Perplexity e sistemas de busca de IA em tempo real integram conteúdo web ao vivo, então manter o SEO e a visibilidade contínua na imprensa tem efeitos imediatos. Ao remover ou corrigir conteúdo da web em tempo real, o Perplexity geralmente deixa de referenciá-lo em dias ou semanas.

Claude e sistemas Anthropic priorizam informações baseadas em fatos e bem fundamentadas. A Anthropic enfatiza confiabilidade factual, então garanta que o conteúdo positivo sobre sua marca seja verificável e vinculado a fontes confiáveis. Ao solicitar correções ao Claude, foque em esclarecimentos baseados em evidências e aponte fontes autoritativas que sustentem a informação correta. O fundamental é entender que cada plataforma tem diferentes fontes de dados, frequências de atualização e padrões de qualidade. Adapte sua estratégia de correção a cada caso.

Testar regularmente como os sistemas de IA descrevem seu nome ou marca é essencial para acompanhar a eficácia das correções. Faça buscas no ChatGPT, Claude, Perplexity e outras plataformas utilizando frases positivas e negativas (por exemplo, “A [marca] é confiável?” versus “conquistas da [marca]”). Registre resultados ao longo do tempo e acompanhe o progresso para identificar imprecisões e medir se suas ações estão mudando a narrativa. Esse monitoramento permite identificar rapidamente novas imprecisões e agir prontamente. Se notar que uma plataforma de IA continua referenciando informações erradas ou desatualizadas semanas após a correção na fonte, é possível escalar o problema pelos canais de suporte da plataforma.

Documente todas as correções solicitadas e as respostas recebidas. Essa documentação serve a vários propósitos: fornece provas caso precise escalar o problema, ajuda a identificar padrões de tratamento de correções em diferentes plataformas e demonstra seu esforço de boa-fé para manter informações precisas. Guarde registros das datas do feedback, do erro reportado e das respostas da plataforma.

A remoção completa de informações imprecisas das buscas por IA é rara, mas diluição e contextualização são metas alcançáveis. A maioria das empresas de IA atualiza os dados de treinamento periodicamente, normalmente a cada 12-18 meses para grandes modelos de linguagem. As ações tomadas hoje influenciarão iterações futuras, mas é preciso esperar um grande intervalo entre a solicitação de correção e sua aparição nas respostas geradas por IA. O sucesso exige paciência e consistência. Ao focar na criação de conteúdo autoritativo, corrigir imprecisões na fonte e construir credibilidade, você pode influenciar como as plataformas de IA retratam sua marca ao longo do tempo.

Plataformas de busca de IA em tempo real, como o Perplexity, podem mostrar resultados em semanas ou meses, enquanto modelos estáticos como o ChatGPT podem levar de 12 a 18 meses para refletir correções no modelo base. Contudo, mesmo em modelos estáticos, melhorias podem surgir antes caso a plataforma lance versões atualizadas ou ajuste aspectos específicos do modelo. O prazo também depende da abrangência da imprecisão e do número de usuários que a reportam. Problemas amplos que afetam muitos usuários recebem atenção mais rápida do que questões que afetam apenas alguns.

Em algumas jurisdições, há recursos legais para informações imprecisas ou difamatórias. Se uma plataforma de IA estiver gerando informações falsas, difamatórias ou prejudiciais sobre sua marca, pode haver fundamentos para ação legal. Leis do direito ao esquecimento em jurisdições aplicáveis, especialmente sob o GDPR na Europa, oferecem opções adicionais. Essas leis permitem solicitar a remoção de certas informações pessoais dos resultados de busca e, em alguns casos, dos dados de treinamento da IA.

Entre em contato com o setor jurídico da plataforma de IA caso acredite que a informação viola os termos de serviço ou a legislação vigente. A maioria das plataformas possui processos para lidar com reclamações legais e solicitações de remoção. Forneça evidências claras da imprecisão e explique por que ela infringe as leis aplicáveis ou as políticas da plataforma. Documente todas as comunicações com a plataforma, criando assim um registro de seu esforço de boa-fé para resolver o problema.

A maneira mais sustentável de gerenciar sua reputação em buscas por IA é superar informações negativas com positividade consistente e autoritativa. Publique conteúdo especializado de forma contínua, mantenha perfis profissionais ativos, conquiste cobertura frequente na mídia, construa redes para amplificar conquistas e evidencie envolvimento comunitário. Essa abordagem de longo prazo garante que qualquer cobertura negativa ou imprecisa se dilua em uma nota de rodapé diante do todo.

Implemente SEO estratégico para futuros treinamentos de IA, garantindo que conteúdo autoritativo ocupe posições de destaque nos mecanismos de busca. Use marcação de dados estruturados e schema para esclarecer contexto, mantenha NAP (Nome, Endereço, Telefone) consistentes e construa backlinks de qualidade para conteúdo positivo e confiável. Esses esforços aumentam as chances de que informações positivas se tornem a narrativa dominante em futuros ciclos de re-treinamento de IA. À medida que os sistemas de IA se tornam mais sofisticados e integrados ao cotidiano, a importância de manter informações precisas e autoritativas na web só tende a crescer. Invista em sua presença digital agora para garantir que as plataformas de IA tenham acesso a informações corretas sobre sua marca por muitos anos.

Acompanhe como sua marca, domínio e URLs aparecem no ChatGPT, Perplexity e outros mecanismos de busca de IA. Receba alertas quando correções forem necessárias e meça o impacto de seus esforços.

Aprenda a identificar e corrigir informações incorretas sobre marcas em sistemas de IA como ChatGPT, Gemini e Perplexity. Descubra ferramentas de monitoramento,...

Guia completo para não participar da coleta de dados de treinamento de IA no ChatGPT, Perplexity, LinkedIn e outras plataformas. Aprenda passo a passo como prot...

Aprenda quando e como atualizar seu conteúdo para visibilidade em IA. Descubra sinais de atualização que ajudam o ChatGPT, Perplexity e Google AI Overviews a ci...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.