Jak zidentyfikować crawlery AI w logach serwera: Kompletny przewodnik po wykrywaniu

Dowiedz się, jak identyfikować i monitorować crawlery AI takie jak GPTBot, PerplexityBot i ClaudeBot w logach serwera. Poznaj ciągi user-agent, metody weryfikac...

Ciąg identyfikacyjny wysyłany przez AI crawlery do serwerów WWW w nagłówkach HTTP, używany do kontroli dostępu, śledzenia w analizie oraz odróżniania legalnych botów AI od złośliwych scraperów. Identyfikuje cel, wersję i pochodzenie crawlery.

Ciąg identyfikacyjny wysyłany przez AI crawlery do serwerów WWW w nagłówkach HTTP, używany do kontroli dostępu, śledzenia w analizie oraz odróżniania legalnych botów AI od złośliwych scraperów. Identyfikuje cel, wersję i pochodzenie crawlery.

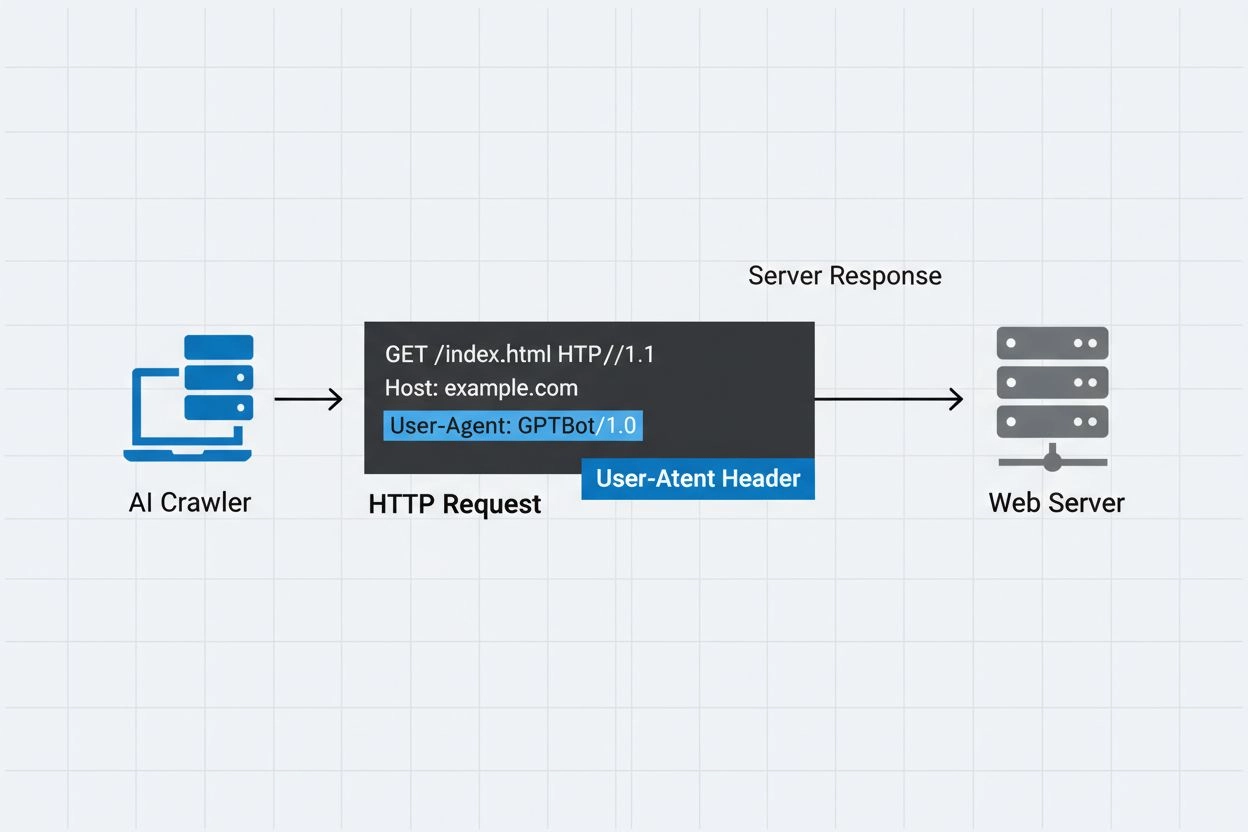

AI crawler user-agent to ciąg nagłówka HTTP identyfikujący zautomatyzowane boty uzyskujące dostęp do treści internetowych w celach treningu sztucznej inteligencji, indeksowania lub badań. Ten ciąg służy jako cyfrowa tożsamość crawlery, informując serwery WWW kto składa żądanie i w jakim celu. User-agent jest kluczowy dla crawlerów AI, ponieważ pozwala właścicielom stron rozpoznawać, śledzić i kontrolować, w jaki sposób ich treści są pobierane przez różne systemy AI. Bez prawidłowej identyfikacji user-agenta rozróżnienie legalnych crawlerów AI od złośliwych botów jest znacznie trudniejsze, dlatego jest to istotny element odpowiedzialnego scrapingu oraz praktyk pozyskiwania danych.

Nagłówek user-agent to kluczowy element żądań HTTP, pojawiający się w nagłówkach każdego żądania wysyłanego przez przeglądarkę lub bota podczas dostępu do zasobu WWW. Gdy crawler wysyła żądanie do serwera WWW, dołącza do nagłówków HTTP metadane o sobie, z których najważniejszym identyfikatorem jest właśnie ciąg user-agent. Typowo zawiera on informacje o nazwie crawlery, wersji, organizacji ją obsługującej oraz często adres URL lub e-mail do weryfikacji. User-agent pozwala serwerom identyfikować klienta realizującego żądanie i podejmować decyzje o udostępnieniu treści, ograniczeniu liczby żądań lub całkowitym blokowaniu dostępu. Przykłady user-agentów głównych crawlerów AI:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot)

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com)

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot)

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko) Chrome/131.0.0.0 Safari/537.36; compatible; OAI-SearchBot/1.3; +https://openai.com/searchbot

| Nazwa crawlery | Cel | Przykład user-agenta | Weryfikacja IP |

|---|---|---|---|

| GPTBot | Zbieranie danych treningowych | Mozilla/5.0…compatible; GPTBot/1.3 | Zakresy IP OpenAI |

| ClaudeBot | Trening modeli | Mozilla/5.0…compatible; ClaudeBot/1.0 | Zakresy IP Anthropic |

| OAI-SearchBot | Indeksowanie wyszukiwania | Mozilla/5.0…compatible; OAI-SearchBot/1.3 | Zakresy IP OpenAI |

| PerplexityBot | Indeksowanie wyszukiwania | Mozilla/5.0…compatible; PerplexityBot/1.0 | Zakresy IP Perplexity |

Kilka czołowych firm AI obsługuje własne crawlery z unikalnymi identyfikatorami user-agent i specyficznymi celami. Te crawlery reprezentują różne zastosowania w ekosystemie AI:

Każda z tych crawlery ma określone zakresy IP i oficjalną dokumentację, do której mogą się odwoływać właściciele stron, aby potwierdzić legalność oraz wdrożyć odpowiednie zabezpieczenia dostępu.

Ciągi user-agent mogą być łatwo podrobione przez dowolnego klienta wysyłającego żądanie HTTP, dlatego same w sobie nie mogą stanowić jedynego mechanizmu uwierzytelniania crawlerów AI. Złośliwe boty często podszywają się pod popularne user-agenty, ukrywając swoją prawdziwą tożsamość i omijając zabezpieczenia stron lub restrykcje robots.txt. Aby przeciwdziałać tej podatności, eksperci ds. bezpieczeństwa zalecają stosowanie dodatkowej warstwy autoryzacji w postaci weryfikacji IP, czyli sprawdzania, czy żądania pochodzą z oficjalnych zakresów IP publikowanych przez firmy AI. Standard RFC 9421 HTTP Message Signatures wprowadza możliwości kryptograficznej weryfikacji, pozwalając crawlerom podpisywać żądania cyfrowo, aby serwery mogły zweryfikować ich autentyczność. Jednak rozróżnienie prawdziwych i fałszywych crawlerów wciąż stanowi wyzwanie, ponieważ zdeterminowani atakujący mogą podszywać się nie tylko pod user-agent, ale i adresy IP, korzystając z proxy lub przejętej infrastruktury. Ten ciągły wyścig między operatorami crawlerów a właścicielami stron dbającymi o bezpieczeństwo napędza rozwój nowych technik weryfikacji.

Właściciele stron mogą zarządzać dostępem crawlerów poprzez określanie dyrektyw user-agent w pliku robots.txt, co pozwala na szczegółową kontrolę, które crawlery mogą indeksować poszczególne części witryny. Plik robots.txt wykorzystuje identyfikatory user-agent do kierowania konkretnych reguł do wybranych crawlerów, umożliwiając pozwolenie jednym, a blokowanie innych. Przykładowa konfiguracja robots.txt:

User-agent: GPTBot

Disallow: /private

Allow: /

User-agent: ClaudeBot

Disallow: /

Choć robots.txt to wygodny mechanizm kontroli crawlerów, ma istotne ograniczenia:

Właściciele stron mogą wykorzystać logi serwera do śledzenia i analizy aktywności crawlerów AI, uzyskując wgląd w to, które systemy AI pobierają ich treści oraz jak często to robią. Analizując logi żądań HTTP i filtrując znane user-agenty crawlerów AI, administratorzy mogą ocenić wpływ na transfer oraz schematy pozyskiwania danych przez różne firmy AI. Narzędzia do analizy logów, usługi web analytics i własne skrypty mogą przetwarzać logi serwera, identyfikując ruch crawlerów, mierząc częstotliwość żądań oraz wolumen przesyłanych danych. Jest to szczególnie ważne dla twórców treści i wydawców, którzy chcą wiedzieć, jak ich praca jest wykorzystywana do trenowania AI i czy warto wdrożyć ograniczenia dostępu. Serwisy takie jak AmICited.com odgrywają tu kluczową rolę, monitorując i śledząc, jak systemy AI cytują i odwołują się do treści z całego internetu, zapewniając twórcom przejrzystość w zakresie wykorzystania ich materiałów w treningu AI. Zrozumienie aktywności crawlerów pomaga właścicielom stron podejmować świadome decyzje dotyczące polityki treści oraz negocjować z firmami AI warunki wykorzystania danych.

Skuteczne zarządzanie dostępem crawlerów AI wymaga wielowarstwowego podejścia, łączącego różne techniki weryfikacji i monitorowania:

Stosując te praktyki, właściciele stron mogą kontrolować swoje treści, wspierając jednocześnie odpowiedzialny rozwój systemów AI.

User-agent to ciąg nagłówka HTTP identyfikujący klienta wykonującego żądanie do strony internetowej. Zawiera informacje o oprogramowaniu, systemie operacyjnym i wersji aplikacji wykonującej żądanie – czy to przeglądarka, crawler, czy bot. Pozwala serwerom WWW identyfikować i śledzić różne typy klientów uzyskujących dostęp do treści.

Ciągi user-agent pozwalają serwerom WWW zidentyfikować, który crawler uzyskuje dostęp do treści, umożliwiając właścicielom stron kontrolę dostępu, śledzenie aktywności crawlerów i rozróżnianie różnych typów botów. Jest to kluczowe dla zarządzania transferem, ochrony treści i zrozumienia, jak systemy AI wykorzystują Twoje dane.

Tak, ciągi user-agent można łatwo podrobić, ponieważ są to tylko wartości tekstowe w nagłówkach HTTP. Dlatego ważna jest dodatkowa weryfikacja IP oraz stosowanie podpisów wiadomości HTTP jako metod potwierdzających prawdziwą tożsamość crawlery i chroniących przed podszywaniem się złośliwych botów pod legalne crawlery.

Możesz użyć robots.txt z dyrektywami user-agent, aby poprosić crawlery o nieodwiedzanie strony, ale nie jest to wymuszane. Dla większej kontroli stosuj weryfikację po stronie serwera, białe/czarne listy IP lub reguły WAF sprawdzające jednocześnie user-agent i adres IP.

GPTBot to crawler OpenAI zbierający dane treningowe dla modeli AI takich jak ChatGPT, natomiast OAI-SearchBot służy do indeksowania i zasilania wyszukiwarki w ChatGPT. Mają różne cele, częstotliwości crawlowań i zakresy IP, co wymaga odmiennych strategii kontroli dostępu.

Sprawdź adres IP crawlera z oficjalną listą IP publikowaną przez operatora crawlera (np. openai.com/gptbot.json dla GPTBot). Legalne crawlery publikują swoje zakresy IP i możesz potwierdzić pochodzenie żądań przez reguły zapory lub konfigurację WAF.

HTTP Message Signatures (RFC 9421) to metoda kryptograficzna, w której crawlery podpisują żądania kluczem prywatnym. Serwery mogą zweryfikować podpis używając klucza publicznego crawlery z katalogu .well-known, co potwierdza autentyczność żądania i jego integralność.

AmICited.com monitoruje, jak systemy AI cytują i odwołują się do Twojej marki w GPT, Perplexity, Google AI Overviews i innych platformach AI. Śledzi aktywność crawlerów i wzmianki AI, pomagając zrozumieć widoczność w odpowiedziach AI i sposób wykorzystania Twoich treści.

Śledź, jak AI crawlery cytują i odwołują się do Twoich treści w ChatGPT, Perplexity, Google AI Overviews i innych platformach AI dzięki AmICited.

Dowiedz się, jak identyfikować i monitorować crawlery AI takie jak GPTBot, PerplexityBot i ClaudeBot w logach serwera. Poznaj ciągi user-agent, metody weryfikac...

Dowiedz się, którym crawlerom AI pozwolić, a które zablokować w swoim pliku robots.txt. Kompleksowy przewodnik obejmujący GPTBot, ClaudeBot, PerplexityBot oraz ...

Dowiedz się, jak działają AI crawlers takie jak GPTBot i ClaudeBot, czym różnią się od tradycyjnych crawlerów wyszukiwarek oraz jak zoptymalizować swoją stronę ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.